Bifurquer avant l’impact : l’impasse du capitalisme de surveillance

La chaleur de l’été ne nous fait pas oublier que nous traversons une crise dont les racines sont bien profondes. Pendant que nos forêts crament, que des oligarques jouent aux petits soldats à nos portes, et vu que je n’avais que cela à faire, je lisais quelques auteurs, ceux dont on ne parle que rarement mais qui sont Ô combien indispensables. Tout cela raisonnait si bien que, le temps de digérer un peu à l’ombre, j’ai tissé quelques liens avec mon sujet de prédilection, la surveillance et les ordinateurs. Et puis voilà, paf, le déclic. Dans mes archives, ces mots de Sébastien Broca en 2019 : « inscrire le capitalisme de surveillance dans une histoire plus large ». Mais oui, c’est là dessus qu’il faut insister, bien sûr. On s’y remet.

Je vous livre donc ici quelques réflexions qui, si elles sont encore loin d’être pleinement abouties, permettront peut-être à certains lecteurs d’appréhender les luttes sociales qui nous attendent ces prochains mois. Alimentons, alimentons, on n’est plus à une étincelle près.

— Christophe Masutti

Le capitalisme de surveillance est un mode d’être du capitalisme aujourd’hui dominant l’ensemble des institutions économiques et politiques. Il mobilise toutes les technologies de monitoring social et d’analyse de données dans le but de consolider les intérêts capitalistes à l’encontre des individus qui se voient spoliés de leur vie privée, de leurs droits et du sens de leur travail. L’exemple des entreprises-plateformes comme Uber est une illustration de cette triple spoliation des travailleurs comme des consommateurs. L’hégémonie d’Uber dans ce secteur d’activité s’est imposée, comme tout capitalisme hégémonique, avec la complicité des décideurs politiques. Cette complicité s’explique par la dénégation des contradictions du capitalisme et la contraction des politiques sur des catégories anciennes largement dépassées. Que les décideurs y adhèrent ou non, le discours public reste campé sur une idée de la production de valeur qui n’a plus grand-chose de commun avec la réalité de l’économie sur-financiarisée.

Il est donc important d’analyser le capitalisme de surveillance à travers les critiques du capitalisme et des technologies afin de comprendre, d’une part pourquoi les stratégies hégémoniques des multinationales de l’économie numérique ne sont pas une perversion du capitalisme mais une conséquence logique de la jonction historique entre technologie et finance, et d’autre part que toute régulation cherchant à maintenir le statu quo d’un soi-disant « bon » capitalisme est vouée à l’échec. Reste à explorer comment nous pouvons produire de nouveaux imaginaires économiques et retrouver un rapport aux technologies qui soit émancipateur et générateur de libertés.

Situer le capitalisme de surveillance dans une histoire critique du capitalisme

Dans la Monthly Review en 2014, ceux qui forgèrent l’expression capitalisme de surveillance inscrivaient cette dernière dans une critique du capitalisme monopoliste américain depuis la fin de la Seconde Guerre Mondiale. En effet, lorsqu’on le ramène à l’histoire longue, qui ne se réduit pas aux vingt dernières années de développement des plus grandes plateformes numériques mondiales, on constate que le capitalisme de surveillance est issu des trois grands axes de la dynamique capitaliste de la seconde moitié du XXᵉ siècle. Pour John B. Foster et Robert W. McChesney, la surveillance cristallise les intérêts de marché de l’économie qui soutient le complexe militaro-industriel sur le plan géopolitique, la finance, et le marketing de consommation, c’est-à-dire un impérialisme sur le marché extérieur (guerre et actionnariat), ce qui favorise en retour la dynamique du marché intérieur reposant sur le crédit et la consommation. Ce système impérialiste fonctionne sur une logique de connivence avec les entreprises depuis plus de soixante ans et a instauré la surveillance (de l’espionnage de la Guerre Froide à l’apparition de l’activité de courtage de données) comme le nouveau gros bâton du capitalisme.

Plus récemment, dans une interview pour LVSL, E. Morozov ne dit pas autre chose lorsqu’il affirme qu’aujourd’hui l’enjeu des Big Tech aux États-Unis se résume à la concurrence entre les secteurs d’activités technologiques sur le marché intérieur et « la volonté de maintenir le statut hégémonique des États-Unis dans le système financier international ».

Avancées technologiques et choix sociaux

Une autre manière encore de situer le capitalisme de surveillance sur une histoire longue consiste à partir du rôle de l’émergence de la microélectronique (ou ce que j’appelle l’informatisation des organisations) à travers une critique radicale du capitalisme. C’est sur les écrits de Robert Kurz (et les autres membres du groupe Krisis) qu’il faut cette fois se pencher, notamment son travail sur les catégories du capitalisme.

Ici on s’intéresse à la microélectronique en tant que troisième révolution industrielle. Sur ce point, comme je le fais dans mon livre, je préfère maintenir mon approche en parlant de l’informatisation des organisations, car il s’agit surtout de la transformation des processus de production et pas tellement des innovations techniques en tant que telles. Si en effet on se concentre sur ce dernier aspect de la microélectronique, on risque d’induire un rapport mécanique entre l’avancement technique et la transformation capitaliste, alors que ce rapport est d’abord le résultat de choix sociaux plus ou moins imposés par des jeux de pouvoirs (politique, financier, managérial, etc.). Nous y reviendrons : il est important de garder cela en tête car l’objet de la lutte sociale consiste à prendre la main sur ces choix pour toutes les meilleures raisons du monde, à commencer par notre rapport à l’environnement et aux techniques.

Pour expliquer, je vais devoir simplifier à l’extrême la pensée de R. Kurz et faire des raccourcis. Je m’en excuse par avance. R. Kurz s’oppose à l’idée de la cyclicité des crises du capitalisme. Au contraire ce dernier relève d’une dynamique historique, qui va toujours de l’avant, jusqu’à son effondrement. On peut alors considérer que la succession des crises ont été surmontées par le capitalisme en changeant le rapport structurel de la production. Il en va ainsi pour l’industrialisation du XIXᵉ siècle, le fordisme (industrialisation moderne), la sur-industrialisation des années 1930, le marché de consommation des années 1950, ou de la financiarisation de l’économie à partir des années 1970. Pour R. Kurz, ces transformations successives sont en réalité une course en avant vers la contradiction interne du capitalisme, son impossibilité à renouveler indéfiniment ses processus d’accumulation sans compter sur les compensations des pertes de capital, qu’elles soient assurées par les banques centrales qui produisent des liquidités (keynésianisme) ou par le marché financier lui-même remplaçant les banques centrales (le néolibéralisme qui crée toujours plus de dettes). Cette course en avant connaît une limite indépassable, une « borne interne » qui a fini par être franchie, celle du travail abstrait (le travail socialement nécessaire à la production, créant de la valeur d’échange) qui perd peu à peu son sens de critère de valeur marchande.

Cette critique de la valeur peut être vue de deux manières qui se rejoignent. La première est amenée par Roswitha Scholz et repose sur l’idée que la valeur comme rapport social déterminant la logique marchande n’a jamais été critiquée à l’aune tout à fait pratique de la reproduction de la force de travail, à savoir les activités qu’on détermine comme exclusivement féminines (faire le ménage, faire à manger, élever les enfants, etc.) et sont dissociées de la valeur. Or, cette tendance phallocrate du capitalisme (comme de la critique marxiste/socialiste qui n’a jamais voulu l’intégrer) rend cette conception autonome de la valeur complètement illusoire. La seconde approche situe dans l’histoire la fragilité du travail abstrait qui dépend finalement des processus de production. Or, au tournant des années 1970 et 1980, la révolution informatique (la microélectronique) est à l’origine d’une rationalisation pour ainsi dire fulgurante de l’ensemble des processus de production en très peu de temps et de manière mondialisée. Il devient alors plus rentable de rationaliser le travail que de conquérir de nouveaux espaces pour l’accumulation de capital. Le régime d’accumulation atteint sa limite et tout se rabat sur les marchés financiers et le capital fictif. Comme le dit R. Kurz dans Vies et mort du capitalisme1 :

C’est le plus souvent, et non sans raison, la troisième révolution industrielle (la microélectronique) qui est désignée comme la cause profonde de la nouvelle crise mondiale. Pour la première fois dans l’histoire du capitalisme, en effet, les potentiels de rationalisation dépassent les possibilités d’une expansion des marchés.

Non seulement il y a la perte de sens du travail (la rationalisation à des échelles inédites) mais aussi une rupture radicale avec les catégories du capitalisme qui jusque-là reposaient surtout sur la valeur marchande substantiellement liée au travail abstrait (qui lui-même n’intégrait pas de toute façon ses propres conditions de reproduction).

Très voisins, les travaux d’Ernst Lohoff et de Norbert Trenkle questionnent la surfinanciarisation de l’économie dans La grande dévalorisation2. Pour eux, c’est la forme même de la richesse capitaliste qui est en question. Ils en viennent aux mêmes considérations concernant l’informatisation de la société. La troisième révolution industrielle a créé un rétrécissement de la production de valeur. La microélectronique (entendue cette fois en tant que description de dispositifs techniques) a permis l’avancée de beaucoup de produits innovants mais l’innovation dans les processus de production qu’elle a induits a été beaucoup plus forte et attractive, c’est-à-dire beaucoup plus rentable : on a préféré produire avec toujours moins de temps de travail, et ce temps de travail a fini par devenir une variable de rentabilité au lieu d’être une production de valeur.

Si bien qu’on est arrivé à ce qui, selon Marx, est une incompatibilité avec le capitalisme : l’homme finit par se situer en dehors du processus de production. Du moins, il tend à l’être dans nos économies occidentales. Et ce fut pourtant une sorte d’utopie formulée par les capitalistes eux-mêmes dans les années 1960. Alors que les industries commençaient à s’informatiser, le rêve cybernéticien d’une production sans travailleurs était en plein essor. Chez les plus techno-optimistes on s’interrogeait davantage à propos des répercussions de la transformation des processus de production sur l’homme qu’à propos de leur impact sur la dynamique capitaliste. La transformation « cybernétique » des processus de production ne faisait pas vraiment l’objet de discussion tant la technologie était à l’évidence une marche continue vers une nouvelle société. Par exemple, pour un sociologue comme George Simpson3, au « stade 3 » de l’automatisation (lorsque les machines n’ont plus besoin d’intervention humaine directe pour fonctionner et produire), l’homme perd le sens de son travail, bien que libéré de la charge physique, et « le système industriel devient un système à boutons-poussoirs ». Que l’automatisation des processus de production (et aussi des systèmes décisionnels) fasse l’objet d’une critique ou non, ce qui a toujours été questionné, ce sont les répercussions sur l’organisation sociale et le constat que le travail n’a jamais été aussi peu émancipateur alors qu’on en attendait l’inverse4.

La surveillance comme catégorie du capitalisme

Revenons maintenant au capitalisme de surveillance. D’une part, son appellation de capitalisme devient quelque peu discutable puisqu’en effet il n’est pas possible de le désincarner de la dynamique capitaliste elle-même. C’est pour cela qu’il faut préciser qu’il s’agit surtout d’une expression initialement forgée pour les besoins méthodiques de son approche. Par contre, ce que j’ai essayé de souligner sans jamais le dire de cette manière, c’est que la surveillance est devenue une catégorie du capitalisme en tant qu’elle est une tentative de pallier la perte de substance du travail abstrait pour chercher de la valeur marchande dans deux directions :

- la rationalisation à l’extrême des processus productifs qu’on voit émerger dans l’économie de plateformes, de l’esclavagisme moderne des travailleurs du clic à l’ubérisation de beaucoup de secteurs productifs de services, voire aussi industriels (on pense à Tesla). Une involution du travail qui en retour se paie sur l’actionnariat tout aussi extrême de ces mêmes plateformes dont les capacités d’investissement réel sont quasi-nulles.

- L’autre direction est née du processus même de l’informatisation des organisations dès le début, comme je l’ai montré à propos de l’histoire d’Axciom, à savoir l’extraction et le courtage de données qui pillent littéralement nos vies privées et dissocient cette fois la force de travail elle-même du rapport social qu’elle implique puisque c’est dans nos intimités que la plus-value est recherchée. La financiarisation de ces entreprises est d’autant plus évidente que leurs besoins d’investissement sont quasiment nuls. Quant à leurs innovations (le travail des bases de données) elles sont depuis longtemps éprouvées et reposent aussi sur le modèle de plateforme mentionné ci-dessus.

Mais alors, dans cette configuration, on a plutôt l’impression qu’on ne fait que placer l’homme au centre de la production et non en dehors ou presque en dehors. Il en va ainsi des livreurs d’Uber, du travail à la tâche, des contrats de chantiers adaptés à la Recherche et à l’Enseignement, et surtout, surtout, nous sommes nous-mêmes producteurs des données dont se nourrit abondamment l’industrie numérique.

On comprend que, par exemple, certains ont cru intelligent de tenter de remettre l’homme dans le circuit de production en basant leur raisonnement sur l’idée de la propriété des données personnelles et de la « liberté d’entreprendre ». En réalité la configuration du travail à l’ère des plateformes est le degré zéro de la production de valeur : les données n’ont de valeur qu’une fois travaillées, concaténées, inférées, calculées, recoupées, stockées (dans une base), etc. En soi, même si elles sont échangeables sur un marché, il faut encore les rendre rentables et pour cela il y a de l’Intelligence Artificielle et des travailleurs du clic. Les seconds ne sont que du temps de travail volatile (il produit de la valeur en tant que travail salarié, mais si peu qu’il en devient négligeable au profit de la rationalisation structurelle), tandis que l’IA a pour objectif de démontrer la rentabilité de l’achat d’un jeu de données sur le marché (une sorte de travail mort-vivant5 qu’on incorporerait directement à la marchandisation). Et la boucle est bouclée : cette rentabilité se mesure à l’aune de la rationalisation des processus de production, ce qui génère de l’actionnariat et une tendance au renforcement des monopoles. Pour le reste, afin d’assurer les conditions de permanence du capitalisme (il faut bien des travailleurs pour assurer un minimum de salubrité de la structure, c’est-à-dire maintenir un minimum de production de valeur), deux choses :

- on maintient en place quelques industries dont tout le jeu mondialisé consiste à être de plus en plus rationalisées pour coûter moins cher et rapporter plus, ce qui accroît les inégalités et la pauvreté (et plus on est pauvre, plus on est exploité),

- on vend du rêve en faisant croire que le marché de produits innovants (concrets) est en soi producteur de valeur (alors que s’accroît la pauvreté) : des voitures Tesla, des services par abonnement, de l’école à distance, un métavers… du vent.

Réguler le capitalisme ne suffit pas

Pour l’individu comme pour les entreprises sous perfusion technologique, l’attrait matériel du capitalisme est tel qu’il est extrêmement difficile de s’en détacher. G. Orwell avait (comme on peut s’y attendre de la part d’un esprit si brillant) déjà remarqué cette indécrottable attraction dans Le Quai de Wigan : l’adoration de la technique et le conformisme polluent toute critique entendable du capitalisme. Tant que le capitalisme maintiendra la double illusion d’une production concrète et d’un travail émancipateur, sans remettre en cause le fait que ce sont bien les produits financiers qui représentent l’essentiel du PIB mondial6, les catégories trop anciennes avec lesquelles nous pensons le capitalisme ne nous permettront pas de franchir le pas d’une critique radicale de ses effets écocides et destructeurs de libertés.

Faudrait-il donc s’en accommoder ? La plus importante mise en perspective critique des mécanismes du capitalisme de surveillance, celle qui a placé son auteure Shoshana Zuboff au-devant de la scène ces trois dernières années, n’a jamais convaincu personne par les solutions qu’elle propose.

Premièrement parce qu’elle circonscrit le capitalisme de surveillance à la mise en œuvre par les GAFAM de solutions de rentabilité actionnariale en allant extraire le minerai de données personnelles afin d’en tirer de la valeur marchande. Le fait est qu’en réalité ce modèle économique de valorisation des données n’est absolument pas nouveau, il est né avec les ordinateurs dont c’est la principale raison d’être (vendables). Par conséquent ces firmes n’ont créé de valeur qu’à la marge de leurs activités principales (le courtage de données), par exemple en fournissant des services dont le Web aurait très bien pu se passer. Sauf peut-être la fonction de moteur de recherche, nonobstant la situation de monopole qu’elle a engendrée au détriment de la concurrence, ce qui n’est que le reflet de l’effet pervers du monopole et de la financiarisation de ces firmes, à savoir tuer la concurrence, s’approprier (financièrement) des entreprises innovantes, et tuer toute dynamique diversifiée d’innovation.

Deuxièmement, les solutions proposées reposent exclusivement sur la régulation des ces monstres capitalistes. On renoue alors avec d’anciennes visions, celles d’un libéralisme garant des équilibres capitalistes, mais cette fois presque exclusivement du côté du droit : c’est mal de priver les individus de leur vie privée, donc il faut plus de régulation dans les pratiques. On n’est pas loin de renouer avec la vieille idée de l’ethos protestant à l’origine du capitalisme moderne selon Max Weber : la recherche de profit est un bien, il s’accomplit par le travail et le don de soi à l’entreprise. La paix de nos âmes ne peut donc avoir lieu sans le capitalisme. C’est ce que cristallise Milton Friedman dans une de ses célèbres affirmations : « la responsabilité sociale des entreprises est de maximiser leurs profits »7. Si le capitalisme est un dispositif géant générateur de profit, il n’est ni moral ni immoral, c’est son usage, sa destination qui l’est. Par conséquent, ce serait à l’État d’agir en assumant les conséquences d’un mauvais usage qu’en feraient les capitalistes.

Contradiction : le capitalisme n’est pas un simple dispositif, il est à la fois marché, organisation, choix collectifs, et choix individuels. Son extension dans nos vies privées est le résultat du choix de la rationalisation toujours plus drastique des conditions de rentabilité. Dans les années 1980, les économistes néoclassiques croyaient fortement au triptyque gagnant investissement – accroissement de main d’œuvre – progrès technique. Sauf que même l’un des plus connus des économistes américains, Robert Solow, a dû se rendre à une évidence, un « paradoxe » qu’il soulevait après avoir admis que « la révolution technologique [de l’informatique] s’est accompagnée partout d’un ralentissement de la croissance de la productivité, et non d’une augmentation ». Il conclut : « Vous pouvez voir l’ère informatique partout, sauf dans les statistiques de la productivité »8. Pour Solow, croyant encore au vieux monde de la croissance « productrice », ce n’était qu’une question de temps, mais pour l’économie capitaliste, c’était surtout l’urgence de se tourner vers des solutions beaucoup plus rapides : l’actionnariat (et la rationalisation rentable des process) et la valorisation quasi-immédiate de tout ce qui pouvait être valorisable sur le marché le plus facile possible, celui des services, celui qui nécessite le moins d’investissements.

La volonté d’aller dans le mur

Le capitalisme à l’ère numérique n’a pas créé de stagnation, il est structurellement destructeur. Il n’a pas créé de défaut d’investissement, il est avant tout un choix réfléchi, la volonté d’aller droit dans le mur en espérant faire partie des élus qui pourront changer de voiture avant l’impact. Dans cette hyper-concurrence qui est devenue essentiellement financière, la seule manière d’envisager la victoire est de fabriquer des monopoles. C’est là que la fatuité de la régulation se remarque le plus. Un récent article de Michael Kwet9 résume très bien la situation. On peut le citer longuement :

Les défenseurs de la législation antitrust affirment que les monopoles faussent un système capitaliste idéal et que ce qu’il faut, c’est un terrain de jeu égal pour que tout le monde puisse se faire concurrence. Pourtant, la concurrence n’est bonne que pour ceux qui ont des ressources à mettre en concurrence. Plus de la moitié de la population mondiale vit avec moins de 7,40 dollars [7,16 euros] par jour, et personne ne s’arrête pour demander comment ils seront “compétitifs” sur le “marché concurrentiel” envisagé par les défenseurs occidentaux de l’antitrust. C’est d’autant plus décourageant pour les pays à revenu faible ou intermédiaire que l’internet est largement sans frontières.

À un niveau plus large […] les défenseurs de l’antitrust ignorent la division globalement inégale du travail et de l’échange de biens et de services qui a été approfondie par la numérisation de l’économie mondiale. Des entreprises comme Google, Amazon, Meta, Apple, Microsoft, Netflix, Nvidia, Intel, AMD et bien d’autres sont parvenues à leur taille hégémonique parce qu’elles possèdent la propriété intellectuelle et les moyens de calcul utilisés dans le monde entier. Les penseurs antitrust, en particulier ceux des États-Unis, finissent par occulter systématiquement la réalité de l’impérialisme américain dans le secteur des technologies numériques, et donc leur impact non seulement aux États-Unis, mais aussi en Europe et dans les pays du Sud.

Les initiatives antitrust européennes ne sont pas meilleures. Là-bas, les décideurs politiques qui s’insurgent contre les maux des grandes entreprises technologiques tentent discrètement de créer leurs propres géants technologiques.

Dans la critique mainstream du capitalisme de surveillance, une autre erreur s’est révélée, en plus de celle qui consiste à persister dans la défense d’un imaginaire capitaliste. C’est celle de voir dans l’État et son pouvoir de régulation un défenseur de la démocratie. C’est d’abord une erreur de principe : dans un régime capitaliste monopoliste, l’État assure l’hégémonie des entreprises de son cru et fait passer sous l’expression démocratie libérale (ou libertés) ce qui favorise l’émergence de situations de domination. Pour lutter contre, il y a une urgence dans notre actualité économique : la logique des start-up tout autant que celle de la « propriété intellectuelle » doivent laisser place à l’expérimentation collective de gouvernance de biens communs de la connaissance et des techniques (nous en parlerons plus loin). Ensuite, c’est une erreur pratique comme l’illustrent les affaires de lobbying et de pantouflage dans le petit monde des décideurs politiques. Une illustration parmi des centaines : les récents Uber Files démontrant, entre autres, les accords passés entre le président Emmanuel Macron et les dirigeants d’Uber (voir sur le site Le Monde).

Situer ces enjeux dans un contexte historique aussi général suppose de longs développements, rarement simples à exposer. Oui, il s’agit d’une critique du capitalisme, et oui cette critique peut être plus ou moins radicale selon que l’on se place dans un héritage marxiste, marxien ou de la critique de la valeur, ou que l’on demeure persuadé qu’un capitalisme plus respectueux, moins « féodal » pourrait advenir. Sans doute qu’un mirage subsiste, celui de croire qu’autant de bienfaits issus du capitalisme suffisent à le dédouaner de l’usage dévoyé des technologies. « Sans le capitalisme nous en serions encore à nous éclairer à la bougie…» En d’autres termes, il y aurait un progrès indiscutable à l’aune duquel les technologies de surveillance pourraient être jugées. Vraiment ?

Situer le capitalisme de surveillance dans notre rapport à la technique

C’est un poncif : les technologies de surveillance ont été développées dans une logique de profit. Il s’agit des technologies dont l’objectif est de créer des données exploitables à partir de nos vies privées, à des fins de contrôle ou purement mercantiles (ce qui revient au même puisque les technologies de contrôle sont possédées par des firmes qui achètent des données).

Or, il est temps de mettre fin à l’erreur répandue qui consiste à considérer que les technologies de surveillance sont un mal qui pervertit le capitalisme censé être le moteur de la démocratie libérale. Ceci conduit à penser que seule une régulation bien menée par l’État dans le but de restaurer les vertus du « bon » capitalisme serait salutaire tant nos vies privées sont sur-exploitées et nos libertés érodées. Tel est le credo de Shoshana Zuboff et avec elle bon nombre de décideurs politiques.

Croire qu’il y a de bons et de mauvais usages

L’erreur est exactement celle que dénonçait en son temps Jacques Ellul. C’est celle qui consiste à vouloir absolument attribuer une valeur à l’usage de la technique. Le bon usage serait celui qui pousse à respecter la vie privée, et le mauvais usage celui qui tend à l’inverse. Or, il n’y a d’usage technique que technique. Il n’y a qu’un usage de la bombe atomique, celui de faire boum (ou pas si elle est mal utilisée). Le choix de développer la bombe est, lui, par contre, un choix qui fait intervenir des enjeux de pouvoir et de valeurs.

Au tout début des années 1970, à l’époque où se développaient les techniques d’exploitation des bases de données et le courtage de données, c’est ce qu’ont montré James Martin et Adrian Norman pour ce qui concerne les systèmes informatiques10 : à partir du moment où un système est informatisé, la quantification est la seule manière de décrire le monde. Ceci est valable y compris pour les systèmes décisionnels. Le paradoxe que pointaient ces auteurs montrait que le traitement de l’information dans un système décisionnel – par exemple dans n’importe quelle organisation économique, comme une entreprise – devait avoir pour objectif de rationaliser les procédures et les décisions en utilisant une quantité finie de données pour en produire une quantité réduite aux éléments les plus stratégiques, or, l’informatisation suppose un choix optimum parmi une grande variété d’arbres décisionnels et donc un besoin croissant de données, une quantité tendant vers l’infini.

Martin et Norman illustraient ce qu’avait affirmé Jacques Ellul vingt ans auparavant : la technique et sa logique de développement seraient autonomes. Bien que discutable, cette hypothèse montre au moins une chose : dans un monde capitaliste, tout l’enjeu consisterait comme au rugby à transformer l’essai, c’est-à-dire voir dans le développement des techniques autant d’opportunités de profit et non pas d’investissements productifs. Les choix se posent alors en termes d’anti-productivité concrète. Dans le monde des bases de données et leur exploitation la double question qui s’est posée de 1970 à aujourd’hui est de savoir si nous sommes capables d’engranger plus ou moins de données et comment leur attribuer une valeur marchande.

Le reste n’est que sophismes : l’usine entièrement automatisée des rêves cybernéticiens les plus fous, les boules de cristal des statistiques électorales, les données de recouvrement bancaires et le crédit à la consommation, les analyses marketing et la consommation de masse, jusqu’à la smart city de la Silicon Valley et ses voitures autonomes (et ses aspirateurs espions)… la justification de la surveillance et de l’extraction de données repose sur l’idée d’un progrès social, d’un bon usage des technologies, et d’une neutralité des choix technologiques. Et il y a un paralogisme. Si l’on ne pense l’économie qu’en termes capitalistes et libéraux, cette neutralité est un postulat qui ne peut être remis en cause qu’à l’aune d’un jugement de valeur : il y aurait des bons et des mauvais usages des technologies, et c’est à l’État d’assurer le rôle minimal de les arbitrer au regard de la loi. Nul ne remet alors en question les choix eux-mêmes, nul ne remet en question l’hégémonie des entreprises qui nous couvrent de leurs « bienfaits » au prix de quelques « négligeables » écarts de conduite, nul ne remet en question l’exploitation de nos vies privées (un mal devenu nécessaire) et l’on préfère nous demander notre consentement plus ou moins éclairé, plus ou moins obligé.

La technologie n’est pas autonome

Cependant, comme nous le verrons vers la fin de ce texte, les études en sociologie des sciences montrent en fait qu’il n’y a pas d’autonomie de la technique. Sciences, technologies et société s’abreuvent mutuellement entre les usages, les expérimentations et tous ces interstices épistémiques d’appropriation des techniques, de désapprentissage, de renouvellement, de détournements, et d’expression des besoins pour de nouvelles innovations qui seront à leur tour appropriées, modifiées, transformées, etc. En réalité l’hypothèse de l’autonomie de la technique a surtout servi au capitalisme pour suivre une course à l’innovation qui ne saurait être remise en question, comme une loi naturelle qui justifie en soi la mise sur le marché de nouvelles technologies et au besoin faire croire en leur utilité. Tel est le fond de commerce du transhumanisme et son « économie des promesses ».

L’erreur consiste à prêter le flanc au solutionnisme technologique (le même qui nous fait croire que des caméras de surveillance sont un remède à la délinquance, ou qu’il faut construire des grosses berlines sur batteries pour ne plus polluer) et à se laisser abreuver des discours néolibéraux qui, parce qu’il faut bien rentabiliser ces promesses par de la marchandisation des données – qui est elle-même une promesse pour l’actionnariat –, nous habituent petit à petit à être surveillés. Pour se dépêtrer de cela, la critique du capitalisme de surveillance doit être une critique radicale du capitalisme et du néolibéralisme car la lutte contre la surveillance ne peut être décorrélée de la prise en compte des injustices sociales et économiques dont ils sont les causes pratiques et idéologiques.

Je vois venir les lecteurs inquiets. Oui, j’ai placé ce terme de néolibéralisme sans prévenir. C’est mettre la charrue avant les bœufs mais c’est parfois nécessaire. Pour mieux comprendre, il suffit de définir ce qu’est le néolibéralisme. C’est l’idéologie appelée en Allemagne ordolibéralisme, si l’on veut, c’est-à-dire l’idée que le laissez-faire a démontré son erreur historique (les crises successives de 1929, 1972, 2008, ou la crise permanente), et que par conséquent l’État a fait son grand retour dans le marché au service du capital, comme le principal organisateur de l’espace de compétition capitaliste et le dépositaire du droit qui érige la propriété et le profit au titre de seules valeurs acceptables. Que des contrats, plus de discussion, there is no alternative, comme disait la Margaret. Donc partant de cette définition, à tous les niveaux organisationnels, celui des institutions de l’État comme celui des organisations du capital, la surveillance est à la fois outil de contrôle et de génération de profit (dans les limites démontrées par R. Kurz, à savoir : pas sans compter presque exclusivement sur l’actionnariat et les produits financiers, cf. plus haut).

Le choix du « monitoring »

La course en avant des technologies de surveillance est donc le résultat d’un choix. Il n’y a pas de bon ou de mauvais usage de la surveillance électronique : elle est faite pour récolter des données. Le choix en question c’est celui de n’avoir vu dans ces données qu’un objet marchand. Peu importe les bienfaits que cela a pu produire pour l’individu, ils ne sont visibles que sur un court terme. Par exemple les nombreuses applications de suivi social que nous utilisons nous divertissent et rendent parfois quelque service, mais comme le dit David Lyon dans The Culture of Surveillance, elle ne font que nous faire accepter passivement les règles du monitoring et du tri social que les États comme les multinationales mettent en œuvre.

Il n’y a pas de différence de nature entre la surveillance des multinationales et la surveillance par l’État : ce sont les multinationales qui déterminent les règles du jeu de la surveillance et l’État entérine ces règles et absorbe les conditions de l’exercice de la surveillance au détriment de sa souveraineté. C’est une constante bien comprise, qu’il s’agisse des aspects techniques de la surveillance sur lesquels les Big Tech exercent une hégémonie qui en retour sert les intérêts d’un ou plusieurs États (surtout les États-Unis aujourd’hui), ou qu’il s’agisse du droit que les Big Tech tendent à modifier en leur faveur soit par le jeu des lobbies soit par le jeu des accords internationaux (tout comme récemment le nouvel accord entre l’Europe et les États-Unis sur les transferts transatlantiques de données, qui vient contrecarrer les effets d’annonce de la Commission Européenne).

Illustration CC-By David Revoy (sources)

Quels espaces de liberté dans ce monde technologique ?

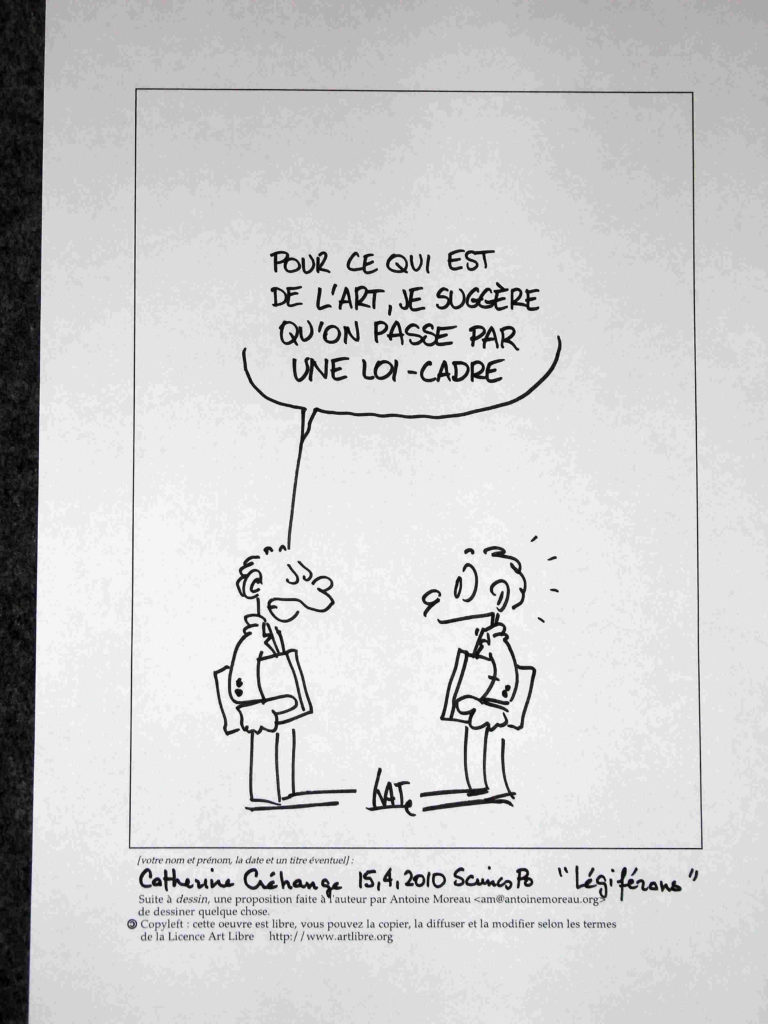

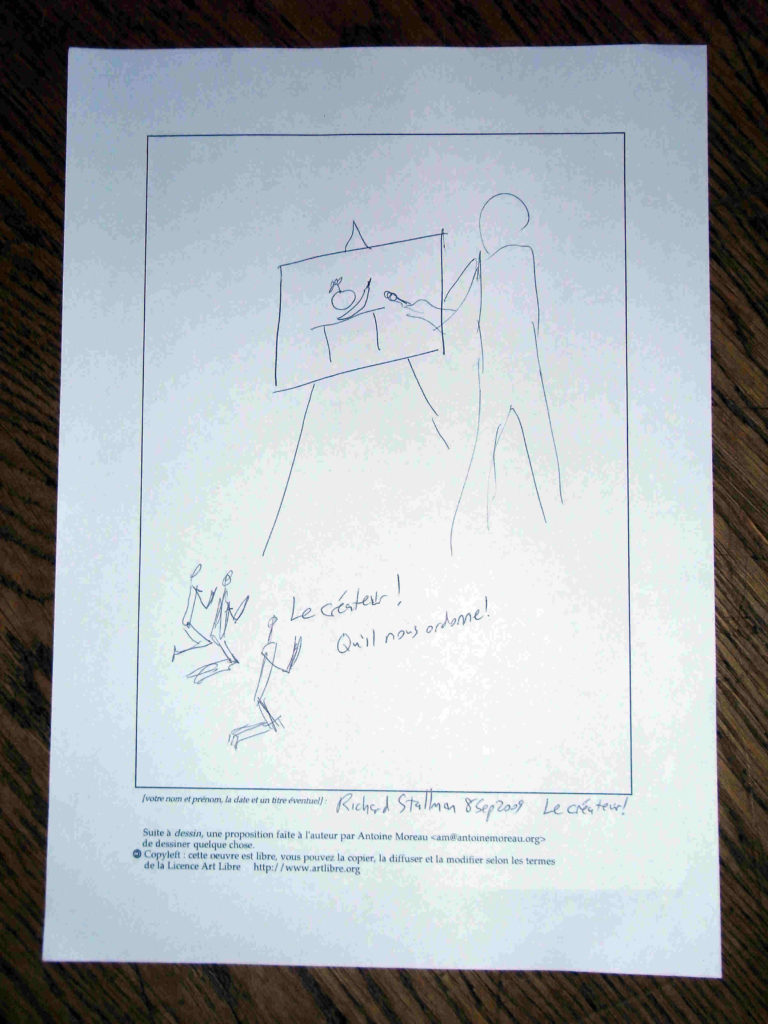

Avec l’apparition des ordinateurs et des réseaux, de nombreuses propositions ont vu le jour. Depuis les années 1970, si l’on suit le développement des différents mouvements de contestation sociale à travers le monde, l’informatique et les réseaux ont souvent été plébiscités comme des solutions techniques aux défauts des démocraties. De nombreux exemples d’initiatives structurantes pour les réseaux informatiques et les usages des ordinateurs se sont alors vus détournés de leurs fonctions premières. On peut citer le World Wide Web tel que conçu par Tim Berners Lee, lui même suivant les traces du monde hypertextuel de Ted Nelson et son projet Xanadu. Pourquoi ce design de l’internet des services s’est-il trouvé à ce point sclérosé par la surveillance ? Pour deux raisons : 1) on n’échappe pas (jamais) au développement technique de la surveillance (les ordinateurs ont été faits et vendus pour cela et le sont toujours11) et 2) parce qu’il y a des intérêts de pouvoir en jeu, policiers et économiques, celui de contrôler les communications. Un autre exemple : le partage des programmes informatiques. Comme chacun le sait, il fut un temps où la création d’un programme et sa distribution n’étaient pas assujettis aux contraintes de la marchandisation et de la propriété intellectuelle. Cela permettait aux utilisateurs de machines de partager non seulement des programmes mais des connaissances et des nouveaux usages, faisant du code un bien commun. Sous l’impulsion de personnages comme Bill Gates, tout cela a changé au milieu des années 1970 et l’industrie du logiciel est née. Cela eut deux conséquences, négative et positive. Négative parce que les utilisateurs perdaient absolument toute maîtrise de la machine informatique, et toute possibilité d’innovation solidaire, au profit des intérêts d’entreprises qui devinrent très vite des multinationales. Positive néanmoins, car, grâce à l’initiative de quelques hackers, dont Richard Stallman, une alternative fut trouvée grâce au logiciel libre et la licence publique générale et ses variantes copyleft qui sanctuarisent le partage du code. Ce partage relève d’un paradigme qui ne concerne plus seulement le code, mais toute activité intellectuelle dont le produit peut être partagé, assurant leur liberté de partage aux utilisateurs finaux et la possibilité de créer des communs de la connaissance.

Alors que nous vivons dans un monde submergé de technologies, nous aurions en quelque sorte gagné quelques espaces de liberté d’usage technique. Mais il y a alors comme un paradoxe.

À l’instar de Jacques Ellul, pour qui l’autonomie de la technique implique une aliénation de l’homme à celle-ci, beaucoup d’auteurs se sont inquiétés du fait que les artefacts techniques configurent par eux-mêmes les actions humaines. Qu’on postule ou pas une autonomie de la technique, son caractère aliénant reste un fait. Mais il ne s’agit pas de n’importe quels artefacts. Nous ne parlons pas d’un tournevis ou d’un marteau, ou encore d’un silex taillé. Il s’agit des systèmes techniques, c’est-à-dire des dispositifs qu’on peut qualifier de socio-techniques qui font intervenir l’homme comme opérateur d’un ensemble d’actions techniques par la technique. En quelque sorte, nous perdons l’initiative et les actions envisagées tendent à la conformité avec le dispositif technique et non plus uniquement à notre volonté. Typiquement, les ordinateurs dans les entreprises à la fin des années 1960 ont été utilisés pour créer des systèmes d’information, et c’est à travers ces systèmes techniques que l’action de l’homme se voit configurée, modelée, déterminée, entre ce qui est possible et ce qui ne l’est pas. Dans son article « Do artefacts have politics ? », Langdon Winner s’en inquiétait à juste titre : nos objectifs et le sens de nos actions sont conditionnés par la technique. Cette dernière n’est jamais neutre, elle peut même provoquer une perte de sens de l’action, par exemple chez le travailleur à la chaîne ou le cadre qui non seulement peuvent être noyés dans une organisation du travail trop grande, mais aussi parce que l’automatisation de la production et de la décision les prive de toute initiative (et de responsabilité).

La tentation du luddisme

Pour lutter contre cette perte de sens, des choix sont envisageables. Le premier consiste à lutter contre la technique. En évacuant la complexité qu’il y a à penser qu’un mouvement réfractaire au développement technique puisse aboutir à une société plus libre, on peut certes imaginer des fronts luddites en certains secteurs choisis. Par exemple, tel fut le choix du CLODO dans la France des années 1980, prétendant lutter contre l’envahissement informatique dans la société. Concernant la surveillance, on peut dire qu’au terme d’un processus de plus de 50 ans, elle a gagné toutes les sphères socio-économiques grâce au développement technologique. Un front (néo-)luddite peut sembler justifié tant cette surveillance remet en cause très largement nos libertés et toutes les valeurs positives que l’on oppose généralement au capitalisme : solidarité et partage, notamment.

Pour autant, est-ce que la lutte contre le capitalisme de surveillance doit passer par la négation de la technique ? Il est assez évident que toute forme d’action directe qui s’oppose en bloc à la technique perd sa crédibilité en ce qu’elle ne fait que proposer un fantasme passéiste ou provoquer des réactions de retrait qui n’ont souvent rien de constructif. C’est une critique souvent faite à l’anarcho-primitivisme qui, lorsqu’il ne se contente pas d’opposer une critique éclairée de la technique (et des processus qui ont conduit à la création de l’État) en vient parfois à verser dans la technophobie. C’est une réaction aussi compréhensible que contrainte tant l’envahissement technologique et ses discours ont quelque chose de suffoquant. En oubliant cette question de l’autonomie de la technique, je suis personnellement tout à fait convaincu par l’analyse de J. Ellul selon laquelle nous sommes à la fois accolés et dépendants d’un système technique. En tant que système il est devenu structurellement nécessaire aux organisations (qu’elles soient anarchistes ou non) au moins pour communiquer, alors que le système capitaliste, lui, ne nous est pas nécessaire mais imposé par des jeux de pouvoirs. Une réaction plus constructive consiste donc à orienter les choix technologiques, là où l’action directe peut prendre un sens tout à fait pertinent.

Prenons un exemple qui pourrait paraître trivial mais qui s’est révélé particulièrement crucial lors des périodes de confinement que nous avons subies en raison de l’épidémie Covid. Qu’il s’agisse des entreprises ou des institutions publiques, toutes ont entamé dans l’urgence une course en avant vers les solutions de visio-conférence dans l’optique de tâcher de reproduire une forme présentielle du travail de bureau. La visio-conférence suscite un flux de données bien plus important que la voix seule, et par ailleurs la transmission vocale est un ensemble de techniques déjà fort éprouvées depuis plus d’un siècle. Que s’est-il produit ? Les multinationales se sont empressées de vendre leurs produits et pomper toujours plus de données personnelles, tandis que les limites pratiques de la visio-conférence se sont révélées : dans la plupart des cas, réaliser une réunion « filmée » n’apporte strictement rien de plus à l’efficacité d’une conférence vocale. Dans la plupart des cas, d’ailleurs, afin d’économiser de la bande passante (croit-on), la pratique courante consiste à éteindre sa caméra pendant la réunion. Où sont les gains de productivité tant annoncés par les GAFAM ? Au lieu de cela, il y a en réalité un détournement des usages, et même des actes de résistance du quotidien (surtout lorsqu’il s’agit de surveiller les salariés à distance).

Les choix technologiques doivent être collectifs

Une critique des techniques pourrait donc consister à d’abord faire le point sur nos besoins et en prenant en compte l’urgence climatique et environnementale dans laquelle nous sommes (depuis des décennies). Elle pourrait aussi consister à prendre le contrepoint des discours solutionnistes qui tendent à justifier le développement de techniques le plus souvent inutiles en pratique mais toujours plus contraignantes quant au limites éthiques vers lesquelles elles nous poussent. Les choix technologiques doivent donc d’abord être des choix collectifs, dont l’assentiment se mesure en fonction de l’économie énergétique et de l’acceptabilité éthique de la trajectoire choisie. On peut revenir à une technologie ancienne et éprouvée et s’en contenter parce qu’elle est efficace et on peut refuser une technologie parce qu’elle n’est pas un bon choix dans l’intérêt collectif. Et par collectif, j’entends l’ensemble des relations inter-humaines et des relations environnementales dont dépendent les premières.

Les attitudes de retraits par rapports aux technologies, le refus systématique des usages, sont rarement bénéfiques et ne constituent que rarement une démarche critique. Ils sont une réaction tout à fait compréhensible du fait que la politique a petit à petit déserté les lieux de production (pour ce qu’il en reste). On le constate dans le désistement progressif du syndicalisme ces 30 ou 40 dernières années et par le fait que la critique socialiste (ou « de gauche ») a été incapable d’intégrer la crise du capitalisme de la fin du XXᵉ siècle. Pire, en se transformant en un centre réactionnaire, cette gauche a créé une technocratie de la gestion aux ordres du néolibéralisme : autoritarisme et pansements sociaux pour calmer la révolte qui gronde. Dès lors, de désillusions en désillusions, dans la grande cage concurrentielle de la rareté du travail rémunéré (rentable) quelle place peut-il y avoir pour une critique des techniques et de la surveillance ? Peut-on demander sérieusement de réfléchir à son usage de Whatsapp à une infirmière qui a déjà toutes les difficultés du monde à concilier la garde de ses enfants, les heures supplémentaires (parfois non payées) à l’hôpital, le rythme harassant du cycle des gardes, les heures de transports en commun et par dessus le marché, le travail domestique censé assurer les conditions de reproduction du travail abstrait ? Alors oui, dans ces conditions où le management du travail n’est devenu qu’une affaire de rationalisation rentable, les dispositifs techniques ne font pas l’objet d’usages réfléchis ou raisonnés, il font toujours l’objet d’un usage opportuniste : je n’utilise pas Whatsapp parce que j’aime Facebook ou que je me fiche de savoir ce que deviennent mes données personnelles, j’utilise Whatsapp parce que c’est le moyen que j’ai trouvé pour converser avec mes enfants et m’assurer qu’ils sont bien rentrés à la maison après l’école.

Low tech et action directe

En revanche, un retrait que je pourrais qualifier de technophobe et donc un minimum réfléchi, laisse entier le problème pour les autres. La solidarité nous oblige à créer des espaces politiques où justement technologie et capitalisme peuvent faire l’objet d’une critique et surtout d’une mise en pratique. Le mouvement Low Tech me semble être l’un des meilleurs choix. C’est en substance la thèse que défend Uri Gordon (« L’anarchisme et les politiques techniques ») en voyant dans les possibilités de coopérations solidaires et de choix collectivement réfléchis, une forme d’éthique de l’action directe.

Je le suivrai sur ce point et en étendant davantage le spectre de l’action directe. Premièrement parce que si le techno-capitalisme aujourd’hui procède par privation de libertés et de politique, il n’implique pas forcément l’idée que nous ne soyons que des sujets soumis à ce jeu de manière inconditionnelle. C’est une tendance qu’on peut constater dans la plupart des critiques du pouvoir : ne voir l’individu que comme une entité dont la substance n’est pas discutée, simplement soumis ou non soumis, contraint ou non contraint, privé de liberté ou disposant de liberté, etc. Or il y a tout un ensemble d’espaces de résistance conscients ou non conscients chez tout individu, ce que Michel de Certeau appelait des tactiques du quotidien12. Il ne s’agit pas de stratégies où volonté et pouvoir se conjuguent, mais des mouvements « sur le fait », des alternatives multiples mises en œuvre sans chercher à organiser cet espace de résistance. Ce sont des espaces féconds, faits d’expérimentations et d’innovations, et parfois même configurent les techniques elles-mêmes dans la différence entre la conception initiale et l’usage final à grande échelle. Par exemple, les ordinateurs et leurs systèmes d’exploitations peuvent ainsi être tantôt les instruments de la surveillance et tantôt des instruments de résistance, en particulier lorsqu’ils utilisent des logiciels libres. Des apprentissages ont lieu et cette fois ils dépassent l’individu, ils sont collectifs et ils intègrent des connaissances en commun.

En d’autres termes, chaque artefact et chaque système technique est socialement digéré, ce qui en retour produit des interactions et détermine des motivations et des objectifs qui peuvent s’avérer très différents de ceux en fonction desquels les dispositifs ont été créés. Ce processus est ce que Sheila Jasanoff appelle un processus de coproduction épistémique et normatif13 : sciences et techniques influencent la société en offrant un cadre tantôt limitatif, tantôt créatif, ce qui en retour favorise des usages et des besoins qui conditionnent les trajectoires scientifiques et technologiques. Il est par conséquent primordial de situer l’action directe sur ce créneau de la coproduction en favorisant les expériences tactiques individuelles et collectives qui permettent de déterminer des choix stratégiques dans l’orientation technologique de la société. Dit en des mots plus simples : si la décision politique n’est plus suffisante pour garantir un cadre normatif qui reflète les choix collectifs, alors ce sont les collectifs qui doivent pouvoir créer des stratégies et au besoin les imposer par un rapport de force.

Créer des espaces d’expérimentations utopiques

Les hackers ne produisent pas des logiciels libres par pur amour d’autrui et par pure solidarité : même si ces intentions peuvent être présentes (et je ne connais pas de libristes qui ne soient pas animés de tels sentiments), la production de logiciel libre (ou open source) est d’abord faite pour créer de la valeur. On crée du logiciel libre parce que collectivement on est capable d’administrer et valoriser le bien commun qu’est le code libre, à commencer par tout un appareillage juridique comme les licences libres. Il en va de même pour toutes les productions libres qui emportent avec elles un idéal technologique : l’émancipation, l’activité libre que représente le travail du code libre (qui n’est la propriété de personne). Même si cela n’exempte pas de se placer dans un rapport entre patron (propriétaire des moyens de production) et salarié, car il y a des entreprises spécialisées dans le Libre, il reste que le Libre crée des espaces d’équilibres économiques qui se situent en dehors de l’impasse capitaliste. La rentabilité et l’utilité se situent presque exclusivement sur un plan social, ce qui explique l’aspect très bigarré des modèles d’organisations économiques du Libre, entre associations, fondations, coopératives…

L’effet collatéral du Libre est aussi de créer toujours davantage d’espaces de libertés numériques, cette fois en dehors du capitalisme de surveillance et ses pratiques d’extraction. Cela va des pratiques de chiffrement des correspondances à l’utilisation de logiciels dédiés explicitement aux luttes démocratiques à travers le monde. Cela a le mérite de créer des communautés plus ou moins fédérées ou archipélisées, qui mettent en pratique ou du moins sous expérimentation l’alliance entre les technologies de communication et l’action directe, au service de l’émancipation sociale.

Il ne s’agit pas de promettre un grand soir et ce n’est certes pas avec des expériences qui se complaisent dans la marginalité que l’on peut bouleverser le capitalisme. Il ne s’agit plus de proposer des alternatives (qui fait un détour lorsqu’on peut se contenter du droit chemin?) mais des raisons d’agir. Le capitalisme est désuet. Dans ses soubresauts (qui pourraient bien nous mener à la guerre et la ruine), on ressort l’argument du bon sens, on cherche le consentement de tous malgré l’expérience que chacun fait de l’exploitation et de la domination. Au besoin, les capitalistes se montrent autoritaires et frappent. Mais que montrent les expériences d’émancipation sociales ? Que nous pouvons créer un ordre fait de partage et d’altruisme, de participation et de coopération, et que cela est parfaitement viable, sans eux, sur d’autres modèles plus cohérents14. En d’autres termes, lutter contre la domination capitaliste, c’est d’abord démontrer par les actes que d’autres solutions existent et sans chercher à les inclure au forceps dans ce système dominant. Au contraire, il y a une forme d’héroïsme à ne pas chercher à tordre le droit si ce dernier ne permet pas une émancipation franche et durable du capitalisme. Si le droit ne convient pas, il faut prendre le gauche.

La lutte pour les libertés numériques et l’application des principes du Libre permettent de proposer une sortie positive du capitalisme destructeur. Néanmoins on n’échappera pas à la dure réalité des faits. Par exemple que l’essentiel des « tuyaux » des transmissions numériques (comme les câbles sous-marins) appartiennent aux multinationales du numérique et assurent ainsi l’un des plus écrasants rapports de domination de l’histoire. Pourtant, on peut imaginer des expériences utopiques, comme celle du Chaos Computer Club, en 2012, consistant à créer un Internet hors censure via un réseau de satellite amateur.

L’important est de créer des espaces d’expérimentation utopiques, parce qu’ils démontrent tôt ou tard la possibilité d’une solution, il sont préfiguratifs15. Devant la décision politique au service du capital, la lutte pour un réseau d’échanges libres ne pourra certes pas se passer d’un rapport de force mais encore moins de nouveaux imaginaires. Car, finalement, ce que crée la crise du capitalisme, c’est la conscience de son écocide, de son injustice, de son esclavagisme technologique. Reste l’espoir, première motivation de l’action.

Notes

- R. Kurz, Vies et mort du capitalisme, Nouvelles Éditions Ligne, 2011, p. 37↩︎

- Ernst Lohoff et Norbert Trenkle, La grande dévalorisation. Pourquoi la spéculation et la dette de l’État ne sont pas les causes de la crise, Paris, Post-éditions, 2014.↩︎

- Georges Simpson, « Western Man under Automation », International Journal of Comparative Sociology, num. 5, 1964, pp. 199-207.↩︎

- Comme le dit Moishe Postone dans son article « Repenser Le Capital à la lumière des Grundrisse » : « La transformation radicale du processus de production mentionnée plus haut n’est pas le résultat quasi-automatique du développement rapide des savoirs techniques et scientifique et de leurs applications. C’est plutôt une possibilité qui naît d’une contradiction sociale intrinsèque croissante. Bien que la course du développement capitaliste génère la possibilité d’une structure nouvelle et émancipatrice du travail social, sa réalisation générale est impossible dans le capitalisme. »↩︎

- Là je reprends une catégorie marxiste. Marx appelle le (résultat du -) travail mort ce qui a besoin de travail productif. Par exemple, une matière comme le blé récolté est le résultat d’un travail déjà passé, il lui faut un travail vivant (celui du meunier) pour devenir matière productive. Pour ce qui concerne l’extraction de données, il faut comprendre que l’automatisation de cette extraction, le stockage, le travail de la donnée et la marchandisation sont un seul et même mouvement (on ne marchande pas des jeux de données « en l’air », ils correspondent à des commandes sur une marché tendu). Les données ne sont pas vraiment une matière première, elles ne sont pas non plus un investissement, mais une forme insaisissable du travail à la fois matière première et système technique.↩︎

- On peut distinguer entre économie réelle et économie financière. Voir cette étude de François Morin, juste avant le crack de 2008. François Morin, « Le nouveau mur de l’argent », Nouvelles Fondations, num. 3-4, 2007, p. 30-35.↩︎

- The New York Times Magazine, 13 septembre 1970.↩︎

- Robert Solow, « We’d better watch out », New York Times Book Review, 12 juillet 1987, page 36.↩︎

- Mike Kwet, « Digital Ecosocialism Breaking the power of Big Tech » (ROAR Magazine), trad. Fr. Louis Derrac, sous le titre « Écosocialisme numérique – Briser le pouvoir des Big Tech », parue sur Framablog.org.↩︎

- James Martin et Adrian R. D. Norman, The Computerized Society. An Appraisal of the Impact of Computers on Society over the next 15 Years, Englewood Cliffs, Prentice-Hall, 1970, p. 522.↩︎

- c’est ce que je tâche de montrer dans une partie de mon livre Affaires privées. Aux sources du capitalisme de surveillance : pourquoi fabriquer et acheter des ordinateurs ? Si les entreprises sont passées à l’informatique c’est pour améliorer la production et c’est aussi pourquoi le courtage de données s’est développé.↩︎

- Sur les « tactiques numériques », on pourra lire avec profit l’article de Beatrice Latini et Jules Rostand, « La libre navigation. Michel de Certeau à l’épreuve du numérique », Esprit, 2022/1-2 (Janvier-Février), p. 109-117.↩︎

- Sheila Jasanoff, « Ordering Knowledge, Ordering Society », dans S. Jasanoff (éd.), States of knowledge. The co-production of science and social order, Londres, Routledge, 2004, pp. 13-45.↩︎

- Sur ce point on peut lire avec intérêt ce texte de Ralph Miliband, « Comment lutter contre l’hégémonie capitaliste ? », paru initialement en 1990 et traduit sur le site Contretemps.↩︎

- Voir David Graeber, et Alexie Doucet, Comme si nous étions déjà libres, Montréal, Lux éditeur, 2014. La préfiguration est l’« idée selon laquelle la forme organisationnelle qu’adopte un groupe doit incarner le type de société qu’il veut créer ». Voir aussi Marianne Maeckelbergh, « Doing is Believing: Prefiguration as Strategic Practice in the Alterglobalization Movement », Social Movement Studies, vol. 10, num. 1, 2011, pp. 1‑20.↩︎