CoursdeProfs.fr : une affligeante initiative aveuglément relayée par la grande presse

Lorsque j’ai découvert il y a peu CoursDeProfs.fr j’en suis resté bouche bée. Et j’ai encore du mal à croire qu’on ait pu oser un tel projet, l’un des pires qui ait été lancé dans l’éducation depuis des années. La seule et unique consolation c’est qu’il n’émane pas de l’institution mais du secteur privé.

Lorsque j’ai découvert il y a peu CoursDeProfs.fr j’en suis resté bouche bée. Et j’ai encore du mal à croire qu’on ait pu oser un tel projet, l’un des pires qui ait été lancé dans l’éducation depuis des années. La seule et unique consolation c’est qu’il n’émane pas de l’institution mais du secteur privé.

De quoi s’agit-il exactement ? D’un site qui propose aux enseignants de déposer leurs cours et aux visiteurs de les consulter. « Venez échanger et partager votre savoir », peut-on lire en accueil. Le slogan est au diapason : « Partageons ! »

Sympa, non ? Jusqu’ici tout va bien. Et, sourire aux lèvres, on pense alors naïvement être en présence d’une sorte de forge communautaire de contenus éducatifs, interopérables et sous licences libres. Quelque chose qui ressemblerait à une Académie en ligne qui aurait gommé tous ses défauts, ou plus sûrement à un Sésamath étendu cette fois-ci à toutes les disciplines et à tous les niveaux.

Grossière erreur, car l’état d’esprit qui anime le projet se trouve précisément aux antipodes de ce modèle. Pour tous ceux qui comme nous participent à diffuser le logiciel libre et sa culture au sein de l’Éducation nationale, c’est plus qu’une déception, c’est une véritable provocation.

Prenez le meilleur de Sésamath et Wikipédia en essayant de faire exactement le contraire, et vous obtiendrez CoursDeProfs.fr !

Que ce site rencontre le succès, que les profs embarquent nombreux consciemment ou non dans cette supercherie[1], et je serais obligé de « faire mon Jospin 2002 », c’est-à-dire en prendre acte et quitter séance tenante aussi bien Framasoft que mon métier d’enseignant pour m’en aller cultiver des tomates bios en Ardèche.

Or l’hypothèse n’est pas à exclure quand on voit avec quelle coupable complaisance l’initiative est unanimement relayée et saluée par nos grands médias, illustrant par là-même leur désolante méconnaissance du sujet.

J’ai vainement cherché le moindre début de critique constructive non seulement sur ces mainstream médias mais également dans la blogosphère et je n’ai strictement rien trouvé. C’est ce qui m’a poussé à rédiger ce billet, histoire d’apporter un peu la contradiction (quitte aussi à prendre le risque de leur faire ainsi une injuste publicité).

Ceci étant dit, CoursDeProfs apporte une très mauvaise réponse à d’excellentes questions. Les enseignants souhaitent-ils se regrouper pour créer et échanger ensemble ? Les élèves et leurs parents souhaitent-ils avoir facilement et librement à disposition des ressources éducatives de qualité sur Internet ?

Des médias complices et ignorants

Je tire mon chapeau au service marketing de CoursdeProfs.fr. Non seulement ils ont eu une prestigieuse couverture médiatique mais en plus les articles sont dithyrambiques.

Jugez plutôt :

Le Nouvel Obs : Une plate-forme collaborative pour les profs

Le site CoursDeProfs.fr s’est ouvert officiellement ce lundi 15 mars, pour le plus grand bonheur des enseignants. Concrètement, le site propose aux profs de mettre en commun leurs cours et devoirs avec un seul mot d’ordre : « Partagez vos expériences et vos savoirs ».

Libération : Des cours Net et sans bavures

Vous êtes prof de maths et vous avez déjà fait faire vingt fois les mêmes exercices sur le tracé des triangles aux différentes classes que vous avez eues. Le problème, c’est que vous êtes à court d’idées… Ou alors prof débutant de physique-chimie, vous vous demandez comment organiser la séance de travaux pratiques sur l’utilisation de l’oscilloscope transparent, d’autant que votre classe de terminale S est plutôt dissipée. Rassurez-vous : le site CoursDeProfs.fr, lancé avant-hier, est censé vous aider. Il se présente comme la première plateforme d’échanges de cours entre professeurs. Le but : favoriser « le partage de savoirs et d’expériences » et faire ainsi mentir le cliché selon lequel chaque prof travaille dans son coin sans se soucier de ce que font les autres.

Le Parisien : Des cours gratuits en ligne

Une salle des profs virtuelle, géante et ouverte à tous : où les enseignants peuvent se retrouver et s’échanger leurs cours, où les parents peuvent aussi « débouler » pour retrouver la leçon de maths du fiston absent la semaine dernière, et les élèves venir vérifier qu’ils ont bien noté le cours, voire compléter la leçon… Ce lieu de rêve, c’est l’objectif de Coursdeprof.fr, qui a inauguré hier la première plate-forme communautaire du genre, qui puisse rassembler tous les profs de France autour de leur métier : leur permettre de transmettre leurs connaissances, la somme de tous les cours préparés dans la solitude de leurs bureaux, où ils échouent à nouveau après avoir été dispensés en classe.

L’Entreprise.com (L’Express) : Les profs parlent aux profs

C’est sans doute le premier réseau social fait par des enseignants pour des enseignants. A l’origine de CoursDeProfs.fr. quatre associés : Nicolas Duflos, ingénieur en informatique et télécommunications, inspirateur du projet ; Gabriel Tabart, prof d’EPS, Xavière Tallent, conseil en marketing et communication et Christophe Claudel fondateur de la SII Itelios[2].

Elle : Rattraper les cours manqués sur CoursDeProfs.fr

Un excellent complément pour les profs qui peuvent ainsi « confronter leurs idées et leurs façons de faire » (…) Preuve de son succès, à l’heure où nous écrivons, le site est surbooké et nous invite à nous reconnecter ultérieurement.

La Tribune : Le partage d’expérience fait son chemin chez les enseignants

Les concepteurs espèrent obtenir le label de ressource « reconnue d’intérêt pédagogique » (RIP). Ils déposeront un dossier en ce sens auprès du ministère de l’Education nationale avant l’été[3].

J’ai également noté un passage télé (France 2 – Télématin – 16 mars) et un passage radio (France Culture – Rue des écoles – 17 mars), deux fleurons de notre service… public !

Donc si je résume, « le partage d’expérience fait son chemin chez les enseignants » (La Tribune), un « grand bonheur » (Nouvel Obs), un « lieu de rêve » (Le Parisien) que CourdDeProfs.fr, ce « premier réseau social fait par des enseignants pour des enseignants » (L’Express), cette « première plate-forme d’échanges de cours entre professeurs » (Libération).

Or à y regarder de plus près, le rêve cache peut-être un cauchemar. Et désolé si ce qui va suivre est susceptible de venir un peu gâcher la fête.

Des cours aux multiples verrous artificiels

On sait comment cela se passe. La boîte balance son communiqué de presse et les rédactions choisissent ou non de s’en saisir. Mais lorsqu’elles s’en saisissent, on est en droit d’attendre d’elles un minimum d’investigation, de mise à distance et de contextualisation, en bref faire son boulot de journaliste et non du publireportage.

Et c’est d’autant plus coupable que lorsqu’une startup s’insère dans l’éducation « pour le bien de tous », la vigilance devrait être naturellement de mise (cf les beaux discours de Microsoft à l’école souvent évoqués sur ce blog).

Nos grands médias sont-ils vraiment allés sur CoursDeProfs.fr voir un peu comment cela se déroulait concrètement ? Permettez-moi d’en douter, parce que dans le détail, la plate-forme possède de nombreux et criants défauts.

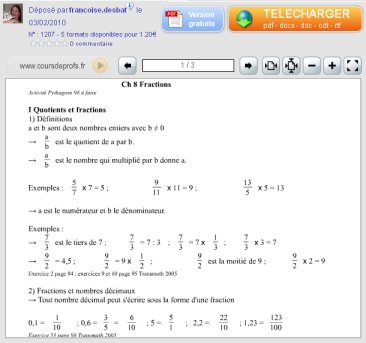

Afin d’illustrer mon propos par l’exemple, j’ai choisi au hasard un document du site dans ma discipline, à savoir les mathématiques.

Afin d’illustrer mon propos par l’exemple, j’ai choisi au hasard un document du site dans ma discipline, à savoir les mathématiques.

Nous sommes en Sixième pour un Cours sur les fractions (cf copie d’écran ci-contre).

Première remarque : ce cours est d’un classicisme absolu. Ouvrez n’importe quel manuel scolaire de ce niveau et ce sera identique mais plus riche et mieux mis en forme et en page. Ici, la valeur pédagogique ajoutée est pour ainsi dire nulle. Cela n’augure rien de bon quant au reste du contenu du site.

Mais regardons surtout comment se présente le document « mis en ligne » afin de mieux comprendre ce qu’on entend par echange, partage et collaboration chez CoursdeProfs.fr.

- Le cours ne possède aucune licence. Par défaut il est donc placé sous le régime du droit d’auteur le plus classique et donc le plus restrictif, c’est-à-dire qu’il est propriété exclusive de son auteur et que vous ne pouvez rien faire avec tant que vous ne lui avez pas demandé l’autorisation. Les licences de type Creative Commons sont ignorées par les créateurs du site alors qu’elles ont justement été conçues pour favoriser le partage.

- Le cours est dans une cage. Il est en effet totalement encapsulé au format propriétaire Flash. On peut certes le voir (en un unique endroit) mais pas le « toucher » puisque, conséquence directe du (mauvais) choix du format, on ne peut ni imprimer le document ni l’enregistrer. Quant à vouloir faire du copier/coller (comme l’autoriserait n’importe quelle page Web rédigée au format standard et ouvert HTML), ce n’est même pas la peine d’y penser.

- Il y a un lien « Version gratuite » en haut à droite. Cliquez dessus et vous obtiendrez un fichier PDF du cours aux caractéristiques un peu particulières puisque entièrement zébré d’un horrible marqueur CoursDeProfs.fr qui recouvre tout le document (cf image ci-dessous) et toujours interdit au copier/coller (alors que tout fichier PDF non vérouillé permet normalement l’opération).

- Il y a également un gros lien « Télécharger » en haut à droite. Cliquez dessus et l’on vous proposera de télécharger le cours aux formats suivants : PDF (enfin modifiable et permettant le copier/coller), DOC, DOCX, ODT et RTF. Sauf qu’il vous en coûtera 1,20 €, (45% pour l’auteur, le reste pour CoursDeProfs.fr). Comme il n’y a que les enseignants qui éprouvent ce besoin de pouvoir modifier et personnaliser le document, on se retrouve à devoir payer un collègue pour jouir pleinement de son cours ! De plus ceci ne vous donne alors qu’un « droit d’usage et de modification du document à des fins personnelles ». En aucun cas vous ne pouvez le copier, l’éditer et le donner à un tiers ou renvoyer la version modifiée sur le site (toujours à cause de l’absence de licence). Cela s’apparente au modèle fermé de l’iTunes d’Apple (DRM inclus). L’amélioration collective des documents est volontairement rendue impossible dans cet écosystème.

Pour rappel les créateurs du site affirment haut et fort dans tous les coins du site que leur projet n’est là que pour favoriser l’échange, le partage et la collaboration !

Mais de qui se moque-t-on ?

Si l’existence même de CoursDeProfs.fr est révélatrice d’une triste situation française, sa médiatisation béate l’est tout autant. Ce n’est pas ici que l’on trouvera des arguments pour nuancer la « crise de la presse ».

Libre comparaison

On ne le répètera jamais assez (surtout que les médias ne l’entendent visiblement toujours pas) : il n’est aujourd’hui pas responsable de développer du contenu collaboratif numérique à l’école sans s’inspirer du logiciel libre et prendre en compte sa culture et ses modes opératoires.

On ne le répètera jamais assez (surtout que les médias ne l’entendent visiblement toujours pas) : il n’est aujourd’hui pas responsable de développer du contenu collaboratif numérique à l’école sans s’inspirer du logiciel libre et prendre en compte sa culture et ses modes opératoires.

Qu’est-ce qu’un logiciel libre ? C’est un logiciel qui possède les quatre libertés fondamentales suivantes : la liberté d’exécuter le programme, la liberté d’étudier le fonctionnement du programme, la liberté de redistribuer des copies, et la liberté d’améliorer le programme et de publier les améliorations. Ce sont des libertés qui sont tournées vers les utilisateurs. La liberté d’étude et d’amélioration nécessite d’avoir accès au code source du programme, c’est-à-dire à son secret de fabrication.

Essayons de transposer cela à la situation en reprenant notre Cours sur les fractions et en l’imaginant donc sous licence libre (par exemple la Creative Commons By dont on a déjà dit le plus grand bien lorsqu’il s’agit d’éducation).

La liberté d’exécuter le programme c’est la liberté de pouvoir lire le cours n’importe où, n’importe quand et sur n’importe quel ordinateur (et non sur un seul site Web). La liberté d’étude correspond à l’accès sans la moindre entrave à la source du document (dans un format ouvert, par exemple ODT, et non sur un PDF bridé), la liberté de copie signifie que vous pouvez copier et distribuer le cours autant de fois que vous le souhaitez à qui vous voulez, enfin la liberté d’amélioration vous autorise à modifier le cours comme bon vous semble et là encore à copier et distribuer cette version modifiée autant de fois que vous le souhaitez à qui vous voulez.

Bien sûr, tout dépend de votre objectif, mais si il s’agit réellement de partager et transmettre du savoir (certains appellent cela l’éducation) alors c’est bien ce dernier modèle qui est le plus pertinent parce qu’il favorise par essence la circulation et la bonification du cours.

Cela figure d’ailleurs noir sur blanc dans la première des douze propositions formulées par l’AFUL (et ignorées par les médias) suite à la publication du rapport Fourgous : « Les logiciels et les ressources numériques acquises, développées ou produites avec participation de fonds publics doivent être placées sous licence libre et disponibles dans un format ouvert afin de permettre leur libre partage : les utiliser, étudier, modifier, redistribuer librement. ».

J’ajoute qu’un tel modèle est centré sur la ressource (qui a un ou plusieurs auteurs) et non sur les auteurs (qui a une ou plusieurs ressources).

On mesure alors l’écart abyssal qui nous sépare de CoursDeProfs.fr puisque, comme nous l’avons vu plus haut, ce dernier ne respecte aucune des quatre libertés.

Ce modèle théorique que nous appelons de nos vœux est-il massivement déployée à l’Éducation nationale ? Non, car nous sommes encore minoritaires. Non car les grands médias nous ignorent encore trop souvent. Mais on y travaille et le temps joue clairement en notre faveur.

Lorsque nous dénonçons les errances de l’Académie en ligne ou les délires juridiques de l’usage des « œuvres protégées » en classe, c’est parce que nous estimons nous en écarter. Lorsque nous mettons en avant des initiatives comme Weblettres ou Sésamath (dont le projet Kidimath s’adresse lui directement et réellement aux élèves soit dit en passant), c’est parce qu’il nous semble nous en approcher.

0/20

En plus d’ignorer superbement la culture libre, la contradiction fondamentale d’un projet comme CoursDeProfs.fr c’est que, ne provenant pas de l’institution mais d’une entreprise privée, il doit nécessairement penser dès le départ son modèle économique. Il y a eu une idée (plutôt bonne du reste), il y a eu dépenses pour la concrétiser et il faut qu’il y ait à plus ou moins court terme retour sur investissement.

Outre le fait que le site affiche déjà de la publicité (Google) et dispose d’un espace annonceurs, ce qui n’est jamais bon lorsque l’on s’adresse à un public scolaire, les créateurs du projet ont imaginé le système complexe et artificiel décrit ci-dessus pour pouvoir tirer quelques subsides de l’aventure.

Un système pervers où les enseignants sont invités à se vendre et s’acheter leurs cours, à faire circuler l’argent entre eux, tout en étant fortement taxés au passage par CoursDeProfs.fr.

C’est indéniable, les enseignant se sont précarisés ces dernières années et les débuts de carrière sont de plus en plus difficiles. Et nombreux sont désormais ceux qui se jettent dans la gueule d’Acadomia et consors pour arrondir les fins de mois. Mais de là à imaginer qu’ils vont se mettre à monnayer leurs cours aux collègues pour que ces derniers puissent les adapter à leurs besoins… Ils ne l’ont jamais fait en salle des profs (qui n’est pas une salle de marché), ils ne vont pas commencer maintenant !

Il faut bien que quelqu’un le dise : CoursDeProfs.fr devrait transformer son projet en, disons, un site de poker en ligne et oublier ses velléités éducatives. J’invite tous les collègues à ne surtout pas y aller. Ce n’est pas à une petite startup de porter sur ses épaules un tel projet qui doit naître et vivre à l’intérieur même du service public qu’est l’Éducation nationale.

Au fait, l’Ardèche, c’est un terreau fertile pour les tomates bios ?

Notes

[1] Crédit photo : Silviadinatale (Creative Commons By)

[2] 1 prof sur 4 parmi les créateurs suffit à leur faire dire que c’est « fait par des enseignants pour des enseignants » !

[3] On saura ainsi si ce label RIP vaut encore quelque chose.

Il y a un peu plus d’une semaine Tristan Nitot

Il y a un peu plus d’une semaine Tristan Nitot  Il y a plus de trois ans déjà le célèbre constructeur d’ordinateurs

Il y a plus de trois ans déjà le célèbre constructeur d’ordinateurs

« Le libre est à la fois une réponse concrète à des problèmes concrets et un outil de réflexion pour penser les problématiques générales de l’immatériel et la connaissance », nous dit ici

« Le libre est à la fois une réponse concrète à des problèmes concrets et un outil de réflexion pour penser les problématiques générales de l’immatériel et la connaissance », nous dit ici