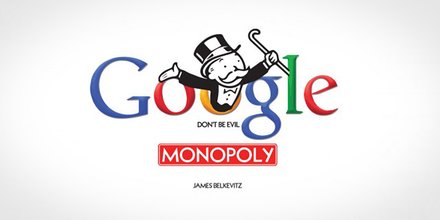

Si Google vous ignore, votre projet est en péril

L’affaire a eu un certain retentissement : une entreprise qui propose du courrier électronique chiffré à ses clients et dont la croissance commence à faire de l’ombre à Gmail disparaît subitement des écrans de radar, ou plutôt des premières pages de la recherche Google, ce qui met en danger son modèle économique.

Aujourd’hui tout est réparé, mais cet épisode illustre une fois de plus le pouvoir de nuisance de Google dans la recherche sur Internet, qui est désormais un tentacule parmi d’autres de la pieuvre Alphabet.

Traduction Framalang : Penguin, goofy, Asta, Rozmador, Lumibd, KoS, xi

Article original sur le site de ProtonMail : Search Risk – How Google Almost Killed ProtonMail

Le risque de la recherche — Comment Google a bien failli faire disparaître ProtonMail

par Andy Yen

Ces deux derniers mois, nombre d’entre vous nous ont contactés pour en savoir plus sur le mystérieux tweet que nous avons envoyé à Google en août. Chez ProtonMail, la transparence est une valeur fondamentale, et nous essayons d’être aussi transparents envers notre communauté que possible. Comme beaucoup de gens continuent à nous poser des questions, nous devons être plus transparents à ce sujet pour éviter toute confusion et spéculation. C’est pourquoi nous racontons toute l’affaire aujourd’hui pour clarifier ce qui est arrivé.

Que s’est-il passé ?

Pour faire court, depuis un an Google ne faisait pas apparaître ProtonMail dans les résultats de recherche (NdT : en langue anglaise) sur les requêtes telles que secure email (e-mail sécurisé) et encrypted email (e-mail chiffré). C’était très suspect car ProtonMail a longtemps été le plus important fournisseur de messagerie chiffrée au monde.

Lorsque la version bêta de ProtonMail a été lancée en mai 2014, notre communauté a rapidement grandi tandis que des gens du monde entier se sont réunis et nous ont soutenu dans notre mission de protection de la vie privée à l’ère numérique. Notre campagne de financement collaboratif a battu tous les records en récoltant plus d’un demi-million de dollars des donateurs et nous a fourni les ressources nécessaires afin d’être compétitifs, même contre les plus gros mastodontes du secteur de l’e-mail.

À l’été 2015, ProtonMail avait passé la barre du demi-million d’utilisateurs et était le service sécurisé de courriels le plus connu au monde. ProtonMail était aussi bien classé à l’époque dans les résultats de recherche de Google, sur la première ou la deuxième page pour la plupart des requêtes comme secure email et encrypted email. Pourtant, à la fin du mois d’octobre 2015, la situation avait complètement changé, et ProtonMail n’apparaissait mystérieusement plus dans les résultats de recherche pour nos deux mots-clefs principaux.

Entre le début de l’été et l’automne 2015, ProtonMail a, il faut le souligner, connu beaucoup de changements. Nous avons lancé ProtonMail 2.0, sommes passés complètement en open source, nous avons lancé des applications mobiles en bêta, et nous avons mis à jour notre site, remplaçant notre ancien domaine de premier niveau .ch par .com, plus connu. Nous avons aussi doublé en taille, atteignant près d’un million d’utilisateurs à l’automne. Tous ces changements auraient dû amélioré le classement de ProtonMail dans les résultats de recherche puisque nous offrions une solution de plus en plus pertinente pour davantage d’utilisateurs.

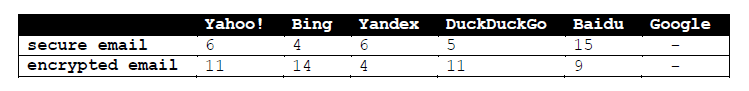

En novembre 2015, nous nous sommes aperçu du problème et avons consulté un certain nombre d’experts en référencement reconnus. Aucun d’entre eux ne pouvait comprendre le problème, en particulier parce que ProtonMail n’a jamais utilisé de tactiques déloyales de référencement, et que nous n’avons jamais observé l’utilisation de ces mêmes techniques contre nous. Mystérieusement, le problème était entièrement restreint à Google, puisque cette anomalie n’était constatée pour aucun autre moteur de recherche. Ci-dessous, le classement dans les résultats de recherche de ProtonMail pour les mots-clefs secure email et encrypted email au début du mois d’août 2016 pour les principaux moteurs de recherche. Nous apparaissons sur la première ou la deuxième page partout sauf pour Google où nous n’apparaissons pas du tout.

Tout au long du printemps 2016, nous avons tenté activement d’établir le contact avec Google. Nous avons créé deux tickets sur leur formulaire de signalement de spam où nous expliquions la situation. Nous avons même contacté le président des Relations Stratégiques EMOA chez Google, mais n’avons ni reçu de réponse ni constaté d’amélioration. Vers cette époque, nous avons aussi entendu parler de l’action liée au droit de la concurrence engagée par la Commission Européenne contre Google, accusant Google d’abuser de son monopole sur les recherches pour abaisser le classement de ses concurrents. Il s’agissait d’une nouvelle inquiétante, car en tant que service de courriels qui valorise d’abord la vie privée des utilisateurs, nous sommes la première alternative à Gmail pour les personnes qui souhaitent que leurs données personnelles restent confidentielles.

Tout au long du printemps 2016, nous avons tenté activement d’établir le contact avec Google. Nous avons créé deux tickets sur leur formulaire de signalement de spam où nous expliquions la situation. Nous avons même contacté le président des Relations Stratégiques EMOA chez Google, mais n’avons ni reçu de réponse ni constaté d’amélioration. Vers cette époque, nous avons aussi entendu parler de l’action liée au droit de la concurrence engagée par la Commission Européenne contre Google, accusant Google d’abuser de son monopole sur les recherches pour abaisser le classement de ses concurrents. Il s’agissait d’une nouvelle inquiétante, car en tant que service de courriels qui valorise d’abord la vie privée des utilisateurs, nous sommes la première alternative à Gmail pour les personnes qui souhaitent que leurs données personnelles restent confidentielles.

En août, à défaut d’autre solution, nous nous sommes tournés vers Twitter pour exposer notre problème. Cette fois, nous avons enfin eu une réponse, en grande partie grâce aux centaines d’utilisateurs de ProtonMail qui ont attiré l’attention sur notre situation et l’ont rendue impossible à ignorer. Quelques jours plus tard, Google nous a informés qu’ils avaient « réparé quelque chose » sans fournir plus de détails. Les résultats ont été visibles immédiatement.

Classement dans les résultats de recherche Google de ProtonMail pour Encrypted Email

Dans le graphique ci-dessus, l’axe des abscisses représente le temps et l’axe des ordonnées le classement dans les résultats (les nombres les plus bas sont les meilleurs). Les dates pour lesquelles il n’y a pas de point correspondent à des moments où nous n’apparaissions pas du tout dans les résultats de Google. Après les quelques changements de Google, le classement de ProtonMail s’est immédiatement rétabli et ProtonMail est maintenant n°1 et n°3 respectivement pour secure email et encrypted email. Sans plus d’explications de la part de Google, nous ne saurons sans doute jamais pourquoi ProtonMail a été déclassé. En tout cas, nous apprécions le fait que Google ait enfin fait quelque chose pour résoudre le problème, nous aurions seulement souhaité qu’ils le fassent plus tôt.

Le risque de la recherche

Cet incident souligne cependant un danger auparavant méconnu que nous appelons maintenant le « Risque de la Recherche ». Le danger est que n’importe quel service comme ProtonMail peut facilement être supprimé par les entreprises qui gèrent les moteurs de recherche, ou le gouvernement qui contrôle ces entreprises. Cela peut même arriver à travers les frontières nationales. Par exemple, même si Google est une société américaine, elle contrôle plus de 90 % du trafic de recherche européen. Dans ce cas précis, Google a directement causé une réduction de la croissance mondiale de ProtonMail de plus de 25 % pendant plus de dix mois.

Cela signifiait que les revenus que Protonmail tirait de ses utilisateurs ont été aussi été réduits de 25 %, mettant de la pression financière sur nos activités. Nous sommes passés de la capacité à couvrir toutes nos dépenses mensuelles à la nécessité de puiser de l’argent de notre fonds de réserve d’urgence. La perte de revenus et les dommages financiers consécutifs ont été de plusieurs milliers de francs suisses (1 CHF = 1,01 USD), qui ne seront jamais remboursés.

La seule raison pour laquelle nous avons survécu pour raconter cette histoire est que la majeure partie de la croissance de ProtonMail provient du bouche à oreille, et que notre communauté est trop active pour l’ignorer. Bien d’autres entreprises ne seront pas aussi chanceuses. Cet épisode montre que bien que les risques en matière de recherche internet sont sérieux, et nous soutenons donc maintenant la commission européenne : compte tenu de la position hégémonique de Google sur la recherche web, plus de transparence et de surveillance sont indispensables.

Se défendre contre le risque de la recherche

Cet épisode démontre que pour que ProtonMail réussisse, il est important que nous puissions nous développer indépendamment des moteurs de recherche, de sorte qu’il devienne impossible pour n’importe quelle entreprise qui gère la recherche de nous paralyser sans le vouloir. Plus facile à dire qu’à faire, mais voici une liste d’actions que nous pouvons tous mener pour préserver l’avenir de ProtonMail :

- Parler de ProtonMail à vos amis et votre famille. Vous en tirerez également un autre avantage : le chiffrement automatique de bout en bout lorsque vous leur enverrez un courriel ;

- Écrire des billets de blog sur ProtonMail et aidez à diffuser le message sur l’importance de la vie privée en ligne ;

- Passer à un compte payant ou faites un don afin que nous puissions reconstituer plus rapidement notre fonds de réserve d’urgence épuisé ;

- Aider ProtonMail à atteindre davantage d’utilisateurs à travers les réseaux sociaux. Vous pouvez tweeter ou partager ProtonMail sur Facebook avec les boutons de partage ci-dessous.

Plus nous diffuserons l’idée que la vie privée en ligne est très importante, plus nous rendrons impossible de supprimer ou interdire les services de messagerie chiffrés tels que ProtonMail, ou d’exercer sur eux une pression quelconque. Nous croyons que la vie privée en ligne est essentielle pour un avenir ouvert, démocratique et libre, et quels que soient les obstacles devant nous, nous allons continuer à élaborer les outils nécessaires pour protéger cet avenir. Nous vous remercions de nous soutenir et de rendre cela possible.

Cordialement,

L’équipe ProtonMail

Depuis un ou deux ans, quelqu’un a sondé les défenses des entreprises qui font tourner des composantes critiques d’Internet. Ces sondes prennent la forme d’attaques précisément calibrées destinées à déterminer exactement comment ces entreprises peuvent se défendre, et ce qui serait nécessaire pour les faire tomber. Nous ne savons pas qui fait cela, mais ça ressemble à un grand État-nation. La Chine ou la Russie seraient mes premières suppositions.

Depuis un ou deux ans, quelqu’un a sondé les défenses des entreprises qui font tourner des composantes critiques d’Internet. Ces sondes prennent la forme d’attaques précisément calibrées destinées à déterminer exactement comment ces entreprises peuvent se défendre, et ce qui serait nécessaire pour les faire tomber. Nous ne savons pas qui fait cela, mais ça ressemble à un grand État-nation. La Chine ou la Russie seraient mes premières suppositions.