HorsCiné, plateforme de films libres et écosystème du cinéma libre en devenir

La plateforme de films libres HorsCiné a fêté ses 3 années d’existence en novembre dernier. On s’est donc saisi de l’occasion pour braquer nos projecteurs sur cette chouette initiative. Pour nous parler de HorsCiné, nous avons donc interviewé Pablo et Tristan, fondateurs de l’association Lent Ciné qui porte ce projet.

Bonjour Pablo et Tristan. Pouvez-vous vous présenter et nous expliquer en quelques phrases ce qu’est HorsCiné ?

P : On est membres (bénévoles) de l’association Lent ciné, une asso de création et diffusion de films libres et de promotion de la culture du libre, qui existe depuis 2016. C’est dans ce cadre qu’on a créé HorsCiné, qui s’est concrétisé fin 2020 avec le lancement de la plateforme. On mène différents projets, et c’est Tristan qui porte celui-ci, alors je vais lui laisser la parole.

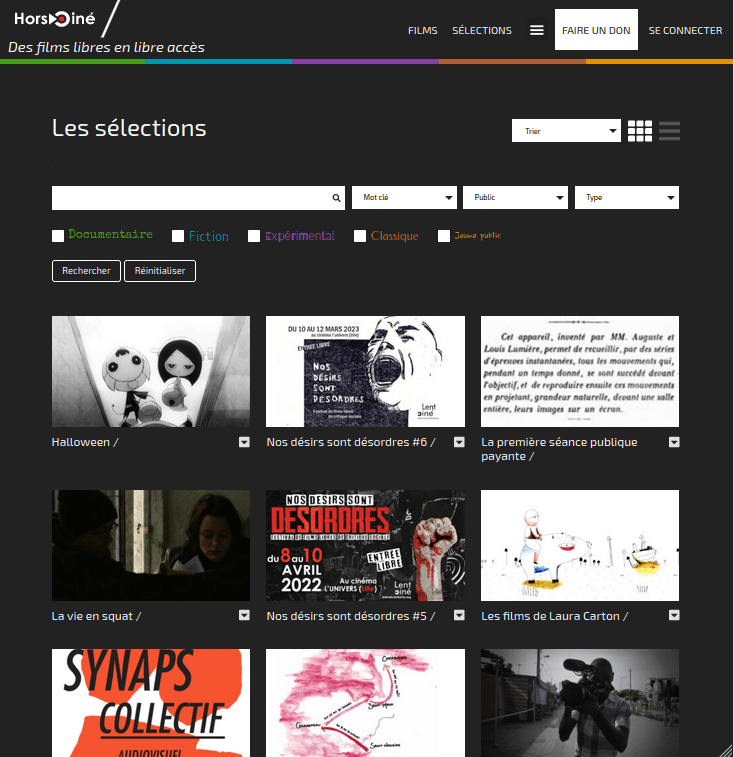

T : HorsCiné, c’est une plateforme de diffusion de films libres indépendante et gratuite. On peut y trouver des centaines de films, courts, moyens et longs-métrages, de la fiction, du documentaire et de l’expérimental, des classiques et des films jeune public. Sur des sujets légers ou très engagés. Parce qu’ils sont libres, ces films restent accessibles, et peuvent être copiés, partagés et diffusés, selon les conditions décidées par leurs auteur⋅rices.

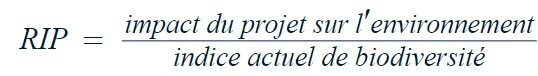

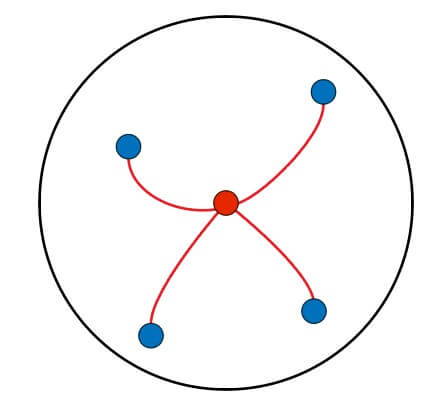

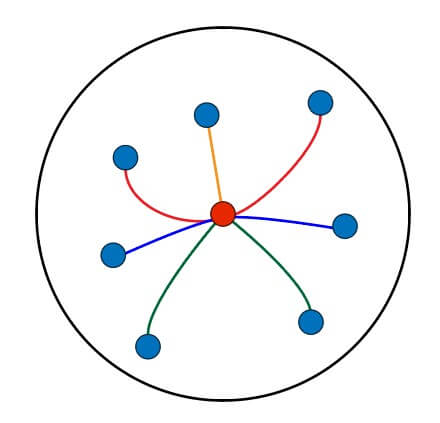

HorsCiné, c’est aussi un projet bien plus large, celui de créer un écosystème du cinéma libre. Pour l’instant on permet au film d’être accessible, mais on souhaite aussi faciliter l’organisation de projections, en mettant en lien les personnes qui créent et celles qui diffusent ou voudraient diffuser (associations, collectifs, médiathèques, centres sociaux, etc.). On souhaite aussi participer à la création d’œuvres, en donnant accès à des ressources et à des moyens. On a créé et animé des ateliers autour des œuvres : création en réutilisant des images et des sons libres, sonorisation de films muets. On a beaucoup d’idées qu’on aimerait voir aboutir.

Que mettez-vous exactement derrière l’expression « films libres » ?

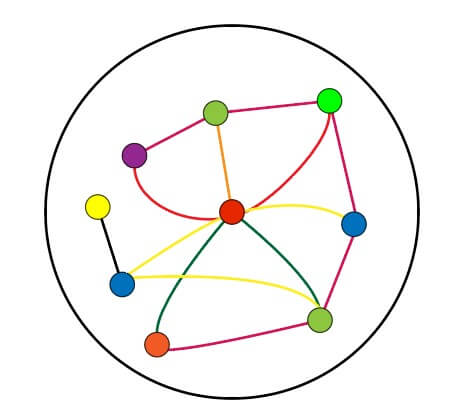

T : Les films libres, ce sont des films qui ont été libérés, plus ou moins partiellement, du droit d’auteur. L’expression films libres est une dénomination générique qui regroupe des films placés sous licence libre ou de libre diffusion et des films entrés dans le domaine public. Schématiquement, en appliquant une licence à son œuvre, son auteur·rice transforme le « tous droits réservés » qui s’applique automatiquement en « certains droits réservés », et donne ainsi la possibilité au public de regarder et partager son film librement. Et parfois plus, comme réutiliser des passages pour créer une nouvelle œuvre. À noter que la plateforme HorsCiné est elle-même sous licence libre (CC BY-SA), chacun⋅e est donc libre de s’en saisir.

Vous vous y prenez comment pour trouver des films libres à référencer ?

P : Depuis 2017, on organise Nos désirs sont désordres, festival de films libres de critiques sociales. On lance chaque année un appel à films. Ça nous a permis de découvrir plein de chouettes films, et de rencontrer des réals et des collectifs qui publient leurs films sous licence libre, comme Synaps ou Ciné 2000, et aussi d’entrer dans des réseaux comme le Réseau d’Ailleurs.

T : Il y a des festivals aussi, comme le Festival Mondial des Cinémas Sauvages qui nous ont simplifié le travail. Et puis ensuite on enquête. On ratisse le web en espérant avoir de la chance. Au début, ça ne marchait pas beaucoup. Et puis à force, on a appris où et comment regarder. Une difficulté, c’est la question des licences : il est parfois difficile de trouver la licence, ou de s’assurer qu’elle émane bien de l’auteur·rice du film. Par exemple sur vimeo, il y a la possibilité de spécifier la licence de la vidéo, mais on s’est rendu compte que ce n’était pas fiable, plein de vidéos sont placés sous une licence sans que les réals ne l’aient fait exprès. Il y a aussi les films du domaine public. Pour les trouver, on passe beaucoup de temps sur wikipedia à vérifier la date de mort de nombreuses personnes, et on a aussi passé beaucoup de temps à trouver les législations de nombreux pays et à comprendre comment elles marchaient et comment elles s’interconnectaient avec le droit français. Et enfin on reçoit régulièrement des films envoyés par leurs auteur·rices depuis le formulaire sur le site.

HorsCiné a fêté ses 3 ans en novembre dernier. Vous nous en dites plus sur l’histoire de ce projet ? Quelles en ont été les différentes étapes ?

T : En 2016, on crée Lent ciné avec l’idée qu’allier le libre et le cinéma, c’est rendre ce dernier plus accessible, tant en terme de création que de diffusion. L’année suivante, on crée le festival Nos désirs sont désordres.

P : Et en 2018, on fait le constat que les films libres ont besoin d’être réunis, parce qu’ils sont dispersés et donc peu visibles. On commence alors à ébaucher ce qu’est HorsCiné. Mais on n’a pas de moyens, et comme on n’a pas de compétence technique vu qu’on ne vient pas du monde de l’informatique, le projet patine.

T : En 2019, on commence à faire une liste de films qu’on publie sur un wiki hébergé par Framasoft qu’on appelle cinélibre. En novembre 2020, après des mois de travail avec un développeur qui finit par nous ghoster, on se retrousse les manches et on bidouille wordpress. On met cette première version en ligne, on y ajoute des films, et on lance un financement participatif pour obtenir de quoi l’améliorer. On obtient quelques articles de presse, et un peu plus de 1000€. Les mois suivants, on continue à l’améliorer en bidouillant et on bosse sur une plateforme plus aboutie avec Christine et Robin de Code Colliders. On rémunère une toute petite partie de leur travail, le reste étant du mécénat. En avril 2022, la version actuelle du site est mise en ligne. En plus d’un meilleur classement des films, on ajoute des sélections et un espace membre. On en a également profité pour changer le logo et l’identité visuelle de HorsCiné, grâce au talent de Valentin. Quelques mois plus tard, un nouveau crowdfunding est lancé, nous offrant environ 1500€. Aujourd’hui, il y a 286 films en ligne et 13 sélections. Et des fonctionnalités permettant de rapprocher les personnes qui créent et les personnes qui diffusent sont toujours en cours de développement.

Si je vais sur HorsCiné, comment je fais pour trouver un film qui me plaise ?

T : La plateforme est pensée autour de cinq catégories : documentaire, fiction, expérimental, classique et jeune public. On classe aussi les films selon le métrage (court, moyen, long), les genres, les thèmes, les âges, les licences et les périodes de sortie. Vous pouvez déjà faire des recherches selon tous ces critères. On ajoute aussi des éléments autour du pays, de la langue et des sous-titres, qui seront disponibles dans la recherche d’une prochaine version du site.

On a aussi créé des sélections de films. Elles sont constituées autour d’un thème, d’une technique, d’une période, d’un genre, des personnes qui créent, qui diffusent ou qui apparaissent dans les films. On en crée, et on peut aussi mettre les vôtres en avant. En effet, on a créé un espace membre, où vous pouvez créer des sélections, les partager, et même les intégrer facilement sur d’autres sites. Dans cet espace membre, vous avez aussi la possibilité d’ajouter des films à vos favoris pour les regarder plus tard.

Vous parlez d’éditorialiser le choix des films à la Une chaque semaine, pouvez-vous nous en dire plus ? Qu’est-ce qui motive votre choix de valoriser ces films ?

T : On ajoute un film par semaine sur HorsCiné, le mercredi midi. Au départ, on ajoutait un avis sur le film, qui expliquait pourquoi on l’a mis en ligne, mais le temps nous manque pour continuer, malheureusement. On propose parfois des interviews des réalisateur·rices, des contextualisations, des zooms thématiques ou techniques, et on renvoie vers d’autres sites où se trouvent des informations sur les films. Et puis on créé des sélections de films, pour les faire dialoguer avec d’autres.

On a cru comprendre que tous les films référencés sur HorsCiné étaient hébergés sur une instance PeerTube. Quel est l’intérêt ? Qui est votre hébergeur ? Ça se passe comment ?

T : Au lancement de la plateforme, on partageait les vidéos depuis les sites de streaming qui les hébergeaient. Mais en plus d’être critiquable sur le plan de la captation des données, des vidéos pouvaient être supprimées sans qu’on ne le sache. On a cherché des solutions et contacté des structures membres du Collectif CHATONS. L’asso belge Domaine Public nous a proposé d’héberger les films sur son instance PeerTube en échange d’une faible cotisation, et on a tout de suite accepté ! Ça fait complètement sens pour nous d’utiliser un logiciel libre, d’autant qu’on a suivi et soutenu (très modestement) son développement depuis le début.

L’intérêt, c’est qu’on a la main sur l’hébergement des vidéos tout en n’ayant pas à gérer la partie technique. PeerTube permet également de clairement indiquer la licence des films dans la description de chaque vidéo, ce qui clarifie les choses. Et surtout vous pouvez maintenant les télécharger en deux clics ! On remercie chaudement Framasoft et Domaine Public pour ça, c’est agréable de dépendre d’associations qui ont les mêmes objectifs et les mêmes valeurs que nous.

Vous êtes combien sur ce projet et vous avez quels moyens ?

T : J’ai envie de répondre « trop peu » pour les deux. HorsCiné, c’est un gros projet qui manque de forces vives et de moyens. Et ça s’explique notamment par le fait que ce soit un projet de niche dans la niche. Le libre, ça parle à de plus en plus de personnes, mais quand même encore trop peu. Le cinéma libre, ça parle à personne ou presque. Je suis la seule personne à m’occuper de la gestion quotidienne du site (le repérage et l’ajout des films, la création des sélections, etc.). Autour gravitent des personnes qui participent plus ponctuellement : Robin pour le développement du site, Max pour la com’ sur les réseaux sociaux. Et puis d’autres sont passées mais n’ont pas pu s’investir durablement. Si le projet vous parle et que vous souhaitez y contribuer, on sera ravi·e de vous accueillir =)

En ce qui concerne les moyens, nous avons reçus 2500€ de dons entre 2020 et 2022 lors de deux crowdfunding. L’année dernière, nous avons sollicité une fondation plutôt que de refaire un financement participatif, mais elle n’a pas donné suite. Nous avons quand même reçu 150€ de dons. On remercie toutes les personnes qui nous ont soutenues.

Évidemment, ce n’est pas assez pour faire vivre un tel projet, même bénévole, et on a dû utiliser des fonds de Lent ciné, qui proviennent de prestations qu’on a réalisées avec Pablo. Et remettre à plus tard beaucoup de choses, notamment la communication.

Si je veux aider la plateforme à se développer, que puis-je faire ?

T : Si vous souhaitez contribuer à HorsCiné, vous pouvez :

- participer à la gestion quotidienne du site : regarder et sélectionner les films, les mettre en ligne, rédiger des contenus sur ces films, rédiger des articles, tenir à jour la FAQ, rédiger des documents sur les licences libres et le domaine public, développer de nouvelles fonctionnalités (en nous contactant)

- proposer des films

- faire connaitre HorsCiné en partageant le site (on est aussi sur les principaux réseaux sociaux, dont mastodon) et en en parlant autour de vous (et notamment aux profs, médiathécaires, membres d’assos et de collectifs, animateur·rices de centres sociaux, etc.)

- diffuser les films de la plateforme (en respectant les licences)

- faire un don

HorsCiné est donc l’un des nombreux projets de l’association Lent ciné. On vous avait déjà interviewés en février 2020 sur le framablog à l’occasion de la campagne de financement participatif du projet Sortir du cadre. On en est où de ce projet là ? Quelles sont les dernières actualités de l’association ?

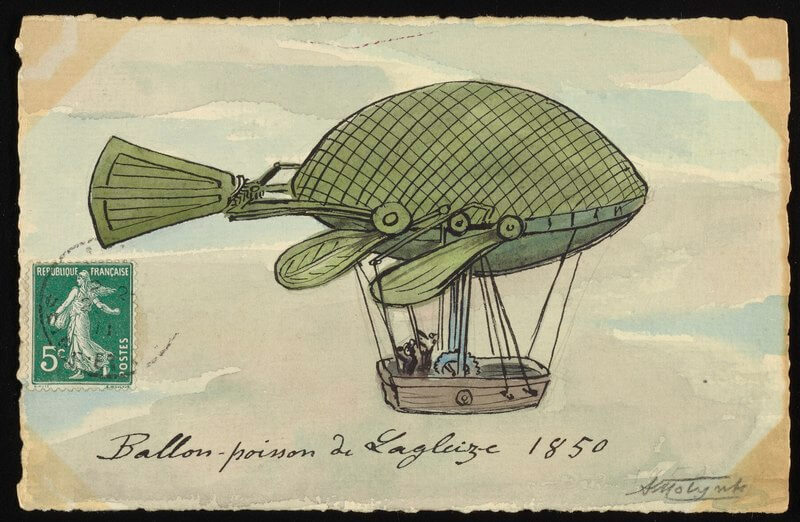

P : Pour commencer, ce projet là a changé de nom, il ne s’appelle plus Sortir du Cadre mais Share Alike. Le projet documentaire a bien évolué depuis cet article du framablog, notamment sur la forme. On a décidé de changer de format pour que ce soit plus simple à diffuser et que ça puisse toucher plus de monde. Maintenant c’est une série de 9 (ou 10, on n’est pas encore décidés) épisodes d’une quinzaine de minutes chacun. Sur le fond, il y a peu de choses qui ont changé si ce n’est qu’on a un peu élargi le sujet. Ça ne parle plus uniquement de l’utilisation des licences libres dans l’art mais aussi du système économique global de la création artistique.

On a commencé à tourner en mai 2022 et après avoir sillonné la France pendant presque deux ans, le tournage touche bientôt à sa fin ! On est hyper contents des personnes qu’on a pu rencontrer à travers ce projet là et des témoignages qu’on a réussi à récolter. Il reste toute la post-production à faire et ça ne va pas être une mince affaire. On a pas trop envie de se prononcer sur une date de sortie mais ce qu’on aimerait, c’est que ça sorte avant 2025.

Pour finir cette interview, auriez-vous quelques films à nous recommander ?

P :

- Caillou de Manue Fleytoux et Jules Ribis

- #Cloud de David Kajman

- Asilah de Joseph Paris

- Fiertés, inc. de Thibault Jacquin

T :

- Dynamique et motivé de Malou Lévêque

- How men propose de Lois Weber et Phillips Smalley (sonorisé lors d’un atelier)

- Le grand ordinaire de Mathieu Kiefer

- Rinocerontes y bestias negras de Manue Fleytoux

- Le carnaval des âmes de Herk Harvey

Merci beaucoup pour vos réponses. On espère que les lectrices et lecteurs auront désormais le réflexe de se tourner vers HorsCiné lorsqu’iels auront envie de regarder un film ! D’ailleurs, on les invite à nous partager dans les commentaires leurs coups de cœur ! Et longue vie à la plateforme HorsCiné !