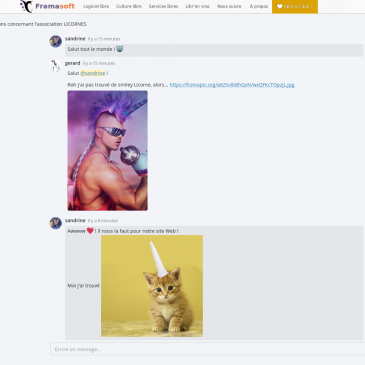

Framateam : libérez vos équipes des groupes Facebook (et de Slack)

Voilà un service de discussion qui se destinait, au départ, aux « dév », aux gens qui codent. Mais quand nous avons vu ses incroyables possibilités, on s’est dit que ce serait dommage que la famille Dupuis-Morizeau passe à côté… Prêts à … Lire la suite