À quoi ça sert de s’activer sur Internet ? Doctorow répond à Morozov

Cory Doctorow est souvent traduit sur ce blog car c’est l’une des rares personnalités qui pense l’Internet et agit en conséquence pour qu’il conserve ses promesses initiales d’ouverture et de partage.

Cory Doctorow est souvent traduit sur ce blog car c’est l’une des rares personnalités qui pense l’Internet et agit en conséquence pour qu’il conserve ses promesses initiales d’ouverture et de partage.

Il a rédigé un long mais passionnant article dans The Guardian qui prend appui sur un lecture (très) critique du récent mais déjà fort commenté livre The Net Delusion: The Dark Side of Internet Freedom de Evgeny Morozov.

Chercheur biélorusse à l’université de Georgetown et chroniqueur dans plusieurs journaux, Morozov remet radicalement en question, dans son ouvrage, le pouvoir libérateur d’Internet.

On peut le voir exposer son point de vue dans cette courte conférence au format TED : Comment Internet aide les dictatures, qui constitue un excellent préambule à ce qui va suivre.

Morozov y dénonce la « cyberutopie » qui draperait la technologie de vertus émancipatrices intrinsèques, comme celle d’être nécessairement vecteur de démocratie pourvu que l’information circule sans entrave (source Rue89). Une « cyberutopie » issue de l’ignorance ou de la paresse intellectuelle de nos contemporains, qui se laissent aller au « web-centrisme » en imaginant que toutes les questions qui se posent dans nos sociétés peuvent être résolues par le prisme d’Internet (source Webdorado). Cliquer sur « J’aime » ou rejoindre une cause sur Facebook, relayer frénétiquement une information non vérifiée sur Twitter, n’ont jamais révolutionné la société,

On comprendra dès lors aisément que le « net-activiste » Cory Doctorow ait pris sa plume pour répondre dans le détail à l’argumentaire de Morozov.

Internet n’est certainement pas synonyme de libération. Mais ce réseau possède des caractéristiques particulières qui font qu’il ne ressemble à rien de ce que l’on a connu auparavant. Raison de plus pour se battre afin de conserver son principe de neutralité et faire en sorte qu’il échappe au contrôle des États et aux logiques mercantiles des entreprises privées.

Wikileaks et ses anonymous[1], hier la Tunisie, l’Égypte aujourd’hui… L’actualité récente n’est pas évoquée, mais il semblerait qu’elle penche plutôt du côté de Doctorow que de celui de Morozov.

Nous avons besoin d’une critique sérieuse de l’activisme sur le Net

We need a serious critique of net activism

Cory Doctorow – 25 janvier 2011 – The Guardian

(Traduction Framalang : Penguin, Barbidule, Gilles, Siltaar, e_Jim, Goofy et Don Rico)

« Net Delusion » (NdT : que l’on pourrait traduire par « Les mirages du Net » ou « Internet, la désillusion ») avance la thèse que la technologie ne profite pas nécessairement à la liberté, mais par quel autre moyen les opprimés se feront-ils entendre ?

Net Delusion est le premier livre de l’écrivain et blogueur d’origine biélorusse Evgeny Morozov, dont le thème de prédilection est la politique étrangère. Morozov s’est bâti une réputation de critique pointu, et parfois mordant, d’Internet et du « cyber-utopisme », et ” Net Delusion ” développe les arguments qu’il a déjà présentés ailleurs. J’ai lu avec intérêt l’exemplaire que j’ai reçu en service de presse. J’apprécie Evgeny, lors de nos rencontres et de nos échanges de courriers, il m’a donné l’impression d’être intelligent et engagé.

Au cœur du livre, on trouve des remarques extrêmement judicieuses. Morozov a tout à fait raison lorsqu’il souligne que la technologie n’est pas intrinsèquement bonne pour la liberté, qu’on peut l’utiliser pour entraver, surveiller et punir, aussi facilement que pour contourner, libérer et partager.

Hélas, ce message est noyé au milieu d’une série d’attaques confuses et faiblement argumentées contre un mouvement « cyber-utopique » nébuleux, dont les points de vue sont évoqués en termes très généraux, souvent sous la forme de citations de CNN et d’autres agences de presse censées résumer un hypothétique consensus cyber-utopique. Dans son zèle à discréditer cette thèse, Morozov utilise tous les arguments qu’il peut trouver, quelle que soit leur faiblesse ou leur inanité, contre quiconque fait mine de soutenir que la technologie est libératrice.

Le rôle de Twitter

Morozov tente d’abord de remettre les pendules à l’heure sur le rôle qu’a joué Twitter lors des dernières élections iraniennes. On a présenté partout le réseau de microblogage comme un outil fondamental pour les initiatives de l’opposition sur le terrain, mais par la suite, il est apparu clairement que les Iraniens d’Iran n’avaient été présents que marginalement sur Twitter, bien qu’ils aient utilisé beaucoup d’autres outils de diffusion et que ceux-ci aient été en effet essentiels dans la réaction à l’élection iranienne.

Morozov décrit minutieusement le fait que beaucoup des trois millions d’Iraniens expatriés sont en effet actifs sur Twitter, et que c’est ce trafic, ainsi que les messages de sympathie d’utilisateurs non-iraniens, qui ont fait de l’élection iranienne et de ses conséquences un évènement majeur sur Twitter.

Il décrit également les liens étroits que ces expatriés ont avec leur famille en Iran, grâce à d’autres outils tels que Facebook. Mais il manque d’en conclure que les informations issues de Twitter ont trouvé écho sur Facebook (et vice-versa) via les Iraniens de l’étranger. Il préfère considérer que les millions d’expatriés Iraniens publiant des messages sur Twitter sont tellement isolés de leur proches relations sur Facebook que ces messages n’ont eu presque aucun impact.

Presque aucun, mais un impact quand même. Morozov poursuit en citant Golnaz Esfandiari, une correspondante de Radio Free Europe en Iran, « déplorant la complicité pernicieuse de Twitter qui a permis aux rumeurs de se propager » en Iran pendant la crise. J’ai été choqué de lire cela dans l’ouvrage de Morozov : comment Twitter pourrait-il être « complice » de la propagation de rumeurs ; Esfandiari or Morozov attendaient-ils des fournisseurs de services sur Internet qu’ils censurent de façon pro-active les contributions des utilisateurs avant de les laisser se diffuser librement sur ur leurs réseaux ? Et si c’était le cas, Morozov pensait-il vraiment que Twitter deviendrait un meilleur soutien de la liberté sur Internet en s’auto-proclamant censeur ?

Cela m’a tellement stupéfait que j’ai envoyé un e-mail à Morozov pour lui demander ce que le lecteur était censé y comprendre au juste. Morozov m’a répondu que d’après lui Esfandiari ne s’était pas exprimée clairement ; elle voulait dire que c’étaient les utilisateurs de Twitter qui étaient « complices » de la propagation des rumeurs. C’est sans doute mieux, mais sans preuves que Twitter n’est fait que pour propager de fausses rumeurs, cela ne suffit pas pour inculper Twitter. Pourquoi alors ce passage figure-t-il dans le livre – sachant que Morozov n’a cessé d’affirmer dans les pages précédentes qu’aucune information postée sur Twitter n’avait atteint l’Iran – si ce n’est comme un pan de la stratégie qui consiste à discréditer les « cyber-utopistes » en balançant tous les arguments possibles en espérant que certains tiennent debout ? Et je pense que c’est le cas : par la suite, Morozov reproche à la « culture Internet » la « persistance de nombreuses légendes urbaines », une idée fort singulière puisque des chercheurs spécialisés en légendes urbaines, tels que Jan Brunvand, ont montré que de nombreuses légendes urbaines contemporaines proviennent du Moyen-Âge et ont prospéré sans avoir besoin d’Internet comme moyen de reproduction.

Technologie et révolution

Morozov est sceptique quant à la capacité de la technologie à déclencher des révolutions et étendre la démocratie. Pour renverser un régime corrompu, dit-il, avoir librement accès à l’information n’est ni nécessaire, ni même important – c’est une antienne des Reaganistes avec leur vision romantique de Samizdat, Radio Free Europe et autres efforts d’information remontant à la guerre froide. L’Union soviétique ne s’est pas effondrée à cause d’un mouvement politique, de courageux dissidents ou de tracts photocopiés – elle s’est écroulée parce qu’elle était devenue un cauchemar mal géré qui a chancelé de crise en crise jusqu’à l’implosion finale.

En effet, le libre accès aux médias étrangers (comme en bénéficiaient les citoyens de RDA qui pouvaient capter les programmes d’Allemagne de l’Ouest) a souvent contribué à désamorcer le sentiment anti-autoritaire, anesthésiant les Allemands de l’Est avec tant d’efficacité que même la Stasi avait fini par chanter les louanges de la décadente télévision occidentale.

L’ironie, c’est que Morozov – involontairement, mais avec vigueur – rejoint sur ce point ses adversaires idéologiques, comme Clay Shirky, le professeur de l’université de New York que Morozov critique lourdement par ailleurs. Les travaux de Shirky – notamment le dernier en date, The Cognitive Surplus – parviennent exactement aux mêmes conclusions au sujet des médias occidentaux traditionnels, et en particulier de la télévision. Shirky soutient que la télé a principalement servi à atténuer le poids de l’ennui né de l’accroissement du temps de loisirs aux premiers jours de l’ère de l’information. Pour Shirky, Internet est palpitant parce qu’il constitue justement l’antidote à cette attitude de spectateur passif, et qu’il constitue un mécanisme incitant les gens à la participation au travers d’une succession d’engagements toujours plus importants.

Régulation et contrôle

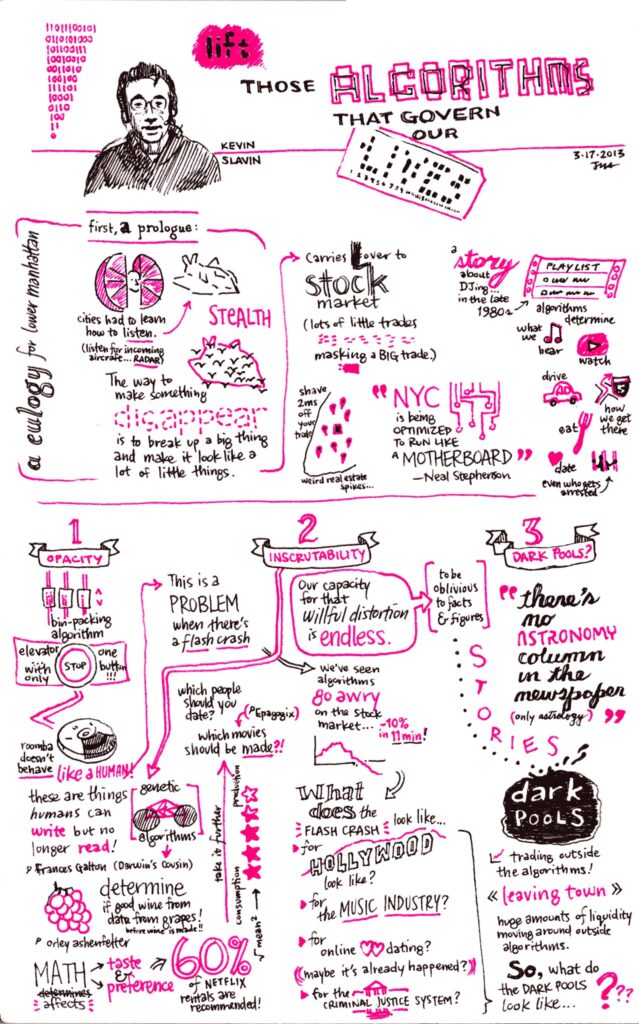

Morozov ne discute cependant pas cette position en profondeur. En fait, quand il examine enfin Internet en tant que tel, indépendamment des réseaux téléphoniques, des programmes télé et des autres médias, il se contente de tourner en ridicule les « gourous de la technologie », qui « révèlent leur méconnaissance de l’histoire » lorsqu’ils se lancent dans des « tirades quasi-religieuses à propos de la puissance d’internet ». Il illustre cette caricature par un florilège de citations stupides, soigneusement choisies parmi deux décennies de discours sur Internet, mais il laisse soigneusement de côté tout le travail sérieux sur l’histoire du Net en tant que média pleinement original – et notamment, il oublie de mentionner ou de réfuter la critique posée par Timothy Wu dans l’excellent livre The Master Switch, paru l’an dernier.

Wu, professeur de droit des télécommunications, retrace avec mordant l’histoire de la régulation des médias en réponse à la possible décentralisation des monopoles et oligopoles dans les télécommunications. Replacé dans ce contexte, Internet apparaît véritablement comme un phénomène original. Morozov sait bien sûr qu’Internet est différent, il le reconnaît lui-même lorsqu’il parle de la manière dont le Net peut imiter et supplanter d’autres médias, et des problèmes que cela engendre.

C’est là que réside la plus sérieuse faiblesse de Net Delusion : dans ce refus de se confronter aux meilleurs textes sur le thème d’Internet et de sa capacité extraordinaire à connecter et émanciper. Quand Morozov parle des menaces pour la sécurité des dissidents lorsqu’ils utilisent Facebook – ce qui revient à faire de jolies listes de dissidents prêtes à être utilisées par les polices secrètes des États oppresseurs – il le fait sans jamais mentionner le fait que, de longue date, des avertissements pressants sur ce sujet ont été lancés par l’avant-garde des « cyber-utopistes », incarnée par des groupes comme l’Electronic Frontier Foundation, NetzPolitik, Knowledge Ecology International, Bits of Freedom, Public Knowledge, et des dizaines d’autres groupes de pression, d’organisations d’activistes et de projets techniques dans le monde entier.

Bien évidemment, presqu’aucune mention n’est faite des principaux défenseurs de la liberté du Net, tel que le vénérable mouvement des cypherpunks, qui ont passé des décennies à concevoir, diffuser et soutenir l’utilisation d’outils cryptographiques spécialement conçus pour échapper au genre de surveillance et d’analyse du réseau qu’il identifie (à juste titre) comme étant implicite dans l’utilisation de Facebook, Google, et autres outils privés et centralisés, pour organiser des mouvements politiques. Bien que Morozov identifie correctement les risques que les dissidents prennent pour leur sécurité en utilisant Internet, son analyse technique présente des failles sérieuses. Lorsqu’il avance, par exemple, qu’aucune technologie n’est neutre, Morozov néglige une des caractéristiques essentielles des systèmes cryptographiques : il est infiniment plus facile de brouiller un message que de casser le brouillage et de retrouver le message original sans avoir la clé.

Battre la police secrète à son propre jeu

En pratique, cela signifie que des individus disposant de peu de ressources et des groupes dotés de vieux ordinateurs bon marché sont capables de tellement bien chiffrer leurs messages que toutes les polices secrètes du monde, même si elles utilisaient tous les ordinateurs jamais fabriqués au sein d’un gigantesque projet s’étalant sur plusieurs décennies, ne pourraient jamais déchiffrer le message intercepté. De ce point de vue au moins, le jeu est faussé en faveur des dissidents – qui jouissent pour la première fois du pouvoir de cacher leur communication hors d’atteinte de la police secrète – au détriment de l’État, qui a toujours joui du pouvoir de garder ses secrets ignorés du peuple.

La façon dont Morozov traite de la sécurité souffre d’autres défauts. C’est une évidence pour tous les cryptologues que n’importe qui peut concevoir un système si sécurisé que lui-même ne peut pas trouver de moyen de le casser (ceci est parfois appelé la « Loi de Schneier », d’après le cryptologue Bruce Schneier). C’est la raison pour laquelle les systèmes de sécurité qui touchent à des informations critiques nécessitent toujours une publication très large et un examen des systèmes de sécurité par les pairs. Cette approche est largement acceptée comme la plus sûre, et la plus efficace, pour identifier et corriger les défauts des technologies de sécurité.

Pourtant, lorsque Morozov nous relate l’histoire de Haystack, un outil de communication à la mode censé être sécurisé, soutenu par le ministère américain des Affaires étrangères, et qui s’est révélé par la suite totalement non-sécurisé, il prend pour argent comptant les déclarations du créateur de Haystack affirmant que son outil devait rester secret car il ne voulait pas que les autorités iraniennes fassent de la rétro-ingénierie sur son fonctionnement (les vrais outils de sécurité fonctionnent même lorsqu’ils ont fait l’objet d’une rétro-ingénierie).

Au lieu de cela, Morozov concentre ses critiques sur l’approche « publier tôt, publier souvent » (NdT : Release early, release often) des logiciels libres et open source, et se moque de l’aphorisme « avec suffisamment de paires d’yeux, les bugs disparaissent » (NdT appelé aussi Loi de Linus). Pourtant, si cela avait été appliqué à Haystack, cela aurait permis de révéler ses défauts bien avant qu’il n’arrive entre les mains des activistes iraniens. En l’occurrence, Morozov se trompe complètement : si l’on veut développer des outils sécurisés pour permettre à des dissidents de communiquer sous le nez de régimes oppressifs, il faut largement rendre public le fonctionnement de ces outils, et les mettre à jour régulièrement au fur et à mesure que des pairs découvrent de nouvelles vulnérabilités.

Morozov aurait bien fait de se familiariser avec la littérature et les arguments des technologues qui s’intéressent à ces questions et y ont réfléchi (les rares fois où il leur accorde son attention c’est pour se moquer des fondateurs de l’EFF : Mitch Kapor pour avoir comparé Internet à un discours de Jefferson, et John Perry Barlow pour avoir écrit une Déclaration d’indépendance du cyberespace). Certains des experts les plus intelligemment paranoïaques au monde ont passé plus de vingt ans à imaginer les pires scénarios catastrophes technologiquement plausibles, tous plus effrayants que les spéculations de Morozv – comme son hypothèse farfelue selon laquelle la police secrète pourrait un jour prochain avoir la technologie pour isoler des voix individuelles dans un enregistrement de milliers de manifestants scandant des slogans, pour les confronter à une base de données d’identités.

Surveiller les surveillants

Le tableau que dépeint Morozov de la sécurité des informations est trompeusement statique. Notant que le web a permis un degré de surveillance alarmant par des acteurs commerciaux tels les réseaux de publicité, Morozov en tire la conclusion que cette sorte de traçage sera adoptée par les gouvernements adeptes de censure et d’espionnage. Mais les internautes sensibles à la menace des publicitaires peuvent sans difficulté limiter cet espionnage à l’aide de bloqueurs de pub ou de solutions équivalentes. Il est déplorable qu’assez peu de personnes tirent avantage de ces contre-mesures, mais de là à supposer que les dissidents sous des régimes répressifs auront la même confiance naïve dans leur gouvernement que le client moyen envers les cookies de traçage de Google, il y a un pas énorme à franchir. Dans l’analyse de Morozov, votre vulnérabilité sur le web reste la même, que vous ayez un a priori bienveillant ou hostile à l’égard du site que vous visitez ou du mouchard qui vous préoccupe.

Morozov est également prêt à faire preuve d’une improbable crédulité lorsque cela apporte de l’eau à son moulin – par exemple, il s’inquiète du fait que le gouvernement chinois ait imposé d’installer un programme de censure obligatoire, appelé « barrage vert », sur tous les PC, même si cette manœuvre a été tournée en ridicule par les experts en sécurité du monde entier, qui ont prédit, à raison, que cela serait un échec lamentable (si un programme de censure n’est pas capable d’empêcher votre enfant de 12 ans de regarder du porno, il n’empêchera pas des internautes chinois éduqués de trouver des informations sur Falun Gong). Dans le même temps, Morozov oublie complètement d’évoquer les projets de l’industrie du divertissement consistant à exploiter l’« informatique de confiance » dans le but de contrôler l’utilisation de votre PC et de votre connexion à Internet, ce qui constitue une menace plus crédible et plus insidieuse pour la liberté du Net.

Morozov n’est pas le seul à avoir cette vision erronée de la sécurité sur Internet. Comme il le fait remarquer, l’appareil diplomatique occidental regorge d’imbéciles heureux prenant leurs désirs pour la réalité en matière de technologie. L’experte de la Chine Rebecca MacKinnon, que l’auteur cite tout au long de Net Delusion, raille l’obstination aveugle des ingénieurs et des diplomates à percer les pare-feux de la censure (comme la « grande e-muraille de Chine »), alors même qu’ils négligent d’autres risques beaucoup plus importants et pernicieux que le politburo de Pékin fait peser sur la liberté. Si Net Delusion a pour but d’amener le corps diplomatique à écouter d’autres groupes d’experts, ou d’inciter la presse généraliste à mieux rendre compte des possibilités de la technologie, je suppose que c’est admirable. Mais je crois que Morozov espère toucher des personnes au-delà de la Maison Blanche, Bruxelles, ou Washington ; j’ai l’impression qu’il espère que le monde entier va cesser d’attendre de la technologie qu’elle soit une force libératrice, pour plutôt faire confiance à… à quoi donc ?

Je n’en suis pas sûr. Morozov voudrait semble-t-il voir le chaos des mouvements populaires remplacé par une espèce d’activisme bien ordonné et impulsé depuis le sommet, mené par des intellectuels dont les réflexions ne peuvent pas s’exprimer de manière concise dans des tweets de 140 caractères. Morozov se voit-il lui-même comme l’un de ces intellectuels ? Voilà un point qui n’est jamais exprimé clairement.

Il est important de se poser la question de la place des discours sérieux à l’ère d’Internet, et Morozov essaie ici d’étayer ses arguments techniques avec des arguments idéologiques. De son point de vue, Internet n’est que le dernier avatar d’une série de technologies de communication qui ne propagent que futilités, rumeurs et inepties, évinçant ainsi les pensées et les réflexions sérieuses. Il n’est pas le premier à remarquer que des médias qui livrent des informations à un rythme effréné conduisent à réfléchir de manière rapide et papillonnante ; Morozov cite le livre de Neil Postman publié en 1985, « Amusing Ourselves to Death » (NdT : « Se distraire à en mourir »), mais il aurait tout aussi bien pu citer Walden ou la vie dans les bois, de Henry David Thoreau : « Nous sommes prêts à creuser un tunnel sous l’Atlantique pour rapprocher de quelques semaines l’Ancien monde du Nouveau ; mais la première nouvelle qui passera jusqu’aux oreilles américaines sera sans doute que la princesse Adélaïde a la coqueluche. »

« Internet nous rendra stupide »

En d’autres termes, les intellectuels se sont de tout temps lamentés sur la futilisation inhérente aux médias de masse – je ne vois pas de grande différence entre les arguments de l’Église contre Martin Luther (permettre aux laïcs de lire la Bible va futiliser la théologie) et ceux de Thoreau, Postman et Morozov qui prétendent qu’Internet nous rend stupides car il nous expose à trop de « LOLCats ».

Mais comme le fait remarquer Clay Shirky, il existe une différence fondamentale entre entendre parler de la santé de la princesse Adélaïde grâce au télégraphe ou suivre les rebondissements de Dallas à la télévision, et faire des « LOLCats » sur le Net : créer un « LOLCat » et le diffuser dans le monde entier est à la portée de tous. Autrement dit, Internet offre la possibilité de participer, d’une manière que les autres médias n’avaient même jamais effleurés : quiconque a écrit un manifeste ou une enquête peut les mettre largement à disposition. Dans un monde où chacun est en mesure de publier, il devient plus difficile, c’est vrai, de savoir à quoi il faut prêter attention, mais affirmer que la liberté serait mieux servie en imposant le silence à 90% de la population afin que les intellectuels aient le champ libre pour éduquer les masses est complètement stupide.

Pourtant, Morozov présente comme un inconvénient la facilité à publier en ligne. D’abord parce que d’après lui les futilités finissent par submerger les sujets sérieux, ensuite parce que des cinglés nationalistes anti-démocratie peuvent utiliser le Net pour attiser la haine et l’intolérance, et enfin parce que les difficultés que l’on rencontrait autrefois pour s’organiser politiquement constituaient un moyen en soi de forger son engagement, les risques et les privations associés à la dissidence renforçant la résolution des opposants.

Il est vrai qu’Internet a mis à portée de clic plus de futilités que jamais auparavant, mais c’est seulement parce qu’il a mis à portée de clic davantage de tout. Il n’a jamais été aussi simple qu’aujourd’hui de publier, lire et participer à des discussions sérieuses et argumentées. Et même s’il existe une centaine (ou un millier) de Twitteurs futiles pour chaque blog sérieux et pertinent, du genre de Crooked Timber, il existe davantage de points d’entrée pour des discussions sérieuses – que ce soit sur des blogs, des forums, des services de vidéo, ou même sur Twitter – qu’il n’y en a jamais eu auparavant dans toute l’histoire de l’humanité.

Il est tentant d’observer toute cette diversité et d’y voir une caisse de résonance dans laquelle les personnes ayant les mêmes points de vue étriqués se rassemblent et sont toutes d’accord entre elles, mais un coup d’œil rapide sur les débats enflammés qui sont la marque de fabrique du style rhétorique d’Internet suffit pour nous en dissuader. En outre, si nous étions tous enfermés dans une caisse de résonance se limitant à une mince tranche de la vie publique, comment se fait-il que toutes ces futilités – vidéos marrantes de Youtube, coupures de presse people fascinantes et liens vers l’étrange et le saugrenu – continuent à parvenir jusqu’à nos écrans ? (Morozov essaie ici d’avoir le beurre et l’argent du beurre, en nous prévenant que nous sommes à la fois en danger de nous noyer dans des futilités, et que l’effet de caisse de résonance va tuer la sérendipité).

Je suis moins inquiet que Morozov sur le fait que le Net fournisse un refuge aux fous littéraires à tendance paranoïaque, aux racistes hyper-nationalistes et aux hordes de tarés violents. Les gens qui croient en la liberté d’expression ne doivent pas s’affliger du fait que d’autres utilisent cette liberté pour tenir des propos mauvais, méchants ou stupides ; comme le dit le mantra de la libre expression : « La réponse à de mauvaises paroles est davantage de paroles ».

Pour la liberté

Sur ce point également Internet n’est pas neutre, et penche plutôt en faveur des défenseurs de la liberté. Les gouvernements puissants ont toujours eu la possibilité de contrôler la parole publique par le biais de la censure, des médias officiels, de la tromperie, des agents provocateurs et de bien d’autres moyens visibles ou invisibles. Mais ce qui est original, c’est que les oligarques russes utilisant Internet pour faire de la propagande sont désormais obligés de le faire en utilisant un média que leurs opposants idéologiques peuvent également exploiter. A l’époque soviétique, les dissidents se limitaient d’eux-mêmes à des chuchottements et des samizdat copiés à la main ; de nos jours, leurs héritiers peuvent lutter à armes égales avec les propagandistes de l’Etat sur le même Internet, un lien plus loin. Bien sûr, c’est risqué, mais le risque n’est pas nouveau (et la création et l’amélioration d’outils permettant l’anonymat, ouverts et validés par des pairs, ouvre de nouvelles perspectives en terme de limitation des risques) ; ce qui est nouveau c’est le remplacement de canaux de propagande unidirectionnels, comme la télévision (qu’elle diffuse des contenus de l’Est ou de l’Ouest) par un nouveau média qui permet de placer n’importe quel message à côté de n’importe quel autre grâce à des concepts puissants comme les hyperliens.

Je partage avec Morozov l’ironie de la situation lorsque les radicaux islamistes utilisent Internet pour honnir la liberté, mais alors que Morozov trouve ironique que les outils de la liberté puissent être utilisés pour embrasser la censure, je trouve ironique que pour se faire entendre, des apprentis-censeurs s’appuient sur le caractère universellement accessible d’un des médias les plus difficiles à censurer jamais conçus.

Sur le fait que la privation est fondamentale pour renforcer l’engagement des activistes, je suis confiant dans le fait que pour chaque tâche automatisée par Internet, de nouvelles tâches, difficiles à simplifier, vont apparaître et prendre leur place. En tant qu’activiste politique durant toute ma vie, je me souviens des milliers d’heures de travail que nous avions l’habitude de consacrer à l’affichage sauvage, au remplissage d’enveloppes ou aux chaînes téléphoniques simplement dans le but de mobiliser les gens pour une manifestation, une pétition ou une réunion publique (Morozov minimise la difficulté de tout cela, lorsqu’il suppose, par exemple, que les Iraniens apprendraient par le bouche à oreille qu’une manifestation va avoir lieu, quels que soient les outils disponibles, ce qui m’amène à croire qu’il n’a jamais essayé d’organiser une manifestation à l’époque où Internet n’existait pas). Je suis convaincu que si nous avions eu la possibilité d’informer des milliers de gens d’un simple clic de souris, nous ne serions pas ensuite rentrés tranquillement chez nous ; ce travail besogneux engloutissait la majeure partie de notre temps et de notre capacité à imaginer de nouvelles façons de changer les choses.

En outre, Morozov ne peut pas gagner sur les deux tableaux : d’un côté, il tire le signal d’alarme à propos des groupes extrémistes et nationalistes qui sont constitués et motivés par le biais d’Internet en vue de réaliser leurs opérations terrifiantes ; et quelques pages plus loin, il nous dit qu’Internet facilite tellement les choses que plus personne ne sera suffisamment motivé pour sortir de chez lui pour faire quoi que ce soit de concret.

Morozov observe les centaines de milliers voire les millions de personnes qui sont motivées pour faire quelques minuscules pas pour le soutien d’une cause, comme par exemple changer son avatar sur Twitter ou signer une pétition en ligne, et il en conclut que la facilité de participer de façon minime a dilué leur énergie d’activiste. J’observe le même phénomène, je le compare au monde de l’activisme tel que je l’ai connu avant Internet, dans lequel les gens que l’on pouvait convaincre de participer à des causes politiques se chiffraient plutôt en centaines ou en milliers, et je constate que tous les vétérans de l’activisme que je connais ont commencé en effectuant un geste simple, de peu d’envergure, puis ont progressivement évolué vers un engagement toujours plus fort et plus profond ; j’en arrive donc à la conclusion que le Net aide des millions de personnes à se rendre compte qu’ils peuvent faire quelque chose pour les causes qui leur tiennent à cœur, et qu’une partie de ces personnes va continuer et en faire toujours plus, petit à petit.

Le pouvoir libérateur de la technologie

La plus étrange des thèses soutenues dans Net Delusion est que la confiance que place l’Occident dans le pouvoir libérateur de la technologie a mis la puce à l’oreille des dictateurs – qui n’étaient auparavant pas intéressés par le contrôle du Net – et a rendu Internet plus difficilement utilisable dans un but de propagation de la liberté. Morozov cite en exemple la réponse des autorités Iraniennes aux affirmations outrancières qu’a tenu le Département d’État américain sur le rôle qu’aurait joué Twitter dans les manifestations post-électorales. Selon Morozov, les hommes politiques au pouvoir en Iran étaient en grande partie indifférents au Net, jusqu’à ce que les Américains leur annoncent que celui-ci allait causer leur perte, suite à quoi ils prirent sur eux de transformer Internet en un outil d’espionnage et de propagande à l’encontre de leurs citoyens.

Morozov fait ensuite état de divers dirigeants, comme Hugo Chávez, qui ont utilisé la rhétorique des USA pour appuyer leurs propres projets concernant Internet.

Il accuse également Andrew Mc Laughlin, conseiller technique adjoint du gouvernement des États-Unis, d’avoir fourni des munitions aux dictateurs du monde entier en déclarant publiquement que les compagnies de télécommunications américaines censurent en secret leurs réseaux, car cela a permis aux dictateurs de justifier leurs propres politiques.

C’est peut-être le passage le plus bizarre de Net Delusion, car il revient à dénoncer le fait qu’un homme politique américain combatte la censure sur le territoire national, au prétexte que les dictateurs étrangers seront réconfortés d’apprendre qu’ils ne sont pas les seuls à pratiquer la censure. Il me semble peu vraisemblable que Morozov veuille véritablement que les hommes politiques occidentaux ferment les yeux sur la censure opérée dans leurs pays de peur que l’écho des imperfections de l’Occident ne parvienne à des oreilles hostiles.

Dans la foulée, Morozov nous prévient que les dictateurs ne sont ni des imbéciles ni des fous, mais plutôt des politiciens extrêmement retors, et techniquement très éclairés. Je pense qu’il a raison : la caricature occidentale dépeignant les dictatures comme des idiocraties criminelles vacillantes ne coïncide tout simplement pas avec les réalisations techniques et sociales de ces États – et c’est justement pourquoi je pense qu’il a tort sur les relations entre les dictatures et Internet. Le pouvoir découle directement de mécanismes de communication et d’organisation, et Internet est là depuis suffisamment longtemps pour que tout autocrate accompli en ait pris note. L’idée que l’élite gouvernante de l’Iran n’ait pris conscience du pouvoir d’Internet que lorsque le ministère des affaires étrangères des États-Unis ont publiquement demandé à Twitter de modifier son planning de maintenance (afin de ne pas interférer avec les tweets liés aux élections en Iran) me paraît aussi ridicule que la surestimation, par ce même ministère des affaires étrangères, de l’influence que peut avoir Twitter sur la politique étrangère. Les activistes qui ont fait attention à la manière dont les États autoritaires interfèrent dans l’utilisation d’Internet par leurs citoyens, savent que la méfiance – et la convoitise – à l’égard du pouvoir d’Internet s’est développée dans les dictatures du monde entier depuis le moment où l’opinion publique s’est intéressée à Internet.

Le véritable problème dans la présentation que Morozov fait des « net-utopistes » est qu’ils n’ont rien en commun avec le mouvement que je connais intimement et dont je fais partie depuis une décennie. Là où Morozov décrit des personnes qui voient Internet comme une « force uni-directionnelle et déterministe allant soit vers une émancipation globale, soit vers une oppression globale » ou « qui refusent de reconnaître que le Web peut tout autant renforcer les régimes autoritaires que les affaiblir », je ne vois que des arguments spécieux, des caricatures inspirées des gros titres de CNN, des extraits sonores de porte-paroles de l’administration américaine, et des réparties de conférence de presse.

Tous ceux que je connais dans ce mouvement – des donateurs aux concepteurs d’outils, en passant par les traducteurs, des activistes de choc aux mordus de l’ONU – savent qu’Internet représente un risque tout autant qu’une opportunité. Mais contrairement à Morozov, ces personnes ont un plan pour minimiser les risques émanant de l’utilisation d’Internet (ceci explique pourquoi il y a tant de campagnes autour de la vie privée et des problèmes de censure provenant des logiciels propriétaires, des services de réseaux sociaux et des systèmes centralisés de collecte de données comme Google) et pour maximiser son efficacité en tant qu’outil d’émancipation. Ce plan implique le développement de logiciels libres et la diffusion de pratiques qui garantissent un meilleur anonymat, des communications plus sécurisées, et même des outils abstraits comme des protocoles réseau à divulgation nulle de connaissance qui permettent une large propagation des informations à travers de vastes groupes de personnes sans révéler leurs identités.

Morozov a raison d’affirmer que les hommes politiques occidentaux ont une vue simpliste du lien entre Internet et la politique étrangère, mais ce n’est pas simplement un problème de politique étrangère, ces mêmes hommes politiques ont incroyablement échoué à percevoir les conséquences d’Internet sur le droit d’auteur, la liberté d’expression, l’éducation, l’emploi et tous les autres sujets d’importance. Morozov a raison de dire que les métaphores dignes de la Guerre Froide comme « Grande muraille électronique » occultent autant qu’elles dévoilent (Net Delusion vaut son prix ne serait-ce que pour sa brillante démonstration que les dictatures utilisent autant les « champs » que les « murs » dans leurs stratégies Internet, et que ceux-ci demandent à être « irrigués » plutôt que « renforcés » ou « démolis »).

Mais dans son zèle à éveiller les décideurs politiques aux nuances et aux aspects non-techniques de la politique étrangère, il est approximatif et paresseux. Il affirme que ce qui différencie Internet d’un fax de l’époque des samizdat, c’est qu’Internet est utile tout autant aux oppresseurs qu’aux opprimés – mais je n’ai jamais rencontré de bureaucrate qui n’aimait pas son fax.

Et bien que Morozov tienne à nous montrer que « ce ne sont pas les tweets qui font tomber les gouvernements, c’est le peuple », il déclare ensuite allègrement que le bloc soviétique s’est désagrégé de lui-même, et pas à cause du peuple, qui n’a eu aucun rôle dans cet inévitable coup de balai de l’Histoire. Morozov croit peut-être que c’est exact dans le cas de l’URSS, mais étant donné qu’une large part du reste du livre est consacrée à la situation difficile des dissidents sur le terrain, je pense que l’on peut affirmer que même Morozov serait d’accord avec lui-même pour dire que, parfois, le peuple joue un rôle dans le renversement des régimes autoritaires.

Pour parvenir à ce but, les dissidents ont besoin de systèmes pour communiquer et s’organiser. Toute entreprise humaine qui nécessite le travail de plusieurs personnes doit consacrer une certaine partie de ses ressources au problème de la coordination : Internet a simplifié grandement ce problème (rappelez-vous les heures consacrées par les activistes au simple envoi de cartes postales contenant les informations au sujet d’une prochaine manifestation). En cela, Internet a donné un avantage substantiel aux dissidents et aux outsiders (qui ont, par définition, moins de ressources de départ) par rapport aux personnes détenant le pouvoir (qui, par définition, ont amassé suffisamment de ressources pour en engloutir une partie dans la coordination et en conserver encore suffisamment pour gouverner).

Internet permet à d’avantage de personnes de s’exprimer et de participer, ce qui signifie inévitablement que les mouvements de protestation vont avoir un ensemble d’objectifs plus diffus qu’à l’époque des révolutions autoritaires orchestrées par le haut. Mais Morozov idéalise le consensus des révolutions passées – que ce soit en 1776, 1914 ou 1989, chaque révolution réussie est une fragile coalition d’intérêts et de points de vue antagonistes, rassemblés par le désir commun d’abolir l’ancien système, même s’il n’y a pas de consensus sur ce qui doit le remplacer.

Désormais, Internet est devenu tellement intégré au fonctionnement des États du monde entier qu’il semble difficile d’accorder crédit à la crainte de Morozov selon laquelle, en cas de menace révolutionnaire sérieuse, les gouvernements débrancheraient simplement la prise. Comme Morozov lui-même le fait remarquer, la junte brutale de Birmanie a laissé fonctionner Internet en permanence pendant les violentes répressions des émeutes politiques, en dépit de la désapprobation mondiale qu’elle a subie du fait des compte-rendus diffusés sur Internet; la Chine dépend tellement du Net pour son fonctionnement interne qu’il est impossible d’envisager une coupure du Net à l’échelle nationale (et les coupures régionales, comme celle de la province du Xinjiang pendant les émeutes des Ouïghours, sont justement remarquables par leur caractère exceptionnel).

Le monde a besoin de plus de personnes œuvrant à l’amélioration du sort des activistes qui utilisent Internet (c’est-à-dire de tous les activistes). Nous avons besoin d’un débat sérieux au sujet des tactiques comme les DDoS (distributed denial-of-service attack ou attaques distribuées par déni de service) – qui inondent les ordinateurs avec de fausses requêtes pour les rendre inaccessibles – que certains ont comparés à des sit-in. En tant que personne arrêtée lors de sit-ins, je pense que cette comparaison est fausse. Un sit-in ne tire pas uniquement son efficacité du blocage des portes de tel endroit blâmable, mais de la volonté affichée de se tenir devant ses voisins et d’assumer le risque d’une arrestation ou de blessures au bénéfice d’une cause juste, ce qui confère une légitimité éthique à la démarche et facilite l’adhésion. En tant que tactique, les DDoS s’apparentent plus à de la super glu dans les serrures d’une entreprise ou au sabotage des lignes de téléphone – risqué, c’est certain, mais plus proche du vandalisme et donc moins susceptible de rallier vos voisins à votre cause.

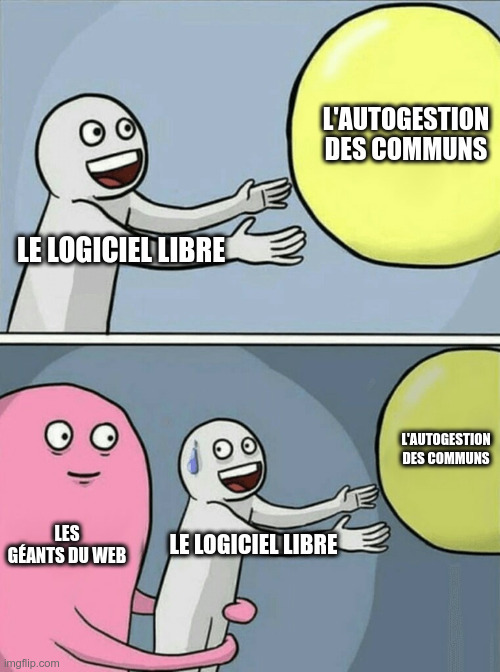

Nous devons réparer l’Internet mobile, qui – reposant sur des réseaux et des appareils fermés – est plus propice à la surveillance et au contrôle que l’Internet filaire. Nous devons nous battre contre les manœuvres– menées par les entreprises du divertissement et les géants de l’informatique comme Apple et Microsoft – consistant à concevoir des machines dont le fonctionnement est secret et échappe au consentement de leur propriétaire, au prétexte de protéger le copyright.

Nous devons prêter attention à Jonathan Zittrain (un autre universitaire que Morozov tout à la fois rejette puis rejoint sans même s’en rendre compte), dont « Le Futur d’Internet » met en garde sur le fait que l’augmentation des crimes, escroqueries et autres fraudes sur le Net fatigue l’utilisateur et rend les gens plus enclins à accepter d’utiliser des appareils et des réseaux verrouillés, pouvant être utilisés aussi bien pour les contrôler que pour les protéger.

Nous avons besoin de tout cela, et surtout d’une critique sérieuse et d’une feuille de route pour l’avenir de l’activisme sur le Net, car les régimes répressifs du monde entier (y compris les soit-disant gouvernements libres de notre Occident) usent pleinement des nouvelles technologies à leur avantage, et le seul moyen pour l’activisme d’être efficace dans cet environnement est d’utiliser les mêmes outils.

Notes

[1] Crédit photo : Anonymous9000 (Creative Commons By)

En ces temps troublés où fait rage le débat (ou plutôt la lutte en ce qui nous concerne) sur l’adoption du projet de loi Hadopi, où l’engagement et l’indignation des uns se heurte à l’indifférence, à la mauvaise foi ou à l’entêtement forcené des autres, il est bon d’avoir l’avis d’un artiste, un écrivain en l’occurrence, qui sait de quoi il parle.

En ces temps troublés où fait rage le débat (ou plutôt la lutte en ce qui nous concerne) sur l’adoption du projet de loi Hadopi, où l’engagement et l’indignation des uns se heurte à l’indifférence, à la mauvaise foi ou à l’entêtement forcené des autres, il est bon d’avoir l’avis d’un artiste, un écrivain en l’occurrence, qui sait de quoi il parle.