Cet article fait partie du dossier Wikipédia et éducation : un exemple de réconciliation.

C’est la traduction du témoignage de l’enseignant qui est ici présentée.

Introduction de Wikipédia dans les salles de classe : le loup est-il dans la bergerie ?

Was introducing Wikipedia to the classroom an act of madness leading only to mayhem if not murder?

Jon Beasley-Murray – avril 2008 – Wikipédia

(Traduction Framalang : Olivier)

Réflexions sur l’utilisation de Wikipédia dans le cadre du cours SPAN312 à l’Université de la Colombie Britannique, « Murder, Madness, and Mayhem: Latin American Literature in Translation » (NdT : « Meurtre, Folie et Chaos : la littérature latino-américaine en mouvement »), printemps 2008.

Wikipédia : mal aimée mais omniprésente dans l’éducation

Tel un membre non invité, Wikipédia s’aventure aujourd’hui très près du monde universitaire. Les objectifs de Wikipédia sont éminemment académiques : l’encyclopédie se focalise sur la collecte, le traitement, l’enregistrement et la transmission du savoir. À en juger par le nombre d’articles et de lecteurs, elle a particulièrement bien réussi à encourager une culture de curiosité intellectuelle. Elle est pourtant régulièrement sujette aux critiques formulées par les universitaires eux-mêmes.

Et pourtant tout le monde en fait usage d’une manière ou d’une autre, même si c’est difficile à admettre. Et surtout, nos étudiants l’utilisent, ouvertement ou non (puisqu’on leur impose souvent de ne pas citer les articles de Wikipédia dans leurs travaux), mais sans nécessairement en connaître véritablement le fonctionnement. On leur dit que l’usage de Wikipédia n’est pas conseillé, mais on leur dit rarement pourquoi, alors qu’eux la voient comme une ressource incroyablement utile.

La consigne : créer un « Article de Qualité »

J’ai décidé de faire de Wikipédia un axe central d’une matière que j’enseignais, en pensant que c’est seulement en y contribuant activement que les élèves découvriraient ses points faibles et ses points forts. J’avais aussi en tête l’idée qu’ils pourraient par la même occasion améliorer les articles dans un domaine qui à mes yeux manquait cruellement de contenu, en l’occurrence la littérature latino-américaine.

Wikipédia devait être un point important du cours mais sans en être pour autant l’essentiel. Ce n’était pas un cours sur Wikipédia mais, comme mes autres cours, il devait plutôt se concentrer sur l’Amérique Latine ainsi que sur la lecture d’un corpus de textes littéraires d’Amérique Latine. Dans ce cours intitulé « Murder, Madness, and Mayhem » (NdT : Meurtre, Folie et Chaos), les textes choisis comportaient une série de romans sur la dictature de la période du dix-neuvième siècle avec l’argentin Domingo Faustino Sarmiento jusqu’à l’époque contemporaine avec certains des auteurs d’Amérique Latine les plus en vue comme Gabriel García Márquez et Mario Vargas Llosa. Ces livres n’étant ni simples ni courts, les étudiants devaient passer une bonne partie de leur temps personnel à la lecture, la majeure partie du temps en classe étant consacrée aux explications et à la discussion.

Wikipédia n’était que peu abordé durant les cours. La tâche qui leur était assignée était plutôt d’éditer (ou, dans deux cas, de créer), en groupe, les articles de Wikipédia se rapportant aux œuvres et aux auteurs étudiés. Au cours de la session ils devaient réussir à faire obtenir à ces articles ce qu’on nomme dans le jargon Wikipédia le grade d’Article de Qualité.

Lorsque je leur ai assigné cette tâche je ne réalisais pas à quel point c’était ambitieux. Wikipédia définit un Article de Qualité comme un article qui « représente ce que l’on peut de trouver de mieux, et qui répond à des standards professionnels d’écriture et de présentation ». Et ces standards placent de fait la barre très haut. C’est manifestement un des paradoxes de Wikipédia : ses standards sont irréprochables alors même que la majeure partie de son contenu en est fort éloigné. Pour vous donner une idée, moins de 0,1% des articles de Wikipédia possèdent le label Article de Qualité.

En effet, alors que Wikipédia a déjà fait l’objet de nombreux projets pédagogiques au sein d’universités aussi dispersées que celles de Sydney, Hong-Kong, Minnesota et Leiden, c’était à ma connaissance la première fois qu’on demandait explicitement à des étudiants de créer des Articles de Qualité.

Considérations initiales : les avantages de Wikipédia

En plus d’enseigner (même indirectement) aux étudiants les faiblesses et les forces de Wikipédia et en même temps (peut-être incidemment) d’améliorer le contenu de l’encyclopédie concernant l’Amérique Latine, d’autres raisons plus positives venaient étayer ce choix de travail.

L’idée que les étudiants se lançaient dans un projet concret ayant des effets tangibles et publics, à défaut d’être éternels, me plaisait. Après tout, une dissertation ou un examen est un parfait exemple de travail inutile : souvent rédigé à la hâte pour un lecteur unique, le professeur, et ensuite mis de côté.

Je trouve regrettable qu’à de rares exceptions près, comme par exemple dans les ateliers d’écriture, les étudiants ne soient pas plus encouragés à relire et à réfléchir à leur propre travail, où trop souvent ils ne font que jeter un coup d’œil aux commentaires que le professeur aura laborieusement griffonné. C’est compréhensible, puisqu’ayant à ce stade très peu de chances de pouvoir retravailler leur devoir, ils ne s’intéressent alors qu’à leur note et c’est tout. Les étudiants ne découvrent que rarement l’importance des corrections dans un bon travail d’écriture. Alors qu’au contraire, sur Wikipédia, les corrections font (presque) tout : les contributeurs sont appelés « éditeurs » justement parce que leurs écrits sont en permanence au stade de la correction.

De plus ils participeraient à l’élaboration de pages qui, pour certaines (l’article sur Gabriel García Márquez par exemple), reçoivent plus de 60 000 visiteurs par mois. Même les articles les moins visités sur lesquels ils travaillaient recevaient plusieurs centaines de visites par mois. Ici ils écrivaient des articles pour un lectorat ayant la possibilité rare de répondre, de ré-écrire et de commenter le contenu qu’ils produisaient. En effet, travailler sur Wikipédia ouvre la porte au travail collaboratif : les étudiants devaient non seulement collaborer entre eux, mais aussi avec d’autres éditeurs ou des wikipédiens qu’ils ne rencontraient que sur le wiki.

Pour finir, l’idée même que l’attribution de la note soit extérieure à la classe m’attirait. L’idée que le travail soit jaugé à l’aune de son impact et non par le jugement personnel d’un professeur (aussi professionnel soit-il) me plaisait. Dès le départ, j’ai établi avec eux que les groupes qui réussiraient à faire obtenir à leur article la mention Article de Qualité seraient notés A+, c’est aussi simple que ça. Ceux qui atteignaient la mention Bon Article (la barre est placée moins haut, mais les Bons Articles ne représentent tout de même que 0,15% de tous les articles de Wikipédia en anglais) recevraient un A. La note pour ce devoir, en d’autres termes, serait déterminée par l’appréciation collective et publique des autres auteurs.

Considérations initiales : pièges potentiels

J’avoue que je n’ai pas beaucoup pris en considération les écueils de ce plan. Je reconnais que c’était un peu une expérience, mais la tenter me rendait enthousiaste. Ce n’était de toute façon pas le seul point sur lequel le cours serait noté et l’évaluation ne reposerait pas entièrement dessus : les étudiants devaient également tenir à jour un blog hebdomadaire sur leurs lectures et rendre deux devoirs, un à mi-session et un autre à la fin.

(En fin de compte le devoir de fin de session a été abandonné à la majorité des 2/3 de la classe après un vote des étudiants à bulletin secret : 85% d’entre eux ont voté pour l’annulation du devoir final et pour un plus gros coefficient du travail sur Wikipédia.)

J’avais surtout peur que les étudiants soient pris dans une guerre d’édition non constructive et potentiellement décourageante. Une guerre d’édition est un débat sans fin entre des éditeurs qui n’arrivent pas à s’accorder sur le contenu de l’article. Comme dans beaucoup d’interactions en ligne, ces désaccords deviennent rapidement désagréables et provoquent l’intervention d’un administrateur de Wikipédia qui peut décider de « bloquer » l’un des individus impolis, voire les deux. Je n’étais que trop conscient de ce problème puisque dans mes tentatives d’exploration de Wikipédia quelques mois avant de donner ce cours, je me suis retrouvé (plutôt par inadvertance) pris dans de telles guerres, et je me suis fait bloquer pendant quelque temps.

C’est toujours un peu risqué d’amener les étudiants à interagir directement avec la sphère publique. Et, d’une certaine manière, nous devons veiller sur eux. C’est peut-être la raison pour laquelle tellement de technologies de l’éducation (dont WebCT est le meilleur exemple) sont hermétiquement isolées du « monde réel ». Et ça ne serait pas très productif si l’un de mes étudiants se retrouvait bloqué et ne pouvait pas poursuivre son travail ! J’ai donc croisé les doigts en espérant que cette éventualité ne se présente pas.

Premiers pas : « notre » projet se met en route

Wikipédia ne m’était pas totalement inconnue puisque j’avais déjà à mon actif de nombreuses éditions d’articles et même quelques créations (même si ces derniers n’étaient rien d’autre que des ébauches, des versions courtes et préliminaires). Mais jusque là je n’avais pas encore travaillé de manière durable sur un article de Wikipédia. Et bien que j’avais quand même un sentiment de familiarité ainsi qu’un certain sens de la culture Wikipédia, j’avoue que j’étais malgré tout (et le suis d’ailleurs toujours) perplexe devant certains des détails les plus impénétrables des techniques et procédures de ce qui est maintenant devenu une gigantesque et labyrinthique entreprise.

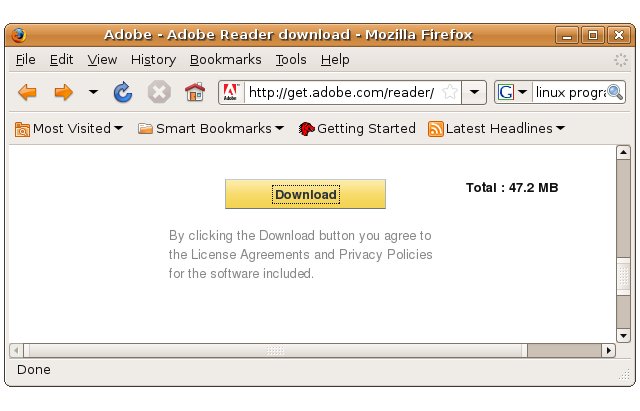

D’un autre côté, cela m’a permis de comprendre l’intimidation que les élèves ne manqueraient pas de ressentir devant la tâche qui se présentaient à eux. Seuls un ou deux étudiants avaient déjà fait des modifications sur Wikipédia et ils étaient peu nombreux à montrer des signes de familiarité avec les conventions du Web. Et ne parlons même pas du code spécifique à Wikipédia (même si celui-ci est simplifié). Je crois que je peux comprendre leur étonnement quand, ayant cliqué pour la première fois sur le bouton « Modifier », ils sont tombés sur une masse confuse de gribouillis caractéristiques des logiciels de wiki.

Pour poser les bases du projet et obtenir du soutien, j’ai enregistré le projet sur une page Wikipédia dédiée à ce genre de choses, j’ai fait apparaître sur tous les articles du projet qu’ils faisaient partie d’une tâche pédagogique, et j’ai démarré une « page projet » décrivant nos objectifs. J’ai aussi laissé des messages sur d’autres projets Wikipédia jugés connexes (principalement des groupes d’éditeurs de Wikipédia qui se concentrent sur un sujet particulier comme par exemple la littérature ou l’Amérique du Sud); j’ai même laissé un mot au journal maison de l’encyclopédie, le Wikipédia Signpost (NdT : le Wikimag en français). J’ai ensuite présenté le projet à la classe, demandé aux étudiants de se créer un compte sur Wikipédia et j’ai croisé les doigts pour que ça marche.

Vous avez peut-être remarqué que je parle de « notre » projet et de « nos » objectifs. J’essaie en général d’inclure tout le monde quand je parle en classe : « nous » lisons les textes « ensemble », « nous » essayons de comprendre comment les interpréter. Mais ici la sensation était presque palpable : dès le départ je sentais que je faisais aussi partie du projet, sentiment qui n’ira qu’en s’amplifiant dans les semaines suivantes.

Leçon numéro 1 : « ceci pourra être effacé »

Assez rapidement, quand tout le monde fut censé s’être enregistré et avoir commencé à jouer un peu avec les modifications, j’ai apporté mon ordinateur en cours et j’ai présenté les bases aux étudiants. Raccordé à un vidéoprojecteur, je leur ai montré sur grand écran où se trouve l’onglet « Modifier », comment faire une modification mineure (en changeant un mot sur la page Wikipédia de notre université) et comment faire une modification majeure (en vaporisant un article associé à l’université qui était manifestement un plagiat d’un autre site Web).

Un élève m’a par la suite demandé de leur montrer comment créer une nouvelle page. Deux des articles sur lesquels ils travaillaient n’existaient pas alors et j’ai alors décidé de créer El Señor Presidente, dont le seul contenu initial était : « El Señor Presidente est le titre d’un roman de Miguel Ángel Asturias ». J’ai ensuite poursuivi sur d’autres pages avant de revenir à celle-ci quelques instants plus tard… et c’était tout pour la première leçon. Sauf que, à mon grand embarras (et devant la classe entière) j’ai découvert qu’en à peine une minute d’autres éditeurs de Wikipédia avaient déjà collé une énorme bannière rose sur notre tout frais nouvel article avec la mention suivante : « Cette page est susceptible de remplir les critères de Wikipédia pour suppression rapide ». « Les salauds ! » murmurai-je dans ma barbe et je me suis dépêché de modifier le contenu de l’article pour y afficher « El Señor Presidente est le titre du roman le plus important du romancier, lauréat du prix Nobel, Miguel Ángel Asturias », inquiet que notre petit projet se fasse torpiller à peine commencé.

Si j’avais voulu montrer aux étudiants que la modification de Wikipédia est un exercice de négociation avec l’entière communauté d’éditeurs et de lecteurs, je n’aurais pas pu mieux choisir mon exemple. J’ai découvert (depuis) que pour d’autres projets pédagogiques sur Wikipédia, les étudiants sont souvent encouragés à faire un brouillon de leurs articles à l’abri des regards et de les enregistrer sur les pages publiques uniquement lorsqu’ils sont prêts à affronter un examen général. Ici tout était exposé et ouvert dès le début. Mais je n’ai aucun regret. C’est en effet là que le projet a puisé certains de ses meilleurs atouts.

La FA-Team : synergies, du bon et du mauvais

Mais on a rapidement eu un gros coup de chance, alors même que les messages que j’avais envoyés aux différents projets Wikipédia pré-existants semblaient lettre morte (la plupart, d’après ce que j’ai pu voir, étant enterrés ou plus souvent simplement débordés). Il s’est en effet trouvé qu’un groupe d’éditeurs expérimentés de Wikipédia avait commencé à lancer des idées pour augmenter le nombre d’Articles de Qualité sur Wikipédia. Ils se sont baptisés la « FA-Team » (NdT : L’équipe des Articles de Qualité, FA pour Featured Articles) et cherchaient alors un projet auquel participer. Or ils « nous » ont repéré et nous ont écrit pour savoir si nous désirions un coup de main.

Est-ce que nous désirions un coup de main ? Évidemment !

La FA-Team s’est répartie les articles du projet, ils ont laissé des messages d’accueil sur la page de discussion de chaque étudiant (les pages personnelles spécifiques à chaque utilisateur enregistré de Wikipédia et qui fonctionnent comme des pages où les éditeurs peuvent entrer en contact directement avec l’utilisateur) et ils ont débuté leur mission d’encouragement, de conseil et de guide auprès de notre groupe afin de nous pousser à rédiger des articles de Wikipédia de haut niveau. Ce sont des gens très méticuleux, dévoués, et par dessus tout généreux.

Je réalise maintenant que la FA-Team nous a fait la démonstration de la plus grand force (et peut-être aussi la plus grande faiblesse) de Wikipédia : la synergie. Les éditeurs de Wikipédia sont attirés par l’activité. J’irai même plus loin : ils sont particulièrement attirés par l’activité qui aboutit à l’ajout de contenu nouveau à l’encyclopédie. Un bon exemple de cette attraction est l’avertissement que j’ai reçu après avoir créé une page : il existe un noyau de volontaires de Wikipédia qui scrute sans cesse la création de nouvelles pages, prêts à se jeter dessus si un sujet déplacé ou non-encyclopédique est proposé. N’importe qui peut créer une page Wikipédia, mais si vous en créez une sur vous, votre petit groupe de musique ou votre chat, attendez vous à la voir disparaître sans avoir le temps de dire ouf.

De même, beaucoup de personnes émettent des critiques à l’encontre de Wikipédia, la plus connue étant peut-être celle du comédien américain Stephen Colbert, justement parce que n’importe qui peut ajouter n’importe quelle bêtise à un article. Mais je crois que ces personnes ne réalisent pas que des équipes dévouées de wikipédiens surveillent les modifications récentes pour éliminer rapidement ces bêtises flagrantes.

Mais l’aspect vraiment constructif de la réactivité de Wikipédia s’est également manifesté quand, dans les deux jours suivants la création de la page El Señor Presidente, une petite armée d’éditeurs a apporté des modifications mineures qui, combinées, ont apporté des changements importants dans la mise en page. Un des étudiants a ensuite ajouté un fragment d’information qu’il avait trouvé sur un autre site Web. Un petit coup de mise en page réalisée par d’autres éditeurs et au cours suivant cet article ressemblait déjà aux autres pages Wikipédia. Un peu court peut-être, plutôt incomplet et avec quelques sources tirées un peu au hasard d’Internet, mais il apportait des informations sur le sujet aux lecteurs, au moins le minimum, et surtout il était intégré au grand vaisseau Wikipedia.

(Je devrais préciser ici que j’étais indifférent au fait que le travail final des étudiants pourrait ne pas être « entièrement leur travail ». Pour moi, réussir à persuader d’autres personnes de travailler avec eux, travailler en harmonie avec des inconnus faisait également partie du projet. On peut évidemment se dire qu’ils pouvaient tricher pour accomplir leur devoir, comme pour n’importe quel autre devoir, par exemple en payant une tierce personne pour écrire les articles à leur place. Mais en fait le logiciel wiki qui suit les contributions de chacun offre une transparence inégalée, on sait ce que les étudiants font, étape par étape, qui, quoi et quand.)

Ainsi, l’intervention de la FA-Team n’était donc pas exceptionnelle. Ce n’est qu’un exemple de ce principe de synergie porté à une échelle légèrement plus importante et développée. On peut énoncer le principe de synergie ainsi : plus vous contribuez à Wikipédia, plus votre activité résonne et est développée et multipliée par l’activité d’autres personnes. Certes, les guerres d’édition existent, mais d’après mon expérience elles n’affectent en général pas l’ajout de nouveaux contenus. Ce n’était pas juste de la chance, on était tombé sur l’un des principes de base du fonctionnement du wiki.

L’inconvénient de ce principe est que là où Wikipédia est moribond, il le demeure. Bien qu’en théorie l’activité sur Wikipédia bourdonne en continu, en pratique un coup d’œil à l’historique de quelques pages (une information à portée de clic) suffira à vous convaincre que ces pages sont en fait plutôt stables. Un mauvais article pourra le rester pendant une très longue période. Ainsi dans notre projet nous avions les exemples de deux articles plus anciens (et donc plus importants) : les entrées pour Gabriel García Márquez et Mario Vargas Llosa, restées presque inchangées pendant des années, mis à part un petit peaufinage ça ou là. Nous nous devions donc d’y remédier.

Chercher et… chercher encore

C’est alors devenu un travail de recherche. Les étudiants devaient trouver ce qui est appelé en jargon wikipédien des sources sûres. Une doctrine fondamentale de Wikipédia (même si cela peut sembler étrange voire paradoxal, particulièrement pour des universitaires) est qu’elle ne sert pas à la publication de résultats inédits. Une entrée encyclopédique n’est pas faite pour introduire un débat. C’est la différence principale entre dissertation traditionnelle et Wikipédia.

La FA-Team ayant pris en charge le travail de mise en page ainsi que les tâches routinières, les étudiants étaient libres de s’adonner entièrement à la recherche. Mais c’était sans compter un autre piège qui nous a beaucoup ralenti et que nous aurions dû pourtant anticiper puisque ses racines plongent au cœur même des règles de Wikipédia : le fait que les étudiants n’évaluent pas suffisamment leurs sources.

Il faut se rappeler que le problème à la base de ce projet est que les étudiants se fient trop à Wikipédia sans vraiment en considérer les risques et les inconvénients. Il n’était en fait guère étonnant de les voir reproduire les mêmes erreurs en cherchant des sources pour les articles qu’ils devaient rédiger. Ainsi, il n’était pas rare qu’ils ajoutent des informations non vérifiables ou mal documentées (et trop souvent plagiées) ou qu’ils usent et abusent de citations d’autres pages Web et encyclopédies en ligne.

Et pourtant c’est de là aussi qu’a été tirée l’une des meilleures leçons de ce travail. Parce que Wikipédia exige que chaque information soit étayée par une référence (ce que les membres de la FA-Team répétaient inlassablement), les étudiants se sont retrouvés forcés de citer leurs sources. Ces sources pas forcément fiables se sont donc retrouvées exposées, ce qui n’aurait pas nécessairement été le cas pour un examen de session. De plus, justement parce que la rédaction sur Wikipédia est un processus de révision permanente, il a été demandé à certains de reprendre leur travail de recherche pour ré-évaluer leurs sources, pour en trouver de plus fiables avant de reprendre la rédaction. Par la même occasion le problème des plagiats a été réglé simplement parce que plus personne ne recopiait de passages en les faisant passer pour un produit fini.

Pour résumer, ce travail a fait ressortir les faiblesses initiales des étudiants dans le domaine de la recherche, mais ces faiblesses étaient bien la raison d’être de ce devoir. Ils ont cependant appris que rechercher des informations (et les mettre en forme) est un processus, souvent long, où l’on commence avec des sources parfois douteuses (comme Wikipédia lui-même) pour progresser vers des éléments ou preuves toujours plus solides, jusqu’à découvrir de nouvelles informations occultées par les premières sources.

Autres observations : un travail professionnel

Au moment où j’écris ceci, l’accouchement sous péridurale du projet n’est toujours pas terminé. Un article, celui que j’avais ironiquement créé devant la classe, a passé sa première inspection avec succès, une inspection particulièrement rigoureuse d’ailleurs, ce qui lui vaut maintenant le grade de Bon Article. Mes étudiants sont donc à l’origine d’une partie des 0,15% de ce que Wikipédia a de meilleur à offrir et tout cela en partant de rien. De plus, parmi ces 0,15% ne figure aucun autre travail littéraire d’Amérique Latine. Ils (nous ?) ont toutes les raisons d’être fiers d’eux[1]. Pour autant que je sache, c’est le seul travail éducatif sur Wikipédia à avoir directement abouti à un Bon Article[2].

Évidemment tout ne s’est pas fait sans accroc. Deux articles n’ont pour le moment pas vraiment progressé. Le rêve de créer douze nouveaux Articles de Qualité ne restera sans doute qu’un rêve (signifiant par là-même que toute la classe aurait eu la note A+ à un devoir représentant désormais 40% de leur note finale). Mais je suis sûr qu’il en sortira encore une série de Bons Articles (deux autres sont en cours d’évaluation), et certains seront sûrement nominés pour le grade d’Article de Qualité.

Voici donc la résultante d’un travail rigoureux qui, parce qu’il avait pour cadre ce site Web tant décrié qu’est Wikipédia, était loin d’être une solution de facilité. C’était même plutôt le contraire.

Je ne suis toujours pas aveuglé par Wikipédia, loin s’en faut. Il faut bien se dire que c’est une encyclopédie dont seulement une infime fraction de ses articles sont considérés comme de « bons » articles, même par ses propres éditeurs. D’autres faiblesses de Wikipédia sont plus apparentes que jamais, on les retrouve même à un certain degré dans ce projet : un article moribond aura tendance à le rester, et certaines sources sont discutables et souvent plagiées.

Mais, pour la défense de Wikipédia, je dois dire que je n’avais jusqu’alors pas réalisé à quel point ses propres critères sont ambitieux et avec quelle rigueur ils sont appliqués, ni même remarqué l’efficacité du processus collaboratif… si vous êtes prêt à apporter votre contribution et surtout si vous êtes prêt à faire les recherches nécessaires à l’ajout d’informations vérifiables. Là encore je dois dire que nous avons été particulièrement chanceux dans les rencontres que nous avons faites, mais je pense aussi que d’autres bénéficieront de la même bonne fortune.

En ce qui concerne le travail, qui je le répète est loin d’être achevé… j’aimerais croire qu’il enseigne aux étudiants l’art de la recherche et de l’écriture dans un environnement proche du monde réel. Il leur a été assigné au début du semestre un but à moyen terme, voire à long terme, et il leur a été demandé de travailler en collaboration au sein de leurs propres groupes mais aussi avec des inconnus dans un environnement ouvert afin d’établir comment parvenir à ce but et comment le réaliser. Ce travail devait déboucher sur un résultat professionnel, visible par des milliers de personnes, une ressource qui dans la plupart des cas serait la première escale de chercheurs futurs, qu’ils soient étudiants comme eux ou qu’ils fassent simplement partie des millions de visiteurs de Wikipédia de par le monde. La plupart de ces articles sont en effet le premier résultat affiché (ou presque) lors d’une recherche sur Internet sur le sujet traité.

En comparaison, les dissertations et les examens classiques que nous donnons à nos étudiants paraissent plutôt anecdotiques.

Inutile ? Pas d’argumentation

Ce que les étudiants n’apprennent pas par contre à travers ce projet est le développement d’un argument. L’argumentation, la construction cohérente d’une série d’idées, la défense et l’étayement d’une thèse convaincante, est évidemment au cœur de l’enseignement académique. J’attache beaucoup d’importance à cette compétence.

Mais on peut également dire que dans la plupart des emplois qu’occuperont les étudiants après la fin de leur cursus, l’argumentation ne tiendra pas une place aussi importante que dans le monde académique. À l’opposé, la recherche d’informations, la présentation, l’exactitude, l’aptitude à travailler en équipe et la capacité à négocier avec la sphère publique leur seront bien plus utiles (même si ça me fait un peu mal de l’admettre).

De plus, l’écriture sur Wikipédia leur inculque la pensée critique, peut-être pas celle qui est en général abordée à l’université… mais peut-être le devrait-elle. Les éditeurs de Wikipédia sont sans cesse encouragés à faire preuve d’esprit critique vis-à-vis des informations qu’ils trouvent et également vis-à-vis de leurs propres écrits.

J’ai un peu peur d’avoir trop enjolivé la chose. Je le ferai différemment si je suis un jour amené à le refaire. Et je dois vous avouer que j’ai souvent eu l’impression de faire un numéro d’équilibriste, que tout pouvait s’écrouler à tout moment. D’ailleurs nous ne sommes toujours pas à l’abri. Mais si quelque chose tourne mal je pourrai toujours modifier ce texte…

Oh, et si ça vous dit, n’hésitez pas à donner un coup de main sur Murder, Madness, and Mayhem !

Les autres articles du dossier

- 2/6 – Le projet vu par l’enseignant

Présentation, chronique et analyse du projet par le professeur Jon Beasley-Murray (à lire en premier).

- 3/6 – Le projet vu par un éditeur de Wikipédia

Le point de vue d’un éditeur de Wikipédia, membre de « l’équipe des Articles de Qualité », ayant accompagné et soutenu les étudiants pendant la durée de leurs travaux.

- 6/6 – Liens connexes

Une sélection de liens francophones autour de Wikipédia et l’éducation.

L’article que nous vous proposons aujourd’hui n’a rien d’original en soi. Il doit en exister de similaires partout dans le monde sachant qu’en plus le mouvement ne fait que commencer. Il nous a semblé pourtant intéressant de le traduire dans un contexte où la France semble prendre du retard sur le sujet.

L’article que nous vous proposons aujourd’hui n’a rien d’original en soi. Il doit en exister de similaires partout dans le monde sachant qu’en plus le mouvement ne fait que commencer. Il nous a semblé pourtant intéressant de le traduire dans un contexte où la France semble prendre du retard sur le sujet. Nous le savions déjà : « musique » et « industrie musicale » sont deux entités distinctes. La révolution numérique n’a fait que nous le rappeler mais en apportant un petit quelque chose en plus : la possibilité pour le premier de ne pas être obligé d’en passer forcément par le second pour exister. Surtout si cette industrie musicale renonce à s’adapter et préfère mettre son énergie à chercher des mesures coercitives pour ramener ses clients dans le droit chemin de la rassurante situation d’avant (qui n’est déjà plus).

Nous le savions déjà : « musique » et « industrie musicale » sont deux entités distinctes. La révolution numérique n’a fait que nous le rappeler mais en apportant un petit quelque chose en plus : la possibilité pour le premier de ne pas être obligé d’en passer forcément par le second pour exister. Surtout si cette industrie musicale renonce à s’adapter et préfère mettre son énergie à chercher des mesures coercitives pour ramener ses clients dans le droit chemin de la rassurante situation d’avant (qui n’est déjà plus). Dans notre récent billet

Dans notre récent billet  Framatube, contraction pas forcément heureuse mais en tout cas signifiante de Framasoft et YouTube, a récemment franchi le cap symbolique des 100 vidéos (104 pour être précis), presque toutes en français ou sous-titrées, offrant par là-même un catalogue « spécialisé » qui pourra être utile à toute personne souhaitant s’informer et diffuser la « culture » et « l’état d’esprit » du logiciel libre, pris au sens large (et nébuleux) du terme.

Framatube, contraction pas forcément heureuse mais en tout cas signifiante de Framasoft et YouTube, a récemment franchi le cap symbolique des 100 vidéos (104 pour être précis), presque toutes en français ou sous-titrées, offrant par là-même un catalogue « spécialisé » qui pourra être utile à toute personne souhaitant s’informer et diffuser la « culture » et « l’état d’esprit » du logiciel libre, pris au sens large (et nébuleux) du terme.

Mon titre est un peu accrocheur et inexact mais il témoigne d’un mouvement d’origine norvégienne de

Mon titre est un peu accrocheur et inexact mais il témoigne d’un mouvement d’origine norvégienne de