Ce blog tente modestement d’en témoigner au quotidien, quelque chose d’important est en train de se jouer actuellement autour d’Internet et des nouvelles technologies.

Ce blog tente modestement d’en témoigner au quotidien, quelque chose d’important est en train de se jouer actuellement autour d’Internet et des nouvelles technologies.

En caricaturant à l’extrême, on pourrait, c’est maladroit et réducteur mais c’est parlant, poser la question ainsi : souhaitons-nous, pour aujourd’hui et pour demain, vivre dans un monde « inspiré par l’Hadopi » ou dans un monde « inspiré par le logiciel libre » ?

Politiques, industriels, juristes, financiers, publicitaires, grands médias… les tenants d’un « monde Hadopi » sont nombreux et puissants. Structurellement et culturellement issus du millénaire précédent, ils ont toutes les peines du monde à comprendre pourquoi on leur répond partage quand ils nous disent consommation. Ils ont une bonne longueur d’avance parce qu’ils possèdent pouvoir, argent, monopoles, brevets ou propriété intellectuelle, et influencent plus ou moins directement tous les moyens de communication de masse, permettant ainsi trop souvent de modeler ou endormir les esprits (qui ne se réveillent que pour les soldes).

Tous les moyens de communication sauf un. Ils ont mis du temps à comprendre mais ils ont désormais pris la mesure de la menace et ils ne s’en laisseront pas compter.

C’est dans ce contexte qu’une « minorité d’agités avant-gardiste » a décidé d’entrer en résistance pour préserver tous les possibles qu’offre potentiellement Internet (normalement, là, la musique de Star Wars devrait se déclencher).

Les modalités d’actions sont diverses et variées. Cela peut par exemple prendre la forme d’un réseau de sites et de projets collaboratifs qui placeraient subversivement toutes ses ressources sous licence libre. Cela peut également prendre la forme d’un groupe de pression qui, de Paris à Strasbourg en passant par Bruxelles, obligerait les élus du peuple à se rappeler au bon souvenir de leurs responsabilités et obligations citoyennes.

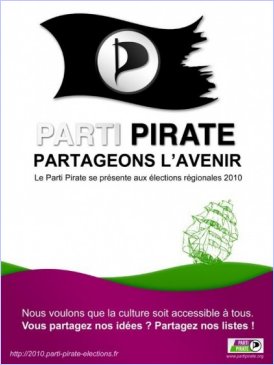

Mais cela peut aussi, et pourquoi pas, prendre carrément la forme d’un parti politique, original et différent, qui viendrait se mêler à la cour des grands pour y apporter sa fraîcheur et sa vision.

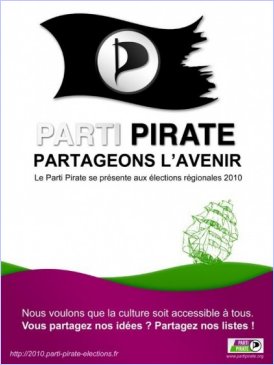

Telle est mon introduction toute personnelle du Parti Pirate, qui après une sorte de galop d’essai remarqué lors d’une législative partielle dans les Yvelines, a décidé de déployer ses voiles à l’occasion des prochaines élections régionales, où tout le monde peut encore être candidat à la candidature (on appréciera au passage la déclaration d’intention de Perline, tête de liste à Paris).

Le connaissant finalement assez peu, j’ai décidé d’en savoir plus en interviewant deux de ses membres ci-dessous.

Entretien croisé avec Jean-Christophe Frachet et Valentin Villenave

Bonjour Jean-Christophe, bonjour Valentin, pouvez-vous vous présenter rapidement ?

Jean-Christophe – Je m’appelle Jean-Christophe Frachet, j’ai 44 ans. J’ai récemment démissionné du MRC de Jean-Pierre Chevènement, où j’étais responsable de fédération, et délégué national aux TIC. J’ai, de plus, été élu à Paris dans le 2e arrondissement délégué au TIC et au développement économique de 2001 à 2008. J’ai été PDG d’un groupe de communication pendant 10 ans ; je suis aujourd’hui responsable de la mission TIC à la direction générale d’un département d’Île-de-France. Je suis au Conseil d’administration de la FING et de Silicon Sentier. J’ai une petite fille de 18 mois, et je joue de la guitare basse dans un groupe.

Valentin – Je m’appelle Valentin Villenave, j’ai 25 et je suis musicien. J’ai découvert les licences libres grâce à Framasoft, et je suis très vite devenu activiste du Libre, tant dans le domaine culturel qu’informatique (je suis contributeur du projet GNU LilyPond). J’ai rejoint le Parti Pirate dès son apparition en juin 2006, et au fil du temps, je me suis retrouvé parmi l’équipe dirigeante : je suis aujourd’hui trésorier du parti.

Qu’est-ce que le Parti Pirate ? Quel est son programme, sa motivation ?

Valentin – L’histoire du Parti Pirate commence comme une blague, un soir de réveillon (trop ?) arrosé. Un programmeur suédois qui, sur un coup de tête et pour épater ses amis, ouvre une page web avec simplement « Parti Pirate » en noir sur fond blanc. La blague marche au-delà de toute attente : des dizaines de milliers de citoyens accourent, parce qu’il y a longtemps qu’ils ne se reconnaissent plus dans les partis politiques traditionnels, parce qu’ils n’en peuvent plus d’être traités, à longueur de médias, de « pirates » pour un oui ou pour un non, et parce qu’ils y voient, enfin, l’espoir de se réapproprier une vie politique qui leur est étrangère. Rien qu’en 2006, une vingtaine de Partis Pirates apparaissent, en Europe puis dans le monde (il y en a aujourd’hui deux fois plus). En France, l’indignation suscitée par la loi « DADVSI » est grande, et les débuts du Parti Pirate seront volontiers provocateurs ; il faudra quelques semaines pour que se stabilisent une idée-force simple et évidente : il faut réaffirmer les Droits de l’homme et les valeurs citoyennes dans la société d’aujourd’hui, en tirant pleinement parti des possibilités ouvertes par le progrès technologique.

Cela passe, notamment, par un accès plus transparent, plus immédiat et universel à l’information, à la culture et à la connaissance. Le droit de la « Propriété Intellectuelle », ces deux derniers siècles, s’est transformé en un outil d’asservissement, de maintien de monopoles et de raréfaction artificielle (alors que, nous le savons bien, les richesses immatérielles peuvent aisément être partagées à l’infini). Le droit (originellement) « d’auteur », par exemple, happe les artistes dans un engrenage d’intermédiaires et d’industriels qui, de fait, les dépossède du contrôle de la façon dont est diffusé le fruit de leur travail.

Autre exemple, le système des brevets tourne en circuit fermé (ex: brevets logiciels), s’étend à tout et n’importe quoi (ex: brevets sur le vivant), et ce au détriment des régions déshéritées du monde (ex: les brevets pharmaceutiques qui empêchent l’accès au soin). Enfin, il est urgent de s’interroger sur l’avenir qui se dessine, aussi bien dans « nos » démocraties occidentales que dans le monde entier : les citoyens doivent faire entendre leur voix, partout, pour que la technologie soit un outil d’émancipation et d’enrichissement, et non d’asservissement ou de flicage. Pas besoin d’aller chercher loin pour en trouver des exemples : ici-même, sous nos yeux, la neutralité du réseau, l’accessibilité et la transparence de l’information, les libertés civiques les plus fondamentales (liberté d’expression, droit à la vie privée) sont constamment rognées sous des prétextes de lutte contre le terrorisme, contre la pédophilie,… sans oublier les vilains « pirates » !

Jean-Christophe. – Après trois ans et demi d’existence en France, j’ai proposé au Parti Pirate de se doter d’un premier texte fondateur, que nous avons rédigé ensemble pour récapituler nos positions et nous permettre de nous exprimer dans différents domaines. Nous en avons assez de la politique purement gestionnaire qui navigue à vue. On arrive à des absurdités où l’on se plaint qu’on ne vend pas assez de voitures mais il ne faut pas s’en servir parce que ça pollue ! On appuie sur le frein et l’accélérateur en même temps.

Le Parti Pirate défend les valeurs de Liberté, Egalité et Fraternité, que l’on pourrait appeler le socle Républicain. Il est le seul qui prend aujourd’hui en compte le bouleversement de l’arrivée de l’internet et des nouvelles technologies avec tout ce que cela modifie dans nos sociétés et nos organisations. Le « développement durable » est aussi une dimension très présente, qui complète notre réflexion. C’est sur ces trois piliers que s’articulent nos prises de positions et propositions.

Est-ce à dire que les partis traditionnels déjà en place ne remplissent pas toutes leurs responsabilités ? Se coupent-ils de la jeune génération ?

Jean-Christophe – Je pense que les Partis « traditionnels » ne prennent pas en compte les bouleversements de l’arrivée des TIC. Nous avons des générations d’hommes et de femmes au pouvoir qui sont nés dans l’illusion d’abondance de ressources et d’énergie, mais dans une rareté de l’information. Cependant c’est aujourd’hui le contraire : il y a pénurie de ressources et d’énergie, alors que l’information est accessible au plus grand nombre. Je crois aux fondamentaux Républicains et à ce projet de société. Pour moi, c’est un projet collectif au service des individus. Mais si on prend en compte le passage de l’ère industrielle à la société de l’information, beaucoup de paradigmes sont remis en question (biens dématérialisés, temps, espaces, citoyenneté, sphère privée,…). Il ne faut pas chercher les solutions de demain avec le contexte d’hier. Je pense que la fracture est là.

Valentin – Nous n’avons pas la prétention d’être un parti générationnel ! Il est certain qu’une certaine partie de la population s’est déjà rendu compte des formidables opportunités nouvelles qu’ouvre, par exemple, Internet ; nous ne devons pas nous en réjouir, mais faire en sorte que cette connaissance s’étende le plus vite possible au reste des citoyens ! En ce qui concerne les partis traditionnels, nous avons bon espoir qu’ils comprendront tôt ou tard qu’il n’y a pas de sens à s’accrocher à un édifice républicain « pyramidal ». Cette prise de conscience a déjà commencé, et se traduit par des réactions de peur, ou de convoitise. Nous voulons croire que peu à peu la notion d’intérêt général prédominera. Le but ultime du Parti Pirate… c’est qu’il n’y ait plus besoin de Parti Pirate !

Et êtes-vous réellement si différent d’un parti écologiste par exemple ? Et que feriez-vous si un tel parti, ou un autre, adoptait en bloc votre programme ?

Valentin – Cela a déjà commencé, très tôt. Nous nous en réjouissons, même si nous regrettons souvent que nos propositions les plus marquantes (par exemple, légalisation du P2P) soient reprises sans les questions fondamentales qui vont avec : à aucun prix nous ne voulons devenir un simple distributeur à buzzwords. Nous cherchons à inventer et proposer un modèle de société, pas à fournir des concepts creux pour communicants de tous poils. Tu évoques les mouvements écologistes ; il est vrai qu’on nous en rapproche parfois, et d’ailleurs les députés européens Pirates siègent avec le groupe parlementaire des Verts. Mais nous osons croire que (tout comme nos préoccupations) le souci des générations futures et du Tiers-monde ne sont pas l’apanage d’un parti quel qu’il soit !

Jean-Christophe – Avant tout, nous défendons des idées. Les idées appartiennent à ceux qui les mettent en œuvre en politique. Il me semble néanmoins qu’il est nécessaire d’avoir une vision politique au delà de telle ou telle proposition. Certains points peuvent nous rapprocher effectivement d’un parti écologiste, mais je ne vois pas pourquoi seulement de ce type de parti. Mon modeste parcours en politique m’a appris à me méfier des étiquettes. J’ai tellement rencontré, par exemple, de militants ou d’élus qui se réclamaient de Gauche et qui avaient oublié l’intérêt général et la défense des services publics ! C’est pour ça qu’au delà des Partis, il y a les idées et les actes.

Jean-Christophe, tu te présentes aux prochaines régionales en tête de la liste Île de France du Parti Pirate. Quelles sont les spécificités de cette région par rapport aux thèmes qui vous sont chers ?

Jean-Christophe. – Avec la réforme territoriale, la Région va prendre de plus en plus d’importance. Et l’Île de France, à ce titre, est symbolique de par son rayonnement national et international. Les problématiques de transport, de logement ou d’éducation y prennent des proportions considérables. Je ne pense pas qu’il y ait un seul domaine qui ne puisse pas être regardé sans tenir compte de l’arrivée des nouvelles technologies et du développement durable. C’est transversal, général et inéluctable.

Par exemple, passer du transport à la mobilité. Comment rendre utile le temps de transport et favoriser le télétravail plutôt que multiplier le nombre de routes ou bien la taille des trains. Cela ne suffira jamais avec l’évolution de la démographie. La spécificité de l’ïle de France, c’est 20% de la population Française, un territoire parmi les plus visités au monde et un rayonnement international.

Valentin – D’une façon générale, les régions sont un espace de choix pour implémenter une politique publique d’accès aux infrastructures, au savoir (lycées, portails Internet, information du grand public,…) et à la culture. Et elles ont également un rôle primordial à jouer dans la défense des libertés civiques : ainsi, la région Île-de-France est particulièrement mise à contribution de la politique sécuritaire que prévoit le projet de loi « Loppsi », que nous avons lu très attentivement et dont nous serons amenés à beaucoup reparler dans les semaines à venir…

Ce n’est pas la première expérience électorale nationale du Parti Pirate puisqu’il y a eu la législative partielle de la 10ème circonscription des Yvelines en septembre dernier. Quels enseignements en avez-vous tiré ? La petit polémique qui a suivi était-elle infondée ?

Jean-Christophe – Même si je suivais déjà tout ça avec attention, je n’étais pas encore au Parti Pirate à cette époque. Valentin ?

Valentin – Ah, les Yvelines… Une bonne surprise au premier tour (où nous avons fait plus de 2%), une mauvaise surprise au second tour (où l’UMP s’est maintenue, à 5 voix près !). Notre candidat Maxime Rouquet n’avait pas voulu donner de consigne explicite, mais avait signalé que le choix de nos électeurs serait « décisif, et pourrait faire basculer cette circonscription » en faveur de la candidate écologiste. D’aucuns ont accusé le Parti Pirate d’avoir fait le jeu de la droite, d’où cette « tempête dans un Vert d’eau » à laquelle tu fais allusion.

Mon principal regret est que cette campagne tout entière ait été submergée par la loi «Hadopi», ce qui a notamment permis au député UMP sortant de brouiller les pistes en s’achetant une vocation de anti-hadopiste de la onzième heure. Il n’en demeure pas moins que le (relatif) enthousiasme provoqué au premier tour par la présence du Parti Pirate ne pouvait que s’estomper lors d’un second tour entre deux partis plus traditionnels.

Nous avons d’ailleurs tenu à rencontrer les Verts par la suite, pour réaffirmer clairement que notre propos n’est pas de faire obstacle à un parti en particulier, et certainement pas au leur. Bien au contraire, comme je le disais plus haut, nous ne pouvons qu’appeler de nos vœux une remise en question profonde des partis traditionnels, que nous souhaiterions plus proches des citoyens, plus ouverts à la société et au monde d’aujourd’hui. Et il sera à ce titre particulièrement intéressant de voir dans quel sens les Verts ont la volonté (et la capacité) d’évoluer.

Comment s’inscrit le Parti Pirate au sein des autres partis pirates nationaux ? Je pense notamment au suédois qui a fait grand bruit aux dernières élections européennes. Et d’ailleurs que fait-il ce Piratpartiet suédois depuis qu’il siège au parlement ?

Valentin – Le mouvement Pirate a ceci d’intéressant (et d’inédit) qu’il a commencé à exister au niveau international avant même le niveau national. Le Parti Pirate International, comme il convient aujourd’hui de l’appeler, est un agrégat à la fois disparate et surprenamment uni ; non en ce qu’il n’y a pas de débats animés, mais qu’on trouvera souvent plus de dissensions entre deux pirates d’un même pays qu’entre des pirates des quatre coins du monde ! Premier parti pirate historiquement, le Piratpartiet est aujourd’hui l’un des partis les plus importants de Suède. Outre son efficacité et le talent de ses membres, il a bénéficié (comme nous-même avec Hadopi) de la politique inique et choquante du gouvernement : la mascarade de procès The Pirate Bay, etc.

Vous apportez un regard nouveau à notre fameuse devise républicaine sur votre site. Or Richard Stallman commence toujours ses conférences en français par : « Je puis définir le logiciel libre en trois mots : liberté, égalité, fraternité… ». Dans la mesure où Framasoft sort en ce moment un livre qui lui est consacré, que vous inspirent cette personnalité et sa croisade pour le logiciel libre ?

Jean-Christophe – Je trouve l’analogie avec les fondamentaux républicains très intéressante. En effet, le logiciel libre regroupe ces concepts. Richard Stallman est « un grand bonhomme », qui a fait beaucoup pour apporter une vision politique, même si cela n’est pas vu comme tel pour une « population » qui, même si elle est militante, se défend d’être politisée. Je pense que c’est dans quelques années que le grand public se rendra compte de l’apport théorique qu’il a apporté à cette société de l’information qui se met en place. Va-t-on revenir aux deux blocs de la guerre froide, du moins sur le plan idéologique ?

Valentin – RMS est sans aucun doute le participant le plus éminent des discussions du Parti Pirate International, dont il ne loupe pas une miette, toujours avec la patience et la minutie qui le caractérisent. J’ai deux grandes fiertés : la première est de pouvoir entretenir, grâce à notre Parti Pirate frenchy, une relation privilégiée avec lui ; nous avons d’ailleurs été les premiers à prendre en compte ses remarques sur la réforme du copyright. La seconde, bien moins anecdotique, est qu’il est également indéniable que l’apparition du Parti Pirate a visiblement nourri la pensée de rms lui-même, et contribue à donner corps à ce qu’il avait pressenti dès le début : « le logiciel Libre est un mouvement social ».

Lorsqu’il nous a rejoints cet automne, Jean-Christophe a été (agréablement, je crois) surpris de constater combien nous étions attachés aux valeurs citoyennes de Liberté, Égalité, Fraternité. De fait, c’est peut-être là l’extraordinaire convergence que permet de réaliser le Parti Pirate : offrir aux communautés du Libre, du P2P, aux artistes, aux citoyens de tous horizons une base commune de dialogue, de réflexion et d’action. Mes collègues du PP vont probablement me dire que ce sont de bien grands mots, mais c’est exactement cette convergence qui m’a amené à tenir bon, contre vents et marées, depuis près de quatre ans, en tant que contributeur Libriste, enseignant, auteur, et citoyen avant tout, le Parti Pirate est presque un résumé de ma vie 🙂

Et d’ailleurs que vous inspire la citation qui orne le Framablog : « …mais ce serait peut-être l’une des plus grandes opportunités manquées de notre époque si le logiciel libre ne libérait rien d’autre que du code » ?

Valentin – … Que cette phrase a une mauvaise influence sur les âmes trop sensibles, puisqu’elle m’a moi-même conduit à gaspiller bêtement quatre ans de ma vie au lieu de m’inscrire à la SACEM « comme tout le monde »… Au-delà de l’anecdote, nous espérons que le Parti Pirate pourra « hacker » la vie politique de la même façon que RMS a « hacké » le copyright lorsqu’il a rédigé la toute première licence libre. L’internet a potentiellement aboli la distance entre émetteur et récepteur, et ouvre la voie à de nouveaux modèles sociaux : contributifs, plus horizontaux et moins pyramidaux. Du reste, les mordu(e)s du Libre ne s’y trompent pas puisque Perline, grande SPIPienne devant l’Éternel, nous a également rejoints il y a peu !

Jean-Christophe – Je pense qu’en effet, il y a des modèles dans le libre qui peuvent être déclinés dans la vie matérielle. Nous avons besoin de revisiter certains fondamentaux de notre société et la société de l’information va très vite, on pourrait dire des années de chien (1 an = 7 ans) ! Il y a des modèles qui se mettent en place, évoluent, mutent et se perfectionnent ou meurs rapidement. C’est presque un laboratoire en accéléré de différents modes de société. Il me semble que l’on pourrait s’en inspirer parfois en politique.

Et pour parfaire le tableau, notre slogan : « La route est longue mais la voie est libre… »

Valentin – Je relis cette phrase avec un peu de nostalgie car elle me renvoie à une époque lointaine où l’on pouvait se dire que la vie politique française avait touché le fond… Nous étions loin du compte.

Jean-Christophe – En effet, nous n’en sommes qu’au début.

Quant à Lenine, il disait : « le communisme, c’est les soviet plus l’électricité ». Et Internet, c’est les réseaux sociaux plus l’électricité ?

Jean-Christophe – Je pense que le réseau c’est le cartographie d’un nouveau monde avec de nouvelles frontières, de nouvelles règles et de nouveaux acteurs. Il y a 15 ans, on ne se serait pas douté de ce qui advient aujourd’hui, alors dans 15 ans… Tout est possible, le meilleur comme le pire, mais à une échelle de temps très réduite.

Valentin – À titre personnel, l’expression même de « réseau social » me hérisse. Nous sommes heureusement nombreux à faire tout notre possible pour qu’Internet ait davantage à apporter aux populations du monde que des gadgets branchouilles et propriétaires.

Vous souhaitez en profiter pour lancer un appel important je crois…

Jean-Christophe – En effet, nous proposons à tout citoyen qui partage nos idées de partager les listes avec nous, sans nécessairement adhérer au Parti Pirate : nous défendons des idées, pas des étiquettes.

Nous avons fait un dossier à télécharger où tout est expliqué. Il ne faut pas trainer, les listes sont à déposer début février ! Vous pouvez en savoir plus sur : http://2010.parti-pirate-elections.fr/Etre-candidat-a-la-candidature

En tout cas, bravo pour le travail que vous faites à Framasoft, c’est utile pour aujourd’hui et pour demain. Et en plus, c’est sympa, ce qui ne gâche rien !

Valentin – Merci à toi aKa pour ton curiosité, ton dévouement et tes questions toujours pertinentes et approfondies. À très bientôt !

Je suis de ceux qui pensent que le futur

Je suis de ceux qui pensent que le futur  La

La  Ce blog tente modestement d’en témoigner au quotidien, quelque chose d’important est en train de se jouer actuellement autour d’Internet et des nouvelles technologies.

Ce blog tente modestement d’en témoigner au quotidien, quelque chose d’important est en train de se jouer actuellement autour d’Internet et des nouvelles technologies. Lorsque, par exemple, vous achetez une

Lorsque, par exemple, vous achetez une