Un grand bonjour à vous, en cette belle journée d’automne sur le Framablog !

Voici, avec un peu de retard, une nouvelle Librologie en écho au précédent portrait, et dans laquelle il sera question de rêves et de visions, de copyleft, de frames HTML, de Marx, de nettoyage industriel, de coiffure pour hommes, d’experts-miami et même de comic sans ms… Ah, et puis de Antoine Moreau, aussi.

Après l’épisode d’aujourd’hui, les Librologies prendront une pause de mi-saison et vous retrouveront en février 2012, même endroit, même jour de la semaine. D’ici là je reste à votre disposition dans les commentaires… et sur mon site personnel.

Bonne lecture, et que cette fin d’année vous soit propice !

Valentin Villenave.

Les aphorismes de l’Oncle Antoine

Antoine Moreau est artiste peut-être.

Ainsi se présente-t-il, d’une façon, nous le verrons, presque obsessionnelle. « Artiste peut-être », le mot peut amuser ou déconcerter, mais intéressera tout particulièrement le Librologue assidu qui ne manque pas, nous l’avons vu, de raisons pour critiquer le mot artiste, si souvent employé pour (dé)limiter et désamorcer une certaine catérorie sociale. Antoine Moreau, qui aime à parler par citations, se réfère d’ailleurs à cette apostrophe de Gombrowicz : « Rejetez une fois pour toute le mot `art’ et le mot `artiste’, [qui] vous culculise et vous cause tant de soucis. Ne peut-on pas penser que chacun est plus ou moins artiste ? »

Symptôme autant que pétition de principe, cette citation n’est pourtant qu’un reflet infidèle de la démarche de Moreau : s’il est attentif au langage et à la terminologie employée (particulièrement à l’étymologie des mots, comme nous le verrons), pour lui les mots sont « légers » plutôt que lourds de sens. Ainsi se refuse-t-il à exclure certains mots de son vocabulaire, comme le fait Richard Stallman. S’interdire des mots, ce serait s’interdire la poésie ; ce serait succomber à une croyance (« croire en le langage qu’on parle, alors qu’on est parlé par le langage ») ; ce serait se soumettre, enfin, à une passion de pouvoir, violente et totalitaire. Partant, Moreau décrit le Libre non comme un discours ou une idéologie, mais comme une réalité profonde des « rêves et des visions ».

Cette « réalité », donc, c’est celle de l’art Libre et du mouvement Copyleft Attitude dont Antoine Moreau est l’initiateur et le commissaire informel, et autour duquel une poignée de personnes se réunit chaque mois auprès d’une table de bistrot à Paris. Cette démarche artistique a été formalisée à travers la Licence Art Libre, rédigée en 2000 et qui prédate donc les célèbres licences Creative Commons. Il s’agit là d’un mouvement dont je me sens moi-même proche, et qu’il m’arrive de fréquenter ; il m’est donc d’autant moins facile de porter un regard critique sur Antoine Moreau, envers qui je dois reconnaître un lien d’estime et d’affection.

Rappelons ici, à toutes fins utiles, le principe du copyleft (jeu de mot avec copyright, et improprement traduit par « gauche d’auteur »). Le droit d’auteur traditionnel, celui qui s’applique par défaut, dispose que sur toute œuvre de l’esprit rien n’est autorisé, sauf exception : on ne peut ni la voir, ni la reproduire, ni s’en inspirer pour réaliser une autre œuvre. Le copyleft, au contraire, est un moyen pour l’auteur d’accorder d’office ces autorisations à tout un chacun… à la condition que toute copie de l’œuvre, ou toute œuvre dérivée, soit à son tour placée sous « copyleft » et bénéficie ainsi des mêmes permissions. Si le copyleft est donc, à l’origine, de nature purement juridique, l’on comprend bien que ce choix n’est pas anodin : c’est sans doute ce que veut ici souligner le terme d’« attitude » — même s’il sonne comme un gimmick malheureux. Publier une œuvre Libre serait donc davantage qu’une simple modalité : ce serait un choix pleinement intégré à la démarche artistique, que celle-ci soit de création, de re-création ou même… de décréation, terme que Moreau emprunte fréquemment à Simone Weil.

Antoine Moreau est dé-créateur, peut-être.

Et son parcours, « peut-être » artistique, se joue depuis une trentaine d’années — soit bien avant la formalisation du copyleft — le long de cette incertitude, oscillant entre création et invention (au sens latin de « découverte »), questionnant la figure traditionnelle de l’auteur et son autorité — là encore, au sens latin : « ce qui fait que l’auteur est auteur ». Il théorisera très tôt cette insatisfaction, comme en témoigne cet entretien de 1987 : « J’essayais de peindre. Cela ne me satisfaisait pas. Plus j’allais, plus j’allais vers la destruction de la toile et des moyens de peindre. Je ne voulais cependant pas non plus nier ni la peinture ni l’image. […] Il est très important pour moi d’éviter le nihilisme avant-gardiste. […] Je n’ai nullement l’intention d’assumer les positions de l’artiste romantique. Il ne s’agit en effet pour moi ni d’exprimer mon `moi’ profond ni de délivrer je ne sais quel message. Le message passe à travers moi. »

- Antoine Moreau en 1986

- © 1986, Benoît Delhomme.

Dès 1981, cette idée se concrétisera avec ses Vitagraphies™, qui consistent à déposer une toile blanche sur le sol, en un lieu public, pour y recueillir la trace des passants :

Tout comme photographie signifie « trace de lumière », Vitagraphie veut dire « trace de vie ». C’est une image acheiropoïète, c’est-à-dire non faite de main d’homme, qui recueille ce qui se passe dans le temps et lieu de sa pose, avec le vivant qui déambule à la surface. Parmi les images non faites de main d’homme, la plus connue est sûrement le Suaire de Turin. […]

Concrètement, une vitagraphie est une toile spécialement préparée que je pose sur le sol d’un lieu, pendant une durée déterminée de 1 jour, 3 jours, 3 semaines ou 9 semaines, suivant la nature du lieu. Le passage des gens sur la toile fait apparaître le graphisme du sol, grâce à la matière poussière. C’est une trace du vivant pendant un temps et dans un espace donné.

Une fois le temps de pose réalisé, la vitagraphie est vernie, tendue sur châssis comme peinture. C’est une image qui se situe dans la tradition des Beaux-Arts, mais c’est une peinture sans peinture. Sans doute, une peinture d’après sa fin, une fin sans fin y compris sans peinture.

- Vitagraphie in-situ

réalisée à Madrid. © A. Moreau, 1989.

« Vitagraphie » est une marque déposée [à l’INPI en 1983, 1993 et 2010]. Il s’agissait, dans le cadre d’une exploitation commerciale, d’utiliser la vitagraphie comme « test de détection de la saleté » à l’usage de sociétés de nettoyage. Un article paru dans « Service 2000, le magazine du nettoyage industriel » en mars 1984 fait état de l’initiative prise en ce sens. […] L’intention était d’articuler l’art avec une fonction annexe utile et inversement, poser une fonction utilitaire et un art en conséquence.

Le terme vitagraphie avait déjà été employé pour désigner le cinéma lorsqu’il fut inventé, et a été également utilisé dans d’autres contextes, parfois similaires. Ce qui n’empêche pas Moreau de le reprendre à son compte et d’en faire, dans tous les sens du terme, une marque déposée — astuce lexicologique qu’il semble toutefois avoir cessé de mettre en avant ces dernières années : peut-être depuis que quelqu’un lui a joué un tour en déposant le mot copyleft ?

Du nettoyage industriel en tant que démarche artistique : ainsi retrouvons-nous cette question de l’utilité que nous avions déjà évoquée, et à laquelle Moreau propose ici une réponse inattendue. Certes, l’aspect final d’une Vitagraphie™ est, en général (c’est-à-dire à moins d’un accident providentiel), prévisible quoique non dénué d’élégance : une empreinte du sol, de couleur grisâtre. Mais l’essentiel, et nous verrons que c’est une constante dans l’œuvre de Moreau, réside probablement moins dans son incarnation effective que dans l’idée qui y a présidé : en l’occurrence, celle qui, renversant les rôles, fait du passant un peintre, et du peintre le simple « révélateur » du piétinement passager, soudain devenu geste artistique. L’idée prime sur la réalisation : même s’il ne se décrit pas ainsi, Antoine Moreau est un artiste conceptuel.

Enfin, peut-être.

- Antoine Moreau en 1991

image extraite du reportage « Une journée au Louvre » © Label Video, 1991.

De ces Vitagraphies™, il dira également (dans cet entretien de 1987 déjà cité) : « C’est toujours comme un miracle. Je crois qu’il me serait impossible de ne pas réussir une toile. Plus elle est piétinée, plus elle est saccagée, plus elle sera réussie. » Ce mot de saccage, Moreau ne l’emploiera plus guère, et pourtant j’imagine qu’il ne lui déplairait pas, comme à son habitude, d’en distinguer deux sens possibles : celui de « bouleversement et dégradation », mais aussi de « pillage des richesses créées par autrui ». C’est en effet une constante chez Antoine Moreau que de chercher à révéler (comme l’on révèle une photographie) l’œuvre d’autrui — de préférence le premier venu. Ainsi, une de ses activités consiste à parcourir les brocantes pour y collecter, selon ses dires, des « croûtes » (de vieux tableaux pompiers sans intérêt historique ou artistique), puis à les « saccager » méthodiquement, leur donner par exemple les séquelles du temps, et constater combien ils en gagnent de force et de beauté. « C’est parce que je les ruine, dit-il, que je les sauve de la ruine. »

Plus radicales et surprenantes encore, ses Peintures recouvertes, telle cette toile qu’il recouvre entièrement, 365 fois par an. Ou encore « sa » Peinture de peintres : à partir de 1985, Moreau invite plusieurs artistes-peintres successifs (une trentaine au dernier recensement, dont certains ont pignon sur rue) à peindre une nouvelle œuvre, successivement, toujours sur une même toile. Seule une photographie témoignera de cette œuvre, avant qu’elle soit recouverte par la suivante.

Au contraire de la figure traditionnelle de l’Artiste, la démarche d’Antoine Moreau est donc d’attirer l’attention sur la valeur — potentiellement — artistique de (tout ?) ce qui n’est pas produit par lui. Un autre projet, initié en 1982, en témoigne : les « feuilles à dessiner » que Moreau distribue à tout un chacun, en proposant d’y dessiner ou d’y inscrire ce que l’on voudra — quand il ne les abandonne pas, simplement, dans un lieu quelconque. C’est l’aboutissement de ce renouveau de la pensée de l’art qu’évoquait plus haut Gombrowicz, dans une société où, de fait, tout le monde est artiste — au moins « peut-être ». Cette initiative se prolongera à la fin des années 1990 avec ses Expositions Mode d’Emploi, puis prendra un nouvel essor au XXIe siècle, lorsque ces feuilles à dessiner distribuées par Moreau deviendront également autant d’invitations à penser et concrétiser la notion de copyleft.

Dès le début des années 1980, Moreau a donc posé clairement les thématiques et concepts autour desquels se construira son œuvre, dans une filiation que l’on pourrait faire remonter aux prémisses de l’art dit « contemporain » et par exemple à Marcel Duchamp. Au motif du « saccage » que nous évoquions plus haut, s’ajoute celui de l’abandon (Moreau ne manquerait pas de remarquer que, par coïncidence, dans « abandonner » il y a « donner ») : selon ses dires, Moreau se plait à cacher des peintures un peu partout, en pleine nature ou chez des connaissances ; il se raconte même — je ne saurais en attester — qu’il aurait jeté quelques œuvres à la Seine, le jour même de leur vernissage… À partir de 1993, alors que le mot interactivité ne fait pas encore fureur, qu’Antoine Moreau entreprend ses premières sculptures confiées. « Je confie une sculpture à quelqu’un en lui demandant de la confier également à quelqu’un d’autre, qui la confiera aussi etc. Je demande aussi à ce qu’on m’écrive pour recueillir les informations concernant la circulation de l’objet. »

Dans ce contexte de libre circulation et de transfert, pourrait-on dire, de pair à pair, l’émergence du Web et du courrier électronique viendra à point nommé. C’est en 1995 que Moreau plonge dans le réseau Internet ; il ouvrira bientôt son site personnel, intitulé d’abord

',',',',',',',Antoine Moreau peut-être un artiste,',',',',',',',',',

puis, plus tard, simplement « Antoine Moreau peut-être ». De 1996 à 1998, y tient « à brûle-pourpoint » un journal d’humeur, blog avant la lettre qui ressemble peu à ce que l’on connaît aujourd’hui de lui :

Le jeudi 16 Novembre 1998

Les projets artistiques comme les projets politiques sont voués à l’échec. Il n’y a pas de politique de l’art qui vaille. La politique tout court déjà ne vaut pas grand chose dans ses desseins. Son trait est lourd et sanglant. L’art n’est pas un projet, c’est un fait accompli et qui s’épanouit sans perspective. Son trait est léger et amoureux

Aujourd’hui, ce qui fait monde, c’est l’organique du monde, une seconde nature.

Le dimanche 08 Novembre 1998

Après l’illusion de la perspective, nous nous laissons séduire par l’ilusion [sic] sans aucune perspective que celle de notre propre illusion, notre propre captation dans un cul de sac qui nous met la tête dans le cul, dans le guidon, dans le sac à puces.

Nous allons vivre dans cette représentation de nos rêves d’ailleurs et ce sera un cauchemard [sic] d’ici bas, une réalité tronquée, un réel enfermement.

L’Internet est en train de devenir une vaste prison animée par des matons marchands qui font le marché mondial et la marche forcée vers la techno-surveillance punitive, la techno-performance dopée, la techno des crétins fachos, toujours ce même mouvement de masse hystérique, ce même coup de massue dans le visage.

Le samedi 07 Novembre 1998

Quand on fait la promotion d’un produit c’est qu’il est déjà vendu, dévalorisé, corrompu par sa publicité, son spectacle. Sur le trottoir qu’il est, à côté, juste à côté de la poubelle.

Il y convie aussi son public à le contacter, par exemple pour l’informer du devenir de ses « sculptures confiées », lui commander des sculptures ou même remplir l’équivalent virtuel de ses « feuilles à dessiner » — on n’ose imaginer ce qu’il aurait pensé, à l’époque, en découvrant ceci, ceci ou ceci (pour ne rien dire de nombreux autres… et qui sait ce que nous réserve l’avenir). De plus, Moreau ne tardera pas à s’emparer du HTML comme outil créatif, et se livrera à de nombreuses expériences artistiques ou facétieuses — quoique parfois, hélas, très datées : texte noir sur fond noir ou à double lecture, jeux de survol, littérature potentielle, et autres curiosités telles cet alphabet défilant ou encore ce Labywikirinthe… Un exemple de cette démarche est On se comprend, réalisée en 1996 (à l’invitation du Centre International de Création Vidéo) et faite de huit frames (compatible Netscape® 2.0), qui donnera lieu à quelques gloses ou paralégomènes et œuvres dérivées.

- Antoine Moreau en 2000

- © Thierry Théolier, 2000.

Cette appétence pour les techniques modernes ne se démentira pas par la suite : on trouvera ainsi dans l’œuvre de Moreau, au début des années 2000, cet autre wiki, ce carré magique, ce prisme multicolore ou ce dialogue interactif, puis plus tard, des code-barres en deux dimensions, et de nombreuses vidéos sur dailymotion ou vimeo (reposant souvent sur des procédés de juxtaposition ou dérivation). À l’intitulé « Antoine Moreau peut-être », son site actuel a substitué le doux nom de Nagbvar Zbernh crhg-êger ; Moreau y exprime, de façon répétée, son goût pour l’indéchiffrable, ainsi que sur son microblog où il poste, de loin en loin, des messages cryptiques toujours inattendus. Existe-t-il autant de messages cachés derrière ces cryptolectes ? Je ne saurais le dire ; mon instinct serait plutôt d’y voir une mystification dans la veine du Manuscrit de Voynich, une supercherie facétieuse qui témoigne aussi du regard que porte Moreau sur l’Internet : là où beaucoup ont voulu y voir un espoir de facilitation d’accès à l’information, de clarification du monde connu, Antoine Moreau semble insister — non sans justesse — sur le regain de bruit et de flou qui s’est ouvert en ce nouvel espace, qu’il prend tout entier, nous le verrons, comme terrain pour un jeu de piste imaginaire. Au « gazouillis » (tweet) ininterrompu du Net, Moreau oppose une éructation compulsive et absconse. Nagbvar Zbernh crhg-êger !

C’est au-delà de son site Web, cependant, que se jouera la réalisation primordiale des « rêves et visions » d’Antoine Moreau : plus spécifiquement, sur Usenet où se crée en 1996 le groupe fr.rec.arts.plastiques, qui s’accompagnera d’une flopée de listes de discussion. Les frapistes, ainsi qu’il convient de les appeler, sont alors à la pointe de la réflexion en matière de progrès informatique, de nouveauté artistique… et d’éthique du droit d’auteur : on mentionnera notamment Le Lièvre de Mars, dont l’œuvre polygraphe est variée, abondante et souvent même plus intéressante, à mon sens, que les travaux de Moreau dont je regrette parfois la démarche systématique et conceptuelle, l’aspect froid et le manque de souffle lyrique — mais sans doute touché-je ici à mes propres limites bourgeoises. (Pour ne rien dire d’autres critiques dans le milieu de l’art contemporain légitimé, qui voient depuis trente ans Moreau comme un imposteur-agitateur dont la démarche se résume à une pure provocation sans profondeur ni sincérité. À toutes ces personnes, je recommande de lire la thèse d’Antoine, dont nous reparlerons plus bas.)

Cette période est également celle où éclosent en France de nombreux mouvements embryonnaires autour du logiciel Libre et de la citoyenneté sur Internet : April, Parinux, BabelWeb, Freescape… Effervescence dont Antoine Moreau fréquente précisément, à l’université de Saint-Denis, un des épicentres, et dont il se liera bientôt avec quelques acteurs majeurs (Frédéric Couchet, Charlie Nestel, Tanguy Morlier ou Jérémie Zimmermann pour ne citer qu’eux), avant de découvrir Richard Stallman lui-même lors d’une conférence en 1999. La convergence entre le logiciel Libre et la « quête d’auteurs » d’Antoine Moreau est presque une évidence, comme il le montrera à cette époque en traduisant le célèbre texte de Eric S. Raymond How To Become A Hacker, devenu pour l’occasion Comment devenir artiste. C’est également de cette convergence que naîtra, fin 1999, la liste Copyleft Attitude, très tôt hébergée par April, et où se joueront les travaux de formalisation aboutissant rapidement à la Licence Art Libre que nous évoquions ci-dessus. Cette liste est encore aujourd’hui — le groupe frap ayant perdu de sa vivacité — le principal lieu d’existence de ce que l’on pourrait appeler la « communauté Art Libre ».

Autant le dire : la Licence Art Libre est sans aucun doute l’une des plus grandes réussites du mouvement Libre à ce jour. Aisément applicable à toutes sortes d’œuvres de l’esprit et dans tous pays, elle fait intervenir quelques trouvailles originales : ainsi, seules les copies de l’œuvre sont licenciées, ce qui peut surprendre dans un contexte purement immatériel mais non dans le domaine des arts graphiques physiques. Concise, claire, cohérente, élégante, elle a tous les avantages qui manqueront cruellement aux licences Creative Commons rédigées peu de temps après aux États-Unis, dans un hasardeux mélange de Libre et non-libre, copyleft et non-copyleft, d’ambigüités juridiques et de mauvais goût intellectuel. Ce sont pourtant ces dernières qui se feront connaître, venant à point nommé dans un contexte mondial largement américano-centré, et disposant d’une infrastructure centralisée jusqu’à l’impérialisme (la Creative Commons Foundation, dont le budget annuel se chiffre en dizaines de millions de dollars), avec l’appui de grandes entreprises et un sens évident du marketing. La Licence Art Libre, toutefois, a très tôt acquis une intégrité et une légitimité indiscutables : elle est même recommandée par le projet GNU.

À partir de 1999, l’activité d’Antoine Moreau prend donc la forme d’une « défense et illustration » du copyleft. Ses écrits en témoignent, à commencer par ses contributions aux listes de discussion : après des débuts modestes, il ne tarde pas à trouver un ton — beaucoup plus lisse que dans ses « brûle-pourpoints » cités plus haut, et sur lequel nous allons revenir — et une place à part entière, trolls compris. Sur son site, il théorise également — non sans humour — l’avènement d’un art virtuel et de son commerce. À ces premières ébauches s’ajouteront vite d’autres textes plus sérieux, souvent rédigés pour des colloques ou revues, et dont nous ne citerons ici que quelques titres :

- De la distinction entre l’objet d’art et l’objet de l’art, du net-art et de l’art du net. (Pour une pratique du réseau en intelligence avec ses acteurs. Rien n’a lieu que le lieu et je est un autre.)

- Copyleft Attitude : une communauté inavouable ?

- La création artistique ne vaut rien.

- La mise en place d’une mythologie de l’immatériel ou l’art de fictionner.

- L’activité opératoire, du Livre à l’internet. Une livraison.

- Il n’y a que faille qui vaille.

- L’art de rien mine de tout.

- Le copyleft, la topie tournante de l’auteur.

- L’autre de l’auteur.

- Rendu à discrétion. Ce que fait le copyleft à l’autorité tonitruante de l’auteur.

- Antoine Moreau en 2002

© Timothée Rolin, 2002.

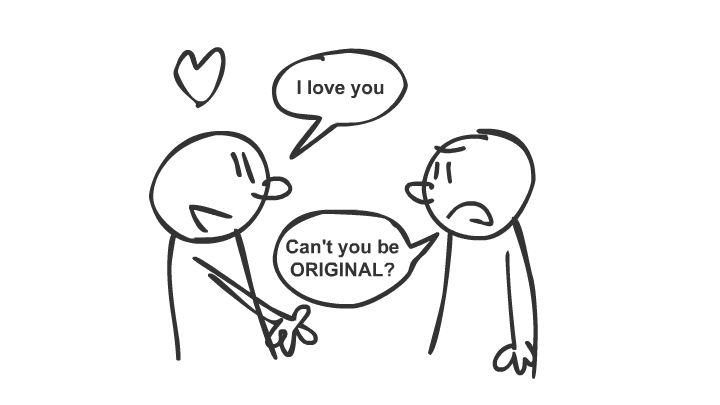

À ce stade, le lecteur attentif (en espérant qu’il le soit encore) commencera peut-être à percevoir une constante stylistique et esthétique chez Antoine Moreau : sa jonglerie incessante et vertigineuse avec les mots. Des mots dont nous avons vu que Moreau revendique la légèreté, comme une impérieuse nécessité de trouver de la poésie en toute chose, en toute phrase — phrase qui, justement, devient dans le discours d’Antoine Moreau l’unité structurelle, non pas de sens, mais d’accomplissement formel. Le mot se fait jeu, la phrase se fait formule : Antoine Moreau parle par aphorismes.

« Le poétique et le politique sont les deux jambes d’un même corps. »

« Il faut dévoiler le Rien du Tout. »

« Une œuvre est œuvre parce qu’elle est à l’œuvre. »

« L’art Libre est d’abord libre de sa preuve. »

« De même que le silence est d’or, il se peut que le public soit d’art. »

« Il faut entendre le possible comme l’Un-possible, l’impossible unique possible. »

« L’art Libre est une opération d’hacker ouvert. »

« L’art est ce qui n’en a pas l’air. »

« Parlant, nous sommes parlés. Croyant faire, nous sommes faits. »

« Le copyleft n’est par pur ; le copyleft est pour. »

« Libre n’est pas gratuit : Libre est gracieux. »

Ces deux derniers exemples, en particulier, mettent en évidence une construction classique mais efficace : exposer d’abord un terme, puis lui substituer un autre en fin de phrase, créant ainsi le jeu de mot ou plus exactement la chute. On est alors moins dans la phrase déclarative que dans le slogan, et il n’est peut-être pas anodin de noter que le gagne-pain d’Antoine Moreau a souvent été de travailler dans les milieux publicitaires.

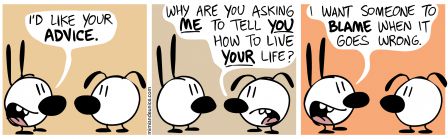

Ce type d’aphorisme court et percutant est ce que l’on nomme, en anglais, un one-liner ; très apprécié des scénaristes hollywoodiens, le procédé est entré au panthéon des memes au début du XXIe siècle… panthéon où je ne peux que souhaiter à Moreau de recevoir un jour la place qui lui revient de droit.

Certes, Antoine Moreau n’est pas le premier (ni le dernier) à se livrer à ce type d’exercice (je note ainsi, dans une conférence de l’excellent Bernard Stiegler : « une vie sans savoir… [mettez vos ray-ban] … c’est une vie sans saveur » — yeeaaaaah). Cependant je suis toujours frappé de voir combien chez Moreau le goût de la formule en vient à contaminer la totalité du discours, transformant le raisonnement même en un tourbillon verbal étourdissant, envoûtant… ou incroyablement frustrant. Ses écrits, ainsi imbibés de ce style très particulier, sont des objets déroutants, souvent poétiques, parfois beaux et attachants, et quelquefois, avouons-le, assez hermétiques. Son mémoire de DEA, daté de 2005, en est peut-être l’exemple le plus parlant : près de 200 pages de formules, d’astuces verbales et de citations souvent fort longues, dont l’intérêt n’est parfois guère qu’anecdotique.

- Antoine Moreau en 2003 – © Isabelle Vodjdani, 2003. LAL

On ne saurait, fort heureusement, en dire autant de sa thèse de doctorat récemment parue, et qui lui a valu en juin 2011 une mention très honorable et les félicitations du jury, toutes deux largement méritées. Objet certes déroutant, qui évolue — de façon peu clairement définie, à tel point qu’elle a probablement nécessité une souplesse peu commune de la part des instances universitaires — entre la philosophie de l’art et la « science informatique », cette somme de 800 pages (prochainement disponible chez Framabook) restera très certainement comme un ouvrage de référence. Pour le dire plus clairement : il faut lire la thèse d’Antoine Moreau ; c’est un ouvrage remarquablement complet et approfondi, parfaitement lisible et intelligible, exigeant et intelligent, d’une élégance certaine et d’une intégrité intellectuelle sans faille.

Non pas que je partage en tout point les analyses et rapprochements présentés dans cet ouvrage. À commencer par son érudition même, à laquelle je ne saurais prétendre et qui le conduit parfois à des juxtapositions inattendues quoique rarement contestables. La divergence la plus profonde, peut-être, concerne ce que je qualifierai d’idéologie de la transcendance ou du « transpercement », terme plus fréquemment employé. Cette thématique sous-tend le raisonnement de Moreau — j’irai même jusque à dire, sa foi : s’il se décrit comme « incroyant », il se réfère fréquemment à une mythologie chrétienne (la légende de Sainte-Véronique que nous citions plus haut) et surtout à des auteurs déistes, anciens (Denys l’Aréopagite, La Boétie, Pascal) ou modernes (Simone Weil, Michel Henry, Michel de Certeau) ; de là à décrire le Libre comme religion, il n’y a qu’un pas que, pour ma part, je me refuse à franchir.

Autre dissension de fond, la critique que Moreau fait de Stallman (que nous évoquions en début d’article) et en particulier de sa volonté de régir le langage, que Moreau juge « totalitaire ». Il pourrait bien ne s’agir ici que d’une question de forme : comme je l’ai expliqué, l’intransigeance de rms sur les questions terminologiques est autant à mettre au compte de la rugosité de son caractère que de l’inculture notoire et navrante d’une large part de son public ; si Stallman savait pouvoir compter sur l’intelligence des geeks Libristes pour utiliser les mots avec discernement, je doute qu’il persisterait à vouloir les bannir. Cependant cette divergence est aussi l’indice d’un désaccord de fond, puisque Moreau se refuse à considérer le mouvement Libre comme une idéologie — concept qu’il juge « mortifère », préférant voir dans le copyleft une « réalité » profonde qui transcende, nous y revoilà, les personnes et les époques.

Cette position donne lieu chez lui à un refus jésuitique de la confrontation idéologique, voire de l’affrontement quel qu’il soit ; bien plus, Moreau peut faire montre d’une propension exaspérante à désamorcer les positions idéologiques du mouvement Libre, par exemple en matière d’anti-capitalisme (il s’emploie ainsi à réhabiliter des mots tels que « commerce » ou « consommateur »). Cette posture de neutralité bienveillante sera d’autant plus agaçante pour le militant Libriste que le copyleft dont se revendique Moreau a, dès son origine, été pensé comme une arme dans un contexte de lutte pour la liberté des citoyens, utilisateurs et développeurs. Au-delà du mouvement Libre, et comme l’a justement remarqué rms, les champs de combat pour les droits de l’Homme ou les valeurs citoyennes ne manquent pas autour de nous — rédigeant cet article tout juste cinquante ans après un massacre raciste perpétré au nom de l’État français, je ne peux m’empêcher de me sentir mal à l’aise lorsqu’il est question de jeter quoi que ce soit dans la Seine… Étant artiste peut-être, mais surtout détenteur d’une parole publique, il me semble impossible (ou en tout cas malvenu) de se dérober à cette responsabilité partagée à laquelle l’on est, pour reprendre le mot de Sartre, condamné. Ainsi, je ne saurais être plus en désaccord avec Moreau que lorsqu’il m’explique que « [sa] pratique de l’art [lui] interdit de tenir un discours politique : ce ne serait qu’obéir à la pression sociale »… et je ne peux qu’avouer mon incompréhension lorsqu’il exprime sa confiance (sa foi ?) en l’art : « Il faut affirmer le fait d’art, et son incidence sur la société. L’art est la politique de la politique. »

La lecture qu’il fait de Marx, à ce titre, est profondément différente de tous les courants « marxistes », « marxiens » ou « post-marxistes », dont on connaît pourtant la grande diversité (sinon parfois l’incohérence). Il rejette notamment Guy Debord, mais aussi Pierre Bourdieu qu’il voit comme… un « dévoiement » de la pensée de Marx ! S’inspirant de Michel Henry mais également de Max Stirner et Louis Althusser, il considère que « la révolution de Marx n’a pas été accomplie par Lénine ; elle l’a été par Duchamp. Le grand échec des révolutions `marxistes’ , a été de manquer d’art. » Pour lui, la seule révolution digne de ce nom ne peut donc venir que par l’art, aujourd’hui soutenu par le dispositif symbolique alliant l’Internet au copyleft. Ce qui le conduit à de longs développements, parfois assez datés, sur le P2P, à l’encontre des lois « dadvsi » ou « hadopi » — posture dont nous avons vu qu’elle est en quelque sorte le degré zéro de la culture politique chez les geeks — et en faveur de modèles tels que le « mécénat global » ou le « revenu d’existence », objets éminemment mythologiques sur lesquels nous reviendrons dans un prochain épisode. Cet ersatz de discours politique a de quoi surprendre : Moreau aurait-il, à son tour, senti le poids de la « pression sociale » ?

Que l’on partage ou non ces points de vue, il faut bien reconnaître à Antoine Moreau une culture et une qualité de réflexion indéniables, que je ne puis prétendre atteindre moi-même. Sa pensée semble d’une cohérence presque hiératique et marmoréenne… et il n’en est que plus amusant de noter qu’il est néanmoins capable d’une certaine hargne, pas toujours justifiée : par exemple envers le nihilisme post-moderne, les situationnistes… ou encore les partisans des licences Creative Commons — alors même que, dans ce dernier cas, la Creative Commons Foundation semble aujourd’hui œuvrer pour une meilleure reconnaissance de l’éthique Libre. À ces fixations « en négatif » de Moreau, il convient toutefois d’en ajouter d’autres en positif : « pour moi, me disait-il récemment, la Vérité existe. » — c’est-à-dire en tant que valeur absolue et universelle, là où tant de discours actuels veulent y voir un concept très relatif et personnel. De même sur le langage : même s’il revendique de ne s’interdire aucun mot, je relève dans sa thèse une critique lucide et saine de mots tels que « artiste », « création », « contenu », « technologie », « culture »… Enfin, sa prétendue absence de discours politique revendiqué comme tel ne l’empêche pas, à l’occasion, de dénoncer la « volonté de détruire la Loi [sous couvert de `modernité’], volonté entreprise, notamment par le matérialisme historique en ses révolutions, mais aussi par les dictatures de toutes sortes via la tabula rasa ou, plus insidieusement, par l’hégémonie mondiale culturo-industrielle du capitalisme libéral-libertaire. » On ne saurait mieux dire.

On remarquera la longueur de la phrase que je viens de citer : nous sommes ici loin du one-liner, sur lequel il me semble intéressant de revenir à ce stade. C’est que le « mot d’esprit », comme l’étudie Freud, fait l’objet d’une véritable économie : mettre en balance ce que l’on dit, ce que l’on veut signifier, et peser soigneusement chaque mot. Pour séduisants qu’ils soient, les aphorismes d’Antoine Moreau sont intéressants pour ce qu’ils lui évitent de dire — rappelons que le terme séduire signifie à l’origine détourner, en l’occurrence détourner l’attention.

- Antoine Moreau en 2010 © Renata Sapey, 2010

J’ai souvent constaté qu’Antoine Moreau a tendance a redoubler de jeux de mots lorsqu’il est mis en difficulté ou en accusation. Sans aller jusqu’à citer une correspondance privée, je me souviens d’un message où, étant convenus de nous rencontrer à trois avec une personne contre qui j’étais en désaccord, je lui reprochais de s’être arrangé avec ladite personne pour que le rendez-vous ait lieu précisément le jour de la semaine où il savait que j’étais indisponible ; mes termes exacts étaient « si j’entends bien votre pas de deux, notre débat à trois n’aura pas lieu puisque vous vous orientez vers un jeudi ». La réponse d’Antoine fut… un modèle de noyage de poisson, à base de « jeudi je dis mais je est un autre (tu dis ?) » et de « pas de pas de deux pas deux deux pas de pas de pas de deux — donc quatre fois deux = huit, le grand huit ! pffuit ! »… Euh… Comment dire…

Parfois, Antoine Moreau est pénible. Peut-être.

Autre exemple, ce long commentaire sur le site Framasoft, où, à des commentateurs qui lui reprochent notamment l’hermétisme d’un de ses textes, Moreau commence par répondre :

Je suis heureux (mais oui !) des problèmes que pose mon texte et qu’il résiste à la lecture au pied de la lettre. Je suis heureux de la lecture inter-dite (ah ah ! jeu de mot, jeu de rot, jeu de mot-rot) qui est faite par ceux qui le comprennent « entre les dits ». Qui en saisissent finalement l’essentiel, ce qui n’est pas même écrit.

Mon sentiment (peut-être infondé) est que les mots d’Antoine Moreau lui servent à se dissimuler. Nous retrouverions ainsi le motif de la dissimulation déjà évoqué plus haut, mais sous une autre forme : si autrefois l’espace géographique urbain lui servait à cacher des peintures, si ses sculptures renfermaient toutes à l’origine une feuille de papier supposée contenir un message secret, et si son site et son microblog actuels fourmillent de cryptogrammes, il ne s’agit plus ici de cacher des « messages » (à l’existence même incertaine) mais de se cacher.

En effet, de la vie d’Antoine Moreau, remarquablement peu de détails sont accessibles en ligne, et lui-même en parle peu. Ses billets d’humeur ont depuis longtemps disparu de son site, ainsi que ses quelques bannières, du reste assez consensuelles ; on trouvera à peine quelques traces de son activité artistique à Pantin (93). Sa notice Wikipédia, d’une brièveté étique, a fini par renoncer (euh, allô ?) à indiquer ses lieu et date de naissance (la date du 1er avril 1970, que lui-même propose sur son site, me semble hautement suspecte). Ce n’est qu’à travers quelques bribes que je situe sa naissance à Angers, où il passera son enfance et son adolescence dans les années 1970 (amateur de rock-punk, il côtoiera notamment le futur groupe des Thugs originaire de son lycée) ; et ce n’est que par une indiscrétion que j’apprends de qui il est le petit-fils. Moreau lui-même s’est ingénié à se rendre le plus introuvable possible — il est d’ailleurs l’un des premiers artisans du contre-googleage au début des années 2000 —, notamment en jouant sur ses nombreux homonymes. Sur son ancien site Web, une rubrique entière est ainsi consacrée à la biographie… d’Antoine Moreau, jeune ingénieur physicien, amateur de jeux de rôle, cultivé et sympathique.

Antoine Moreau est Antoine Moreau peut-être.

Peut-être devrions-nous y voir une invitation à postuler que la seule façon possible d’appréhender ce « peut-être artiste », serait d’ordre socratique : connaître Antoine Moreau, c’est se rendre compte qu’on le connaît, finalement, bien peu. Ou bien, n’y voir qu’un jeu de plus : jeu de piste, jeu de mots. Ou plutôt jeu de masques : ce jeu est un autre.

En ce sens, le présent article, fruit de plusieurs semaines de recherches, de réflexion et d’efforts, n’est-il peut-être, somme toute, qu’une œuvre d’Antoine Moreau, de ces œuvres que la Licence Art Libre nomme « conséquentes ».

Et j’ai bien dit : peut-être.

Drôle de monde que celui dans lequel nous vivons et qui entrave à tous les étages le partage et le bidouillage.

Drôle de monde que celui dans lequel nous vivons et qui entrave à tous les étages le partage et le bidouillage. Qu’est-ce que Framasoft, si ce n’est au départ avant tout un vaste service se proposant de mettre en relation les développeurs et les utilisateurs (que l’on souhaite toujours plus nombreux) de logiciels libres.

Qu’est-ce que Framasoft, si ce n’est au départ avant tout un vaste service se proposant de mettre en relation les développeurs et les utilisateurs (que l’on souhaite toujours plus nombreux) de logiciels libres. Coup sur coup cet été

Coup sur coup cet été

L’Europe prolonge de 20 ans les droits des interprètes et producteurs de musique pouvait-on lire dans

L’Europe prolonge de 20 ans les droits des interprètes et producteurs de musique pouvait-on lire dans