Éric Bruillard est professeur au STEF – ENS Cachan.

L’article ci-dessous reprend une présentation faite le 15 décembre 2012 lors des Rencontres Wikimédia, à l’université Paris Descartes.

Remarque : Vous pouvez également accéder directement à la version ODT et PDF du document.

Wikipédia face aux institutions

Éric Bruillard – décembre 2012

Introduction

Il y a cinq ans, en mars 2007, j’avais écrit un article intitulé « Wikipédia : la rejeter ou la domestiquer ». J’avançais l’idée, qui a souvent été mal comprise, que Wikipédia ne pouvait pas « avoir une présence reconnue dans l’enseignement en France, ses principes mêmes (neutralité) n’étant pas compatibles avec les valeurs de l’école laïque et républicaine française, valeurs qui conduisent à privilégier certains points de vue et à en interdire d’autres ». J’ajoutais que Wikipédia pouvait cependant avoir une place, d’une part comme projet encyclopédique avec des participations actives à ce projet, comme faire écrire des articles à des élèves, et, d’autre part, comme une encyclopédie à laquelle beaucoup auraient recours, dans une posture de consommateur.

Ces deux directions ont été effectivement suivies, et des utilisations constructives sont repérables dans l’enseignement secondaire ou supérieur, quoique la « consommation » est certainement beaucoup plus développée que la participation. Mais Wikipédia aurait-elle maintenant une présence reconnue dans l’éducation ?

Dans un premier temps, nous allons tenter de situer les discours généraux sur Wikipédia, notamment dans l’éducation nationale. Ensuite, nous verrons en quoi Wikipédia est maintenant une véritable institution, statut qui n’est pas sans poser de nouvelles questions. Enfin nous traiterons la question de l’évaluation des articles de cette encyclopédie : une évaluation interne s’est installée alors que l’évaluation externe ne semble pas beaucoup progresser : serait-ce révélateur de relations encore difficiles avec un projet collectif que l’on a toujours du mal à appréhender ?

Wikipédia : quoi de neuf depuis 2007 ?

Le premier constat que l’on peut faire, sans avoir spécialement besoin de l’étayer, est celui de la croissance impressionnante du projet Wikipédia : une présence très importante (notamment via Google), des utilisations qui se multiplient, notamment dans l’éducation, de nouveaux projets associés…

Pourtant, face à ce formidable déploiement, on s’aperçoit, notamment à travers le discours d’étudiants ou d’enseignants, d’une méconnaissance persistante du fonctionnement de Wikipédia, d’idées reçues tenaces, d’utilisations contestées, d’interrogations sur la fiabilité…

Wikipedia nous aide d’ailleurs à cerner ce que qu’est une idée reçue : « une opinion, située entre le stéréotype, le cliché et le lieu commun », précisant qu’elle a « la particularité de s’admettre aisément » parce qu’elle est « très répandue, que celui qui la transmet la considère très souvent comme évidemment démontrée ; elle est agréable à admettre, parce qu’elle répond (le plus souvent simplement) à une question redondante, ou gênante, ou complexe : elle aide à ne plus réfléchir et s’impose insidieusement ». Justement, un peu de réflexion s’impose.

Comme il est possible à n’importe qui de créer ou modifier le contenu d’un article, que ce n’est pas réservé à des spécialistes, il ne semble pas possible qu’il y ait des articles de qualité et on ne peut en aucun cas s’en remettre à Wikipédia. Ce discours de sagesse populaire continue à être très souvent énoncé. Prenons juste un seul exemple : “Wikipedia is a free, web-based, collaborative, multilingual encyclopedia project. Anybody is able to change, add or remove articles on Wikipedia. This of course is prone to many problems as some authors may be: biased, vandalise the article or write incorrect information.”

Les études comparatives qui ont été menées attestent du contraire et l’expérience quotidienne de nombre d’entre nous montre qu’on lui fait malgré tout confiance. Peu d’études nouvelles sont disponibles. La seule étude récente est intitulée Assessing the accuracy and quality of Wikipedia entries compared to popular online encyclopaedias A preliminary comparative study across disciplines in English, Spanish and Arabic. Mais les auteurs remercient la Wikimedia Foundation pour son soutien financier. D’autres institutions ne sont sans doute intéressées à financer une évaluation des articles de Wikipedia, préférant laisser planer le doute et les idées reçues.

Quelle présence officielle dans l’éducation ?

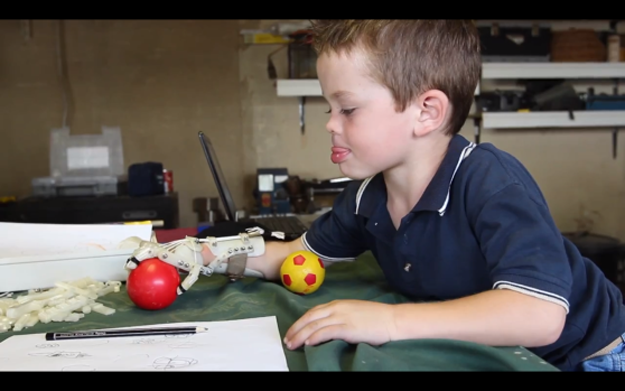

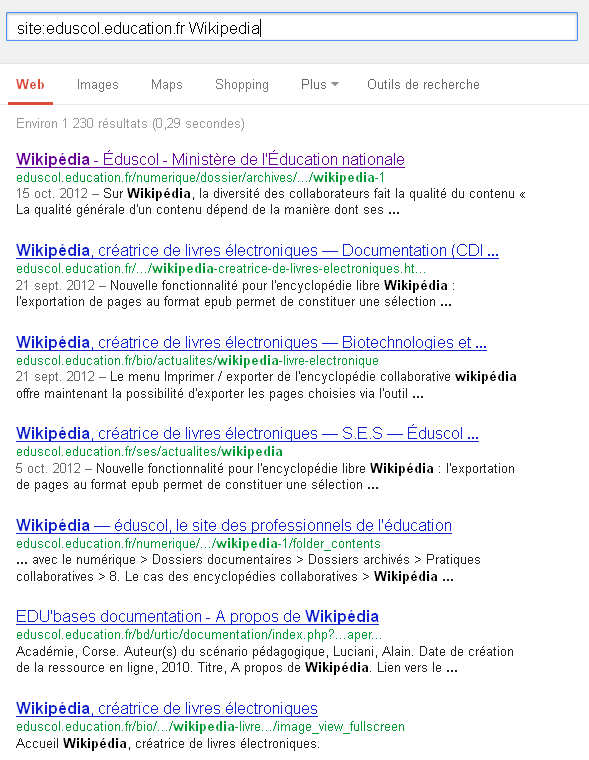

Si la neutralité de l’éducation nationale française l’invite à ne pas citer de marque ou de nom de produit dans ses programmes officiels, sauf exception, elle est conduite à veiller sur ce qui est proposé. Une recherche sur le site officiel Eduscol atteste de la présence de Wikipédia.

On trouve des revues de presse ; un dossier déjà ancien sur les usages pédagogiques ; des recommandations, des définitions issues de Wikipédia, le fait que Wikipedia offre une nouvelle fonctionnalité (l’exportation de pages au format epub, ce qui permet de constituer une sélection d’articles à consulter hors ligne sur une liseuse ou sur smartphone).

On trouve également référence à Wikipedia dans des sujets de bac, des ressources pour la résolution de problèmes, des dossiers pédagogiques… mais avec le plus souvent des modes de citation approximatifs (cf page 2 de ce document). Dans les ressources pour la classe terminale générale et technologique, Physique-chimie, Série S (Eduscol), on trouve 10 références à Wikipédia.

Ce bref tour d’horizon nous en apprend plus sur le système éducatif que sur Wikipédia. Cette dernière apparaît pratique et très utile, mais demeure un motif récurrent de complaintes, attestant des difficultés (ou de l’incapacité ?) du système éducatif à traiter les évolutions en cours sur les savoirs, leur diffusion, leur mise en question… Une utilisation parfois « honteuse », que l’on peut rapprocher des usages des calculatrices en collège il y a quelques années[1] : une sur utilisation, une maîtrise très diversifiée et un manque de formation des élèves. Au début du collège, utiliser la calculatrice est considéré comme une tricherie, il ne faudrait s’en servir que pour contrôler les résultats des opérations que l’on fait à la main. Mais dès la 4e, la tricherie est quelque sorte légalisée, notamment avec les fonctions trigonométriques, et ceux qui ont acquis une bonne maîtrise des calculatrices, sont alors avantagés. Le système éducatif prend peu en charge, voire pas du tout, la formation des élèves à cette maîtrise.

Wikipédia dans le site Eduscol – 10 décembre 2012

Les objets informatiques spécifiques du système éducatif ne sont pas bien traités par Wikipédia. Ainsi, l’article ENT est encore une ébauche de piètre qualité. On retrouve une même ébauche, non signalée comme telle, sur l’expression « manuel numérique », page modifiée pour la dernière fois le 28 juin 2010[2]. C’est une version quasi « ministérielle » qui est proposée, la page « discussion » n’est pas ouverte et aucun article dans une autre langue n’est associé. Ce n’est toutefois par mieux en anglais où l’article “digital textbook” est une présentation du programme de ministère de l’éducation de Corée du Sud ! Les exemples sont coréens, avec des liens vers Toshiba et Fujitsu. Il s’agit d’un article sur le projet coréen, et pas sur l’initiative californienne par exemple.

Enfin, pour clore ce rapide tour d’horizon, un site de l’académie de Montpellier propose de « créer un manuel numérique à l’aide de Wikipédia ». Il est écrit : « Wikipédia est une excellente ressource pour construire un livre numérique dans le but d’explorer un sujet ou d’entamer une recherche documentaire. Pour inciter les étudiants à utiliser Wikipédia comme outil de départ plutôt que comme finalité d’une recherche, un enseignant peut facilement fournir à ses étudiants une collection d’articles de références sous la forme d’un livre numérique. Retrouvez les différentes étapes de création d’un livre numérique dans un mode opératoire mis à disposition sur le site “Prof Web”. »

Si on clique sur l’adresse indiquée, on retrouve le même paragraphe à la virgule près, puis un petit mode d’emploi. Tous les éléments sont présents : citation et même copié-collé. Un exemple mais avec la parapluie de la bonne pratique (il faut utiliser simplement comme point de départ). On se sert de Wikipedia mais d’une manière non risquée !!! On ne cherche pas à comprendre, mais à trouver une pratique que l’on considère légitime et que les autres ne pourront pas contester.

Cette méfiance persistante sur un projet maintenant très établi ne cache-t-elle pas des caractéristiques encore mal connues ou mal comprises. Et Wikipedia, s’il est encore regardé de travers par les institutions, ne serait-il pas aussi une institution ?

Wikipédia est une institution

En effet, pour la recherche, une simple interrogation sur Wikipedia dans Google Scholar produit de très nombreux résultats ; depuis 2011 : 45 700 résultats ; depuis 2012 : 23 100 résultats (à titre de comparaison, on obtient pour les mêmes dates concernant Britannica : 13100 / 7320). Dans les travaux auxquels on accède, il y a des études sur le fonctionnement même de Wikipédia : contenus, conflits, participation, etc. ; des outils pour Wikipédia.

Issus de son fonctionnement même, l’encyclopédie fournit des corpus très utiles pour les linguistes, notamment les paraphrases et modifications locales dans l’historique des révisions des articles, conduisant à améliorer les performances d’applications de TAL : traduction automatique, question-réponse, génération…

Encore plus intéressant, dans un processus d’institutionnalisation de Wikipédia, le projet Semanticpedia associe le ministère de la culture, l’INRIA et Wikimedia France. Cette collaboration vise à « réaliser des programmes de recherche et développement appliqués à des corpus ou des projets collaboratifs culturels, utilisant des données extraites des projets Wikimédia ». Il s’agit notamment de fournir des données culturelles accessibles à tous, dans une version Web sémantique structurée ; en gros devenir la référence pour la culture avec des modes d’interrogation très avancés dans des formes de déclaration sémantique.

Wikipédia est même vu comme un nouvel outil d’évaluation : une évaluation de la réputation ponctuelle, la fréquentation de Wikipédia étant considéré comme outil de mesure ; mais aussi, l’influence qu’une personne a sur un pays ou même sur une civilisation, qui pourrait être mesurée en fonction des liens menant à sa page Wikipédia.

Ainsi, Wikipédia est devenu outil de référence, même s’il s’en défend. C’est déjà un attracteur très puissant pour les recherches et, selon Kien Quach Tat[3] (2011), au Vietnam, Wikipédia est ce qui permet aux lycéens de valider une information trouvée sur un autre site.

Quelle implication du fait que Wikipédia est une institution ? Peut-on être en dehors de Wikipédia ? Comme elle devient la référence, peut-on continuer à l’ignorer, si une information nous concernant est fausse, peut-on encore traiter cela par le mépris ou l’absence de réaction n’est pas une sorte d’acquiescement ? En tous cas, si Wikipedia gère très efficacement les vandalismes, on sait qu’elle est mal armée pour lutter contre des organisations qui cherchent à imposer leur point de vue. Un projet d’émancipation ne s’est-il pas transformé en un instrument de domination ? On n’en est pas (encore) là ! Demeure une question clé : comment évaluer un article de Wikipédia ?

Comment évaluer un article de Wikipédia ?

En 2007, Wikipédia précisait qu’elle n’avait pas les moyens de juger de la crédibilité d’une information et que la fondation cherchait des solutions à cette absence de validation du contenu des articles, notamment « par l’ajout de systèmes de notation, d’identification des versions non vandalisées et par des collaborations avec des chercheurs et des enseignants » (Bruillard, 2007). Des avancées importantes ont été réalisées. Wikipédia évalue elle-même les articles qu’elle produit. Ainsi, l’article Projet :Évaluation est consacré à « déterminer l’état des articles de Wikipédia selon deux critères : leur importance et leur avancement ».

Mais quelle évaluation externe peut-on trouver ?

Quand on lance la requête « évaluation article Wikipédia », via Google, environ 16 900 000 de résultats (0,42 secondes) sont fournis. Mais la grande majorité de ces résultats correspondent à des articles de Wikipedia. La requête « évaluer un article de Wikipédia » -wikipedia.org ne donne aucun résultat. Enlever les guillemets dans la requête conduit à 8 040 000 résultats (0,19 secondes). Que trouve-t-on ?

D’abord des conseils, il s’agit d’évaluer le nombre et la qualité des sources, de consulter l’historique (combien de personnes y ont contribué, et quand), de consulter l’évaluation de l’article et surtout de le comparer à d’autres sources !

Le tutoriel Cerise propose d’autres conseils :

- « Voir si le plan est bien construit et détaillé

- Juger de la qualité de la rédaction : syntaxe, orthographe, synthèse, illustration, …

- Repérer les liens vers les notes et les définitions

- Voir s’il y a une bibliographie récente et mise à jour

- Voir s’il y a un portail sur le thème sélectionné. »

Les guides de la BU de l’université de Rennes 2 dans une page sur « évaluer l’information » consacre un petit encart à Wikipédia en conseillant de regarder les avertissements sur les pages, la date de création (onglet “historique”) et les débats (onglet “discussion”). Cela renvoie à un article du Monde.fr et étrangemenent, aux évaluations internes de Wikipédia.

Sur la Teluq, Marc Couture, dans son cours sur l’évaluation de la crédibilité des documents en ligne, traite du cas particulier de « la crédibilité de Wikipédia ». Il constate que les critères généraux ne s’appliquent qu’imparfaitement aux articles de Wikipédia. Ainsi, ceux reliés à l’insertion dans la littérature spécialisée : « Ce critère prendra donc une valeur toute relative compte tenu à la fois du rôle que joue une encyclopédie dans la littérature scientifique ou savante, et de la difficulté à évaluer le nombre de références à un article de Wikipédia. » Les critères sur l’auteur ne sont pas applicables, les autres (la validation du contenu, forme et la structure du document) sont soit sans garantie soit réfèrent aux classements et processus internes de Wiipédia.

Cherchant dans les sources en anglais, on trouve de nouveau beaucoup de redondances, avec une référence citée, reprise, tronquée dans la Wikipedia anglaise. Un article intitulé Wikipedia:Researching with Wikipedia n’a pas d’équivalent en français avec la recommandation rituelle : “Wikipedia should be a starting place for research, not an end destination and independent confirmation of any fact presented is advised”.

Cet article fournit un lien avec une page sur l’évaluation des articles de Wikipédia, page que l’on retrouve ici (source Phoebe Ayers, en octobre 2006). En fait, ce texte donne tous les éléments pour évaluer un article, les autres sources n’en sont souvent qu’une reprise tronquée. Au bout du compte, c’est une source datée de 2006 (et qui est peut-être antérieure) qui donne les meilleures informations et fait le point le plus complet sur les modes d’évaluation des articles.

Mais est-ce que les procédures d’évaluation préconisées sont opérationnelles ? Autrement dit, peut-on appliquer ces processus dans des utilisations courantes, c’est-à-dire hors situations particulières (notamment scolaires) et de nécessités de vérification. On peut raisonnablement penser que non, si je m’en réfère à mes propres utilisations et ce que peuvent dire les étudiants. Qui confronte systématiquement ce qui est écrit dans un article de Wikipédia à d’autres sources ?

Ce que l’on peut regretter, c’est l’absence de cartographie thématique, alors que l’on imagine qu’il y a des zones de fiabilités différentes, des repérages a priori pourraient guider le lecteurs (les articles dans le domaine X sont plutôt fiables, alors que dans le domaine Y c’est problématique), des marques reconnaissables. Alors que l’on comprend qu’il faut consulter l’historique et les discussions, il y a peu d’outils de visualisation nous donnant une image interprétable ; en conséquence, historique et discussions restent très difficiles à analyser rapidement. En effet, il s’agit de prendre en compte la dynamique collective et temporelle et de pouvoir juger une ressource de par l’histoire de sa construction et des discussions qui l’ont accompagnée. Mais comment le faire rapidement et de manière fiable sans instrumentation. History Flows[4] proposait des visualisations intéressantes. Mais il ne semble pas que ce travail ait été repris et il demeure mal connu.

Des enjeux de formation : guider des consommateurs via des passeurs outillés

L’évaluation dépend bien évidemment dépend de la finalité, du public visé, etc. et on pourrait refuser une sorte d’évaluation intrinsèque des articles de Wikipédia. Mais le jugement sur cette qualité a des incidences fortes, notamment sur les représentations sociales de ce projet encyclopédique. Chacun a ses propres croyances sur Wikipédia, mais il n’y a pas de « sagesse collective » ou de connaissance collective nous en donnant une image moins naïve. Comment juger de la qualité ? On voit que la question est délicate : qualité proportionnelle ou inversement proportionnelle au nombre de contributeurs ; processus linéaire d’accroissement avec quelques accidents ou des formes de plateau, voire des régressions ? La qualité des collaborations aurait un effet sur la qualité des articles.

Selon une étude récente, les changements apportés pour assurer la qualité des articles, avec de nouveaux contributeurs nombreux, aurait un effet négatif sur le recrutement de ces nouveaux contributeurs découragés par les mécanismes mis en place. Ainsi, incontestablement, un processus de professionnalisation a été organisé, processus qui a un effet dissuasif. D’un autre côté, on s’aperçoit que les « consommateurs », rôle que nous prenons tous à un moment ou à un autre pour Wikipédia, ont du mal à sortir d’une vision très naïve et se satisfont d’une sorte de « bonne pratique » paravent : on n’utiliserait que pour commencer une recherche, on ne s’arrêterait jamais sur un article de Wikipédia. Comportement que très peu de personnes adoptent, sauf dans des contextes très particuliers. Alors que l’on propose des modèles à discuter de perméabilité entre concepteurs et consommateurs, on s’aperçoit que pour Wikipédia, il y a d’un côté des concepteurs très instrumentés et d’un autre côté des consommateurs très peu outillés. Entre les deux, on peut s’interroger sur les connaissances, les instruments pour les « médiateurs » (enseignants, documentalistes, etc.). Ne devraient-ils pas en savoir collectivement beaucoup plus que les « simples » utilisateurs ?

Wikipedia est un excellent analyseur des évolutions éducatives : un discours rituel sur la nécessité de développer des utilisations du « numérique », une présence effective mais comme une espèce de sous culture, acceptable parce qu’elle rend des services, pratique mais décriée. Wikipedia est une mine pour les chercheurs, c’est aussi un projet en avance dans le domaine de la culture et dans celui du Web sémantique. Mais comment maîtriser cette technologie collective ? On ne perçoit pas encore bien toutes les potentialités et limites de l’écriture collective. Une tension apparaît : si on apprend par l’écriture, des contraintes de forme trop fortes découragent, l’exigence de qualité risque de conduire à un élitisme par trop restrictif. Il faudrait professionnaliser les intermédiaires, afin de palier le manque d’instrumentation, notamment permettant de visualiser des processus de construction pour juger une production. La question de l’expertise des éducateurs se pose avec une certaine urgence. Pourquoi n’arrive pas à se développer un regard plus professionnel sur les productions de ce travail collectif ?

Crédit photo : Kalexanderson (Creative Commons By)

Les associations du logiciel libre appellent donc tous les députés, de toute tendance politique, à soutenir vivement

Les associations du logiciel libre appellent donc tous les députés, de toute tendance politique, à soutenir vivement  À propos de l’Adullact (

À propos de l’Adullact ( À propos de l’AFUL (

À propos de l’AFUL ( À propos de Framasoft (

À propos de Framasoft (