L’impression 3D déjà à la portée de tous avec Blender et Shapeways

Le Framablog poursuit son petit dossier sur l’impression 3D, histoire de faire comprendre à certains de quoi il s’agit et de donner à d’autres le goût d’entreprendre.

Après une courte vidéo explicative et un article de fond sur l’impact actuel et futur de la propriété intellectuelle sur l’impression 3D, voici une leçon pratique et concrète réalisée à partir du logiciel de modélisation 3D Blender.

Ce qui est intéressant ici, c’est d’abord le fait que Blender soit un logiciel libre mais c’est aussi le fait que vous n’avez pas besoin d’avoir une imprimante 3D à la maison, c’est le service en ligne Shapeways qui se charge de matérialiser l’objet à partir de votre fichier Blender et qui vous envoie le tout par la Poste.

Conclusion : on peut déjà s’y mettre !

PS : On nous signales dans les commentaires l’existence de la société Sculpteo qui propose en français un service similaire à Shapeways.

Créer des figurines imprimées 3D avec Blender et le service d’impression Shapeways

Creating 3D Printed Models with Blender and the Shapeways Printing Service

Terry Hancock – 26 mai 2011 – Free Software Magazine

(Traduction Framalang : Lolo le 13)

Un des sujets technologiques les plus intéressants de ces récentes années a été la montée en puissance de la technologie « d’impression 3D » pour le prototypage rapide de formes peines. J’avais déjà évoqué le sujet pour le Free Software Magazine, mais ce mois-ci j’ai finalement décidé de l’essayer pour mon propre compte, en créant matériellement des « figurines d’étude » (un joli synonyme de jouets) pour mon projet vidéo, Lunatics.

Dans cet article, je vais vous décrire le processus complet, depuis la création des modèles 3D jusqu’à la réception du produit fini dans ma boîte aux lettres.

La principale raison pour laquelle j’ai fait ce projet, c’est que je voulais tester les capacités du service d’impression 3D de Shapeways. Ils ont associé ce service d’impression avec une conception collaborative en ligne, ce qui crée un environnement fun et motivant pour créer et commander des figurines. C’est un service très facile à utiliser et la qualité d’impression semble être au rendez-vous. Ils proposent aussi une grande variété de matériaux d’impression comme la céramique cuite, des métaux et des plastiques.

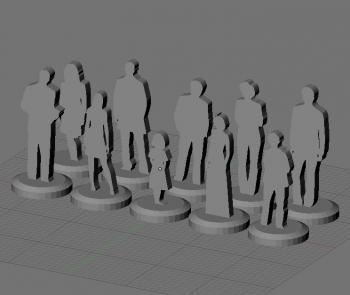

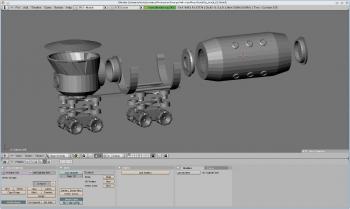

Figure 1 : Conçu dans Blender, exporté et téléversé chez Shapeways, livré en tant que figurine plastique imprimée – C’est cool non ?

La deuxième raison est que je désirais avoir quelque chose d’un peu plus tangible pour élaborer mon projet Lunatics. J’aime travailler avec des ordinateurs, mais parfois vous voulez avoir quelque chose de tangible à tenir et à manipuler avec vos mains quand vous essayez de figer les scènes et planifier les scripts.

Il nous fallait constuire une maquette de la colonie lunaire dans laquelle se déroule la plupart des actions du film. D’ordinaire c’est une affaire de mousse avec des plans de sols imprimés, un peu comme un jeu de plateau. Et comme pour un jeu de plateau, nous allions donc avoir besoin de figurines représentant nos personnages. Nous aurions pu opter pour des pions de Cluedo ou utiliser ceux des échecs avec un code couleur ou encore des petits chevaux, mais ça aurait été bien plus sympa si nous avions des figurines qui ressemblent réellement à nos personnages.

À la même échelle (1/100e) que ces personnages, J’ai aussi voulu créer quelques véhicules spatiaux. J’ai décidé de commencer avec le Moon Truck, un rover lunaire pressurisé conçu pour transporter fret et passagers.

Comme j’ai eu quelques difficultés à imaginer concrètement ce véhicule, il m’a semblé utile d’essayer d’externaliser cette tâche à la fois comme une maquette 3D dans un ordinateur et comme une maquette physique à tenir et à regarder.

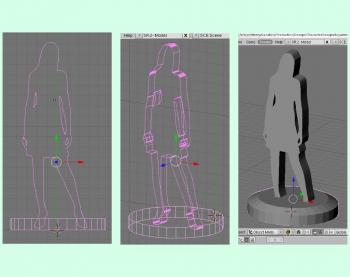

Figurine des personnages

J’ai commencé par créer les silhouettes de mes personnages dans un brouillon Inkscape. Elles sont basées sur des figurines d’architecture du domaine public que j’ai grandement modifiées. J’en ai fait des pions comme de simples découpes sur une base ronde (à la différence de soldats de plomb ou des pions Cluedo).

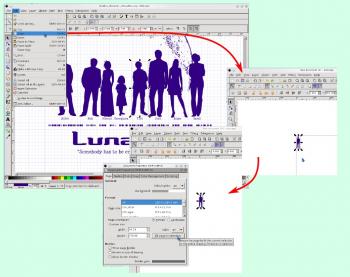

Puis, j’ai sélectionné chaque personnage depuis mon dessin original sous Inkscape et je les ai copiées dans des fichiers SVG séparés (Figure 2). Je les ai sauvegardés en tant que Plain SVG pour un maximum de compatibilité.

Figure 2 : J’ai d’abord copié le dessin des silhouettes en SVG dans des fichiers séparé et sauvegardé ceux-ci au format Plain SVG.

J’ai importé chaque SVG dans Blender en tant que curves (Figure 3). Il y avait huit personnages principaux (plus deux extras). Pour les mettre à la bonne taille (à l’échelle 1/100e, un mètre est réduit à un centimètre) j’ai décidé de prendre la convention qu’un Bender Unit (BU) serait égale à 1 cm. J’ai donc mis à l’échelle les courbes de cette façon.

Figure 3 : J’ai importé les objet SVG dans Blender en tant que curves.

Les courbes (curves) sont des objets spéciaux et limités dans Blender. Il vaut mieux utiliser le format mesh pour l’impression 3D. Donc, après avoir importé les courbes depuis le fichier original en SVG, j’ai du les convertir en meshes (soit ALT+C au clavier, soit Changer le type d’objet… depuis le menu Objet).

Mais après la conversion, je n’avais que le squelette, c’est-à-dire les sommets et les arêtes qui les reliaient. Pour créer une face (surface) représentant la silhouette, j’ai utilisé la fonction Beauty Fill (avec le raccourci clavier Alt+F ou en sélectionnant Mesh > Faces > Beauty Fill dans le menu Option du Mode d’édition accessible via la touche Tab). En fait, ça ne crée pas une seule surface, mais plusieurs, l’espace est alors rempli automatiquement par des triangles.

J’ai ensuite passé quelques temps à simplifier la forme. La chose la plus importante est de s’assurer que les petites surfaces sont coplanaires (appartiennent à un même plan).

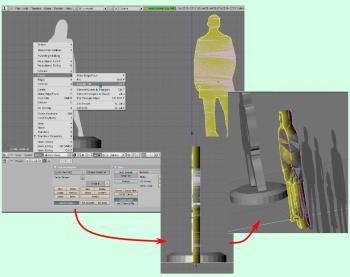

Figure 4 : Extrusion de la silhouette.

Ensuite, il m’a fallu donner de l’épaisseur à la découpe. J’ai décidé de les faire d’un millimètre de large, ce qui correspond ici à un dixième de Blender Unit. Pour ce faire, j’ai sélectionné le mesh, puis j’ai basculé sur la vue le long de l’axe X (en tapant 3 sur le pavé numérique). Puis j’ai tapé sur Tab pour passer en Mode édition et j’ai sélectionné tous les sommets (tapez A pour basculer la sélection sur tous les sommets). Enfin, tapez la séquence E (extrude), Y (direction) et 0.1 : cela créera l’extrusion de la silhouette dans la dimension Y (Figure 4).

Figure 5 : La représentation du personnage d’Anya montre comment la silhouette extrudée chevauche la base cylindrique.

J’ai répété l’opération pour mes dix figurines : création d’une base mesh et extrusion en cylindre mesh, en faisant se chevaucher les figurines extrudées et la base (voir Figure 5).

Il n’est pas nécessaire de fusionner les objets dans Blender, ce qui me sauve d’une trop grande complexité, mais qui donnera une légère surcharge de travail à Shapeways (en effet le calcul actuel est basé sur une analyse des meshes et ils ne compte pas les chevauchements, ainsi, vous serez facturés en double pour les volumes chevauchés).

Figure 6 : Toutes mes dix figurines dans Blender.

Téléverser le modèle

J’ai fait cela plus d’une fois : au départ téléverser juste un des personnages puis essayer différentes combinaisons. Heureusement Shapeways ne fait pas attention si une forme consiste en une simple pièce ou en une douzaine, mais ils facturent un supplément par forme pour la plupart de leurs matériaux. Ça veut dire qu’il est généralement moins cher d’imprimer une petite collection d’objets en tant que forme simple (si vous le pouvez) en particulier dans le cas où, comme moi ici, elles sont de petite taille.

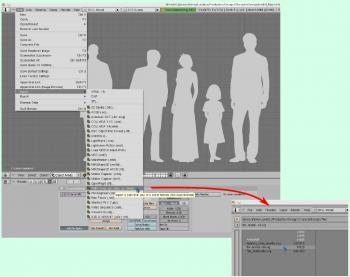

Figure 7 : Exportation d’une forme Blender en format STL pour l’impression 3D chez Shapewys.

Quand vous avez fini votre conception, l’étape suivante est de les exporter dans un format que Shapeways va comprendre. Celui que j’ai trouvé le plus simple à utiliser est le format STL (Figure 7). Ce format est commandé par le menu d’export standard dans Blender (File > Export > STL).

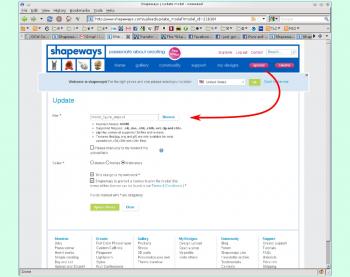

Pour impimer la forme en utilisant Shapeways, j’ai commencé par aller sur le site pour m’identifier. J’ai ensuite cliqué sur le bouton “upload” tout en haut qui m’a renvoyé vers un formulaire d’envoi de ma forme (Figure 8). Le formulaire permet aussi de créer des formes pour votre propre utilisation ou pour le rendre public. En fait, comme avec d’autres service de fabrication communautaire, si vous mettez vos formes à la vente, vous toucherez une commission. N’étant pas tout à fait prêt pour rendre ces fomes libres, j’ai donc juste cliqué sur la boite privée.

Figure 8 : Téléversement de la figurine Anya chez Shapeways.

Il est possible que vous ayez besoin de modifier ce qui a été téléversé si vous voulez que l’image apparaisse correctement, J’ai suivi quelques mauvais conseils et j’ai orienté l’axe Y en tant que “up” (haut) à la place de l’axe Z, ce qui a eu pour résultat la malheureuse Figure 9. Ça aurait été bien imprimé, mais ça donne un rendu de prévisualisation affreux.

Figure 9 : Ooops ! L’axe Z devrait être en haut si vous voulez une prévisualisation correcte (là j’ai mis Y).

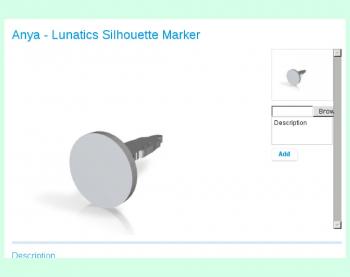

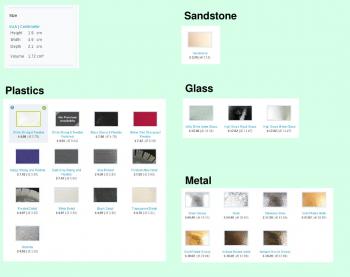

Une fois que vous avez bien téléversé votre forme, vous pouvez commander une impresion 3D avec comme matériau une variété de plastiques, des pierres recomposées, quelques différents types de métal et différents finis de verre (Figure 10).

De façon pratique, l’interface calcule automatiquement le volume et le prix de chaque matériau pour que vous puissiez comparer. Le coût de pour mon lot de 10 figurines va de $3.20 avec de la pierre recomposée jusqu’à $64.40 pour de l’argent (j’ai fait mes figurines en plastique “Indigo strong and flexible” vu que j’avais utilisé de l’indigo pour les travaux artistiques des Lunatics). Le coût a été facturé en fonction des volumes calculés des formes (pas le bounding box, la vraie forme), plus un coût de base par forme.

Figure 10 : Matériaux disponibles et prix pour mon lot de figurines.

Camion lunaire

Après le téléversement de figurines et ma tentative de les commander, j’ai découvert une autre particularité du service Shapeways : Il y a un minimum de commande de 25 dollars. Donc si je ne voulais pas gâcher mon argent, il me fallait commander autre chose. J’ai donc décidé de créer une autre forme au 1/100e, cette fois un des véhicules créés pour mon projet Lunatics (Figure 11). Je ne vais pas vous faire le détail de la création, mais c’est bien entendu une conception plus complexe.

Figure 11 : La conception du camion lunaire dans Blender (je n’ai pas imprimé le module passager sur la droite).

J’ai fait un camion en plusieurs parties qui seront assemblables après coup. C’était en partie pour permettre un assemblage modulaire avec des pièces d’autres modèles (les boogies à quatre roues sont supposés être enlevables sur le camion réel par exemple). Pour d’autres il a été plus facile de faire des formes creuses avec des paroies fines qui ne coûteraient pas tant que ça à imprimer. Le couvercle amovible sur le module l’est aussi pour pouvoir accéder à l’intérieur, bien qu’il n’y ait pas vraiment de détails à l’intérieur (mais je pourrai en ajouter dans une prochaine version).

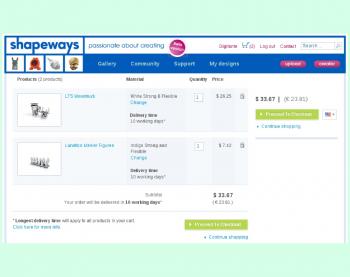

Vous pouvez commander les pièces en utilisant un simple système de vérification, comme n’importe quel site d’e-commerce. En tant que produits fabriqués à la demande, il y a des délais de fabrication en plus des délais de livraison à inclure dans le bon de commande (Figure 12).

Figure 12 : Shapeway s’engage sur un délai de fabrication de 10 jours dans la vue du panier d’achat.

Livraison

Bon, cet article ne serait pas complet sans les photos des produits tels que je les ai reçus ! Ils arrivent dans de jolis petits emballages, un par forme, comme vous pouvez le voir sur la Figure 13.

Figure 13 : Mes objets, tels qu’ils me sont arrivés depuis Shapeways.

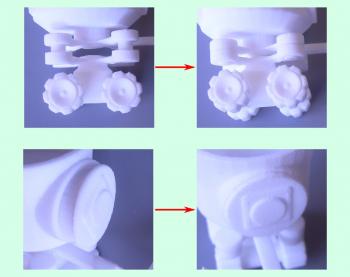

J’étais content de voir qu’il n’y a pas eu de figurines cassées (séparées de leur socle). Le camion est arrivé en pièces comme prévu (Figure 14).

Figure 14 : Le camion a été imprimé en cinq parties (châssis principal et cabine, deux boogies à quatre roues, un conteneur et le toît de la cabine).

L’assemblage du camion a marché dès le premier essai. Les roues sont plus glissées qu’emboitées, mais elles restent en place comme il faut. La prise du sas était passablement dure à ajuster et il a fallu un peu forcer mais le plastique a résisté (Figure 15).

Figure 15 : Assemblage des composants du camion lunaire.

Il est intéressant d’examiner la texture de près. Il est possible de voir les faces du modèle original sous Blender (les formes cylindriques sont en fait des polygones à très grand nombre de côtés, comme dans le haut du boogie à quatre roues de la Figure 16)

Figure 16 : Zoom sur un des boogies, notez les lignes dûes à la méthode d’impression.

Et voila !

Il faut vous avouer que j’avais espéré que les roues tournent. J’ai essayé de concevoir un modèle articulé comme un challenge, mais apparemment je n’ai pas dû laisser suffisamment de jeu pour ça et elles sont donc coincées comme si elles étaient imprimées en bloc. C’est un des nombreux problèmes de conception que j’étudierai avant de tenter d’imprimer ces figurines à nouveau.

La Figure 17 montre les figurines assemblées avec un sous et un DVD pour donner une idée de l’échelle. Je suis ravi d’avoir pu tester cette technologie sur quelle j’écrirai certainement à nouveau et j’espère avoir fait quelques émules parmi les courageux lecteurs.

Figure 17 : Mes pièces complètes avec un penny et un DVD pour l’échelle.

Mais je vais arrêter d’écrire. J’ai trop envie de jouer là avec ma voiture lunaire 🙂

« Un certain nombre de forces convergentes vont faire passer la fabrication personnelle, ou autofabrication, du statut de technologie marginale utilisée par les seuls pionniers et passionnés à un outil quotidien pour le consommateur et l’entreprise lambda.

« Un certain nombre de forces convergentes vont faire passer la fabrication personnelle, ou autofabrication, du statut de technologie marginale utilisée par les seuls pionniers et passionnés à un outil quotidien pour le consommateur et l’entreprise lambda. Ça y est, les premiers « ordinateurs Google », les

Ça y est, les premiers « ordinateurs Google », les  Le monde de plus en plus numérique qui se met en place présente le risque et le paradoxe de nous déposséder d’une part de nous-mêmes, celle qui laisse toujours plus de traces sur le réseau.

Le monde de plus en plus numérique qui se met en place présente le risque et le paradoxe de nous déposséder d’une part de nous-mêmes, celle qui laisse toujours plus de traces sur le réseau.

Certains résistent encore mais nombreux sont les visiteurs (et rédacteurs) de ce site à posséder un compte de messagerie Google

Certains résistent encore mais nombreux sont les visiteurs (et rédacteurs) de ce site à posséder un compte de messagerie Google