Bataille de la vidéo sur le Web : Quand Google restreint pour mieux ouvrir ?

La semaine dernière Google annonçait que Chrome, le navigateur de la firme, ne supporterait plus dorénavant le format vidéo fermé et payant H.264 pour la vidéo sur le Web, préférant promouvoir exclusivement les formats vidéo libres et gratuits tels que WebM (VP8) et Ogg Theora.

La semaine dernière Google annonçait que Chrome, le navigateur de la firme, ne supporterait plus dorénavant le format vidéo fermé et payant H.264 pour la vidéo sur le Web, préférant promouvoir exclusivement les formats vidéo libres et gratuits tels que WebM (VP8) et Ogg Theora.

Cette décision a été diversement accueillie, certains félicitant Google de continuer à peser de tout son poids pour faire émerger un standard libre et gratuit pour la vidéo sur le Web (on se souvient que Google a racheté l’année dernière la société On2 à l’origine du codec vidéo VP8 – que l’on retrouve dans le format WebM – pour permettre à chacun de l’implémenter et de l’utiliser gratuitement). Tandis que d’autres ont reproché à Google son incohérence en continuant de supporter dans le même temps le greffon propriétaire Flash.

En effet, jusqu’à présent la vidéo sur le Web nécessitait un greffon (typiquement Flash, de la société Adobe, omniprésent) qui agissait comme une boite noire en s’intercalant entre le navigateur et l’utilisateur. La récente mise à jour de la spécification HTML (qui sert à créer et afficher les pages Web) offre depuis la possibilité d’afficher les vidéos directement dans n’importe quel navigateur à jour, sans avoir à dépendre d’un unique logiciel appartenant à une unique société privée avec tous les dangers que cela représente[1].

Mais il reste pour cela à se mettre d’accord sur le choix du format dans lequel encoder la vidéo. Apple (Safari) refuse d’implémenter autre chose que le format payant H.264 qu’il souhaiterait voir s’imposer, ce qui placerait la vidéo sur le Web entre les mains d’un consortium de sociétés privées chargé de récolter les redevances et créerait un péage incontournable pour toute société qui souhaiterait innover sur le Web (avec ce système, Firefox et bien d’autres n’auraient jamais pu voir le jour). Pour leur part, Mozilla (Firefox), Opera et Google (Chrome) soutiennent WebM et Ogg Theora en tant que technologies libres et gratuites pouvant être mises en œuvre par n’importe qui sans restriction. Pendant ce temps Microsoft compte les points, n’excluant aucune des solutions

Tristan Nitot, Président de Mozilla Europe, l’explique bien : « Si le Web est si participatif, c’est parce qu’il n’y a pas de royalties pour participer et créer un contenu. (Faire le choix du H.264) serait hypothéquer l’avenir du Web. On créerait un îlot technologique, un club de riches : on pourrait produire du texte ou des images gratuitement, mais par contre, pour la vidéo, il faudrait payer. »

Nous avons choisi de reproduire ici la réponse de Haavard, employé chez Opera Software, à ceux qui dénoncent la récente décision de Google.

Le retrait de Chrome du codec H.264 conduit-il à moins d’ouverture ?

Is the removal of H.264 from Chrome a step backward for openness?

par Haavard, employé chez Opera Software, le 13 janvier 2011

(Traduction Framalang : Antistress et Goofy)

Dans un long article publié sur le site Ars Technica, Peter Bright soutient que retirer de Chrome le support d’un standard fermé conduit à moins d’ouverture.

Je suis fermement en désaccord avec cette assertion et je vais essayer d’expliquer rapidement pourquoi et ce qui cloche avec les arguments mis en avant dans l’article.

1. « H.264 est un standard ouvert »

Malheureusement H.264 est un format breveté et vous ne pouvez l’utiliser sans bourse délier. Conformément à la politique du W3C sur les brevets, cela est incompatible avec la définition d’un standard ouvert, spécialement dans le contexte du Web. D’après la définition même de « ouvert », H.264 ne peut être ouvert car il ne peut être utilisé sans payer.

2. « VP8 n’est pas un standard ouvert »

Ce point est exact, en effet. Le format VP8 est une technologie avec une spécification, pas un standard. Pourtant Google a choisi de concéder à chacun le droit de l’utiliser sans payer de redevance. Ce qui signifie que VP8 est en fait un bon candidat pour devenir un véritable standard ouvert pour le Web.

3. « H.264 est libre d’utilisation à certaines conditions »

Rappelez-vous que H.264 coûte toujours de l’argent. Et même si des produits avec une faible base d’utilisateurs peuvent être exemptés dans un premier temps, vous devez toujours ouvrir votre portefeuille à un moment donné si vous voulez réaliser quelque chose sur le Web. Le consortium MPEG-LA a intelligemment « offert » la première dose. Une fois que vous êtes accro, ils peuvent commencer à vous présenter la facture.

C’est un leurre destiné à vous appâter.

4. « Le support de H.264 n’est pas requis dans la spécification HTML5 »

Mais cela deviendrait un autre standard de fait, fermé, comme l’était Internet Explorer 6. Et nous avons tous à l’esprit les dégâts que cela a causés au Web.

5. « Google fournit Chrome avec le greffon Flash préinstallé ; son attitude est hypocrite »

Cela revient à comparer des pommes avec des poires. Flash est un greffon que Google a choisit de fournir en même temps que son navigateur car il y a beaucoup de contenus qui nécessitent Flash sur le Web. H.264, loin de n’être qu’un simple greffon, ferait partie du navigateur lui-même.

Une chose qu’il est important d’avoir à l’esprit c’est que Flash est d’ores et déjà omniprésent. Si vous voulez profiter de la vidéo sur le Web, vous n’avez pas le choix : il vous faut Flash. Pourtant la « bataille » de la vidéo directement dans le navigateur, via HTML5, fait toujours rage sans qu’on puisse encore désigner le vainqueur. Mais à présent que Google laisse tomber le codec fermé H.264 dans son navigateur, la probabilité qu’un codec libre et ouvert finisse par s’imposer augmente.

Que Google continue de fournir le greffon Flash avec son navigateur est parfaitement compréhensible. La plupart des contenus vidéo sur le Web sont en Flash et Google Chrome peut ainsi continuer de les afficher, en attendant qu’un codec ouvert s’impose pour la vidéo directement dans le navigateur. Il n’y a aucune hypocrisie ici, seulement du pragmatisme.

Finalement le reproche fait à Google de livrer le greffon Flash avec son navigateur sert à détourner l’attention de la véritable question : est-ce que la vidéo directement dans le navigateur se fera au moyen d’une technologie ouverte ou fermée ?

Mise à jour : Certains brandiront iOS comme contre-argument mais ça ne résiste pas à l’analyse. Il y a une raison pour laquelle beaucoup d’utilisateurs d’iPhone/iPad sont prêts à payer même pour des solutions de transcodage de piètre qualité sur iOS : ils ne peuvent accéder à la plupart des sites de vidéos. La raison pour laquelle iOS trace sa route avec H.264 c’est basiquement que YouTube (le site d’hébergement de vidéos de Google, qui s’avère être le plus important sur le Web) le supporte. La vaste majorité des sites vidéo requièrent encore Flash. Cela dit, je comprends que certains des fans les plus importants d’Apple soient ennuyés par l’initiative de Google de promouvoir WebM. Perdre le support de YouTube serait un coup terrible pour Apple.

6. « H.264 est partout et le Web n’existe pas en vase clos »

Le fait qu’un format soit répandu en dehors d’Internet ne signifie pas qu’il convient pour le Web. Puisque le Web nécessite des formats ouverts, H.264 n’est pas adapté comme format de référence pour le Web, par définition.

Et l’argument selon lequel H.264 est partout et chacun devra faire avec ne tient pas la route à mon avis. Des sites comme YouTube doivent convertir et compresser les vidéos de toute façon, de sorte que très peu d’entre elles sont publiées telles qu’elles sortent de votre caméra.

Autrement dit : la recompression sera toujours là, et au lieu de réencoder le fichier en H.264 pour réduire sa taille et le jouer en ligne, il peut très bien être réencodé dans un format ouvert.

7. « H.264 peut être utilisé à la fois pour les vidéos en Flash et les vidéos HTML5, assurant une transition douce »

Comme je l’ai déjà expliqué, les vidéos sont habituellement recompressées d’une façon ou d’une autre. En effet, la plupart des sites offrent des vidéos de différents débits et de différentes tailles. Ils convertissent déjà les vidéos ! ils pourraient simplement les convertir dans un format ouvert à la place.

8. « Les utilisateurs de Firefox pourraient voir les vidéos H.264 en utilisant le greffon développé par Microsoft »

Notez bien le mot « greffon ». Cela veut dire que nous abandonnons la vidéo HTML5 pour retourner aux greffons. Tous les bénéfices de la vidéo directement dans le navigateur s’évanouissent (sans compter que le greffon n’existe que pour Windows 7). Par contre je pense qu’il est raisonnablement facile d’ajouter le support de WebM à Safari et Internet Explorer en complétant la liste des codecs supportés par le système d’exploitation[2].

9. « La part de marché des navigateurs qui supportent H.264 dépasse celle des navigateurs qui supportent WebM »

Google, avec son monopole de la publicité en ligne, met les bouchées doubles pour que ça n’arrive pas. Si je ne me trompe pas, la part des navigateurs basés sur les standards ouverts croît au détriment d’Internet Explorer. Bien qu’il soit impossible de mesurer de manière fiable les parts de marché de chaque navigateur, la plupart des données semblent le confirmer.

10 « La décision de Google restreint le choix des utilisateurs »

Nous attaquons maintenant le cœur du problème. Et malheureusement, c’est le format H.264 qui supprime le choix. Pendant que le format WebM maintient le Web comme plateforme ouverte, H.264 est un standard fermé détenu par un cartel d’industriels qui essaie d’éradiquer sans ménagement toute tentative de faire émerger une alternative.

Je suis également estomaqué de voir que Google est accusé de restreindre le choix des utilisateurs alors que Microsoft et Apple ne sont même pas mentionnés. Ils refusent de supporter WebM après tout.

11. « VP8 est contrôlé par Google et est propriétaire »

Je ne suis pas certain que cela fasse partie des griefs mais c’est l’interprétation que j’en ai. Et c’est un grief non fondé. Lisez la licence de WebM pour plus d’information]. WebM est un projet libre sponsorisé par Google et il est gratuitement disponible du fait de sa licence.

Propos finaux :

L’article tente de montrer que la décision de Google conduit à moins d’ouverture. En réalité l’article met sur la table toutes sortes de choses qui sont sans rapport avec cette question. Cela, je crois, pour embrouiller les choses, alors que la question des standards ouverts est une des plus importantes !

Nous pouvons facilement analyser ce qui permet plus d’ouverture dans le contexte du Web :

- H264 est breveté, c’est donc un standard « fermé ». Il est incompatible avec la politique du W3C sur le brevets pour un Web ouvert. Par conséquent, promouvoir H.264 comme format de référence pour la vidéo HTML5 est le contraire de promouvoir l’ouverture.

- De l’autre côté, WebM correspond bien plus à la politique des brevets du W3C. Google concède à chacun le droit d’utiliser cette technologie sans payer de redevance. Puisque WebM est ouvert, il promeut un Web ouvert.

Conclusion : En rejetant ce qui ferme le Web tout en promouvant des technologies ouvertes, Google contribue à un Web plus ouvert contrairement à ce qu’affirme l’article.

Notes

[1] Crédit photo : Justin De La Ornellas (Creative Commons By)

[2] Télécharger les codecs libres et gratuits WebM/VP8, Ogg Theora et Ogg Vorbis pour Windows – Télécharger le codec libre et gratuit WebM/VP8 pour MacOS avec les codecs libres et gratuits Ogg Vorbis et Ogg Theora pour MacOS (déposer le fichier dans votre bibliothèque QuickTime située sur votre disque dur à cet endroit : Macintosh HD/Bibliothèque/QuickTime).

Un nouvel élément à ajouter à

Un nouvel élément à ajouter à  Il y a quelques temps nous recevions une question fort pertinente via le formulaire de contact du Framablog. Une question du genre de celles dont on n’improvise pas la réponse dans la foulée, et il arrive alors que les réponses se fassent attendre un moment. Toutefois, les réponses une fois construites peuvent valoir le coup d’être partagées… [

Il y a quelques temps nous recevions une question fort pertinente via le formulaire de contact du Framablog. Une question du genre de celles dont on n’improvise pas la réponse dans la foulée, et il arrive alors que les réponses se fassent attendre un moment. Toutefois, les réponses une fois construites peuvent valoir le coup d’être partagées… [ Voici une courte traduction qui fait en quelque sorte la jonction entre

Voici une courte traduction qui fait en quelque sorte la jonction entre  Wikipédia célèbre ses

Wikipédia célèbre ses  Lorsque

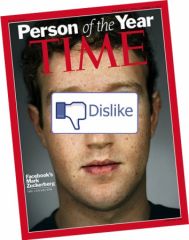

Lorsque  Répondons sans attendre à la question du titre. Vous trouverez la version française du bouton « J’aime pas » Facebook, ci-dessous, sur le Framablog ! Explications…

Répondons sans attendre à la question du titre. Vous trouverez la version française du bouton « J’aime pas » Facebook, ci-dessous, sur le Framablog ! Explications…

Alors, à quoi ressemblait cette fameuse semaine aux HackWeeks « automne 2010 » finalement ?

Alors, à quoi ressemblait cette fameuse semaine aux HackWeeks « automne 2010 » finalement ?