À l’ère de la surveillance numérique – Interview d’Antoine Tricot

Sur les ondes de France Culture, Antoine Tricot a récemment cosigné une série de quatre épisodes sur La Série Documentaire intitulée « À l’ère de la surveillance numérique ». Quatre épisodes pour parler du capitalisme de surveillance, de pouvoirs étatiques sur les outils numériques… et de comment s’y soustraire. Quatre épisodes que nous vous invitons à écouter, au contenu bourré d’informations, d’ambiances sonores, de témoignages de différents milieux professionnels, et dont nous avons souhaité interroger l’un des auteurs.

Bonjour Antoine, peux-tu te présenter ?

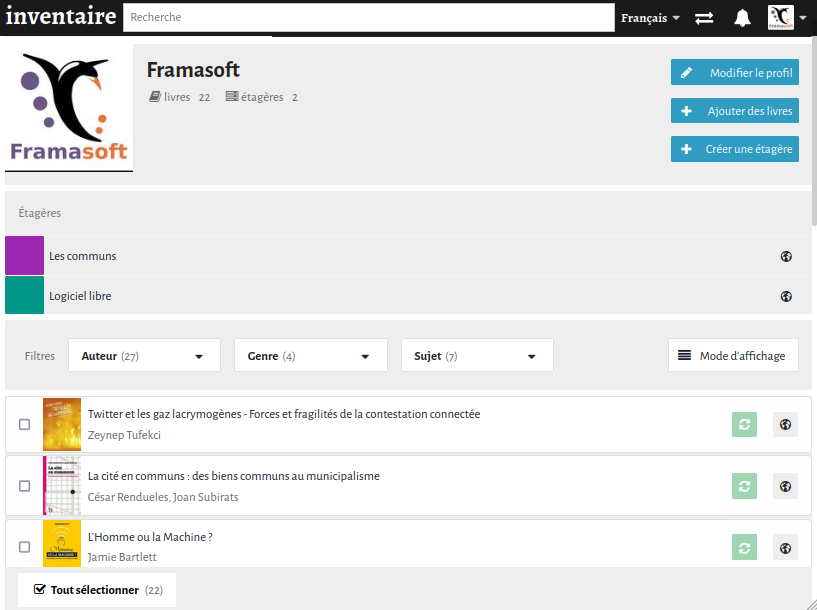

Je suis journaliste et je travaille principalement pour les émissions documentaires de la radio publique France culture. Je m’intéresse à des sujets très divers comme les quartiers populaires et les ruralités mais j’ai un petit tropisme sur les questions que posent à la société les technologies numériques et leurs usages. J’ai d’ailleurs commencé à France Culture en 2013 comme stagiaire dans l’émission Place de la Toile de Xavier De La Porte. J’ai ensuite pu organiser quelques émissions autour de ces sujets lorsque je travaillais pour l’émission Du Grain à Moudre, notamment celle intitulée « Que reste-t-il du logiciel libre ? » en 2016 où l’on a fait dialoguer Pierre-Yves Gosset de Framasoft et Bernard Ourghanlian de Microsoft ainsi qu’Amaëlle Guiton de Libération. Dernièrement, j’ai produit pour l’émission LSD – La Série Documentaire une série de 4 documentaires radio sur la surveillance numérique.

Le fonctionnement de LSD n’étant pas forcément connu de toutes et tous, peux-tu nous dire qui a travaillé sur ce documentaire audio ?

L’équipe d’un LSD est assez simple. Outre Perrine Kervran et Maryvonne Abolivier qui coordonnent l’émission, nous sommes une vingtaine de travailleuses et travailleurs indépendant.es qui proposons nos sujets régulièrement. Nous sommes ce que l’on appelle dans le jargon de la radio des « producteurs et productrices délégué⋅es ». Nous concevons les projets, proposons un découpage en quatre épisodes, nous choisissons les intervenant.es, préparons et dirigeons les interviews, écrivons et interprétons les voix-off (on appelle ça les « micros »)… Pour moi c’est un métier entre celui d’auteur et celui de journaliste. Nous travaillons avec un réalisateur ou une réalisatrice de France Culture pour monter les émissions, les mettre en son et en musique. Ici j’ai travaillé avec Rafik Zénine avec qui j’avais déjà travaillé avec plaisir sur une série autour des jeux vidéo. Et ce sont des technicien⋅nes du son qui s’occupent de la prise de son et du mixage final. Pour tous les citer, on a travaillé cette fois avec Laurent Macchietti, Martin Troadec, Valérie Lavallart et Eric Boisset.

Donc, concernant la série « À l’ère de la surveillance numérique » : comment t’es venue l’idée de ce sujet ? Et as-tu su comment la traiter dès le départ ?

L’idée de cette série est née durant le confinement. C’est un sujet que je suis depuis longtemps mais c’est à l’occasion d’un projet collectif réalisé pour LSD pendant le premier confinement et intitulé « Un printemps au temps du confinement » que j’ai commencé à en parler avec Perrine Kervran. Il me semblait que durant cette période si particulière, le débat notamment autour de l’application Stop Covid, des visioconférences et du télétravail, avait pris une amplitude rarement atteinte pour des sujets numériques qui ne mobilisent habituellement qu’une faible part de la population.

Au départ, je voulais donc surtout parler de ce que le numérique fait à nos vies et à notre société. Mais en rédigeant le projet, je me suis rendu compte que la question de la surveillance numérique revenait sans cesse. Elle était transversale à tous les autres sujets auxquels je pouvais penser. Y consacrer seulement un épisode sur quatre ne me semblait donc pas suffisant. D’autant plus que les ramifications de la question sont vraiment très complexes. J’ai donc proposé à France Culture d’angler toute la série autour de cette question et c’est ce qui a finalement été accepté à la fin de l’été 2020.

Par où as-tu commencé ?

Je commence toujours ma préparation de la même manière : par une boulimie de lectures. Que ce soit des articles scientifiques, des articles journalistiques, des livres mais aussi de la fiction en tout genre qui aborde d’une manière ou d’une autre le sujet. Sur des sujets internationaux comme celui-ci, j’essaie de varier les points de vue en lisant en français, en anglais et en allemand. Très vite, je me suis rendu compte que la surveillance numérique est extrêmement documentée et il a été difficile de faire un tri entre tout ce que je trouvais. J’ai rarement eu aussi souvent peur de passer à côté de quelque chose d’essentiel, de gommer la complexité, de tomber dans la caricature… Et à la fois, pour rendre intelligible le sujet pour toutes et tous, il était nécessaire de ne pas vouloir trop en dire de peur d’embrouiller les enjeux.

Sur la forme, toujours, comment s’est fait le choix des intervenant⋅es ?

C’est pour moi le plus difficile et une très grande partie du travail. Je ne cherche pas quelqu’un parce qu’il est connu et s’exprime beaucoup sur la question. Au contraire, le documentaire, en sortant de la maison de la radio, me semble permettre de donner la parole à d’autres que l’on entend moins. Je cherche des personnes qui ont une perspective particulière qui va éclairer la question de manière différente à chaque interview et permettre ainsi de faire avancer la narration.

Je cherche aussi des situations sonores. C’est-à-dire des situations qui vont faire entendre une ambiance, faire voyager l’auditeur quelque part où il n’irait pas forcément tout seul, lui faire comprendre des choses au-delà des mots par une ambiance. Ça peut-être par exemple la visite d’un Data Center (très sonore) ou bien le check-up des pisteurs présent sur mon smartphone avec une militante de Exodus Privacy. Cela permet des dialogues plus concrets, plus imagés, plus vivant aussi.

Un des enjeux est aussi de veiller à la parité (ou en tout cas essayer de s’en approcher) de voix féminines et masculines. Cela n’a pas été évident pour ce sujet même si les choses changent peu à peu et que certaines femmes deviennent un peu plus visibles. Il faut toujours un peu plus de temps pour trouver des interlocutrices plutôt que des interlocuteurs.

Trouver le bon équilibre entre tous ces critères est vraiment précaire et ça me terrorise jusqu’au dernier moment de ne pas avoir le bon casting. Tout se monte, mais la qualité des paroles récoltées fait beaucoup à la qualité d’un documentaire et au temps que l’on va passer sur le montage. Comme je ne veux pas faire perdre du temps aux gens en les interviewant pour ensuite m’apercevoir au montage que leur propos passe un peu à côté du sujet ou bien qu’on n’a pas la place de le mettre, je me mets énormément de pression. Malheureusement, ça arrive parfois que l’on soit obliger de passer à la trappe une interview pour de multiples raisons. On ne peut pas tout prévoir.

Et combien de temps l’ensemble du travail vous a-t-il pris ?

J’aurai du mal à dire exactement combien de temps j’y ai passé à temps plein. Environ 4 mois très chargés. En tout cas c’est très intense à chaque fois et je finis épuisé.

J’ai travaillé sur la préparation entre juillet et septembre 2020 en faisant d’autres projets à côté. Puis à temps (plus que) plein de mi-novembre à début janvier. Ensuite il y a eu 2 semaines de tournages, 5 semaines de montages, 2 semaines d’écriture de la voix off, puis 1 semaine de mixage ce qui nous a amené jusqu’à mi-mars 2021. Donc oui, 4 gros mois sans compter la rédaction du projet au départ.

Rentrons un peu dans le détail des épisodes.

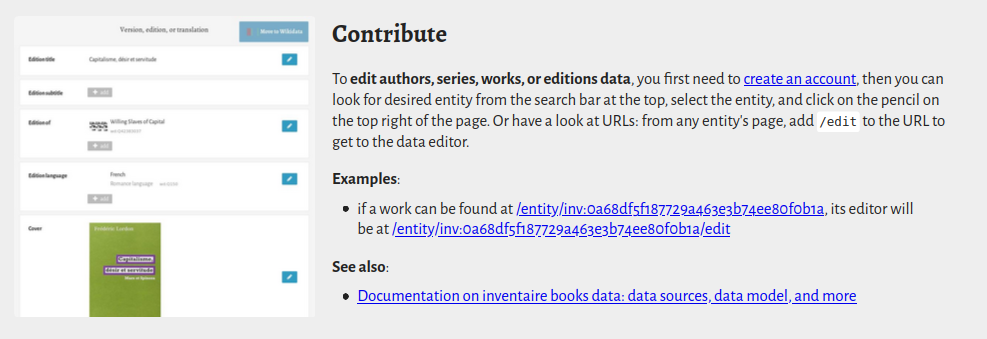

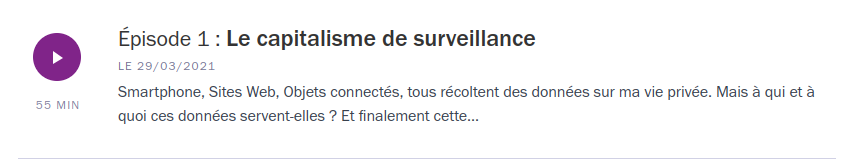

L’épisode 1, « Capitalisme de surveillance » est évidemment un sujet qui nous touche particulièrement à Framasoft. Cela fait quelques années que nous participons à sensibiliser à cette problématique. Un de nos administrateurs bénévoles que tu as interviewé, Christophe Masutti, a même écrit un ouvrage dessus. Peux-tu nous en dire plus sur cet épisode, notamment sur ce qui t’a marqué, et ce que tu y as toi-même appris ?

Ce qui me semblait important c’était de partir de ce que l’on voit le plus au quotidien : la publicité ciblée puis de montrer petit à petit l’ampleur des enjeux que peut poser la collecte massive des données numériques par des entreprises privées.

Mais je voulais aussi montrer que l’on n’est pas arrivé par hasard à cette idée de faire des profits en vendant, louant, échangeant de l’information sur les clients en puissance que sont les usagers d’internet. C’est le résultat d’une longue évolution de l’économie, du marketing et de l’industrie, en particulier américaine. Christophe Masutti l’explique très bien dans son livre Affaires privées et dans ses articles. Mais c’est rarement rappelé dans les travaux journalistiques sur la question. Heureusement, les travaux de la chercheuse américaine Shoshana Zuboff ont enfin obtenu récemment un écho que toutes les autres personnes travaillant sur ces questions depuis longtemps espéraient avoir un jour.

Ce qui m’a le plus marqué c’est bien sûr les conséquences sur la vie politique que peuvent avoir ces pratiques de traitement et d’exploitation des données à grande échelle. Ce qu’a révélé le scandale Cambridge Analytica est pour moi décisif pour comprendre comment se fabrique la politique actuellement. Les politiques ne parlent plus à un peuple de citoyens mais à des segments de consommateurs. C’est ce qui explique des discours politiques qui paraissent parfois contradictoires pour ceux qui, comme les journalistes, se situent au-delà des bulles d’informations et les reçoivent tous en même temps. Mais il faut comprendre que très peu de personnes ont une vue globale de l’information à un instant T. Ce qui compte pour un politique n’est plus de persuader une majorité d’électeurs sur un sujet donné, mais de convaincre des groupes très restreints sur des sujets de niches en adoptant une posture qui les séduit. Ce n’est pas infaillible et c’est plus limité en Europe qu’aux États-Unis du fait d’une réglementation plus protectrice des données. Mais je pense qu’il faut aujourd’hui en être conscient et en informer les citoyens si l’on veut se positionner, comme le fait Framasoft, contre ce modèle de surveillance numérique et y apporter les bonnes réponses.

Le second épisode : « Géopolitique de la surveillance numérique » est un sujet assez peu traité par les médias. Là encore, quel sentiment gardes-tu de cet épisode ?

Je suis parti d’une question assez simple : est-ce que la NSA ou bien les services Chinois lisent mes SMS ? C’est un peu ce que tout le monde se demande depuis Snowden. Mais la réponse est en fait très difficile à donner pour une seule et bonne raison : on a très peu d’informations fiables sur le sujet. De manière pas tout à fait étonnante : les espions ne parlent pas beaucoup. Certes les révélations de Snowden et les quelques leaks qui ont touché les entreprises de sécurité ces dernières années nous donnent tout de même des pistes. Mais on parle de documents qui ont maintenant parfois plus de dix ou quinze ans et entre ce qu’affichent les entreprises ou les États en interne et la réalité des pratiques, il y a parfois de grandes différences. De plus, je me suis aperçu que pour comprendre les documents de l’Affaire Snowden, il fallait souvent interpréter d’obscurs schémas, notices, slides, etc. Alors un peu comme les exégèses religieuses, des visions différentes s’opposent. Certaines plus alarmistes, d’autre plus mesurées. Attention, tout le monde est d’accord pour dire que les agences de renseignements de la plupart des États scrutent ce qu’il se passe sur internet à grande échelle. Mais le débat porte sur les capacités des services secrets des différents pays à collecter de manière massive les données, ce qu’ils peuvent faire et qui ils surveillent exactement. On ne peut pas dire que ce soient des sujets qui sont peu abordés dans les médias depuis l’affaire Snowden. Au contraire même. Mais ils le sont souvent de manière schématique.

Je parle de géopolitique car c’est ce qui s’est imposé assez vite dans ma tête : cette question de la surveillance numérique a des conséquences concrètes pour les citoyens de nombreux pays, mais elle a un impact aussi très important sur les relations internationales. C’est aujourd’hui un véritable espace de compétition internationale et d’affrontement. Et ça ne va pas aller en s’arrangeant.

On se doute que tu n’as pas de boule de cristal, mais suite à ce que tu as lu/vu/entendu : comment imagines-tu la suite des événements concernant, justement, la géopolitique de la surveillance ? Dit autrement, si tu avais la possibilité d’aller enquêter plus avant, quels seraient les sujets que tu aimerais traiter ?

J’aimerais beaucoup être un petit lutin pouvant me glisser dans les centres de renseignements de la Chine et dans les bureaux de la NSA pour pouvoir répondre à cette question.

Ce qui me paraît probable c’est que la concurrence entre les pays pour récolter le plus d’informations possible ne va pas diminuer. Cela va ouvrir encore plus d’opportunités pour toute une industrie privée fabriquant des « armes » numériques. Il y a fort à parier que ces « armes » soient un jour réutilisées par des groupes criminels pour leurs propres usages. Donc, comme le dit la juriste Aude Géry dans le documentaire cette militarisation d’Internet va avoir et a déjà des conséquences rudes pour les usagers d’Internet. Par ailleurs, l’augmentation d’acteurs privés collaborant avec les services de renseignements étatiques soulèvent aussi des questions de contrôle de ces pratiques par les gouvernements et par les parlements.

La troisième séquence de la série s’intéresse à la « Safe city ». Honnêtement, c’est un sujet que nous maîtrisons moins. En plus des militant⋅es de La Quadrature (coucou !) qui coordonnent notamment la campagne « technopolice », tu t’es rendu à Roubaix au Centre de Supervision Urbaine qui organise entre autres la gestion des caméras de surveillance de la ville. C’est à la fois un petit choc cognitif d’entendre les deux parties (citoyenne/militante, et « forces de l’ordre », comme on les appelle maintenant), et pourtant, on sent chez l’officier directeur de ce centre à la fois un grand professionnalisme, mais aussi poindre la critique des limites d’un tel système, dépendant de technologies extérieures. La police dépendant des industriels pour faire leur travail, ce n’est pas forcément nouveau, mais avec ton regard de journaliste, comment perçois-tu cette transition vers le numérique (« digitalisation », dirait-on dans certain milieux) ? Notamment en ce qui concerne la question de l’intelligence artificielle ?

(HS: on en profite pour signaler à celleux que ça intéresse une autre émission de France Culture, « Pass sanitaire et identité numérique : quels dangers pour nos libertés ? » avec l’incontournable Olivier Tesquet, mais aussi William Eldin, CEO de l’entreprise XXII dont les technos nous font plus flipper que rêver, et que tu interviewais aussi dans cet épisode 3)

Pour moi la vidéosurveillance, d’autant plus si elle est automatique, est un parfait exemple de solutionnisme technologique et c’est là où une partie de l’approche de La Quadrature du net me parle. Toute une série de facteurs d’ordre économiques, sociaux, politiques créent des situations d’insécurité et de la violence dans la société. Mais plutôt que de se confronter aux causes réelles du phénomène, on présente une solution technique comme à même d’éliminer tous les symptômes. Alors certains mettent en place des dispositifs avec professionnalisme et déontologie comme c’est le cas de Christian Belpaire à Roubaix avec qui il est vraiment intéressant d’échanger sur ces questions. Certains entrepreneurs réfléchissent sincèrement comme William Eldin qui dirige l’entreprise XXII sur ce qu’ils produisent et sur les moyens d’utiliser à bon escient la vidéosurveillance automatique. Dans des situations particulières cela peut certainement être très utile. Mais à aucun moment on pose la question du rapport coût/efficacité/conséquences pour les Droits humains. La Cour des Comptes elle-même a mis en garde les collectivités locales contre les dépenses liées à la vidéosurveillance dans la mesure où aucune enquête ne prouve jusqu’à présent son efficacité pour lutter contre la délinquance par rapport aux dispositifs préexistant. Mais cela n’empêche pas les politiques d’en installer toujours plus. Je le vois concrètement à Saint-Denis où j’habite depuis les dernières élections municipales de 2020. Les entreprises ne s’y trompent pas non plus. La pression sur les collectivités locales est très importante car les sommes en jeu sont colossales. Et l’argent qui est utilisé là, n’est pas utilisé ailleurs.

Les investissements dans ce domaine participent d’une logique politique actuelle qui préfère mettre beaucoup de sous sur un temps réduit dans des équipements plutôt que de financer sur le long terme des salaires. Pourtant, j’ai passé beaucoup de temps dans les quartiers populaires à Dunkerque et j’ai pu observer l’impact positif que pouvait avoir la présence des éducateurs de rue sur la délinquance et bien d’autres situations de détresse. Et pourtant, je ne connais aucun politique qui actuellement se vante d’augmenter les ressources de ces dispositifs de prévention spécialisée.

Enfin, la quatrième et dernière partie s’intéresse aux solutions. Là encore, on y croise des gens proches de Framasoft ou qu’on aime beaucoup (coucou Geoffrey), et même des personnes de Framasoft (l’une de nos co-présidentes, Maiwann). Toujours sans redire ce qui s’est dit dans le documentaire, quels étaient tes sentiments en interrogeant ces chercheurs, journalistes, militant⋅es ? T’es-tu dit que c’était foutu ou qu’il restait de l’espoir ?

Je suis de nature optimiste. Des peuples ont renversé des autocrates tout puissants tout au long de l’histoire. Rien n’est définitif. On parle aujourd’hui plus que jamais de ces dispositifs de surveillance numérique. On commence à comprendre le danger qu’ils représentent pour la démocratie. Des structures comme Framasoft obtiennent une audience auprès du grand public qu’aucun bidouilleur du logiciel libre n’a eu jusqu’à présent. De plus en plus de personnes comprennent les nécessités d’étendre le chiffrement à toutes les communications numériques. L’application Signal s’impose comme une référence dans le domaine de la messagerie… Alors certes, la puissance des multinationales peu vertueuses et des autocraties sans scrupule n’en sort pas diminuée. Mais il y a de l’espoir. Et ce que j’aborde dans le documentaire n’est qu’une toute petite partie des initiatives et résistances qui existent et se développent aujourd’hui.

Au final, maintenant ce travail publié et diffusé, il y a forcément pour nous une frustration à ce que ce travail de vulgarisation et de sensibilisation, qu’on considère comme important et largement financé par de l’argent public, ne soit pas sous licence libre (si les hautes sphères de Radio France nous lisent et veulent en discuter, on est disponibles pour en parler !). Cependant, te concernant, quelles suites souhaiterais-tu voir donner à cette série ?

La licence n’est pas libre car actuellement Radio France tente de reprendre la main sur la diffusion de ses podcasts face aux plateformes qui réalisent des profits grâce aux productions du service public. Le paradoxe est donc qu’il faut restreindre la diffusion pour qu’elle soit plus pérenne et ne soit pas soumise au bon vouloir des Google, Apple et autres Spotify. Cependant toutes les productions de France Culture sont disponibles sur le site internet tant que Radio France restera un service public. On ne peut donc qu’espérer qu’un maximum de personnes écoute, partage, commente, critique et se réapproprie les pistes que j’ai déployées dans cette série documentaire. Ce n’est qu’une brique de plus dans les efforts fait pour documenter et réfléchir la place de la technologie dans la société et il reste beaucoup à dire et à faire.

Dernière question, traditionnelle : y a-t-il une question que l’on ne t’a pas posée ou un élément que tu souhaiterais ajouter ?

Demandez à Google et à la NSA… ils doivent bien savoir ce que l’on a oublié.

Merci Antoine !