Descendez dans la rue et demandez (gentiment) aux gens de vous parler du logiciel libre et vous constaterez encore trop souvent ignorance et méconnaissance du sujet.

Descendez dans la rue et demandez (gentiment) aux gens de vous parler du logiciel libre et vous constaterez encore trop souvent ignorance et méconnaissance du sujet.

Mais c’est paradoxalement également le cas d’Internet alors que, contrairement au cas précédent, tout le monde en a entendu parler et (presque) tout le monde en fait usage au quotidien[1].

Comment voulez-vous que les gens adhèrent aux mouvements de défense de la neutralité du Net si ils ne comprennent même pas ce qu’est le Net ?

Une nouvelle traduction qui souhaite participer à améliorer la situation…

PS : J’ai particulièrement apprécié cette phrase : « La copie est pour les ordinateurs ce que la respiration est pour les organismes vivants ».

Tout ce que vous devez savoir sur Internet

Everything you need to know about the internet

John Naughton – 20 juin 2010 – The Guardian – The Observer

(Traduction Framalang : Olivier Rosseler)

En dépit de toutes les réponses qu’Internet nous apporte, son plein potentiel à transformer nos vies reste encore à découvrir. Voici neuf points clés pour comprendre l’outil le plus puissant de notre époque, et où il nous emmène.

Notre marche vers le futur a connu un drôle d’évènement. D’outil exotique, l’Internet est devenu une commodité, comme l’électricité ou l’eau courante, et ce, sans vraiment qu’on s’en aperçoive. Nous sommes donc devenus complètement dépendants d’un système pour lequel nous montrons étrangement très peu de curiosité.

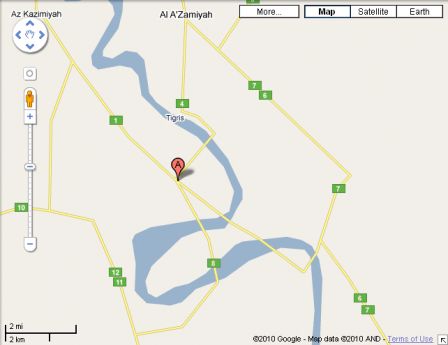

J’exagère en parlant de dépendance ? Demandez son avis à l’Estonie, l’un des pays les plus dépendants d’Internet au monde, qui a été presque entièrement paralysé durant deux semaines en 2007 par des attaques dirigées contre son infrastructure réseau. Ou bien imaginez qu’un jour vous ne puissiez plus réserver de vols, effectuer d’opération sur votre compte bancaire, vérifier les horaires de bus, faire de recherches, appeler votre famille avec Skype, acheter de la musique chez Apple ou des livres chez Amazon, vendre des trucs sur eBay, regarder des vidéos sur Youtube ou écouter les programmes de la BBC sur iPlayer, ou toutes les 1001 autres choses qui vous sont devenues aussi naturelles que respirer.

Internet s’est doucement mais sûrement infiltré dans nos vies, sans véritable évaluation du phénomène de notre part. Ce n’est pas par manque d’informations sur ce réseau, au contraire, on pourrait se noyer dedans. C’est plutôt par manque de compréhension du phénomène. Nous sommes, comme le décrit un grand penseur du cyberespace, Manuel Castells, hypnotisés par l’information.

Les médias traditionnels ne nous aident pas beaucoup ici car leur couverture d’Internet est largement, si ce n’est entièrement, négative. S’ils veulent bien reconnaître que c’est un outil essentiel à l’éducation de nos enfants, ils n’ont également de cesse de souligner que c’est un espace envahi par des prédateurs virtuels à la recherche de gamins à séduire et tromper. On dit ainsi que « Google nous rend stupide », qu’il détourne notre attention, et qu’il est aussi à l’origine d’une épidémie de plagiat. Et puis l’échange de fichiers détruit la musique, les nouvelles en ligne tuent la presse traditionnelle et Amazon assassine les librairies. Le réseau se moque des injonctions légales et le Web est tissé de mensonges, de déformations et de demi-vérités. Quant aux réseaux sociaux, ils attisent le feu de ces « flash mobs » vindicatifs qui tendent des pièges à d’innocents journalistes comme Jan Moir, etc.

Que devrait en penser un observateur indépendant ? Si Internet est une chose si horrible, pourquoi est-ce que 27% de la population mondiale (environ 1,8 milliards de personnes) l’utilisent joyeusement chaque jour et que des milliards d’autres n’espèrent qu’une chose, pouvoir les rejoindre ?

Quelle vision plus équilibrée du Net pouvons nous offrir ? Que vous manque-t-il pour mieux comprendre le phénomène Internet ? Après mûre réflexion, j’en suis arrivé à la conclusion qu’il suffit de quelques grandes idées qui, mises bout à bout, dissipent l’hypnotisme dont Castells parle avec tant d’éloquence.

Combien d’idées exactement ? En 1956, le psychologue George Miller a publié un article célèbre dans le journal Psychological Review. Son titre était « Sept, plus ou moins deux, le nombre magique : limites de notre capacité à assimiler les informations » et Miller y résume ses expériences précédentes qui visaient à mesurer les limites de la mémoire à court terme. À chaque fois il rapporte que la « capacité à intégrer » est comprise entre cinq et neuf items. Miller n’a pourtant pas tiré de conclusion de ses expériences, il s’est contenté simplement de conjecturer que « le chiffre sept qui revient régulièrement a peut-être une signification, ou alors ce n’est que pure coïncidence ». Et cela s’arrêtait là pour lui.

Mais Miller a sous-estimé l’attrait de la culture populaire pour tout ce qui contient « magique » dans le titre. Et cet article propulsa Miller au rang d’une espèce de sage, celui qui aurait découvert une vraie vérité de la nature humaine. Il écrira plus tard : « Mon problème est que j’ai été persécuté par une nombre entier. Pendant sept ans ce nombre m’a poursuivi, jusque dans mes données les plus personnelles, et m’a traqué jusque dans les pages de nos journaux les plus publics… Soit ce nombre a vraiment quelque chose de particulier, soit je suis atteint de délire paranoïaque. » L’idée qui émerge de l’article de Miller a pourtant traversé les années. Il semblerait que notre mémoire à court terme ne puisse emmagasiner que cinq à neuf « morceaux » d’information à tout moment (ici morceau signifie « unité significative »). Lorsqu’il s’agit de déterminer combien d’idées auront un véritable impact sur les lecteurs, il semble logique de s’arrêter au nombre magique de neuf. Les voici donc.

1. Prenez la longue vue

Ce qu’il y a de particulier lorsqu’on vit une révolution, c’est qu’il est difficile de prendre du recul. Vous imaginez vous, habitant Saint-Petersbourg en 1917, dans les mois précédant la prise du pouvoir par Lénine et les bolcheviques ? Vous sentez que quelque chose de grand se trame, que des rumeurs et des théories se contredisent, mais personne ne sait ce qu’il va en résulter. C’est seulement avec un peu de recul qu’il est possible de se faire une idée de ce qui se passe. Mais la clarté que nous offre le recul est trompeuse, elle sous-estime la complexité des évènements tels qu’ils apparaissent à ceux qui les vivent.

Internet est donc parmi nous désormais. Nous vivons une transformation radicale de notre écosystème de communication. Ne disposant pas du luxe du recul, nous ignorons encore où cela va nous mener. Et s’il y a un enseignement que l’on peut tirer de l’histoire des communications, c’est bien que l’impact à court terme des nouvelles technologies est plutôt surestimé alors que leur impact à long terme est sous-estimé.

Nous en sommes les témoins permanents, comme des petits scientifiques, commentateurs, écrivains, consultants et visionnaires en herbe qui offrent leur petite interprétation personnelle de l’impact d’Internet sur le business, la publication, le commerce, l’éducation, la politique et le futur de la civilisation telle que nous la connaissons. Ces idées sont souvent résumées en slogans chocs, redites ou autres aphorismes : l’information « veut être libre », la « longue traîne » est le futur du commerce en ligne, « Facebook vient de prendre le contrôle d’Internet », etc. Ces slogans ne sont que des extrapolations à court terme des expériences d’hier et d’aujourd’hui. Ils ne révèlent rien de la révolution que nous vivons.

Alors peut-on faire mieux, sans tomber dans le piège de la prétention à l’omniscience ?

On commence avec une idée neuve : pourquoi ne pas regarder si l’histoire peut nous apprendre quelque chose ? L’humanité a déjà connu une transformation de son écosystème de communication avec l’invention de l’imprimerie. Cette technologie a changé le monde, elle a effectivement façonné l’environnement culturel dans lequel nous avons grandi. Et l’avantage, du point de vue de cet article, est que nous bénéficions du recul, nous savons ce qui s’est passé.

Une expérience de pensée

Ok, on va donc faire ce que les Allemands appellent une Gedankenexperiment, une expérience de pensée. Imaginons que les changements que va apporter Internet dans notre écosystème de communication soient comparables à la rupture introduite par l’imprimerie. Quel enseignement pourrions-nous tirer d’une telle expérience ? Les premières Bibles imprimées sont sorties en 1455 des presses inventées par Johannes Gutenberg dans la ville allemande de Mayence. Alors, vous êtes en 1472, soit 17 ans après 1455. Concentrez vous un peu plus et imaginez que vous êtes l’équivalent médiéval d’un enquéteur pour un institut de sondage. Vous êtes là, sur le pont de Mayence avec vos feuillets de réponse et vous posez aux passants quelques questions. Voici quatre questions : sur une échelle de un à cinq, où 1 correspond à pas du tout d’accord et 5 signifie complètement d’accord, pensez-vous que l’invention de Herr Gutenberg va :

- Saper l’autorité de l’église catholique ?

- Encourager la Réforme ?

- Permettre l’avènement de la science moderne ?

- Faire émerger des classes sociales et des professions encore inconnues ?

- Modifier notre conception de l’enfance, au profit d’une vision protectrice des premières années d’une personne ?

Sur une échelle de un à cinq ! Le simple fait de poser la question révèle toute la stupidité qu’elle renferme. L’imprimerie a entraîné tous ces changements, mais personne en 1472 à Mayence (ou n’importe où dans le monde) n’aurait pu se douter de l’impact qu’elle allait avoir.

Cet article est daté de 2010, soit 17 ans après que le Web ait émergé. Si je ne me trompe pas en comparant Internet et l’imprimerie pour leurs effets sur notre écosystème de communication, il serait complètement absurde de ma part (ou de la part de n’importe qui d’autre) de prétendre en connaître les ramifications à long terme. L’honnêteté impose donc d’avouer notre ignorance.

Cependant, tous ceux que le Net touche exigent une réponse immédiate. Les journalistes de la presse écrite et leurs employeurs s’inquiètent du devenir de leur industrie. Il en va de même pour les vendeurs de musique, les maisons d’édition, les chaînes de TV, les stations de radio, les gouvernements, les agences de voyages, les universités, les entreprises de téléphonie, les compagnies aériennes, les bibliothèques, et bien d’autres encore. Malheureusement pour eux, ils vont devoir apprendre à être patients. Et pour certains, la réponse viendra trop tard.

2 Le Web n’est pas Internet

On pense souvent, à tort, que le Web et Internet désignent la même chose. Ça n’est pas le cas.

Pour mieux comprendre la différence, on peut faire une analogie avec le réseau ferré. Internet, c’est les rails et la signalisation, c’est l’infrastructure sur laquelle repose tous les services. Sur le réseau ferré, l’infrastructure accueille différents types de services : les trains à grande vitesse, les trains locaux qui marquent tous les arrêts, les trains de banlieue, les trains de marchandise et (parfois) ceux dédiés à l’entretien.

Sur Internet, les pages Web ne constituent qu’une part du trafic qui circule sur ces voies virtuelles. Les autres types de trafic sont par exemple la musique échangée par les réseaux pair-à-pair, ou de l’iTunes Store, les films voyageant par BitTorrent, les mises à jour logicielles, les e-mails, la messagerie instantanée, les conversations téléphoniques par Skype ou d’autres services de VoIP (la téléphonie Internet), les services de streaming vidéo et audio et encore d’autres trucs trop obscurs pour être mentionnés. Or (et c’est là que ça devient intéressant) l’Internet dans 10 ans abritera sans doute de nouveaux types de trafics, des innovations que l’on n’imaginerait même pas dans nos rêves les plus fous.

Retenez que le Web est gigantesque et très important, mais ce n’est qu’un des nombreux services qui tournent sur Internet. Le Net est plus grand encore et surtout bien plus important que les services qu’il véhicule. Saisissez cette distinction simple et vous aurez accompli un grand pas vers la sagesse.

3 La rupture est un atout, pas un défaut

Le Net a une capacité sans précédent à bouleverser l’ordre établi, ce qui peut choquer les gens. Un jour votre entreprise est florissante, à la tête de votre label de musique par exemple, et le lendemain vous vous battez pour votre survie et vous payez des sommes fantastiques à des avocats spécialisés en propriété intellectuelle dans un combat perdu d’avance pour tenter de stopper l’hémorragie. Ou alors vous dirigez un groupe de presse et vous vous demandez où se sont évaporés les revenus publicitaires réguliers que vous engrangiez. Ou encore, vous êtes ce bibliothécaire universitaire qui se demande pourquoi de nos jours les étudiants consultent uniquement Google.

Comment tout cela a-t-il pu arriver ? Et surtout, pourquoi aussi vite ?

La réponse se cache dans les entrailles de l’architecture du réseau. À sa conception, dans les années 1970, Vint Cerf et Robert Kahn, ingénieurs en chef, ont été confronté à deux difficultés principales : comment créer un système liant pléthore d’autres réseaux en toute transparence, et comment créer un système taillé pour le futur ? Leur solution est désarmante de simplicité. Elle est construite autour de deux axiomes. Premièrement, le réseau n’appartiendra à personne, aucune institution ne devrait décider de qui pourrait rejoindre le réseau ou de l’usage qui en est fait. Deuxièmement, le réseau ne devrait pas être optimisé pour un usage particulier. C’est d’un réseau simple, qui ne fait qu’une chose : accompagner les paquets de données de leur point d’entrée jusqu’à leur destination. Le réseau se devait d’être neutre quant au contenu de ces paquets, que ce soient des bouts d’e-mail, une vidéo porno, une conversation téléphonique, une image… Le réseau ne fait pas la différence et les traite de la même manière.

En mettant en application ces deux concepts, Vint Cerf et Robert Kahn créèrent un terrain de jeu mondial ouvert aux surprises. Avec ce singulier cahier des charges, si vous avez une idée qui peut se concrétiser grâce à des paquets de données, alors Internet est tout de suite à disposition pour la mettre en œuvre. Et aucune demande d’autorisation n’est requise. L’explosion de la créativité que le monde a connu depuis l’émergence du réseau dans les années 1980 a certainement pris beaucoup d’institutions et d’entreprises par surprise, mais elle était prévisible si l’on s’en réfère à son architecture. Le monde est plein de programmeurs futés et le Net était le terrain de jeu parfait pour tester leurs inventions. Quelles inventions ? Le Web lui-même par exemple. On le doit essentiellement à un seul individu, Tim Berners-Lee, qui, en 1991, a mis son code sur un serveur Internet sans demander la permission à qui que ce soit.

Dix ans après les travaux de Berners-Lee, un ado rebelle, féru de musique, du nom de Shawn Fanning passa six mois à écrire un logiciel de partage de fichiers de musique et, en 1999, il mit sa petite surprise en ligne. Répondant au nom de Napster, il conquit 60 millions d’utilisateurs enchantés avant que les maisons de disque ne le fassent fermer. Mais le virus de l’échange de fichiers s’était déjà propagé.

Et pendant ce temps, plein d’autres programmeurs tout aussi ingénieux nous concoctaient des surprises plus sombres : le spam, les virus, les vers et autres exploitations de failles de sécurité qu’ils ont pu faire déferler sur un réseau qui ne se soucie pas du contenu de vos paquets de données. Les dangers potentiels de cette explosion de « pourriciels » sont alarmants. Par exemple, des groupes mystérieux ont assemblé ce qu’on appelle des « botnets » (constitué de millions d’ordinateurs connectés au réseau et secrètement corrompus) pouvant être utilisés pour lancer des attaques massives et coordonnées qui pourraient tout à fait mettre à genoux l’infrastructure réseau de n’importe quelle entreprise, voire de pays entiers. À l’exception de l’Estonie en 2007, nous n’avons heureusement pas assisté à ce genre d’attaque jusque là, mais on peut craindre que cela finisse par se produire. Ce sera alors le 11 septembre du Net.

Les bouleversements qu’apporte le Net sont inscrits dans son ADN technique. En jargon de programmeur, c’est un avantage, et non un bogue, c’est à dire une fonctionnalité intentionnelle, pas une erreur. Il est difficilement envisageable du supprimer les fonctions du réseau qui permettent ces surprises désagréables sans affecter les autres formes de créativité qu’il génère.

4 Pensez écologie, pas économie

L’économie, comme outil d’analyse, peut perdre ses repères lorsqu’elle est appliquée au Net. En effet l’économie s’intéresse à la distribution de ressources limitées, alors que le monde virtuel, au contraire, se distingue plutôt par l’abondance. Similairement, l’écologie (l’étude des systèmes naturels) se spécialise dans l’abondance et emprunter le regard d’un écologiste pour décrire Internet n’est pas dénué de sens.

Depuis l’avènement du Web en 1993, l’écosystème médiatique est devenu incommensurablement plus complexe. L’ancien écosystème des médias de masse industrialisé s’essoufle, détenu par quelques éditeurs et diffuseurs puissants mais peu réactifs, à destination d’un public de masse constitué essentiellement de consommateurs passifs, cible de contenus formatés. Il se caractérise également par la faiblesse du nombre de moyens de communication et par une évolution lente. Le nouvel écosystème se développe rapidement, les éditeurs se comptent par millions et le public en milliards de lecteurs, d’auditeurs, de spectateurs actifs, expert en Web et très informés. Les moyens de communications sont indénombrables et tout cela évolue à une vitesse phénoménale.

Pour un écologiste, ce sont les signes distinctifs d’un écosystème dont la biodiversité a explosé. C’est un monde où les grandes créatures comme les dinosaures (pensez à Time Warner, Encyclopædia Britannica) continuent à avancer lentement, paisiblement, en s’échangeant de l’information par grosses bribes, mais où parallèlement la vie évolue en un écosystème où des miliards de plus petites espèces consomment, transforment, agrègent ou désagrègent et échangent l’information par petites bribes et duquel de nouvelles formes de vie géantes (Google, Facebook…) émergent. Dans la nature, une telle biodiversité accrue, où énergie et matière se consomment et se consument plus rapidement, est synonyme de croissance de l’ensemble du système.

Est-il possible que la sphère de l’information subisse une telle évolution ? Et si c’est le cas, qui en profitera à long terme ?

5 La complexité est la nouvelle réalité

Même si vous n’êtes pas d’accord avec la métaphore écologique, notre environnement informationnel devient plus complexe, cela ne fait aucun doute.

Nombre de participants, densité d’interactions, vitesse d’évolution… cette complexité est sans commune mesure avec tout ce qu’on a pu voir auparavant. Et elle n’est pas une aberration, il ne faut pas souhaiter qu’elle retourne d’où elle vient : c’est la nouvelle réalité, une réalité avec laquelle nous devons composer. Cela ne sera pas facile, pour plusieurs raisons.

D’abord, le comportement des systèmes complexes est souvent difficile à comprendre, et encore plus à prédire. Ensuite, et c’est là le point important, nos systèmes de création de valeur et de gouvernances ne sont pas équipés pour affronter la complexité. L’approche habituelle des entreprises est de réduire la complexité : racheter un concurrent, rendre captif le consommateur, créer des produits et des services standardisés, etc. Dans le nouvel environnement ces stratégies risquent fort d’échouer. Il faudra être intelligent, habile, flexible, réactif et accepter les échecs afin de proposer de meilleures statégies pour s’adapter à tout ce que cet environnement connecté cache comme surprises.

6 Le réseau est l’ordinateur désormais

Pour la génération du baby-boom, les ordinateurs étaient des PC isolés, tournant avec des logiciels Windows. Et puis, ces appareils se sont connectés, d’abord localement (dans les réseaux d’entreprises) et enfin mondialement (grâce à Internet). Mais à mesure que les accès à haut débit se sont démocratisés, on a assisté à quelque chose d’étrange : avec une connexion rapide au réseau, aussi bien l’endroit où sont stockées vos données que celui où le processeur opère est devenu secondaire. Et votre travail s’en est retrouvé simplifié. On a vu d’abord les entreprises dont le cœur de métier est la recherche (Yahoo, Google, Microsoft dans une certaine mesure) se mettre au webmail, ce service d’e-mail fourni par des programmes qui ne tournent pas sur votre PC mais sur des serveurs, quelque part dans le nuage Internet. Puis Google a lancé ses produits bureautiques dématérialisés, le traitement de texte, le tableur, les présentations, etc.

Une transition s’effectue entre un monde où le PC était l’ordinateur et un monde où le réseau devient l’ordinateur. Et nous sommes désormais à l’ère de l’informatique dans les nuages, une technologie où, par l’intermédiaire d’appareils simples (téléphones portables, netbooks, tablettes), on peut accéder à des services délivrés par de puissants serveurs quelque part sur le Net. Cette évolution a des implications importantes pour notre vie privée et notre sécurité alors que dans le même temps le développement économique et la perception publique évoluent lentement par rapport à la vitesse à laquelle se produisent les changements. Que deviennent vos photos de famille si elles sont stockées dans les nuages et que vous emportez votre mot de passe dans la tombe ? Et qu’en est-il de vos documents et de vos e-mails, eux aussi stockés dans les nuages sur un serveur tiers ? Ou encore votre reputation sur eBay ? Dans tous les domaines, le passage à l’informatique dans les nuages a des implications importantes car il nous rend plus dépendant encore du Net. Et pourtant nous avançons comme des somnambules dans ce meilleur des mondes.

7 Le Web évolue

Il fut un temps où le Web n’était qu’un outil de publication, où les éditeurs (professionnels ou amateurs) mettaient en ligne des pages Web statiques et passives. Nombreux sont ceux, dans le monde des médias, pour qui cette description correspond toujours à la réalité du Web.

Or le Web a connu depuis au moins trois phases évolutives : du Web 1.0 du début, au Web 2.0 fait de « petites briques faiblement liées » (NdT : en référence au livre Small Pieces Loosely Joined) – réseaux sociaux, remix, webmail, etc. – et, selon l’idée de Tim Berners-Lee, il devient maintenant une sorte de Web 3.0 sémantique où les pages Web contiennent suffisamment de données pour permettree aux logiciels d’analyser leur pertinence et leur fonction.

Si nous voulons comprendre le Web tel qu’il est et non pas tel qu’il fut, il faut constamment adapter les perceptions que nous nous en faisons. Nous devons nous souvenir qu’il n’est plus seulement un moyen de publication.

8 Huxley et Orwell sont les serre-livres de notre futur

Il y a maintenant quelques années de cela, le critique culturel et théoricien des médias Neil Postman prédisait que les intuitions de deux écrivains encadreraient notre futur, comme deux serre-livres. Pour Aldous Huxley, nous serons détruits par les choses que nous aimons, alors que pour George Orwell nous serons détruits par les choses que nous craignons.

À l’époque de Postman, l’Internet n’avait pas encore aquis l’importance qu’il a maintenant, mais je crois qu’il avait raison. D’un côté (du côté huxleyen), le Net a eu une profonde influence libératrice sur nos vies : l’information, le divertissement, le plaisir, la joie, la communication et la consommation sans effort ni limites. À tel point que cela en est presque devenu une drogue, surtout pour les plus jeunes générations. L’inquiétude des professeurs, des gouvernements et des hommes politiques est à la mesure du phénomène. « Google nous rend-il stupide ? » : tel est le titre de l’un des articles les plus cités en 2008 du magazine Atlantic. Nicholas Carr, blogueur réputé, en est l’auteur et il s’y demande si l’accès permanent à l’information en ligne (pas seulement Google) fait de nous des penseurs superficiels et turbulents à la capacité de concentration réduite (d’après une étude de Nielsen, entreprise spécialiste des études de marché, un internaute reste en moyenne 56 secondes sur une page Web). Pour d’autres, l’usage immodéré d’Internet serait en train de reconfigurer les connexions dans notre cerveau.

De l’autre côté, le côté orwellien, Internet est ce qui s’approche le plus de la machine de surveillance parfaite. Tous vos faits et gestes sur le Net sont enregistrés, chaque e-mail envoyé, chaque site Web visité, chaque fichier téléchargé, chaque terme cherché, tout est enregistré et stocké quelques part. Soit sur les serveurs de votre fournisseur d’accès, soit chez les fournisseurs de services dans les nuages que vous utilisez. C’est l’outil rêvé d’un état totalitaire qui souhaiterait connaître le comportement, les activités sociales et les modes de pensée de ses sujets.

9 Les lois sur la propriété intellectuelle ne sont plus adaptées à leur objet

Dans le monde analogique, il était difficile de copier et on perdait en qualité (les copies de copies devenaient graduellement moins bonnes). Dans le monde numérique, la copie se fait sans peine et elle est parfaite. En réalité, la copie est pour les ordinateurs ce que la respiration est pour les organismes vivants, puisqu’elle est présente dans toutes les opérations de calcul. Lorsque par exemple vous regardez une page Web, une copie de celle-ci est chargée dans la mémoire de votre ordinateur (ou de votre téléphone portable, de votre iPad…) avant que l’appareil ne puisse l’afficher sur l’écran. Si bien que vous ne pouvez même pas regarder un contenu quelconque sur le Web sans en faire (à votre insu) une copie.

Notre régime de propriété intellectuelle actuel a été conçu à une époque où la copie était difficile et imparfaite, il n’est donc pas étonnant de constater qu’il n’est plus en phase avec le monde connecté. Et, pour remuer le couteau dans la plaie (ou déposer la cerise sur le gateau, question de point de vue), la technologie numérique propose aux usagers d’Internet des logiciels simplifiant au maximum la copie, l’édition, le remix et la publication de ce qui est disponible sous forme numérique, ce qui englobe pratiquement tout de nos jours. Ainsi, des millions de personnes sont devenues des éditeurs, en ce sens qu’ils publient leurs créations sur des plateformes mondiales telles que Blogger, Flickr et Youtube. Et par ricochet les violations du droit d’auteur, même minimes, sont partout.

Tout désagréable qu’il soit, c’est un fait incontournable, tout comme le fait que les jeunes adultes ont tendance à boire trop d’alcool. L’ultime protection anti-copie est de débrancher le Net. Le droit d’auteur n’est pas mauvais en soi (l’alcool non plus), mais il est devenu tellement déconnecté de la réalité qu’il perd tout crédit. Une réforme est plus que nécessaire pour adapter le droit d’auteur au monde numérique. Mais il semblerait qu’aucun législateur ne soit encore parvenu à cette conclusion. L’attente risque donc d’être longue.

Post-scriptum

Il serait ridicule de prétendre que ces neuf idées englobent tout ce qu’il faut savoir à propos du Net. Elles constituent simplement les fondations d’une vision plus globale de la situation et peuvent même servir d’antidote face à certaines étroites et hâtives extrapolations sur le développement du cyberespace.

Malheureusement, s’il y a une vérité connue à propos d’Internet, elle est plutôt prosaïque : la seule réponse rationnelle à toutes les questions sur les implications à long terme du réseau est la célèbre phrase attribuée au ministre des Affaires étrangères de Mao Tsé-toung, Zhou Enlai, qui interrogé sur le bilan qu’il faisait de la Révolution française répondit sagement : « Il est encore trop tôt pour se prononcer ».

Et c’est bien le cas.

John Naughton est professeur à l’Open University. Il rédige actuellement un livre sur le phénomène Internet.

Un court billet pour évoquer la relation entre le software et le hardware, entre le logiciel et le matériel, à l’ère où le (mal nommé)

Un court billet pour évoquer la relation entre le software et le hardware, entre le logiciel et le matériel, à l’ère où le (mal nommé)  Prenant des allures de « Courrier International du Libre » (mais sans les

Prenant des allures de « Courrier International du Libre » (mais sans les  Descendez dans la rue et demandez (gentiment) aux gens de vous parler du logiciel libre et vous constaterez encore trop souvent ignorance et méconnaissance du sujet.

Descendez dans la rue et demandez (gentiment) aux gens de vous parler du logiciel libre et vous constaterez encore trop souvent ignorance et méconnaissance du sujet. Avec l’avènement d’Internet on parle régulièrement de révolution dès qu’un petit malin trouve le moyen de faire avec des bits d’information ce qu’on faisait jusque là avec des atomes de matière.

Avec l’avènement d’Internet on parle régulièrement de révolution dès qu’un petit malin trouve le moyen de faire avec des bits d’information ce qu’on faisait jusque là avec des atomes de matière.