Rien de tel pour aborder la rentrée scolaire qu’un excellent article de synthèse de notre ami Jean-Pierre Archambault qui réunit ici deux de ses sujets favoris : le logiciel libre et la place de l’informatique à l’école.

Rien de tel pour aborder la rentrée scolaire qu’un excellent article de synthèse de notre ami Jean-Pierre Archambault qui réunit ici deux de ses sujets favoris : le logiciel libre et la place de l’informatique à l’école.

Il est intéressant de noter que l’auteur a associé dans le titre les termes « fracture » et « solidarité », sachant bien que le logiciel, les contenus et les formats libres et ouverts apportent non seulement une réponse au premier mais développent et favorisent le second[1].

Un article un peu long pour un format blog mais qui vaut le coup ! Pour vous donner un ordre d’idée il correspond à deux cents messages Twitter que l’on parcourerait en enfilade 😉

Fracture et solidarité numériques

URL d’origine du document

Jean-Pierre Archambault – septembre 2009 – Association EPI

Licence Creative Commons By-Nd

Le thème de la fracture numérique est solidement installé dans le paysage des débats sociétaux. La nécessité de la réduire prend des allures de consensus : acceptons-en l’augure. Une raison de fond à cela : la place sans cesse croissante de l’informatique dans tous les secteurs de la société, et les enjeux qui y correspondent. La fracture numérique ce sont les inégalités d’accès aux réseaux, aux contenus entre le Nord et le Sud, ainsi qu’au sein des pays développés. Ce sont aussi les inégalités en terme de maîtrise conceptuelle du numérique. Nous examinerons ces problématiques. Le libre, désormais composante à part entière de l’industrie informatique, a permis de constituer au plan mondial un bien commun informatique, accessible à tous. Nous verrons donc pourquoi il est intrinsèquement lié à la lutte contre la fracture numérique, et donc à la solidarité numérique, avec son approche, transposable pour une part à la production des autres biens informationnels, ses réponses en matière de droit d’auteur. Comme le sont également les formats et les standards ouverts. Et nous rappellerons que dans la société de la connaissance, la « matière grise » et l’éducation jouent, on le sait, un rôle décisif.

Le numérique partout

Le numérique est partout, dans la vie de tous les jours, au domicile de chacun, avec l’ordinateur personnel et l’accès à Internet ; dans l’entreprise où des systèmes de contrôle informatisés font fonctionner les processus industriels. Ses métiers, et ceux des télécommunications, occupent une place importante dans les services. On ne compte plus les objets matériels qui sont remplis de puces électroniques. Il y a relativement, et en valeur absolue, de plus en plus de biens informationnels. C’est l’informatique, pour ne prendre que ces exemples, qui a récemment fait faire de très spectaculaires progrès à l’imagerie médicale et qui permet ceux de la génétique. Elle modifie progressivement, et de manière irréversible, notre manière de poser et de résoudre les questions dans quasiment toutes les sciences expérimentales ou théoriques qui ne peuvent se concevoir aujourd’hui sans ordinateurs et réseaux. Elle change la manière dont nous voyons le monde et dont nous nous voyons nous-mêmes. L’informatique s’invite aussi au Parlement, ainsi on s’en souvient, en 2006, pour la transposition de la directive européenne sur les Droits d’auteur et les droits voisins dans la société de l’information (DADVSI), suscitant des débats complexes où exercice de la citoyenneté rimait avec technicité et culture scientifique. Et plus récemment avec la « loi Hadopi ».

La fracture numérique

On imagine sans peine que pareille omniprésence de l’informatique signifie des enjeux forts, économiques notamment. Que tous ne soient pas sur un pied d’égalité, loin s’en faut, face aux profondes mutations que le numérique engendre ne saurait a priori surprendre. Cela vaut, à plus ou moins grande échelle, pour tous les pays. Il y a beaucoup de fractures : sanitaires, alimentaires… Culturelles aussi. Ainsi concernant la maîtrise de sa langue maternelle. Ainsi la fracture mathématique, qui serait bien plus grave encore s’il n’y avait pas un enseignement de culture générale mathématique tout au long de la scolarité. Si l’interrogation sur « la poule et l’oeuf » est éternelle, on peut penser qu’« il est certain que la fracture numérique résulte des fractures sociales produites par les inégalités sur les plans économique, politique, social, culturel, entre les hommes et les femmes, les générations, les zones géographiques, etc. »[2].

Un problème d’accès

La fracture numérique tend à être perçue, d’abord et surtout, comme un problème d’accès : les recherches sur Internet avec son moteur préféré ne laissent aucun doute à ce sujet. Il y a ceux pour qui il est possible, facile de disposer d’ordinateurs connectés au réseau mondial, et les autres. C’est vrai pour le monde en général, et la France en particulier. En juin 2008, présentant « ordi 2.0 », plan anti-fracture numérique, Éric Besson rappelait qu’« être privé d’ordinateur aujourd’hui pour les publics fragiles, c’est être privé d’accès à l’information, à la culture, à l’éducation, aux services publics, donc être exposé à un risque accru de marginalisation ». Un premier volet de son plan, qui confirmait la possibilité prévue par la loi de finances 2008, permettait aux entreprises de donner leurs ordinateurs inutiles, mais en état de marche, à leurs salariés, sans charges sociales ni fiscales. Un deuxième volet visait à favoriser la création d’une filière nationale de reconditionnement, de redistribution et de retraitement des ordinateurs, ainsi que la mise en place d’un « label de confiance », garantissant un matériel en état de fonctionnement et vendu à très bas prix.

La fracture numérique a une dimension géographique. De ce point de vue, la question de l’accès égal aux réseaux est primordiale. Une politique d’aménagement du territoire ne peut que s’en préoccuper. Avec l’objectif de « démocratiser le numérique en accélérant le déploiement des infrastructures », la décision 49 du Rapport de la Commission pour la libération de la croissance française, sous la présidence de Jacques Attali[3], consistait en la « garantie d’une couverture numérique optimale en 2011 ». La décision 51, « faciliter l’accès de tous au réseau numérique » correspondait à l’objectif de réduire les fractures numériques, dont il était dit qu’« elles recouvrent la fracture sociale ». Elle proposait d’« accélérer le taux d’équipement en ordinateurs dans les foyers et TPE/PME avec un objectif d’équipement de 85 % en 2012, au moyen notamment de donations des PC usagés, de soutiens spécifiques aux étudiants, et microcrédit social ».

Pour le World Wide Web consortium qui, le 28 mai 2008, lançait un groupe d’intérêt web mobile pour le développement social (MW4D), « les technologies mobiles peuvent ouvrir aux plus pauvres des accès à des services d’informations essentiels comme les soins de santé, l’éducation, les services administratifs »[4].

L’accès à Internet, un bien commun

Le problème de l’accès est bien réel. De l’accès à Internet, tel qu’il a été créé et a fonctionné jusqu’à maintenant, et qu’il faut préserver. En effet, Internet est, en lui-même, un bien commun accessible à tous, une ressource sur laquelle n’importe quel usager a des droits, sans avoir à obtenir de permission de qui que ce soit. Son architecture est neutre et ouverte. Le « réseau des réseaux » constitue un point d’appui solide dans la lutte contre la fracture numérique[5].

Internet repose sur des standards ouverts de formats de données (HTML pour écrire des pages web) et de protocoles de communication (TCP/IP, HTTP). Il fonctionne à base de logiciels libres : Apache, SendMail, Linux… Il est donc impossible de verrouiller le réseau par la pratique du secret. Les logiciels libres contribuent à construire une plate-forme neutre. Ils la protègent par des licences comme la GPL et la diffusion du code source, garantissant aux développeurs qu’elle le restera dans l’avenir.

Les logiciels et les contenus numériques

Si l’accent est mis, à juste titre, sur la nécessité de disposer d’un ordinateur pour accéder au monde du numérique[6], les discours sont en général plus « discrets » sur le système d’exploitation. Or, sans système d’exploitation, que les acheteurs ont encore trop souvent l’impression de ne pas payer même lorsqu’il est « propriétaire », pas de machine qui fonctionne.

La fracture numérique, c’est aussi les inégalités d’accès aux logiciels et aux contenus, les régimes de propriété intellectuelle qui entravent leur circulation, leur production. Il y a désormais deux informatiques qui coexistent : libre et propriétaire. Des contenus numériques sous copyright mais aussi sous licences Creative Commons. Ces approches diffèrent sensiblement, sont quasiment antinomiques. Le débat sur leurs « mérites » respectifs, et les choix à opérer, se situe de plain-pied dans la problématique de la fracture numérique. Il peut arriver qu’il en soit absent, les deux « protagonistes » n’étant pas explicitement nommés. Cela étant, la Conférence « Repenser la fracture numérique » de l’Association for Learning Technology, dans une vision multidimensionnelle de la fracture numérique, posait la question « Open or proprietary ? »[7]. Une question qui mérite effectivement d’être posée.

Ce fut le cas à l’Université d’été de Tunisie qui s’est déroulée à Hammamet, du 25 au 28 août 2008[8]. Organisée par le Fonds Mondial de Solidarité Numérique (FSN)[9] et par l’Association pour le Développement de l’Éducation en Afrique (ADEA), elle était consacrée au thème de « La solidarité numérique au service de l’enseignement ». À son programme figuraient notamment les usages du TBI (Tableau blanc interactif), la création de ressources pédagogiques par les enseignants « auto-producteurs » et le rôle des communautés d’enseignants, les problématiques de droits d’auteur. Un atelier, qui portait sur les ressources pédagogiques des disciplines scientifiques et techniques des lycées, a fait différentes propositions dont l’une essentielle aux yeux de ses participants, qui affirme que les logiciels et les ressources pédagogiques utilisés et produits doivent être libres. Les standards et les formats de données doivent être ouverts[10]. Trois raisons ont motivé cette proposition : les coûts, le caractère opérationnel de la production collaborative de contenus pédagogiques, et le fait que les modalités de réalisation et les réponses du libre en terme de propriété intellectuelle sont en phase avec la philosophie générale d’un projet de solidarité numérique, à savoir partage, coopération, échange.

Le projet RELI@, « Ressources en ligne pour institutrices africaines », est destiné à améliorer la qualité de l’enseignement dans les pays du Sud par l’utilisation des outils et contenus numériques. Il repose sur des logiciels et ressources libres. Il a tenu son premier atelier à Dakar, du 22 au 24 octobre 2008[11]. Un « Appel de Dakar » a été lancé pour la production panafricaine de ressources pédagogiques numériques libres.

L’Unesco prime le libre

En 2007, l’association Sésamath[12] a reçu le 3e prix UNESCO (sur 68 projets) sur l’usage des TICE[13]. Pour le jury, Sésamath est « un programme complet d’enseignement des mathématiques conçu par des spécialistes, des concepteurs et près de 300 professeurs de mathématiques ». Il a été récompensé « pour la qualité de ses supports pédagogiques et pour sa capacité démontrée à toucher un large public d’apprenants et d’enseignants ».

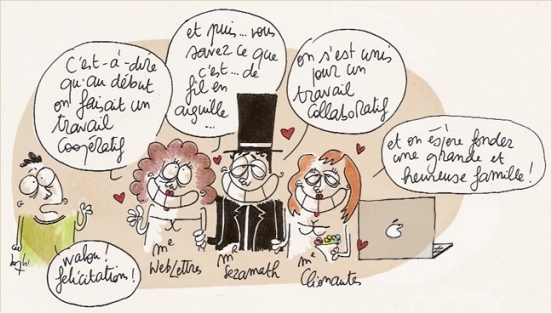

« Remerciant particulièrement la commission française pour l’UNESCO qui a soutenu officiellement sa candidature », l’association Sésamath a vu dans l’obtention de ce prix « l’ouverture d’une nouvelle ère pour son action, vers l’internationalisation et plus particulièrement encore vers l’aide au développement ». Elle a ajouté : « Que pourrait-il y avoir de plus gratifiant pour des professeurs de Mathématiques que de voir leurs productions coopératives libres (logiciels, manuels…) utilisées par le plus grand nombre et en particulier par les populations les plus défavorisées ? C’est vrai dans toute la Francophonie… mais de nombreuses pistes de traductions commencent aussi à voir le jour. »[14]

Les deux lauréats 2007 étaient le Consortium Claroline[15] et Curriki[16]. Claroline, représenté par l’Université Catholique de Louvain, en Belgique, fournit à quelque 900 établissements répartis dans 84 pays une plate-forme « open source », sous licence GPL, en 35 langues. Claroline offre une série d’outils pédagogiques interactifs et centrés sur l’apprenant. C’est un modèle de réseau et de communauté qui met en relation des apprenants, des enseignants et des développeurs du monde entier. Créée en 2004 par Sun Microsystems, Curriki est une communauté mondiale qui se consacre à l’éducation et à la formation. Elle a désormais le statut d’organisme à but non lucratif. Elle fournit un portail Internet, un ensemble d’outils et de services aux utilisateurs grâce auxquels chacun peut librement concevoir, regrouper, évaluer et enrichir les meilleurs programmes d’enseignement, ce qui permet de répondre aux besoins de toutes les classes d’âge et de toutes les disciplines. Curriki a ainsi créé une communauté très vivante composée d’enseignants, d’apprenants, de ministères de l’Éducation, d’établissements scolaires et d’organisations publiques et privées.

L’UNESCO a ainsi mis à l’honneur des démarches éducatives fondées sur le libre, logiciels et ressources.

Parmi les avantages du libre

Parmi les avantages du libre, bien connus, il y a des coûts nettement moins importants. Si libre ne signifie pas gratuit, on peut toujours se procurer une version gratuite d’un logiciel libre, notamment en le téléchargeant. Une fantastique perspective quand, organisée au niveau d’un pays, la diffusion d’un logiciel libre permet de le fournir gratuitement à tous, avec seulement des coûts de « logistique » pour la collectivité mais une économie de licences d’utilisation à n’en plus finir.

Partage-production collaborative-coopération sont des maîtres mots de la solidarité numérique qui supposent des modalités de propriété intellectuelle qui, non seulement, favorisent la circulation des ressources numériques et les contributions des uns et des autres mais, tout simplement l’autorisent. La réponse est du côté de la GPL et des Creative Commons.

L’on sait la profonde affinité entre libre et standards et formats ouverts. Or, par exemple, les documents produits par un traitement de texte lambda doivent pouvoir être lus par un traitement de texte bêta, et réciproquement. La coopération et l’échange sont à ce prix. Il s’agit là d’une question fondamentale de l’informatique et de la fracture numérique. Tout citoyen du monde doit pouvoir avoir accès à ses données, indépendamment du matériel et du logiciel qu’il utilise. De plus en plus de biens informationnels ont une version numérisée. L’enjeu est d’accéder au patrimoine culturel de l’humanité, de participer à sa production, d’être un acteur à part entière du partage et de la coopération.

Avec le libre, chaque communauté peut prendre en main la localisation/culturisation qui la concerne, connaissant ses propres besoins et ses propres codes culturels mieux que quiconque. Il y a donc, outre une plus grande liberté et un moindre impact des retours économiques, une plus grande efficacité dans le processus, en jouant sur la flexibilité naturelle des créations immatérielles pour les adapter à ses besoins et à son génie propre. C’est aussi plus généralement ce que permettent les « contenus libres », c’est-à-dire les ressources intellectuelles – artistiques, éducatives, techniques ou scientifiques – laissées par leurs créateurs en usage libre pour tous. Logiciels et contenus libres promeuvent, dans un cadre naturel de coopération entre égaux, l’indépendance et la diversité culturelle, l’intégration sans l’aliénation.

Les logiciels (et les ressources) libres, composante à part entière de l’industrie informatique, ne peuvent qu’avoir une place de choix dans la lutte contre la fracture numérique. Sans pour autant verser dans l’angélisme. Entre les grands groupes d’acteurs du libre (communautés de développeurs, entreprises, clients comme les collectivités), dont les motivations et ressorts sont divers, il existe des conflits et des contradictions. Des dérives sont possibles, comme des formes de travail gratuit. Mais au-delà des volontés des individus, il y a la logique profonde d’une façon efficace de produire des contenus de qualité[17].

L’accès à la culture informatique

Dans un texte de l’UNESCO, TIC dans l’éducation[18], il est dit que « l’utilisation des TIC dans et pour l’éducation est vue maintenant dans le monde entier comme une nécessité et une opportunité. ». Les grandes questions sur lesquelles l’UNESCO se concentre en tant « qu’expert et conseiller impartial » sont : « Comment peut-on employer les TIC pour accélérer le progrès vers l’éducation pour tous et durant toute la vie ? (…) En second lieu, les TIC, comme tous les outils, doivent être considérées en tant que telles, et être employées et adaptées pour servir des buts éducatifs. » Elle revendique que « l’initiation à l’informatique soit reconnue comme une compétence élémentaire dans les systèmes d’enseignement »[19].

Le numérique, ce sont des outils conceptuels, des abstractions, une discipline scientifique et technique en tant que telle. Au service des autres disciplines, comme le sont les mathématiques. L’ordinateur est une prothèse du cerveau, dont on se sert d’autant plus intelligemment qu’on en connaît l’« intelligence »[20]. La fracture numérique ne serait-elle pas aussi (d’abord ?) une fracture culturelle, qui ne concerne pas que le Sud ? D’ailleurs, ne parle-t-on pas fréquemment de l’« accès » à la culture ?

« L’utilisation d’un outil, si fréquente et diversifiée soit-elle, ne porte pas en elle-même les éléments qui permettent d’éclairer sa propre pratique. »[21] « Comment en effet procéder à une recherche d’information efficace lorsque l’on n’a aucune connaissance du mode de fonctionnement de l’instrument utilisé ? »[22] Or, une enquête menée auprès de 640 000 utilisateurs de l’internet en France en 2001 avait montré que 87 % d’entre eux ne savaient pas se servir d’un moteur de recherche[23]. « Depuis que "l’homo faber" fabrique des outils et s’en sert, une bonne intelligence de l’outil est considérée comme nécessaire pour une bonne utilisation, efficace, précise et raisonnée : plus on en sait quant aux possibilités de réglage et aux conditions d’utilisation mieux cela vaut, partout. Il n’y aurait que l’informatique qui échapperait à cette règle et où l’ignorance serait un avantage ! »[24].

Partout dans le monde, lutter véritablement contre la fracture numérique suppose de donner à tous les élèves les fondamentaux scientifiques du domaine[25]. L’objectif est la maîtrise de ces instruments intellectuels d’un type nouveau. Elle n’est pas vraiment aisée et nécessite des années d’apprentissage (pour un individu il faut environ 20 ans pour maîtriser l’ensemble des instruments et méthodes liés à l’exercice d’une pensée rationnelle). On voit mal comment la diffusion d’objets matériels permettrait en elle-même de raccourcir les délais d’apprentissage, comment on entrerait dans le monde du numérique, abstrait et conceptuel, sans en faire un objet d’étude.

À l’appui de cette nécessité d’enseignement en tant que tel, le fait que la fracture numérique peut se loger là où on ne l’attend pas. Ainsi pointe-t-on une fracture numérique qui émerge, non plus entre les particuliers, mais entre les entreprises, notamment les plus petites et les plus grandes[26]. D’un côté « les mieux loties, accompagnées d’une armée de consultants ou naturellement aguerries à ces sujets ». De l’autre « des centaines de milliers d’entreprises qui souhaitent ardemment tirer profit, dès maintenant, des outils à disposition mais qui butent sur la complexité technologique, les tarifications inadaptées, les offres sur ou sous dimensionnées sans parler des compétences inaccessibles et en voie de raréfaction ». En fait, on voit aujourd’hui émerger « une nouvelle e-aristocratie qui va à l’encontre de la promesse de démocratisation des bénéfices économiques des NTIC (productivité, économie, accessibilité) ».

Dans leur rapport sur l’économie de l’immatériel[27], Maurice Lévy et Jean-Pierre Jouyet soulignent que, dans l’économie de l’immatériel, « l’incapacité à maîtriser les TIC constituera (…) une nouvelle forme d’illettrisme, aussi dommageable que le fait de ne pas savoir lire et écrire ». Ils mettent en évidence les obstacles qui freinent l’adaptation de notre pays à l’économie de l’immatériel, notamment « notre manière de penser », invitant à changer un certain nombre de « nos réflexes collectifs fondés sur une économie essentiellement industrielle ».

La lutte contre la fracture numérique a bien d’abord une dimension éminemment culturelle. Il s’agit d’un enjeu éducatif majeur, de culture générale scientifique et technique pour tous. D’un défi aussi dont les réponses pour le relever se trouvent d’évidence dans les systèmes éducatifs, dont c’est une des raisons d’être.

Jean-Pierre Archambault

Chargé de mission au CNDP-CRDP de Paris

Vous n’êtes pas un familier du Framablog et de ses thèmes de prédilection ? Alors ce billet risque de vous sembler destiné à une chapelle de spécialistes, susceptibles et pointilleux, toujours prompts à s’enflammer pour d’obscures querelles de clochers[1] (autrement appelés trolls dans le milieu).

Vous n’êtes pas un familier du Framablog et de ses thèmes de prédilection ? Alors ce billet risque de vous sembler destiné à une chapelle de spécialistes, susceptibles et pointilleux, toujours prompts à s’enflammer pour d’obscures querelles de clochers[1] (autrement appelés trolls dans le milieu). Mon petit doigt me dit que cette année le Framablog va moins se lamenter sur la situation du Libre dans

Mon petit doigt me dit que cette année le Framablog va moins se lamenter sur la situation du Libre dans  Bonjour, dans la vraie vie, je suis père de famille.

Bonjour, dans la vraie vie, je suis père de famille.

S’il y a un choix, un choix militant même, c’est celui de garantir la gratuité et l’égalité d’accès pour tous à ce travail qui est l’œuvre d’une communauté (même si, bien sûr, actuellement il y a encore peu d’auteurs, puisque nous venons tout juste de rendre public le projet !).

S’il y a un choix, un choix militant même, c’est celui de garantir la gratuité et l’égalité d’accès pour tous à ce travail qui est l’œuvre d’une communauté (même si, bien sûr, actuellement il y a encore peu d’auteurs, puisque nous venons tout juste de rendre public le projet !). C’est lorsque la pléthore de documents nous a poussés à faire des sélections, des classements et, en général, à retravailler les documents, donc à les modifier, que nous avons compris que rien ne serait possible tant que ce qui est mutualisé sur le site restait placé sous le sceau par défaut du copyright. Forts de cette expérience, nous avons cette fois sérieusement examiné les licences avant de nous plonger dans d’autres projets collectifs. Ainsi, Vocabulettres, mais aussi les Livrets TICE, sont-ils placés sous le signe de la licence libre.

C’est lorsque la pléthore de documents nous a poussés à faire des sélections, des classements et, en général, à retravailler les documents, donc à les modifier, que nous avons compris que rien ne serait possible tant que ce qui est mutualisé sur le site restait placé sous le sceau par défaut du copyright. Forts de cette expérience, nous avons cette fois sérieusement examiné les licences avant de nous plonger dans d’autres projets collectifs. Ainsi, Vocabulettres, mais aussi les Livrets TICE, sont-ils placés sous le signe de la licence libre. Il le faudra pourtant, parce que j’imagine que des professeurs de langues, notamment, voire des professeurs à l’étranger, pourraient être tentés de créer leurs exercices sur WebLettres, que nous ne publierions pas parce que ce ne seront pas des exercices de français. Mais nous n’avons aucun programmeur chez WebLettres (Notre webmestre est saturé et, en ce qui concerne Vocabulettres, tout est fait maison par mes blanches mains sur mon temps libre), c’est le triste lot des professeurs de lettres qui, comme chacun sait, sont plus littéraires que programmeurs.

Il le faudra pourtant, parce que j’imagine que des professeurs de langues, notamment, voire des professeurs à l’étranger, pourraient être tentés de créer leurs exercices sur WebLettres, que nous ne publierions pas parce que ce ne seront pas des exercices de français. Mais nous n’avons aucun programmeur chez WebLettres (Notre webmestre est saturé et, en ce qui concerne Vocabulettres, tout est fait maison par mes blanches mains sur mon temps libre), c’est le triste lot des professeurs de lettres qui, comme chacun sait, sont plus littéraires que programmeurs. Vous connaissez Framasoft ? Alors vous devez être également un tant soit peu familier avec « nos » pingouins, qui donnent cette identité visuelle particulière à

Vous connaissez Framasoft ? Alors vous devez être également un tant soit peu familier avec « nos » pingouins, qui donnent cette identité visuelle particulière à

Mon lycée a, depuis un certain temps déjà, opté pour un déploiement massif de la suite bureautique libre OpenOffice.org. Sauf que notre informaticien l’installe sur les postes en modifiant systématiquement l’option du format d’enregistrement « par défaut », substituant au

Mon lycée a, depuis un certain temps déjà, opté pour un déploiement massif de la suite bureautique libre OpenOffice.org. Sauf que notre informaticien l’installe sur les postes en modifiant systématiquement l’option du format d’enregistrement « par défaut », substituant au  Rien de tel pour aborder la rentrée scolaire qu’un excellent article de synthèse de

Rien de tel pour aborder la rentrée scolaire qu’un excellent article de synthèse de  À l’heure où le feuilleton

À l’heure où le feuilleton