L’article ci-dessous de Jean-Pierre Archambault évoque avec brio les enjeux éducatifs du libre et des standards ouverts.

Antérieur à sa nomination, il n’a pas été rédigé en direction de Vincent Peillon. Nous avons néanmoins choisi de l’interpeller en modifiant son titre tant il nous semble important de ne plus perdre de temps et de faire enfin des choix clairs et assumés en la matière[1].

S’il n’y avait qu’un document à lire sur l’éducation, ce serait peut-être celui-là…

Enjeux éducatifs du libre et des standards ouverts

Jean-Pierre Archambault – janvier 2012 – EPI

La connaissance est universelle. Son développement, sa diffusion et son appropriation supposent de pouvoir réfléchir, étudier, produire, travailler ensemble, aisément et dans l’harmonie. Il faut pour cela des règles communes, des normes et standards.

Ouvert/fermé ?

Mais il y a standard (ouvert) et standard (fermé). « On entend par standard ouvert tout protocole de communication, d’interconnexion ou d’échange et tout format de données inter-opérables et dont les spécifications techniques sont publiques et sans restriction d’accès ni de mise en oeuvre »[2]. Cette définition « rend obligatoire l’indépendance des protocoles et des formats de données vis-à-vis des éditeurs, des fabricants et des utilisateurs de logiciels ou de systèmes d’exploitation ainsi que la mise à disposition de spécifications techniques documentées et non soumises à des royalties en cas de brevet. Mais elle permet que la mise à disposition sans restriction d’accès des spécifications, ou leur mise en oeuvre soit payante contre un paiement forfaitaire raisonnable (destiné par exemple à couvrir les frais relatifs à cette publication ou à la maintenance administrative des normes par leur éditeur) ».

Il y a de plus en plus d’immatériel et de connaissance dans les richesses créées et les processus de leur création. Conséquence, depuis des années, des processus de marchandisation sont en cours touchant des domaines d’activité qui relevaient prioritairement de l’action publique[3]. Cela vaut pour l’informatique en général et les TICE en particulier, mais aussi pour toute la connaissance scientifique, les semences, les médicaments et la santé, les savoirs ancestraux, l’eau, l’énergie, le vivant, la création artistique, les données publiques… et les ressources pédagogiques et l’éducation. Pédagogie et économie se trouvent ainsi étroitement mêlées. La pédagogie se situe pleinement au coeur des enjeux économiques, sociaux, culturels du monde actuel.

Les questions de l’accès et de la mise en oeuvre étant primordiales, normes et standards s’interpénètrent fortement avec les questions de propriété intellectuelle, ce qui amenait Michael Oborne, responsable du programme de prospective de l’OCDE, à dire, en 2002, que « la propriété intellectuelle deviendra un thème majeur du conflit Nord-Sud »[4]. On pourrait ajouter Nord-Nord.

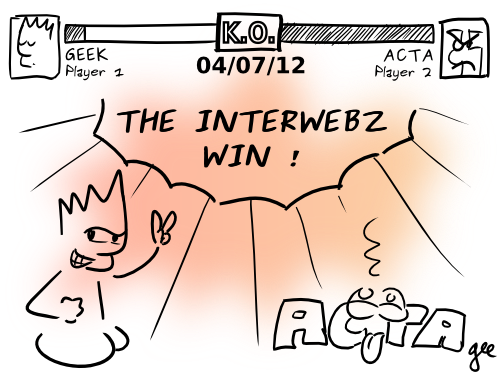

D’abord à la demande du gouvernement américain, puis de la plupart des pays industrialisés, la protection des droits de propriété intellectuelle est devenue partie intégrante des négociations de l’Organisation Mondiale du Commerce (OMC). C’est ainsi qu’a été négocié puis adopté l’accord sur les ADPIC (Accord sur les Aspects des Droits de Propriété Intellectuelle qui touchent au Commerce). Des normes sont imposées dans le cadre du commerce international. Des accords bilatéraux ou régionaux les renforcent. Ainsi ceux qui interdisent aux agences nationales du médicament de s’appuyer sur les résultats d’essais cliniques attestant de l’efficacité et de l’innocuité de molécules déjà commercialisées pour autoriser la mise sur le marché de génériques[5].

Imposer son standard, fermé, c’est acquérir une position dominante sur un marché, voire de monopole. Avec un format de fichier fermé, on verrouille un marché. L’informatique était libre à ses débuts. Son développement grand public a signifié la suprématie d’une informatique propriétaire avec ses formats et ses standards fermés. L’informatique libre s’est constituée en réaction à cette situation. Et ses partisans ne cessent de souligner qu’informatique libre et standards ouverts sont les deux faces d’un même combat. « L’approche des logiciels libres est intrinsèquement une réponse majeure aux impératifs de compatibilité, d’interopérabilité et d’échange puisque, le code source étant donné, “on sait tout”. Les spécifications sont publiques et il n’y a pas de restriction d’accès ni de mise en oeuvre »[6]. Nous présenterons donc les logiciels et les ressources libres, leurs licences notamment, leurs enjeux sociétaux et éducatifs. Ils sont à la fois des réponses concrètes à des questions de fabrication d’un bien informatique et outil conceptuel pour penser les problématiques de l’immatériel et de la connaissance.

La tendance au monopole de l’informatique grand public

Dans l’économie de l’immatériel en général, les coûts marginaux, correspondant à la production et la diffusion d’un exemplaire supplémentaire, tendent vers zéro. Les coûts fixes sont importants et les dépenses afférentes sont engagées avant que le premier exemplaire ne soit vendu. Les acteurs dominants sont donc en position de force.

Les externalités de réseau jouent également en leur faveur. En amont, un fabricant de composants, des développeurs de logiciels choisiront la plate-forme la plus répandue qui, de ce fait, le sera encore plus. En aval, les consommateurs se tournent prioritairement vers les grands éditeurs de logiciels, y voyant un gage de pérennité (confondant en la circonstance entreprise et produit, que l’on pense aux versions successives accélérées d’une même application sans que leur compatibilité soit assurée), un réseau dense d’assistance, de la compétence. Et un directeur informatique minimise ses risques face à sa hiérarchie, en cas de problèmes, en choisissant l’acteur dominant.

Enfin, l’acteur dominant propriétaire verrouille le marché, s’étant rendu incontournable avec ses standards et formats fermés. Par exemple, les utilisateurs de son traitement texte ne peuvent pas lire les fichiers réalisés par les usagers du traitement de texte d’un nouvel entrant sur le marché qui, eux, ne peuvent pas lire les fichiers des utilisateurs, beaucoup plus nombreux, du traitement de texte de l’acteur dominant. Or, quand on écrit un texte, c’est souvent pour que d’autres le lisent… Ces pratiques de verrouillage qui empêchent la communication, dissuadent l’adoption d’un nouveau produit concurrent et sont des entraves à la diversité et au pluralisme. La non-compatibilité est sciemment organisée pour des raisons commerciales qui vont à l’encontre des intérêts des utilisateurs.

Ce genre de situations se retrouve avec d’autres logiciels, ainsi ceux des TNI quand ils ne permettent pas de transférer un scénario pédagogique d’un environnement à un autre. Il en va autrement avec les standards et formats ouverts et avec les logiciels libres dont les auteurs font en sorte que leurs utilisateurs lisent et produisent des fichiers aux formats des logiciels propriétaires correspondants (en général une quasi compatibilité).

Les logiciels libres

Les logiciels libres s’opposent aux logiciels propriétaires, ou privatifs. Quand on achète ces derniers, en fait on achète le droit de les utiliser dans des conditions données, très restrictives. Pour cela, seul le code exécutable, code objet, est fourni.

En revanche, avec les logiciels libres, on bénéficie des quatre libertés suivantes. On peut :

- les utiliser, pour quelque usage que ce soit,

- en étudier le fonctionnement et l’adapter à ses propres besoins (l’accès au code source est une condition nécessaire),

- en redistribuer des copies sans limitation aucune,

- les modifier, les améliorer et diffuser les versions dérivées au public, de façon à ce que tous en tirent avantage (l’accès au code source est encore une condition nécessaire).

Ces libertés ne sont accordées qu’à la condition d’en faire bénéficier les autres, afin que la chaîne de la « vertu » ne soit pas interrompue, comme cela est le cas avec un logiciel du domaine public quand il donne lieu à une appropriation privée.

La licence GNU-GPL (General Public License), la plus répandue, traduit au plan juridique cette approche originale qui concilie le droit des auteurs et la diffusion à tous de la connaissance. Elle constitue une modalité particulière de mise à disposition d’une richesse créée. La licence GNU-GPL correspond bien à la nature du bien informatique, à la façon dont il se crée, dans des processus cumulatifs de correction des erreurs et d’amélioration du produit par les pairs, les développeurs et les utilisateurs. Elle est pertinente, contrairement au brevet qui signifie procès en contrefaçons à n’en plus finir et donc frein à l’innovation, à la création. Elle n’interdit aucunement des activités commerciales, de service essentiellement. Elle s’inscrit dans une philosophie de libre accès à la connaissance et de son appropriation par tous.

Pour lever certaines incertitudes, liées à la diffusion de logiciels libres sous licence de source américaine, le CEA, le CNRS et l’INRIA ont élaboré CeCILL, la première licence qui définit les principes d’utilisation et de diffusion des logiciels libres en conformité avec le droit français, reprenant les principes de la GNU-GPL[7]. La vocation de cette licence est d’être utilisée en particulier par les sociétés, les organismes de recherche et établissements publics français et, plus généralement, par toute entité ou individu désirant diffuser ses résultats sous licence de logiciel libre, en toute sécurité juridique.

La notion de logiciel libre n’est pas synonyme de gratuité, même si les tarifs pratiqués sont sans commune mesure avec ceux de l’informatique commerciale traditionnelle[8]. Il y a toujours la possibilité de se procurer un logiciel libre sans bourse délier. Les logiciels libres jouent un rôle de premier plan dans la régulation de l’industrie informatique. Ils facilitent l’entrée de nouveaux arrivants, favorisent la diversité, le pluralisme et la concurrence. Il peut arriver que la problématique de la gratuité brouille le débat. Elle n’est pas le problème. Les produits du travail humain ont un coût, la question étant de savoir qui paye, quoi et comment. La production d’un logiciel, qu’il soit propriétaire ou libre, nécessite une activité humaine. Elle peut s’inscrire dans un cadre de loisir personnel ou associatif, écrire un programme étant un hobby comme il en existe tant. Elle n’appelle alors pas une rémunération, la motivation des hackers (développeurs de logiciels dans des communautés) pouvant résider dans la quête d’une reconnaissance par les pairs. En revanche, si la réalisation se place dans un contexte professionnel, elle est un travail qui, toute peine méritant salaire, signifie nécessairement rémunération. Le logiciel ainsi produit ne saurait être gratuit, car il lui correspond des coûts. Mais, même quand un logiciel n’est pas gratuit, il doit le devenir lorsqu’il a été payé (par exemple, les collectivités ne doivent pas payer cent fois le même produit en agissant en ordre dispersé). C’est le cas quand il est sous licence libre. Autre chose est de rémunérer des activités de service sur un logiciel devenu gratuit (installation, adaptation, évolution, maintenance…). Même si, ne versons pas dans l’angélisme, la tentation existe de ne pas développer telle ou telle fonctionnalité pour se ménager des activités de service ultérieures.

Le paradigme de la recherche scientifique

L’approche du logiciel libre relève du paradigme de la recherche scientifique, ce qui a sa cohérence puisque l’informatique est une science ! À l’information, préoccupation structurelle majeure de la recherche correspond la publication du code source des logiciels. À la validation par les pairs correspond le débogage par des centaines, des milliers de programmeurs disséminés sur toute la planète. Comme on est plus intelligents à plusieurs que tout seuls, la qualité est (souvent) au rendez-vous. Et il y a les libertés de critiquer, d’amender, d’approfondir…

Les mathématiques sont libres depuis 25 siècles, depuis le temps où Pythagore interdisait à ses disciples de divulguer théorèmes et démonstrations. Or, à ses débuts, d’une manière qui était donc quelque peu paradoxale, l’approche du logiciel libre était perçue comme « nouvelle ». Alors que c’est le logiciel propriétaire qui l’est, depuis une trentaine d’années avec l’émergence d’un marché grand public. Il est vrai aussi que la « république des sciences » n’est plus ce qu’elle était, que le principal fil conducteur de la recherche scientifique devient la création de monopoles privés au détriment de la production de connaissances. Jean-Claude Guédon plaide pour l’accès libre aux résultats de la recherche afin de rétablir la « grande conversation ». Cette dérive de la science est notamment « justifiée » par le fait qu’il faut bien évidemment rémunérer les chercheurs. Le statut public de l’enseignant-chercheur a gardé toute sa pertinence : rémunération pour des activités pédagogiques (cours…) et résultats de la recherche, partie intégrante du patrimoine de l’humanité, mis à la disposition de tous. Point n’est donc besoin de multiplier les brevets. De plus, le partage valorise le chercheur, permet l’accès du Sud (et du Nord !) à la connaissance et le développement d’applications au bénéfice de tous.

Des modèles économiques

Donner un logiciel ? Il y a encore quelques années régnait un certain scepticisme. La réalité est passée par là. La majorité des serveurs Web de par le monde sont développés avec le logiciel libre Apache. Tous les constructeurs informatiques ont une politique, et des budgets, en matière de libre. Idem pour les entreprises en général. Linux est désormais un acteur à part entière du marché des systèmes d’exploitation et des serveurs (c’est le cas pour la quasi-totalité des environnements informatiques de l’administration centrale du ministère de l’Éducation nationale et des rectorats)… Les administrations et les collectivités locales se tournent effectivement vers le libre car l’argent public ne doit servir qu’une fois et, dès lors qu’il a été payé, un logiciel est gratuit.

Il y avait pourtant des antécédents célèbres. Au début des années 80, la DGT (Direction générale des télécommunications, le « France Télécom » de l’époque) a mis à disposition gratuitement le Minitel, un terminal qui coûtait cher, 4 ou 5 000 F. Coup de génie. Des millions d’utilisateurs, un Internet avant la lettre (en Grande Bretagne, échec retentissant car il fallait acheter le terminal). Et toute une économie de services qui s’est développée. Et beaucoup de communications téléphoniques. La démarche est fondamentalement la même avec les appareils photos bon marché qui génèrent plein de photos que l’on fait développer. Ou avec ces imprimantes très peu chères, et ces cartouches qui le sont davantage. Sans parler de Rockfeller qui distribuait des lampes à pétrole… La démarche gagne encore en pertinence dans le domaine de l’immatériel, dans le domaine des logiciels qu’il faut installer, personnaliser, modifier, maintenir… Choisir le libre pour une collectivité c’est aussi contribuer à substituer à une politique d’achat de licences des activités de service favorisant le développement de l’emploi local.

Au-delà des programmeurs, tous concernés

Une analogie avec la comptabilité nationale qui est publique. Tout le monde peut la consulter. Certes très peu le font. Pourtant c’est très important que l’on puisse le faire. C’est pareil avec les logiciels. Que fait exactement le système d’exploitation propriétaire d’un ordinateur quand une application dialogue avec votre machine alors que vous êtes connecté sur Internet ? Vous ne le savez pas. Peut-être communique-t-il à autrui le contenu de votre disque dur ? Gênant pour un individu. Et pour un État qui a confié son informatique, et ses secrets, au logiciel propriétaire d’une société étrangère. Et tout cela n’est pas que de la fiction. Cela existe dans la réalité. Ce simple exemple montre donc que tout le monde, informaticien ou non, est concerné par le fait que le code source d’un logiciel soit accessible.

Le libre est une réalité économique. Certains parlent alors d‘Open Source et de ses qualités : commodité, rentabilité, efficacité, fiabilité. Libre/Open source ? Il faut distinguer Open Source et logiciel libre. Pour Richard Stallman, fondateur du logiciel libre, à l’origine du projet GNU et de la GPL, le libre est une philosophie, une conception de la société à ne pas confondre avec l‘Open Source. Il a l’habitude dans ses conférences sur l’histoire du logiciel libre (en France en tout cas), de faire une référence appuyée à la devise « Liberté-Egalité-Fraternité ». Il s’agit de promouvoir un changement social par une action technique. L’enjeu est la liberté de l’utilisateur, le contrôle de son informatique.

Au-delà de l’informatique, les ressources pédagogiques

Le paysage de l’édition scolaire s’est profondément transformé de par l’irruption de l’informatique et des réseaux. Et du libre dont on pu rapidement constater une transférabilité à la production d’autres ressources immatérielles, tant du point de vue des méthodes de travail que de celui des réponses apportées en termes de droit d’auteur. C’est le cas des ressources pédagogiques et tout le monde a en tête les réalisations remarquables de l’association Sésamath. Cette association est synonyme d’excellence en matière de production pédagogique et de communauté d’enseignants-auteurs-utilisateurs. Sésamath a reçu une mention d’honneur pour le prix 2007 Unesco-Roi Hamad Bin Isa Al-Khalifa sur l’utilisation des technologies de l’information et de la communication dans l’éducation. L’Unesco a décidé d’attribuer une mention spéciale au projet de manuel libre « pour la qualité de ses supports pédagogiques et pour sa capacité démontrée à toucher un large public d’apprenants et d’enseignants ». L’association a également été récompensée aux Lutèce d’Or (Paris capitale du libre).

D’évidence, il existe des auteurs par milliers, des acteurs multiples (enseignants, associations, institutions, collectivités territoriales) qui mettent en place des coopérations souples et diverses. Certes, de tout temps les enseignants ont réalisé des documents en préparant leurs cours. Mais, avant la banalisation des outils numériques de production des contenus (traitement de texte, présentation, publication) et le développement d’Internet qui donne à l’auteur un vaste public potentiel qui peut aisément reproduire les documents qu’il a récupérés, qui en bénéficiait ? Les élèves du professeur. Des collègues de son lycée. Des élaborations collectives de sujets existaient pour des contrôles communs. Mais, rappelons-nous qu’à cette époque les photocopieuses étaient rarissimes et l’usage de la machine à alcool avait un côté pour le moins fastidieux. Au-delà de ces premiers cercles proches, les choses se compliquaient encore davantage. Il fallait mettre en forme le manuscrit et la machine à écrire manquait de souplesse. Et en cas de projet de manuel, l’éditeur constituait le passage obligé, et tout le monde n’était pas élu. On lui accordait d’autant plus facilement des droits sur la production des oeuvres que l’on ne pouvait pas le faire soi-même. Les conditions de cet exercice délicat de production de ressources pédagogiques ont radicalement changé. La conséquence en est la profusion de ressources éducatives sur Internet. Ce nouveau paysage constitue pour les enseignants et le service public d’éducation, une opportunité et, pour les éditeurs traditionnels, une obligation de se repositionner. Les technologies de l’information et de la communication contribuent à modifier les équilibres et les positions anciennement installés. Leur « enfant chéri », le manuel scolaire, est entré dans une période de turbulences avec le manuel numérique.

Le pourquoi de la propriété intellectuelle

À ce stade, il n’est pas inutile de rappeler le pourquoi du droit d’auteur et des brevets afin de ne pas se laisser enfermer dans des arguties de convenance. L’objectif fondamental est de favoriser la création des richesses, au nom de l’intérêt général, et pour cela il faut concilier incitation à l’innovation et diffusion technologique, dépasser le dilemme entre performance individuelle et efficacité collective, inciter les entreprises individuelles à l’innovation en leur garantissant une situation de monopole temporaire dans l’exploitation des droits. Et, plus encore que par le passé, l’incitation à l’innovation n’a de sens que si la technologie se diffuse et irrigue l’ensemble de la structure dont elle participe ainsi à l’amélioration de l’efficience collective. Les limitations à la libre circulation de l’information et de la connaissance ne se justifient en dernière instance que par l’objectif d’encourager et de valoriser le travail intellectuel quand il est au service de tous. Le risque existe de justifier dans une dialectique un peu spécieuse des pratiques commerciales par une prééminence d’un droit qui serait immuable, ou de déclarer illégitime une réflexion sous le prétexte qu’elle serait iconoclaste au regard d’une législation en vigueur.

En son temps, Victor Hugo disait que « le livre, comme livre, appartient à l’auteur, mais comme pensée, il appartient – le mot n’est pas trop vaste – au genre humain. Toutes les intelligences y ont droit. Si l’un des deux droits, le droit de l’écrivain et le droit de l’esprit humain, devait être sacrifié, ce serait, certes, le droit de l’écrivain, car l’intérêt public est notre préoccupation unique, et tous, je le déclare, doivent passer avant nous »[9].

Rendons hommage à Boris Vian pour sa vision prémonitoire de certains « débats » qui nous occupent aujourd’hui. Auteur-compositeur-interprète, musicien de jazz, écrivain… et centralien, dans En avant la zizique[10], il pointait une relation conflictuelle, en observant l’attitude du commerçant qui intime à l’artiste de « se contenter de son talent et de lui laisser l’argent » et qui s’ingénie souvent « à brimer ce qu’il a fait naître en oubliant qu’au départ de son commerce il y a la création ». Boris Vian remarquait que « le commercial se montrait également agressif par rapport au bureau d’études qui s’apprêtait à lui porter un coup dont il ne se relèverait pas, à savoir l’automation de ses fonctions ». Et de lui conseiller d’en profiter car cela ne durerait pas éternellement !

Les licences Creative Commons

La numérisation des oeuvres et de la connaissance en général, et leur diffusion sur Internet posent avec une acuité sans pareille le problème de l’usage que l’on peut en faire. Des millions d’utilisateurs ont accès à des millions d’oeuvres, grandes ou petites. Difficile d’imaginer que leur utilisation puisse passer par une demande d’autorisation. De ce point de vue, le copyright est un non-sens sur Internet. La loi doit pouvoir être applicable. D’où la pertinence de la démarche de Creative Commons dans laquelle l’auteur, en mettant à disposition sa création sur la Toile, indique ce que les internautes peuvent en faire.

La démarche est issue de la licence GPL qui, bien adaptée aux logiciels, n’en a pas moins une portée plus large. Mais il serait absurde de vouloir transposer tel quel ce modèle aux créations de l’esprit, d’une manière indifférenciée. Les modalités juridiques doivent tenir compte de la spécificité d’un bien. Un morceau de musique, par exemple, n’est ni une oeuvre littéraire, ni une documentation informatique ou une ressource pédagogique. On peut, également, souhaiter la diffusion d’un article sans pour autant permettre des modifications successives, au terme desquelles on ne reconnaîtrait plus l’original. Une chose est sa diffusion et sa libre circulation sans contraintes, pour que l’on puisse réagir, approfondir, critiquer… autre chose est son éventuelle dénaturation ou disparition de fait. Dans pareil cas, on parlera plutôt de « ressource à diffusion libre ». Par ailleurs, la légalité se doit d’être morale. Les médecins, qui importent illégalement des copies de médicaments sous brevet pour soigner des malades, se moquent éperdument de savoir si leur geste est légal ou non : il est vital tout simplement. La légalité est aussi une notion relative. Ainsi, le laboratoire indien Cipla, qui produit des traitements antirétroviraux contre le sida en copiant des molécules des firmes pharmaceutiques occidentales, protégées par des brevets, est-il un « pirate » ? Non, car la législation indienne ne reconnaît pas les brevets sur les médicaments. Cipla est donc une entreprise parfaitement légale, au regard de la loi de son pays[11].

L’objectif général, clairement exprimé, est de favoriser la diffusion et l’accès pour tous des oeuvres de l’esprit, la production collaborative, en conciliant les droits légitimes des auteurs et des usagers. Il reste à en définir les modalités juridiques permettant une circulation fluide des documents et, si nécessaire, leur modification. Le projet Creative Commons s’y emploie. Il a vu le jour à l’université de Standford, au sein du Standford Law School Center for Internet et Society, à l’initiative notamment de Lawrence Lessing. Il s’agit d’adapter le droit des auteurs à Internet et de fournir un cadre juridique au partage sur la Toile des oeuvres de l’esprit. L’économie de l’édition ne peut plus se confondre avec celle du support des oeuvres, maintenant qu’elles ne sont plus attachées à un support unique, le livre par exemple. Il faut redéfinir les utilités sociales, les raisons d’être.

Creative Commons renverse le principe de l’autorisation obligatoire. Il permet à l’auteur d’autoriser par avance, et non au coup par coup, certains usages et d’en informer le public. Il est ainsi autorisé d’autoriser ! Métalicence, Creative Commons permet aux auteurs de se fabriquer des licences, dans une espèce de jeu de LEGO simple, constitué de seulement quatre briques. Première brique, Attribution : l’utilisateur, qui souhaite diffuser une oeuvre, doit mentionner l’auteur. Deuxième brique, Commercialisation : l’auteur indique si son travail peut faire l’objet ou pas d’une utilisation commerciale. Troisième brique, non-dérivation : un travail, s’il est diffusé, ne doit pas être modifié. Quatrième brique, Partage à l’identique : si l’auteur accepte que des modifications soient apportées à son travail, il impose que leur diffusion se fasse dans les mêmes termes que l’original, c’est-à-dire sous la même licence. La possibilité donnée à l’auteur de choisir parmi ces quatre composantes donne lieu à onze combinaisons de licences. Grâce à un moteur de licence proposé par le site de Creative Commons, l’auteur obtient automatiquement un code HTML à insérer sur son site qui renvoie directement vers le contrat adapté à ses désirs.

« Localisation » des ressources

Si chacun a vocation à produire ses propres ressources, la coopération internationale et des formes de solidarité numérique c’est aussi l’adaptation de celles réalisées par l’autre[12]. Avec le libre, chaque communauté peut prendre en main la localisation/culturisation qui la concerne, connaissant ses propres besoins et ses propres codes culturels mieux que quiconque. Il y a donc, outre une plus grande liberté et un moindre impact des retours économiques, une plus grande efficacité dans le processus, en jouant sur la flexibilité naturelle des créations immatérielles pour les adapter à ses besoins et à son génie propre. C’est aussi plus généralement ce que permettent les « contenus libres », c’est-à-dire les ressources intellectuelles – artistiques, éducatives, techniques ou scientifiques – laissées par leurs créateurs en usage libre pour tous. Logiciels et contenus libres promeuvent, dans un cadre naturel de coopération entre égaux, l’indépendance et la diversité culturelle, l’intégration sans l’aliénation.

L’exception pédagogique

La réalité montre que numérique, droit d’auteur et pédagogie entretiennent des liens étroits. Les enseignants utilisent leurs propres documents ainsi que les productions de l’édition scolaire, dont la raison d’être est de réaliser des ressources pour l’éducation, et qui bien évidemment doit en vivre. Ils utilisent également des ressources qui n’ont pas été réalisées explicitement pour des usages scolaires. Cela est vrai pour toutes les disciplines, mais particulièrement dans certaines d’entre d’elles comme l’histoire-géographie, les sciences économiques et sociales ou la musique : récitation d’un poème, lecture à haute voix d’un ouvrage, consultation d’un site Web… Ces utilisations en classe ne sont pas assimilables à l’usage privé. Elles sont soumises au monopole de l’auteur dans le cadre du principe de respect absolu de la propriété intellectuelle. Cela peut devenir mission impossible, tellement la contrainte et la complexité des droits se font fortes. Ainsi pour les photographies : droits du photographe, de l’agence, droit à l’image des personnes qui apparaissent sur la photo ou droit des propriétaires dont on aperçoit les bâtiments… Difficile d’imaginer les enseignants n’exerçant leur métier qu’avec le concours de leur avocat ! Mais nous avons vu les licences Creative Commons qui contribuent, en tout cas sont un puissant levier, à développer un domaine public élargi de la connaissance. Et la GNU-GPL et le CeCILL qui permettent aux élèves et aux enseignants de retrouver, dans la légalité, leurs environnements de travail sans frais supplémentaires, ce qui est un facteur d’égalité et de démocratisation.

L’exception pédagogique, c’est-à-dire l’exonération des droits d’auteurs sur les oeuvres utilisées dans le cadre des activités d’enseignement et de recherche, et des bibliothèques, concerne potentiellement des productions qui n’ont pas été réalisées à des fins éducatives. Elle reste posée avec une acuité accrue dans le contexte du numérique. L’activité d’enseignement est désintéressée et toute la société en bénéficie. L’enjeu est de légaliser un « usage loyal » de ressources culturelles au bénéfice des élèves, dans le cadre de l’exercice de leur métier7.

L’immatériel et la connaissance

Dans les colonnes du Monde diplomatique, en décembre 2002, John Sulston, prix Nobel de médecine, évoquant les risques de privatisation du génome humain, indique que « les données de base doivent être accessibles à tous, pour que chacun puisse les interpréter, les modifier et les transmettre, à l’instar du modèle de l’open source pour les logiciels ». Ce propos illustre la question de savoir si le modèle du libre préfigure des évolutions en termes de modèles économiques et de propriété intellectuelle (droit d’auteur, brevets).

Il y a relativement de plus en plus de biens immatériels. Et de plus en plus d’immatériel et de connaissance dans les biens matériels et dans les processus de création de la richesse. La dialectique coopération-espaces publics/concurrence-enclosures est universelle[13]. Quel est le terme de la contradiction qui est le plus efficace pour produire des richesses à l’heure de l’entrée dans l’économie du savoir dans laquelle l’immatériel et la connaissance jouent un rôle de plus en plus décisif ? On sait que la connaissance fuit la clôture. Et l’approche du libre a montré concrètement sa pertinence pour produire des biens de connaissance de qualité, des biens communs informatiques mondiaux. Alors…

Jean-Pierre Archambault

Président de l’EPI

(Enseignement Public et Informatique)

Paru initialement dans la revue Frantice.net n° 4, Normes et standards éducatifs : état, enjeux et perspectives, janvier 2012, p. 77-85.