Vista et MS Office 2007 – Rapport Becta – Extraits et Recommandations

Nous avons tout récemment mis en ligne notre traduction du Rapport Becta dont nous espérons beaucoup comme cela a été dit dans le billet de présentation.

Nous avons tout récemment mis en ligne notre traduction du Rapport Becta dont nous espérons beaucoup comme cela a été dit dans le billet de présentation.

Il ne s’agit nullement de faire une sorte de guerre à Microsoft aussi puérile que contre-productive. Il s’agit de faire en sorte que, comme en Grande-Bretagne, l’école française se pose de bonnes questions.

- Mon établissement scolaire a-t-il réellement besoin de migrer vers Vista ? vers MS Office 2007 ?

- Les coûts d’une telle opération seront-ils compensés par la qualité de ces nouveaux produits ? A l’échelle nationale, les coûts globaux d’une telle opération ne pourraient-ils pas être épargnés et affectés ailleurs ?

- Un parc hétérogène Windows XP et Windows Vista ne va-t-il pas créer de la confusion chez mes utilisateurs ? ne va-t-il compliquer la tâche de l’administrateur du réseau ?

- Si je me retrouve avec MS Office 2007, dois-je utiliser par défaut le nouveau format de Microsoft Open XML (OOXML) ?

- Est-ce que tout a été fait pour garantir une bonne interopérabilité ? Est-ce je facilite la vie numérique de mes élèves dans leur liaison école/domicile ?

- La collectivité territoriale qui me fournit en machines neuves a-t-elle prévue d’intégrer nativement une suite bureautique libre ? A-t-elle prévue que je puisse sans entraves lire et écrire par défaut au format OpenDocument ODF ?

- Si Windows Vista et MS Office 2007 ne sont pas recommandés, n’est-il pas temps d’évaluer sérieusement si Linux (associé à OpenOffice.org) pourrait constituer une réelle alternative ?

Voici, entre autres, quelques question d’importance qu’aborde ce rapport.

Et pour vous en faire tout de suite une meilleure idée, et donner envie d’en savoir en plus en parcourant l’intégralité du rapport, nous vous proposons ci-dessous quelques extraits.

Les recommandations

p.18 – § 4.29 « Les nouvelles fonctions de Vista apportent une certaine valeur ajoutée mais, si l’on prend en compte les coûts de déploiement et les bénéfices potentiels, une mise à jour généralisée du parc informatique des écoles et des universités n’est pas recommandée. »

p.19 – § 4.31 « Le mélange des systèmes d’exploitation peut très bien se faire dans les écoles ou le réseau informatique fonctionne déjà avec plusieurs systèmes d’exploitation comme Windows, Mac et Linux quand cette mixité est adaptée. Nous recommandons cependant que les écoles et universités ayant un parc informatique cohérent sous Windows XP faisant l’acquisition de systèmes avec Vista préinstallé exercent, lorsque c’est possible, leur droit du choix du système d’exploitation et maintiennent la cohésion de leur installation avec Windows XP. »

p.20 – § 4.32 « Les écoles et les universités ne devraient envisager le passage à Vista seulement s’il est question d’installer un nouveau parc informatique complet et ne devraient pas envisager la mise à jour des systèmes existants ou faire cohabiter les deux environnements. »

p.21 – § 4.36 « Aucun déploiement de grande ampleur de Office 2007 ne devrait avoir lieu tant que les écoles et les universités ne sont pas certaines d’avoir mis en place tous les mécanismes permettant l’interopérabilité et permettant d’éviter toute fracture numérique possible comme celles citées plus tôt dans ce rapport. »

p.21 – § 4.37 « Les écoles et les universités qui envisagent le passage à Microsoft Office 2007 ne devrait le faire que dans un contexte de renouvellement complet pour n’utiliser qu’une seule version de la suite bureautique dans un établissement/environnement donné. »

p.35 – § 6.15 « Quand cela est possible, les écoles et les universités devraient s’assurer que les étudiants, les professeurs et les parents connaissent l’existence de l’ensemble des suites bureautiques "libres d’utilisation" disponibles, qu’ils savent comment se les procurer et comment les utiliser. Les écoles et les universités devraient configurer les outils de bureautique de manière à ne pas créer d’obstacles pour les élèves, les enseignants et les parents qui utilisent ces produits alternatifs (y compris les produits "libres d’utilisation") à domicile. »

p.36 – § 6.17 « Les entreprises des TIC devraient prendre les devants et configurer les produits qu’ils envoient aux écoles et aux universités pour faciliter l’accès à une suite bureautique « libres d’utilisation », idéalement une suite sous licence libre. Lors de l’achat de nouveaux systèmes, les écoles et les universités devraient normalement exiger qu’une suite bureautique capable d’ouvrir, d’éditer et de sauvegarder les documents au format standard international ODF soit installée et que ce format soit configuré par défaut. De tels produits devraient être choisis avec comme critère la possibilité pour les étudiants, les professeurs et les parents de s’en procurer une version sans avoir à payer de frais de licence supplémentaire. Les écoles et les universités devraient être prudentes lorsqu’elles utilisent une version d’essai d’un logiciel commercial, particulièrement lorsque les étudiants, les professeurs et les parents peuvent avoir l’impression que la seule manière pour eux d’accéder aux fichiers créés est d’acheter une copie du logiciel. »

Morceaux choisis

p.3 – § 1.2 « Les nouvelles fonctionnalités de Microsoft Vista présentent certes un intérêt, mais ne justifient pas une implantation immédiate dans le domaine de l’éducation : les coûts seraient élevés et les avantages loin d’être évidents. »

p.3 – § 1.2 « Office 2007 n’apporte aucune fonctionnalité indispensable et il faudrait que Microsoft présente une étude d’impact bien étayée pour justifier son implémentation dans le secteur de l’éducation. »

p.3 – § 1.2 « Il existe des problèmes d’incompatibilité concernant Office 2007 ; de plus, Microsoft devrait assurer au plus vite la compatibilité de sa suite bureautique avec le format OpenDocument (ODF). »

p.4 – § 1.4 « Dans notre rapport intermédiaire nous exprimions le souhait que Microsoft facilite la conduite de quelques activités pilotes permettant de mettre plus en évidence les avantages du déploiement de Vista dans un établissement scolaire et de mieux appréhender le coût qu’aurait ce déploiement. Becta n’a pas eu connaissance d’une telle analyse de rentabilité effectuée par Microsoft.. »

p.4 – § 1.8 « Alors qu’on estime à 66% le nombre de machines du parc informatique scolaire pouvant fonctionner avec Vista (d’après la définition de Microsoft), nous estimons quant à nous à 22% le nombre de machines répondant aux critères pour faire fonctionner Vista de manière correcte. »

p.5 – § 1.10 « Notre rapport intermédiaire recommandait que Microsoft présente une étude d’impact bien étayée pour justifier l’implantation d’Office 2007 dans l’éducation nationale en Grande-Bretagne. Aucun document de ce type n’a été porté à notre connaissance. Le rapport final confirme que son déploiement n’est pas absolument nécessaire. Il confirme également que l’utilisation d’Office 2007 pourrait avoir un effet pervers sur l’interopérabilité entre l’école ou l’université et le domicile. »

p.5 – § 1.11 « Nous conseillons de ne pas effectuer de déploiement massif d’Office 2007 avant que les écoles et les universités ne soient certaines d’avoir mis en place tous les mécanismes nécessaires pour assurer l’interopérabilité et éviter un potentiel « fossé numérique » mis en évidence lors des tests. Agir à l’encontre de ce conseil entraînerait des difficultés inutiles et restreindrait le choix offert aux étudiants, aux professeurs et aux familles qui doivent échanger des documents entre le domicile et l’école. De plus, cela imposerait également aux parents une contrainte financière. »

p.5 – § 1.13 « une standardisation de fait (par l’utilisation généralisée de produits d’un même fournisseur) peut être néfaste pour la concurrence et le choix, ce qui revient à augmenter les coûts. De plus en plus, les gouvernements, les entreprises et le système d’éducation refusent de voir leurs informations contrôlées par un fournisseur unique. Il en résulte un mouvement qui tend à délaisser les formats de fichiers propriétaires pour s’intéresser aux nouveaux formats de fichiers, plus ouverts, sous le contrôle d’un organisme de normalisation efficace. »

p.5 – § 1.14 « Nous avons identifié un certain nombre de points critiques concernant les capacités d’interopératibilité d’Office 2007. Ces points sont les suivants : l’adoption par Office 2007 d’un nouveau format de fichier qui n’est compatible avec aucun autre produit, et le manque de prise en charge du format de document standard international (ODF) qui est de plus en plus utilisé par les produits concurrents. »

p.6 – § 1.16 « Microsoft n’a rien fait pour répondre aux demandes concernant l’interopérabilité exprimées dans notre rapport intermédiaire. Office 2007 ne gère toujours pas efficacement le format de document standard international ODF. Microsoft a continué à chercher à obtenir la normalisation de son format de fichier Office 2007, ce qui ferait cohabiter deux formats standards. Cette opération a soulevé une importante controverse. »

p.6 – § 1.18 « Nous ressentons une certaine incompréhension vis-à-vis de l’approche adoptée pour le support de l’ODF dans Office 2007. Alors que le produit permet de lire quasiment tous les autres formats attendus nativement, les manipulations à effectuer pour utiliser les fichiers ODF sont vraiment fastidieuses. Nous avons dénombré 10 étapes qu’un utilisateur devrait suivre pour trouver et installer le convertisseur permettant à Office 2007 d’accéder aux fichiers ODF et nous avons également noté que les procédures pour ouvrir ou enregistrer des fichiers ODF dans Microsoft Office 2007 ne sont pas intuitives car elles diffèrent des procédures familières aux utilisateurs. D’après nous, ces procédures présentent suffisamment de difficultés techniques pour la plupart des utilisateurs pour qu’ils soient découragés d’utiliser des produits concurrents, ce qui pourrait affaiblir la compétition. »

p.6 – § 1.20 « Nous pensons que les obstacles que Microsoft a placés sur le chemin des utilisateurs qui voudraient utiliser le format de fichier qui devient de plus en plus commun dans les produits de la concurrence auront pour effet de limiter l’utilisation de ces produits. La compatibilité que Microsoft propose dans Office 2007 avec les produits concurrents est moindre que celle qu’il offre pour sa propre famille de produits. Nous nous sommes plaints à l’Office of Fair Trading (OFT) du risque que cela fait courir à la concurrence et que cela constitue un abus de position dominante par Microsoft. Notre plainte est considérée par l’OFT. »

p.7 – § 1.21 « Si les établissements scolaires devaient faire la mise à jour vers Office 2007 maintenant, nous ne pensons pas que cela apporterait un plus au niveau de l’interopérabilité (indépendamment des standards) mais, au contraire, cela se ferait au détriment de l’interopérabilité et que cela introduirait des difficultés supplémentaires dans le travail quotidien. La mise en œuvre de l’interopérabilité dans un usage à domicile et à l’école ne peut pas être considéré comme facile, que ce soit pour une utilisation directe ou après configuration des éléments nécessaires (packs de compatibilité, modifications des formats de fichiers par défaut ou extensions ODF). »

p.7 – § 1.24 « Sans faire de jugement sur les avantages techniques du format de document standard international (ODF) ou du deuxième format de document proposé pour devenir un standard international (OOXML), nous pensons toujours que la cohabitation de plusieurs normes internationales incompatibles offrant globalement les mêmes fonctionnalités n’est pas dans l’intérêt des utilisateurs. Cela ne fera qu’apporter confusion et complexité et introduira un surcoût inutile. Cela constituera une formidable occasion manquée qui sera préjudiciable au marché, au monde de l’enseignement et au concept lui-même de norme internationale. »

p.9 – § 1.33 « Nous recommandions que les fournisseurs facilitent le choix aux écoles en s’assurant que les ordinateurs pour ce marché soient proposés avec un choix de suites bureautiques et que ces offres devraient idéalement comprendre une solution en logiciels libres. Nos entretiens avec l’industrie ont confirmé qu’il n’y a pas de raison concrète pour que la mise à en œuvre de cette proposition pose problème. »

p.9 – § 1.34 « Nous proposons que les écoles et les universités, lorsqu’elles établissent le cahier des charges, devraient insister pour que leurs fournisseurs leur proposent une suite bureautique capable d’ouvrir, d’éditer et de sauvegarder des documents au format ODF et permettant de définir l’ODF comme format de fichier par défaut. »

p.14 – § 4.4 « Les essais ont confirmé qu’Office 2007 fonctionne toujours bien sous Windows XP, ce qui veut dire qu’il n’est pas absolument nécessaire de migrer vers Vista avant une mise à jour vers Office 2007. »

p.15 – § 4.9 « Office 2007 introduit un nouveau format de fichier par défaut et, comme le souligne notre rapport intermédiaire, cette évolution pose quelques problèmes de compatibilité. L’interopérabilité entre Office 2007 et les versions précédentes de Microsoft Office ainsi qu’avec les suites bureautiques d’autres fournisseurs n’est pas satisfaisante. »

p.17 – § 4.22 « Le coût total du déploiement de Vista dans les écoles anglaises et galloises se situe autour de 175 millions de livres sterling (environ 230 millions d’euros). Si cette estimation n’inclut pas les cartes graphiques supplémentaires nécessaires au fonctionnement de l’interface Aero (ce qui augmenterait nettement le montant minimum) elle tient compte des mises à niveau matérielles nécessaires, du coût des licences, des tests ainsi que du coût de la configuration et du déploiement. Environ un tiers de cette somme est imputable au prix des licences Microsoft. »

p.17 – § 4.23 « Le coût d’une mise à jour de Vista sur tout le parc informatique d’une école primaire typique serait de l’ordre de £5000 (environ 6500€) (environ £125 (160€) par machine). Pour un lycée, le coût d’une mise à jour semblable serait de l’ordre de £24000 (31200€), ce qui revient à un coût par machine d’environ £75 (98€). »

p.19 – § 4.30 « Nous suggérons que les nouvelles machines achetées avec Windows Vista pré-installé soient remises sous Windows XP en attendant que tout le réseau puisse être mis à jour. »

p.19 – § 4.31 « L’interface utilisateur différente de Vista par rapport à Windows XP peut impliquer que le personnel et les élèves aient besoin d’un entraînement ou d’une familiarisation avec le nouveau système d’exploitation. Cela pourrait être source de confusion si un cours ou un enseignement clé utilise les deux systèmes. »

p.19 – § 4.31 « Les machines sous Vista pourraient ne fonctionner qu’avec une autre version d’une application voir même seulement avec des produits différents. Cela peut être source de confusion si le personnel ou les élèves doivent travailler avec les deux systèmes d’exploitation. Il pourrait aussi être nécessaire de dupliquer le travail pour certaines leçons ou pour certains projets pour les adapter à Windows Vista et Windows XP. »

p.21 – § 4.36 « Il est important de ne pas placer d’obstacles inutiles sur le chemin des élèves, des professeurs et des familles lorsque des documents doivent faire le va-et-vient entre le domicile et l’école ou l’université. De tels obstacles pourraient restreindre l’utilisation de systèmes utilisant des formats de documents différents ou aboutir à des contraintes financières inutiles. »

p.22 – § 5.2 « Une véritable interopérabilité entre documents réduit les coûts, améliore la productivité des utilisateurs et permet d’éviter de se retrouver piégé par une technologie. »

p.23 – § 5.6 « Microsoft n’a pas cherché à remédier aux préoccupations relatives à l’interopérabilité que nous avions identifiées quant au support de la norme internationale existante. Au contraire, Microsoft a continué à rechercher l’approbation pour la création d’une seconde norme internationale de documents (Office Open XML) basée sur ses propres formats de fichiers Office 2007. »

p.23 – § 5.10 « L’approche actuelle de Microsoft pour assurer l’interopérabilité avec le standard ODF est de faciliter le développement par de tierces parties de modules ou de convertisseurs pour Office 2007 plutôt que réaliser le développement elle-même et de l’intégrer complètement dans son produit. Cette approche soulève des questions en ce qui concerne les utilisateurs béotiens, comment vont-ils accéder à la fonctionnalité nécessaire et quel va être son niveau d’ergonomie. »

p.23 – § 5.11 « Sous certaines conditions, inhérentes à la date de l’étude, les utilisateurs devaient aller sur un site web tiers et effectuer une série de tâches techniques avant de pouvoir de manière satisfaisante ouvrir, modifier et enregistrer des documents au format de fichier ODF. »

p.25 – § 5.14 « Nous pensons que ces bricolages pour accéder et utiliser la possibilité d’interopérer avec les produits concurrents de Microsoft Office 2007 présentent des difficultés techniques. Ces difficultés sont susceptibles de rendre les utilisateurs moins enclins à se servir des produits concurrents et donc de fausser la compétition. »

p.26 – § 5.19 « L’interoperabilité entre Microsoft Office 2007 et des versions antérieures de Microsoft Office n’est pas supporté de façon native. Malgré tout, Microsoft a publié une mise à jour de l’ensemble de ses modules de compatibilité qui devrait permettre aux versions antérieures de Microsoft Office d’ouvrir les formats de fichiers Office 2007. Cette solution est la plupart du temps suffisante mais, en fonction de l’application bureautique utilisée et dans certaines circonstances, elle va provoquer divers degrés de dégradation ou de perte de fidélité. »

p.28 – § 5.28 « Si l’on n’intervient pas, ces évolutions vont créer, pour les utilisateurs béotiens, une vision de l’intéropérabilité des documents qui sera complexe et partisane, ce qui serait un échec de l’objectif initial d’aller vers des standards ouverts. Microsoft a une position dominante sur le segment des systèmes d’exploitation pour PC et cette position risque d’être renforcée par son approche actuelle des standards de documents ouverts. »

p.30 – § 5.33 « Les utilisateurs d’Office 2003 ou antérieur devraient installer le pack de compatibilité afin de pouvoir ouvrir n’importe quel document OOXML Office 2007. Ils ne devraient pas enregistrer leurs documents dans le format OOXML. Comme les utilisateurs d’Office 2007, ils devraient les enregistrer dans les anciens formats Microsoft (.doc pour les documents texte, .xls pour les tableurs et .ppt pour les présentations). »

p.30 – § 5.34 « Les utilisateurs d’OpenOffice.org ou de Star Office (ou d’ailleurs de n’importe quelle suite bureautique basée sur les standards libres) auront plus besoin d’être conscients de la technologie utilisée par la personne à qui ils destinent leur document pour pouvoir tenir compte des limitations d’Office 2007. Pour permettre la compatibilité, ces utilisateurs devraient toujours enregistrer leurs documents dans les anciens formats Microsoft car c’est le plus petit dénominateur commun, entre ces produits disparates, qui peut permettre l’interopérabilité . »

p.30 – § 5.36 « Les fournisseurs doivent développer des applications qui sont capables de traiter toutes les normes internationales pertinentes, en laissant aux utilisateurs le choix de savoir quel sera leur format "par défaut". »

p.31 – § 5.38 « Nous ne sommes pas convaincus que le développement de plusieurs standards internationaux traitant essentiellement du même champ d’activité soit de l’intérêt du milieu éducatif. Comme nous l’avons précédemment exprimé, nous estimons qu’une telle approche va introduire confusion, complexité et coûts inutiles. Elle constitue une formidable occasion manquée qui risque de perturber le marché, la communauté éducative et le concept même de standards internationaux. »

p.32 – § 6.4 « Ces évolutions mettent en avant le nombre grandissant de concurrents dans le domaine des suites bureautiques et montrent que des systèmes innovants basés sur des alternatives à Windows commencent à voir le jour. »

p.32 – § 6.5 « Cependant, afin que ces innovations se développent sur le marché de l’éducation il ne faut pas que des barrières réduisent la concurrence, que ce soit par des restrictions liées aux licences ou par des obstacles liés à l’interopérabilité. Ainsi, par exemple, Becta considère qu’un arrangement par lequel un appareil fonctionnant sous Linux est sujet à un paiement annuel à Microsoft selon les termes d’un programme de licence Accord School, même si cet appareil n’utilise aucun logiciel de Microsoft, n’est pas acceptable. De tels arrangements font partis des pratiques qui font l’objet de notre plainte à l’OFT. »

p.33 – § 6.9 « Contrairement à d’autres secteurs ou la demande pour des solutions en logiciels libres est visible et croissante, les estimations dans le secteur éducatif montrent une demande faible, Becta est vu comme un facteur clé dans l’instauration de cette demande. »

p.34 – § 6.11 « Au cours des douze prochains mois Becta prendra un certain nombre de mesures pour encourager un choix plus efficace dans le cadre d’un usage éducatif. Ce travail inclura la publication d’un programme de travail dont le but sera de :

– fournir plus d’informations sur le site de Becta sur ce qu’est un logiciel libre et quels sont ses avantages pour l’éducation en Grande-Bretagne

– compléter la base de recherche actuelle qui recense les usages des logiciels libres dans le secteur éducatif et identifier des déploiements modèles de logiciels libres. Cela engloberait également l’esquisse d’un tableau national des usages des logiciels libres dans les écoles et les universités

– travailler avec la communauté du logiciel libre pour établir un catalogue en ligne des logiciels libres appropriés pour l’usage dans les écoles de Grande-Bretagne. Parmi les informations disponibles on retrouvera les moyens d’obtenir une assistance dédiée à ces logiciels et comment contribuer à leur développement futur. Ce catalogue sera publié sous une licence Creative Commons afin que les fournisseurs puissent le modifier pour leur propre usage

– donner des indications aux sociétés de services en logiciels libres pour qu’elles puissent efficacement participer dans de nouvelles structures compétitives et pour qu’elles puissent proposer des logiciels libres via la structure de fournisseurs existante de Becta »

p.34 – § 6.12 « Le point de vue de certaines écoles et universités est qu’elles doivent utiliser des logiciels propriétaires particuliers car ces produits sont les plus utilisés dans l’industrie et le commerce et que, d’après cet argument, les élèves doivent se familiariser avec ce qu’ils rencontreront dans la "vraie vie". »

p.34 – § 6.13 « Les étudiants aujourd’hui sont cependant en général à l’aise avec les TIC et ils sont capables d’utiliser une large gamme de logiciels à l’école ou à l’université et certainement plus encore à leur domicile. Ils peuvent également passer sans problème de l’ordinateur de l’école à celui à la maison ou celui de la bibliothèque de quartier ou encore à celui du cybercafé. Il est très peu probable qu’ils se retrouvent démunis devant une suite bureautique particulière après leurs études parce qu’ils auront été habitués à utiliser, par exemple, OpenOffice.org à l’école. »

p.35 – § 6.14 « En résumé, l’argument de la "familiarité" est recevable pour les élèves des années 80 et 90 mais moins pour ceux du 21ème siècle. Ce serait en effet un triste constat pour l’éducation aujourd’hui en matière de TIC si, dès qu’ils s’éloignaient de leur apprentissage, les élèves n’étaient pas capables d’utiliser des programmes basiques (comme les suites bureautiques ou les navigateurs) simplement à cause de différences de fonctionnement ou entre les interfaces utilisateurs. Posséder des compétences multiples devrait faciliter la recherche d’emploi au 21ème siècle, pas la compliquer. »

Le

Le

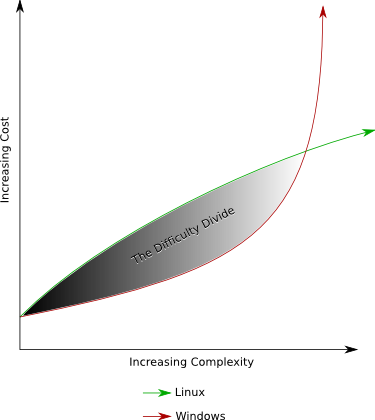

Vous souhaitez convaincre votre hiérarchie, votre direction, voire votre conjoint de migrer vers GNU/Linux ? Rédigé il y a plus de deux ans par le

Vous souhaitez convaincre votre hiérarchie, votre direction, voire votre conjoint de migrer vers GNU/Linux ? Rédigé il y a plus de deux ans par le