Geektionnerd : Abécédaire libre

Sources :

- Abécédaire – Un projet collectif libre

- Abécédaire – Appel à contribution pour coloriser

- Un abécédaire libre et contributif par et pour les enfants

Crédit : Simon Gee Giraudot (Creative Commons By-Sa)

Sources :

Crédit : Simon Gee Giraudot (Creative Commons By-Sa)

Plutôt que de se résigner à l’usage de services en ligne n’offrant aucune garantie réelle de confidentialité, Frank Karlitschek a décidé de ne pas se contenter de prêcher la bonne parole mais de passer à l’acte en élaborant (avec d’autres) un projet qui remporte un succès grandissant : un logiciel libre et open source de stockage de données. En revenant sur l’historique du projet ownCloud, il nous rappelle au passage les clés de la réussite (ne perdons pas de vue la proportion importante de projets open source qui n’aboutissent jamais) : développement collaboratif du code ouvert, prenant appui sur des outils et choix techniques ayant déjà une large base de développeurs, flexibilité, compatibilité multi-plateforme…

Cet article donne quelques indications plus précises sur les technologies mises en œuvre qui peuvent laisser perplexe le lecteur non développeur, mais la démarche et la philosophie de l‘open source y apparaîtront pour tous avec clarté. L’enjeu, c’est de rendre à l’utilisateur le contrôle de ses données.

Au fait, Framasoft dispose depuis un an de son propre ownCloud [1], pourquoi pas vous ?

par Frank Karlitschek, fondateur de ownCloud et mainteneur de l’architecture globale du projet.

Article original : Why I Built OwnCloud and Made It Open Source Traduction Framalang : Asta, r0u, KoS, Wan, Omegax, goofy, Diab

Il y a 4 ans, j’étais au CampKDE à San Diego, je donnais une conférence sur la protection des données, mettant en garde le public sur les risques pour leur vie privée auprès des fournisseurs de cloud – en particulier Dropbox. « — Eh bien fais-le toi-même », m’a-t-on dit. Bien sûr, j’avais déjà créé des choses dans le passé, alors bien sûr, j’ai dit que j’allais le faire. Et c’est là que j’ai commencé mon odyssée, en premier lieu pour me protéger moi-même, mes amis et mes collègues de l’espionnage des gouvernements et d’autres méchants, et plus tard – quand j’ai vu l’intérêt croître dans le monde – pour concevoir un projet concret et efficace.

je n’avais pas envie d’envoyer mes données à un service tiers pour qu’il les stocke on ne sait où

Évidemment, je devais décider d’un certain nombre de choses avant de commencer, notamment ce que je voulais que fasse le logiciel, quelle plateforme de développement utiliser, comment le structurer et bien sûr il fallait que je lui trouve un nom : ownCloud (NdT : littéralement, « le nuage qu’on possède »).

Mes amis et moi avions besoin d’un moyen de synchroniser nos images, nos documents et même nos vidéos en passant d’un appareil à l’autre (au lieu d’utiliser une clé USB), nous voulions aussi partager ces fichiers avec nos amis et nos proches. À l’époque, Dropbox devenait très populaire, mais je n’avais pas envie d’envoyer mes données à un service tiers pour qu’il les stocke on ne sait où. Je voulais créer une plateforme que mes amis puissent utiliser sur les espaces de stockage qu’ils avaient déjà, à la différence du cloud, pas seulement pour synchroniser et partager, mais aussi une plateforme assez flexible pour qu’on puisse y créer des applications.

Bien sûr ownCloud allait être open source.

Je faisais déjà partie de la communauté open source, mais ce n’est pas la seule raison. En faisant de l‘open source je concevais un code qui serait complètement transparent (et donc aurait peu de risques de comporter des « portes dérobées » pour entrer dans mes données). De plus je pouvais compter sur un grand nombre de personnes animées des mêmes convictions pour m’aider à créer ownCloud, je n’étais donc pas tout seul. Et je pouvais réutiliser les technologies d’autres projets. Comme SABREDAV, qui est le framework que nous utilisons pour la communication WebDAV du serveur (CalDAV, CardDAV et WebDAV sont tous utilisés par ownCloud), et nous utilisons aussi jQuery. Nous avons également utilisé csync pour les capacités de synchronisation bi-directionnelle du client de bureau et Qt pour l’interface utilisateur multi-plateforme. Je n’ai pas eu à réinventer la roue une fois de plus, je n’ai eu qu’à assembler ce qui existait déjà pour que tout fonctionne.

Mais comme je l’ai déjà dit, je savais ce que je voulais : ownCloud devait être plus qu’une « app ». Bien sûr, stocker les données d’une manière sûre et sécurisée est une chose importante. Mais en fin de compte, les gens veulent faire quelque chose de leurs données, alors j’ai voulu ajouter davantage de fonctionnalités à travers les applications ownCloud. Les applications sont des extensions qui peuvent implémenter des fonctionnalités telles que la détection de virus, la journalisation des accès et des changements de fichiers, le versionnage, le chiffrement, l’édition de fichiers et bien d’autres choses. Ce genre d’intégration du stockage de fichiers avec d’autres services est essentiel pour le développement futur.

Je voulais que mon projet soit flexible, de sorte que les gens puissent s’appuyer sur ownCloud (et beaucoup l’ont fait, avec une application type « Google News », un streamer de vidéos, un lecteur de musique, un calendrier – et plus encore) et que ownCloud puisse s’intégrer dans de nombreux environnements. Par exemple, n’importe quel client WebDAV devait pouvoir accéder à ownCloud dès le départ et le concept d’applications internes est là aussi depuis le début du projet.

Bien entendu, nous sommes plus avancés à présent — il y a des API de partage et d’administration, des API internes pour les applications utilisant OCS, il existe des bibliothèques pour mobile (que nous avons rendues open source) et qui permettent l’intégration à d’autres applications mobiles, une base de données clés-valeurs pour un usage général de stockage de données, de synchronisation, et davantage encore. Ensuite, il y a l’intégration de systèmes de stockage externe comme FTP, S3, SWIFT, CIFS, iRODS et beaucoup d’autres. Mais même à l’époque où nous avons commencé, les intentions étaient claires – construire quelque chose d’assez flexible pour que les gens puissent créer des solutions auxquelles nous n’avions pas pensé.

Et c’est justement ça, la puissance de l‘open source.

Nous (ma communauté grandissante et moi) avons évalué différentes options pour trouver la bonne technologie qui pourrait tourner sur chaque plateforme, du micro serveur jusqu’à des clusters de serveurs, qui aurait toutes les fonctionnalités et serait connue d’un grand nombre de développeurs. C’est pourquoi nous avons opté pour PHP et JS pour la partie serveur, C++ pour la synchronisation des Clients, Objective-C pour iOS et Java pour Android.

Il y avait plusieurs critères architecturaux à remplir dès le départ : multiplateforme, facilité d’extension, support des infrastructures, haute disponibilité basée sur les composants les plus largement utilisés. Donc, nous avons choisi PHP, pour cibler la pile « LAMP » (Linux / Apache / MySQL / PHP) qui est la plus répandue et éprouvée des plateformes permettant tout cela.

C’est également un projet open source et PHP est disponible gratuitement, facile à trouver, et multiplateforme (variantes Windows et Linux, IIS, Apache et autres serveurs Linux). Il bénéficie d’une communauté massive de développeurs dont beaucoup sont très expérimentés. Enfin, c’est un langage facilement accessible pour la communauté. Avec tout ça, c’était une évidence.

« L‘open source est la seule solution pour un stockage de données réellement sécurisé »

Comme j’ai commencé ce projet par une conférence sur la sécurité et la confidentialité, il était essentiel d’avoir la meilleure sécurité possible pour les API. J’ai choisi un chiffrement SSL fort pour toutes les API WebDAV et REST. L’authentification est faite via la méthode basique, qui est très simple et facile à gérer. On peut également utiliser SAML, fourni au travers de son implémentation Shibboleth. En complément OAuth et l’authentification à deux facteurs sont disponibles, et nous profitons même de la flexibilité de ownCloud pour intégrer un backend personnalisé, en utilisant des jetons à la place des mots de passe standards.

Je suis convaincu que le stockage de fichiers n’est pas seulement un service web ou une infrastructure informatique de plus. C’est là où les gens et les entreprises stockent et gèrent leurs données les plus importantes. C’est pourquoi il est essentiel de le rendre aussi sécurisé que possible. Avec un logiciel propriétaire, vous ne pouvez jamais être sûr qu’il n’y a pas une porte dérobée ou d’autres problèmes de sécurité. L’open source est la seule solution pour un stockage de données réellement sécurisé. Voilà ce que j’ai fait et pourquoi je l’ai fait. J’ai mis à ce travail toute ma passion pour l‘open source et il a aussi demandé beaucoup de soin !

Faire le point sur un an de révélations que nous devons à Snowden permet de comprendre comment nous sommes passés peut-être définitivement dans l’ère de la défiance. Quand la machine ubiquiste de surveillance de masse nous considère tous comme des suspects potentiels, nous ne pouvons faire autrement que de soupçonner à priori le plus vertueux des opérateurs téléphoniques ou des fournisseurs d’accès à l’internet d’être bon gré mal gré un complice de la NSA et de lui remettre les clés de nos vies privées, de nos engagements politiques etc. sans même parler de l’espionnage des grands de ce monde .

Cette liste tire sa force accusatrice de sa sècheresse factuelle. Chaque élément y est toutefois documenté par un lien (en anglais en général) vers un article de presse en ligne.

Article original sur le site de l’Electronic Frontier Foundation

par Nadia Kayyali et Katitza Rodriguez

Traduction Framalang :

Voilà un an que le journal The Guardian a publié pour la première fois le Foreign Intelligence Surveillance Court order, révélé par Edward Snowden, ex-sous-traitant de la NSA. Le document démontrait que la NSA avait mené des opération de surveillance généralisée sur des millions de personnes innocentes. Depuis lors, toute une vague de révélations choquantes, de divulgations, d’aveux partiels des autorités gouvernementales, d’appels aux lois qui garantissent la liberté de l’information, et de poursuites judiciaires, a déferlé sans interruption. Pour l’anniversaire de cette première révélation, voici 65 choses sur la surveillance par la NSA que nous savons maintenant mais que nous ignorions il y a un an.

1. Nous avons vu un exemple des décisions de justice qui autorisent la NSA à récolter potentiellement tout appel téléphonique aux USA – ce qui veut dire qui vous appelez, qui vous appelle, quand, pendant combien de temps et quelquefois même où.

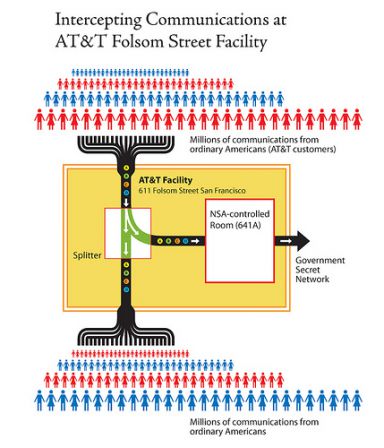

2. Nous avons découvert les diaporamas en Powerpoint de la NSA qui détaillent comment est menée la récolte « en amont », par la collecte d’informations captées directement dans l’infrastructure des opérateurs de télécoms.

3. La NSA a conçu une vaste « drague du Web » en s’assurant qu’elle peut intercepter non seulement les communications d’une cible lorsqu’elle fait partie d’une communication mais aussi celles qui « concernent une cible, même si la personne ciblée ne participe pas à une communication ».

4. La NSA a confirmé qu’elle recherche des données collectées selon les clauses de la section 702 des amendements à la FISA (FISA Amendments Act) pour avoir accès sans mandat aux communications des citoyens des USA, grâce à ce que le sénateur Ron Wyden a appelé « le vide juridique de la recherche via porte dérobée ».

5. Même si la NSA a déclaré de façon répétée qu’elle ne ciblait pas les citoyens des États-Unis, ses propres documents montrent que les fouilles de données menées sous l’égide de la section 702 sont conçues pour déterminer avec un degré de confiance de 51% seulement si la cible est étrangère.

6. Si la NSA n’établit pas l’origine étrangère d’une cible, elle ne va pas arrêter d’espionner cette cible pour autant. Au lieu de ça, la NSA va présumer que la cible est étrangère tant qu’elle ne peut être « identifiée positivement comme une personne des États-Unis ».

7. Un audit interne de la NSA révélé par une fuite a donné les détails de 2776 violations de règles ou de décisions judiciaires en une seule année.

8. Les hackers de la NSA ciblent les administrateurs systèmes, indépendamment du fait que ces administrateurs systèmes peuvent eux-mêmes être totalement innocents de tout acte répréhensible…

9. La NSA et la CIA ont infiltré des communautés de jeu en ligne comme World of Warcraft et Second Life pour récolter des données et mener leur surveillance.

10. Le gouvernement a détruit des preuves dans des procès pour espionnage intentés par l’EFF contre la NSA. Comble de l’ironie, le gouvernement a également prétendu que les clients de l’EFF avaient besoin de ces preuves pour établir la recevabilité de leur plainte.

11. Le directeur du renseignement national, James Clapper, a menti au Congrès lorsqu’il a été interrogé directement par le sénateur Ron Wyden pour savoir si la NSA était en train de rassembler des données de quelque nature que ce soit sur des millions d’habitants des USA.

12. Microsoft, comme d’autres sociétés, a collaboré étroitement avec le FBI afin de permettre à la NSA de « contourner le chiffrement pour avoir accès aux données des utilisateurs ».

13. Pendant la seule année 2013, le budget du renseignement était de 52,6 milliards de dollars — ce chiffre a été révélé par la fuite d’un document, et non par le gouvernement. Sur ce budget, 10,8 milliards de dollars ont été attribués à la NSA. Cela équivaut approximativement à 167 dollars par personne résidant aux Etats-Unis.

14. La Cour fédérale de la surveillance et du renseignement (Foreign Intelligence Surveillance Court) a rendu des décisions qui autorisent la NSA à partager des données brutes — non expurgées des informations permettant d’identifier les personnes — avec le FBI, la CIA et le Centre national de lutte antiterroriste (National Counterterrorism Center).

15. Conformément à un protocole d’accord (memorandum of understanding), la NSA partage régulièrement des données brutes avec Israël sans en expurger les informations personnelles permettant d’identifier les citoyens des USA.

16. Les divulgations de Snowden ont montré clairement que l’administration Obama avait induit la Cour suprême en erreur à propos de questions clés dans le procès intenté par l’ACLU à la NSA pour espionnage, Clapper v. Amnesty International, ce qui a conduit à un renvoi de l’affaire pour manque de preuves.

17. La NSA « a pénétré le système de communication interne d’Al Jazeera ». Les documents de la NSA font état de ce que « les cibles sélectionnés avaient un “fort potentiel en tant que sources de renseignement” ».

18. La NSA a utilisé des cookies soi-disant anonymes de Google comme balises de surveillance, aidant ainsi à pister les utilisateurs individuels.

19. La NSA « intercepte “des millions d’images par jour” – dont environ 55 000 “images de qualité suffisante pour la reconnaissance faciale” » et les traite avec de puissants logiciels de reconnaissance faciale.

20. Le programme de reconnaissance faciale de la NSA « peut maintenant comparer les photos des satellites d’espionnage avec les photos personnelles interceptées prises en extérieur, pour déterminer leur localisation ».

21. Bien que la réforme de la NSA se soit essentiellement focalisée sur la Section 215 du PATRIOT Act, et que la plupart des magistrats aient également poussé à réformer la Section 702 du FISA Amendments Act, certains des pires espionnages de la NSA ont été effectués conformément au décret 12333, que le président Obama pourrait abroger ou modifier dès aujourd’hui.

22. La NSA a collecté les informations de localisation des téléphones mobiles des citoyens des USA durant deux ans sous couvert d’un projet pilote ayant pour but de voir comment pourraient être analysées de telles informations dans ses énormes bases de données.

23. Au cours du seul mois de mars 2013, la NSA a rassemblé 97 milliards de renseignements en provenance de réseaux informatiques du monde entier, dont 3 milliards de renseignements des réseaux propres aux USA.

24. La NSA a ciblé Tor, un ensemble d’outils qui permet aux internautes de naviguer sur le net de manière anonyme.

25. Le programme MUSCULAR de la NSA infiltre des liens entre les data centers mondiaux des sociétés technologiques comme Google et Yahoo. De nombreuses sociétés ont répondu à MUSCULAR en chiffrant le trafic sur leur réseau interne.

27. Le programme XKEYSCORE analyse les courriers électroniques, les conversations en ligne et l’historique de navigation de millions de personnes n’importe où dans le monde.

28. À travers BULLRUN, la NSA sabote les outils de chiffrement auxquels se fient les utilisateurs ordinaires, les entreprises et les institutions financières, cibles ou non, dans un effort sans précédent visant à affaiblir la sécurité des utilisateurs d’Internet, vous y compris.

28. L’opération Dishfire a collecté 200 millions de textos par jour à travers le globe, qui peuvent être utilisés pour extraire des informations intéressantes sur vous : localisation, contacts, données de carte de crédit, appels manqués, alertes d’itinérance (qui indiquent que vous franchissez une frontière), cartes de visite électroniques, informations sur vos paiements par carte, alertes aux voyageurs, et renseignements sur vos réunions.

29. À travers l’opération CO-TRAVELER, les États-Unis collectent des informations de localisation provenant de relais de téléphonie mobile GSM, d’émetteurs Wi-Fi et de concentrateurs GPS, qui sont ensuite analysées en fonction du temps pour déterminer entre autres avec qui une cible voyage.

30. Un mémo de 2004 intitulé DEA – The “Other” Warfighter (DEA – « l’autre » combattant) montre que la NSA et la DEA « profitent d’échanges réciproques d’information ».

31. Quand la DEA agit sur les renseignements que sa division « Opérations spéciales » reçoit de la NSA, ils cachent la source de l’information à travers une « construction parallèle », une mascarade recréant une enquête imaginaire destinée à cacher la source de l’indice, non seulement au défenseur, mais à la Cour. Il s’agit de faire en sorte qu’aucun tribunal ne rende de décision sur la légalité ou la finalité de l’usage qui sont faits des données de la NSA dans les enquêtes ordinaires.

32. Le produit de la surveillance de la NSA finit régulièrement entre les mains de l’IRS (NdT : le fisc des États-Unis). Tout comme la DEA, l’IRS utilise la « construction parallèle » pour dissimuler l’origine de l’indice.

33. Même le Conseil de surveillance de la vie privée et des libertés civiles (Privacy and Civil Liberties Oversight Board), dont les membres sont triés sur le volet par le président des États-Unis, a recommandé que le gouvernement fasse cesser la collecte massive des enregistrements téléphoniques autorisée par la section 215 [NdT : du PATRIOT Act], cette collecte étant inefficace, illégale, et probablement anticonstitutionnelle.

34. La NSA a des projets pour infecter potentiellement des millions d’ordinateurs en y implantant des malwares dans le cadre du programme Tailored Access Operations (opérations d’accès personnalisé).

35. La NSA a eu un contrat secret de 10 millions de dollars avec la société de sécurité RSA pour créer une « porte dérobée » dans ses produits de chiffrement, largement utilisés par les entreprises.

36. « Dans le cadre d’une proposition visant à salir la réputation de ceux dont l’agence pense que les discours incendiaires radicalisent les autres », la NSA a surveillé leurs accès aux contenus pornographiques et rassemblé d’autres informations d’ordre explicitement sexuel.

37. La NSA et ses partenaires exploitent les applications mobiles, comme le jeu populaire Angry Birds, pour accéder à des informations privées sur les utilisateurs comme la localisation, l’adresse personnelle, le genre, et plus encore.

38. Le Washington Post a révélé que la NSA récolte « des centaines de millions de carnets d’adresses provenant de comptes personnels de courriel ou de messagerie instantanée du monde entier, dont beaucoup sont des citoyens des USA ».

Beaucoup de révélations de Snowden ont concerné les activités de la NSA à l’étranger, ainsi que les activités de certains des plus proches alliés de la NSA, comme son homologue britannique le GCHQ. Certaines de ces activités ont été des entreprises coopératives. En particulier, les « Cinq Yeux » – les États-Unis, la Nouvelle Zélande, l’Australie, le Royaume-Uni et le Canada – se communiquent mutuellement les données concernant leurs citoyens, constituant ainsi des failles susceptibles de saper la législation nationale.

39. La NSA a versé à son homologue britannique, le GCHQ, 155 millions de dollars ces trois dernières années « pour sécuriser l’accès aux programmes de collecte du renseignement britannique et les influencer ».

40. The Guardian a rapporté ceci : « Sur une période de six mois en 2008, [le GCHQ] a collecté les l’images de webcam – y compris une quantité importante de communications explicitement sexuelles – de plus d’1,8 millions de comptes utilisateurs Yahoo à l’échelle mondiale. »

41. Le GCHQ a utilisé des logiciels malveillants pour compromettre des réseaux appartenant à l’entreprise belge de télécommunications Belgacom.

42. Les principales entreprises de télécommunications, y compris BT, Vodafone, et Verizon business ont fourni au GCHQ un accès illimité à leurs câbles de fibre optique.

43. Le GCHQ a utilisé des attaques DDoS et autres méthodes pour interrompre les communications des Anonymous et de LulzSec, y compris les communications de personnes qui n’étaient accusées d’aucun délit.

44. La station Bude du GCHQ a surveillé des dirigeants de l’Union européenne, de l’Allemagne et d’Israël. Elle a également ciblé des organisations non gouvernementales comme Médecins du monde.

45. Partenaires de la NSA aux antipodes, les services de l’Australian Signals Directorate, ont été impliqués dans des violations de communications entre avocat et client couvertes par le secret professionnel, remettant en question un principe fondamental de notre système de justice pénal commun.

46. Les agents du renseignement australien ont espionné les téléphones mobiles du cabinet ministériel indonésien et du président Susilo Bambang.

47. En 2008, l’Australie a offert de partager les données brutes concernant ses citoyens avec ses partenaires du renseignement.

48. Le CSEC a aidé la NSA à espionner les dirigeants politiques durant le sommet du G20 au Canada.

49. Le CSEC et le CSIS ont été récemment réprimandés par le juge d’une cour fédérale pour l’avoir induit en erreur dans une demande de réquisition faite il y a 5 ans, à propos de l’utilisation des ressources des Cinq Yeux pour pister les Canadiens à l’étranger.

Ironie du sort, certaines opérations de la NSA ont ciblé des pays qui avaient collaboré directement avec l’agence en d’autres circonstances. Et certaines semblaient simplement non indispensables et disproportionnées.

50. Les documents de la NSA montrent que tous les gouvernements ne sont pas transparents sur leur propre niveau de coopération avec la NSA. Comme le rapporte The Intercept : « Peu de dirigeants élus ont connaissance de cet espionnage, voire aucun ».

51. La NSA intercepte, enregistre et archive chaque communication de téléphone mobile des Bahamas.

52. La NSA a surveillé les communications téléphoniques d’au moins 35 chefs d’États.

53. La NSA a espionné des diplomates français à Washington et aux Nations Unies.

54. La NSA a piraté les réseaux de l’entreprise chinoise Huawei et volé les sources de son code.

55. La NSA a posé des mouchards dans les ambassades de l’Union européenne à New York et à Washington. Elle a copié des disques durs dans les bureaux de l’UE à New York, et a mis sur écoute le réseau informatique interne des ambassades de Washington.

56. La NSA a collecté les métadonnées de plus de 45 millions d’appels téléphoniques italiens sur une période de 30 jours. Elle a également entretenu des stations de surveillance à Rome et à Milan.

57. La NSA a stocké les données d’approximativement 500 millions de connexions des systèmes de communication allemands chaque mois.

58. La NSA a collecté les données de plus de 60 millions d’appels téléphoniques espagnols sur une période de 30 jours, fin 2012 et début 2013, et a espionné des membres du gouvernement espagnol.

59. La NSA a collecté les données de plus de 70 millions d’appels téléphoniques français sur une période de 30 jours, fin 2012 et début 2013.

60. The Hindu, sur la base de documents de la NSA, a rapporté que « Sur une liste exhaustive des pays espionnés par les programmes de la NSA, l’Inde est en cinquième place. »

61. La NSA a pénétré le compte officiel de courriel de l’ancien président mexicain Felipe Calderon.

62. D’après The Guardian : « La NSA a, pendant des années, systématiquement écouté le réseau des télécommunications brésiliennes et et a intercepté, collecté et stocké sans discrimination les courriels et enregistrements téléphoniques de millions de Brésiliens ».

63. La NSA a surveillé les courriels, les appels téléphoniques et les textos de la présidente brésilienne Dilma Rousseff et de ses plus proches collaborateurs.

64. Les agences du renseignement allemand ont coopéré avec la NSA et ont implémenté le programme de la NSA XKeyscore, tandis que la NSA était en train d’espionner les dirigeants allemands.

65. Le quotidien norvégien Dagbladet a rapporté que la NSA a acquis des données sur 33 millions d’appels de téléphones mobiles norvégiens sur une période de 30 jours.

Il ne fait aucun doute que les relations internationales qu’Obama s’était engagé à restaurer, de même que la confiance du peuple des États-Unis dans le respect de sa vie privée et de ses droits constitutionnels, ont été sapées par la surveillance tous azimuts de la NSA. Mais un an après, le gouvernement des USA aussi bien que les gouvernements d’autres pays n’ont pas pris les mesures nécessaires pour faire en sorte que cette surveillance cesse. C’est pourquoi chacun doit se mobiliser – contactez votre député, rejoignez Reset the Net, et apprenez comment la loi internationale s’applique à la surveillance états-unienne aujourd’hui.

Toutes les images sous licence CC BY 2.0, par EFF, JeepersMedia et Richard Loyal French,

Le 28 mai prochain, l’académie de Paris organise sa « Journée 2014 de l’innovation et du numérique éducatif ».

Cette journée est ouverte à tout le personnel, à savoir « encadrement, formateurs, enseignants du premier et du second degrés, CPE de l’académie de Paris ». Et pour finir la journée (en beauté) : « Clôture par Monsieur le recteur de l’académie de Paris ».

Elle est ainsi présentée : « Le numérique vivifie la pédagogie, facilite l’accès au savoir et favorise le travail collaboratif. Bref, le numérique peut changer l’école. Comment alors s’y préparer ?

Faciliter l’accès au savoir et favoriser le travail collaboratif… Naïvement on pense naturellement au Libre.

Il n’en sera rien puisque cette journée se déroulera au siège de Microsoft France !!! (qui en profite au passage, dans le programme, pour y glisser sa « Classe immersive »).

Faut-il que l’académie de Paris manque à ce point de locaux pour devoir organiser cette journée chez Microsoft ? Accepterait-on que le ministère de l’Agriculture organise son colloque chez Monsanto ?

Ce n’est pas le première fois que Microsoft invite ainsi nos fonctionnaires : en 2011 Les inspecteurs de l’éducation nationale convoqués chez Microsoft, et en 2013 L’école selon Microsoft : comment j’ai appris à ne plus m’en faire et à aimer l’éducation privatrice et fermée.

Nous sommes en 2014 et l’Éducation nationale baigne toujours dans une culture propriétaire. C’est bien joué de la part de Microsoft. Beaucoup moins de la part d’une institution qui s’égare une fois de plus dans sa mission de service public, au détriment de ses élèves et de nos enfants.

Edit du 22 mai : la réponse Twitter de l’académie de Paris qui évoque un « choix technique » assez peu convaincant.

Edit du 30 mai : Basta! (Les profs réfléchissent sur le numérique à l’école… chez Microsoft !) et le site de l’Humanité (Quand l’éducation nationale se fait « sponsoriser » par Microsoft (SNUipp-FSU Paris)) ont consacré un article à ce sujet.

Sources :

présenté par Christophe Masutti

Le moins que l’on puisse dire, lorsqu’on fréquente les milieux universitaires, c’est que les enseignants-chercheurs partagent des avis très différents à propos de l’encyclopédie en ligne libre Wikipédia. Pour certains, c’est un non-sujet puisqu’il s’agit seulement de permettre à n’importe qui d’écrire n’importe quoi. Pour d’autres, il faut savoir y contribuer parfois pour corriger des erreurs, parfois parce qu’il est aussi du devoir du chercheur que de partager ses connaissances, et pour d’autres encore la pertinence de Wikipédia ne saurait être valide à cause de l’anonymat des contributeurs et de l’absence d’un comité éditorial dans les règles de l’art des revues universitaires classiques.

Une quatrième catégorie, en revanche, prend du recul par rapport aux régimes de publication académiques et considère que ce n’est pas parce que les règles de publications sont universitaires qu’elles doivent être universelles. Ceux-là proposent de contribuer activement à Wikipédia mais en tâchant d’opérer la distinction entre les objectifs et les normes de Wikipédia et les attentes habituelles des publications académiques.

L’American Historical Association est l’une des plus anciennes sociétés savantes aux États-Unis. L’une de ses publications mensuelles, Perspectives on History, a 50 ans d’existence et reste l’une des revues historiques les plus lues au niveau mondial. Stephen W. Campbell, un jeune chercheur, vient d’y publier un article-témoignage dont nous vous proposons ci-dessous une traduction. Il y synthétise rapidement l’attitude classique des historiens vis-à-vis de Wikipédia et propose justement de prendre un peu de recul par rapport aux questions épistémologiques de la neutralité et de l’objectivité.

Certains arguments sont bien entendus discutables, mais le plus important est que, en publiant ce témoignage dans une telle revue, on assiste certainement à une déclaration d’intérêt. Cela montre aussi que l’attitude des chercheurs par rapport à Wikipédia n’est pas un phénomène générationnel. William Cronon, le président de l’AHA en 2012, y est cité comme ayant encouragé la participation à Wikipédia.

La question est plutôt à entrevoir du point de vue de la participation active et volontaire : il y a une vie au-delà du régime de l’évaluation permanente et épuisante des instances de “valorisation” de la recherche académique…

Source : Stephen W. Campbell, Improving Wikipedia: Notes from an Informed Skeptic, dans la revue : Perspectives on History, American Historical Association, mai 2014

Traduction Framalang : hack, r0u, KoS, Amargein, Gilles, Asta, Fchaix, goofy

En tant qu’historien américain qui étudie l’économie politique de la période d’avant la guerre de Sécession, j’ai toujours été fasciné par le mouvement de panique de 1837 – un cataclysme financier qui mérite son nom de « première grande dépression américaine », suivant l’expression employée dans un livre récent. Pendant les congés d’hiver 2012-1013, j’ai cherché « Crise de 1837 » sur Wikipédia et n’ai trouvé qu’une entrée assez décousue qui ne pointait que sur bien peu de sources secondaires. C’était fâcheux, c’est le moins qu’on puisse dire. Les rédacteurs de Wikipédia avaient marqué l’article comme partial ou incomplet et demandaient à un « spécialiste » de l’histoire des États-Unis de l’améliorer.

J’ai pris la décision d’améliorer l’entrée, et dans ce processus j’ai découvert des détails importants concernant les règles de Neutralité du point de vue de Wikipédia, les sous-cultures idéologiquement chargées qui, souvent, altèrent et falsifient ces entrées et une explication probable de mon aptitude à réhabiliter l’entrée avec succès. Depuis deux ans et jusque très récemment, j’ai été un critique véhément à l’encontre de Wikipédia, étant frustré par de trop nombreuses réponses dérivées de Wikipédia aux examens. Mais comme je vais le montrer plus loin, je suis devenu plus optimiste concernant la mission de Wikipédia et je crois qu’elle incarne de nombreuses valeurs auxquelles sont très attachés les universitaires.

Parmi ces derniers on trouve un large éventail d’opinions sur l’utilité de Wikipédia. L’ancien président de l’AHA William Cronon ne voyait que des avantages au fait d’encourager les historiens à contribuer davantage à Wikipédia, tandis que Timothy Messer-Kruse émet un jugement sévère en soulignant les écueils d’un site web qui ne fait pas la différence entre les opinions d’un expert et celles d’un profane, et dont la politique de vérification exclut les contenus seulement fondés sur des sources primaires inaccessibles – ce qui fait de lui un critique virulent de Wikipédia(1). Ma position se situe quelque part entre les deux.

En examinant de plus près cet article sur la Crise de 1837, j’ai remarqué que pratiquement tous les auteurs cités dans les références étaient des libertariens radicaux. La seule « référence externe » était un article écrit de façon informelle, aux sources sélectives, écrit par un obscur historien ne citant pas ses références, et rendu publique lors d’une conférence au Ludwig Von Mises Institute (LVMI), un think-tank d’Alabama qui n’est rattaché à aucune université ni soumis à un système de révision par des pairs.

Tenant son nom de l’économiste autrichien Ludwig Von Mises (1881-1973), l’organisation sponsorise des chercheurs prônant le « laissez-faire » économique et les théories du cycle économique de Friedrich Hayek. Certains LVMIstes (« membres » du LVMI) ont réduit à néant Abraham Lincoln, promu l’étalon-or, et donné une vision romantique du Vieux Sud en omettant l’esclavage. Le groupe rejette catégoriquement, d’après son site web, toute forme de régulation par l’État comme dangereuse pour « la science de la liberté ». Cela semble simpliste. La plupart des historiens reconnaissent que le terme « liberté » a plusieurs significations. L’accès à une assurance-maladie, la protection de l’environnement, ou celle des droits civiques, relèvent de la « liberté », mais nécessitent l’intervention de l’État

J’ai passé plusieurs jours de mes congés d’hiver à ajouter du contenu et des références sur le site, et les éditeurs de Wikipédia, vraisemblablement après avoir approuvé mes modifications, ont supprimé la mention qui fait référence à des informations partiales et incomplètes. Quant à savoir pourquoi cette expérience a été un succès, la réponse pourrait se trouver dans la politique de Wikipédia sur la neutralité de point de vue : les contributeurs doivent s’efforcer de « ne pas donner une fausse impression de parité, ni ne donner trop de poids à un point de vue particulier »(2). Tout économiste chevronné qu’ait été Hayek, l’interprétation de Von Mises était encore en minorité.

La façon dont j’ai édité pourrait expliquer pourquoi je ne me suis pas retrouvé dans une guerre d’édition chronophage. J’ai plus que doublé le nombre de références monographiques et d’articles de journaux révisés par des pairs tout en supprimant très peu du texte préexistant même si je le jugeais suspect. J’ai plutôt restructuré la prose pour la rendre plus lisible. Cette formule ne fonctionne peut être pas toujours, mais les historiens devraient essayer d’écrire autant que possible d’une manière descriptive sur Wikipédia et non de façon analytique, bien que cela puisse être contre-intuitif par rapport à notre formation et que la frontière entre description et analyse soit incertaine.

Les détracteurs de Wikipédia ont beaucoup d’objections valides. Il n’y a pas de rédacteur en chef ayant le dernier mot sur le contenu. La sagesse collective peut renforcer certains préjugés innés ou se révéler erronée au cours du temps. C’est le problème que Messer-Kruse a judicieusement mis en exergue dans ses recherches approfondies sur l’attentat de Haymarket Square – même lorsqu’un contributeur-expert, comme Messer-Kruse, élabore un argumentaire basé sur de solides preuves, les éditeurs bénévoles de Wikipédia peuvent tergiverser ou amoindrir le nouveau point de vue « minoritaire ». Enfin, il existe une possibilité pour que l’existence même de Wikipédia dévalue l’art et le travail d’enseigner et publier. Il y a quelques années, j’ai rédigé un article pour un projet d’encyclopédie sur l’esclavage américain d’un éditeur de référence bien connu. L’éditeur m’informa, après que j’eus fini mon article, que le projet serait interrompu pour une durée indéterminée, en partie en raison de la concurrence avec Wikipédia.

Il n’y a peut-être aucun sujet qui mène autant à la controverse que la pierre fondatrice de Wikipédia sur la neutralité. Les détracteurs se demandent si cet objectif peut être atteint ou même s’il est désirable(3). En décrivant ses règles qui mettent l’accent sur le double verrou de la « vérifiabilité » et du refus des « travaux inédits », Wikipédia indique qu’il vise à décrire les débats, mais pas à s’y engager. C’est cela qui fait hésiter les historiens. À partir du moment où nous sélectionnons un sujet de recherche et que nous collationnons des faits dans un ordre particulier, nous nous engageons involontairement dans un débat. Ajoutons à cela que les faits ne sont jamais vraiment neutres puisque ils sont toujours compris à l’intérieur d’un contexte idéologique plus vaste(4).

De plus, le plus surprenant parmi les règles de Wikipédia est la façon dont le site gère les approches complexes de ces nombreux problèmes philosophiques. Les contributeurs de Wikipédia insistent sur le fait que la neutralité n’est pas la même chose que l’objectivité. Le site évite de traiter les peudo-sciences, les fausses équivalences et soutient les principes de la revue par les pairs. Pour valider des arguments contradictoires, il donne la primauté à l’argument dans les publications érudites, et non à la validation par le grand public. Le règlement de Wikipédia reconnaît même que l’on ne peut pas considérer le principe de neutralité au sens le plus strict car les tentatives d’élimination de toute partialité peuvent se faire au détriment de la signification(5). Ce sont toutes ces normes que les universitaires devraient applaudir. Les rédacteurs de Wikipédia ont sans doute répondu aux critiques de Messer-Kruse, et bien qu’il n’incorporera jamais correctement des informations trop innovantes et récentes uniquement connues dans les milieux scientifiques, la beauté du site est qu’il contient les outils de ses propres améliorations.

Ayant conscience que certains de ces problèmes ne trouveront jamais vraiment de solution, j’en appelle aux historiens pour qu’ils consacrent quelques heures de leur précieux temps libre à l’amélioration de Wikipédia ; à titre d’encouragement. Les docteurs récemment diplômés font face actuellement à une terrible crise de l’emploi et l’objectif tant convoité d’obtenir un poste de professeur à temps plein s’avère de plus en plus difficile à atteindre. Les contributions à Wikipédia pourraient être un bon moyen de valoriser leur CV en prévision d’un prochain entretien d’embauche. Les détails pour y parvenir restent probablement à régler.

Photo par mikedesign, licence CC BY-2.0

Peut-être des historiens pourraient-ils s’identifier publiquement sur Wikipédia, sauvegarder leurs contributions, et être crédités si Wikipédia conserve leurs corrections. Publier ouvertement peut réduire le risque de troll, l’anonymat protégeant souvent les internautes des répercussions de commentaires indésirables. Les articles Wikipédia doivent venir en complément, et non en substitution, des articles traditionnels (dans des revues) et monographies, et les comités de validation devraient prendre en compte un certain quota d’articles en ligne par rapport aux articles traditionnels – peut-être quatre ou cinq entrées validées dans Wikipédia pour chaque article dans un journal traditionnel spécialisé.

Une des critiques récurrentes à l’égard des monographies est qu’elles conviennent seulement à un public spécialisé et limité, et finissent par s’empoussiérer sur des étagères de bibliothèques endormies. Peut-être que Wikipédia est le lieu idéal pour diffuser nos propres recherches et expertises à destination d’un public plus vaste, ce qui, théoriquement, permettrait d’améliorer la conception de l’histoire qu’a le public et la façon dont on en parle. Nombreux sont les représentants des sciences dures qui ont déjà pris en compte la publication électronique et comme d’autres l’ont souligné, nous risquons d’être marginalisés comme discipline si nous ne nous joignons pas à ce mouvement(6).

Au moment où j’écris ceci, environ un tiers du texte et la moitié des citations de l’article sur la crise de 1837 sont de ma main. J’ai dû mettre de côté ce précieux projet parce que le nouveau semestre venait de commencer, ce qui est bien regrettable parce que la page pouvait encore être améliorée, du moins ai-je procuré les lignes directrices aux autres spécialistes. Le site compte cinquante-huit « abonnés à cette page » et la section « Historique » affiche un grand nombre de suppressions qui ont été réintroduites – ce qui est peut-être l’indice de l’incorrigible obstination des partisans de Wikipédia. Les étudiants, les passionnés d’économie politique et le grand public disposeront toutefois de meilleures informations historiques, du moins je l’espère, à mesure que Wikipédia s’améliorera de façon continue.

Stephen W. Campbell est maître de conférence au Pasadena City College. Sa thèse de doctorat, terminée en 2013 à l’Université de Santa Barbara, analyse l’interaction entre les journaux, les institutions financières et le renforcement de l’État avant la guerre de Sécession.

Notes (Les ouvrages référencés en liens sont en anglais)

1. William Cronon, « Scholarly Authority in a Wikified World », Perspectives on History, février 2012, http://www. historians.org/perspectives/issues/2012/1202/Scholarly-Authority-in-a-Wikified-World.cfm (consulté le 23 avril 2013). « The Professor Versus Wikipedia », On The Media, 9 mars 2012, http://www.onthemedia.org/story/191440-professor-versus-wikipedia/transcript/ (consulté le 27 février 2014).

2. Wikipédia : Neutralité du point de vue, http://en.wikipedia. org/wiki/Wikipedia:Neutral_point_of_view (consulté le 26 décembre 2013).

3. Jeremy Brown et Benedicte Melanie Olsen, « Using Wikipedia in the Undergraduate Classroom to Learn How to Write about Recent History », Perspectives on History, 50, Avril 2012 (consulté le 23 avril 2013).

4. Martha Nichols et Lorraine Berry, « What Should We Do About Wikipedia ? », Talking on Writing, 20 mai 2013, http://talkingwriting.com/what-should-we-do-about-wikipedia (consulté le 27 décembre 2013).

5. Wikipédia : Neutralité du point de vue.

6. Lori Byrd Phillips et Dominic McDevitt-Parks, « Historians in Wikipedia : Building an Open, Collaborative History », Perspectives on History, décembre 2012, http://www.historians.org/perspectives/issues/2012/1212/Historians-in-Wikipedia. cfm (consulté le 26 avril 2013).

* Ce travail est sous licence Creative Commons Attribution-NonCommercial-NoDerivatives 4.0 International.

Sources sur Numerama :

Crédit : Simon Gee Giraudot (Creative Commons By-Sa)

En marge de la préparation d’un événement organisé sur Lyon par la communauté Mozilla (dont on vous reparlera bientôt), nous avons eu le plaisir de rencontrer l’un des développeurs de Prototypo, un logiciel libre de dessin typographique, à l’usage très innovant.

Une soirée de présentation du logiciel ayant lieu ce soir (Lyon 7ème)[1], nous avons souhaité poser quelques questions aux créateurs du projet, afin qu’ils nous présentent le parcours de ce logiciel, qui sera bientôt disponible.

Yannick, 28 ans. Depuis maintenant 4 ans je dessine et intègre des sites webs, des interfaces et parfois je touche un peu au papier. J’ai commencé à toucher au code durant ma dernière année des Arts Décoratifs de Strasbourg lorsque j’ai réalisé la version Alpha de Prototypo, développée en Processing. Après une année passée en agence à Paris, j’ai décidé de me lancer en freelance, à Lyon, et j’essaie depuis de me perfectionner dans tout ce qui m’intéresse, c’est-à-dire le dessin de caractère, le développement et le design interactif en général.

Louis-Rémi, 27 ans, développeur web indépendant depuis trois ans. Je suis tombé dans le logiciel libre en même temps que je suis tombé dans le web : sur le tard (en 2007), et très naturellement, parce le web et le libre étaient déjà largement entremêlés à cette époque. J’ai participé il y a quelques années au développement de la branche 1.X de jQuery et créé quelques plugins assez populaires. Et je suis un Mozillien depuis six ans, j’ai participé à “Jetpack / addon SDK”, à la documentation sur MDN. Aujourd’hui je développe Prototypo avec Yannick tout en essayant de rendre ce “logiciel libre de niche” viable financièrement.

Prototypo est un logiciel de dessin typographique, il permet de créer de nouvelles polices des caractère qui seront utilisées dans le design graphique (affiches, sites web, jeux vidéo, etc.). Dans Prototypo, le dessin démarre en modifiant une vingtaine de paramètres qui vont changer l’apparence de toutes les lettres de l’alhabet en même temps. Alors que dans les autres logiciels (Fontlab, Glyphs, Robofont et l’alternative libre Fontforge) on dessine chaque caractère un à un. L’intérêt c’est qu’on démarre plus vite, même avec des connaissances limités dans cette discipline exigeante, et que l’on peut explorer de nouvelles formes et proportions en quelques clics.

Y. : En étant graphiste papier à la base, l’intérêt pour la typographie m’est venu tout naturellement, car c’est une pierre d’angle de la création graphique quelque soit son envergure et ses objectifs. Assez rapidement, j’ai essayé de créer moi-même un caractère typographique que je pourrais utiliser en petit corps (corps de labeur) dans mes projets. Mais dessiner un caractère de qualité requiert un investissement important et n’est pas du tout une tâche accessible si l’on n’y consacre tout son temps. Il existe une multitude de règles optiques, de dessin, à respecter (et avant tout à connaître) pour que le caractère soit fonctionnel. Étant donné que beaucoup de ces règles sont récurrentes et mesurables, je me suis dit qu’il serait possible de les systématiser et donc de les coder. Prototypo est né de cette idée : permettre à l’utilisateur de se concentrer sur le design et laisser la machine s’occuper des tâches répétitives et gérer ces micro-corrections.

LR. : moi j’ai découvert la vidéo de la première version développée par Yannick il y a à peu près un an. Visuellement c’était bluffant, et comme j’ai une écriture manuscrite déplorable, j’ai peut-être vu inconsciemment en Prototypo un moyen à ma porté d’avoir une écriture personelle ET lisible. Quoi qu’il en soit j’ai contacté l’auteur de cette vidéo pour savoir où en était le projet. Il aurait pu habiter aux US, il aurait pu ne jamais me répondre ou être passé à autre chose… Mais non, il habitait à Lyon, à trois kilomètres de moi, il avait envie de redémarrer le projet avec des technos web et il était prêt à me rencontrer (plus tard on s’est apperçu qu’on s’était croisé dans son école et à un déménagement sans le savoir). On a commencé à travailler sur notre temps libre et à voir que ça marchait, puis on s’est dits qu’on voulait faire les choses en grand, qu’on travaillerait à temps plein un mois ou deux avant de tenter une campagne de financement participatif.

Les logiciels de dessin typographique s’adressent aux graphistes et typographes. Prototypo est utile aux amateurs et étudiants pour s’initier de manière ludique, ainsi qu’aux professionnels, particulièrement pendant la phase de recherche graphique. Mais nous espérons aussi rendre cette discipline accessible aux novices qui veulent une police sur mesure pour leur site, leur jeu vidéo, ou toute autre création qui utilise du texte.

LR. : Cétait une évidence. J’ai toujours publié le code que j’écrivais sur mon temps libre sous licence libre, parce que j’ai toujours développé avec du logiciel libre. Et Yannick s’était initié au développement principalement sur Processing dont la communauté est très encline au partage. Mais cette fois-ci il y avait un vrai défi : gagner sa vie en créant un logiciel libre.

Y. : J’ai aussi fait mes premiers pas avec des CMS comme SPIP et la communauté m’a beaucoup apporté. Depuis tout ce temps, j’ai beaucoup reçu mais jamais donné; avec Prototypo c’était l’occasion ou jamais.

Presque. Le plan initial était d’arriver rapidement à un prototype qui prouverait que le concept marchait aussi dans un navigateur, en plus de créer de la nouveauté pour les personnes qui suivaient le projet depuis plusieurs années. Et ensuite de lancer très tôt une campagne de financement participatif pour vérifier l’intérêt du public et la viabilité du projet. Dans les faits ça a pris beaucoup de temps. Nous rallongions contamment la liste des “fonctionnalités essentielles” et avons mis cinq mois à être satisfaits, puis encore un mois à lancer la campagne sur Kickstarter. À l’origine nous pensions donc devoir vivre deux ou trois mois sur nos économies (ce qui est tout à fait envisageable tant qu’on n’habite pas Paris). Finalement il a fallu se serrer la ceinture les trois derniers mois et accepter des petits contrats.

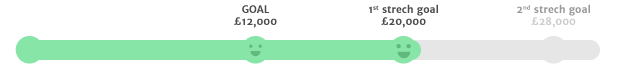

La campagne visait à rassembler 12.000£ (15.000€) en un mois, pour financer les cinq mois de travail nécessaire à la sortie de la version 1. Nous avons atteint cet objectif en trois jours, et au bout de deux semaines nous en sommes à presque 20.000£ (24.000€). Cela va nous permettre d’ajouter des fonctionnalités avancées telles qu’un éditeur intégré permettant d’importer ses propres polices pour les rendre paramétrables, ou des extensions de navigateur pour prévisualiser en temps réel la police dans des pages web.

C’est le résultat d’une longue préparation, entamée dès le début de notre collaboration : nous avons animé un blog et des comptes sur les réseaux sociaux, et aussi mis en place un formulaire pour s’abonner à notre newsletter, sur notre site principal. En six mois 10.000 personnes s’y sont inscrites, dont la moité après un effet boule de neige démarré par un simple tweet de Smashing Magazine. C’est grâce à ces inscrits que la campagne a connu un bon démarrage. Désormais nous sommes occupés à plein temps par son animation : nous répondons aux questions des utilisateurs, sollicitons des blogs pour des interviews (big up au Framablog), et participons à des évènements autour du design et de la typographie.

Pendant la campagne et par la suite, nous vendons un abonnement qui permet d’utiliser le logiciel sur nos serveurs pendant un an. Pour nous c’est un moyen d’obtenir un revenu régulier qui nous permette de nous consacrer à temps plein à l’amélioration du logiciel. Pour les utilisateurs, c’est la possibilité de bénéficier instantanément de tous les avantages d’une web-app (applications et données disponibles partout, toujours à jour), en gardant la possibilité d’installer l’application en local. Nous sommes aussi en discussion avec des éditeurs de solutions hébergées qui souhaitent intégrer Prototypo à leurs applications.

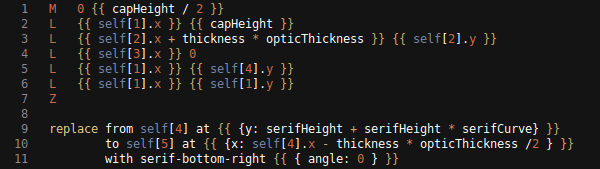

Nous utilisons les languages de base du web : HTML, SVG, JS et SCSS (CSS avec des variables et règles imbriquées). Cela nous permet d’être le plus ouvert aux contributions externes. Pour structurer notre application et simplifier le développement de l’interface utilisateur nous avons choisi AngularJS, qui est très activement développé et dispose d’une bonne documentation et d’une forte communauté de développeurs. Pour que l’application fonctionne de manière “hors-ligne par défaut” nous utilisons Hoodie, un projet encore perfectible mais très activement développé par une équipe expérimenté et ambitieuse. Pour gérer les interactions tactiles et à la souris de manière unifiée nous utilisons la librairie PointerEvents, qui est un sous-projet de Polymer, développé par Google. Et nous utilisons encore jQuery, parce que les navigateurs modernes ont et auront toujours des bugs, que son API conserve des avantages par rapport à celle du DOM (chaînages des méthodes, délégation d’évènements), et qu’elle intègre des optimisations internes (différents caches et utilisation de fragments DOM). Enfin, nous nous sommes rapprochés d’autres développeurs de webapps libres de dessin typographique pour créer une librairie capable de générer des fichiers de polices binaires (.otf) directement dans le navigateur.

Par ailleurs, nous créons petit à petit notre propre language afin de créer les “caractères paramétrables” qui sont au coeur de Prototypo : des caractères qui se transforment lorsque l’utilisateur interragit avec les paramètres de l’interface. À la base c’était un mélange de SVG et de JS mais nous permettons de rajouter des contraintes (un point placé à une interection par exemple), et d’inclure dans un tracé des composants réutilisables. C’est en évolution constante et très spécifique à notre usage, mais nous espérons bien que les utilisateurs s’en saisiront pour enrichir les possibilités du logiciel. Quelle est la suite des évènements ? (annoncer entre autre l’apéro)

Nous allons encore être occupé à plein temps par la campagne pendant ses 15 derniers jours. Nous organisons mardi soir un Apéro Prototypo sur Lyon (chez KolleBolle) auquel nous convions tous nos amis, mais aussi les graphistes et libristes qui voudraient essayer la version de développement du logiciel et discuter avec nous autour d’un verre. Les 6 et 7 Mai nous seront au Automatic Type Design organisé par l’ANRT à Nancy. Une fois que la campagne sera finie nous nous remettrons enfin au dévelopement et essayerons de créer les conditions favorables à l’accueil de contributeurs externes. La version de travail sera accessible fin Mai et la version 1.0 devrait être disponible en Septembre prochain. Nous continuerons à développer Prototypo aussi longtemps que notre trésorerie le permettra.

On remercie toutes les personnes qui nous ont soutenu jusqu’ici, en donnant de leur temps, en participant à la campagne de financement, en affichant leur soutien sur Twitter et Facebook, en nous inviant dans leurs colonnes, et on remercie par avance toutes les personnes qui vont le faire. Dès le début Prototypo a été un projet passionnant, maintenant grâce à vous c’est un projet exaltant.

[1] Oui, je sais, on prévient “un peu” tard :-/

Le samedi 17 mai et le dimanche 18 mai à Gérardmer se déroulera un événement inédit dans la région Grand Est : Vosges Opération Libre. Il est ouvert à tous et orienté à la fois vers le grand public et les professionnels.

Cette opération libre est à l’initiative de Framasoft et d’autres d’associations d’envergure nationale ayant une grande expérience dans le Libre, l’ouverture des données, les licences libres et le libre accès.

Il s’agit de la seconde Opération Libre se déroulant sur le territoire français. La première ayant eu lieu à Brocas (Aquitaine) en 2013. Les Opérations Libres visent à rassembler, le temps d’un week-end, des acteurs du Libre en vue d’initier la démarche open data dans les petites villes et villages en présentant les outils disponibles, notamment des logiciels libres. Elles invitent les habitants à participer à l’ouverture et à la diffusion des données de leur territoire. Elles proposent aussi d’engager les citoyens dans un rapport différent avec leur territoire en montrant que le partage des connaissances leur permet d’être collectivement valorisées.

Cette initiative portera aussi sur les usages numériques, leur appropriation, leur potentiel de créativité et leur économie. Cette manifestation vise à promouvoir la culture libre et l’ouverture des données en organisant des actions thématiques formulées en stands, ateliers de formation, conférences, projection permanente de films libres, débats, etc.

Il s’agit d’un événement culturel et participatif où le logiciel libre et ses principes sont conçus comme autant de moyens au service des activités pratiques proposées à destination du grand public. Un travail préalable précédant la manifestation a été mené avec les acteurs de la vie culturelle locale, en particulier la médiathèque de Gérardmer (soirées Wikipédia, ateliers et conférence).

Le programme de la manifestation est disponible à l’adresse vosges.operation-libre.org. Il comprendra :