Windows 8, le nouveau système d’exploitation de Microsoft, qui sera le même pour PC, tablette et smartphone, devrait être lancé officiellement le 26 octobre, et on peut compter sur le puissant marketing de la multinationale pour nous abreuver d’images cool, avec des doigts qui caressent une interface tactile en tuiles sur un bureau attrayant. C’est certain, l’interface entièrement rénovée sera plus au goût du jour, maintenant que la vaste diffusion des appareils mobiles nous a accoutumés à d’autres gestes que cliquer sur des icônes…

Le libristes habitués aux versions successives plus ou moins buguées de Windows (et celle-ci promet déjà de l’être) hausseront sans doute les épaules et retourneront à leur Debian. Ils auront peut-être tort si l’on en croit Casey Muratori, qui se demande si l’impact du nouveau système ne pourrait pas être aussi décisif pour l’informatique grand public que la sortie de Windows 3.0.

En effet, derrière ce qu’on ne manquera pas de nous vendre comme un progrès, c’est une véritable régression qui va s’opérer : tous les logiciels qui tourneront avec le nouveau système devront passer obligatoirement par le Windows Store, Microsoft exercera donc un contrôle total sur son écosystème logiciel.

De plus, la compatibilité maintenue de l’ancienne interface avec la nouvelle, si elle semble assurée dans une première étape, pourrait à terme en signer la disparition pure et simple, comme le souligne l’auteur de l’article ci-dessous, qui établit judicieusement un rappel historique : souvenez-vous de la manière dont MS-DOS a progressivement été effacé du paysage après une brève période de coexistence avec Windows 3.0. Euh oui ça ne rappellera rien aux plus jeunes, mais prendre un peu de recul est ici pertinent.

La menace de Windows 8 c’est d’abord d’imposer un système fermé à tous les développeurs et bien sûr à tous les consommateurs. Mais Casey Muratori se demande in fine si la première victime ne sera pas Microsoft lui-même, tant le virage stratégique qu’il opère risque de lui coûter ses principaux soutiens. La bataille des systèmes d’exploitation est engagée, qui en sortira indemne ?

Remarque : Nous n’avons pas traduit les deux appendices qui figurent en bas de l’article d’origine mais nous serions ravis de trouver des volontaires prêts à compléter cela avec nous sur le framapad de travail.

Les vingt ans à venir

The Next Twenty Years

Casey Muratori – 8 octobre 2012 – MollyRocket.com

(Traduction : Genevois, Maïeul, KoS, BlackEco, mib_6025, Geekandco, FredB, goofy, Quentin)

Voici pourquoi le modèle de distribution fermé de Windows 8 doit être remis en cause dans l’intérêt des développeurs, des consommateurs et même de Microsoft lui-même.

Pour la première fois dans l’histoire du PC, Microsoft s’apprête à diffuser un nouvel écosystème Windows dont il sera le seul et unique fournisseur de logiciels. Si vous achetez Windows 8, le seul endroit où vous pourrez télécharger des logiciels qui s’intègreront à la nouvelle interface de système, ce sera le Windows Store officiel. Microsoft exercera un contrôle total sur les logiciels autorisés ou non sur son système d’exploitation.

Microsoft a déclaré que les applications destinées à l’interface plus ancienne du bureau ne seraient pas impactées par cette nouvelle politique. Tant qu’ils utiliseront seulement des applications qui tournent sur le bureau classique, les utilisateurs auront encore la possibilité d’acheter, vendre, développer et distribuer des logiciels sans que Microsoft ne s’en mêle. Beaucoup d’utilisateurs de Windows ont compris cette déclaration comme une assurance que le modèle ouvert de distribution dont ils bénéficient aujourd’hui serait encore valide dans les futures versions de Windows. Du coup beaucoup moins de gens ont réagi au problème posé par Windows 8 que si la déclaration avait été comprise différemment.

Mais est-ce bien réaliste de croire que l’ordinateur de bureau sous Windows sera encore une plateforme informatique utilisable à l’avenir ? Et quelles en seraient les conséquences si elle venait à disparaître, laissant les utilisateurs de Windows avec pour toute ressource l’écosystème cadenassé de logiciels introduit par Windows 8 ? Pour répondre à ces questions, cette édition de Critical Detail examine les effets à court et à long terme des exigences imposées par Microsoft pour obtenir sa certification. Nous explorerons en profondeur comment l’histoire permet de prédire la durée de vie du PC classique sous Windows, nous aborderons de façon pragmatique cette question : vaut-il mieux pour Microsoft en tant qu’entreprise qu’elle adopte un écosystème ouvert ou fermé ?

Le Jeu de l’Année 2032

Selon PC Gamer Magazine, et de nombreuses autres sources en accord, le jeu PC de l’année 2011 était Skyrim : Elder Scrolls V. Ce constat n’a étonné personne. Skyrim pour PC a été rendu disponible sur Windows, pas MS-DOS. Même si les développeurs le voulaient, il leur était impossible de mettre à disposition un jeu PC comme Skyrim sur DOS car aucune des innovations graphiques des 15 dernières années n’est disponible sur celui-ci. Il est même absurde de penser pouvoir vendre des applications tournant sous MS-DOS aujourd’hui.

Hypothétiquement, on peut penser autant absurde dans 20 ans de vendre des applications pour la version bureau de Windows. Il n’y aura pas de jeux vidéo PC en 2032 comme il n’y a pas de jeux sous DOS en 2012. Tout fonctionnera sous une forme redéfinie pour l’interface moderne de Windows 8.

Puisque aucune application pour cette plateforme à venir ne pourra être vendue sans passer par le Windows Store, l’équipe ayant travaillé sur Skyrim devra envoyer son application à Microsoft pour validation. C’est ensuite la firme qui jugera de la validité de l’application et de la possibilité de la vendre. Savez-vous ce que pourrait être la réponse de Microsoft ?

Moi oui. Ce serait « non ».

Ce n’est pas une spéculation, c’est une certitude. Skyrim est un jeu pour adultes. Il est certifié PEGI 18. Si vous lisez les conditions de certification Windows 8 App, vous trouverez à la section 5.1 :

Votre application ne doit pas proposer de contenu pour adulte, et les metadatas doivent être appropriés à chacun. Les applications avec une évaluation PEGI 16, ESRB ADULTE, ou qui proposent du contenu pouvant nécessiter une telle évaluation ne sont pas autorisées.

Et c’est plié. Pas de Skyrim sur le Windows Store, à moins que les développeurs ne reviennent en arrière et retirent le contenu classé PEGI-18.

C’est le Jeu de l’Année 2011, banni du Windows Store. Et à propos de 2012 ? Avec de nombreux jeux très attendus à venir, personne ne peut deviner lesquels seront sélectionnés. Mais une sélection aléatoire des prédictions actuelles que l’on retrouve sur la toile suggère comme principaux prétendants Max Payne 3, The Witcher 2, Mass Effect 3, Assassins Creed 3, Call of Duty: Black Ops 2 et Borderlands 2. Parmi les quatre de cette liste qui ont reçu une évaluation PEGI pour adultes, combien pourront être vendus sur le Windows Store ?

— Aucun.

Il y a certainement aujourd’hui de nombreuses personnes, si ce n’est la majorité, qui pensent que les jeux vidéo n’ont pas de vrai potentiel culturel. Ce ne sont pas des œuvres d’art diront certains, et ce n’est donc pas grave qu’une plateforme majeure interdise sa diffusion. Dans l’intérêt d’illustrer de manière plus étendue l’importance d’une plateforme ouverte , donnons à nos jeux un lifting culturel. Supposons que nous ayons d’un coup de baguette magique tout un lot de jeux équivalents aux meilleures séries nommées aux Emmies 2012 : Boardwalk Empire, Breaking Bad, Mad Men, Downton Abbey, Homeland et Game of Thrones.

Admettons que Downtown Abbey ait été le seul à franchir le test d’évaluation PEGI, mais même si les autres satisfaisaient plus ou moins les critères, ils auraient été exclus du magasin pour un tas d’autres raisons, telles que l’expose la section 3.5 :

Votre application ne devra pas proposer du contenu ou des fonctionnalités qui encouragent, facilitent ou glorifient des activités illégales.

Et section 5.6 :

Votre application ne devra pas proposer du contenu qui encourage, facilite, ou glorifie une utilisation excessive ou irresponsable d’alcool, de tabac, de drogues ou d’armes.

Ou section 5.8 :

Votre application ne devra pas contenir de propos blasphématoires outranciers.

Cette vision d’un futur Windows fortement censuré par Microsoft est effrayante. Mais quelles sont les risques que cela arrive ?

Pour Windows RT, la version de Windows pour les tablettes peu puissantes et les téléphones, ce futur commence le 26 octobre. Tous les appareils fonctionnant avec Windows RT ne pourront faire tourner que des logiciels venant du Windows Store, et tous les logiciels devront suivre les exigences de certification énoncées ci-dessus et des dizaines d’autres. Les utilisateurs de Windows RT n’auront pas dix ou vingt ans avant de ne plus pouvoir jouer aux jeux les plus populaires sur leurs machines. Ces jeux auront été bannis dès le premier jour.

Mais pour Windows 8 et Windows 8 Pro, les versions qui seront les plus répandues, le calendrier est encore incertain. Contrairement à Windows RT, ces versions incluent le bureau classique de Windows qui prend encore en charge la distribution ouverte. Est-il possible, alors, que les utilisateurs de la version bureau n’aient jamais à expérimenter ce futur ?

Une brève analyse de l’histoire de Microsoft suggère plutôt l’inverse.

Anatomie d’un changement de plateforme chez Microsoft

Dans la fin des années 1980 une bonne partie de l’informatique grand public utilisait déjà des interfaces graphiques. Des machines comme le Macintosh d’Apple, le Commodore d’Amiga et l’Atari ST ont eu un grand succès et chacune était livrée avec un système d’exploitation graphique moderne pré-installé. D’un autre côté, les PC tournaient essentiellement sous MS-DOS, un environnement en ligne de commande où les applications devaient implémenter leur propre interface rudimentaire.

Malgré cet inconvénient, le PC n’en était pas moins florissant. Comme c’était une plateforme matérielle ouverte et qu’elle avait été adoptée dans l’environnement professionnel, la plupart des logiciels de productivité de l’époque, comme Lotus 1-2-3 et WordPerfect – traitaient MS-DOS comme une plateforme commerciale majeure.

Puis, le 22 mai 1990, Microsoft sort Windows 3.0. Cette version de Windows peut faire quelque chose que les précédentes versions ne pouvaient pas : faire tourner des programmes MS-DOS en plus des applications graphiques natives. Pour la première fois, on pouvait faire tourner les applications de travail standards sans quitter une interface conviviale. L’interface graphique de Windows n’était peut-être pas aussi flashy que ce qui existait sur d’autres plateformes, mais cela offrait aux gens la possibilité de n’utiliser qu’un seul OS pour tout et c’est ce que les consommateurs voulaient. Le taux d’adoption monta en flèche.

Durant les cinq années suivantes, Microsoft continua à ajouter de nouvelles API à Windows. Bien que les gens aient continué à développer des programmes sous MS-DOS, il devint de plus en plus difficile de faire une application professionnelle qui n’intégrait pas des choses comme le gestionnaire de polices de Windows, les services d’impression, les boîtes de dialogue standard et les presse-papiers. Les clients s’attendaient à pouvoir utiliser ce genre de choses et les logiciels MS-DOS ne le pouvaient tout simplement pas.

La plupart des applications firent la transition vers des versions natives Windows ou disparurent, mais les jeux furent l’obstacle majeur. Ils vivaient et mouraient par la performance et ne pouvaient se permettre la surcharge induite par Windows. Mais finalement Microsoft trouva le moyen de leur fournir l’accès au hardware dont ils avaient besoin, et lentement mais sûrement les jeux natifs Windows devinrent de plus en plus communs. Lorsque Windows 2000 fut lancé le 17 février 2000, seulement dix ans après la sortie de Windows 3.0, faire tourner des programmes MS-DOS était passé du statut de principale caractéristique qui faisait de Windows ce qu’il était à un mode de compatibilité fermé destiné seulement à assurer le support des versions précédentes. MS-DOS en tant que plateforme et tous les programmes qui lui étaient liés sombrèrent dans l’obscurité.

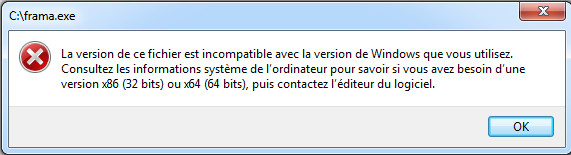

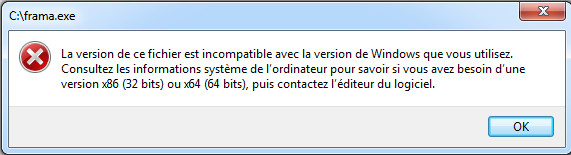

Le 22 juillet 2009, pas loin de vingt ans après la sortie de Windows 3.0, Microsoft présenta la version de Windows la plus utilisée aujourd’hui, Windows 7 64-bits. Si vous essayez de lancer une application MS-DOS sur Windows 64 bits, vous aurez une boîte de dialogue qui dit :

Vous pouvez toujours faire tourner ce programme, mais vous devrez installer une version 32 bits de Windows ou télécharger et installer un paquet Windows XP Mode sur le site de Microsoft.

Retour à 1990

La situation du PC en tant qu’objet informatique de consommation est très similaire aujourd’hui en 2012 à ce qu’elle était en 1990. Sur le PC, nous utilisons encore l’interface WIMP (Windows, Icônes, Menus, Pointeur) dont le standard s’est imposé depuis une trentaine d’années (seulement une vingtaine sur les seuls PC). Mais pour ce qui est de tous les autres appareils populaires aujourd’hui — les smartphones et les tablettes — les interfaces WIMP n’existent plus. Les systèmes d’exploitation comme iOS et Android ont remplacé le WIMP par des interfaces tactiles, exactement comme les Macintosh et Amiga ont fait disparaître la ligne de commande des interfaces utilisateurs dans les années 80.

Mais voilà que le 26 octobre, Microsoft va lancer son premier système d’exploitation tactile, Windows 8. Plutôt que d’abandonner carrément le WIMP, ils ont choisi de l’inclure comme sous-ensemble de leur nouvelle interface tactile. Tout comme l’interface de Windows 3.0 coexistait avec MS-DOS, la nouvelle interface de Windows 8 sera disponible avec un bureau traditionnel Windows 7.

Comme c’était déjà le cas pour Windows 3.0 et DOS, l’intégration d’une interface dans l’autre est tout à fait superficielle. Certaines parties sont bien intégrées mais la plupart ne le sont pas. Vous pouvez créer des tuiles dans la nouvelle interface utilisateur pour lancer des programmes dans l’ancienne, tout comme dans Windows 3.0 vous aviez des icônes qui permettaient de lancer des programmes sous DOS. Mais exactement comme les programmes DOS tournaient dans un conteneur spécial, et rendaient impossibles des opérations comme l’ouverture d’autres fenêtres, de boîtes de dialogue, l’usage de fontes différentes ou le transfert d’images vers le bureau, les applications de bureau classiques sont contingentées dans un conteneur spécial du bureau de Windows 8 et ne pourront accéder à la plupart des nouvelles fonctionnalités de nouvelle interface Windows 8.

Bref, le bureau sous Windows 8 en est au point où se trouvait MS-DOS sous Windows 3.0. Ce qui nous amène à la question cruciale?: si Microsoft est aussi attentif à la nouvelle interface utilisateur de Windows 8 qu’il l’a été à celle de Windows 3.0, à quoi va ressembler le support du bureau Windows classique à l’avenir ? Si vous pensez que l’histoire se répète, la réponse est sans ambiguïté : il sera relégué dans l’oubli d’ici dix ans et cessera d’exister dans vingt sauf si on assure la rétro-compatibilité manuellement.

Maintenant, nul ne peut prédire l’avenir avec certitude. Beaucoup d’entre vous ne sont probablement pas convaincus le moins du monde que l’avenir du bureau sera inspiré par une version plus élaborée et affinée de la nouvelle interface de Windows 8. Mais si vous jetez un coup d’œil en arrière vous prendrez conscience que beaucoup de gens pensaient exactement ainsi quand Windows 3.0 est sorti, j’espère que vous mesurez à quel point il est possible que nous soyons dans une situation similaire.

L’avenir mort-né de Windows 8

Pour les développeurs aujourd’hui, le monde de l’informatique de grande consommation avant l’arrivée de Windows 8 est un peu chaotique. Il y a iOS, une plateforme sur laquelle vous ne pouvez publier aucune application native sans la permission aléatoire et arbitraire d’Apple. Il y a Android, une plateforme agréablement ouverte mais qui est en proie à une gestion catastrophique des spécifications du matériel, qui manque d’implication pour le support de code natif et qui est menacée d’être sérieusement mise en péril par des poursuites judiciaires qui bloqueraient tout au nom des brevets logiciels. Et puis il y a les plateformes comme Blackberry, WebOS, Kindle Fire (basée sur Android) et Nook, qui sont encore en quête d’une adoption plus consistante par des utilisateurs.

Entre en scène Windows 8. Il est conçu pour une interaction tactile, a de spécifications matérielles bien définies, est doté d’une interface dont le code natif est bien documenté, peut être utilisé directement comme environnement de développement sans nécessiter de compilation sur un autre système — et oui, il est soutenu par une entreprise notoire pour sa sournoiserie, qui détient un portefeuille de brevets cinq fois plus épais que celui d’Apple. Donc si jamais Apple essayait d’entreprendre une action litigieuse contre Windows 8 similaire à celle qu’il a menée contre Android, nous verrions se déclencher en représailles un tir nourri de plaintes pour violation de brevets qui atteindrait un tel niveau que le chouette immeuble flambant neuf du quartier général d’Apple serait submergé par des tonnes de paperasses rédigées en une obscure langue juridique.

On en est aujourd’hui à un tel point de confusion dans le paysage du développement en informatique que cela pourrait effectivement être un pas en avant pour les développeurs. En supposant que le développement du nouvel écosystème de Windows 8 suivra les mêmes règles que le développement de l’ancien, n’importe quel développeur pourrait simplement installer Windows 8, développer des logiciels ciblant le marché du tactile, puis le distribuer gratuitement ou en le monnayant via son site web ou un distributeur tiers. Moins de prises de têtes avec la diversité des plateformes, pas d’exigences incertaines à satisfaire préalablement pour tester, pas de frais de développement bizarres ou de souscription obligatoire — et plus important encore, pas de puissance hégémonique d’Apple s’interposant entre les développeurs et leurs clients.

Mais voilà, il y a un petit problème. Microsoft a décidé de ne pas suivre, pour le nouvel écosystème de Windows 8, les mêmes règles qu’avec les éditions précédentes de Windows. À la différence de la transition entre MS-DOS et Windows 3.0, Microsoft ne prévoit pas d’étendre l’écosystème de Windows. Ils veulent lui faire prendre une tout autre voie.

Monopole

Le problème commence avec le Windows Store. Si le nom vous rappelle le App Store d’Apple, c’est parce qu’effectivement c’est l’App Store d’Apple. C’est une plateforme de distribution centralisée que Microsoft contrôle, qui permet aux utilisateurs finaux d’acheter des logiciels à partir d’un catalogue de titres explicitement approuvés par Microsoft.

Ce qui, en soi, pourrait ne pas être aussi mauvais. Il y a des arguments valables contre le fait que le propriétaires d’une plateforme contrôle le marketplace par défaut pour cette plateforme, mais si la plateforme permet aux personnes de développer et de distribuer des logiciels gratuitement en-dehors du marketplace, alors d’autres entreprises peuvent aussi bien contourner/se passer du/ le magasin. Les développeurs peuvent distribuer leurs logiciels par d’autres canaux, ou même fournir des magasins alternatifs, réduisant par une saine concurrence le danger d’abus ou d’obstruction de la part du propriétaire de la plateforme.

Toutefois, il est très clair en parcourant les publications de Microsoft sur Windows 8 que pour avoir le droit de bénéficier de la nouvelle interface utilisateur, vous devrez distribuer votre application dans le Windows Store. Cela veut dire qu’en octobre, Microsoft lui-même sera devenu l’unique source de logiciels pour tout ce que vous voudrez faire tourner sur une machine Windows qui ne serait pas relégué au vieil écosystème précédent. À la différence de la transition historique entre MS-DOS et l’interface utilisateur de Windows, et même si la précédente version restera probablement disponible, la nouvelle (celle de Windows 8) sera bel et bien fermée. Ce qui placera Microsoft dans une position de monopole totalement nouvelle : celle d’un distributeur exclusif de logiciels pour la majeure partie des ordinateurs du monde entier.

Maintenant, il existe apparemment un point qui fait controverse. Peut-être parce que Microsoft n’en a pas fait état de façon très importante dans ses communiqués de presse, certains doutent que pour distribuer des logiciels destinés à la nouvelle interface utilisateur, il faudra nécessairement que les développeurs obtiennent la permission de Microsoft. Mais ils ont tort. Afin de mettre les choses au clair une fois pour toutes, une analyse complète et des recherches approfondies sur les publications officielles de Microsoft sur le sujet figurent en annexe B de l’article d’origine. Il démontre qu’il n’y aura aucun moyen pour les développeurs de distribuer sur Internet des applications compatibles avec l’interface utilisateur moderne, sans avoir reçu une approbation explicite de la part de Microsoft.

Donc, en gardant cela à l’esprit, il est grand temps de se poser la question cruciale : si l’interface du nouveau Windows 8 en vient à remplacer complètement le bureau classique, et que Microsoft exerce désormais un contrôle total sur les logiciels qui seront autorisés ou non pour cette nouvelle interface, dans quelle mesure l’avenir de Windows sera-t-il spectaculairement affecté ? Est-ce que les jeux conçus pour les adultes seront les seules victimes de ce changement ou bien l’enjeu est-il beaucoup plus important ?

L’avenir pourrait être n’importe où

Bannir la plateforme de jeux la plus populaire du tout nouvel écosystème Windows 8 – qui est aussi le seul écosystème accessible aux utilisateurs de Windows RT – est l’une des conséquences négatives des directives de certification des applications par Microsoft. D’autres parties de ces directives auraient empêché l’existence de choses comme Flash, JavaScript et le Web dynamique, l’app store lui-même, s’ils n’existaient pas encore et donc d’être inclus à la plateforme de Microsoft elle-même. Il est donc clair que Microsoft s’est assuré que le nouvel écosystème Windows n’hébergerait jamais plus que les quelques applications que Microsoft considère comme importantes.

Mais simplement parce que Microsoft a fait un travail épouvantable en définissant les limites du nouvel écosystème, est-ce que cela signifie que la seule alternative est de réaliser un écosystème complètement ouvert ? Microsoft ne pourrait-il par définir de nouvelles et meilleures directives ?

La réponse étant pas tant qu’ils ne connaissent pas l’avenir. Et pas dans un sens général, mais littéralement le voir en pleine résolution/*lumière*/, et chaque détail avec clarté. En l’absence de telles prévisions idéales, comment une entreprise pourrait-elle dicter des règles pour des logiciels futurs sans interdire accidentellement des choses sur lesquelles de nouveaux logiciels révolutionnaires pourraient se fonder ?

La réalité est que même les entreprises les plus prospères sont rarement capables de prédire le futur avec précision. L’histoire de l’informatique regorge d’exemples. Digital Equipment Corporation, qui a été un certain temps la seconde plus grande entreprise d’informatique, n’a pas réussi à prévoir la révolution de l’informatique personnelle et son nom lui-même n’existe plus maintenant. Silicon Graphics, qui a été le leader du matériel d’imagerie 3D, n’a pas prévu la popularisation de ce matériel et à finalement été contraint de se déclarer en faillite.

Bien qu’étant très loin de connaître un sort aussi affreux, le passé de Microsoft montre qu’ils ne sont pas meilleurs prophètes. Bill Gates a ainsi déclaré à la fin des années 1990 :

« On se fait parfois surprendre. Par exemple, quand Internet est arrivé, c’était notre cinquième ou sixième priorité. »

– Bill Gates, lors d’un discours à l’Université de Washington en 1998

Et le changement de barreur sur le navire Microsoft n’a pas apporté d’amélioration :

« Il n’y a aucune chance que l’iPhone s’attribue une part de marché significative. Aucune chance. »

– Steve Ballmer, dans une entrevue avec USA Today en 2007, dans laquelle il a prédit que l’iPhone ne prendrait que « 2 ou 3% » du marché du smartphone.

Sans connaissance précise du futur, la seule manière d’éviter de bloquer l’innovation sans le vouloir est par définition de ne rien interdire de manière significative. Les seules exigences de certification que Microsoft pourrait choisir et qui soutiendraient complètement le futur seraient celles qui permettraient de certifier tout ce que des développeurs pourraient créer.

C’est la définition la plus épurée d’un écosystème ouvert.

Une maigre concession

Pour n’importe quel développeur désireux de créer le logiciel innovant du futur, il devrait être extrêmement clair que la nature fermée du nouvel écosystème de Windows 8 sera catastrophique pour la plateforme. La question ne se pose même pas, elle devrait être ouverte. Mais les développeurs ne sont pas les personnes chargées des politiques de Windows 8.

Donc la question plus pertinente pourrait être : est-ce que Microsoft peut se permettre de changer de cap et autoriser la distribution des applications Windows 8 par n’importe qui, et non pas seulement sur le Windows Store! ?

En prenant en compte le long terme, Microsoft ne peut pas se permettre de ne pas changer de cap. Ils sont déjà en retard sur tous les segments du marché de la consommation en-dehors du PC, par conséquent ils n’ont pas le droit à l’erreur. Si une nouvelle innovation logicielle arrive et considère qu’Android est sa plateforme primaire/de prédilection parce qu’elle a un système ouvert de distribution, cela pourrait facilement conduire à une nouvelle “décennie perdue” pour Microsoft, lorsqu’ils devront à nouveau rattraper leur retard.

Mais aujourd’hui les entreprises ne regardent généralement pas sur le long terme. Les profits à court terme et les besoins des actionnaires constituent des préoccupations immédiates et impératives ; et Microsoft est un compagnie notoire, contrainte par des nombreux intérêts externes. La question se pose donc en ces termes : l’entreprise Microsoft peut-elle autoriser un système de distribution ouvert avec Windows 8 sans nuire à son chiffre d’affaires ?

De manière surprenante, la réponse est qu’il y aura peu ou pas de pertes de revenus en autorisant un système ouvert de distribution dans Windows 8. Cela peut sembler absurde, mais si vous lisez attentivement les publications de Microsoft, vous verrez que c’est vrai. Bien que Microsoft ait fermé le système de distribution à l’intérieur du nouvel écosystème de Windows 8, ils n’ont pas fermé le système de paiement. Extrait de l’agrément développeur de Microsoft lui-même :

« En ce qui concerne le commerce d’applications. Vous pouvez choisir de proposer des options d’achat à l’intérieur même de votre application. Il n’est pas requis que vous utilisiez le moteur de commerce de Microsoft pour proposer ces achats. Si vous choisissez d’utiliser le moteur d’achat commercial de Microsoft, les achats seront soumis à l’Agrément/*, y compris, mais pas seulement, les frais de magasin et les exigences de licence et de transfert. »

Aussi étrange que cela puisse sembler, si un développeur propose une application limitée dans sa version gratuite sur le Windows Store, il pourrait alors vendre, directement dans l’application, une mise à niveau ou un déverrouillage vers la version complète pour laquelle il pourrait accepter un paiement direct. Ils n’ont pas besoin de verser 20 ou 30% de royalties comme c’est le cas avec une transaction sur le Windows Store. La seule chose qu’ils ne peuvent pas faire c’est utiliser un système de distribution non-Microsoft, tel que leur propre site web ou leur propre « boutique » en ligne.

Ainsi, il est presque impossible de concevoir une situation où Microsoft perdrait des revenus significatifs en ouvrant le système de distribution, puisqu’il a déjà ouvert le système de paiement, et que pratiquement tous les revenus proviennent du système de paiement. Le seul revenu que Microsoft continuera à obtenir du store pour une application qui n’utiliserait pas leur moteur de commerce serait les frais variables d’application, d’un montant de 100 $ par application (et non pas par achat). Le Windows Store devra perdre 10.000 – 20.000 applications avec la distribution ouverte chaque jour pour atteindre l’équivalent de 1% du revenu de Microsoft. Pour référence, l’app store le plus populaire au monde, celui d’Apple, en reçoit moins de 500 par jour.

De plus, le potentiel de migration des utilisateurs du Windows Store depuis Microsoft vers des fournisseurs tiers ne serait pas aussi important avec un système ouvert de distribution. N’importe quel utilisateur du Windows Store tel qu’il est actuellement décrit pourrait ouvrir un compte pour un autre système de paiement, pour une application qui proposerait l’achat en son sein. Une fois qu’il a décidé de créer un compte de ce type, rien ne l’empêche d’utiliser ce compte de façon triviale pour acheter n’importe quelle autre application qui serait disponible par le même processus de paiement. L’inertie de l’achat via un tiers n’est présente que la toute première fois qu’on l’utilise. Une distribution ouverte ne fonctionnerait pas différemment. Le Windows Store resterait la source par défaut des applications pour Windows 8, et c’est seulement quand l’utilisateur pourrait créer un compte pour une distribution externe que le Windows Store perdrait l’avantage de l’inertie.

Ainsi donc, Microsoft n’a quasiment aucun intérêt financier à ne pas autoriser un système ouvert de distribution. On peut supposer qu’il y a d’autres raisons sous-jacentes à leur décision de garder fermé le système de distribution. Est-ce pour limiter la menace de malware ? Est-ce pour prévenir le piratage ? Est-ce pour mieux gérer leur image de marque ? Tant que Microsoft ne sera pas explicite quant à ses objectifs, sa décision pourra être portée contre elle, nous pouvons seulement spéculer sur les motivations ; tous les autres candidats similaires proposent des solutions simples qui n’impliquent nullement une politique draconienne, comme forcer les utilisateurs à installer seulement des logiciels approuvés par Microsoft.

Et maintenant que fait-on ?

Les expériences sur les plateformes ouvertes sont l’une des sources premières d’innovation dans l’industrie informatique. Il n’y a pas deux manières de voir les choses. Les écosystèmes logiciels ouverts sont ce qui nous a donné la plupart des produits que nous utilisons aujourd’hui, qu’il s’agisse de logiciels d’entreprise tels que les feuilles de calculs, de logiciels de divertissement comme ceux de tir à la première personne, ou les paradigmes révolutionnaires qui changent le monde, comme le World Wide Web. Le monde sera bien meilleur pour tout le monde si ce type d’innovation continue.

Les développeurs, les consommateurs et même Microsoft devraient souhaiter que les vingt prochaines années ressemblent aux vingt dernières : année après année des nouvelles choses auparavant inimaginables, vous ont été apportées par des développeurs motivés et créatifs qui étaient libres d’aller là où leur vision les conduisait, sachant très bien que s’ils produisaient quelque chose de grand, il n’y aurait pas de barrière entre eux et la diffusion de leur création dans la monde entier.

Avec Windows 8, Microsoft est dans une position pivot pour aider à faire de ce futur une réalité. Ils pourraient devenir l’une des principales forces luttant pour permettre le développement pour tablette aussi ouvert que l’était le développement pour ordinateurs de bureau avec le Windows traditionnel. Ils pourraient prendre des parts de marché à l’iPad, complètement fermé (et totalement d hégémonique), et aider à restaurer dans ce domaine la liberté d’innover que les développeurs ont perdue lorsque Apple a imposé ses politiques restrictives.

Ou bien Microsoft peut lancer Windows RT, Windows 8 et Windows 8 Pro avec leur politiques actuellement en place, et se contenter d’être un autre acteur du marché de l’appareil tactile, avec leur propre jeu d’obstacles ridicules qui restreignent considérablement les possibilités de logiciel et font perdre leur temps aux développeurs avec leurs processus mal conçus de certification.

Pourquoi prendre ce risque ? Pourquoi pas ne pas se mettre en quatre pour fournir aux développeurs une plateforme ouverte, afin que tous et chacun d’entre eux ne soient pas seulement des soutiens, mais vraiment des personnes enthousiastes pour aider Windows à débarquer dans le monde des tablettes ?

Le succès de Windows 8 sur le marché des tablettes et des smartphones est loin, très loin d’être garanti. Est-ce que Microsoft veut véritablement se lancer dans la bataille sans l’appui de ses plus importants atouts ? Veulent-ils qu’une entreprise comme Valve, qui contrôle plus de 50% des ventes de jeux pour PC, décide de porter tout son effort vers Linux, compte-tenu que l’écosystème de Windows 8 interdit les plateformes de distribution tierces comme son fleuron Steam ? Veulent-ils vraiment que le lancement de Windows 8 soit pourri par une cascade de déclarations de développeurs de premier plan prenant position contre la nouvelle plateforme ? Et surtout, vont-ils délibérément courir le risque de s’attirer l’hostilité des développeurs au point de les voir promouvoir activement et développer leurs propres plateformes comme leur produit phare, puisque Windows ne leur offrira plus la liberté de développer et distribuer leurs logiciels à leur gré ?

Espérons, dans l’intérêt de tous, qu’ils prendront conscience que la seule réponse sensée à toutes ces questions est « NON ».

Crédit photo : Kiwi Flickr (Creative Commons By)

Que couvre le livre comme concepts mathématiques ?

Que couvre le livre comme concepts mathématiques ? Qui a participé ? Étaient-ils tous des formateurs ? Les participants avaient-ils déjà écrit ou édité des manuels scolaires ?

Qui a participé ? Étaient-ils tous des formateurs ? Les participants avaient-ils déjà écrit ou édité des manuels scolaires ? Que retirez-vous de cette expérience ? Qu’est ce qui a été plus difficile que prévu ? Quels conseils donneriez vous à d’autres envisageant un projet similaire ?

Que retirez-vous de cette expérience ? Qu’est ce qui a été plus difficile que prévu ? Quels conseils donneriez vous à d’autres envisageant un projet similaire ? Et après ? Y a-t-il une période de relecture/modification prévue ? Des professeurs pensent-ils utiliser d’ores et déjà votre manuel ?

Et après ? Y a-t-il une période de relecture/modification prévue ? Des professeurs pensent-ils utiliser d’ores et déjà votre manuel ?