OpenStreetMap : le prochain projet libre vraiment indispensable, par Glyn Moody

OpenStreetMap vient de fêter sa dixième bougie (et la communauté française vous invite à célébrer cela le lundi 8 septembre à Numa Paris).

Et comme le souligne Glyn Moody dans l’article traduit ci-dessous, on est bien content qu’il soit là parce qu’on ne peut pas compter sur Google pour aborder la cartographie sous l’angle des biens communs…

OpenStreetMap : le prochain projet libre vraiment indispensable

OpenStreetMap: the Next Truly Indispensable Open Project

Glyn Moody – 28 août 2014 – ComputerWorld

(Traduction : Narcisse, rocherd, aKa, PxlCtzn, Asta, fal7i, Piup, yoLotus, Mooshka, tetrakos, Mooshka, Jeff_, Omegax, Goofy, yaap, GregR + 4 anonymes)

L’année dernière, je décrivais OpenStreetMap (OSM) comme « la cartographie open source » » À l’occasion des dix ans du projet, j’aimerais me pencher plus avant sur cet exemple important de collaboration ouverte et expliquer en quoi il est selon moi destiné à devenir le prochain projet ouvert absolument incontournable.

Tout d’abord, un peu d’histoire ; pour fêter l’anniversaire d’OSM, TechCrunch a réalisé une excellente interview de Steve Coast, le fondateur du projet. Voici comment tout a commencé :

L’idée de départ était très très simple. J’avais un GPS sur mon portable mais l’on ne pouvait pas en faire grand-chose car il ne contenait aucune donnée. On pouvait télécharger l’image d’une carte, mais si l’on voulait faire quoi que ce soit d’un peu utile comme demander à l’ordinateur d’identifier la route sur laquelle on se trouvait ou de nous guider à chaque intersection, c’était impossible car il n’y avait pas de données cartographiques. Je me suis donc dit : pourquoi ne pas créer des données cartographiques ? Avec un GPS, il suffit de passer en voiture, en vélo ou à pied sur toutes les routes, tous les chemins et utiliser ces informations pour créer une carte. J’établis un petit bout de carte là où j’habite et tu établis un petit bout de carte là où tu habites et nous construisons tout cela comme un puzzle géant — et accessoirement, on le met à disposition gratuitement. Tout comme Wikipédia qui développait une encyclopédie de façon très similaire ; j’ai copié beaucoup d’éléments utilisés par Wikipédia — comme la licence libre, la possibilité que tout le monde puisse contribuer, etc.

Bien que Coast évoque ici Wikipédia, GNU/Linux a également joué un rôle déterminant dans le développement du projet :

J’ai fait beaucoup d’interventions. Les groupes d’utilisateurs de Linux étaient très à la mode — les gens se retrouvaient le samedi après-midi pour discuter de Linux. Ils connaissaient déjà une bonne partie de l’histoire puisqu’ils connaissaient l’open source et avaient des connaissances informatiques. Il n’était donc pas très difficile de leur expliquer ce que faisait OpenStreetMap. À partir de là, je suis intervenu dans des conférences sur la cartographie. J’ai arrêté de compter après environ 500 interventions. J’avais l’habitude de mettre le chiffre sur ma première diapo.

L’existence préalable des communautés Linux a permis à Coast d’avancer dans leur sillage. Comme il le souligne, les idées fondatrices comme la collaboration et le fait que le produit fini soit libre étaient les mêmes, il n’a donc pas bataillé pour convaincre. C’est un autre bon exemple de l’aspect déterminant du succès de GNU/Linux sur celui des autres choses « ouvertes » — le contenu ouvert, les données ouvertes, l’accès ouvert et OpenStreetMap.

L’autre parallèle intéressant avec la montée de GNU/Linux est que Coast travaille maintenant pour Telenav, une entreprise développant un logiciel de navigation (il a aussi travaillé pour Microsoft pendant un temps, curieux…). Telenav a apparemment embauché plusieurs acteurs clés d’OSM, tout comme des entreprises comme Red Hat ont employé des bidouilleurs du noyau de Linux à ses débuts. Dans l’interview TechCrunch, Coast explique les principaux défis actuels :

Il manque plusieurs choses à OpenStreetMap. Des informations de navigation comme les rues à sens unique, les restrictions horaires ou les limites de vitesse. Il manque aussi des adresses. Telenav a beaucoup de tracés GPS. Nous traitons ces tracés en informations pour la navigation. Si vous prenez toutes les personnes qui voyagent sur une nationale et qu’elles vont toutes à 90 km/h, vous savez que c’est probablement la vitesse limite. Si personne ne tourne à gauche à une intersection, c’est probablement qu’il y a une interdiction de tourner à cet endroit.

Vous pouvez donc résoudre ce problème avec les traces GPS. Cependant, les données d’adresse sont plus difficiles à utiliser. Aux États-Unis, il est possible de placer une licence sur ces données, mais, en Europe, entre autres, c’est plus difficile. Aux États-Unis, le gouvernement fédéral est comparable à une organisation du domaine public, et cela transpire sur les gouvernements locaux. Vous pouvez en obtenir les données. Tous les autres pays essayent de s’approprier les données cartographiques. Aux États-Unis, la plupart des adresses sont prévisibles. Dans le reste du monde, ce n’est pas aussi simple. Au Japon, les numéros de rue sont à la fois basés sur le bloc et l’âge de la maison. La première maison a le numéro un, la suivante le deux, et ainsi de suite. De fait, il est plus difficile de prédire où se trouvent les choses.

C’est quelque chose que beaucoup de personnes cherchent à résoudre, donc j’imagine que ce sera résolu un de ces jours ; et il existe beaucoup de façons intéressantes de le faire. Vous pouvez faire intervenir la communauté pour obtenir ces données, vous pouvez payer des gens pour les collecter mais, je pense qu’au final, la solution sera un mix de plusieurs choses. Par exemple, à chaque fois que vous utilisez une application qui vous permet de vous géolocaliser, vous signalez que tel restaurant à telle adresse se trouve à tel endroit.

Cela nous amène directement au futur d’OSM : que peut ajouter OSM à ses données géographiques de base – et que faut-il ajouter ? Doit-on, par exemple, chercher à coller au fonctionnement de Google Maps en tous points, y compris la navigation (point qui est visiblement important pour Coast) ou même l’imagerie satellitaire ? La première semble réellement faisable, et peut être que des drones bon marché pourraient être utilisés par la communauté pour la seconde. Mais que pourrions-nous ajouter encore ?

Comme je l’ai écrit l’an dernier, je pense qu’OSM devrait essayer de devenir l’infrastructure open source du monde mobile, comme GNU/Linux l’a fait pour la précédente génération d’ordinateurs (et pour la plateforme mobile dominante, Android). le service Waze donne une assez bonne idée de ce que cela pourrait être :

Le concept de Waze est la contribution au bien commun quand vous êtes sur la route.

En connectant les conducteurs les uns aux autres, nous aidons les gens à créer des communautés locales de conducteurs qui travaillent ensemble pour améliorer la qualité de conduite de chacun au quotidien. Cela leur permet d’éviter la frustration de rester bloqués par des bouchons ou un barrage de police, ou de gagner 5 minutes sur leur trajet quotidien en leur montrant un nouveau trajet dont ils ne connaissaient même pas l’existence.

Alors, comment ça fonctionne ?

Après avoir saisi l’adresse de destination, les utilisateurs n’ont qu’à conduire avec l’application lancée sur leur téléphone afin de contribuer passivement à mettre à jour les informations liées au trafic et aux autres informations de la route. Mais ils peuvent aussi être actifs en partageant un état de la route comme un accident, un barrage de police ou tout autre danger sur leur chemin, ce qui aide les autres usagers à savoir ce qui se passe sur leur trajet.

En plus de la communauté de conducteurs locaux utilisant l’application, Waze profite aussi d’une communauté active éditant la carte en ligne afin d’assurer que les environs soient aussi à jour que possible.

Même si cela met l’accent sur les données routières issues des voitures, le processus se généralise à toute forme de transport. Waze porte sur l’utilisation d’une application sur périphériques mobiles pour produire en temps réel et de manière participative des informations à jour sur les déplacements et les lieux. C’est une bonne idée, avec une erreur fatale : l’énorme quantité des données uniques fournies par les utilisateurs de Waze appartiennent à Waze : c’est un cas classique où les utilisateurs créent le service pour ensuite laisser quelqu’un d’autre en gérer la valeur. Voilà pour « la contribution “au bien commun” ».

Les choses sont pires depuis que Waze fait maintenant partie de Google, car cela veut dire que toutes ces informations incroyablement personnelles à propos de vous et de vos compagnons de voyage sont envoyées aux machines avides de Google, dans le but d’être traitées, liées et analysées pour révéler plus de choses sur les gens qu’ils ne le pensent probablement.

En fait, le problème avec Google est encore plus vaste depuis qu’il possède le service de cartographie qui domine le monde de la cartographie exactement comme le fait Microsoft Windows dans le monde du système d’exploitation grand public. Même avant qu’il n’achète Waze, Google encourageait ses utilisateurs à contribuer à « l’amélioration » de l’entreprise, qui en conserve la plupart des bénéfices, comme il le fait avec la quasi-totalité des ses services « gratuits ».

Mikel Maron nous a avertis du danger de cette approche pour OSM — et pour nous — depuis 2011, lorsqu’il a écrit un billet intitulé « Nous devons empêcher Google d’exploiter les communautés ouvertes »

La stratégie de Google est de construire un marché en Afrique en s’appropriant des méthodes de la communauté des données ouvertes tout en laissant à l’entreprise le contrôle de ce qui mérite d’être une ressource partagée. Ils ciblent spécifiquement les gouvernements et les ONG, proposant de « cartographier leurs pays gratuitement », mais en gardant les résultats et en attirant les consommateurs.

Ce qui me dérange le plus, c’est qu’ils ont copié OpenStreetMap de manière flagrante. Premièrement, leur produit MapMaker est directement calqué sur OSM, mais avec une licence restrictive pour les données qui fait en sorte que vous ne puissiez pas les utiliser comme bon vous semble. Ensuite, ils ont volé l’idée des Carto-parties, un concept unique et un nom que nous avons développé. Enfin, ils ont même copié des initiatives visant à cartographier des bidonvilles, comme Map Kibera.

Ce ne sont pas des choses qui importent uniquement aux geeks de la cartographie. Maron donne un très bon exemple concernant l’importance de la cartographie dans notre société. Il nous invite à comparer la carte de Google d’une zone particulièrement digne d’intérêt à l’heure actuelle — Gaza — avec celle d’OSM. Quand la première montre une grosse grille de rues anonymes, sans aucun détail, et donc aucune humanité quelle qu’elle soit, celle d’OSM ne se contente pas de montrer le nom de la plupart des principales rues et bâtiments, mais montre aussi la présence actuelle des bâtiments — une représentation exacte de la population et des vies qu’ils contiennent. En d’autres mots, les cartes sont très politiques et il est important qu’elles ne soient pas contrôlées par quelques entités commerciales.

Dans un article paru cette année dans le Guardian, Serge Wroclawski se penche sur ce problème et suggère à quel point l’importance d’OSM est vitale ici. Il distingue trois motifs d’inquiétude à propos des cartes fournies par Google (ou par une autre société quelconque) :

Qui décide de ce qui s’affiche sur Google Maps ? C’est Google, bien sûr. J’ai entendu cette préoccupation lors d’une rencontre avec une collectivité locale en 2009 : le souci portait sur le choix par Google des commerces affichés dans Google Maps. Les personnes présentes à cette réunion avaient raison d’être inquiètes, car les pouvoirs publics doivent rester impartiaux. En sous-traitant leurs cartes, ils en donneraient le contrôle à des tiers.

Il semble inévitable que Google se mette à monétiser les recherches géographiques, avec des résultats premium ou de l’affichage prioritaire — si ce n’est pas déjà en place (est-ce une coïncidence si, quand je cherche « petit-déjeuner » près de mon domicile, la chaîne Subway est le premier résultat ?)

C’est le problème habituel du contrôle. Si le logiciel sur votre ordinateur n’est pas un logiciel libre, ce n’est pas réellement votre ordinateur, mais juste un que le fournisseur de logiciel propriétaire vous autorise à utiliser d’une certaine façon, définie par lui.

Le second problème concerne la localisation. Qui définit où se situe un quartier ou si oui on non vous devriez vous y rendre ? Ce problème a été soulevé par l’American Civil Liberties (ACLU) quand les algorithmes d’un fournisseur d’itinéraires (en voiture, en vélo ou à pied) prenaient en compte le fait qu’un quartier était considéré comme « sûr » ou « dangereux » pour éditer ses trajets. Cela soulève la question de qui détermine ce qui fait un quartier « sûr » ou non ou si le terme « sûr » cache quelque chose de plus grave.

On peut étendre cet avis à Gaza : les cartes ne sont pas seulement un ensemble de données mais représentent un point de vue. Bien qu’une carte totalement neutre soit probablement impossible, on peut au moins la faire aussi ouverte que possible. La façon dont les cartes sont élaborées pose aussi problème finalement, et la façon dont les métadonnées peuvent être bien ou mal utilisées… d’autant plus crucial dans un monde post-Snowden :

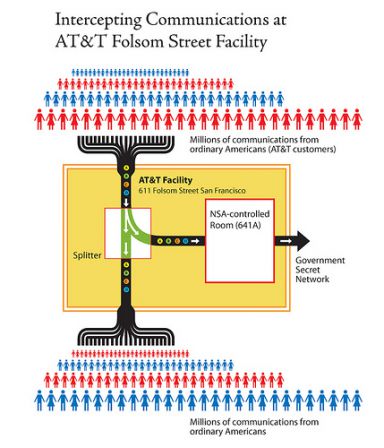

Les fournisseurs de cartes ont une propension à collecter des informations vous concernant avec des méthodes que vous pourriez ne pas apprécier. Google et Apple amoncellent toutes vos données géographiques quand vous utilisez leurs services. Ils peuvent les utiliser pour améliorer la précision de leurs cartes mais Google a déjà annoncé qu’il utiliserait ces données pour calculer la corrélation entre les recherches que vous effectuez et les endroits où vous vous rendez. Avec plus de 500 millions de smartphones sous Android en cours d’utilisation, cela représente une masse énorme d’informations collectées à l’échelle individuelle à propos des habitudes des gens : s’ils se baladent occasionnellement, s’ils effectuent un changement dans les transports en commun pour aller travailler, s’ils se rendent chez le médecin ou peut-être s’ils participent à une manifestation.

Ce n’est pas un problème avec OSM, qui ne collecte que les données de base dont il a besoin pour créer les cartes, sans intentions cachées.

Comme l’indique ce qui précède, du moins je l’espère, le succès mondial d’OSM nous concerne tous autant que le succès de GNU/Linux dans le monde du logiciel. Nous avons besoin d’une source complète et indépendante de données et d’informations géoréférencées. Durant ces dix années d’existence, OpenStreetMap a largement progressé dans ce sens ; c’est dans notre intérêt à tous de l’aider à prospérer et grandir jusqu’à ce qu’elle réussisse et devienne aussi incontournable que GNU/Linux l’est aujourd’hui.