La démocratie 2.0 à l’œuvre en France pour défendre la neutralité du réseau

Sujet récurrent depuis maintenant de nombreuses années, la Neutralité du Net, principe pourtant fondateur de l’Internet, est de plus en plus menacée. En France, plusieurs lois récentes l’attaquent, comme la Hadopi, la Loppsi ou l’Arjel. Mais c’est le cas partout en Europe, comme au Royaume Uni, en Allemagne ou en Italie. Et finalement, le reste du monde n’est pas non plus dans une ère favorable aux libertés comme on le constate en Australie ou en Nouvelle-Zélande, ainsi que dans beaucoup d’autres démocraties et de non-démocraties. La Neutralité du Net n’existe tout simplement plus en Chine ou en Iran ainsi que dans d’autres pays qui tentent ouvertement de contrôler l’opinion publique.

Sujet récurrent depuis maintenant de nombreuses années, la Neutralité du Net, principe pourtant fondateur de l’Internet, est de plus en plus menacée. En France, plusieurs lois récentes l’attaquent, comme la Hadopi, la Loppsi ou l’Arjel. Mais c’est le cas partout en Europe, comme au Royaume Uni, en Allemagne ou en Italie. Et finalement, le reste du monde n’est pas non plus dans une ère favorable aux libertés comme on le constate en Australie ou en Nouvelle-Zélande, ainsi que dans beaucoup d’autres démocraties et de non-démocraties. La Neutralité du Net n’existe tout simplement plus en Chine ou en Iran ainsi que dans d’autres pays qui tentent ouvertement de contrôler l’opinion publique.

Les enjeux de cette Neutralité sont considérables, tant sur un plan économique, que politique et culturel. C’est l’existence même du réseau qui est en cause, car la Neutralité du Net c’est la prévention des discriminations à l’égard de la source, de la destination et du contenu de l’information transmise via le réseau.

Préserver cette situation de non-privilèges dans les télé-communications pourrait être naturel pour tous, mais ça ne l’est apparemment pas pour les fournisseurs d’accès à Internet, quand bien même la loi française définit la neutralité des réseaux de communication de manière claire et sans équivoque :

Article L32-1 du Code des Postes et communications électroniques :

II.-Dans le cadre de leurs attributions respectives, le ministre chargé des communications électroniques et l’Autorité de régulation des communications électroniques et des postes (note: ARCEP) […] veillent :

« 5° Au respect par les opérateurs de communications électroniquesdu secret des correspondances et du principe de neutralité au regard du contenu des messages transmis, ainsi que de la protection des données à caractère personnel; »

« 13° Au respect de la plus grande neutralité possible, d’un point de vue technologique, des mesures qu’ils prennent […] »

C’est cette liberté de transmission qui met tous les utilisateurs d’Internet sur un pied d’égalité, qui donne la même chance à tout le monde (qu’on soit une multinationale ou un artisan local) et qui permet à tous de recevoir et de distribuer l’information de son choix, et ce, quelques soient ses ressources financières ou son statut. C’est grâce à cette « neutralité » que de petites entreprises peuvent se faire connaître sur la toile et que les petits projets libres peuvent se développer. C’est comme ça que sont apparus Microsoft (un lecteur nous indique en commentaire que l’ancienneté de Microsoft, créé 1975, dessert l’argument, lisons donc « eBay » à la place), Google, ou Facebook… Et maintenant, des projets prometteurs voient le jour tels que Seeks, Diaspora ou Movim et peuvent se développer sans se faire phagocyter voire interdire par leurs « aînés » devenus d’influentes puissances commerciales.

Pourtant, aujourd’hui de nombreux opérateurs de télécommunications (Orange, Comcast, SFR, Free…) mais aussi des gouvernements souhaitent remettre en cause cette neutralité dans le but de monopoliser, ou de censurer les différents flux d’information, les protocoles, les sites, les blogs, nos paroles.

On peut parler entre autres de l’affaire Free / Dailymotion, de la polémique que le filtrage du Port 25 (SMTP) par Orange a suscité, de la loi LOPPSI ou de la loi sur les jeux en lignes (ARJEL) et de son obligation de filtrage alors qu’il a été démontré, plusieurs fois, que ce filtrage est impossible et peut avoir des effets collatéraux dangereux et simplement sans précédents. Autant de « petits » détails qui nous rappellent que la liberté d’expression, rendue possible par le numérique [1], est menacée et que la liste des dérives s’allonge.

Les gouvernements eux, cherchent à mettre en place des techniques de filtrage du réseau, bridant notre liberté d’expression (Hadopi en France), ou dans le but d’avoir la mainmise sur les organes de presses (Berlusconi en Italie), pour empêcher les manifestants de se concerter (Iran), ou filtrer des sites prétenduement « pédophiles » (Australie)…

C’est dans ce contexte qu’une loi sur la Neutralité du Net vient d’être proposées en France pour la fin de l’année. Et elle est bienvenue car la lecture du rapport « La neutralité de l’Internet. Un atout pour le développement de l’économie numérique » de la secrétaire d’État chargée de la Prospective et du Développement de l’économie numérique Nathalie Kosciusko-Morizet (UMP), fait froid dans le dos, comme le disait récemment Benjamin Bayart sur Écrans.fr : « Dans ce rapport, ce qui saute aux yeux, c’est l’incompétence ». Et en effet, de l’incompétence on en trouve dans ce rapport mais pas seulement, on trouve également des traces de lobbyisme de vendeurs de contenus ayant racheté un FAI, ou de FAI ayant acheté du contenu à vendre…

C’est un autre personnage politique donc, le député Christian Paul (PS), qui a mis en ligne sur son blog une ébauche de proposition de loi consacrant la Neutralité du Net.

Pour compléter cette ébauche, il invite les citoyens à commenter et améliorer le texte en-ligne grâce à un outil libre : co-ment. Et il a également rédigé une tribune ré-affirmant l’importance de la Neutralité du Net en guise d’introduction à son projet de loi. C’est cette tribune, publiée conjointement sur Numérama et sur son blog (sous licence libre) que nous vous invitons à lire ci-dessous.

Il est primordial de réaliser l’importance de la Neutralité du Net et d’établir des règles pour la pérenniser. Cette loi ne doit pas être faite dans l’intérêt privé de certains groupes industriels, mais pour et par les citoyens. La France pourrait, sur ce sujet, retrouver ses Lumières et montrer la voie à suivre…

Merci à Skhaen pour la rédaction originale de cette introduction.

Proposition de loi visant à affirmer le principe de neutralité de l’internet, et son contenu

Christian Paul – 16 août 2010 – Numerama

I had a dream… J’ai fait un rêve, ou plutôt un cauchemar. Je me réveillais en 2030, buvais une tasse de café noir, puis allumais mon ordinateur, et me voyais soudain interdire l’accès à l’Internet. Mes dernières déclarations sur les pratiques abusives des géants de l’Internet n’y étaient certainement pas pour rien. Ou, du moins, quelques propos sur le « filtrage de bordure », directement intégré à ma « box » sous prétexte de lutte contre les contenus illicites, avec un « moteur de contrôle » jugeant automatiquement de la légalité de mes faits et gestes. Le service où je publiais jusqu’ici régulièrement des tribunes (lointain successeur de Médiapart, de Rue 89 ou de Numérama !), où j’avais accès à une information que l’on ne trouvait plus forcément dans les médias traditionnels, venait de fermer, après une longue descente aux enfers au gré de la généralisation des accords de priorisation de certains services et contenus. Un de mes principaux canaux d’expression avait disparu.

Ces derniers temps, ma « box » Internet me conseillait fermement (m’imposait même parfois) plusieurs heures par jour le visionnage de programmes choisis par mon opérateur. J’étais certes informé de cette limitation, mais que faire alors que tous les opérateurs se comportaient à l’identique et que le contournement de ce dispositif de contrôle était passible de prison ? J’avais eu par ailleurs à changer ces dernières années plusieurs fois d’équipement, au gré des accords exclusifs entre mon FAI avec le constructeur ou l’éditeur le plus offrant. Mes plaintes contre cette censure et cette vente forcée avaient été classées sans suite par le procureur compétent du tribunal de Nevers.

Je me souvenais alors qu’il y a plus de 20 ans, l’irruption de l’Internet portait la promesse d’une croissance durable de la diversité, de nouvelles médiations, d’un plus grand accès à l’information et à la culture et d’une amélioration du droit réel à l’initiative économique pour le plus grand nombre.

Mais depuis son ouverture au grand public au milieu des années 90, les coups de canifs à la liberté et l’égalité des utilisateurs du « réseau des réseaux » s’étaient multipliés. Les réseaux « de pair à pair » avaient été combattus en tant que tel, alors qu’ils ne sont pourtant que de simples outils dont seuls certains usages sont répréhensibles. Le choix de l’appareil de raccordement au réseau, la « box », avait progressivement été imposé aux particuliers par tous les opérateurs. Les services « exclusifs » s’étaient généralisés, après une période transitoire où ils étaient seulement plus prioritaires que les autres.

Retour à 2010, au cœur de l’été. Pourquoi faut-il s’inquiéter ? Le cadre juridique garantissant nos libertés a considérablement évolué [2], et les dernières années ont donné le signal de la régression. Mais aujourd’hui, le socle même de ces libertés est en jeu, du fait de l’évolution du cadre technique que préfigurent les débats actuels. Comme le dit Lawrence Lessig, « Code is Law », « le logiciel et le matériel font du cyberespace ce qu’il est » [3]. Pour autant, la menace n’est pas que technique. Jiwa, sur lequel j’aimais écouter de la musique, n’est pas aujourd’hui en liquidation du fait d’une censure généralisée du net ou de mutations du réseau, mais à cause du maintien d’un modèle inadapté de négociation de gré à gré des droits. Il produit des effets également très négatifs, et la responsabilité du gouvernement qui tarde à agir, écrasante.

Le débat sur la « neutralité du net », qui a cours en France ou aux Etats-Unis depuis des mois, doit être l’occasion de réaffirmer les principes d’ouverture et de liberté auxquels nous sommes attachés. À la laïcité garantissant la liberté de conscience et le libre exercice des cultes doit correspondre dans l’espace numérique une « laïcité informationnelle » garantissant nos libertés de choix, d’initiative et d’expression.

Qu’on ne s’y trompe pas ! Notre amour de la liberté nous conduit non pas au laisser-faire, mais au choix d’une « bonne » régulation. La transparence et l’information sur les pratiques des opérateurs ne suffisent à l’évidence pas. Les pouvoirs publics doivent prendre leurs responsabilités et garantir de nouveaux droits à tous les internautes. Nous n’accepterions pas que tel ou tel opérateur de réseau autoroutier n’accueille plus que les automobiles d’une certaine marque. De même, nous n’accepterions pas que les fournisseurs d’énergie électrique nous imposent le choix d’un panneau de raccordement ou de la marque de notre machine à laver. Il doit en être de même dans le monde numérique. Un accès à l’Internet n’est, au niveau le plus simple, qu’un ensemble de signaux électriques convoyés par notre fournisseur d’accès. Le choix de notre appareil de raccordement doit être libre, pour peu que les normes en vigueur ou à inventer rapidement soient respectées. Sous réserve du paiement permettant de disposer d’une puissance suffisante, chacun est également libre de faire fonctionner simultanément autant d’appareils électriques qu’il le souhaite. Il doit en être de même pour le numérique. Les règles de circulation des signaux numériques en notre domicile doivent relever de notre seul choix.

Choisissons un combat juste. Il ne s’agit pas ici de défendre le tout gratuit. Il est logique que celui qui consomme plus de ressources, par exemple en visualisant continuellement des vidéos en haute définition, ait à payer plus cher que celui qui envoie et reçoit quelques courriers électroniques par jour. Il s’agit par contre de s’assurer que l’utilisation du réseau restera libre et non faussée, tant en émission qu’en réception.

C’est pourquoi je transmets ces jours-ci à Jean-Marc Ayrault, président du groupe PS à l’Assemblée nationale le texte d’une proposition de loi affirmant le principe de neutralité de l’internet, et son contenu. Son article 1er est sans ambiguïté : « Le principe de neutralité doit être respecté par toute action ou décision ayant un impact sur l’organisation, la mise à disposition, l’usage commercial ou privé des réseaux numériques. Ce principe s’entend comme l’interdiction de discriminations liées aux contenus, aux tarifications, aux émetteurs ou aux destinataires des échanges numériques de données. »

Vous en lirez le texte complet sur mon blog. Aidez-moi à enrichir cette proposition, le principe et son contenu. C’est un nouveau combat pour la liberté du net, pour sa « bonne » régulation, pour résister à son asservissement commercial.

Vite, prenons date ! Mieux vaut prévenir, que tenter de réparer tardivement. La neutralité du net apparait, d’ores et déjà, comme un principe offensif, efficace et indispensable.

Christian PAUL, député de la Nièvre

Notes

[1] « l’imprimerie a permis au peuple de lire, Internet va lui permettre d’écrire » – Benjamin Bayart dans La bataille HADOPI 2009

[2] Avec les lois LCEN, DADVSI, la loi sur les jeux en ligne, HADOPI 1 et 2, en attendant la LOPPSI2…

Un court billet pour évoquer la relation entre le software et le hardware, entre le logiciel et le matériel, à l’ère où le (mal nommé)

Un court billet pour évoquer la relation entre le software et le hardware, entre le logiciel et le matériel, à l’ère où le (mal nommé)  Prenant des allures de « Courrier International du Libre » (mais sans les

Prenant des allures de « Courrier International du Libre » (mais sans les  Grande première : des

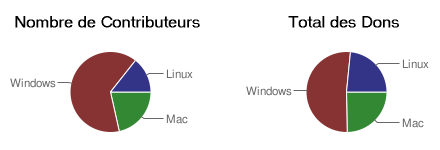

Grande première : des  Un pack de 5 jeux disponible pendant une semaine au prix que vous voulez, tel est l’objet de l’opération

Un pack de 5 jeux disponible pendant une semaine au prix que vous voulez, tel est l’objet de l’opération