Nous traduisons souvent Bruce Byfield, libre penseur du logiciel libre, sur le Framablog.

A-t-il raison d’affirmer qu’il est des sujets pour ainsi dire tabous dans la communauté et surtout que la situation a évolué, n’en déplaise à certains ?

Neuf choses dont on ne discute jamais sur l’open source

9 Things That Are Never Admitted About Open Source

Bruce Byfield – 22 janvier 2013 – Datamation

(Traduction : Moosh, brandelune, Sky, ehsavoie, Astalaseven, petit bonhomme noir en haut à droite, mike, goofy, KoS, Mowee, arcady, maxlath, Astalaseven, mariek, VifArgent, Rudloff, VIfArgent, Penguin, peupleLa, Vilrax, lamessen + anonymous)

Quels sont les sujets tabous dans l‘open source de nos jours ? Certains peuvent se deviner mais d’autres pourraient bien vous surprendre.

On pourrait penser qu’un groupe de personnes intelligentes comme les membres de la communauté des logiciels libres et open source (NdT : FOSS pour Free and Open Source Software) seraient sans tabous. On pourrait s’attendre à ce qu’un tel groupe d’intellectuels juge qu’aucune idée n’est interdite ou gênante – mais ce serait une erreur.

Comme toute sous-culture, la communauté FOSS est cimentée par des croyances. Ces croyances contribuent à bâtir une identité commune : par conséquent, les remettre en cause revient à remettre en cause cette identité.

Certains de ces sujets tabous peuvent saper des évidences admises depuis vingt ans ou plus. D’autres sont nouveaux et contestent des vérités communément acceptées. Quand on les examine, on s’aperçoit que chacun d’entre eux peut être aussi menaçant que la déclaration de valeurs communes peut être rassurante.

Pourtant, même s’il est inconfortable d’interroger ces tabous, il est souvent nécessaire de le faire. Les croyances peuvent perdurer longtemps après le temps où elles s’appliquaient, ou après avoir dégénéré en semi-vérités. Il est utile de temps en temps de penser l’impensable, ne serait-ce que pour mettre ces croyances en phase avec la réalité.

Suivant cette logique, voici neuf observations sur l‘open source qui nécessitent selon moi un nouvel examen.

1. Ubuntu n’est plus le dernier grand espoir de l’open source

Quand Ubuntu est apparue il y a neuf ans, nombreux sont ceux qui l’ont considérée comme la distribution qui mènerait la communauté à dominer le monde. Débarquant de nulle part, Ubuntu s’est immédiatement concentrée sur le bureau comme aucune autre distribution avant elle. Des outils et des utilitaires furent ajoutés. De nombreux développeurs Debian trouvèrent un travail chez Canonical, la branche commerciale d’Ubuntu. Des développeurs virent leurs frais payés pour des conférences auxquelles ils n’auraient pas pu se rendre autrement.

Au fil du temps, une bonne partie de l’enthousiasme initial est retombée. Personne ne semble s’être intéressé à la demande de Mark Shuttleworth, le fondateur d’Ubuntu, à ce que les principaux projets coordonnent leurs cycles de livraison ; ils l’ont tout simplement ignorée. Mais on a vu des sourcils se froncer lorsqu’Ubuntu a commencé à développer sa propre interface plutôt que de contribuer à GNOME. Canonical a commencé à contrôler ce qui se passait dans Ubuntu, apparemment pas pour l’intérêt général mais surtout pour la recherche de profits. Nombreux, aussi, furent ceux qui n’apprécièrent pas l’interface d’Ubuntu, Unity, à sa sortie.

Pourtant, à écouter les employés de Canonical, ou les bénévoles Ubuntu, on aurait presque l’impression qu’il ne s’est rien passé pendant ces neuf dernières années. Lisez notamment le blog de Shuttleworth ou ses déclarations publiques : il se donne le rôle de figure de proue de la communauté et déclare que les « hurlements des idéologues » finiront par cesser devant son succès.

2. Le « cloud computing » sape les licences libres

Il y a sept ans, Tim O’Reilly affirmait que les licences libres étaient devenues obsolètes. C’était sa manière un peu dramatique de nous prévenir que les services en ligne mettent à mal les objectifs du logiciel libre. Comme le logiciel, le cloud computing offre aux utilisateurs l’usage gracieux des applications et du stockage, mais sans aucune garantie ou contrôle quant à la vie privée.

La Free Software Foundation (NdT : Fondation pour le Logiciel Libre) répondit à la popularité grandissante du cloud computing en dépoussiérant la GNU Affero General Public License, qui étend les idéaux du FOSS au cloud computing.

Après cela, pourtant, les inquiétudes à propos de la liberté logicielle au sein du cloud ont faibli. Identi.ca fut créé comme une réponse libre à Twitter, et MediaGoblin développé comme l’équivalent libre d’Instagram ou de Flickr, mais ce genre d’efforts est occulté par la compétition. On n’a pas mis l’accent sur l’importance des licences libres ou du respect de la vie privée dans le cloud.

Par conséquent, les avertissements de O’Reilly sont toujours aussi pertinents de nos jours.

3. Richard Stallman est devenu un atout contestable

Le fondateur de la Free Software Foundation et le moteur derrière la licence GNU GPL, Richard M. Stallman, est une des légendes des logiciels libres et open source. Pendant des années, il a été l’un des plus ardents défenseurs de la liberté du logiciel et la communauté n’existerait probablement pas sans lui.

Ce que ses supporters rechignent à admettre, c’est que la stratégie de Stallman a ses limites. Nombreux sont ceux qui disent que c’est un handicapé social, et que ses arguments se basent sur la sémantique — sur les mots choisis et comment ils influencent le débat.

Cette approche peut être éclairante. Par exemple, lorsque Stallman s’interroge sur l’analogie entre le partage de fichiers et les pillages perpétrés par les pirates, il révèle en fait le parti-pris que l’industrie du disque et du cinéma tente d’imposer.

Mais, malheureusement, c’est à peu près la seule stratégie de Stallman. Il dépasse rarement ce raisonnement qu’il utilise pour fustiger les gens, et il se répète même davantage que des personnes qui passent leur temps à faire des discours. Il est perçu de plus en plus, par une partie de la communauté, comme quelqu’un hors de propos voire même embarrassant. Comme quelqu’un qui fut efficace… mais ne l’est plus. Il semble que la communauté a du mal à admettre l’idée que Stallman a eu un impact certain pendant des années, mais qu’il est moins utile aujourd’hui. Soit il est défendu férocement pour son passé glorieux, soit il est attaqué comme un usurpateur parasite. Je crois que les affirmations concernant ce qu’il a accompli et son manque d’efficacité actuel sont vraies toutes les deux.

4. L’open source n’est pas une méritocratie

L’une des légendes que les développeurs de logiciels libres aiment à se raconter est que la communauté est une méritocratie. Votre statut dans la communauté est censément basé sur vos dernières contributions, que ce soit en code ou en temps.

L’idée d’une méritocratie est très attirante, en cela qu’elle forme l’identité du groupe et assure la motivation. Elle encourage les individus à travailler de longues heures et donne aux membres de la communauté un sentiment d’identification et de supériorité.

Dans sa forme la plus pure, comme par exemple au sein d’un petit projet où les contributeurs ont travaillé ensemble pendant de nombreuses années, la méritocratie peut exister.

Mais le plus souvent, d’autres règles s’appliquent. Dans de nombreux projets, ceux qui se chargent de la documentation ou bien les graphistes sont moins influents que les programmeurs. Bien souvent, vos relations peuvent influencer la validation de votre contribution au moins autant que la qualité de votre travail.

De même, la notoriété est plus susceptible d’influencer les décisions prises que le grade et les (surtout si elles sont récentes) contributions. Des personnes comme Mark Shuttleworth ou des sociétés comme Google peuvent acheter leur influence sur le cours des choses. Des projets communautaires peuvent voir leurs instances dirigeantes dominées par les sponsors privés, comme c’est de fait le cas avec Fedora. Bien que la méritocratie soit l’idéal, ce n’est presque jamais la seule pratique.

5. L’open source est gangrené par un sexisme systémique

Une autre tendance qui plombe l’idéal méritocratique est le sexisme (parfois sour la forme de la misogynie la plus imbécile) que l’on trouve dans quelques recoins de la communauté. Au cours des dernières années, les porte-parole du FOSS ont dénoncé ce sexisme et mis en place des règles officielles pour décourager quelques uns de ses pires aspects, comme le harcèlement pendant les conférences. Mais le problème demeure profondément ancré à d’autres niveaux.

Le nombre de femmes varie selon les projets, mais 15 à 20 pour cent peut être considéré comme un chiffre élevé pour un projet open source. Dans de nombreux cas, ce nombre est en dessous des cinq pour cent, même en comptabilisant les non-programmeurs.

De plus les femmes sont sous-représentées lors des conférences, à l’exception de celles où les femmes sont activement encouragées à faire part de leurs propositions (ces efforts entraînent, inévitablement, leur lot d’accusations quant à des traitements spéciaux et des quotas, quand bien même aucune preuve ne peut être avancée).

La plus grande évidence de sexisme se produit quotidiennement. Par exemple, Slashdot a récemment publié un entretien avec Rikki Ensley, membre de la communauté USENIX. Parmi les premiers commentaires, certains se référaient à une chanson populaire dont le refrain mentionne le prénom Rikki. D’autres discutent de son apparence et lui donnent des conseils pour avoir l’air plus « glamour ».

On assiste à des réactions du même ordre, et bien d’autres pires encore sur de nombreux sites dédiés au monde du libre ou sur IRC, dès qu’une femme apparaît, surtout s’il s’agit d’une nouvelle venue. Voilà qui dément les affirmations d’une communauté qui prétend ne s’intéresser qu’aux seules contributions, ou encore l’illusion que la sous-représentation des femmes serait simplement une question de choix individuels.

6. Microsoft n’est plus l’ennemi irréductible du logiciel libre

Il y a à peine plus d’une dizaine d’années, vous pouviez compter sur Microsoft pour traiter le monde du Logiciel Libre de « communiste » ou « anti-Américain », ou sur leurs intentions parfois divulguées dans la presse de vouloir détruire la communauté.

Une grande partie de la communauté s’accroche encore à ces souvenirs. Après tout, rien ne rassemble plus les gens qu’un ennemi commun, puissant et inépuisable.

Mais ce dont la communauté ne se rend pas compte, c’est que la réaction de Microsoft est devenue plus nuancée, et qu’elle varie d’un service à l’autre au sein de l’entreprise.

Nul doute que les dirigeants de Microsoft continuent de voir le logiciel libre comme un concurrent, bien que les dénonciations hautes en couleur aient cessé.

Cependant, Microsoft a pris conscience que, compte-tenu de la popularité du logiciel libre, les intérêts à court terme de l’entreprise seraient mieux servis si elle s’assurait que les outils libres (en particulier les langages de programmation les plus populaires) fonctionnent correctement avec ses propres produits. C’est d’ailleurs la mission principale du projet Microsoft Open Technologies. Récemment, Microsoft est même allé jusqu’à publier une courte déclaration faisant l’éloge de la dernière version de Samba, qui permet l’administration des serveurs Microsoft depuis Linux et les systèmes Unix (NdT : Voir aussi cette FAQ en français publiée par Microsoft).

Bien sûr, il ne faut pas non plus s’attendre à voir Microsoft devenir une entreprise open source ou faire des dons désintéressés d’argent ou de code à la communauté. Mais, si vous faites abstraction des vieux antagonismes, l’approche égoïste de Microsoft à l’égard du logiciel libre n’est pas très différente de nos jours de celle de Google, HP, ou n’importe quelle autre entreprise.

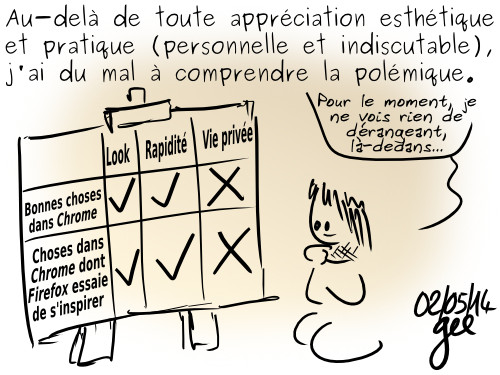

7. L’innovation des interfaces stagne

En 2012, nombreux furent ceux qui n’ont pas adopté GNOME 3 et Unity, les deux dernières interfaces graphiques majeures. Cet abandon fut largement lié à l’impression que GNOME et Ubuntu ignoraient les préoccupations des utilisateurs et qu’ils imposaient leur propre vision, sans concertation.

À court terme, cela a mené à la résurrection de GNOME 2 sous des formes variées.

En tant que prédécesseur de GNOME 3 et de Unity, GNOME 2 fut un choix évident. C’est une interface populaire qui n’impose que peu de restrictions aux utilisateurs.

Quoi qu’il en soit, cela risque d’être, à long terme, étouffant pour l’innovation. Non seulement parce que le temps passé à ressuciter GNOME 2 n’est pas mis à profit pour explorer de nouvelles voies, mais parce que cela semble être une réaction à l’idée même d’innovation.

Peu sont ceux, par exemple, qui sont prêts à reconnaître que GNOME 3 ou Unity ont des fonctionnalités intéressantes. Au contraire, les deux sont condamnés dans leur ensemble. Et les développements futurs, tels l’intention de GNOME de rendre la sécurisation et la confidentialité plus simples, n’ont pas reçu l’attention qu’ils méritaient.

Au final, au cours des prochaines années, l’innovation en sera probablement réduite à une série de changements ponctuels, avec peu d’efforts pour améliorer l’ergonomie dans son ensemble. Même les développeurs hésiteront à tenter quoi que ce soit de trop différent, afin d’éviter le rejet de leurs projets.

Je me dois d’applaudir le fait que les diverses résurrections de GNOME 2 marquent le triomphe des requêtes des utilisateurs. Mais le conservatisme qui semble accompagner ces aboutissements m’inquiète : j’ai bien peur que cette victoire n’engendre d’autres problèmes tout aussi importants.

8. L’open source est en train de devenir une monoculture

Ses partisans aiment à revendiquer que l’un des avantages du logiciel libre et open source, c’est d’encourager la diversité. À la différence de Windows, les logiciels libres sont supposés être plus accueillants pour les idées nouvelles et moins vulnérables aux virus, la plupart des catégories de logiciels incluant plusieurs applications.

La réalité est quelque peu différente. À la lecture d’une étude utilisateurs vous remarquerez un modèle plutôt constant : une application ou technologie recueille 50 à 65% des votes, et la suivante 15 à 30%.

Par exemple, parmi les distributions, Debian, Linux Mint et Ubuntu, qui utilisent toutes le format de packet en .DEB, recueillent 58% du choix des lecteurs 2012 du Linux Journal, que l’on peut comparer aux 16% recueillis par Fedora, openSUSE, et CentOS, qui utilisent quant à elles le format .RPM.

De même, Virtualbox atteint 56% dans la catégorie « Meilleure solution de virtualisation », et VMWare 18%. Dans la catégorie « Meilleure gestion de versions », Git recueille 56% et Subversion 18%. La catégorie la plus asymétrique est celle des « Suites bureautiques » dans laquelle LibreOffice recueille 73% et (sic) Google Docs 12%.

Il n’y avait que deux exceptions à cette configuration. La première était la catégorie « Meilleur environnement de bureau », dans laquelle la diversification des dernières années était illustrée par les scores de 26% pour KDE, 22% pour GNOME 3, 15% pour GNOME 2 et 12% pour Xfce. La deuxième catégorie était celle de « Meilleur navigateur web »dans laquelle Mozilla Firefox recueillait 50% et Chromium 40%.

De manière générale, les chiffres ne rendent pas compte d’un monopole, mais dans la plupart des catégories, la tendance est là. Au mieux, on pourrait dire que, si la motivation n’est pas le profit, le fait d’être moins populaire n’implique pas que l’application va disparaître. Mais si la concurrence est saine, comme tout le monde aime à le dire, il y a tout de même des raisons de s’inquiéter. Quand on y regarde de près, les logiciels libres sont loin d’être aussi diversifiés que ce que l’on croit.

9. Le logiciel libre est bloqué si près de ses objectifs

En 2004, les logiciels libres et open source en étaient au stade où ils couvraient la plupart des usages de base des utilisateurs : envoi de courriels, navigation sur internet et la plupart des activités productives sur ordinateur. En dehors des espoirs de disposer un jour d’un BIOS libre, il ne manquait plus que les pilotes pour les imprimantes 3D et les cartes WiFi pour atteindre l’utopie d’un système informatique entièrement libre et open source.

Neuf ans plus tard, de nombreux pilotes libres de carte WiFi et quelques pilotes libres de cartes graphiques sont disponibles – mais nous sommes loin du compte. Pourtant la Free Software Foundation ne mentionne que rarement ce qui reste à faire, et la Linux Foundation ne le fait pratiquement jamais, alors même qu’elle sponsorise l’OpenPrinting database, qui liste les imprimantes ayant des pilotes libres. Si l’on combinait les ressources des utilisateurs de Linux en entreprise, on pourrait atteindre ces objectifs en quelques mois, pourtant personne n’en fait une priorité.

Admettons que certaines entreprises se préoccupent de leur soi-disant propriété intellectuelle sur le matériel qu’elles fabriquent. Il est possible également que personne ne veuille courir le risque de fâcher leurs partenaires commerciaux en pratiquant la rétroingénierie. Pourtant, on a bien l’impression que l’état actuel de statu quo persiste parce que c’est déjà bien assez, et que trop peu de personnes ont à cœur d’atteindre des objectifs dont des milliers ont fait le travail de leur vie.

Des discussions, non des disputes

Certains ont peut-être déjà conscience de ces sujets tabous. Cependant, il est probable que chacun trouvera dans cette liste au moins un sujet pour se mettre en rogne.

Par ailleurs, mon intention n’est pas de mettre en place neuf aimants à trolls. Même si je le voulais, je n’en aurais pas le temps.

Ces lignes sont plutôt le résultat de mes efforts pour identifier en quoi des évidences largement admises dans la communauté devraient être remises en question. Je peux me tromper. Après tout, je parle de ce que j’ai pris pour habitude de penser, moi aussi. Mais au pire, cette liste est un bon début.

Si vous pensez qu’il y a d’autres sujets tabous à aborder et à reconsidérer au sein de la communauté des logiciels libres et open source, laissez un commentaire. Cela m’intéresse de voir ce que je pourrais avoir oublié.

Crédit photo : Laëtitia Dulac (Creative Commons By)

Travaux effectués

Travaux effectués