Opposez-vous à Chat Control !

Sur ce blog, nous transposons régulièrement différents points de vue concernant les luttes pour les libertés numériques. Dans ce domaine, on constate souvent que les mouvements sociaux (solidariste, durabilistes, préfiguratifs, etc.) ne prennent que trop rarement en compte les implications directes sur leurs propres luttes que peuvent avoir les outils de surveillance des États et des entreprises monopolistes. Cela rend toujours plus nécessaire une éducation populaire d’auto-défense numérique… Du côté des mouvements autonomes et anti-autoritaires, on ressent peu ou prou les mêmes choses. Dans les groupes européens, le sujet du capitalisme de surveillance est trop peu pris en compte. C’est du moins l’avis du groupe allemand Autonomie und Solidarität qui, à l’occasion du travail en cours au Parlement Européen sur l’effrayant et imminent projet Chat Control (voir ici ou là), propose un appel général à la résistance. L’heure est grave face à un tel projet autoritaire (totalitaire !) de surveillance de masse.

Cet appel a été publié originellement en allemand sur Kontrapolis et en anglais sur Indymedia. (Trad. Fr. par Framatophe).

Opposez-vous à Chat Control !

Une minute s’il vous plaît ! Chat Control ? C’est quoi ? Et pourquoi cela devrait-il nous intéresser en tant qu’autonomes et anti-autoritaires ?

Chat Control est le projet de règlement de l’Union Européenne portant sur la prévention et la protection des enfants contre les abus sexuels. Il a été reporté pour le moment, mais il risque d’être adopté prochainement1.

Ce projet de loi est une affaire assez grave pour plusieurs raisons2.

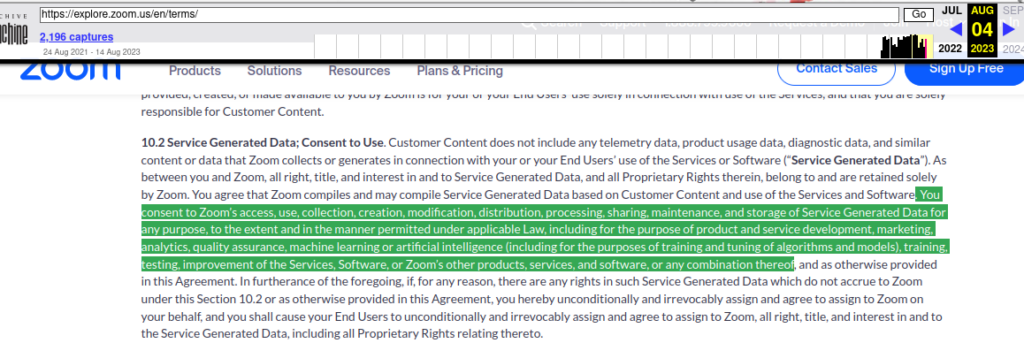

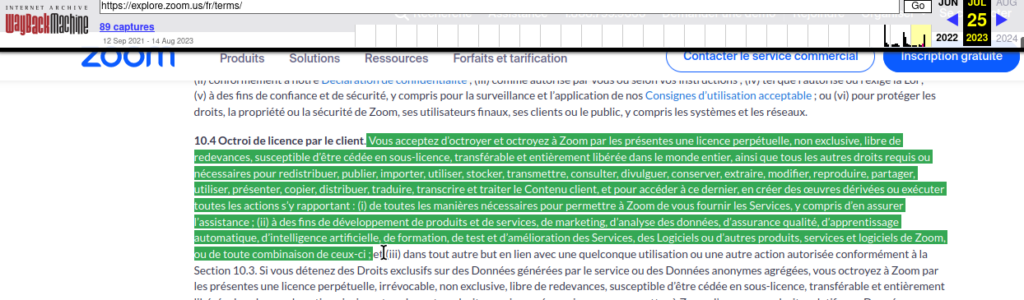

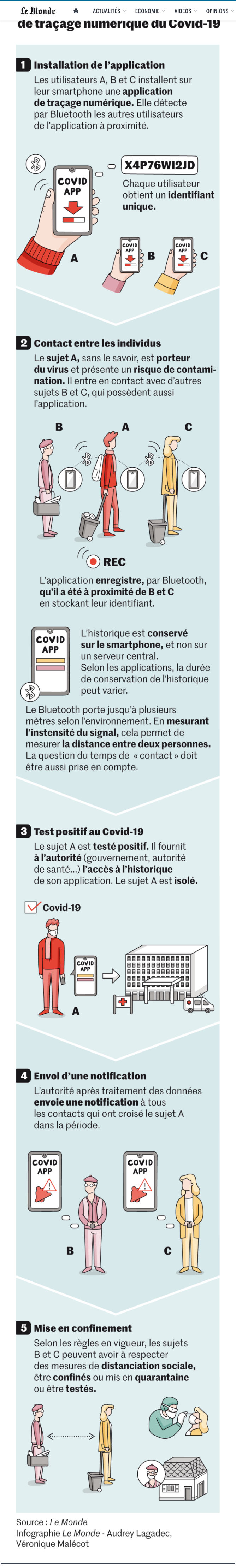

Avec Chat Control, les autorités publiques seront autorisées à scanner, analyser et lire automatiquement les contenus des communications privées en ligne de tous les utilisateur·ices. Cela se fera via une contrainte sur les fournisseurs de chat tels que Signal, Threema, Telegram, Skype, etc.3, soit par ce qu’on appelle une analyse côté client (Client Side Scanning). Les messages et les images seraient alors lus directement sur les terminaux ou les dispositifs de stockage des utilisateur·ices. Et cela avant même qu’ils soient envoyés sous format chiffré ou après leur réception, une fois déchiffrés.

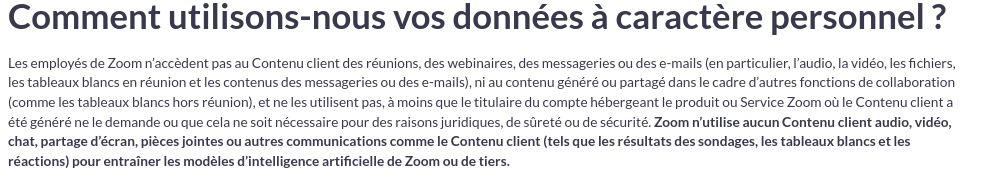

C’est précisément ce que l’UE souhaite atteindre, entre autres, avec Chat Control : rendre les communications chiffrées inutiles. Les services de renseignement, les ministères de l’Intérieur, les autorités policières, les groupes d’intérêts privés et autres profiteurs du capitalisme de surveillance, ont en effet depuis longtemps du mal à accepter que les gens puissent communiquer de manière chiffrée, anonyme et sans être lus par des tiers indésirables.

Pourtant, la communication chiffrée est très importante. Face aux répressions de l’État, elle peut protéger les millitants, les opposant·es et les minorités. Elle sert aussi à protéger les sources et les lanceur·euses d’alerte, et rendre également plus difficile la collecte de données par les entreprises.

Comme si l’intention d’interdire ou de fragiliser le chiffrement n’était pas déjà assez grave, il y a encore pas mal d’autres choses qui nous inquiètent sérieusement avec Chat Control. Ainsi, l’introduction de systèmes de blocage réseau4 est également en discussion. Plus grave encore, l’obligation de vérifier l’âge et donc de s’identifier en ligne. Cela aussi fait explicitement partie du projet. Il s’agira de faire en sorte que l’accès à certains sites web, l’accès aux contenus limités selon l’âge, l’utilisation et le téléchargement de certaines applications comme Messenger, ne soient possibles qu’avec une identification, par exemple avec une carte d’identité électronique ou une identité numérique.

Voici l’accomplissement du vieux rêve de tou·tes les Ministres de l’Intérieur et autres autoritaires du même acabit. L’obligation d’utiliser des vrais noms sur Internet et la « neutralisation » des VPN5, TOR et autres services favorisant l’anonymat figurent depuis longtemps sur leurs listes de vœux. Et ne négligeons pas non plus la joie des grands groupes de pouvoir à l’avenir identifier clairement les utilisateur·ices. L’UE se met volontiers à leur service6. Tout comme le gouvernement allemand, Nancy Faser en tête, qui se distingue par ailleurs avec une politique populiste et autoritaire de droite.

Le « tchat controle » n’est pas la première tentative mais une nouvelle, beaucoup plus vaste, d’imposer la surveillance de masse et la désanonymisation totale d’Internet. Et elle a malheureusement de grandes chances de réussir car la Commission Européenne et la majorité du Parlement, ainsi que le Conseil, les gouvernements et les ministères de l’Intérieur de tous les États membres y travaillent. Et ils voudraient même des mesures encore plus dures comme étendre ce projet au scan de nos messages audios au lieu de scanner « seulement » nos communications textuelles7.

Dans le discours manipulateur, il existe déjà des « propositions de compromis » avec lesquelles les États autoritaires souhaitent faire changer d’avis les critiques. Il s’agirait dans un premier temps, de limiter le type de contenus que les fournisseurs devront chercher, jusqu’à ce que les possibilités techniques évoluent. La surveillance du chiffrement devrait tout de même avoir lieu. Il est évident que ce n’est qu’une tentative pour maquiller les problèmes8.

Comme toujours, la justification est particulièrement fallacieuse ! On connaît la chanson : la « lutte contre le terrorisme », les « copies pirates », les drogues, les armes etc. sont des constructions argumentaires par les politiques pour faire accepter des projets autoritaires et pour en discréditer toute résistance dans l’opinion publique. Il n’en va pas autrement pour Chat Control. Cette fois-ci, l’UE a même opté pour un classique : la prétendue « protection des enfants et des adolescents » et la lutte contre l’exposition des mineurs aux contenus pornographiques. Qui voudrait s’y opposer ?

Pourtant, même des experts, provenant notamment d’associations de protection de l’enfance, affirment que Chat Control ne protégera pas les enfants et les adolescents9. En effet, il permettra également de surveiller leurs communications confidentielles. Le projet peut même conduire tout droit à ce que des agents des autorités aient accès aux photos de nus et aux données confidentielles que des mineurs s’envoient entre eux… Et ils pourront ensuite faire n’importe quoi avec. Le risque de faux positifs à cause de l’emploi de l’IA est également très important. Les gens pourraient avoir de gros problèmes à cause d’une erreur technique. Mais l’UE ne s’en soucie pas car la protection des mineurs n’est pas le sujet ici.

Les domaines d’application ont déjà été élargis entre-temps… Drogues, migration, etc. Tout doit être étroitement surveillé. Quelle sera la prochaine étape ? Une application contre les extrémistes politiques identifiés comme tels ?

Et puis, il y a aussi la très probable question de « l’extension des objectifs ». Nous connaissons déjà suffisamment d’autres lois et mesures étatiques. Elles sont souvent introduites pour des raisons d’urgence. Ensuite, elles sont constamment étendues, différées, puis soudain elles sont utilisées à des fins totalement différentes par les flics et les services de renseignement, selon leur humeur. L’extension de Chat Control se prête bien à ce jeu. Les premières demandes ont déjà été formulées10.

Dans une Europe où : il y a des interdictions de manifester11 et des détentions préventives, des perquisitions pour des commentaires sur les « quéquettes »12, des liens vers Linksunten/Indymedia13 ou des graffitis14, où des enquêtes par les services de renseignement pour adbusting dans l’armée allemande, ou bien des avis de recherche pour « séjour illégal » sont monnaie courante, dans une Europe où les ultraconservateurs occupent des postes de pouvoir, appellent à l’interdiction de l’avortement et à la lutte contre les personnes queer et réfugiées15, où des structures d’extrême-droite existent dans les administrations et la police16, dans cette Europe, une infrastructure de surveillance comme Chat Control, avec interdiction du chiffrement et permis de lecture de l’État sur tous les appareils, a de graves conséquences pour la liberté de tous les êtres humains17.

Des lois et des avancées similaires, la surveillance biométrique de masse18, l’utilisation d’IA à cet égard comme à Hambourg19, les identités numériques20, le scoring21, la police prédictive22, et ainsi de suite sont en cours de développement ou sont déjà devenus des réalités… tout cela crée une infrastructure totale, centralisée et panoptique qui permet d’exercer un énorme pouvoir et une répression contre nous tous.

En tant qu’antiautoritaires, nous devrions nous défendre, attirer l’attention et faire connaître ce sujet en dehors de l’activisme numérique germanophone ! Nous appelons donc à protester et à résister contre Chat Control. Les alliances existantes comme Stop Chat Control23 pourraient être complétées par une critique autonome24. D’autres actions de protestation peuvent être imaginées, il n’y a pas de limites à la créativité. Les objectifs de telles actions de protestation pourraient éventuellement découler de la thématique…

Les anti-autoritaires résistent à Chat Control !

Nous apprécions les suggestions, les questions, les critiques et, dans le pire des cas, les louanges, et surtout la résistance !

- “Zeitplan für Chatkontrolle ist vorerst geplatzt”, Netzpolitik.org, 20/09/2023. (NdT –) Il s’agit du règlement CSAR, également appelé Chat Control. La Quadrature du Net en a fait une présentation.↩︎

- “EU-Gesetzgebung einfach erklärt” Netzpolitik.org, 28/06/2023, “Das EU-Überwachungsmonster kommt wirklich, wenn wir nichts dagegen tun”, Netzpolitik.org, 11/05/2022 ;ChatKontrolle Stoppen ; “Kennen wir ansonsten nur aus autoritären Staaten”, Süddeutsche Zeitung, 10/08/2022.↩︎

- “NetzDG-Bußgeld: Justizminister Buschmann will Telegram mit Trick beikommen”, Heise Online, 28/01/2022.↩︎

- “Die Rückkehr der Netzsperren”, Netzpolitik.org, 11/03/2021.↩︎

- “Online-Ausweis und VPN-Verbot: Streit über Anonymität im Netz kocht wieder hoch”, Heise Online, 08/10/2023.↩︎

- “EU-Ausschuss will Chatkontrolle kräftig stutzen”, Netzpolitik.org, 15/02/2023.↩︎

- “Live-Überwachung: Mehrheit der EU-Staaten drängt auf Audio-Chatkontrolle”, Heise Online, 17/05/2023.↩︎

- “Ratspräsidentschaft hält an Chatkontrolle fest”, Netzpolitik.org, 12/10/2023.↩︎

- “Immer wieder Vorratsdatenspeicherung”, Netzpolitik.org, 23/06/23.↩︎

- “https://netzpolitik.org/2023/ueberwachung-politiker-fordern-ausweitung-der-chatkontrolle-auf-andere-inhalte/”, Netzpolitik.org, 06/10/2023.↩︎

- “Noch mehr Macht für Beamte ist brandgefährlich”, nd Jounralismus von Links, 13/09/2021 ; “Amnesty sieht Versammlungsfreiheit in Deutschland erstmals eingeschränkt – auch in NRW”, Westdeutscher Rundfunk, 20/09/2023.↩︎

- “Unterhalb der Schwelle”, TAZ, 08/08/2022.↩︎

- “Die Suche nach einer verbotenen Vereinigung”, Netzpolitik.org, 03/08/2023.↩︎

- “Linksextreme Gruppen in Nürnberg: Polizei durchsucht mehrere Wohnungen”, Nordbayern, 11/10/2023.↩︎

- “Sehnsucht nach dem Regenbogen-Monster”, TAZ, 28/07/2023.↩︎

- “Das Ende eines Whistleblowers”, TAZ, 01/10/2019.↩︎

- “Chatkontrolle: Mit Grundrechten unvereinbar”, Gesellschaft für Freiheitsrechte ; “Sie betrifft die Rechte aller Internetnutzer”, Junge Welt, 15/09/2023.↩︎

- “Polizei verdoppelt Zahl identifizierter Personen jährlich”, Netzpolitik.org, 03/06/2021 ; “Mehr Kameras an Bahnhöfen”, DeutschlandFunk, 22/12/2014 ; “Polizei bildet Hunderte Drohnenpiloten aus”, nd Jounralismus von Links, 04/01/2023.↩︎

- “Polizei Hamburg will ab Juli Verhalten automatisch scannen”, Netzpolitik.org, 19/06/2023.↩︎

- “Digitale Identität aller Menschen – Fortschritt oder globale Überwachung?”, SWR, 28/08/2022.↩︎

- “Punkte für das Karmakonto”, Jungle.World, 25/05/2022.↩︎

- “Überwachung: Interpol baut Big-Data-System Insight für”vorhersagende Analysen”, Heise Online, 24/09/2023.↩︎

- “Chatkontrolle-Bündnis fordert Bundesregierung zum Nein auf”, Netzpolitik.org, 18/09/2023 ; “Unser Bündnis gegen die Chatkontrolle”, Digital Courage, 12/10/2022 ; Chatkontrolle Stoppen, Digital Gesellschaft ; “Aufruf Chatkontrolle stoppen”, Digital Courage, 10/10/2022.↩︎

- “Statement zum EU-Verschlüsselungsverbot / Chatdurchleuchtungspflicht”, Enough 14, 15/05/2022.↩︎