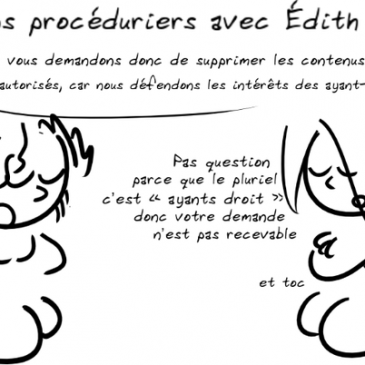

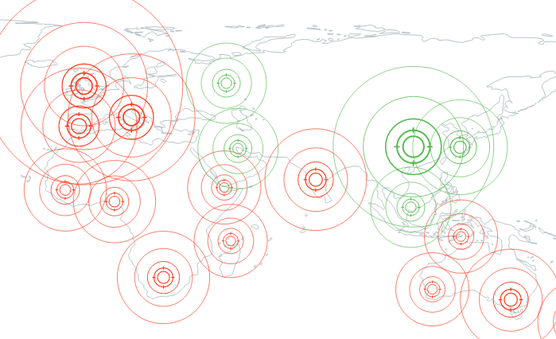

Quand les tribunaux nourrissent les trolls

Les Patent Trolls ou « chasseurs de brevets » sont des sociétés parasites qui tirent profit d’un portefeuille de brevets dont elles ont fait le plus souvent des dépôts abusifs. Elles sont particulièrement néfastes aux USA où elles multiplient les menaces de … Lire la suite