CaRMetal : Entretien avec Eric Hakenholz

CaRMetal est un excellent logiciel éducatif de géométrie dynamique. CaRMetal est un logiciel libre (sinon d’ailleurs il n’aurait jamais vu le jour puisqu’il est directement issu du code source d’un autre logiciel libre). CaRMetal est développé et maintenu par un professeur de mathématiques français fort expérimenté qui a des choses à dire.

CaRMetal est un excellent logiciel éducatif de géométrie dynamique. CaRMetal est un logiciel libre (sinon d’ailleurs il n’aurait jamais vu le jour puisqu’il est directement issu du code source d’un autre logiciel libre). CaRMetal est développé et maintenu par un professeur de mathématiques français fort expérimenté qui a des choses à dire.

Autant de bonnes raisons de rencontrer Eric Hakenholz pour un entretien témoignage riche et intéressant.

Remarque : Le Framablog poursuit ici sa série de mises en valeur et en lumière de projets éducatifs libres et de ceux qui les portent.

Entretien avec Eric Hakenholz

Eric bonjour, une rapide présentation personnelle ?

Je suis professeur de mathématiques depuis 1989. J’ai passé mes deux premières années d’enseignement dans une école française installée dans un lycée public australien (Melbourne). Grâce à ce poste d’enseignant, j’ai eu la chance de pouvoir travailler dès 89 dans un environnement très informatisé et d’être témoin de nombreuses pratiques pédagogiques liées à l’utilisation du réseau (les nombreux Mac Plus de l’établissement étaient tous interconnectés). J’ai programmé là-bas mon premier logiciel Mac : un traceur de courbes et de surfaces, dont l’interface paraîtrait aujourd’hui bien désuète.

J’ai passé ensuite douze années dans l’académie de la Réunion, où j’ai « milité » pour l’utilisation du logiciel Cabri-Géomètre par le biais de formations et de publications (sites, journal bimestriel abraCAdaBRI, développement de l’utilitaire Cabri File Exchange). En 2004, en arrivant dans l’académie de Toulouse, j’ai cherché s’il existait un autre logiciel de géométrie dynamique, libre et gratuit cette fois-ci, qui puisse rivaliser avec la puissance et la pertinence de Cabri : j’ai découvert cette année-là le logiciel C.a.R. (Compass and Ruler).

Qu’est-ce que le logiciel CaRMetal ?

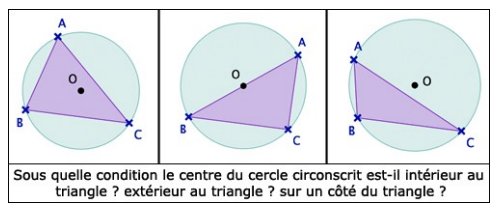

C’est un logiciel de géométrie dynamique, un environnement qui permet notamment d’explorer de manière interactive les propriétés géométriques des figures. Dans ce type de logiciel, les utilisateurs peuvent effectuer des constructions géométriques et déplacer les objets sur lesquels se basent la construction.

Pendant ces déplacements les propriétés sont conservées, et de nombreuses constatations peuvent surgir à ce moment-là : le simple mouvement des figures permet de mettre en évidence de nombreuses propriétés géométriques qui seraient passées inaperçues dans un environnement papier-crayon.

Lorsque j’ai découvert le logiciel C.a.R. de René Grothmann en 2004, je me suis aperçu qu’il contenait de nombreuses fonctionnalités très originales, avec une gestion très pointue des macro-constructions (possibilité de se créer des outils à partir de ceux déjà existants). Cependant, malgré tout l’émerveillement que me procurait la découverte des possibilités de C.a.R., je gardais un oeil assez critique sur la façon d’accéder aux fonctionnalités, sur l’interface utilisateur.

CaRMetal au départ (février 2006) était juste un « TP » motivé par mon envie d’apprendre le langage java. Mes années de programmation en Pascal et en C m’ont amené petit à petit à vouloir changer pour un langage objet multi-plateforme, sur un code qui puisse être exécuté aussi bien sur GNU/Linux, Macintosh ou Windows. Les sources du logiciel C.a.R., écrits en Java par un programmeur clair, rigoureux et doué, ont rempli à merveille leur rôle de tuteur pendant mes deux premiers mois d’apprentissage. Le but que je m’étais fixé au départ était de reprendre les algorithmes mathématiques de C.a.R. et de les installer dans une interface neuve, intuitive, et toute en manipulation directe. Les choses sont allées plus vite que je ne le pensais, et les premiers résultats m’ont encouragé à changer d’optique : ce qui n’était qu’un TP est rapidement devenu un vrai projet, que j’ai décidé de publier sur Internet et de mettre à jour régulièrement.

On développe aujourd’hui des interfaces avec le soucis de donner une réponse immédiate à l’action de l’utilisateur : on s’aperçoit qu’il est presque toujours possible, avec des efforts de programmation supplémentaires, de supprimer toute situation bloquante (comme un dialogue avec boutons ok ou appliquer) ou toute situation qui ralentirait l’action (comme l’obligation systématique de dérouler un menu et de chercher l’item). Développée dans ce sens, avec le soucis d’une organisation claire et rationnelle des outils, une interface graphique permet de travailler d’une façon beaucoup plus fluide, avec un gain de temps très sensible, et une impression de liberté pour l’utilisateur qui s’en trouve nettement améliorée.

C’est avec l’objectif de produire un logiciel qui réponde un peu à ces critères que j’ai programmé CaRMetal : les seules boîtes à dialogues qui existent sont celles relatives à l’enregistrement et l’ouverture des fichiers. En phase de construction ou d’édition des objets, aucun menu n’est à dérouler, l’accès aux fonctionnalités est sans étape intermédiaire et les modifications apportées à l’aspect des objets sont visibles immédiatement dans la fenêtre de travail.

Jusqu’en décembre 2007, je suivais de très près l’évolution du logiciel C.a.R. en incluant dans CaRMetal, version après version, les modifications que René apportait à son « moteur mathématique ». Mais à partir de cette date j’ai souhaité mettre la main sous le capot algorithmique, ce qui nécessitait l’abandon du copier-coller de C.a.R. vers CaRMetal, et plusieurs dizaines de fonctionnalités qui me tenaient particulièrement à coeur ont ainsi pu voir le jour.

En quoi se distingue-il des autres logiciels de la catégorie ? Je pense en particulier à Geogebra lui aussi libre et sous Java.

L’interface utilisateur de CaRMetal se distingue de celle des autres logiciels pour toutes les raisons évoquées précédemment. Certains utilisateurs me disent aussi que, pour leurs élèves, les retours vidéos systématiques ainsi que le caractère graphique des palettes et de l’inspecteur rend pratiquement nul le temps de prise en main du logiciel. D’autres, en général des adultes habitués à des logiciels différents, disent que l’absence de menus-boutons classés par types d’objets les perturbent : je laisse donc le soin aux utilisateurs de se faire leur propre opinion !

Bien sûr il y a de nombreuses fonctionnalités originales qui ne se retrouvent que dans CaRMetal, mais dire uniquement ceci serait oublier un peu trop vite que c’est aussi le cas pour d’autres logiciels de géométrie dynamique, comme Geogebra (je pense notamment à sa récente fonctionnalité « tableur » qui ne se retrouve nulle part ailleurs, du moins dans une forme très proche de celle des tableurs).

Comparer les fonctionnalités est un exercice assez subjectif : chacun peut faire son propre tableau avec en ligne le nom des logiciels, en colonne ses propres fonctionnalités, et ainsi faire apparaître une belle et unique ligne entièrement cochée… Je préfère de loin m’intéresser à l’ergonomie et l’expérience utilisateur, mais je vais tout de même essayer de faire une liste non exhaustive de quelques fonctionnalités "exotiques" de CaRMetal :

- Les diaporamas : CaRMetal peut transformer automatiquement (en un seul clic comme disent les commerciaux) un dossier contenant des figures en un mini site web. En cliquant sur les liens de la page générée, on charge des applets qui correspondent à chacune des figures.

- Les objets magnétiques : Cela permet notamment de créer un point sur plusieurs objets ou un point tout simplement attiré par un ensemble d’objets, conformément à une zone d’attraction définie en pixels par l’utilisateur.

- Les contrôles systèmes : on peut inclure dans la figure des curseurs systèmes, des menus déroulants, des boîtes à cocher, des boîtes d’entrées numériques et des boutons poussoir.

- Le JavaScript : un éditeur graphique permet de créer des scripts utilisant l’intégralité du langage javascript, enrichi de commandes liées à la pratique de la géométrie dynamique. Le logiciel permet de lancer un script et de l’annuler dans une figure.

- Attribution automatique des noms de points : avec un tableau numérique interactif, il est assez gênant d’avoir à utiliser le clavier. Un dispositif d’attribution de noms permet de sélectionner à la volée et au stylet les noms qu’on veut donner aux objets.

- Le mode « tableau numérique interactif » (TNI) : un stylet sur un tableau interactif ne se comporte pas tout à fait comme une souris. On perd la notion de mouse over et par conséquent bon nombre d’informations que donne la souris lors du survol d’objets d’intérêts (retours vidéos). Va-t-on par exemple, en cliquant, créer un point à une intersection, ou va-t-on louper sa cible et créer un point libre à côté ? En mode TNI, un cliquer-glisser équivaut à un survol de souris, et un lâché de stylet correspond à un clic de souris. Dans ce mode, sur un tableau interactif, on garde le même confort visuel et la même précision que lorsqu’on construit à la souris.

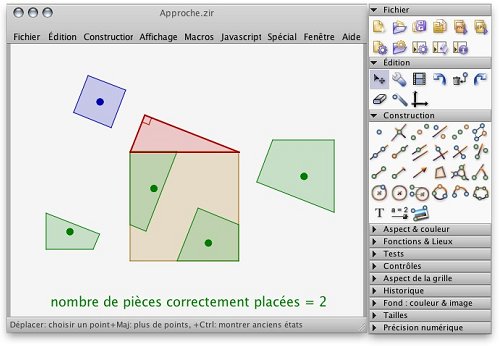

- Les exercices : le formateur peut créer une construction-exercice avec comme objectif de faire construire un objet-cible (un orthocentre par exemple). L’élève doit effectuer la construction et s’il la réussit correctement, le message bravo ! apparaît. Dans ce type de figure c’est le logiciel lui-même qui s’assure que le travail a été effectué sans erreur.

CaRMetal dérive du logiciel C.a.R. (Compass and Ruler) développé par un professeur allemand. C’est parce que ce dernier était un logiciel libre que vous avez pu récupérer les sources et le modifier pour l’adapter à vos besoin. Que cela vous inspire-t-il ?

Certains informaticiens qui vivent en free-lance de leurs productions n’ont pas envie de produire des algorithmes ouverts, de peur que ce qu’ils programment ne soit immédiatement repris et vendu par d’autres. De peur finalement que le bénéfice de leurs travaux, pour lesquels ils ont dépensé beaucoup d’énergie et monopolisé beaucoup de connaissances, aillent dans une autre poche que la leur. Même si je ne fais pas partie de ce monde-là, je peux comprendre cette démarche de protection, par fermeture, dans des secteurs pointus dominés par les majors, les requins et la course au profit. Je préfère de très loin cette démarche cohérente à celle de nombreuses boîtes informatiques entièrement habillées chez Microsoft, et qui d’un autre côté ne jurent que par l’open source, en utilisant abondamment ce label dans le seul but de faire du dollars à grands coups de copier-coller. Concernant l’open source, les choses ne sont donc pas si simples et si manichéennes…

C.a.R. est un logiciel libre, et pas seulement open source : il est sous licence GNU-GPL et par conséquent CaRMetal l’est aussi. René Grothmann, le concepteur de C.a.R., a développé son logiciel dans une démarche d’ouverture et de partage : le véritable esprit du libre est-là, dans un comportement plus éthique et moral que purement technique. Reprendre les sources de René, les adapter suivant mes préférences, ajouter de nouvelles fonctionnalités m’a permis de créer un autre logiciel, qui a son tour peut être repris, et amélioré dans le même esprit.

L’idée du libre me fait penser au chanteur folk américain Woody Guthrie, qui, prenant le contre-pied des copyrights déjà en vogue à son époque, écrivait ceci en 1930 dans un recueil de chansons : This song is Copyrighted in U.S., under Seal of Copyright #154085, for a period of 28 years, and anybody caught singin’ it without our permission, will be mighty good friends of ourn, cause we don’t give a dern. Publish it. Write it. Sing it. Swing to it. Yodel it. We wrote it, that’s all we wanted to do.

Rares sont les enseignants développeurs de logiciels libres, êtes-vous reconnu et soutenu par l’Institution ? Est-ce important pour vous ?

N’ayant jamais aimé jouer les commerciaux, je n’ai jamais rien demandé à personne pendant ces quatre années de développement. C’est peut-être la raison pour laquelle je n’ai jamais eu aucun soutien, aucune reconnaissance de la part de ma hiérarchie institutionnelle ici, dans l’académie de Toulouse.

Lorsque je lis par exemple des présentations de CaRMetal comme celle mise en ligne par l’académie de Poitier, cela me fait bien évidemment plaisir, et je ne cacherai pas qu’une petite reconnaissance du travail effectué, par ma hiérarchie toulousaine, me paraîtrait bien sympathique. Développer un logiciel comme celui-ci prend beaucoup de temps, et le temps n’est pas extensible… Pour la petite histoire, en dehors de mes 19h00 de cours hebdomadaire, il m’a été reproché l’an dernier de ne pas avoir voulu m’investir et participer à la vie informatique de mon établissement, comme personne ressource. Si l’absence de reconnaissance de ma hiérarchie locale n’est pour moi qu’un petit regret, ce genre de reproche-là, par contre, fait plutôt du mal.

Hors institution par contre, l’encouragement est très présent, avec des articles récents comme celui publié sur le portail des IREMs (Institut de Recherche sur l’Enseignement des Mathématiques), ou par exemple les travaux réalisés par l’IREM de La Réunion. L’IREM de Toulouse m’a contacté très tôt, en 2007, pour savoir si je voulais intervenir dans ses stages « Enseigner les maths au collège » et c’est avec grand plaisir que j’ai accepté, et que je donne dans ce cadre-là quelques heures de formation par an. Tout ce qui est écrit aussi au sujet de CaRMetal dans le monde du logiciel libre me donne bien sûr l’envie de continuer !

Que pensez-vous du label RIP et de l’initiative SIALLE visant à promouvoir le logiciel libre dans l’éducation ?

Sans même parler des critères d’attribution de ce label RIP (Reconnu d’Intérêt Pédagogique), on peut se demander si les enseignants ont vraiment besoin qu’on leur indique quelles ressources sont intéressantes pour eux, avec comme corollaire possible que les autres ne le sont pas. Une ressource pédagogique n’étant pas tout à fait comparable à un poulet sous cellophane, j’ai toujours été assez réservé sur la nécessité de labelliser quoi que ce soit dans notre métier d’enseignant. Pour bénéficier de ce label, il faut le demander, et ce n’est peut-être pas dans la culture de tous les développeurs libres du monde éducatif. Cependant, je n’irai pas jusqu’à affirmer que c’est pour cela que presque aucun logiciel libre n’est classé RIP !

Je n’ai jamais demandé le label RIP pour CaRMetal, qui ne fait donc pas partie de la liste : on constate par contre que cela convient tout à fait aux sociétés privées de e-learning qui cherchent à se faire estampiller leurs animations flash, et qui, par les temps qui courent, y arrivent plutôt bien.

Je vois par contre d’un tout autre oeil l’initiative SIALLE, qui montre que l’idée du libre fait aussi son chemin dans l’Education Nationale, même si tout cela reste très timide. C’est pour cette raison-là que lorsqu’on m’a contacté il y a deux ans pour faire partie de cette base de logiciels, j’ai donné mon accord immédiatement. Je regrette un peu l’aspect rigide de la base de données, avec des classements par étoiles qui ne sont issus en général que d’un ou deux avis, mais il reste que cette initiative a le mérite d’exister et qu’il faut l’encourager, et faire en sorte qu’elle prenne plus d’importance.

En mathématiques, il y a l’incontournable et très libre association Sésamath. Participez-vous, de près ou de loin, à ses travaux ?

Non, et c’est un de mes grands regrets… J’ai participé il y a trois ans, avec l’équipe de développeurs de mathenpoche, à une réunion qui s’était fixée pour objectif de jeter les bases du Labomep à venir. J’aurai dû continuer à collaborer sur ce projet avec ces collègues sympas et talentueux, mais je suis resté "en solo" sur CaRMetal, en ne traitant que l’infinie liste des choses à faire pour ce logiciel… On n’a qu’une vie et c’est dommage ! Je suis par contre, dans ma pratique pédagogique, un utilisateur très assidu de toutes les productions de cette association : les manuels, les démos, Mathenpoche, Sesaprofs, eBep’s etc.

Sésamath est un formidable ballon d’oxygène au milieu d’un monde de brutes. Je ne prendrai qu’un seul exemple, que je souhaite détailler : celui des manuels numériques. A l’occasion des nouveaux programmes de sixième estampillés « manuels numériques », les enseignants ont reçu en fin d’année dernière de nombreux spécimens, avec du Bordas, du Nathan, du Hachette et du Hatier comme s’il en pleuvait. Rien de très nouveau dans cette avalanche de papier glacé, mise à part la possibilité de vidéo-projeter le manuel. Il n’y a souvent aucune interactivité véritable dans les documents proposés : juste du texte, des images, et l’idée véhiculée qu’avec tout ça, on allait enfin pouvoir se sentir dans le vent.

Les choses se compliquent lorsque l’enseignant veut installer pour lui et pour sa classe les manuels numériques en question :

- On commence par la case tiroir-caisse avec en moyenne 5,50€ par élève, si on a bien sûr déjà payé les 20€ par élève du manuel papier. Ceux qui souhaitent étudier de près les grilles de tarification des éditeurs, peuvent cliquer ici pour visualiser l’exemple de l’offre de la maison Hachette.

- On part sur un site portail (KNE) pour télécharger son manuel, avec les codes d’accès achetés par l’établissement.

- On installe une application nommée delivery (logiciel utilisé pour les ventes de magazines en ligne) qui a pour fonction de télécharger, lire, et cadenasser la ressource par l’utilisation d’un format propriétaire (.dly).

Pour un enseignant donné, le manuel ne s’installe qu’une seule fois, avec à la limite une autre installation possible sur une clé USB. Si cela vous rappelle quelque chose, c’est normal : il s’agit bien de DRMs appliquées à l’Education Nationale. J’allais oublier de signaler que l’installation de ces manuels numériques, quand on y arrive (de nombreux collègues rencontrent de grosses difficultés techniques pendant cette phase), ne peut se faire que sur windows ou mac. Amis linuxiens, bonjour. Les collègues qui ont opté pour le manuel sesamath 6e (mais aussi les autres !) peuvent aller librement sur le site, téléchargent sans code d’accès ce qu’ils veulent, d’où ils veulent, sous format pdf ou OpenOffice.org, le modifient comme ils le souhaitent, utilisent les démos interactives des chapitres, le site Mathenpoche, ainsi que tous les formidables outils produits par cette association.

Sésamath, c’est le choix de la pertinence et de la sérénité, très loin des contraintes, des contorsions techniques et des interdits que veulent nous imposer les marchands du temple par le biais de leurs relais institutionnels.

La situation du logiciel libre à l’école : excellente, bonne, peut mieux faire ?

Peut beaucoup mieux faire bien entendu… J’attends impatiemment que l’institution se mette enfin à étudier sérieusement les alternatives libres, mais avec des exemples récents comme celui des manuels numériques, on peut se dire qu’il y a encore beaucoup de travail à faire de ce côté-là.

Il serait pourtant possible d’imaginer des établissements entièrement équipés de clients linux sur les réseaux pédagogiques : l’offre logicielle, ainsi que la simplicité d’installation et d’utilisation des nouvelles distributions le permettrait dès maintenant. Il manque juste, pour se faire, une évolution des mentalités des acteurs du monde éducatif, et je ne parle pas que de l’institution : beaucoup de collègues, qui ne se sentent pas en confiance avec l’outil informatique, sont encore très attachés au système windows qui leur a été livré en standard avec leur machine. Je peux comprendre cela et je ne critique pas : je pense juste que la situation du logiciel libre à l’école va sûrement évoluer, mais pas aussi rapidement qu’on pourrait le croire…

Que manque-t-il à CarMetal selon vous et quels sont les améliorations que vous aimeriez voir figurer dans les prochaines versions ?

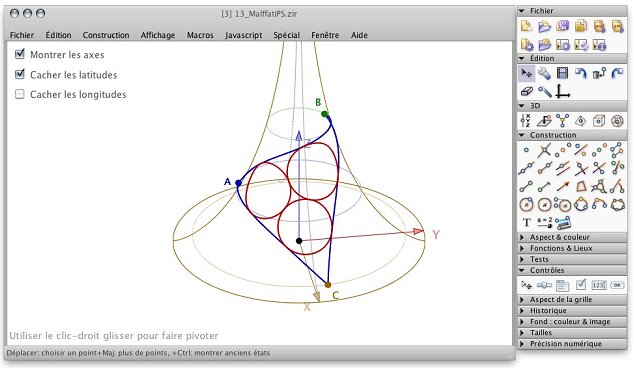

CaRMetal est un logiciel de géométrie plane qui simule assez bien la 3D, mais il lui manque certaines fonctionnalités pour qu’on puisse directement construire et manipuler des objets dans l’espace : c’est sur cette question-là que je travaille en ce moment, et une version qui véritablement 3D devrait voir le jour d’ici décembre.

Une autre amélioration en vue : le multi-fenêtrage de l’application devrait être remplacé, dans un avenir proche, par une navigation par onglets qui permettra un accès plus simple aux figures.

Mon lycée a, depuis un certain temps déjà, opté pour un déploiement massif de la suite bureautique libre OpenOffice.org. Sauf que notre informaticien l’installe sur les postes en modifiant systématiquement l’option du format d’enregistrement « par défaut », substituant au

Mon lycée a, depuis un certain temps déjà, opté pour un déploiement massif de la suite bureautique libre OpenOffice.org. Sauf que notre informaticien l’installe sur les postes en modifiant systématiquement l’option du format d’enregistrement « par défaut », substituant au  Rien de tel pour aborder la rentrée scolaire qu’un excellent article de synthèse de

Rien de tel pour aborder la rentrée scolaire qu’un excellent article de synthèse de  Dans notre imaginaire collectif la Suède est un pays où il fait bon vivre, auquel on accole souvent certains adjectifs comme « social », « mesuré », « organisé », « tranquille, voire même « conservateur ».

Dans notre imaginaire collectif la Suède est un pays où il fait bon vivre, auquel on accole souvent certains adjectifs comme « social », « mesuré », « organisé », « tranquille, voire même « conservateur ». À la prochaine séance du Parlement Européen,

À la prochaine séance du Parlement Européen,  Un bail que je n’ai mis les pieds dans une discothèque estivale. Mais si cela m’arrivait demain , je ne serais guère surpris d’y être accueilli par la chanson

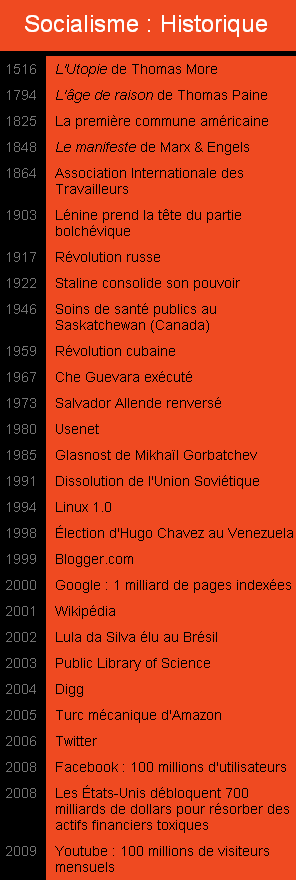

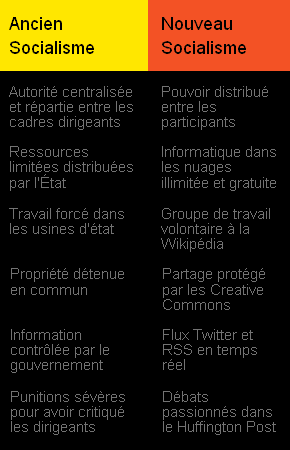

Un bail que je n’ai mis les pieds dans une discothèque estivale. Mais si cela m’arrivait demain , je ne serais guère surpris d’y être accueilli par la chanson  Le socialisme est mort, vive le socialisme ? À l’instar de

Le socialisme est mort, vive le socialisme ? À l’instar de  Dans son livre publié en 2008,

Dans son livre publié en 2008,  Alors qu’une encyclopédie peut être rédigée de façon coopérative, nul n’est tenu pour responsable si la communauté ne parvient pas au consensus, et l’absence d’accord ne met pas en danger l’entreprise dans son ensemble. L’objectif d’un collectif est cependant de concevoir un système où des pairs autogérés prennent la responsabilité de processus critiques, et où des décisions difficiles, comme par exemple définir des priorités, sont prises par l’ensemble des acteurs. L’Histoire abonde de ces centaines de groupes collectivistes de petite taille qui ont essayé ce mode de fonctionnement. Les résultats se sont révélés peu encourageants (quand bien même on ne tienne pas compte de

Alors qu’une encyclopédie peut être rédigée de façon coopérative, nul n’est tenu pour responsable si la communauté ne parvient pas au consensus, et l’absence d’accord ne met pas en danger l’entreprise dans son ensemble. L’objectif d’un collectif est cependant de concevoir un système où des pairs autogérés prennent la responsabilité de processus critiques, et où des décisions difficiles, comme par exemple définir des priorités, sont prises par l’ensemble des acteurs. L’Histoire abonde de ces centaines de groupes collectivistes de petite taille qui ont essayé ce mode de fonctionnement. Les résultats se sont révélés peu encourageants (quand bien même on ne tienne pas compte de  Une formidable occasion manquée pour notre cher ministère de l’Éducation nationale de se rapprocher de la culture des

Une formidable occasion manquée pour notre cher ministère de l’Éducation nationale de se rapprocher de la culture des  Le

Le