« Mais que fais-tu donc derrière ton ordinateur ? » est une question qui me revient assez souvent. Lorsque je dispose d’un peu de temps devant moi il m’arrive de répondre d’applomb : « Je participe à la prochaine révolution ! ».

C’est vrai après tout. Tant qu’à y passer du temps autant que ce soit pour une bonne raison 😉

C’est évidemment une boutade à la limite de la provocation mais elle a le mérite de piquer la curiosité de mon interlocuteur. Et alors de lui évoquer en vrac le logiciel libre, son mouvement, sa culture, ses extensions du domaine comme Wikipédia, Creative Commons, PLoS, etc.

Bref, en gros, tout ce que contient cette nouvelle traduction (by Olivier et Daria from Framalang Institute). C’est un article exotique puisqu’il nous vient d’Inde. Mais il m’est plus familier que bon nombres d’articles de mes propres compatriotes. En imaginant qu’il y ait des V. Sasi Kumar dans tous les pays du monde, il y a de quoi être optimiste…

Crédit photo : Vibrantly Rabari par Meanest Indian (Creative Commons By)

Une nouvelle vague de liberté

A new wave of freedom

V. Sasi Kumar – Mai 2008 – Frontline Magazine (India)

Le nouveau mouvement de liberté, dans les logiciels, le savoir, la publication et le commerce va complètement bouleverser notre manière de penser, de faire les choses et d’interagir.

« Toute action qui est dictée par la peur ou par la contrainte de quelque nature que ce soit cesse d’être morale »

Mahatma Gandhi

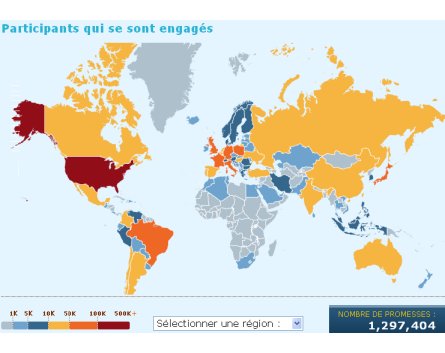

Politiquement, nous ne jouissons pas de certaines libertés que nous méritons. Une nouvelle vague de mouvements pour la liberté, pour rendre concrètes ces libertés, balaie actuellement le monde, un mouvement qui modifiera notre façon de penser, notre façon de faire les choses et notre manière d’interagir. Il a pris sa source aux États-Unis et vise à libérer les gens des serres des monopoles capitalistes. Ici le rôle de Gandhi est joué par une personne extraordinaire qui porte les cheveux longs et a une longue barbe, un homme qui répond au nom de Richard Mathew Stallman, qui rejette avec énergie toute comparaison à Gandhi ou Nelson Mandela.

Gandhi disait « Tant que nous ne sommes pas complètement libres nous sommes des esclaves ». L’évolution des technologies a permis à l’humanité de jouir d’une plus grande liberté. Cependant, des intérêts particuliers, avec l’aide des législateurs, parviennent maintenant à empêcher la société de jouir de cette liberté. Par exemple, avec l’avènement des ordinateurs et d’Internet, les données, les informations et la connaissance peuvent être transmises instantanément à la condition que des deux côtés il y ait ordinateur raccordé à Internet. Toutefois, certaines de nos lois conçues pour une ère dépassée empêchent les peuples de profiter pleinement de cette technologie.

Le nouveau mouvement de liberté parvient à se frayer un chemin autour de ces lois. Et, de façon intéressante, ce mouvement n’est mené par aucun parti politique ni aucun activiste politique, mais bien par des programmeurs informatiques (ou hackers). Voyons de quelles manières nos libertés sont réduites et par quels moyens nous pouvons les reconquérir même au sein du paradigme actuel.

Lorsque vous démarrez votre ordinateur vous vous engagez politiquement. Cela peut vous paraitre absurde de chercher un aspect politique à une chose aussi triviale. Mais c’est là un fait. A l’aube de l’informatique, ce sont les utilisateurs qui écrivaient leurs propres programmes et se les échangeaient selon leurs besoins. Personne alors ne détenait de droit exclusif sur ces programmes. A l’époque les ordinateurs étaient imposants et chers, ils occupaient souvent une salle entière mais étaient bien moins puissants que les PC d’aujourd’hui, même les plus petits. A mesure que la technologie a évolué les ordinateurs sont devenus plus petits et aussi plus puissants.

C’est vers le début des années 80 que les fabricants d’ordinateurs ont commencé à imposer ce qu’on appelait des accords de dissimulation aux programmeurs qu’ils engageaient pour écrire les logiciels. Ces accords interdisaient aux développeurs de révéler le code source de leurs programmes (NdT : leur secret de fabrication). Et ainsi les logiciels sont devenus un produit que les utilisateurs doivent payer. Évidemment, certains utilisateurs ont continué à écrire des programmes pour leurs propres besoins, et ils continuent encore aujourd’hui, mais les logiciels tout-prêts sont devenus accessibles en échange d’un paiement et les utilisateurs d’ordinateurs se sont mis à les utiliser de plus en plus.

Les logiciels pour tous

C’est en réaction à cette marchandisation du logiciel que Richard Stallman, alors employé du Laboratoire d’Intelligence Artificielle du Massachusetts Institute of Technology (MIT), a décidé de créer un système d’exploitation (ou OS pour operating system) et des programmes qui rendraient aux utilisateurs la liberté. Il croyait que les logiciels sont comme la connaissance (il les compare souvent à des recettes de cuisine) et que comme la connaissance les logiciels ne devraient pas être la propriété d’une personne ou d’un organisme. Ils devraient appartenir à l’humanité toute entière.

Stallman a écrit : « De quoi à donc besoin la société ? Elle a besoin d’informations qui sont réellement disponibles aux citoyens, par exemple des programmes que des gens peuvent lire, réparer, adapter et améliorer, pas seulement utiliser. Mais en général les propriétaires des logiciels ne fournissent qu’une boîte noire qu’on ne peut ni étudier ni modifier. La société a également besoin de liberté. Quand un programme est possédé, les utilisateurs perdent la liberté de contrôler une partie de leur propre vie. » (source)

Stallman a initié un projet nommé GNU pour créer des logiciels libres et il a décidé de façonner son OS libre d’après Unix qui était alors très populaire. Unix était un OS propriétaire qui pouvait gérer plusieurs utilisateurs simultanément, il pouvait interconnecter les ordinateurs et était très sécurisé. A l’époque, de nombreux programmeurs avaient pris l’habitude de baptiser un nouveau programme qui était similaire à un autre pré-existant en créant un acronyme signifiant que ce n’était justement pas ce programme.

Ainsi, par exemple, un nouvel éditeur de texte similaire à l’éditeur existant Emacs se nommait Eine pour Eine Is Not Emacs (NdT : Eine n’est pas Emacs). De même, Stallman baptisa son système d’exploitation GNU pour GNU is Not Unix. Il sera plus tard combiné avec le noyau Linux (la partie centrale d’un OS) pour donner naissance au système d’exploitation GNU/Linux. Il existe maintenant plusieurs noyaux qui peuvent être utilisés avec GNU, comme FreeBSD, Open Solaris etc.

« Pour les logiciels libres ce qui importe est la liberté, pas le coût. C’est une question de liberté, pas de prix. Le mot "libre" dans "logiciel libre" a une signification proche de celle dans liberté de parole, peuple libre ou pays libre et ne devrait être confondu avec une autre signification associée à coût zéro. Il faut que vous voyez "logiciel libre" comme libre de fardeau, pas nécessairement libre de frais. Il faut le voir comme logiciel swatantra (NdT : libre ou indépendant en sanskrit) » précise la Free Software Foundation d’Inde. Les logiciels libres apportent quatre libertés aux utilisateurs :

- La liberté de les utiliser sur un nombre illimité d’ordinateurs pour n’importe quelle tâche ;

- La liberté de partager le logiciel dans votre cercle familial ou d’amis ;

- La liberté d’étudier et de modifier le logiciel ;

- La liberté de redistribuer les modifications.

(NdT : toute la confusion entre libre et gratuit provient du double sens de "free" en anglais)

La troisième liberté implique que ce que l’on appelle le code source (le texte compréhensible par l’Homme) du programme devrait être mis à disposition de tout utilisateur souhaitant l’obtenir. Mais on peut se demander ce que peuvent en faire les utilisateurs. Alors que la plupart d’entre eux seraient certainement incapables de l’étudier ou de le comprendre, sans même parler de le modifier, cette liberté permet à tout un chacun de demander à un programmeur de le modifier et permet également aux programmeurs de par le monde au moins d’étudier le programme pour vérifier que rien de ce qu’il contient ne constitue une menace pour les utilisateurs. Concrètement, les sociétés et autres organisations peuvent modifier le programme pour qu’il réponde à leurs besoins.

Stallman a rapidement démissionné du MIT par crainte que le MIT revendique les droits sur son travail. Il était quasiment une entreprise à un seul employé lorsqu’il a démarré le projet GNU en 1984 mais des dizaines de milliers de personnes du monde entier l’on rejoint ensuite. En 1985 il a lancé la Free Software Foundation (FSF). Aujourd’hui, en plus de la FSF à Boston aux Etats-Unis on retrouve des FSF en Europe, en Inde et en Amérique Latine. Et les logiciels libres sont devenus suffisamment puissants, et populaires aussi, pour défier la puissance de nombreuses entreprises de logiciels propriétaires.

Libre et populaire

Par exemple, toutes les écoles du Kerala n’emploient que des logiciels libres et tous les ordinateurs du gouvernement du Kerala sont en cours de migration vers les logiciels libres. Les écoles de la province d’Estrémadure en Espagne en font de même. Mais bien avant eux la ville de Munich avait déjà décidé de faire migrer tous ses ordinateurs vers des logiciels libres. De nombreuses entreprises et organismes gouvernementaux ont déjà effectué la migration (comme ELCOT dans la Tamil Nadu) ou sont en train de le faire (comme le Kerala State Electricity Board par exemple). Bien que le gouvernement du Kerala ait adopté une politique des TIC promouvant explicitement les logiciels libres, le gouvernement de l’Inde n’a pas encore pris une telle décision. Espérons que le gouvernement de l’Inde à son tour proclame la liberté des logiciels.

Les logiciels sont vraiment identiques à la connaissance comme l’a découvert Stallman. La ressemblance peut être établie de manière très détaillée. Plutôt que d’énumérer tous les arguments on peut signaler qu’un vaste ensemble de savoirs est disponible au format numérique et, pour un ordinateur, il n’y a pas beaucoup de différence entre un programme et un savoir numérisé comme un fichier texte, une image ou une vidéo. Dans ce cas il devrait être possible de libérer aussi la connaissance, tout comme le projet GNU a libéré les logiciels.

En mars 2000, Jimmy Wales, un entrepreneur américain de l’Internet, a lancé Nupedia, une encyclopédie en ligne dont le contenu est libre, le précurseur du Wikipédia actuel. Le contenu de l’encyclopédie était sous licence Nupedia Open Content License qui autorisait à n’importe qui de la copier, modifier et distribuer mais qui défendait quiconque d’en faire payer le contenu. Le contenu était rédigé par des volontaires dont les connaissances dans le domaine étaient évaluées par un comité et le contenu était soumis à révision avant publication. Les coûts de fonctionnement de Nupedia étaient couverts par Bomis, une entreprise Internet que détenait Wales.

Mais le succès de Wikipédia apporta un coup d’arrêt à Nupedia en 2003. Une majorité des contributeurs n’étaient pas satisfaits des lourdeurs du contrôle éditorial exercé sur les contributions et Stallman et la FSF étaient en faveur d’une plus grande liberté laissée aux contributeurs. Par conséquent la FSF a lancé une nouvelle encyclopédie appelée GNUPedia en 2001. Mais comme Wales possédait déjà le nom de domaine gnupedia.org elle a été renommée GNE (pour GNE is Not an Encyclopedia) sur la même idée que GNU.

GNE a eu une vie plus courte encore, en partie à cause de son incapacité à décider du poids du contrôle éditorial mais surtout parce que Nupedia a lancé Wikipédia en 2001 qui offrait une liberté totale et dont le contenu était placé sous la GNU Free Documentation Licence. Apparemment ce serait Stallman qui aurait le premier évoqué l’idée d’une encyclopédie en ligne libre en 1999.

Même s’il a lancé GNE, depuis son échec, il supporte Wikipédia. Aujourd’hui Wikipédia est l’encyclopédie la plus populaire avec plus de deux millions d’articles rien que pour la langue anglaise et bien plus encore dans d’autres langues. Parmi ces autres langues on en dénombre huit qui dépassent les 300 000 articles chacune et huit autres encore qui dépassent la barre des 100 000 articles chacune.

On recense 254 langues du monde possédant au moins une page Wikipédia. Les dialectes indiens ne sont pas bien représentés dans Wikipedia. Le premier est le telugu avec 38 000 articles, suivi par le bishnupriya manipuri avec 23 000 articles, le bengali (17 000), l’hindi (16 500), le marathi (16 200) et le tamil (13 000). Aucun autre langage indien ne compte plus de 10 000 articles. Il est acquis maintenant que l’encyclopédie Malayalam, publiée par le gouvernement du Kerala, mettra tous ses articles sur Wikipédia.

Même s’il est vrai que le nombre d’utilisateurs d’Internet ne représente qu’un infime pourcentage de la population, ce pourcentage est amené à croitre et la disponibilité de l’information en langues indiennes sera certainement d’une grande utilité à tous les Indiens, en Inde et à l’étranger.

Wikipédia est actuellement dirigée par une organisation à but non lucratif, la Wikimedia Foundation, grâce aux contributions du public. D’autres projets sont dans les cartons aujourd’hui, comme Wikibooks, Wikinews et Wiktionary. Tous les documents, y compris le texte et les illustrations, sur tous ces sites peuvent être copiés, modifiés et utilisés librement à toute fin sans violer de lois du droit d’auteur. C’est réellement la liberté du savoir.

Un autre projet connexe est WikiMapia. En reprenant une citation de Wikipédia : « WikiMapia est un projet inspiré par Google Maps et par Wikipédia. WikiMapia utilise les vues satellitaires de Google Maps et permet de les annoter avec un système wiki. Les Russes Alexandre Koriakine et Evgeniy Saveliev ont lancé ce projet le 24 mai 2006. Le projet est destiné à « cartographier et décrire la planète Terre » vue par satellite. Il fait partie des 1 000 sites les plus visités et recense plus de 6 millions d’endroits annotés. Alors qu’aucune inscription n’est requise pour éditer WikiMapia, plus de 153 000 utilisateurs partout dans le monde sont actuellement inscrits. »

Le terme "connaissance" est utilisé ici dans une conception large et désigne aussi bien des articles que des livres, des histoires, des images, de la musique, des films, etc. Il faut se rappeler que chaque support possède certaines particularités que les autres n’ont pas. Ainsi par exemple, un article sur l’astronomie indienne contient principalement de la documentation issue de sources variées même si la présentation finale de l’information est celle propre à l’auteur. Mais une histoire (un roman, une nouvelle…) est le travail créatif émergeant complètement de l’imagination de l’auteur.

Ainsi, pour les humains, la connaissance se distingue des logiciels par une différence fondamentale. En effet, contrairement aux logiciels, certaines formes de connaissance ne se prêtent pas aux modifications anonymes. Par exemple, une interview avec une personnalité doit conserver sa forme et son contenu puisque c’est le compte-rendu d’une vraie conversation. Il serait dangereux de laisser quiconque la modifier.

D’un autre côté, la liberté pourrait être accordée, par exemple, de la publier ailleurs sans modification. De même, un artiste ne souhaiterait peut-être pas que n’importe qui puisse modifier sa peinture, même si cela ne poserait pas de problème. Il n’est donc pas suffisant de disposer d’une seule licence pour toutes les formes de savoir contrairement aux logiciels. Mais alors quelle est la solution ?

Creative Commons

La solution a d’abord était proposée par Creative Commons (CC) en décembre 2002. CC a été lancé par Lawrence Lessig, Professeur à la Stanford Law School, avec quelques amis pour répondre précisément à ce problème. « Creative Commons a repris l’idée "offrir des licences de droit d’auteur libres" du Free Software Movement. Mais le problème que nous essayions de résoudre était quelque peu différent » dit Lessig.

En quoi était-il différent ? « Nous ne partions pas d’un monde sans culture propriétaire. Au contraire, la culture propriétaire avait toujours été là, les œuvres étaient protégées par un droit exclusif. (…) Mais globalement, le fardeau imposé par le droit d’auteur aux autres créateurs et sur la culture en général était léger. Et une somme importante de travail créatif pouvait se faire hors des contraintes de la loi. … Tout ceci a commencé à changer avec la naissance des technologies numériques et pour une raison que personne n’a vraiment cherché à comprendre. » (source).

Une autre raison a entraîné la formulation de ces licences. Après la Convention de Berne en 1886 il n’était plus nécessaire de déclarer un droit d’auteur. Tout œuvre originale tombe automatiquement sous le régime du droit d’auteur. Et finalement il n’est plus devenu nécessaire de marquer un document comme protégé par le droit d’auteur. Sauf déclaration contraire, tout document qui n’appartient pas au domaine public est protégé par le droit d’auteur.

Rien que de savoir si un document est protégé par les lois du droit d’auteur devient par conséquent difficile. Cela rend la ré-utilisation d’œuvres déjà disponibles très compliquée. De plus, les auteurs désirant offrir certaines libertés aux autres n’ont aucun moyen de le faire. Ils n’avaient le choix qu’entre le droit d’auteur et le domaine public (qui concède tous les droits à tout le monde).

Creative Commons propose plusieurs licences grâce auxquelles le créateur peut offrir certaines libertés aux gens, ou, comme le dit CC, Certains Droits Réservés en opposition au Tous Droits Réservés du régime "classique" du droit d’auteur. CC dispose de quatre licences principales : Attribution (notée by), Noncommercial (nc), No Derivative Work (nd) et Share Alike (sa) (NdT : Paternité, Pas d’Utilisation Commerciale, Pas d’œuvre Dérivée et Partage à l’Identique). Ces licences peuvent être combinées pour produire de nouvelles licences comme by-sa, by-nc-nd etc. qui sont plus utiles que les licences principales.

CC a également élaboré une Licence de Sample qui permet aux autres d’utiliser des portions de votre œuvre dans leur propre œuvre. Vous vous souvenez de la jeune auteure indienne, Kaavya Viswanathan, punie il y a quelques temps pour l’utilisation de passages d’autres livres dans sa nouvelle, même si les lecteurs appréciaient sa nouvelle ?

Un développement intéressant permis par CC a été la création d’un morceau de musique par la collaboration d’artistes qui ne se sont jamais rencontrés. Colin Mutchler, un défenseur de l’utilisation des média et de la technologie pour donner envie aux gens de prendre des mesures en faveur d’une économie durable, a envoyé My Life, une chanson joué à la guitare acoustique, sur Opsound, un répertoire de musique qui impose aux morceaux soumis d’être sous licence Attribution-Share Alike ; Cora Beth, une personne complètement inconnue de Colin, y a ajouté un violon pour créer My Life Changed. Aucun avocat de la Propriété Intellectuelle n’a été consulté, ou maltraité, pour cela. Gilberto Gil, le ministre brésilien de la Culture et musicien lauréat d’un Grammy Award supporte la liberté de la culture et a sorti quelques-unes de ses musiques sous la licence CC Sampling.

Rentable également

Une question qu’il est naturel de se poser est alors : est-ce que le créateur ne va pas perdre ses revenus s’il permet aux gens d’utiliser ses créations librement ? L’expérience montre que ça n’est pas le cas. Par exemple, les groupes de musique affirment que les téléchargements de musique libre en fait les aident à faire plus de concerts et leur source de revenus principale est la scène (source). Une recherche sur Google vous fera découvrir d’autres études de ce genre.

Comme Stallman et d’autres l’ont suggéré, un lien sur la page de téléchargement peut permettre aux utilisateurs d’effectuer un paiement volontairement. Pour une œuvre assez bonne cela peut apporter à son auteur une somme appréciable. De toute façon des copies illégales de la plupart des films ou des musiques sont disponibles gratuitement, particulièrement dans les pays émergents et rien n’est arrivé, ni à l’industrie de la musique, ni à celle du film.

Cependant, à long terme, les industries de l’édition, du disque et du cinéma pourraient avoir à adopter un nouveau paradigme qui pourrait être défini par les nouvelles technologies qui émergeront à coup sûr, même si ces industries se sont toujours montrées très attachés aux anciens paradigmes et qu’elles font tout ce qu’elles peuvent pour ne pas changer. Souvenez-vous des protestations de l’industrie de la musique lorsque l’enregistreur cassette a été inventé. Pourtant jusqu’à maintenant aucun changement drastique n’est en vue.

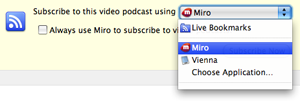

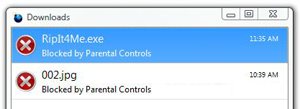

L’industrie du disque aux États-Unis a réussi à mettre le législateur de son côté pour subvenir à ses propres besoins au travers de la technologie des DRM (NdT : Digital Rights Managements ou Mesures Techniques de Protection) et une loi associée et le DMCA (NdT : Digital Millenium Copyright Act dont la loi DADVSI est la transposition en droit français). Stallman et les partisans du logiciel libre appellent les DRM Digital Restrictions Managements (ou Mesures Techniques de Privation). Les DRM empêchent en fait les gens de copier les œuvres incorporant cette technologie ou encore de jouer l’enregistrement sur un autre lecteur. Par conséquent, le mot Restrictions (Privations) semble plus approprié.

Les fans de musique se sont opposés à cette politique et on peut trouver beaucoup d’articles sur le Web à ce sujet. Ils disent que les DRM les empêchent même d’exercer leur droit à la copie privée. Les opposants ont créé des logiciels qui peuvent outrepasser la technologie DRM. Mais le DMCA (NdT : tout comme la DADVSI) rend illégal la création ou l’utilisation d’une technologie visant à briser les DRM. Heureusement, ces lois ne sont actuellement en vigueur que dans quelques pays. L’industrie du disque fait pression sur l’Inde et d’autres pays pour adopter ces lois. Mais espérons que l’Inde choisisse d’offrir les bénéfices des technologies à son peuple plutôt qu’aux industriels.

Les publications dans des revues scientifiques étaient à l’origine faites pour communiquer les résultats des recherches à d’autres scientifiques. La première revue scientifique au sens moderne est le Philosophical Transactions de la Royal Society of London dont la publication a commencé en 1665. A l’époque, seule l’imprimerie permettait cette communication. La plupart des premiers journaux étaient édités par des sociétés de chercheurs comme la Royal Society. Avec l’augmentation du nombre de revues et de chercheurs, les éditeurs se sont dits qu’une manne leur tendait les bras.

Quelques grandes maisons d’édition ont investi le marché et, bizarrement, le prix des revues s’est aussi mis à augmenter. Finalement, la communauté scientifique a commencé à se révolter contre les revues qui faisaient payer le prix fort. En 2001, deux organisations ont co-publié Declaring Independence.

Rémunérer l’éditeur

L’édition scientifique est à bien des égards différente des autres formes d’édition. Ici les articles sont rédigés par les chercheurs et relus par des chercheurs. Les éditeurs du journal sont souvent eux-mêmes des chercheurs également. Les maisons d’édition ne font qu’imprimer et envoyer le journal aux abonnés. Le salaire des chercheurs provient essentiellement de l’argent public. Leur travail de recherche est également financé par l’argent public. Et pourtant c’est la maison d’édition qui détient les droits sur les articles.

Les chercheurs et le public doivent s’abonner à ces journaux (ils doivent payer l’éditeur) pour avoir accès aux informations obtenues grâce à l’argent public. Et le prix des journaux a commencé à augmenter au point que certaines universités parmi les plus aisées dans les pays industrialisés ont de plus en plus de mal à s’abonner à tous les journaux qui traitent de leurs activités. C’est dans ces conditions que les scientifiques ont commencé leur révolte. On attribue la naissance du mouvement à une pétition de 2001 à l’initiative de Patrick Brown et de Michael Eisen même si des voix isolées les précédaient.

Ainsi, Prof. Donald Knuth, auteur du classique Art of Computer Programming et inventeur de Tex, un langage de traitement de texte pour documents techniques, écrit : « J’adore ma bibliothèque et les autres bibliothèques que je visite fréquemment et ça me met en rage de voir les prix qu’ils imposent aux bibliothèques. J’ai donc écrit une lettre salée à Elsevier en août 2001 pour leur faire part de ma grande inquiétude quant à leur future politique de prix pour le Journal of Algorythms. Elsevier a cependant ignoré ma lettre et ne m’a pas répondu. » (source)

La pétition de Brown et Eisen appelait tous les scientifiques à s’engager à partir de septembre 2001 à ne plus soumettre leurs papiers aux journaux qui ne rendaient pas le texte complet de leurs travaux accessible à tous, librement et sans entraves, que ce soit immédiatement ou après un délai de quelques mois.

La fondation de la Public Library of Science (PLoS) a été la grande étape suivante du mouvement vers la libération des éditions scientifiques. Malgré le soutien d’un éminent prix Nobel, Dr. Harold Varmus, ils ont dû patienter quelques temps avant de devenir complètement opérationnels et de publier le journal PLoS Biology en 2003.

Maintenant ils éditent sept journaux dont le contenu est disponible librement sur Internet. Ils ont adopté un modèle où les auteurs des articles paient pour être publiés. Ils conservent un fond, comme le font d’autres journaux du même type, pour affranchir de tout paiement les auteurs de pays émergents ou les auteurs qui n’ont pas les moyens suffisants.

En Europe, la Budapest Open Access Initiative, qui est à la fois une déclaration d’intention, de stratégie et d’engagement, a été signée par plusieurs scientifiques lors d’une réunion organisée par l’Open Society Institute en décembre 2001. Aujourd’hui des milliers de scientifiques sont signataires de l’initiative. Elle a eu un impact très fort dans le monde entier, en particulier en Europe.

Plusieurs agences de recherche et de financement, comme le Organisation Européenne pour la Recherche Nucléaire (CERN) et le National Institutes of Health (NIH), ont imposé l’accès libre pour toutes les publications issues de recherches qu’ils ont financées.

L’Accès Libre (AL) signifie que toutes les publications sont librement accessibles par les autres scientifiques et par le public. En fait, il offre toute liberté aux utilisateurs et demande simplement que l’auteur soit reconnu et que l’intégrité des documents soit conservée. Bien sûr il ne permet pas la ré-édition des documents, dans leur forme originale ou modifiée, comme les licences CC le font. Mais L’Accès Libre aux publications scientifiques est une avancée très importante dans des pays comme l’Inde.

Le gouvernement d’Inde devrait par conséquent imposer l’Accès Libre pour toutes les publications issues de recherches financées par l’argent public. Cela peut-être réalisé de deux manières : soit l’auteur affiche l’article sur son site Web, sur le site de son institut ou sur un site de centralisation (les revues qui permettent cela sont appelés AL vert) soit il peut publier dans des revues Accès Libre qui affichent leur contenu sur leur propre site Web (appelées AL d’or). Heureusement, une grande partie des journaux indiens sont AL. Mais la plupart des bons articles d’Inde sont publiés dans des journaux étrangers qui ne sont pas nécessairement AL.

La liberté dans le commerce

Nous allons parler ici d’une nouvelle expérience menée en Inde. L’idée est de parvenir à une transparence totale du commerce. Une entreprise technologique nommée WikiOcean a vu le jour à Pune. L’entreprise est unique de part le fait qu’elle expose tout son fonctionnement sur son site Web, même ses transactions financières. Ils appellent ce genre de système un wékosystème, un jeu de mot entre wiki et écosystème. Comme l’explique le site Web : « WikiOcean est une organisation participative, non-propriétaire où les professionnels rejoignent un modèle de partage des bénéfices comme expliqué dans le wékosystème. »

Cette entreprise a été inspirée par la transparence des logiciels libres et, en fait, l’un de ceux que l’on pourrait appeler les catalyseurs (ceux qui régulent la structure et la dynamique de Wékosystème) est le président de la Free Software Foundation of India, Prof. G. Nagarjuna. L’entreprise travaille déjà sur quelques projets. Mais il est encore trop tôt pour juger des chances de survie d’une telle entreprise. Souhaitons que tout se passe pour le mieux.

Une autre idée complètement exotique est de copier le modèle des logiciels libres pour d’autres produits. En d’autres termes rendre tous les besoins librement disponibles pour tous. Bien que ça puisse sembler absurde il ne faudrait pas rejeter cette idée puisque certains efforts à petite échelle ont été lancés et semblent fonctionner.

Cette idée est envisagée par un groupe pas si petit que ça qui s’appelle Oekonux (dérivé de oekonomie, le terme allemand pour économie et Linux). Vous pourrez en apprendre plus sur www.oekonux.org et vous pouvez rejoindre leur liste de diffusion si vous êtes vraiment intéressés.

Comme nous l’avons vu, les nouvelles technologies apportent de nouveaux défis, de nouvelles idées. Et nous serons peut-être amenés à ré-écrire de vieilles lois qui avaient été créées pour des situations complètement différentes, un autre paradigme technologique.

Quand de nouvelles technologies apparaissent il nous faut changer nos lois pour nous adapter à la nouvelle donne afin que la société puisse pleinement bénéficier de la nouvelle technologie ou alors seule une petite portion de la société en récoltera tous les bienfaits. Et au rythme auquel la technologie évolue il ne va pas être facile de suivre toutes ses implications. Nos technocrates et nos législateurs vont devoir suivre le rythme.

Cet article (et sa traduction) est publié sous licence Creative Commons Attribution Share Alike 2.5.