L’enseignante Christine Mytko ou l’exception qui devrait être la règle

C’est la rentrée des classes. Et nous publions, à l’occasion, la traduction d’un entretien avec une enseignante américaine impliquée dans ce que l’on appelle les Ressources Éducatives Libres, ces ressources placées sous licence libre et qui offrent aux utilisateurs les mêmes droits que ceux d’un logiciel libre : utilisation, étude, modification, duplication et diffusion. Face au casse-tête du « tous droits réservés », elles représentent une formidable opportunité pour l’éducation. Une opportunité d’usage mais aussi de remix et de création collective. Une opportunité qui met l’accent sur le partage et la coopération au détriment de l’individualisme et de la compétition.

C’est la rentrée des classes. Et nous publions, à l’occasion, la traduction d’un entretien avec une enseignante américaine impliquée dans ce que l’on appelle les Ressources Éducatives Libres, ces ressources placées sous licence libre et qui offrent aux utilisateurs les mêmes droits que ceux d’un logiciel libre : utilisation, étude, modification, duplication et diffusion. Face au casse-tête du « tous droits réservés », elles représentent une formidable opportunité pour l’éducation. Une opportunité d’usage mais aussi de remix et de création collective. Une opportunité qui met l’accent sur le partage et la coopération au détriment de l’individualisme et de la compétition.

Le problème c’est que vos enfants ont encore aujourd’hui une chance infime de rencontrer de tels professeurs dans leur classe cette année.

Pourquoi ? Principalement à cause de la scandaleuse et irresponsable politique de l’autruche du ministère de l’Éducation Nationale qui ne s’est toujours pas décidé à les encourager. Aussi hallucinant que cela paraisse, rien, absolument rien d’envergure n’est prévu pour les mettre en avant. Aucune trace dans les programmes officiels, aucune directive adressée aux enseignants. Et cela dure depuis des lustres.

Cela va même au delà de la belle ignorance ou de la simple indifférence, il suffit de parcourir ces quelques anciens articles du Framablog pour s’en convaincre :

- De l’usage des « œuvres protégées » à l’Éducation Nationale

- Le Centre Français d’exploitation du droit de Copie mène l’enquête à l’école

- Les drôles de conseils du site Educnet

- L’académie en ligne ou la fausse modernité de l’Éducation nationale

- Hadopi à l’école : transformons la propagande en opportunité

L’aggiornamento n’a toujours pas eu lieu. C’est une « culture propriétaire » et non une « culture libre » qui règne encore au sein du ministère et qui influence tous ses fonctionnaires. Voilà la triste vérité.

Dans ce contexte hostile on ne s’étonnera pas que les enseignants de la trempe de Christine Mytko[1] demeurent pour le moment minoritaires. Il en existe bien sûr, mais leur sensibilisation s’est bien moins faite grâce à l’école que malgré l’école. C’est pourquoi d’ailleurs un site comme le nôtre continue malheureusement d’avoir sa modeste utilité, mais qu’il est dur de nager à contre-courant alors que nous devrions plutôt tous surfer sur la vague du bon sens.

Au cours de l’interview ci-dessous publiée à l’origine sur le blog du site des Creative Commons, Christine Mytko constate que c’est la méthode « CASE » qui prévaut encore chez les enseignants. C’est l’acronyme anglais de « Copy And Steal Everything » signifiant que tout le monde fait à peu près n’importe quoi avec le respect des licences. Il suffit effectivement de passer une journée devant la photocopieuse d’une salle des professeurs pour s’en rendre compte.

On fait n’importe quoi mais comme on ne reçoit aucune information et qu’on ne s’expose à aucune sanction, il n’y a aucune raison de modifier son comportement. Un comportement que l’on retrouvera alors naturellement par ricochet chez les élèves de ces enseignants, c’est-à-dire nos enfants.

C’est entendu, l’école à d’autres chats plus importants à fouetter actuellement que ce détail des licences des ressources. Certes mais sans vouloir être grandiloquent « l’école du XXIe siècle sera libre ou ne sera pas ». Alors autant s’y préparer sérieusement dès maintenant et ne plus faire de chaque jour qui passe un jour de perdu.

Éducation et politique pédagogique libres : Entretien avec Christine Mytko, du site Curriki

Curriki’s Christine Mytko: Open Education and Policy

Jane Park – 5 août 2010 – Creative Commons Blog

(Traduction Framalang : Don Rico)

Au début de l’année 2010, nous avons annoncé une refonte de nos projets consacrés à l’éducation et un soutien accru au mouvement des REL, les Ressources Éducatives Libres (NdT: OER en anglais, pour Open Educational Resources). En ce sens, nous avons redoublé d’efforts pour accroître la quantité d’informations disponibles sur notre site. Outre la mise en ligne d’une nouvelle page d’acueil pour notre rubrique Éducation et notre portail consacré aux REL, sur laquelle nous expliquons le rôle que jouent les Creative Commons en tant qu’infrastructure technique et juridique, nous avons réalisé une série d’entretiens destinés à exposer les obstacles que rencontrent les REL et les chances qu’elles ont de trouver leur place dans notre paysage pédagogique.

Un changement de politique au niveau local, national et international constitue l’un des vecteurs les plus probants pour la promotion des REL. Il y a peu, nous avons eu la chance d’interroger Christine Mytko, qui milite pour l’adoption des REL à l’échelle locale dans le cadre de son métier d’enseignante et en tant que validatrice principale de la rubrique scientifique du site Curriki. De par son statut de professeure, Christine Mytko apporte un point de vue précieux sur l’éducation et la politique libres, et nous offre un bon aperçu de la façon dont on perçoit le copyright, l’utilisation des Creative Commons et des REL dans le monde éducatif.

Vous êtes enseignante et validatrice de la section scientifique de Curriki, que l’on décrit comme le « wiki nouvelle génération » pour l’enseignement primaire et secondaire. Pouvez-vous nous décrire brièvement qui vous êtes et ce qui vous a conduite aux fonctions que vous occupez aujourd’hui ? Quelle est d’après vous la mission de Curriki, et comment ce site aide-t-il les enseignants ?

J’ai passé la majeure partie de ma carrière à enseigner les sciences dans des collège publics. Il y a trois ans, j’ai eu la chance de trouver un poste qui allie mes deux passions : la science et la technologie. À l’heure actuelle, je suis intervenante en sciences chez les maternelles et professeure de technologie dans un petit collège de Berkeley, en Californie.

En 2007, j’ai posé ma candidature pour un temps partiel chez Curriki. Comme de nombreux enseignants, je cherchais à arrondir mes fins de mois. J’ai alors découvert une communauté d’éducateurs dévoués à la création collaborative et au partage de ressources libres. Membre de l’équipe de modération de Curriki, je suis chargée de valider les contenus scientifiques que l’on nous soumet et de fournir une notation et des retours publics au contributeur. Si besoin est, je participe aussi à d’autres projets. En ce moment, je travaille avec un professeur de chimie afin de réviser et soumettre un manuel de chimie numérique open-source dans le cadre de la California Learning Resource Network’s Free Digital Textbook Initiative.

Comme on peut le lire en page d’accueil du site, la mission de Curriki est de « fournir des ressources et des programmes libres de grande qualité aux enseignants, étudiants et parents du monde entier. » Certains l’auront deviné, son nom est un jeu sur les mots « curriculum » (NdT: « programme d’enseignement » en anglais) et wiki. Le dépôt de Curriki contient un choix riche pour les programmes d’enseignement, allant des plans de leçons à des séquences complètes, disponibles pour plusieurs matières, niveaux et langues. Curriki offre d’autres ressources tels que des manuels scolaires, des supports multimédia, et des projets collaboratifs.

Tout le contenu présent sur Curriki est partagé sous la licence Creative Commons Paternité (CC-BY), ce qui l’inscrit solidement dans l’espace des REL. Savez-vous pourquoi Curriki a choisi la CC-BY pour ses ressources en ligne ? Si vous l’ignorez, quel avantage présente la CC-BY comparé à du contenu « Tous droits réservés » ?

Les contributeurs de Curriki sont libres de placer leur contenu soit dans le domaine public soit sous une licence CC de leur choix, mais le contrat de licence par défaut est en effet le CC-BY. Je ne connais pas les raisons qui ont poussé Curriki à la choisir, mais c’est une excellente décision. La CC-BY confère aux enseignants la possibilité de remixer, partager et distribuer des ressources afin qu’elles soient les plus pertinentes pour leur programme d’enseignement.

La souplesse offerte par la licence CC-BY permet d’adapter le contenu très vite. La révision d’un manuel scolaire s’étale sur un cycle de sept ans. Le contenu de Curriki, lui, peut être mis à jour et « publié » en quelques secondes, et la communauté peut corriger les éventuelles erreurs tout aussi rapidement. De nombreux sujets, surtout en sciences et en technologie, évoluent si vite que l’enseignement ne peut se permettre d’être dépendant des cycles de publication trop longs des ouvrages propriétaires.

À l’heure actuelle, la Californie et le Texas sont les plus gros acheteurs de manuels traditionnels « Tous droits réservés », et les éditeurs se coupent en quatre pour répondre aux exigences de ces états. Les enseignants des autres états (et autres pays) sont contraints à composer avec ces limitations propriétaires. Des initiatives de REL telle que Curriki permettent néanmoins de modifier librement des outils afin qu’ils correspondent le mieux à leurs besoins pédagogiques et culturels. En créant ou en mettant à disposition un tel contenu dans des dépôts publics, les enseignants n’auront plus à travailler chacun dans leur coin et ne seront plus forcés à constamment « réinventer la roue ». Plus on donnera à partager librement du contenu de qualité au sein de communautés d’enseignants, moins on passera de temps à adapter de la matière propriétaire, ce qui permettra aux enseignants de consacrer davantage de leur temps, qui est précieux, à d’autres domaines importants de l’enseignement.

Décrivez-nous un projet pédagogique auquel vous avez intégré du contenu sous CC et/ou des REL. Quelles difficultés avez-vous rencontrées, vous ou vos élèves, en recherchant ou en utilisant des ressources sur le web ? Comment relateriez-vous cette expérience à des enseignants qui souhaitent attribuer les bonnes licences à leurs propres ressources pour la recherche et la découverte des REL ? Que doivent savoir ces professeurs ?

Pour mes cours de technologie, je fais en sorte désormais que tous les supports médias incorporés aux devoirs soient sous Creative Commons, dans le domaine public ou dépourvus de tout copyright. Au début, après des années à pouvoir piocher sans restriction dans Google Images, mes élèves se sont sentis très restreints dans leurs choix, mais nous avons débattu de ce qui sous-tend le copyright et les solutions alternatives à celui-ci, et nombre d’entre eux ont compris l’importance de respecter les droits.

Il existe de nombreuses sources d’excellente qualité pour aider les enseignants et les élèves à utiliser des ressources sous Creative Commons en cours. La page de recherche des Creative Commons, Wikimedia Commons, la section CC de Flickr et l’option de recherche avancée de Google sont des outils fantastiques pour trouver des images placées sous licence alternative. Pour la musique, des sites tels que Jamendo sont formidables.

Au départ, la terminologie a présenté des difficultés pour mes collégiens. Bien qu’il n’y ait que six contrats CC principaux, mes élèves ont été déroutés par des termes tels que « Paternité » (NdT: Attribution en anglais) et « Pas de modification » (NdT: No Derivatives en anglais). Le fait que Google emploie des formulations légèrement différentes (« réutilisation autorisée » et « réutilisation avec modification autorisée ») dans ses filtres de recherche n’a pas arrangé les choses. Mais les jeunes ont vite apprivoisé les termes et les procédures, et en l’espace de quelques cours, ils accédaient aisément à du contenu sous licence « Certains droits réservés » et l’utilisaient à bon escient. Évidemment, je leur demande de définir des droits d’utilisation pour leurs travaux, ce qui renforce la compréhension des licences et les pousse à réfléchir soigneusement aux droits qui comptent pour eux.

Concernant la mise à disposition de mes travaux sous forme de REL, je n’ai pas fini d’apprendre. Avant de rejoindre l’équipe de Curriki, j’hésitais à « publier » mes ressources sous licence libre. Après avoir consacré tant de temps et d’énergie à créer certaines préparations, il me semblait aberrant de les distribuer gratuitement sur Internet. Depuis quelques années, j’ai toutefois compris les avantages que présentent les contenus libres, et je publie sur Curriki, sous licence CC-BY, certains de mes travaux autrefois jalousement gardés. À présent, je partage sans restriction mes nouveaux travaux. Je me sens plus à l’aise pour utiliser et créer des ressources libres, et j’espère à présent passer à l’étape supérieure et collaborer avec d’autres enseignants.

Quelles sont les idées erronées ou les inquiétudes les plus répandues chez les professeurs concernant le partage de leur travail ? Pensez-vous que dans le secondaire, le professeur moyen connaisse l’existence de licences alternatives comme les Creative Commons ? Quelles politiques sont menées au niveau des établissements ou des institutions pour aider les professeurs à partager leur travail ?

Je suis certaine que le professeur moyen ignore jusqu’à l’existence même des solutions alternatives ouvertes. La plupart de mes collègues appliquent toujours la méthode CASE, Copy and Steal Everything (NdT: Tout copier, tout voler). Je ne pense pas que les enseignants utilisent des ressources de cette manière par paresse ou volonté de nuire. Quiconque a enseigné un jour sait l’ampleur du travail qu’il faut accomplir en très peu de temps. Parfois, copier une activité (souvent placée sous copyright) et la déposer dans le casier d’un collègue, ce n’est qu’une question de survie. Même parmi les professeurs qui sont conscients des problèmes de copyright, beaucoup invoquent le « fair use » (NdT: usage raisonnable en droit anglo-saxon, plus ou moins proche du droit de citation). Le problème, c’est que ces personnes surestiment souvent les protections et les privilèges que leur confère le fair use. En outre, nous sommes très peu formés sur le copyright et le fair use, et encore moins sur les Creative Commons et les REL. En plus de ne pas connaître ses responsabilités, un enseignant du secondaire ignore les droits et les autres solutions dont il dispose pour partager son travail.

Un certain nombre de blocages empêchent les enseignants de penser au partage de leurs ressources. Tout d’abord, créer un programme d’enseignement prend tellement de temps que beaucoup sont réticents à partager leurs cours parce qu’ils estiment que le produit de leurs efforts leur appartient. D’autres ont le sentiment que leur travail n’est pas assez bon. Et même pour ceux qui surmontent ces obstacles psychologiques, il reste les questions techniques sur la façon dont ils partageront leur travail sous licence libre. Aucun des établissements où j’ai travaillé n’avait mis en place une politique ou une plage de temps pour le partage des ressources. En discutant avec des collègues, j’ai découvert qu’eux aussi déploraient cette même absence de volonté de la part de leurs établissements. Même dans les rares cas où l’on tentait de donner des directives dans ce sens, les professeurs choisissaient souvent de ne pas les appliquer. À l’heure actuelle, la plupart des enseignants n’ont ni l’accès, ni la formation, ni le soutien nécessaires pour participer en confiance au mouvement des REL.

Curriki fournit un gros travail pour indiquer à quelles standards pédagogiques des divers états des USA correspondent ses ressources. Pouvez-vous nous expliquer cela fonctionne ? Quels avantages et difficultés cela présente-il ? En quoi est-ce utile ?

Ce travail ne fait pas partie de mes attributions chez Curriki, mais je peux vous donner un avis personnel, en tant qu’enseignante et membre de Curriki. Lorque l’on consulte une ressource sur notre site, quatre onglets apparaissent – Contenu, Détails, Standards, et Commentaires. Cliquer sur l’onglet Standards permet à l’utilisateur de voir à quels programmes elle correspond, ainsi que de l’associer aux standards d’un autre état. Le procédé est très intuitif : l’utilisateur parcourt une série de menus et choisit les standards qui lui paraissent appropriés.

Le bénéfice principal sera sans doute la possibilité de rechercher des ressources répondant à un standard voulu en passant par la page que je viens de mentionner. Le plus grand défi consiste à associer les différents standards à nos ressources existantes et futures. Curriki s’appuie en grande partie sur la communauté pour que ce chantier s’accélère. Pour l’heure, les couples standards/normes ne sont établis que pour la moitié des états, et même ces regroupements sont incomplets.

On parle beaucoup des REL en ce qui concerne les politiques pédagogiques, surtout sur la question des manuels scolaires libres. À votre avis, quel est l’avenir du manuel scolaire pour le primaire et le secondaire ? Comment souhaiteriez-vous que cela se traduise dans les politiques éducatives ?

Comme de nombreux enseignants, j’ai le sentiment que le règne du manuel scolaire touche à sa fin. En tant que professeur de sciences, j’ai rarement été dépendante d’un manuel pour préparer mes cours, et je m’appuie davantage sur des ressources que je trouve en ligne ou que je crée moi-même. Grâce aux REL, je profite mieux de la création et du partage de travaux au sein d’une communauté collaborative. La science et la technologie se prêtent bien à une adoption précoce de la philosophie du libre, mais je suis convaincue que d’autres matières suivront bientôt.

Les manuels ne pourront conserver leur mainmise actuelle. Un article récent du New York Times indiquait que « même les éditeurs de manuels traditionnels reconnaissent que l’époque où l’on modifiait quelques pages dans un livre afin d’en vendre une nouvelle version était révolue. » Les manuels scolaires coûtent cher et sont vite obsolètes. Pour corriger les erreurs qu’ils contiennent, il faut attendre l’édition suivante. En comparaison, les REL sont très bon marché voire gratuites, constamment mises à jour, et faciles à corriger. Il serait formidable que l’argent économisé si l’on préférait les REL abordables aux coûteux manuels servait à acquérir des outils pédagogiques supplémentaires et financer des formations pour les enseignants. Ou mieux encore, que les administrations puissent employer ces fonds à payer les enseignants pour qu’ils se réunissent et collaborent à la création de REL sur leur temps de travail.

Pour terminer, à quoi « ressemble » un environnement d’enseignement et d’apprentissage qui exploite avec succès les immenses possibilités des REL ? Avez-vous des considérations à nous faire partager… des inquiétudes, des espoirs, des prédictions ?

Un environnement d’apprentissage efficace se doit d’être bien pensé, attrayant, motivant, et souple. Les REL sont toujours d’actualité, on peut aisément et en toute légalité les adapter aux besoins des élèves. Une communauté de REL peut fournir aux enseignants les ressources et le soutien nécessaires pour répondre aux attentes de la catégorie d’élèves à laquelle ils s’adressent. Des ressources partagées librement permettent à d’autres de gagner d’innombrables heures de travail individuel redondant, et grâce à eux, les professeurs ne sont plus prisonniers d’un programme pédagogique propriétaire.

Les établissements scolaires commencent à comprendre les économies que permet l’abandon du modèle actuel de manuels scolaires, et je prédis que les éditeurs s’adapteront aux exigences du marché. J’espère que les établissements reconnaîtront enfin que les enseignants sont une ressource précieuse, des professionnels qualifiés, et qu’ils méritent une contrepartie pour le temps qu’ils passent à créer leurs programmes de cours.

Dans l’idéal, la salle de classe devrait être un espace où les élèves ne sont pas que des consommateurs passifs de ressources et de documents multimédia, mais plutôt des collaborateurs actifs, qui synthétisent et publient leur travail. J’espère que dès le plus jeune âge on apprendra aux élèves à utiliser le travail d’autres personnes de façon appropriée, et qu’on les encouragera à partager leurs travaux sous une licence libre avec certains droits réservés au lieu de se rabattre sur la solution par défaut du copyright classique, ou pire, ne pas les partager du tout. Je veux que mes élèves et mes collègues comprennent qu’en partageant des ressources, ils contribuent à constituer une réserve de matériel pédagogique qui servira à d’autres bien au-delà des murs de leur salle de classe. C’est un changement important dans la philosophie pédagogique actuelle, mais des sites tels que Curriki constituent un grand pas dans la bonne direction.

Notes

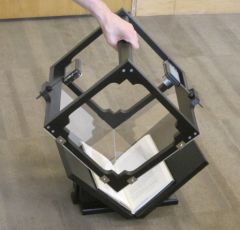

[1] Crédit photo : Christine Mytko (Creative Commons By-Nc)

Si vous êtes un lecteur assidu du Framablog, vous ne découvrirez probablement pas grand-chose de nouveau dans l’article qui suit. Mais il n’est pas non plus dépourvu d’intérêt, loin s’en faut : il peut être une référence pour tous ceux qui ne connaissent pas bien la différence entre les « hackers » et les « crackers », et ils sont nombreux. On dit souvent, à raison, que cette confusion est de nature médiatique, mais malheureusement ce n’est que partiellement vrai. Avec l’influence que les médias ont pu avoir, il est devenu très courant d’entendre au détour d’une conversation que des « hackers ont piraté (ou que des pirates ont hacké !) tel système ». Et même dans les

Si vous êtes un lecteur assidu du Framablog, vous ne découvrirez probablement pas grand-chose de nouveau dans l’article qui suit. Mais il n’est pas non plus dépourvu d’intérêt, loin s’en faut : il peut être une référence pour tous ceux qui ne connaissent pas bien la différence entre les « hackers » et les « crackers », et ils sont nombreux. On dit souvent, à raison, que cette confusion est de nature médiatique, mais malheureusement ce n’est que partiellement vrai. Avec l’influence que les médias ont pu avoir, il est devenu très courant d’entendre au détour d’une conversation que des « hackers ont piraté (ou que des pirates ont hacké !) tel système ». Et même dans les  Un jour que je questionnais une élève sur ses pratiques numériques qui me semblaient un peu confuses, j’ai eu cette curieuse mais révélatrice réponse : « si je peux techniquement le faire, je ne vois pas pourquoi je me l’interdirais, de toutes les façons tout le monde le fait, et puis ça ne fait pas de mal à une mouche ».

Un jour que je questionnais une élève sur ses pratiques numériques qui me semblaient un peu confuses, j’ai eu cette curieuse mais révélatrice réponse : « si je peux techniquement le faire, je ne vois pas pourquoi je me l’interdirais, de toutes les façons tout le monde le fait, et puis ça ne fait pas de mal à une mouche ». Si j’ai demandé l’autorisation à son auteur d’exhumer et reproduire ici-même un de ses articles pourtant déjà vieux de presque dix ans, c’est parce qu’il touche à une notion simple mais essentielle : la confiance.

Si j’ai demandé l’autorisation à son auteur d’exhumer et reproduire ici-même un de ses articles pourtant déjà vieux de presque dix ans, c’est parce qu’il touche à une notion simple mais essentielle : la confiance. Les mouvements alternatifs d’émancipation portés par le numérique, dont le logiciel libre fait partie, ont été récupérés et domestiqués par le système et sa force marketing sous la bannière et le vocable du

Les mouvements alternatifs d’émancipation portés par le numérique, dont le logiciel libre fait partie, ont été récupérés et domestiqués par le système et sa force marketing sous la bannière et le vocable du  Tout le monde connaît ou tout du moins a déjà entendu parler du

Tout le monde connaît ou tout du moins a déjà entendu parler du