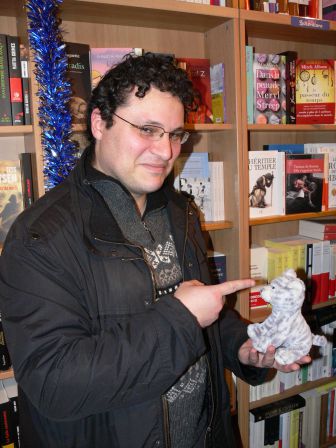

Pouhiou est notre joyeux et émérite premier romancier chez Framabook. À l’occasion de la sortie prochaine du livre II du cycle des NoéNautes, il a lancé une originale campagne de crowdfunding sur Ulule qui a fait réagir le blogueur influent (parce que brillant) Calimaq.

Ce dernier s’est en effet aventuré à parier que si cette campagne aboutissait alors il élèverait lui aussi son blog dans le domaine public via la licence Creative Commons CC-0. Bien mal lui en a pris puisque la campagne vient déjà de dépasser la barre escomptée (Pouhiou vous en remercie en vidéo ici) et se poursuit d’ailleurs…

Chose promise, chose due donc, et prétexte surtout à un passionnant entretien dialogue entre deux personnalités fortes du « Libre » francophone.

Je cède la parole à Pouhiou, et ça tombe bien car il adore la prendre 😉

En lançant le blog de mon roman feuilleton, j’ai eu d’instinct l’envie que cette histoire appartienne à ses lecteurs. Qu’ils s’en emparent. C’était une certitude que je ne savais pas comment appliquer dans les faits. M’intéressant au livre et au droit d’auteur, je suivais déjà le blog S.I.Lex écrit par un certain Calimaq. Ce mec, passionné et passionnant, arrive à transformer un sujet à priori lourd et chiant (la propriété intellectuelle) en une épopée rocambolesque. A force d’exemples, de décryptages, de coups de sang et de coup de cœur, il nous plonge dans les eaux du copy-right-left-up&down, on baigne en Absurdie et l’on ressort de son blog plus juriste qu’on y est rentré… sans même s’en apercevoir.

Un de ses billets m’a fait prendre conscience que la place de mes œuvres était dans le domaine public. J’ai donc passé tous mes écrits sous la licence CC0 et l’ai chaudement remercié dans cet article.

Il est né de cet échange une amitié intellectuelle. Calimaq s’est mis à défendre et mon œuvre, et la démarche qui l’accompagnait. Je me suis engagé dans SavoirsCom1, un collectif qu’il a co-fondé pour la défense des biens communs informationnels. Je ne compte plus les fois où l’on s’est dit « merci », tant chacun semble admirer et être complice de ce que fait l’autre. C’est ce genre d’émulation où la réflexion de l’autre nourrit la tienne, et te mène un poil plus vite, un poil plus loin que là où tu te serais rendu tout seul.

Quand, avec Framasoft, on a initié ce crowdfunding fou (toujours en cours sur Ulule) pour que le lancement de #MonOrchide (livre II des NoéNautes) puisse financer la distribution gratuite d’exemplaires de #Smartarded (le livre I), Calimaq a répondu présent. Il a fait un bel article pour promouvoir cette expérience . Mais, chose inattendue, il a ajouté ce post-scriptum explosif :

PS : allez, moi aussi, je mets quelque chose dans la balance. Si Pouhiou réussit son pari, je passe S.I.lex en CC0. Ceci n’est pas une parole en l’air !

Le pari est réussi. En 22 jours, on a atteint les 2200 € qui nous permettront de distribuer au moins 32 exemplaires de #Smartarded. Grâce à une mobilisation peu commune il ne nous a fallu que la moitié des 45 jours prévus (ce qui veut dire qu’il reste trois semaines pour battre tous les records et accroître le nombre de livres à distribuer !)

Le pari est réussi, et S.I.Lex devient un dommage collatéral : Calimaq tient sa part du contrat, élevant son blog dans le Domaine Public Vivant. Je sais que, le connaissant, ce n’est pas un geste anodin. Une belle occasion de discuter avec lui de licences, d’écriture, et de qu’est-ce que ça veut bien dire, toutes ces choses-là…

Pouhiou : Tu m’as fait un super article sur ton blog S.I.Lex, qui a été repris par ActuaLitté. Cela m’a beaucoup aidé à faire connaitre le projet. C’était déjà énorme (merci ^^). Pourquoi avoir en plus ajouté la licence de ton blog dans la balance ?

Calimaq : Cela fait un moment que je m’intéresse à ce que tu fais autour du cycle des Noenautes et d’après ce que tu as écrit sur ton blog, un des billets que j’avais écrit sur S.I.Lex t’avait influencé dans ta décision d’adopter la licence CC0 pour ton premier roman #Smartarded.

Quand j’ai vu que tu lançais cette opération de crowdfunding, j’ai voulu la soutenir et la faire connaître, parce que je trouve qu’elle bouscule la manière dont nous avons l’habitude d’appréhender des notions fondamentales, comme celles du gratuit et du payant. Avec la licence CC0, tu as renoncé à tes droits d’auteur pour que tes œuvres soient complètement libres, tout en réussissant à faire paraître ton roman chez Framabook. C’est déjà en soi assez perturbant pour les schémas habituels. Mais tu ne t’es pas arrêté là et par le financement collaboratif, tu as cherché à faire en sorte qu’un maximum de livres en papier deviennent gratuits afin de pouvoir les offrir.

Le plus intéressant dans ta démarche, je trouve, c’est que derrière ces décisions, il y a un modèle économique bien pensé, qui utilise le crowdfunding pour raccourcir la chaîne de l’auteur au lecteur, dans le but de diminuer les coûts. Tu démontres de manière paradoxale que la gratuité a toujours un coût. C’est typiquement le genre d’approches alternatives qui retiennent mon attention, parce que je trouve qu’elles font avancer la réflexion. Dans le contexte actuel de crispations autour des questions de droit d’auteur, qui sont particulièrement vives dans le secteur du livre, je pense que des initiatives comme les tiennes sont importantes. J’ai aussi beaucoup apprécié la lecture de ton premier roman #Smartarded et j’ai commencé à lire la suite #MonOrchide par petites touches sur ton blog. Tout cela a fait que j’ai voulu te soutenir en écrivant un billet sur S.I.lex et je me réjouis de ta réussite.

Merci ! Mais là tu parles plus de moi que de toi, hein… J’ai bien saisi que ce billet a été un élément déclencheur, mais est-ce qu’il s’agit d’un coup de tête ou est-ce que ça fait partie d’une réflexion personnelle plus… ancienne ?

Au-delà du billet, pourquoi avoir promis de changer la licence de mon blog si ton pari réussissait ? Peut-être d’abord un peu par superstition, pour porter chance à ton projet, en engageant quelque chose qui me tenait vraiment à cœur. Par ailleurs, je me posais des questions à propos de la licence de S.I.Lex depuis un certain temps. À vrai dire depuis le moment où j’ai écrit le billet Rien n’est à nous : grandeur et misère du domaine public volontaire. J’y montrais comment un certain nombre de créateurs dans le passé avaient choisi pour diverses raisons de renoncer aux droits sur leurs œuvres pour se placer en dehors de la logique de la propriété intellectuelle : Léon Tolstoï, Romain Rolland, Jean Giono, les affichistes de mai 68, les situationnistes, le musicien folk Woodie Guthrie.

Le domaine public est une notion qui a un grande importance pour moi et pour laquelle j’essaie de me battre. Il m’a semblé que le moment était venu de franchir le pas et de placer ma propre création, S.I.Lex, dans le domaine public volontaire.

Ton blog était en licence CC-BY (la seule condition de partage est de citer l’auteur). Là tu le passes en CC0. C’est quoi, au fond, la différence ?

Juridiquement dans le cadre du droit français, il n’y a pas tellement de différences. En effet, le Code de Propriété Intellectuelle ne permet pas dans notre pays de renoncer valablement à son droit moral, ce qui signifie qu’on doit théoriquement interpréter la CC0 comme une CC-BY. Je n’ai pas la possibilité légale de renoncer à mon droit à la paternité. Ce caractère inaliénable du droit moral a été voulu pour protéger l’auteur dans le cadre des contrats d’édition. Même dans le cas des « nègres » (ou, plus joliment dit, Ghostwriters en anglais), il reste possible pour eux de réclamer devant un juge la paternité d’un texte écrit pour quelqu’un d’autre, quand bien même ils se seraient engagés par contrat à ne pas révéler leur identité (on a des jurisprudences intéressantes à ce sujet dès le 19ème siècle, notamment dans l’affaire qui opposa Alexandre Dumas à l’un de ses collaborateurs, Auguste Maquet.

Le problème, c’est que l’application trop rigide de ce principe aujourd’hui peut conduire à « protéger » l’auteur contre lui-même, alors qu’il manifeste clairement la volonté de renoncer à ses droits. La licence CC0 a d’ailleurs été obligée de prendre en compte cet état de fait, en précisant que l’auteur renonce à ces droits « dans la mesure permise par la loi ». Cela veut dire que l’effet de la CC0 varie selon les pays : aux États-Unis, où le droit moral n’existe pas vraiment, il est total ; en France, il reste juridiquement incomplet, puisque le droit moral persiste. Le seul pays à l’heure actuelle qui reconnaisse explicitement la possibilité de verser ses œuvres dans le domaine public volontaire, c’est le Chili.

Donc passer de CC-BY (licence déjà très ouverte) à CC0 n’a pas beaucoup d’effets pratiques… tant que la propriété intellectuelle n’est pas réformée en France. Malgré tout, je ne t’imagine pas homme à manier ces licences à la légère. Si passer de la CC-BY au Domaine Public Vivant n’est pas un choix pratique, il est de quel ordre ?

Cette décision revêt à mes yeux une valeur symbolique et psychologique importante, en tant qu’auteur. Je ne suis pas comme toi auteur de littérature ou de théâtre, mais j’ai un rapport profond avec l’écriture. J’écris sur S.I.Lex par besoin viscéral d’écrire et quand je décroche de l’écriture, je périclite littéralement. Pour moi, l’écriture a aussi une importance comme trace que l’on laisse de soi au-delà de son existence. Du coup, le BY – la paternité – gardait une vraie importance à mes yeux, comme une sorte de « cordon ombilical » ou de minimum minimorum du droit d’auteur, dont il était difficile de se détourner. Couper ce cordon en adoptant la CC0 n’était pas anodin et il m’a fallu un certain temps – et un coup de pouce de ta part – pour lâcher prise !

Quel est l’intérêt, pour toi, de mettre de son vivant des textes dans le domaine public ?

Pour moi, l’intérêt principal, c’est de sortir en dehors du cadre du droit d’auteur. Avec les licences libres, on passe de la logique du copyright à celle du copyleft, mais on reste encore dans le système du droit d’auteur. Les licences libres ne sont pas une négation du droit d’auteur, mais une autre manière de le faire fonctionner. Avec la licence CC0, on n’est plus dans le copyright, ni même dans le copyleft, mais littéralement dans le copy-out. On décide sciemment que son œuvre n’est plus saisie par le droit d’auteur et ne doit plus être comprise à travers ce filtre. Je ne prétends pas que cette voie doive être suivie par tous les auteurs. Mais au stade où j’en suis, c’est cohérent avec ma démarche.

Tu dis de ton côté que tu n’as pas l’impression que tes textes ne t’appartiennent pas, mais que tu “digères” des éléments extérieurs que tu restitues par tes écrits. De mon côté, j’ai très tôt été sensible aux effets d’intelligence collective sur la Toile, avec le sentiment que je me devais de rendre à l’intelligence collective ce qu’elle me donne. Il n’y a pas un seul de mes billets qui n’ait été déclenché par les conversations et les échanges dans les flux. Dès lors, le meilleur moyen d’être cohérent avec moi-même, c’est d’opter pour le domaine public volontaire.

Par ailleurs, je pense important de montrer que le domaine public n’est pas seulement une chose du passé, mais qu’il peut être vivant aujourd’hui. En tant qu’auteur de son vivant, contribuer à alimenter le domaine public, c’est la meilleure manière de s’en faire l’ambassadeur et d’agrandir le cercle des biens communs de la connaissance.

OK : on a tous les deux ce souci de cohérence. C’est bien beau d’utiliser une licence parce qu’elle te met en adéquation avec ce que tu ressens de ta production intellectuelle… Mais il y a forcément des pragmatiques qui vont nous traiter d’utopistes ! Ils vont nous rappeler qu’on vit dans un monde où les enjeux commerciaux prévalent et où — selon eux — les circonstances font qu’il vaudrait mieux armer et protéger ses œuvres… D’un point de vue pratique, la clause non commerciale (NC) est un outil redoutable quand la CC0 est une passoire ! Du coup, une licence, c’est la conséquence d’un ressenti théorique ou la résultante d’un besoin pratique d’outil légal ?

C’est sans doute assez souvent le résultat d’un compromis entre les deux. Il faut considérer la situation des auteurs dans leur diversité et de multiples stratégies sont envisageables avec les licences. Les choses peuvent varier également selon les domaines de la création. Quand on voit un Cory Doctorow ou un Lawrence Lessig publier leurs ouvrages chez des éditeurs traditionnels et placer les versions numériques sous CC-BY-NC, je trouve que c’est une stratégie compréhensible et qu’ils ont par ce biais contribué à faire avancer la cause, en diffusant leurs idées dans un large cercle.

Beaucoup de créateurs en revanche ne cherchent pas un retour financier pour les œuvres qu’ils produisent. C’est le cas pour la plupart des amateurs qui créent des contenus sur Internet. Dans ce genre de situation, la réservation de l’usage commercial n’est généralement pas justifiée et choisir cette clause impose des contraintes sans réelle nécessité. Mais dans certaines situations, la clause NC peut constituer un élément intéressant pour permettre la circulation des œuvres tout en mettant en place un modèle économique. Il y a un débat assez vif en ce moment sur la légitimité de la clause NC, notamment telle qu’elle figure dans les licences Creative Commons. Je ne fais pas partie de ceux qui condamnent cette clause de manière systématique et j’ai déjà essayé de montrer que ce serait une erreur selon moi de la supprimer.

Malgré cela, tu n’as jamais mis de clause NC sur ton blog S.I.Lex...

Dans mon propre cas, je n’en vois absolument pas l’intérêt… Mon objectif en écrivant de cette manière est d’être lu par un maximum de personnes. Si certains de mes billets sont repris sur d’autres sites, y compris des sites se livrant à des activités commerciales, cela ne peut qu’augmenter l’exposition de mes écrits. J’ai d’ailleurs toujours fonctionné depuis le lancement de S.I.Lex dans un « écosystème » de sites. Très vite, j’ai eu la chance de voir certains de mes billets repris par le regretté OWNI. Cela a grandement contribué à faire connaître S.I.Lex et à développer mon lectorat. D’autres sites me reprennent régulièrement, comme Actualitté ou plus récemment Slate.fr. J’ai toujours considéré que S.I.lex était une sorte de plateforme de tir, où je posais des écrits qui pouvaient ensuite aller faire leur vie ailleurs. Avec une licence NC, les choses auraient été beaucoup plus compliquées.

La licence CC0 est peut-être une passoire, mais dans les conditions particulières qui sont les miennes comme auteur, elle conviendra parfaitement à ce que je veux faire de mes créations. Même si un éditeur vient publier certains de mes billets sous forme de livre dans un recueil, cela ne fera que contribuer encore à leur diffusion.

Du coup, tu n’exiges plus que l’on te cite comme source de tes écrits… de manière légale, c’est ça ? C’est un peu comme moi en fait : tu ne brandis pas d’arme juridique. Plutôt que de les craindre, tu donnes ta confiance aux personnes qui s’inspireront de (ou diffuseront) tes écrits. Confiance en le fait qu’elles soient assez respectueuses pour citer leur source.

La question qui peut se poser est celle du plagiat, quelqu’un qui viendrait s’approprier certains de mes textes en les publiant sous son nom. C’est une chose qui m’est déjà arrivée une fois et j’avoue que cela m’avait laissé une sensation assez désagréable.

Mais une personne comme l’artiste Nina Paley dit des choses très intéressantes sur les rapports entre le copyright et le plagiat. Elle considère en effet que le droit d’auteur paradoxalement favorise davantage le plagiat qu’il ne l’empêche. Elle explique également que le fait de créditer l’auteur relève en fait d’un système de régulation sociale qui n’a pas nécessairement besoin du droit pour fonctionner. Il s’agit en fait davantage de règles éthiques que des communautés se donnent. Nina Paley place d’ailleurs ses créations dans le domaine public volontaire en utilisant la non-licence Copyheart ou la CC0. Elle dit vouloir en cela faire œuvre de « non-violence légale » et je trouve que c’est un discours inspirant.

Un des pivots du libre, c’est sa viralité. On m’affirme que des processus du type la clause SA ont permis au libre de se développer tel qu’il est aujourd’hui. Pour mon compte, la SA est trop paradoxale. Je dis toujours que la première des libertés c’est de ne pas me lire. Dans la même veine, obliger les gens qui adapteront/traduiront/réécriront/diffuseront mes romans à mettre leur production sous licence libre, ça me semble créer de l’enclosure. Ce serait un peu comme forcer les gens à se vacciner au lieu de leur montrer comme on est mieux une fois bien portant… Et du coup j’aperçois que ton blog S.I.Lex n’était même pas sous clause SA ? Pourquoi ?

C’est une question intéressante et là aussi, je m’étais longuement posé la question lorsque j’avais choisi ma licence.

La clause de partage à l’identique est très importante dans beaucoup de domaines, comme celui du logiciel libre qui est fondé sur cette idée qu’il ne doit pas y avoir de possibilité de supprimer les libertés conférées à tous par la licence. Contrairement à ce que tu dis, je soutiendrais que le SA garantit au contraire qu’il ne puisse jamais y avoir d’enclosure sur une œuvre. Personne ne peut plus s’approprier de manière définitive un contenu placé sous Share-Alike. C’est pourquoi il me semble que c’est un type de licence adapté pour les biens communs que des communautés veulent protéger des risques d’enclosure. Si l’on prend le cas de Wikipédia, la licence CC-BY-SA est parfaitement adaptée, à la fois au travail collaboratif et aux réutilisations des contenus. Elle garantit que cela puisse se faire, même à titre commercial, mais sans réappropriation.

Cependant, je peux comprendre que tu ne veuilles pas placer tes écrits sous le régime du partage à l’identique, et c’est aussi la conclusion à laquelle j’étais arrivé pour S.I.Lex. Si je prends le cas des billets que reprenait OWNI par exemple, les choses auraient été trop compliquées avec une CC-BY-SA. En effet, OWNI reprenait mes billets, mais en les modifiant légèrement. Les journalistes de la plate-forme changeaient généralement le titre, ajoutaient des intertitres, inséraient des illustrations, des vidéos et parfois même des infographies. Il arrivait également que certains de mes billets soient traduits en anglais pour alimenter OWNI.eu. Tout cet apport éditorial était à mes yeux excellents, mais d’un point de vue juridique, il s’agissait d’adaptations de mes créations, ce qui aurait déclenché la clause de partage à l’identique, si j’avais choisi une CC-BY-SA. Or OWNI était sous CC-BY-NC-SA et il n’aurait pas été simple pour eux d’intégrer mes billets si je n’avais pas laissé une grande ouverture avec la CC-BY.

De plus, la CC-BY-SA n’est pas toujours simple à appliquer, comme l’avait prouvé l’affaire qui avait opposé Michel Houellebecq à Wikimedia, lorsque qu’il avait intégré dans son roman La Carte et le Territoire des extraits d’articles de Wikipédia sans mention de la source, ni crédits des auteurs.

Le domaine public et le libre ne sont pas exactement superposables. Le propre du domaine public, c’est de constituer un réservoir complètement ouvert dans lequel on peut venir puiser pour alimenter sa création sans contraintes. Les deux approches sont importantes et complémentaires.

Mais attends, de nous jours, entre les CopyrightMadness, les guerres de brevets, ceux qui s’approprient mon grain de maïs ou ton rectangle à bords arrondis… Avec tous ces abus du côté de la propriété intellectuelle et des biens communs… Y’a pas plus important ou plus urgent que de s’occuper du domaine public ?

Oui, c’est certain qu’il existe des sujets alarmants sur lesquels il devient urgent d’agir. Je ne suis pas seulement engagé pour la défense du domaine public, mais plus globalement pour la promotion des biens communs de la connaissance, ce que je fais au sein du collectif SavoirsCom1. Je milite également aux côtés de la Quadrature du Net pour la légalisation des échanges non-marchands et la mise en place de solutions de financement mutualisées pour la création, comme la contribution créative ou le revenu de base.

Néanmoins, je pense que le domaine public peut constituer un bon angle d’attaque pour s’engager dans une réforme positive de la propriété intellectuelle. On a un peu l’impression d’être aujourd’hui face à une forteresse imprenable et on n’arrive pas à sortir des débats autour de la répression du partage des œuvres, qui continuent à monopoliser l’attention du législateur comme on le voit bien avec les travaux de la mission Lescure. C’est pourquoi il me paraît intéressant d’ouvrir de nouveaux fronts qui permettront de défendre l’idée que nous possédons des droits positifs sur la culture. Le domaine public peut être une piste en ce sens et j’ai fait des propositions de réforme législative pour consacrer et renforcer cette notion dans le Code de Propriété Intellectuelle.

Par ailleurs, tu évoques le Copyright Madness, mais le domaine public pourrait aussi être un moyen de lutter contre les pires dérapages de la propriété intellectuelle. On a vu par exemple récemment des laboratoires pharmaceutiques déposer valablement des brevets en Australie sur les gènes responsables du cancer du sein, ce qui est absolument terrifiant puisque cela signifie que tout chercheur qui voudra mettre au point un remède devra leur verser des royalties. Aux États-Unis, Monsanto a relancé une offensive en justice pour empêcher des agriculteurs de replanter des semences de variétés brevetées et l’entreprise semble en passe de l’emporter. Cela peut avoir des conséquences dramatiques au niveau mondial.

Ces dérives ont un lien avec le domaine public, parce que celui-ci ne contient pas seulement les œuvres anciennes, mais aussi tout ce qui ne devrait pas pouvoir faire l’objet d’une appropriation exclusive. Cela vaut pour certains éléments de la Culture, mais aussi pour des choses aussi essentielles que le génome humain ou les semences.

Le domaine public devrait être le bouclier qui protège tous ces éléments fondamentaux de la folie de l’appropriation, mais c’est à nous de le promouvoir et de le faire vivre pour qu’il puisse remplir ce rôle.

Je crois qu’on ne peut pas trouver de meilleure conclusion ! Merci à toi, Calimaq.