L’hôte principal de ce blog, perdu quelque part entre la Grande-Bretagne et le maquis d’Hadopi, m’a demandé de venir vous faire un petit point sur les perspectives du projet Framakey sur les prochains mois (ça sortira quand ça sortira inside).

L’hôte principal de ce blog, perdu quelque part entre la Grande-Bretagne et le maquis d’Hadopi, m’a demandé de venir vous faire un petit point sur les perspectives du projet Framakey sur les prochains mois (ça sortira quand ça sortira inside).

Te voici donc, ami lecteur, devant un article plus centripète que centrifuge et avouons le sans fard, plus geek que de coutume, dont l’idée est un peu de vous dire où en est la Framakey et où elle va[1].

Historique et bilan

Mais avant de commencer, rappelons en deux mots ce qu’est la Framakey.

D’habitude, sous Windows, lorsqu’on télécharge un logiciel, il faut l’installer (mais si, on l’a tous fait un jour : cliquer sur Setup, puis Suivant, J’accepte, puis Suivant 4 fois, puis revenir en arrière pour décocher la case installer la super toolbar de-la-mort-qui-tue, puis Suivant 3 fois, et enfin le bouton Installer). Ce logiciel s’installe alors le plus souvent dans le dossier C:\Windows\Program Files\LeLogiciel mais il s’éparpille aussi souvent un peu en mettant des données dans le dossier Documents and Settings, voire dans la base de registre (une base de données propre[2] à Windows conservant les paramètres de nombreux logiciels. Or, cet éparpillement est souvent inutile, et peut ralentir Windows, qui n’a vraiment pas besoin de ça pour se trainer.

Maintenant, imaginez que vous téléchargiez le même logiciel, dans un bête fichier zip. Vous dézippez où cela vous plait, vous lancez le logiciel, et… il fonctionne! Pas d’installation, pas de Suivantx12, pas de trucs qui trainent à droite ou à gauche, pas besoin de la base de registre. Tout est dans le dossier qui a été dézippé, je vous dis.

Allons plus loin : puisque le logiciel fonctionne en vase clos, alors on peut l’utiliser depuis n’importe quel dossier. Le bureau Windows. Le dossier Mes Documents. Une clé USB. Un baladeur MP3. La carte mémoire d’un appareil photo. Un lecteur réseau. etc.

C’est ce qu’on appelle un logiciel portable. Si je met les versions portables de Firefox et d’OpenOffice.org sur une clé USB, que je met la clé USB dans ma poche et que je vais au cybercafé du coin où chez ma cousine en Irlande, il suffit que je branche ma clé USB, et je retrouverai mon Firefox (marque-pages, historique et surtout extensions compris) et mon OpenOffice.org (en français, avec mon dico perso et tout et tout). Le tout exécuté depuis la clé, sans rien copier ou installer sur la machine de ma cousine ou du cybercafé (ça marche même en Chine, c’est vous dire).

Ce concept d’applications portables a toujours existé (sous Windows comme sous GNU/Linux), mais sous Windows il s’est perdu en route ces dernières années, quand Microsoft a demandé aux développeurs de ranger les paramètres de leurs applications au même endroit[3]. Il a été remis au goût du jour il y a quelques années par un américain, John Haller, qui a depuis créé le site portableApps.com.

Et la Framakey, dans tout ça ? me demandez-vous, prêt à quitter cette page (alors qu’en réalité, je teste votre résistance au syndrome Google)

La Framakey est tout simplement la première[4] initiative de démocratisation de ce concept d’applications portables pour le grand public, en proposant en un seul téléchargement d’installer facilement sur votre clé plusieurs applications portables, le tout enrobé dans une belle interface que même Tata Jeannine arriverait à utiliser.

Sortie l’été 2005, le projet a maintenant plus de 3 ans. Étant un projet 100% libre, il a connu de très nombreuses déclinaisons, puisque comme tout projet libre, chacun est encouragé à l’adapter a ses besoins. Ainsi, on a retrouvé la Framakey (ou des forks) en langue arabe[5], diffusée à plusieurs centaines de milliers d’exemplaires auprès de lycéens parisiens, auprès d’enseignants, dans des écoles primaires, en entreprise, etc. Il paraitrait même qu’un gros-industriel-plein-de-sous vend dans toutes les bonnes crèmeries une version à peine modifiée (et obsolète) de la Framakey, mais ça ne doit pas être vrai, sinon ils auraient accepté notre proposition (gracieuse) de mise à jour, ou alors ils nous auraient fait un petit don, non ?[6]… Aujourd’hui, nous estimons le nombre de Framakey diffusé à plus de trois millions d’exemplaires. Pas mal pour un projet libre.

La Framakey c’est aussi une bien belle communauté, et en tant que mainteneur du projet depuis sa création, j’en profite ici pour remercier chaleureusement tous ceux qui nous ont apporté leur aide tout au long de cette aventure et sans qui, ce n’est pas une formule, rien n’aurait été possible. C’est aussi la preuve de la force du libre, sur le plan technique (pouvoir intégrer et remixer d’autres projets libres) comme sur le plan humain (non seulement au sein de la communauté Framakey, mais aussi des échanges permanents inter-communautés avec les communautés logicielles ou celles de portableApps, de Framasoft, Dogmazic, InLibroVeritas, etc).

La Framakey évolue lentement, il faut le reconnaitre, avec une à deux versions majeures par an. Et même si techniquement, des projets comme la Liberkey (malheureusement non libre) lui sont supérieurs, j’expliquais d’ailleurs il y a peu pourquoi nous continuons à faire évoluer la Framakey face à cette stimulante concurrence.

C’est pourquoi nous avons pensé qu’il pourrait être utile de donner quelques indications sur les actions envisagées en 2009.

Les projets en cours

La Framakey 1.9

D’abord, la branche 1.x verra apparaître une nouvelle version.

- Mise à jour de la plupart des applications, notamment OpenOffice.org en version 3.0.1

- Nouvelle interface pour le Kiosk, basée sur jQuery

- Modification de certains lanceurs pour une meilleure compatibilité avec Vista.

- Ajout de quelques applications portables

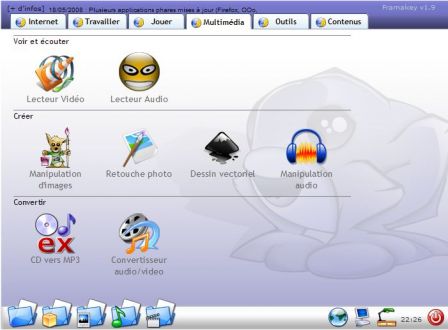

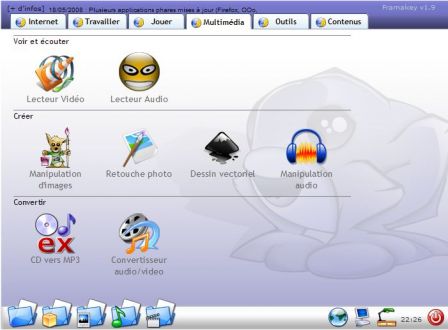

En dehors de l’interface (qui devrait furieusement vous rappeler quelque chose), il s’agit surtout de bénéficier d’une clé avec toutes les applications à jour. Par contre, côté développement, pas mal de travaux ont été effectués pour permettre une personnalisation plus aisée. En effet, nous pensons comme le rapportait l’infatigable et inénarrable Tristan N. qu’il faut aller (retourner ?) vers un monde de bricoleurs. Cela n’empêchera pas de livrer une Framakey aussi aboutie techniquement que graphiquement pour l’utilisateur final, mais cet utilisateur aura en plus la possibilité de bricoler le projet en fonction de ses besoins, un peu comme l’acheteur d’une voiture devrait pouvoir bricoler son véhicule comme il le souhaite (pour peu qu’il en ait l’envie). Bricoler sa Framakey a toujours été possible, puisqu’elle repose sur des technologies et des standards ouverts (Firefox + HTML/JS/CSS), mais pas forcément très simple d’accès. La version 1.9 est une version de transition qui apportera un peu plus de souplesse de ce côté là.

- Avancement : 90%

- Ce qu’il reste à faire : voir ici

- Date de release estimée : 4 mars 2009 13:04:12 (au moins, on ne pourra pas me reprocher d’être précis !)

Les Framakey « Spécial Edition »

Il s’agit de versions destinées à des publics particuliers ou répondant à des « univers fonctionnels » précis.

Framakey LaTeX

La Framakey LaTeX Edition a été créée pour accompagner le Framabook « Tout… sur LaTeX » de Vincent Lozano. Il s’agit d’une version largement basée (avec l’autorisation de l’auteur !) sur l’excellente USBTeX de Nicolas Poulain, à laquelle ont été ajoutée des outils pour en faciliter l’utilisation, et des logiciels libres permettant de travailler sur l’ensemble de la chaine de publication.

Il nous faut donc la mettre à jour, et corriger quelque petits bugs.

- Date de release estimée : RMLL 2009 (Juillet)

Framakey Education

Framasoft est historiquement lié au milieu de l’éducation nationale (que les profs, instits et autres personnels de l’EN lèvent le doigt. Vous voyez ? Vous êtes nombreux !).

La première adaptation de la Framakey a d’ailleurs été le projet « Clef en main » coéditée par le CRDP de Paris et Mostick. Depuis, la Framakey a inspiré de nombreux autres projets : dans le primaire, au collège/lycée, à l’université, pour les IUFM, etc. Voir des logiciels libres à portée de mains d’élèves[7] nous ravi et nous motive.

Il est aussi régulièrement question de travailler avec l’association de profs de maths SESAMATH qui sont autant des amis qu’une source d’inspiration. Le projet est pour l’instant en stand-by, mais nous ne désespérons pas d’avancer dans les mois qui viennent. De plus, laclasse et cyrille, deux gentils membres de la communauté Framakey, se sont donnés bien du mal pour portabiliser des logiciels éducatifs que vous retrouverez très bientôt sur le portail Framakey.

- Date de release estimée : fin 2009

La Framakey Jeux

Il y a une demande. On sait le faire. On peut le faire. Alors on le fera 🙂

- Date de release estimée : RMLL 2009 (Juillet)

La Framakey Handicap

Pour rencontrer régulièrement des personnes traitant du handicap et de l’accessibilité face aux logiciels (libre ou pas), nous avons décidé d’intégrer cette problématique de façon transversale en 2008 en ajoutant différents logiciels libres à tous les packs Framakey (comme une loupe ou un lecteur d’écran). Après en avoir discuté avec des professionnels du métier, nous pensons pouvoir travailler avec eux pour les aider à concevoir le contenu d’une clé spécifique.

- Date de release estimée : 2009 (Stéphanie, si tu me lis…)

La FramaGNU

Ahhhhh. Si Framasoft avait touché 1€ à chaque fois qu’on nous posait la question « La Framakey, elle marche sous linux ? », nous n’aurions même pas besoin de lancer (très bientôt) une campagne de soutien à Framasoft !

Ahhhhh. Si Framasoft avait touché 1€ à chaque fois qu’on nous posait la question « La Framakey, elle marche sous linux ? », nous n’aurions même pas besoin de lancer (très bientôt) une campagne de soutien à Framasoft !

Jusqu’ici la réponse était « La Framakey fonctionne avec Wine. On peut aussi y faire tourner des distributions légères comme SLAX ou ToutouLinux en émulation. Mais on ne fera probablement jamais de clé bootable, car 1) ça prends beaucoup de place 2) les applications sur la Framakey sont déjà presque toutes présentes dans n’importe quelle distrib, et 3) booter sur une clé, Tata Jeannine elle va galérer comme une maman ourse. »

Mais il n’y a que les imbéciles (et les développeurs JSP) qui ne changent pas d’avis, et comme on n’a pas envie d’en faire partie, on va faire un peu de teasing :

- Oui, il y aura bientôt une Framakey incluant un système GNU/Linux bootable.

- Oui, ce système aura un disque persistant (= les documents et les applications ajoutés sous Linux resteront sur la clé, contrairement aux LiveCD/LiveUSB)

- Oui, il y aura des liaisons entre les deux systèmes (= je suis avec portableThunderbird sous Windows, je relève mes mails. Je reboote sous Linux, j’ouvre Thunderbird, je retrouve ces mêmes mails).

- Oui, a priori ce système sera… Ubuntu

Houla, j’en vois qui s’énervent déjà à lire le dernier point : « Encore du Ubuntu ! Pourquoi pas (Mandriva\Fedora\Hurd.*) ? » toussatoussa.

D’abord, rappelons que Framasoft – et donc la Framakey – vise le plus large public et que, sans aucunement préjuger de qualité techniques d’une distrib, l’expérience (tout a fait subjective, mais tout à fait assumée) nous a montré que des utilisateurs comme Tata Jeannine avaient de meilleurs retours sur la communauté Ubuntu-fr qu’ailleurs.

Ensuite, rappelons que la Framakey est volontairement hackable by design et 100% libre, donc aide toi et le GNU/RTFM t’aidera.

De plus, nous avons d’excellentes relations avec la communauté Ubuntu-fr, qu’on a connu à l’époque où ils étaient, oh pas plus haut que ça, alors que maintenant même le géant vert à l’air d’un nain à côté d’eux (il n’y a bien que Chuck Norris qui puisse encore leur faire de l’ombre). Je vous avais prévenu, c’est subjectif comme point de vue.

Enfin, pour ceux qui répondraient qu’on entretient un système, blablabla, je répondrai qu’on a déjà commencé à travailler sur un outil qui permettrait de choisir sa distribution avant l’installation. Un mix entre UnetBootin (pour le choix des ditribs) et Fedora LUC pour la possibilité de créer un disque persistant. Elle est pas belle la vie[8] ?

- Avancement : une version alpha de chez alpha, disponible pour les windowsiens existe déjà, mais c’est tellement alpha que je n’ose vous livrer de lien[9]

Date de release estimée : RMLL 2009 (Juillet) (dépendra en partie de la communauté Ubuntu-fr. C’est pas parce que ce sont des amis qu’on ne va pas leur mettre la pression 😛 )

Le retour de la version Light

On nous a souvent reproché le fait d’avoir abandonné la version Light (pour les clés de 256Mo). C’était tout simplement trop lourd de maintenir 2 packages. Grâce aux outils dont je vous parlais plus haut, développés pour la Framakey 1.9, la version light fera son retour. N’espérez pas y trouver OpenOffice.org, celui-ci a pris beaucoup d’embonpoint, et son transfert sur clé peut prendre plusieurs heures sur des clés de mauvaises qualité.

- Date de release estimée : fin mars 2009.

La Framakey Megapack

Tata Jeannine, quand elle achète un ordinateur, elle a de fortes probabilités de se retrouver avec du Windows inside (c’est le problème de la vente liée, mais je préfère ne pas l’évoquer aujourd’hui, sous peine de cumuler ça à l’exaspération générée par Hadopi). En plus, elle a plein de logiciels, dont la plupart lui diront au bout de trente jours qu’elle doit leur donner son numéro de carte bleue, sinon, ils se mettront en grève.

Par contre, elle n’a aucun logiciel libre. Alors que pour pas un rond, ils feraient tout aussi bien le travail et, accessoirement mais pas trop, lui redonnerait une prise directe et citoyenne sur sa vie numérique.

Alors, si Tata elle téléchargeait la Framakey Megapack, en 3 clics et le temps d’un épisode de Derrick, elle se retrouverait avec 60 applications libres sur son disque dur, le menu Démarrer qui va bien et tout et tout. Et même, on lui expliquerait en quoi Firefox (yeepa !) c’est plus mieux qu’Internet Explorer (bweark !), le tout avec un peu de musique libre pour bercer ces oreilles.

- Date de release estimée : RMLL 2009 (Juillet)

D’autres éditions en perpective

Tout est possible, mais le temps n’étant pas extensible, voilà déjà un planning bien chargé. Évidemment, les idées sont les bienvenues…

Les « Framakey webapps »

De plus en plus d’applications qu’on utilise sont des applications web. D’ailleurs, je ne vous ai pas dit que Tata Jeannine utilisait (l’excellent) Dotclear pour raconter la vie de Puffy, son caniche nain ?

De plus en plus d’applications qu’on utilise sont des applications web. D’ailleurs, je ne vous ai pas dit que Tata Jeannine utilisait (l’excellent) Dotclear pour raconter la vie de Puffy, son caniche nain ?

Le souci, c’est que les applications web, on aime bien les tester avant, et que c’est souvent compliqué de mettre en place un système Apache/PHP/MySQL, puis d’y installer l’appli en configurant la base et tout et tout.

Alors l’idée serait donc de proposer des applis web portables pour Windows. Par exemple : PortableDotclear.zip, je dézippe, je lance PortableDotclear.exe, et hop, me voilà avec un dotclear directement utilisable.

Portable(Drupal|wordpress|joomla|mediawiki|dokuwiki|alfresco|sugarCRM|.*), c’est possible !

D’ailleurs, Bitnami le propose déjà. Mais 1) c’est pas 100% libre, et 2) ça n’est pas portable (installation de services windows).

Éventuellement, imaginez-le couplé avec Mozilla Prism, et ça peut donner un truc vraiment sympa, non ? (Évidemment, dans les endroits hyper-connectés, l’intérêt peut être limité, mais puisqu’on veut mettre vos sites sur liste blanche…)

- Avancement : 30%

- Dates de release estimée : 5 à 6 paquets pour les RMLL 2009 (Juillet)

Les projets à venir

La Framakey Mac

Évidemment, il n’y a pas que Windows dans la vie, il y a Mac aussi[10].

– « Et pourquoi pas une Framakey pour les Mac ? »

Il y a une demande. On sait le faire. Mais on ne peut pas le faire…

C’est tout bête, mais on n’a pas de Mac, chez Framasoft (notez qu’on m’en a prêté un, une fois, j’ai trouvé que ça ressemblait furieusement à une Fedora[11]). L’appel au don[12] est ouvert. Par contre, c’est pas pour faire mon difficile, mais s’il pouvait être 1) récent et 2) portable ou mini, ça m’arrangerait pour préserver la paix de mon ménage qui commence à trouver que le bureau ressemble furieusement à la salle des machines de Star Treck IV.

- Date de release estimée : pas de Mac, pas de Framakey Mac.

La Framakey 2

Ah, la Framakey 2, alias Winaptic, alias « ça sortira… un jour… peut être »… Tous les libristes m’ayant croisé ces 3 dernières années ont dû repartir avec un bon mal de crâne, tellement je les ai saoulé avec ce projet (les Kazé, Paul, Sonny, et j’en passe). Le principe, c’est tout simplement un Synaptic pour Windows. Avec pour système de paquets, le … .zip (volontairement, on ne gère pas de dépendances, tout étant dans le zip). Là encore, un des problèmes de Tata Jeannine, c’est qu’elle n’a jamais entendu parler de Firefox (la pauvre) ou d’Audacity, ou d’InfraRecorder. Pourtant, ça lui serait bien utile.

Elle télécharge donc la Framakey 2 (10Mo) sur son disque dur (interne ou externe) ou sa clé USB, l’exécute et là on lui demande de quoi elle a besoin. « Un navigateur web ? Mais bien sûr qu’on a cela, je vous propose de télécharger Firefox en cochant la case à côté. Ah, et un logiciel pour enregistrer vos vinyls ? bien entendu, cochez donc Audacity. Ca sera tout ? Bien. Tant que vous êtes là, je vous signale que l’application CoolPlayer que vous aviez téléchargée existe dans une version plus récente. Souhaitez vous la mettre à jour ? Parfait. Maintenant, cliquez donc sur Télécharger et installer et allez donc regarder la fin de Derrick pendant que je travaille. »

Bref, une Framakey sur mesure.

Dans mes rêves les plus fous, elle était faite en XUL, la technologie qui motorise Firefox. D’ailleurs, entre télécharger une extension et une application, il n’y a qu’un pas…(je laisse les développeurs XUL méditer cette phrase). Mais mes rêves les plus fous… Enfin bref, une version alpha est disponible depuis plusieurs mois. Mais elle est boguée et pas très à jour… Elle repose sur aSuite pour le lanceur, et AppSnap pour le gestionnaire d’applications, avec une glue maison pour faire tourner tout ça. Grâce à Mouss (de la communauté Framakey), on a pu faire le gros des adaptations nécessaires, mais il reste encore pas mal de bugs…

Vous pouvez d’ailleurs en voir une ancienne vidéo (ça commence en gros à la moitié) :

—> La vidéo au format webm

- Avancement : 50%

- Date de release estimée : 2009 si tout va bien… et on ne rigole pas au fond de la salle…

Pendant ce temps là, à Vera Cruz

La roadmap serait incomplète sans parler :

- du portail d’applications portables, qu’il faut maintenir à jour (sans parler des nouvelles applications qui y seront ajoutées sous peu),

- du rapprochement en cours avec la communauté PortableApps.com (même si je suis critique sur leur système de packaging et description d’applications, ils sont infiniment plus gros que Framakey, et nous avons donc tout intérêt à coller à leurs normes),

- du site web Framakey, qui sera probablement refondu dans l’année,

- du projet, récurrent, de monter une petite boutique en ligne où vous pourriez acheter des clés de qualité à prix modique, avec la Framakey de votre choix préchargée (donc, plus la peine d’enchainer Les feux de l’amour, Derrick et Arabesque, que tous les fichiers soient copiés).

Voilà, c’était un rapide (!) tour d’horizon de « où en est Framakey, et où va-t-elle ? ». Félicitations à ceux qui auront réussi à lire jusqu’ici !

Si vous le souhaitez, et si l’hôte de ce blog en est d’accord, je reviendrais régulièrement vous donner des nouvelles de l’avancement de ces différents projets.

A moins que ça ne soit pour vous parler du FramaDVD… Mais chut, je ne vous en dis pas plus…

« Nous sommes tous des juifs allemands » est l’une des citations célèbres de mai 68, proclamée par la jeunesse en signe de solidarité à Daniel Cohn-Bendit, alors interdit de séjour en France.

« Nous sommes tous des juifs allemands » est l’une des citations célèbres de mai 68, proclamée par la jeunesse en signe de solidarité à Daniel Cohn-Bendit, alors interdit de séjour en France. Le titre de ce billet est une suggestion et non une injonction. Il invite les étudiants à considérer la

Le titre de ce billet est une suggestion et non une injonction. Il invite les étudiants à considérer la

Je viens de parcourir un article extrêmement critique vis-à-vis de la

Je viens de parcourir un article extrêmement critique vis-à-vis de la  L’hôte principal de ce blog, perdu quelque part entre la

L’hôte principal de ce blog, perdu quelque part entre la

Ahhhhh. Si Framasoft avait touché 1€ à chaque fois qu’on nous posait la question « La Framakey, elle marche sous linux ? », nous n’aurions même pas besoin de lancer (très bientôt) une campagne de soutien à Framasoft !

Ahhhhh. Si Framasoft avait touché 1€ à chaque fois qu’on nous posait la question « La Framakey, elle marche sous linux ? », nous n’aurions même pas besoin de lancer (très bientôt) une campagne de soutien à Framasoft ! De plus en plus d’applications qu’on utilise sont des applications web. D’ailleurs, je ne vous ai pas dit que Tata Jeannine utilisait (l’excellent)

De plus en plus d’applications qu’on utilise sont des applications web. D’ailleurs, je ne vous ai pas dit que Tata Jeannine utilisait (l’excellent)

Il n’y a pas que les « anarchistes du Net » et les « hacktivistes libristes » qui sont contre le projet de loi Internet et Création. Il y a aussi des « gens très sérieux » qui réfléchissent depuis longtemps à toutes ces questions.

Il n’y a pas que les « anarchistes du Net » et les « hacktivistes libristes » qui sont contre le projet de loi Internet et Création. Il y a aussi des « gens très sérieux » qui réfléchissent depuis longtemps à toutes ces questions.