Un autre monde musical est possible nous dit Trent Reznor

On peut voir le document que nous vous présentons aujourd’hui comme la majeure contribution du Framablog au débat actuel sur le trop fameux projet de loi « Création et Internet », qui porte si mal son nom. Nous sommes en effet fiers de vous proposer la traduction (sous-titrage et transcription écrite ci-dessous) d’une conférence qui apporte comme un grand bol d’oxygène à la période tendue et crispée que nous sommes en train de traverser.

Oui, avec du talent et de l’imagination, on peut (économiquement) réussir dans la musique en dehors des circuits traditionnels (comprendre avant tout les Majors du disque) en utilisant à plein les extraordinaires potentialités d’Internet pour se mettre directement en relation avec son public.

C’est ce que démontre le parcours de l’artiste Trent Reznor, chanteur des Nine Inch Nails, brillamment analysé ici par Mike Masnick, dont le blog décrypte les tendances des nouveaux médias sociaux.

Cette conférence d’une quinzaine de minutes a été donnée en janvier dernier au MIDEM 2009 de Cannes. L’étrange équation énoncée, « CwF + RtB = $$$ », tient de la formule magique mais elle est pourtant simple à comprendre pourvu qu’on accepte la nouvelle donne et surtout les nouvelles règles du jeu.

N’ayez pas peur, disait l’autre. Nous ne sommes plus ici dans le monde des « pirates » à éradiquer mais dans celui, passionnant, de ceux qui ouvrent la voie d’un nouveau paradigme…

—> La vidéo au format webm

Trent Reznor et l’équation pour de futurs modèles économiques de la musique

Trent Reznor And The Formula For Future Music Business Models

Mike Masnick – 17 janvier 2008 – TechDirt

(Traduction Framalang : Don Rico, Joan, Yostral)

Je suis Mike Masnick, mon entreprise s’appelle Floor64. Voici notre site web : nous avons diverses activités, travaillons avec différentes entreprises, les aidons à comprendre les tendances des nouveaux médias sociaux et à établir un lien avec les communautés auxquelles elles s’adressent.

On me connaît surtout, quand on me connaît, pour TechDirt, le blog que nous publions sur Floor64. Voilà à quoi ça ressemble. Sur ce blog, j’aborde très souvent le sujet de l’industrie musicale et de l’industrie du disque, et j’ai notamment beaucoup écrit sur les initiatives de Trent Reznor et les modèles économiques qu’il applique et expérimente depuis quelque temps. Ces billets sont bien sûr à l’origine de cette intervention : « Pourquoi Trent Reznor et Nine Inch Nails représentent l’avenir de l’industrie musicale ».

Nous sommes un peu en retard car nous devions commencer à 11h45. Chez moi, en Californie, il est 2h45 du matin. Je souffre du décalage horaire, comme d’autres ici je pense, alors pour qu’on reste éveillés, je vais faire défiler que 280 diapos au cours de cette intervention, car je pense qu’en gardant un rythme soutenu on ne s’endormira pas trop vite. Mais pendant ces 280 diapos je vais quand même aborder quelques points importants sur les actions de Trent Reznor et expliquer pourquoi les modèles économiques qu’il expérimente représentent vraiment l’avenir de la musique.

Sans plus attendre, rentrons dans le vif du sujet.

Chapitre 1

Que ce soit volontaire ou pas, je n’en sais d’ailleurs rien, il semblerait que Trent Reznor ait découvert le secret d’un modèle économique efficace pour la musique. Ça commence par quelque chose de très simple : CwF, qui signifie « Créer un lien avec les fans ». Ajoutez-y une pincée de RtB : « Une Raison d’acheter ». Associez les deux, et vous obtenez un modèle économique. Ça parait très simple, et beaucoup pensent que ça n’a rien de sorcier. Mais le plus stupéfiant, c’est la difficulté qu’ont d’autres à combiner ces deux ingrédients afin de gagner de l’argent, alors que Trent Reznor, lui, s’en est sorti à merveille, à de nombreuses reprises, et de nombreuses façons.

Tout a commencé quand il était encore signé chez une major. Il a appliqué ce modèle de façon très intéressante sur l’album Year Zero, en 2007. Avant la sortie de l’album, il a établi un lien avec ses fans en organisant une sorte de chasse au trésor, ou un jeu de réalité virtuelle. Voici le dos du t-shirt qu’il portait pendant la tournée de 2007. Certaines lettres des noms de ville sont en surbrillance : en les isolant puis en les remettant dans l’ordre, on obtient la phrase « I am trying to believe ». Certains ont été assez futés pour assembler la phrase et y ajouter un « point com ». Puis ils sont allés sur le site « Iamtryingtobelieve.com » et se sont retrouvés dans un jeu de réalité virtuelle, qui était assez marrant. Voici qui a apporté un gros plus à l’expérience générale pour les fans et permis d’établir avec eux un lien qui allait au-delà de la seule musique.

Du coup, les fans étaient plus impliqués, motivés et impatients. Il est allé plus loin encore : vous approuverez ou pas, tout dépend de l’endroit où vous êtes assis dans la salle. Ça a mis en rogne la maison de disque de Reznor, parce qu’il s’est amusé à mettre de nouveaux morceaux sur des clés USB qu’il abandonnait ensuite par-terre dans les toilettes à chaque concert qu’il donnait. Les fans trouvaient ces clés USB dans les différentes salles de concert, les ramenaient chez eux, les branchaient sur leur ordinateur et y trouvaient de nouveaux morceaux de Nine Inch Nails, et bien sûr ils les partageaient.

De cette façon, le groupe a impliqué les fans, les a motivés et les a mis dans tous leurs états. Les seuls à ne pas avoir été ravis, c’était la RIAA, qui a envoyé des messages d’avertissement pour de la musique que Trent Reznor lui-même distribuait gratis. Ça, ce n’est pas un moyen d’établir un lien avec les fans, mais plutôt de se les mettre à dos.

Trent Reznor continuait donc à donner aux gens des raisons d’acheter alors qu’il refilait lui-même sa musique. Quand l’album est sorti, le CD changeait de couleur. On le mettait dans le lecteur, et en chauffant la couleur du disque changeait. C’est gadget, mais c’était assez sympa et ça donnait aux fans une raison d’acheter le CD, parce qu’on ne peut pas reproduire ça avec un MP3.

C’était un exemple simple datant de l’époque où il était encore sous contrat avec une major, mais passons au…

Chapitre 2

Après cet album, il n’avait plus de maison de disque, et a préféré voler de ses propres ailes, s’aventurant alors sur les terres soi-disant dévastées de l’industrie musicale d’aujourd’hui. Pourtant ça ne lui a pas posé problème, car il savait qu’en créant un lien avec les fans et en leur donnant une raison d’acheter il pouvait créer un modèle économique efficace. Il a donc commencé par l’album Ghosts I-IV, et il a créé des liens avec ses fans en leur offrant plusieurs choix, au lieu d’essayer de leur imposer une façon unique d’interagir avec sa musique. On avait différentes options, et il leur a donné une raison d’acheter en proposant une offre améliorée.

Je vais rapidement énumérer ces options. À la base, il y avait un téléchargement gratuit. L’album comptait 36 morceaux. On pouvait télécharger gratuitement les 9 premiers, et les 36 étaient sous licence Creative Commons, donc il était possible de les partager légalement. Bref, quand on voulait les télécharger gratuitement sur le site de NIN, on n’avait que les neuf premiers. Pour 5 dollars, on recevait les 36 morceaux et un fichier PDF de 40 pages. 5$ pour 36 morceaux, c’est beaucoup moins cher que le modèle d’iTunes à 1$ par chanson. Pour 10$, vous receviez une boîte avec deux CDs et un livret de 16 pages. 10 $ pour une boîte de 2 Cds, c’est pas mal. Mais ça, beaucoup d’autres le font, tout le monde applique ce principe de musique offerte et de vente de CDs à prix raisonnable sur le site.

Ce qui est intéressant, c’est ce qu’il a proposé en plus. Là, on commence par un coffret édition deluxe à 75 dollars, qui contenait tout un tas de choses. C’était une sorte de coffret, mais centré sur ce seul album et qui contenait un dvd et un disque blu-ray, un beau livret, le tout fourni dans une boîte sympa. 75$, bonne affaire pour des fans qui veulent vraiment soutenir Reznor. Mais le plus intéressant, c’était le coffret ultra deluxe édition limitée à 300 $.

Comme on le voit sur ce site, tous ont été vendus. Il y a tout un tas de suppléments dans ce coffret. Voici à quoi ça ressemblait.

Là encore, on trouve le contenu du coffret de base, plus d’autres trucs. Mais ce qui est vraiment important, c’est qu’il n’a été tiré qu’à 2500 exemplaires, et que tous étaient dédicacés par Trent Reznor. Le tout coûtait 300$, mais c’était exceptionnel, unique, et ça ajoutait de la valeur à la musique. Les 2500 ont été vendus, ce qui n’a rien d’étonnant. Mais ce qui est impressionnant, c’est la vitesse à laquelle ils sont partis. Moins de 30 heures. Faites le calcul : ça donne 750 000 dollars en 30 heures pour de la musique qu’il donnait gratuitement.

Rien que la première semaine, si l’on inclut les autres offres, ils ont encaissé 1,6 million de dollars, là encore pour de la musique qu’ils distribuaient gratuitement, sans label, mais c’était vraiment une façon de créer un lien avec les fans, de leur donner une raison d’acheter, et de trouver un modèle économique efficace. Même si c’était gratuit et qu’on pouvait tout télécharger légalement une fois les morceaux mis en ligne sur des sites de Torrent ou de partage de fichiers, voici ce qu’a publié Amazon la semaine dernière : la liste de leurs meilleures ventes d’albums au téléchargement en 2008, où Ghosts I-IV arrive en tête.

Donc, voici un album gratuit qui en une seule semaine a rapporté 1,6 million de dollars, et qui a continué à bien se vendre sur Amazon tout le reste de l’année. On se rend bien compte qu’ici, la question ce n’est pas le prix. Le fait que l’album soit disponible gratuitement ne signifie pas la fin du modèle économique, il n’y a pas lieu de s’inquiéter. Tant que l’on crée un lien avec les fans et qu’on leur donne une raison d’acheter, il y a de l’argent à se faire.

Chapitre 3

Dans cette série d’expériences, deux mois seulement après Ghosts I-IV est sorti The Slip, et cette fois-ci c’était complètement gratuit, il suffisait de donner son adresse e-mail et on pouvait le télécharger en entier. Un lien de plus avec les fans. Les téléchargements étaient de qualité, on avait le choix entre des versions MP3 ou lossless. Pas du tout le principe « on vous file gratis la version merdique, passez à la caisse pour une meilleure version ». Encore une fois, il a essayé d’innover pour créer un lien plus fort avec les fans.

Voici les données de TopSpin, qui fournissait l’infrastructure pour les téléchargements, et qui a créé ces cartes sympas sur Google Earth pour qu’on voit d’où tous les autres téléchargeaient. Pas forcément utile, mais c’était chouette, et ça contribuait à construire la communauté, à créer un lien avec les fans. En parallèle, le jour de la sortie de The Slip, ils ont publié la liste des concerts pour la tournée 2008. On pouvait donc télécharger la musique, l’écouter, et aussitôt acheter des places.

Bien entendu, Reznor et NIN on toujours veillé à ce qu’il y ait une raison d’acheter des billets : ils ne donnent pas de simples concerts, mais offrent un spectacle complet. Ils jouaient devant un grand écran et amenaient plein d’idées afin d’en faire une expérience passionnante pour les fans, et les fans en redemandent. Ils sont emballés à l’idée d’aller à ces concerts, et pas seulement parce qu’ils vont voir Trent Reznor jouer. Bien sûr, Reznor n’en faisait pas profiter que NIN. Il y avait des premières parties sur la tournée, et il a enregistré un disque samplé, téléchargeable gratuitement lui aussi, avec des fichiers de bonne qualité de morceaux des différents groupes qui jouaient en première partie, permettant ainsi aux fans de créer un lien et leur donnant des raisons d’acheter des places de concerts pour aller voir ces groupes s’ils leur plaisaient.

Là encore, même si l’album était gratuit, il a donné d’autres raisons d’acheter en pressant l’album sur CD et vinyl, avec un tas de contenu supplémentaire dans une édition limitée et numérotée. On en revient au procédé de Ghosts I-IV, avec des tas de suppléments. J’insiste sur ce point parce que c’est vraiment important.

Chapitre 4

On n’a parlé que de sortie d’album, mais ces règles ne s’appliquent pas seulement quand on sort un album. Il faut créer un lien avec les fans tout le temps, sans discontinuer. Voici le site Web de Reznor, où il a mis en place des tas d’idées intéressantes, et je vais passer vite dessus parce qu’il y a beaucoup de choses, mais le lien se crée en permanence. Quand on se connecte, on voit les nouveautés, et puis on trouve les fonctions habituelles : de la musique à écouter, des outils communautaires comme les forums, les tchats. Mais il y a aussi des éléments moins évidents. Par exemple ce flux de photos, qui proviennent de Flickr. Ces photos ne sont pas toutes des clichés du groupe prises par des pros, mais ceux que les fans mettent sur Flickr sont regroupés sur le site. Ainsi on peut voir ce que les autres voyaient aux concerts où vous êtes allés, ou à ceux que vous avez manqué.

Il offre aussi des fonds d’écran que l’on peut télécharger, sous licence Creative Commons. On peut les retoucher, et d’ailleurs vous remarquerez que les images d’illustration que j’utilise sont justement tirées de ces fonds d’écran, légèrement modifiés pour que ça rentre sur les diapos. Dans le même esprit que les photos Flickr, il y a les vidéos. En gros, les fans filment des vidéos avec leur téléphone mobile, les mettent en ligne sur YouTube, et elles sont toutes regroupées sur le site. Pas de problème de procès, pas d’avertissements, pas de réclamations de la part de YouTube, les vidéos servent juste à créer du lien avec les fans, à leur donner une raison d’acheter.

Sur le site, on peut aussi télécharger des fichiers bruts, et NIN encourage les fans à les remixer, à les écouter, à les noter, à les échanger, ce qui implique vraiment les fans.

Autres idées amusantes : des concours, par exemple des tickets cachés qu’il faut trouver sur le site, des coordonnées indiquant l’emplacement de places gratuites pour un concert que NIN donnait dans un tunnel d’égout à Los Angeles. Il a mis sur son site une enquête de 10 pages à remplir, ce qui a permis d’élaborer un profil complet de ses fans. Mais le plus intéressant, c’est le courriel qu’il a envoyé, assez long comme vous le voyez, qui a montré que Reznor est proche de ses fans, ce qui hélas est rare dans l’industrie musicale.

À suivre

Passons au dernier chapitre. Je l’intitule « À suivre » plutôt que « Dernier chapitre », parce que c’est loin d’être fini. Reznor continue en permanence à expérimenter de nouvelles idées. Pas plus tard que la semaine dernière, j’ai dû compléter cette intervention, en espérant qu’il allait calmer le rythme de ses expérimentations, parce que ça commençait à être dur de maintenir cette présentation à jour. Il a publié un billet sur son blog expliquant sur le ton de la plaisanterie avoir été contacté par un mystérieux groupe d’agitateurs qui avaient filmé trois concerts et mis en ligne les rushes, des rushes en haute définition. Il y en a pour 450 gigas de rushes. La plupart des disques durs n’ont pas une telle capacité, et ça m’étonnerait que beaucoup d’entre vous ici aient 450 Go sur votre portable. Et puis il y a les fournisseurs comme ComCast qui limitent la bande passante à 250 Go par mois, voire TimeWarner qui descend encore plus bas, à 5 Go par mois. Et voilà Reznor qui refile 450 Go de vidéo HD et déclare : « Je suis sûr que des fans entreprenants vont nous mitonner un truc sympa ». Ça c’est vraiment un super moyen de créer le lien avec les fans, de leur donner une raison d’acheter, et c’est ce qui donne le modèle économique.

On peut voir ça sous un autre angle : au lieu de signifier Connect with Fans, CtW pourrait être l’acronyme de Compete With Free (NdT : le Gratuit Compétitif) et Rtb, au lieu de Reason to Buy, peut être l’abréviation de Retour au Business. Au lieu de se plaindre sans cesse du piratage et de diaboliser les nouvelles technologies, il vaut mieux s’efforcer de trouver un modèle économique qui fonctionne.

Ce qu’il faut retenir, c’est que ça fonctionne pour de bon, sans qu’il y ait besoin de recourir aux licences collectives, aux DRM ou aux procès. Techniquement parlant, et c’est ce qui agace certains, il n’y a pas besoin de recourir aux droits d’auteur pour que ça marche: il suffit de créer le lien avec les fans et de leur donner une raison d’acheter.

Ce qu’il faut retenir aussi, c’est que ça vaut pour tous les musiciens, connus ou moins connus. Je me suis concentré sur Reznor, parce que c’est le sujet de mon intervention, mais des tas de petits groupes appliquent ce même modèle. En gros, Reznor ne fait qu’ouvrir la voie pour des tas d’autres et permettre que ça fonctionne. Quant aux autres, ils ne plagient pas, ils ne se contentent pas de copier les idées de Reznor. Ils partent de la recette de départ pour l’adapter à leur façon, et ça fonctionne aussi pour eux sans qu’ils aient à se soucier des licences, des DRM ou des procès. Pas de problème de copyright. Ils ne leur reste qu’à se concentrer sur l’avenir, sur la musique, et à inventer les modèles économiques qui fonctionnent de nos jours.

Voilà, j’ai expliqué dans cette intervention pourquoi Trent Reznor et NIN représentent l’avenir de l’industrie musicale. Si vous souhaitez me contacter, voici mes deux adresses e-mail.

Merci.

L’hôte principal de ce blog, perdu quelque part entre la

L’hôte principal de ce blog, perdu quelque part entre la

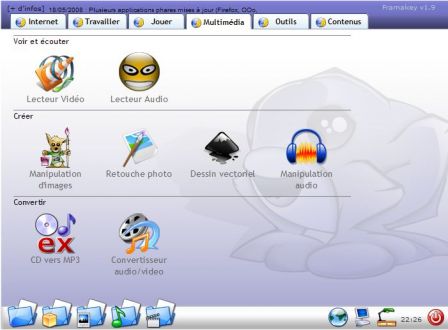

Ahhhhh. Si Framasoft avait touché 1€ à chaque fois qu’on nous posait la question « La Framakey, elle marche sous linux ? », nous n’aurions même pas besoin de lancer (très bientôt) une campagne de soutien à Framasoft !

Ahhhhh. Si Framasoft avait touché 1€ à chaque fois qu’on nous posait la question « La Framakey, elle marche sous linux ? », nous n’aurions même pas besoin de lancer (très bientôt) une campagne de soutien à Framasoft ! De plus en plus d’applications qu’on utilise sont des applications web. D’ailleurs, je ne vous ai pas dit que Tata Jeannine utilisait (l’excellent)

De plus en plus d’applications qu’on utilise sont des applications web. D’ailleurs, je ne vous ai pas dit que Tata Jeannine utilisait (l’excellent)

Dites, vous n’avez pas mieux à faire que de venir fouiner par ici ? En plus c’est

Dites, vous n’avez pas mieux à faire que de venir fouiner par ici ? En plus c’est