Un autre monde est possible selon André Gorz (et le logiciel libre)

Avant de se donner la mort en septembre 2007, le philosophe et journaliste André Gorz a transmis un dernier texte à la revue EcoRev’, qu’il avait parrainée lors de sa création, intitulé « La sortie du capitalisme a déjà commencé ».

Avant de se donner la mort en septembre 2007, le philosophe et journaliste André Gorz a transmis un dernier texte à la revue EcoRev’, qu’il avait parrainée lors de sa création, intitulé « La sortie du capitalisme a déjà commencé ».

Nous le reproduisons ici pour alimenter le débat, en rappelant que le sous-titre de ce blog stipule que « ce serait l’une des plus grandes opportunités manquées de notre époque si le logiciel libre ne libérait rien d’autre que du code ». Ce texte ayant fait l’objet d’une version remaniée, nous avons choisi de mettre en ligne l’un après l’autre les deux articles, qui bien que très proches, offrent tout de même d’intéressantes nuances.

Extrait de la version remaniée :

Ce qui importe pour le moment, c’est que la principale force productive et la principale source de rentes tombent progressivement dans le domaine public et tendent vers la gratuité ; que la propriété privée des moyens de production et donc le monopole de l’offre deviennent progressivement impossibles ; que par conséquent l’emprise du capital sur la consommation se relâche et que celle-ci peut tendre à s’émanciper de l’offre marchande. Il s’agit là d’une rupture qui mine le capitalisme à sa base. La lutte engagée entre les logiciels propriétaires et les logiciels libres (libre, free, est aussi l’équivalent anglais de gratuit) a été le coup d’envoi du conflit central de l’époque. Il s’étend et se prolonge dans la lutte contre la marchandisation de richesses premières – la terre, les semences, le génome, les biens culturels, les savoirs et compétences communs, constitutifs de la culture du quotidien et qui sont les préalables de l’existence d’une société. De la tournure que prendra cette lutte dépend la forme civilisée ou barbare que prendra la sortie du capitalisme.

Cette sortie implique nécessairement que nous nous émanciperons de l’emprise qu’exerce le capital sur la consommation et de son monopole des moyens de production. Elle signifie l’unité rétablie du sujet de la production et du sujet de la consommation et donc l’autonomie retrouvée dans la définition de nos besoins et de leur mode de satisfaction. L’obstacle insurmontable que le capitalisme avait dressé sur cette voie était la nature même des moyens de production qu’il avait mis en place : ils constituait une mégamachine dont tous étaient les serviteurs et qui nous dictait les fins à poursuivre et la vie a mener. Cette période tire à sa fin. Les moyens d’autoproduction high-tech rendent la mégamachine industrielle virtuellement obsolète. Claudio Prado invoque l’appropriation des technologies parce que la clé commune de toutes, l’informatique, est appropriable par tous. Parce que, comme le demandait Ivan Illich, chacun peut l’utiliser sans difficulté aussi souvent ou aussi rarement qu’il le désire… sans que l’usage qu’il en fait empiète sur le liberté d’autrui d’en faire autant ; et parce que cet usage (il s’agit de la définition illichienne des outils conviviaux) stimule l’accomplissement personnel et élargit l’autonomie de tous. La définition que Pekka Himanen donne de l’Ethique Hacker est très voisine : un mode de vie qui met au premier rang les joies de l’amitié, de l’amour, de la libre coopération et de la créativité personnelle.

Extrait de la version originale :

Pourtant une tout autre voie de sortie s’ébauche. Elle mène à l’extinction du marché et du salariat par l’essor de l’autoproduction, de la mise en commun et de la gratuité. On trouve les explorateurs et éclaireurs de cette voie dans le mouvement des logiciels libres, du réseau libre, de la culture libre qui, avec la licence CC (creative commons) rend libre (et libre : free signifie, en anglais, à la fois librement accessible et utilisable par tous, et gratuit) de l’ensemble des biens culturels – connaissances, logiciels, textes, musique, films etc. – reproductibles en un nombre illimité de copies pour un coût négligeable. Le pas suivant serait logiquement la production « libre » de toute le vie sociale, en commençant par soustraire au capitalisme certaines branches de produits susceptibles d’être autoproduits localement par des coopératives communales.

Ce genre de soustraction à la sphère marchande s’étend pour les biens culturels où elle a été baptisée « out-cooperating », un exemple classique étant Wikipedia qui est en train d’« out-cooperate » l’Encyclopedia Britannica. L’extension de ce modèle aux biens matériels est rendue de plus en plus faisable grâce à le baisse du coût des moyens de production et à la diffusion des savoirs techniques requis pour leur utilisation. La diffusion des compétences informatiques, qui font partie de la « culture du quotidien » sans avoir à être enseignés, est un exemple parmi d’autres. L’invention fabbers, aussi appelés digital fabicators ou factories in a box – il s’agit d’une sorte d’ateliers flexibles transportables et installables n’importe où – ouvre à l’autoproduction locale des possibilités pratiquement illimitées.

Un texte qui pour certains a valeur de référence et que nous souhaitions vous faire partager.

Non seulement André Gorz[1] y annonce par anticipation la crise que nous vivons actuellement (et peut-être aussi les logiques sous-jacentes à la loi Hadopi) mais il nous propose également quelques pistes pour en sortir. Que le logiciel libre soit aujourd’hui un exemple, un espoir et une source d’inspiration aux solutions envisagées n’est en rien étonnant tant nous sommes allés loin dans la privatisation des biens communs et la déshumanisation du monde…

La sortie du capitalisme a déjà commencé (version 2)

André Gorz – 17 septembre 2007 – EcoRev’

EcoRev’ précise : Ce texte qu’André Gorz a terminé d’écrire le 17/09/2007 est une version revue et approfondie de celui écrit pour le manifeste d’Utopia (voir ci-dessous). Rebaptisé pour notre dossier Le travail dans la sortie du capitalisme il a depuis été publié dans son livre posthume Écologica sous le titre La sortie du capitalisme a déjà commencé.

La question de la sortie du capitalisme n’a jamais été plus actuelle. Elle se pose en des termes et avec une urgence d’une radicale nouveauté. Par son développement même, le capitalisme a atteint une limite tant interne qu’externe qu’il est incapable de dépasser et qui en fait un système qui survit par des subterfuges à la crise de ses catégories fondamentales : le travail, la valeur, le capital.

La crise du système se manifeste au niveau macro-économique aussi bien qu’au niveau micro-économique. Elle s’explique principalement par un bouleversement technoscientifique qui introduit une rupture dans le développement du capitalisme et ruine, par ses répercussions la base de son pouvoir et sa capacité de se reproduire. J’essaierai d’analyser cette crise d’abord sous l’angle macro-économique, ensuite dans ses effets sur le fonctionnement et la gestion des entreprises.

L’informatisation et la robotisation ont permis de produire des quantités croissantes de marchandises avec des quantités décroissantes de travail. Le coût du travail par unité de produit ne cesse de diminuer et le prix des produits tend à baisser. Or plus la quantité de travail pour une production donnée diminue, plus le valeur produite par travailleur – sa productivité – doit augmenter pour que la masse de profit réalisable ne diminue pas. On a donc cet apparent paradoxe que plus la productivité augmente, plus il faut qu’elle augmente encore pour éviter que le volume de profit ne diminue. La course à la productivité tend ainsi à s’accélérer, les effectifs employés à être réduits, la pression sur les personnels à se durcir, le niveau et la masse des salaires à diminuer. Le système évolue vers une limite interne où la production et l’investissement dans la production cessent d’être assez rentables.

Les chiffres attestent que cette limite est atteinte. L’accumulation productive du capital productif ne cesse de régresser. Aux États-Unis, les 500 firmes de l’indice Standard & Poor’s disposent de 631 milliards de réserves liquides ; la moitié des bénéfices des entreprises américaines provient d’opérations sur les marchés financiers. En France, l’investissement productif des entreprises du CAC 40 n’augmente pas même quand leurs bénéfices explosent.

La production n’étant plus capable de valoriser l’ensemble des capitaux accumulés, une partie croissante de ceux-ci conserve la forme de capital financier. Une industrie financière se constitue qui ne cesse d’affiner l’art de faire de l’argent en n’achetant et ne vendant rien d’autre que diverses formes d’argent. L’argent lui-même est la seule marchandise que l’industrie financière produit par des opérations de plus en plus hasardeuses et de moins en moins maîtrisables sur les marchés financiers. La masse de capital que l’industrie financière draine et gère dépasse de loin la masse de capital que valorise l’économie réelle (le total des actifs financiers représente 160 000 milliards de dollars, soit trois à quatre fois le PIB mondial). La « valeur » de ce capital est purement fictive : elle repose en grande partie sur l’endettement et le « good will », c’est-à-dire sur des anticipations : la Bourse capitalise la croissance future, les profits futurs des entreprises, la hausse future des prix de l’immobilier, les gains que pourront dégager les restructurations, fusions, concentrations, etc. Les cours de Bourse se gonflent de capitaux et de leurs plus-values futurs et les ménages se trouvent incités par les banques à acheter (entre autres) des actions et des certificats d’investissement immobilier, à accélérer ainsi la hausse des cours, à emprunter à leur banque des sommes croissantes à mesure qu’augmente leur capital fictif boursier.

La capitalisation des anticipations de profit et de croissance entretien l’endettement croissant, alimente l’économie en liquidités dues au recyclage bancaire de plus-value fictives, et permet aux États-Unis une « croissance économique » qui, fondée sur l’endettement intérieur et extérieur, est de loin le moteur principal de la croissance mondiale (y compris de la croissance chinoise). L’économie réelle devient un appendice des bulles spéculatives entretenues par l’industrie financière. Jusqu’au moment, inévitable, où les bulles éclatent, entraînent les banques dans des faillites en chaîne, menaçant le système mondial de crédit d’effondrement, l’économie réelle d’une dépression sévère et prolongée (la dépression japonaise dure depuis bientôt quinze ans).

On a beau accuser le spéculation, les paradis fiscaux, l’opacité et le manque de contrôle de l’industrie financière (en particulier des hedge funds), la menace de dépression, voire d’effondrement qui pèse sur l’économie mondiale n’est pas due au manque de contrôle ; elle est due à l’incapacité du capitalisme de se reproduire. Il ne se perpétue et ne fonctionne que sur des bases fictives de plus en plus précaires. Prétendre redistribuer par voie d’imposition les plus-values fictives des bulles précipiterait cela même que l’industrie financière cherche à éviter : la dévalorisation de masses gigantesque d’actifs financiers et la faillite du système bancaire. La « restructuration écologique » ne peut qu’aggraver la crise du système. Il est impossible d’éviter une catastrophe climatique sans rompre radicalement avec les méthodes et la logique économique qui y mènent depuis 150 ans. Si on prolonge la tendance actuelle, le PIB mondial sera multiplié par un facteur 3 ou 4 d’ici à l’an 2050. Or selon le rapport du Conseil sur le climat de l’ONU, les émissions de CO2 devront diminuer de 85% jusqu’à cette date pour limiter le réchauffement climatique à 2°C au maximum. Au-delà de 2°, les conséquences seront irréversibles et non maîtrisables.

La décroissance est donc un impératif de survie. Mais elle suppose une autre économie, un autre style de vie, une autre civilisation, d’autres rapports sociaux. En leur absence, l’effondrement ne pourrait être évité qu’à force de restrictions, rationnements, allocations autoritaires de ressources caractéristiques d’une économie de guerre. La sortie du capitalisme aura donc lieu d’une façon ou d’une autre, civilisée ou barbare. La question porte seulement sur la forme que cette sortie prendra et sur la cadence à laquelle elle va s’opérer.

La forme barbare nous est déjà familière. Elle prévaut dans plusieurs régions d’Afrique, dominées par des chefs de guerre, par le pillage des ruines de la modernité, les massacres et trafics d’êtres humains, sur fond de famine. Les trois Mad Max étaient des récits d’anticipation.

Une forme civilisée de la sortie du capitalisme, en revanche, n’est que très rarement envisagée. L’évocation de la catastrophe climatique qui menace conduit généralement à envisager un nécessaire « changement de mentalité », mais la nature de ce changement, ses conditions de possibilité, les obstacles à écarter semblent défier l’imagination. Envisager une autre économie, d’autres rapports sociaux, d’autres modes et moyens de production et modes de vie passe pour « irréaliste », comme si la société de la marchandise, du salariat et de l’argent était indépassable. En réalité une foule d’indices convergents suggèrent que ce dépassement est déjà amorcé et que les chances d’une sortie civilisée du capitalisme dépendent avant tout de notre capacité à distinguer les tendances et les pratiques qui en annoncent la possibilité.

Le capitalisme doit son expansion et sa domination au pouvoir qu’il a pris en l’espace d’un siècle sur la production et la consommation à la fois. En dépossédant d’abord les ouvriers de leurs moyens de travail et de leurs produits, il s’est assuré progressivement le monopole des moyens de production et la possibilité de subsumer le travail. En spécialisant, divisant et mécanisant le travail dans de grandes installations, il a fait des travailleurs les appendices des mégamachines du capital. Toute appropriation des moyens de production par les producteurs en devenait impossible. En éliminant le pouvoir de ceux-ci sur la nature et la destination des produits, il a assuré au capital le quasi-monopole de l’offre, donc le pouvoir de privilégier dans tous les domaines les productions et les consommations les plus rentables, ainsi que le pouvoir de façonner les goûts et désirs des consommateurs, la manière dont ils allaient satisfaire leurs besoins. C’est ce pouvoir que la révolution informationnelle commence de fissurer.

Dans un premier temps, l’informatisation a eu pour but de réduire les coûts de production. Pour éviter que cette réduction des coûts entraîne une baisse correspondante du prix des marchandises, il fallait, dans toute la mesure du possible, soustraire celles-ci aux lois du marché. Cette soustraction consiste à conférer aux marchandises des qualités incomparables grâce auxquelles elles paraissent sans équivalent et cessent par conséquent d’apparaître comme de simples marchandises.

La valeur commerciale (le prix) des produits devait donc dépendre davantage de leurs qualités immatérielles non mesurables que de leur utilité (valeur d’usage) substantielle. Ces qualités immatérielles – le style, la nouveauté le prestige de la marque, le rareté ou « exclusivité » – devaient conférer aux produits un statut comparable à celui des oeuvres d’art : celles-ci ont une valeur intrinsèque, il n’existe aucun étalon permettant d’établir entre elles un rapport d’équivalence ou « juste prix ». Ce ne sont donc pas de vraies marchandises. Leur prix dépend de leur rareté, de la réputation du créateur, du désir de l’acheteur éventuel. Les qualités immatérielles incomparables procurent à la firme productrice l’équivalent d’un monopole et la possibilité de s’assurer une rente de nouveauté, de rareté, d’exclusivité. Cette rente masque, compense et souvent surcompense la diminution de la valeur au sens économique que la baisse des coûts de production entraîne pour les produits en tant que marchandises par essence échangeable entre elles selon leur rapport d’équivalence.

Du point de vue économique, l’innovation ne crée donc pas de valeur ; elle est le moyen de créer de la rareté source de rente et d’obtenir un surprix au détriment des produits concurrents. La part de la rente dans le prix d’une marchandise peut être dix, vingt ou cinquante fois plus grand que son coût de revient, et cela ne vaut pas seulement pour les articles de luxe ; cela vaut aussi bien pour des articles d’usage courant comme les baskets, T-shirts, portables, disques, jeans etc.

Or la rente n’est pas de même nature que le profit : elle ne correspond pas à la création d’un surcroît de valeur, d’une plus-value. Elle redistribue la masse totale de le valeur au profit des entreprises rentières et aux dépends des autres ; elle n’augmente pas cette masse[2].

Lorsque l’accroissement de la rente devient le but déterminent de la politique des firmes – plus important que le profit qui, lui, se heurte à le limite interne indiquée plus haut – la concurrence entre les firmes porte avant tout sur leur capacité et rapidité d’innovation. C’est d’elle que dépend avant tout la grandeur de leur rente. Elles cherchent donc a se surpasser dans le lancement de nouveaux produits ou modèles ou styles, par l’originalité du design, par l’inventivité de leurs campagnes de marketing, par la « personnalisation » des produits. L’accélération de l’obsolescence, qui va de pair avec la diminution de la durabilité des produits et de la possibilité de les réparer, devient le moyen décisif d’augmenter le volume des ventes. Elle oblige les firmes à inventer continuellement des besoins et des désirs nouveaux , à conférer aux marchandises une valeur symbolique, sociale, érotique, à diffuser une « culture de la consommation » qui mise sur l’individualisation, la singularisation, la rivalité, la jalousie, bref sur ce que j’ai appelé ailleurs la « socialisation antisociale ».

Tout s’oppose dans ce système à l’autonomie des individus ; à leur capacité de réfléchir ensemble à leurs fins communes et à leurs besoins communs ; de se concerter sur la meilleure manière d’éliminer les gaspillages, d’économiser les ressources, d’élaborer ensemble, en tant que producteurs et consommateurs, une norme commune du suffisant – de ce que Jacques Delors appelait une « abondance frugale ». De toute évidence, la rupture avec la tendance au « produire plus, consommer plus » et la redéfinition autonome d’un modèle de vie visant à faire plus et mieux avec moins, suppose la rupture avec une civilisation où on ne produit rien de ce qu’on consomme et ne consomme rien de ce qu’on produit ; où producteurs et consommateurs sont séparés et où chacun s’oppose à lui-même en tant qu’il est toujours l’un et l’autre à la fois ; où tous les besoins et tous les désirs sont rebattus sur le besoin de gagner de l’argent et le désir de gagner plus ; où la possibilité de l’autoproduction pour l’autoconsommation semble hors de portée et ridiculement archaïque – à tort.

Et pourtant : la « dictature sur les besoins » perd de sa force. L’emprise que les firmes exercent sur les consommateurs devient plus fragile en dépit de l’explosion des dépenses pour le marketing et la publicité. La tendance à l’autoproduction regagne du terrain en raison du poids croissant qu’ont les contenus immatériels dans la nature des marchandises. Le monopole de l’offre échappe petit à petit au capital.

Il n’était pas difficile de privatiser et de monopoliser des contenus immatériels aussi longtemps que connaissances, idées, concepts mis en oeuvre dans la production et dans la conception des marchandises étaient définis en fonction de machines et d’articles dans lesquels ils étaient incorporés en vue d’un usage précis. Machines et articles pouvaient être brevetés et la position de monopole protégée. La propriété privée de connaissances et de concepts était rendue possible par le fait qu’ils étaient inséparables des objets qui les matérialisaient. Ils étaient une composante du capital fixe.

Mais tout change quand les contenus immatériels ne sont plus inséparables des produits qui les contiennent ni même des personnes qui les détiennent ; quand ils accèdent a une existence indépendante de toute utilisation particulière et qu’ils sont susceptibles, traduits en logiciels, d’être reproduits en quantités illimitées pour un coût infime. Ils peuvent alors devenir un bien abondant qui, par sa disponibilité illimitée, perd toute valeur d’échange et tombe dans le domaine public comme bien commun gratuit – à moins qu’on ne réussisse à l’en empêcher en en interdisant l’accès et l’usage illimités auxquels il se prête.

Le problème auquel se heurte « l’économie de la connaissance » provient du fait que la dimension immatérielle dont dépend le rentabilité des marchandises n’est pas, à l’âge de l’informatique, de la même nature que ces dernières : elle n’est la propriété privée ni des entreprises ni des collaborateurs de celles-ci ; elle n’est pas de par sa nature privatisable et ne peut par conséquent devenir une vraie marchandise. Elle peut seulement être déguisée en propriété privée et marchandise en réservant son usage exclusif par des artifices juridiques ou techniques (codes d’accès secrets). Ce déguisement ne change cependant rien à la réalité de bien commun du bien ainsi déguisé : il reste une non-marchandise non vendable dont l’accès et l’usage libres sont interdits parce qu’ils demeurent toujours possibles, parce que le guettent les « copies illicites », les « imitations », les usages interdits. Le soi-disant propriétaire lui-même ne peut les vendre c’est-à-dire en transférer la propriété privée à un autre, comme il le ferait pour une vraie marchandise ; il ne peut vendre qu’un droit d’accès ou d’usage « sous licence ».

L’économie de la connaissance se donne ainsi pour base une richesse ayant vocation d’être un bien commun, et les brevets et copyrights censés le privatiser n’y changent rien ; l’aire de la gratuité s’étend irrésistiblement. L’informatique et internet minent le règne de la marchandise à sa base. Tout ce qui est traduisible en langage numérique et reproductible, communicable sans frais tend irrésistiblement à devenir un bien commun, voire un bien commun universel quand il est accessible à tous et utilisable par tous. N’importe qui peut reproduire avec son ordinateur des contenus immatériels comme le design, les plans de construction ou de montage, les formules et équations chimiques ; inventer ses propres styles et formes ; imprimer des textes, graver des disques, reproduire des tableaux. Plus de 200 millions de références sont actuellement accessibles sous licence « créative commons ». Au Brésil, où l’industrie du disque commercialise 15 nouveaux CD par an, les jeunes des favelas en gravent 80 par semaine et les diffusent dans la rue. Les trois quarts des ordinateurs produits en 2004 étaient autoproduits dans les favelas avec les composants de matériels mis au rebut. Le gouvernement soutient les coopératives et groupements informels d’autoproduction pour l’auto approvisionnement.

Claudio Prado, qui dirige le département de la culture numérique au ministère de la Culture du Brésil, disait récemment : « L’emploi est une espèce en voie d’extinction… Nous comptons sauter cette phase merdique du 20è siècle pour passer directement du 19è au 21è siècle ». L’autoproduction des ordinateurs par exemple a été officiellement soutenue : il s’agit de favoriser « l’appropriation des technologies par les usagers dans un but de transformation sociale ». La prochaine étape sera logiquement l’autoproduction de moyens de production. J’y reviendrai encore.

Ce qui importe pour le moment, c’est que la principale force productive et la principale source de rentes tombent progressivement dans le domaine public et tendent vers la gratuité ; que la propriété privée des moyens de production et donc le monopole de l’offre deviennent progressivement impossibles ; que par conséquent l’emprise du capital sur la consommation se relâche et que celle-ci peut tendre à s’émanciper de l’offre marchande. Il s’agit là d’une rupture qui mine le capitalisme à sa base. La lutte engagée entre les « logiciels propriétaires » et les « logiciels libres » (libre, « free », est aussi l’équivalent anglais de « gratuit ») a été Le coup d’envoi du conflit central de l’époque. Il s’étend et se prolonge dans la lutte contre la marchandisation de richesses premières – la terre, les semences, le génome, les biens culturels, les savoirs et compétences communs, constitutifs de la culture du quotidien et qui sont les préalables de l’existence d’une société. De la tournure que prendra cette lutte dépend la forme civilisée ou barbare que prendra la sortie du capitalisme.

Cette sortie implique nécessairement que nous nous émanciperons de l’emprise qu’exerce le capital sur la consommation et de son monopole des moyens de production. Elle signifie l’unité rétablie du sujet de la production et du sujet de la consommation et donc l’autonomie retrouvée dans la définition de nos besoins et de leur mode de satisfaction. L’obstacle insurmontable que le capitalisme avait dressé sur cette voie était la nature même des moyens de production qu’il avait mis en place : ils constituait une mégamachine dont tous étaient les serviteurs et qui nous dictait les fins à poursuivre et la vie a mener. Cette période tire à sa fin. Les moyens d’autoproduction high-tech rendent la mégamachine industrielle virtuellement obsolète. Claudio Prado invoque « l’appropriation des technologies » parce que la clé commune de toutes, l’informatique, est appropriable par tous. Parce que, comme le demandait Ivan Illich, « chacun peut l’utiliser sans difficulté aussi souvent ou aussi rarement qu’il le désire… sans que l’usage qu’il en fait empiète sur le liberté d’autrui d’en faire autant » ; et parce que cet usage (il s’agit de la définition illichienne des outils conviviaux) « stimule l’accomplissement personnel » et élargit l’autonomie de tous. La définition que Pekka Himanen donne de l’Ethique Hacker est très voisine : un mode de vie qui met au premier rang « les joies de l’amitié, de l’amour, de la libre coopération et de la créativité personnelle ».

Les outils high-tech existants ou en cours de développement, généralement comparables à des périphériques d’ordinateur, pointent vers un avenir où pratiquement tout le nécessaire et le désirable pourra être produit dans des ateliers coopératifs ou communaux ; où les activités de production pourront être combinées avec l’apprentissage et l’enseignement, avec l’expérimentation et la recherche, avec la création de nouveaux goûts, parfums et matériaux, avec l’invention de nouvelles formes et techniques d’agriculture, de construction, de médecine etc. Les ateliers communaux d’autoproduction seront interconnectés à, l’échelle du globe, pourront échanger ou mettre en commun leurs expériences, inventions, idées, découvertes. Le travail sera producteur de culture, l’autoproduction un mode d’épanouissement.

Deux circonstances plaident en faveur de ce type de développement. La première est qu’il existe beaucoup plus de compétences, de talents et de créativité que l’économie capitaliste n’en peut utiliser. Cet excédent de ressources humaines ne peut devenir productif que dans une économie où la création de richesses n’est pas soumise aux critères de rentabilité. La seconde est que « l’emploi est une espèce en voie d’extinction ».

Je ne dis pas que ces transformations radicales se réaliseront. Je dis seulement que, pour la première fois, nous pouvons vouloir qu’elles se réalisent. Les moyens en existent ainsi que les gens qui s’y emploient méthodiquement. Il est probable que ce seront des Sud-Américains ou des Sud-Africains qui, les premiers, recréeront dans les banlieues déshéritées des villes européennes les ateliers d’autoproduction de leur favela ou de leur township d’origine.

La sortie du capitalisme a déjà commencé (version 1)

André Gorz – 16 septembre 2007 – EcoRev’

Ce texte d’André Gorz a été distribué le 16 septembre 2007 à l’université d’Utopia.

La question de la sortie du capitalisme n’a jamais été plus actuelle. Elle se pose en des termes et avec une urgence d’une radicale nouveauté. Par son développement même, le capitalisme a atteint une limite tant interne qu’externe qu’il est incapable de dépasser et qui en fait un système mort-vivant qui se survit en masquant par des subterfuges la crise de ses catégories fondamentales : le travail, la valeur, le capital.

Cette crise de système tient au fait que la masse des capitaux accumulés n’est plus capable de se valoriser par l’accroissement de la production et l’extension des marchés. La production n’est plus assez rentable pour pouvoir valoriser des investissements productifs additionnels. Les investissements de productivité par lesquels chaque entreprise tente de restaurer son niveau de profit ont pour effet de déchaîner des formes de concurrence meurtrières qui se traduisent, entre autres, par des réductions compétitives des effectifs employés, des externalisations et des délocalisations, la précarisation des emplois, la baisse des rémunérations, donc, à l’échelle macro-économique, la baisse du volume de travail productif de plus-value et la baisse du pouvoir d’achat. Or moins les entreprises emploient de travail et plus le capital fixe par travailleur est important, plus le taux d’exploitation, c’est-à-dire le surtravail et la survaleur produits par chaque travailleur doivent être élevés. Il y a à cette élévation une limite qui ne peut être indéfiniment reculée, même si les entreprises se délocalisent en Chine, aux Philippines ou au Soudan.

Les chiffres attestent que cette limite est atteinte. L’accumulation productive de capital productif ne cesse de régresser. Aux Etats-Unis, les 500 firmes de l’indice Standard & Poor’s disposent, en moyenne, de 631 milliards de réserves liquides ; la moitié des bénéfices des entreprises américaines provient d’opérations sur les marchés financiers. En France, l’investissement productif des entreprises du CAC 40 n’augmente pas, même quand leurs bénéfices explosent. L’impossibilité de valoriser les capitaux accumulés par la production et le travail explique le développement d’une économie fictive fondée sur la valorisation de capitaux fictifs. Pour éviter une récession qui dévaloriserait le capital excédentaire (suraccumulé), les pouvoirs financiers ont pris l’habitude d’inciter les ménages à s’endetter, à consommer leurs revenus futur, leurs gains boursiers futurs, la hausse future des entreprises, les achats futurs des ménages, les gains que pourront dégager les dépeçages et restructurations, imposés par les LBO, d’entreprises qui ne s’étaient pas encore mises à l’heure de la précarisation, surexploitation et externalisation de leurs personnels.

La valeur fictive (boursière) des actifs financiers a doublé en l’espace d’environ six ans, passant de 80 000 milliards à 160 000 milliards de dollars (soit trois le PIB mondial), entretenant aux Etats-Unis une croissance économique fondée sur l’endettement intérieur et extérieur, lequel entretient de son côté la liquidité de l’économie mondiale et la croissance de la Chine, des pays voisins et par ricochet de l’Europe.

L’économie réelle est devenue un appendice des bulles financières. Il faut impérativement un rendement élevé du capital propre des firmes pour que la bulle boursière n’éclate pas – et une hausse continue – du prix de l’immobilier pour que n’éclate pas la bulle des certificats d’investissement immobilier vers lesquels les banques ont attiré l’épargne des particuliers en leur promettant monts et merveilles – car l’éclatement des bulles menacerait le système bancaire de faillites en chaîne, l’économie réelle d’une dépression prolongée (la dépression japonaise dure depuis quinze ans).

« Nous cheminons au bord du gouffre », écrivait Robert Benton. Voilà qui explique qu’aucun Etat n’ose prendre le risque de s’aliéner ou d’inquiéter les puissances financières. Il est impensable qu’une politique sociale ou une politique de « relance de la croissance » puisse être fondée sur la redistribution des plus-values fictives de la bulle financière. Il n’y a rien à attendre de décisif des Etats nationaux qui, au nom de l’impératif de compétitivité, ont au cours des trente dernières années abdiqué pas à pas leurs pouvoirs entre les mains d’un quasi-Etat supranational imposant des lois faites sur mesure dans l’intérêt du capital mondial dont il est l’émanation. Ces lois, promulguées par l’OMC, l’OCDE, le FMI, imposent dans la phase actuelle le tout-marchand, c’est-à-dire la privatisation des services publics, le démantèlement de la protection sociale, la monétarisation des maigres restes de relations non commercia1es. Tout se passe comme si le capital, après avoir gagné la guerre qu’il a déclaré à la classe ouvrière, vers la fin des années 1970, entendait éliminer tous les rapports sociaux qui ne sont pas des rapports acheteur/vendeur, c’est-à-dire qui ne réduisent pas les individus à être des consommateurs de marchandises et des vendeurs de leur travail ou d’une quelconque prestation considérée comme « travail » pour peu qu’elle soit tarifée. Le tout-marchand, le tout-marchandise comme forme exclusive du rapport social poursuit la liquidation complète de la société dont Margaret Thatcher avait annoncé le projet. Le totalitarisme du marché s’y dévoilait dans son sens politique comme stratégie de domination. Dès lors que la mondialisation du capital et des marchés, et la férocité de la concurrence entre capitaux partiels exigeaient que l’Etat ne fût plus le garant de la reproduction de la société mais le garant de la compétitivité des entreprises, ses marges de manœuvre en matière de politique sociale étaient condamnées à se rétrécir, les coûts sociaux à être dénoncés comme des entorses à la libre concurrence et des entraves à la compétitivité, le financement public des infrastructures à être allégé par la privatisation.

Le tout-marchand s’attaquait à l’existence de ce que les britanniques appellent les commons et les Allemands le Gemeinwesen, c’est-à-dire à l’existence des biens communs indivisibles, inaliénables et inappropriables, inconditionnellement accessibles et utilisables par nous. Contre la privatisation des biens communs les individus ont tendance à réagir par des actions communes, unis en un seul sujet. L’Etat a tendance à empêcher et le cas échéant à réprimer cette union de tous d’autant plus fermement qu’il ne dispose plus des marges suffisantes pour apaiser des masses paupérisées, précarisées, dépouillées de droits acquis. Plus sa domination devient précaire, plus les résistances populaires menacent de se radicaliser, et plus la répression s’accompagne de politiques qui dressent les individus les uns contre les autres et désignent des boucs émissaires sur lesquels concentrer leur haine.

Si l’on a à l’esprit cette toile de fond, les programmes, discours et conflits qui occupent le devant de la scène politique paraissent dérisoirement décalés par rapport aux enjeux réels. Les promesses et les objectifs mis en avant par les gouvernement et les partis apparaissent comme des diversions irréelles qui masquent le fait que le capitalisme n’offre aucune perspective d’avenir sinon celle d’une détériorisation continue de vie, d’une aggravation de sa crise, d’un affaissement prolongé passant par des phases de dépression de plus en plus longues et de reprise de plus en plus faibles. Il n’y a aucun « mieux » à attendre si on juge le mieux selon les critères habituels. Il n’y aura plus de « développement » sous la forme du plus d’emplois, plus de salaire, plus de sécurité. Il n’y aura plus de « croissance » dont les fruits puissent être socialement redistribués et utilisés pour un programme de transformations sociales transcendant les limites et la logique du capitalisme.

L’espoir mis, il y a quarante ans, dans des « réformes révolutionnaires » qui, engagées de l’intérieur du système sous la pression de luttes syndicales, finissent par transférer à la classe ouvrière les pouvoirs arrachés au capital, cet espoir n’existe plus. La production demande de moins en moins de travail, distribue de moins en moins de pouvoir d’achat à de moins en moins d’actifs ; elle n’est plus concentrée dans de grandes usines pas plus que ne l’est la force de travail. L’emploi est de plus en plus discontinu, dispersé sur des prestataires de service externes, sans contact entre eux, avec un contrat commercial à la place d’un contrat de travail. Les promesses et programmes de « retour » au plein emploi sont des mirages dont la seule fonction est d’entretenir l’imaginaire salarial et marchand c’est-à-dire l’idée que le travail doit nécessairement être vendu à un employeur et les biens de subsistance achetés avec l’argent gagnés autrement dit qu’il n’y a pas de salut en dehors de la soumission du travail au capital et de la soumission des besoins à la consommation de marchandises, qu’il n’y a pas de vie, pas de société au-delà de la société de la marchandise et du travail marchandisé, au-delà et en dehors du capitalisme

L’imaginaire marchand et le règne de la marchandise empêchent d’imaginer une quelconque possibilité de sortir du capitalisme et empêchent par conséquent de vouloir en sortir. Aussi longtemps que nous restons prisonniers de l’imaginaire salarial et marchand, l’anticapitalisme et la référence à une société au-delà du capitalisme resteront abstraitement utopiques et les luttes sociales contre les politiques du capital resteront des luttes défensives qui, dans le meilleur des cas, pourront freiner un temps mais non pas empêcher l’intériorisation des conditions de vie.

La « restructuration écologique » ne peut qu’aggraver la crise du système. Il est impossible d’éviter une catastrophe climatique sans rompre radicalement avec les méthodes et la logique économique qui y mènent depuis 150 ans. Si on prolonge la tendance actuelle, le PIB mondial sera multiplié par un facteur 3 ou 4 d’ici à l’an 2050. Or selon le rapport du Conseil sur le climat de l’ONU, les émissions de CO2 devront diminuer de 85% jusqu’à cette date pour limiter le réchauffement climatique à 2°C au maximum. Au-delà de 2°, les conséquences seront irréversibles et non maîtrisables.

La décroissance est donc un impératif de survie. Mais elle suppose une autre économie, un autre style de vie, une autre civilisation, d’autres rapports sociaux. En leur absence, la décroissance risque d’être imposée à force de restrictions, rationnements, allocations de ressources caractéristiques d’un socialisme de guerre. La sortie du capitalisme s’impose donc d’une façon ou d’une autre. La reproduction du système se heurte à la fois à ses limites internes et aux limites externes engendrées par le pillage et la destruction d’une des deux « principales sources d’où jaillit toute richesse » : la terre. La sortie du capitalisme a déjà commencé sans être encore voulue consciemment. La question porte seulement sur la forme qu’elle va prendre et la cadence à laquelle elle va s’opérer.

L’instauration d’un socialisme de guerre, dictatorial, centralisateur, techno-bureautique serait la conclusion logique – on est tenté de dire « normale » – d’une civilisation capitaliste qui, dans le souci de valoriser des masses croissantes de capital, a procédé à ce que Marcuse appelle la « désublimation répressive » – c’est-à-dire la répression des « besoins supérieurs », pour créer méthodiquement des besoins croissants de consommation individuelle, sans s’occuper des conditions de leur satisfaction. Elle a éludé dès le début la question qui est à l’origine des sociétés : la question du rapport entre les besoins et les conditions qui rendent leur satisfaction possible : la question d’une façon de gérer des ressources limitées de manière qu’elles suffisent durablement à couvrir les besoins de tous ; et inversement la recherche d’un accord général sur ce qui suffira à chacun, de manière que les besoins correspondent aux ressources disponibles.

Nous sommes donc arrivés à un point où les conditions n’existent plus qui permettraient la satisfaction des besoins que le capitalisme nous a donnés, inventés, imposés, persuadé d’avoir afin d ’écouler des marchandises qu’il nous a enseigné à désirer. Pour nous enseigner à y renoncer, l’écodictature semble à beaucoup être le chemin le plus court. Elle aurait la préférence de ceux qui tiennent le capitalisme et le marché pour seuls capables de créer et de distribuer des richesses ; et qui prévoient une reconstitution du capitalisme sur de nouvelles bases après que des catastrophes écologiques auront remis les compteurs à zéro en provoquant une annulation des dettes et des créances.

Pourtant une tout autre voie de sortie s’ébauche. Elle mène à l’extinction du marché et du salariat par l’essor de l’autoproduction, de la mise en commun et de la gratuité. On trouve les explorateurs et éclaireurs de cette voie dans le mouvement des logiciels libres, du réseau libre (freenet), de la culture libre qui, avec la licence CC (creative commons) rend libre (et libre : free signifie, en anglais, à la fois librement accessible et utilisable par tous, et gratuit) de l’ensemble des biens culturels – connaissances, logiciels, textes, musique, films etc. – reproductibles en un nombre illimité de copies pour un coût négligeable. Le pas suivant serait logiquement la production « libre » de toute la vie sociale, en commençant par soustraire au capitalisme certaines branches de produits susceptibles d’être autoproduits localement par des coopératives communales. Ce genre de soustraction à la sphère marchande s’étend pour les biens culturels où elle a été baptisée « out-cooperating », un exemple classique étant Wikipedia qui est en train d’« out-cooperate » l’Encyclopedia Britannica. L’extension de ce modèle aux biens matériels est rendue de plus en plus faisable grâce à la baisse du coût des moyens de production et à la diffusion des savoirs techniques requis pour leur utilisation. La diffusion des compétences informatiques, qui font partie de la « culture du quotidien » sans avoir à être enseignées, est un exemple parmi d’autres. L’invention fabbers, aussi appelés digital fabricators ou factories in a box – il s’agit d’une sorte d’ateliers flexibles transportables et installables n’importe où – ouvre à l’autoproduction locale des possibilités pratiquement illimitées.

Produire ce que nous consommons et consommer ce que nous produisons est la voie royale de la sortie du marché. Elle nous permet de nous demander de quoi nous avons réellement besoin, en quantité et en qualité, et de redéfinir par concertation, compte tenu de l’environnement et des ressources à ménager, la norme du suffisant que l’économie de marché a tout fait pour abolir. L’autoréduction de la consommation, son autolimitation – le self-restraint – et la possibilité de recouvrer le pouvoir sur notre façon de vivre passent par là.

Il est probable que les meilleurs exemples de pratiques alternatives en rupture avec le capitalisme nous viennent du Sud de la planète, si j’en juge d’après la création au Brésil, dans des favelas mais pas seulement, des « nouvelles coopératives » et des « pontos de cultura ». Claudio Prado, qui dirige le département de la « culture numérique » au ministère de la culture, déclarait récemment : « Le ’job’ est une espèce en voie d’extinction… Nous espérons sauter cette phase merdique du 20e siècle pour passer directement du 19e au 21e. » L’autoproduction et le recyclage des ordinateurs par exemple, sont soutenus par le gouvernement : il s’agit de favoriser « l’appropriation des technologies par les usagers dans un but de transformation sociale ». Si bien que les trois quarts de tous les ordinateurs produits au Brésil en 2004/5 étaient autoproduits.

Notes

[1] Crédit photo : Auteur non identifié, mis en ligne par Imago sur Flickr (Creative Commons By-Nc-Sa)

[2] La valeur travail est une idée d’Adam Smith qui voyait dans le travail la substance commune de toutes les marchandises et pensait que celles-ci s’échangeaient en proportion de la quantité de travail qu’elles contenaient. La valeur travail n’a rien à voir avec ce qu’on entend par là aujourd’hui et qui (chez Dominique Méda entre autres) devrait être désigné comme travail valeur (valeur morale, sociale, idéologique etc.). Marx a affiné et retravaillé la théorie d’A. Smith. En simplifiant à l’extrême, on peut résumer la notion économique en disant : Une entreprise crée de la valeur dans la mesure où elle produit une marchandise vendable avec du travail pour la rémunération duquel elle met en circulation (crée, distribue,) du pouvoir d’achat. Si son activité n’augmente pas la quantité d’argent en circulation elle ne crée pas de valeur. Si son activité détruit de l’emploi elle détruit de la valeur. La rente de monopole consomme de la valeur crée par ailleurs et se l’approprie.

Seriez-vous choqués si, profitant éhonteusement de cette tribune, j’évoquais rapidement le futur premier roman de ma… sœur, quand bien même il ne soit pas sous licence libre ?

Seriez-vous choqués si, profitant éhonteusement de cette tribune, j’évoquais rapidement le futur premier roman de ma… sœur, quand bien même il ne soit pas sous licence libre ? L’hôte principal de ce blog, perdu quelque part entre la

L’hôte principal de ce blog, perdu quelque part entre la

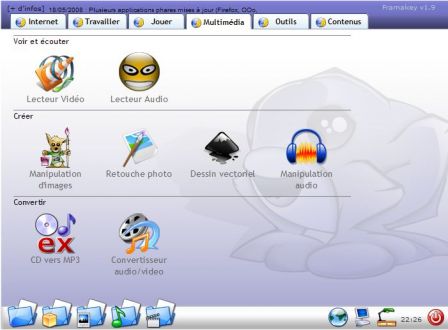

Ahhhhh. Si Framasoft avait touché 1€ à chaque fois qu’on nous posait la question « La Framakey, elle marche sous linux ? », nous n’aurions même pas besoin de lancer (très bientôt) une campagne de soutien à Framasoft !

Ahhhhh. Si Framasoft avait touché 1€ à chaque fois qu’on nous posait la question « La Framakey, elle marche sous linux ? », nous n’aurions même pas besoin de lancer (très bientôt) une campagne de soutien à Framasoft ! De plus en plus d’applications qu’on utilise sont des applications web. D’ailleurs, je ne vous ai pas dit que Tata Jeannine utilisait (l’excellent)

De plus en plus d’applications qu’on utilise sont des applications web. D’ailleurs, je ne vous ai pas dit que Tata Jeannine utilisait (l’excellent)

Nous le savions déjà : « musique » et « industrie musicale » sont deux entités distinctes. La révolution numérique n’a fait que nous le rappeler mais en apportant un petit quelque chose en plus : la possibilité pour le premier de ne pas être obligé d’en passer forcément par le second pour exister. Surtout si cette industrie musicale renonce à s’adapter et préfère mettre son énergie à chercher des mesures coercitives pour ramener ses clients dans le droit chemin de la rassurante situation d’avant (qui n’est déjà plus).

Nous le savions déjà : « musique » et « industrie musicale » sont deux entités distinctes. La révolution numérique n’a fait que nous le rappeler mais en apportant un petit quelque chose en plus : la possibilité pour le premier de ne pas être obligé d’en passer forcément par le second pour exister. Surtout si cette industrie musicale renonce à s’adapter et préfère mettre son énergie à chercher des mesures coercitives pour ramener ses clients dans le droit chemin de la rassurante situation d’avant (qui n’est déjà plus).