Si j’ai demandé l’autorisation à son auteur d’exhumer et reproduire ici-même un de ses articles pourtant déjà vieux de presque dix ans, c’est parce qu’il touche à une notion simple mais essentielle : la confiance.

Si j’ai demandé l’autorisation à son auteur d’exhumer et reproduire ici-même un de ses articles pourtant déjà vieux de presque dix ans, c’est parce qu’il touche à une notion simple mais essentielle : la confiance.

La grande chance, ou plutôt la grande force, du logiciel libre, et dans son sillage de toute la culture libre, c’est de bénéficier dès le départ d’un certain niveau de confiance.

Pourquoi ? Parce que la licence libre qui l’accompagne.

C’est cette mise sous licence libre qui non seulement donne son nom au logiciel libre mais qui, de par les garanties offertes, favorise l’émergence d’une communauté autour du projet et tisse des liens solides entres ses membres.

Cela ne constitue évidemment pas un gage absolu de succès (cf Comment détruire votre communauté en 10 leçons), mais c’est tout de même un sacré avantage lorsque l’on sait combien cette confiance peine à s’installer dans des structures plus « classiques ».

Le texte ci-dessous est de Jean-Yves Prax qui travaille à Polia Consulting, une société de conseil en Knowledge Management.

Il ne se focalise nullement sur le logiciel libre en tant que tel mais ne s’aventure pas non plus jusqu’à la relation amoureuse[1]. Il se limite ici « à une analyse de la confiance dans un environnement professionnel (même si cette limite ne supprime pas complètement les facteurs affectifs et moraux, loin s’en faut), et principalement dans le champ de l’action collective au sein d’une communauté : travail en équipe, partage de connaissance, mutualisation de compétence, décision collective, process… ».

Vous trouverez en bas de page une version PDF de l’article.

Le rôle de la confiance dans la performance collective

URL d’origine du document

”Texte de la conférence faite par Jean-Yves Prax pour l’ouverture du KMForum 2001, le mardi 25 septembre 2001, au Palais des Congrès, Porte Maillot, Paris.

La confiance est un facteur déterminant de la performance collective et en particulier dans le cas des communautés virtuelles ou/et d’équipes dont la production est à forte intensité immatérielle. Même si, d’expérience ou d’intuition, nous partageons tous cette conviction, les mécanismes de création de la confiance restent énigmatiques et peu maîtrisables : la confiance, qu’est-ce que c’est ? comment la créer ? A quelle rationalité obéit-elle ?

Analyser la confiance, c’est aborder l’un des aspects les plus délicat du fonctionnement d’une communauté.

La confiance, qu’est-ce que c’est ?

La littérature sur le sujet est abondante et les définitions très diverses et variées, par exemple :

- La confiance analysée d’un point de vue rationnel, comme un choix raisonné, par exemple le ratio effort-bénéfice d’une action individuelle au sein d’un collectif ; on entend parler d’indice de confiance, de ce qui est maîtrisable ; la notion peut être utile en cas de délégation.

- La confiance analysée d’un point de vue normatif, conforme à un label, une certification : par exemple, nous sommes capables de confier notre santé et notre vie à un médecin parfaitement inconnu au seul prétexte qu’il a obtenu un diplôme national, diplôme que nous ne vérifions même pas, alors que nous hésiterons à confier les clefs de notre véhicule à un laveur de voitures.

- Une confiance par intuition, par croyance, qui ne suppose pas de véritable délibération critique, elle est affective, esthétique, c’est-à-dire purement émotionnelle et par conséquent tout à fait irrationnelle. Beaucoup de comportement racistes sont typiquement dans ce registre (la fameuse "note de sale gueule") mais si vous ne le croyez pas, essayez donc d’aller solliciter un emprunt à votre banquier en babouches !

- La confiance vue d’un point de vue social, basé sur une sorte « d’engagement de moyens » issu d’un code partagé (souvent implicite) de devoirs réciproques, de valeurs morales et d’éthique. « Il n’a pas réussi, mais il a fait tout ce qu’il pouvait ».

La perspective rationnelle se définit comme « une attente sur les motivations d’autrui à agir conformément à ce qui était prévu dans une situation donnée ». Elle considère l’individu comme un acteur rationnel, prévisible, et sa rationalité est confortée par le fait que ses choix et ses actes sont gagnants, utiles. Cette définition de la confiance, largement présente dans le monde professionnel, a des avantages et des limites.

- L’avantage majeur est qu’il n’y a pas confusion entre « confiance » et « affinité » ; une personne peut acheter un livre par amazon.com, car elle a confiance dans le système de paiement et de livraison, mais aucune affinité. Ne vous est-il jamais arrivé, impressionné par le professionnalisme d’un individu que vous n’aimez pas beaucoup, de dire « il est bon et je lui fais entièrement confiance, mais je ne passerais pas mes vacances avec lui ».

- La limite réside dans la prévision de rationalité : un individu confronté à un système complexe : environnement incertain, jeu de contraintes, choix difficiles, n’agit pas toujours de la façon qui était prévue et n’obtient pas toujours les résultats escomptés. Les freins à l’innovation se cachent dans ce domaine : un individu sera freiné dans ses idées et initiatives dès le départ, non pas à cause d’une analyse du projet, mais tout simplement parce qu’il dérange l’ordre établi.

La théorie de la rationalité en économie voudrait que les choix individuels s’appuient sur des raisonnements utilitaires :

- Si je préfère A à B et B à C, alors je préfère A à C ;

- Toute décision est fondée sur un calcul coût-bénéfice, ou sur une analyse de risque.

Dans la vraie vie, cette rationalité n’existe pas ! En effectuant leurs choix les hommes n’obéissent pas aux lois bayésiennes de la décision :

- ils accordent trop de poids à l’information qui leur est parvenue en dernier ;

- ils ne sont pas sensibles à la taille de l’échantillon, c’est même souvent l’inverse[2],

- ils réagissent plus à la forme qu’au fond.

La perspective sociale considère qu’un individu n’est pas évalué uniquement par ses résultats mais aussi en tant qu’acteur social ; il peut conforter les prévisions ou de les décevoir, à condition qu’il le fasse dans le respect de ses obligations morales et d’un certain nombre de codes.

Une intentionnalité limitée au champ d’interaction

Comme nous le constatons, le champ d’investigation est immense, mais on peut singulièrement le réduire si l’on accepte l’hypothèse d’une confiance limitée au domaine d’interaction ; je m’explique : lorsqu’on fait confiance à une autre personne, ce n’est pas dans l’absolu, c’est dans un domaine précis, qui est le champ d’interaction prévu ; ainsi une jeune adolescente qui accepte de sortir au cinéma avec son ami lui fait confiance par rapport à un certain nombre de critères ; ces critères ne sont pas les mêmes que ceux qui dicteront le choix du futur directeur général d’une firme internationale, ou encore d’un guide de haute montagne.

Nous nous limiterons ici à une analyse de la confiance dans un environnement professionnel (même si cette limite ne supprime pas complètement les facteurs affectifs et moraux, loin s’en faut), et principalement dans le champ de l’action collective au sein d’une communauté : travail en équipe, partage de connaissance, mutualisation de compétence, décision collective, process…

Si l’on prend soin de distinguer la confiance de l’affinité, alors on devine que, dans un groupe de travail ou une équipe, la confiance est en forte interaction avec la compétence : chaque membre fait confiance à un individu pour sa capacité à…

Alors la question devient : « comment créer dans une équipe les conditions de la confiance mutuelle ? »

Comment créer la confiance ?

L’approche de la compétence que propose R. Wittorski[3] nous renseigne sur le processus de création de confiance au sein d’un groupe ; selon lui, la compétence s’élabore à partir de cinq composantes :

La composante cognitive : elle est constituée de deux éléments : les représentations et les théories implicites (paradigmes) ; on distingue les représentations cognitives (savoirs et schèmes d’interprétation) et les représentations actives (construction par l’auteur du sens de la situation).

- La composante affective : c’est l’un des moteurs de la compétence. Elle regroupe trois éléments : l’image de soi (valorisation de notre personne), l’investissement affectif dans l’action (plaisir de ce que l’on fait), l’engagement (motivation). Le premier élément suggère à quel point elle est influencée par l’environnement social immédiat : un jugement positif ou négatif agira directement sur l’image de soi et aura pour effet de renforcer ou casser la motivation (voir l’effet Pygmalion ci-dessous).

- La composante sociale : elle représente la reconnaissance par l’environnement immédiat de la pratique de l’individu ou du groupe et aussi l’image que ces derniers se font de cette reconnaissance ; ce dernier point indique que la composante sociale comporte également le choix que l’acteur fera de « ce qui est montrable ». La stratégie du connaisseur n’est pas tant de connaître mais de faire savoir qu’il connaît.

- La composante culturelle : elle représente l’influence de la culture sociale sur les compétences.

- La composante praxéologique : elle renvoie à la pratique dont le produit fait l’objet d’une évaluation sociale ; il s’agit de la partie observable (évaluable) de la compétence.

L’effet Pygmalion

Nous opterons pour une approche mixte, à la fois rationnelle, sociale et affective de la confiance, c’est à dire l’ensemble des facteurs permettant la collaboration entre les membres d’une équipe, basées sur le respect mutuel, l’intégrité, l’empathie, la fiabilité. Les cinq composantes citées ci-dessus sont à la fois l’image de soi même, et l’image de soi vu à travers le regard des autres. Le groupe agit comme un miroir grossissant ; en psychologie, on appelle cela l’effet Pygmalion : "La prédiction faite par un individu A sur un individu B finit par se réaliser par un processus subtil et parfois inattendu de modification du comportement réel de B sous la pression des attentes implicites de A".

Il s’agit d’un mécanisme amplificateur en boucle : un jugement négatif de A casse la confiance de B en lui même, ce qui se voit et a pour effet de renforcer A dans son jugement négatif initial[4].

La confiance dans le partage de connaissances

Au cours de nos missions de Knowledge Management, nous avons pu interroger un certain nombre de professionnels de tous niveaux sur la question : « qu’est-ce qui favorise (ou empêche) le partage de connaissance dans un groupe de travail ? » Tous ont spontanément insisté sur le caractère primordial de la confiance dans une équipe et ils ont précisé les facteurs susceptibles de la créer :

1. Réciprocité (jeu gagnant-gagnant)

J’accepte de donner mes idées, mon ingéniosité, mon expérience au groupe, mais j’attends que les autres membres en fassent autant ; chacun veille à respecter un équilibre en faveur d’une performance collective. Ce mécanisme de surveillance exclut le « passager clandestin », c’est à dire celui qui à l’intention de recueillir les fruits du travail du groupe sans y avoir vraiment contribué.

2. Paternité (identité, reconnaissance)

J’accepte de donner une bonne idée à mon entreprise, et de voir cette dernière transformée en une innovation majeure ; mais je ne tolèrerais jamais de voir l’idée signée du nom de mon chef à la place du mien. Il s’agit d’un fort besoin de reconnaissance de la contribution d’un individu au sein d’un groupe.

3. Rétroaction (feed-back du système)

L’erreur est la première source d’apprentissage ; à condition d’avoir un feed-back du système.

L’enfant apprend par un processus répétitif de type essai-erreur-conséquence :

- essai : il faut que l’organisation encourage les initiatives, les « stratégies tâtonnantes » afin de développer l’autonomie et la créativité ; comment un enfant apprendrait t’il à marcher s’il avait peur d’être ridicule ?

- erreur : elle doit être documentée et communiquée (feed-back) ; la conséquence la plus immédiate sera d’éviter aux autres de la reproduire !

- conséquence : c’est le point le plus fondamental ; un système est apprenant dans la mesure où il délivre à l’individu le feedback sur son action, ce qui lui permet immédiatement d’évaluer l’impact de son action sur le système. C’est ce qui pose problème dans les très grandes organisations : l’individu peut faire tout et son contraire, dans la mesure où il n’a jamais de réponse du système , il ne saura jamais évaluer le bien-fondé de ses actions et progresser.

Dans un groupe, l’erreur doit être admise, c’est un signe très fort de la confiance et du fonctionnement effectif du groupe. En revanche on ne devrait jamais laisser quelqu’un la dissimuler.

4. Sens (unité de langage, de valeurs)

Une connaissance strictement personnelle ne peut être partagée que par l’utilisation d’un code et d’une syntaxe connue d’un groupe social, qu’il soit verbal ou non verbal, alphabétique ou symbolique, technique ou politique En faisant partie de la mémoire collective, le langage fournit à chaque individu des possibilités de son propre développement tout en exerçant un fort contrôle social sur lui. Ainsi, le langage est à la fois individuel, communicationnel et communautaire.

Mais ce n’est pas tant un problème de traduction que de sens : dans une conversation, deux interlocuteurs peuvent arriver à partager des mêmes points-de-vue s’ils établissent un processus de coopération : écoute active, participation, questionnement, adaptation sémantique, feed-back, reformulation. En effet, si le mot, comme symbole collectif, appartient à la communauté linguistique et sémantique, le sens qu’il recouvre est purement individuel car il est intimement lié à l’expérience et à l’environnement cognitif dans lequel se place l’individu.

La confiance, une construction incrémentale

Les auteurs et nos expériences s’accordent sur la nature incrémentale du processus de construction de la confiance ; dans certains domaines commerciaux, par exemple, on dit « il faut 10 ans pour gagner la confiance d’un client, et 10 minutes pour la perdre ! ».

Cette notion est largement étayée par le modèle de Tuckman qui voit quatre état chronologiques (ontologiques) majeurs dans le développement d’un groupe : formation, turbulence, normalisation, performance[5].

La confiance se construit, puis se maintient ; alors qu’il est difficile de distinguer un processus standard de construction de la confiance, en revanche, il semble qu’un modèle en 5 composantes puisse rendre compte de son maintien : instantanée, calculée, prédictive, résultat, maintien.

La confiance instantanée

A l’instant même de la rencontre, un individu accorde à l’autre un « crédit de confiance » ; c’est un processus instantané mais limité, peu fondé ni étayé, donc fragile, sous haute surveillance ; une sorte de confiance sous caution. C’est ce qui permet à des gens qui sont parachutés dans des groupes temporaires de pouvoir travailler ensemble, par exemple dans les équipes de théâtre ou de production cinématographique, dans les équipages d’avion, dans les staffs médicaux, etc.

Cette confiance se base principalement sur deux facteurs :

- On estime que les autres membres ont été sélectionnés par rapport à des critères de fiabilité, compétence, valeurs, etc. On a affaire à la notion de tiers-certificateur, dont on verra plus loin que le rôle peut être capital.

- On suppose qu’il y a réciprocité : si je n’accorde pas ma confiance à l’autre, alors l’autre en fera autant et il nous sera impossible de construire la moindre relation.

Ce type d’équipe se met très vite au travail et devient performant sans passer par les longues et progressives étapes de maturation.

La confiance calculée

Cette étape est franchie lorsque les acteurs attendent qu’une collaboration apporte un certain bénéfice. La confiance trouve alors sa source dans la conformité ou non de l’exécution d’une tâche collaborative particulière ; par exemple, la confiance d’un client dans une entreprise générale qui construit sa maison peut être assortie de mécanismes de contrôle et de clauses de pénalités de façon à maîtriser des dérives ou des comportements opportunistes.

L’une des façons de créer un climat de confiance est de mettre en place des procédures, comme la définition des rôles et responsabilités, des mécanismes de reporting, etc.

La confiance prédictive

Dans le process prédictif, la confiance est largement basée sur le fait que les acteurs se connaissent bien : ils se basent sur le comportement passé pour prédire le comportement à venir. Les acteurs qui n’ont pas la possibilité d’avoir des relations ou expériences communes réclameront des séances d’entraînement, des réunions ou d’autres dispositifs leur permettant de mieux se connaître.

La confiance basée sur le résultat

Dans ce mécanisme, la confiance est basée sur la performance de l’autre. Au départ, cette confiance dépend des succès passés ; elle sera encore renforcée si l’autre accomplit sa tâche avec succès, et rompue si des problèmes sont rencontrés. Ce mécanisme est particulièrement important dans les communautés virtuelles où les acteurs ne se connaissent pas, ne peuvent pas voir comment les autres travaillent ; ils ne peuvent juger que sur le résultat : délai, qualité des produits

La confiance intensive

Finalement la confiance intensive suppose que les deux parties identifient et acceptant les objectifs, finalités et valeurs de l’autre.

La confiance dans les communautés virtuelles

Le texte ci-dessous est le résultat d’une expérience menée avec quatre groupes d’étudiants devant effectuer une travail commun à distance en utilisant des outils de groupware et de visioconférence.

L’expérience a montré que la confiance jouait un rôle primordial dans la qualité du travail collaboratif et que l’usage d’un outil présentait de nombreux risques de sérieusement l’entamer, voire la détruire. Un certain nombre de comportements ont été révélés comme porteurs de danger :

- s’enflammer : s’énerver tout seul et se décharger dans un longue tirade écrite ;

- poser des requêtes ou assigner des tâches irréalisables ;

- ignorer les requêtes ; ne pas répondre à ses mails ;

- dire du mal ou critiquer quelqu’un ;

- ne pas remplir ses engagements.

Bien entendu on se doute que ce genre de comportement n’est pas fait pour améliorer la confiance, mais il se trouve que l’usage d’un outil les rend davantage possibles qu’une interaction physique. En effet, dans une conversation face-à-face, il se produit des sortes de micro-boucles qui ont la vertu de désamorcer des conflits par une meilleure compréhension des points-de-vue de chacun. La plupart des crises sociales sont des crises du langage et du sens.

Le tableau ci-dessous résume les facteurs qui renforcent ou au contraire diminuent l’établissement de la confiance dans une communauté.

La confiance est renforcée quand :

- La communication est fréquente, les membres sont bien informés et partagent leurs compréhensions.

- Les messages sont catégorisés ou formatés, ce qui permet aux récepteurs une économie de temps.

- Les tâches, rôles et responsabilités sont bien définis, chaque membre connaît ses propres objectifs.

- Les membres tiennent leurs délais et leurs échéances.

- Il y a un esprit positif permanent, chaque membre reçoit des encouragements et un feed-back.

- Les membres s’entraident mutuellement.

- Les attentes personnelles et celles du groupe ont été clairement identifiées.

- Les membres ont le même niveau d’engagement.

La confiance est affaiblie quand :

- Il y a peu de communication, les idées ne sont pas partagées.

- Les membres ne sont pas réactifs ; certains messages urgents restent sans réponse.

- Les objectifs n’ont pas été clairement définis.

- Les délais et livrables n’ont pas été clairement définis.

- L’esprit n’est pas positif et il n’y a pas de feed-back ou celui ci est systématiquement négatif.

- Les attentes personnelles et celles du groupe n’ont pas été identifiées.

- Les membres cherchent plutôt à esquiver, à éviter de contribuer.

- Les membres ne s’engagent pas vraiment.

Ces facteurs contribuent à une performance du groupe élevée ou faible, qui elle-même contribue par une boucle de retour à la motivation des acteurs pour coopérer. On peut parler d’une véritable spirale de la confiance.

La spirale de la confiance

A partir des différents éléments cités ci-dessus, on peut donc évoquer un processus cumulatif, une sorte de spirale, qui peut être positive ou négative :

- au départ, un acteur va contribuer au groupe sur la base d’une « confiance instantanée », donc forcément limitée ;

- en fonction de la contribution des autres, du côté positif du feed-back et éventuellement de la performance constatée, cet acteur sera incité à renforcer sa contribution.

En sens opposé, on peut vite imaginer comment se crée un « processus contre-productif » où la dimension sociale d’un groupe joue dans le sens contraire de la compétence individuelle et finit par démotiver complètement la personne. En d’autres termes, si on oppose une personne compétente à un système déficient, le système gagne à tous les coups.

La compétence individuelle, 6ème facteur de performance collective

Dans cet esprit, une étude nord-américaine a démontré que la compétence individuelle n’intervenait qu’en sixième position comme facteur de performance collective ; les spécifications des produits, le système organisationnel, les feed-back du système aux actions étant des préalables à l’efficacité collective :

- Spécifications claires (produit de sortie, standards )

- Support organisationnel (ressources, priorités, processus, rôles )

- Conséquences personnelles (reconnaissance des autres )

- Feedback du système (résultat d’une action)

- Savoir-être de l’individu (physique, mental, émotionnel)

- Compétence et savoir individuel

Cela tend à montrer que les dispositifs de formation professionnelle sont certes nécessaires, mais qu’il peuvent être très dispendieux s’ils ne s’inscrivent pas dans une démarche globale, incluant une refonte des organisations (modes de fonctionnement de l’équipe, management), du système d’évaluation et de reconnaissance (objectifs, réalisation, évaluation de la performance), des processus (modélisation des tâches et des compétences), des spécifications produits.

Les conventions du travail collaboratif

Revenons à nos équipes virtuelles ; il semblerait qu’un certain nombre de conventions ou protocole favorisent l’établissement d’un niveau de confiance suffisant pour un travail collaboratif efficace. Ces conventions se regroupent en cinq catégories :

- Catégorie : Intégrité

- Caractéristiques : honnêteté, éthique, loyauté, respect, fiabilité et engagement

- Facteurs et comportements : être honnête, tenir ses engagements,être réactif, être droit et loyal, être fiable

- Catégorie : Habilitation

- Caractéritiques : savoirs, savoir-faire, compétences individuelles et collectives

- Facteurs et comportements : mettre en application avec succès les savoirs, compétences, partager les expériences, les bonnes pratiques

- Catégorie :Ouverture

- Caractéristiques : volonté de partager des idées et des informations, intérêt aux autres, apprendre des erreurs

- Facteurs et comportements : informer les autres,partager librement les idées et les informations, être curieux,donner un feed-back positif,reconnaître ses erreurs

- Catégorie : Charisme

- Caractéristiques :empathie, envie de bien faire, bonne volonté, générosité

- Facteurs et comportements : s’entraider,être amical, être courtois,avoir de la considération,rester humble,savoir apprécier le travail des autres

- Catégorie : Attentes

- Caractéristiques : bénéfice potentiel, cohérence, évaluation

- Facteurs et comportements : être à l’écoute des attentes, rechercher un consensus ou des compromis, rester cohérent sur les attentes

Ce qui est important dans cette énumération de facteurs, c’est qu’ils n’ont pas tous la même importance par rapport au processus cumulatif de construction de la confiance :

- Certains sont mineurs, ils seront corrigés en temps réel : quelqu’un oublie de communiquer une information, le groupe lui fait remarquer, il s’en excuse ; c’est une mise au point nécessaire.

- Certains sont « proportionnels » : tout le monde n’a pas le même charisme et cela n’empêche pas forcément un groupe de fonctionner.

- Certains sont majeurs et définitifs : c’est notamment le cas des facteurs regroupés dans la catégorie « intégrité » ; une trahison sera perçue comme une atteinte définitive à la confiance.

Conclusion : le rôle de la confiance dans la connaissance collective

Une fois admis que la subjectivité, l’affectif, l’émotion, gouverne nos représentations individuelles, on conçoit que le processus de construction collective d’une représentation passe nécessairement par une étape de mise en commun des perceptions, de confrontation, de négociation et de délibération de ces différentes subjectivités. Ce processus nécessite des qualités humaines d’empathie, de « reliance »[6] davantage que des capacités d’analyse.

En ce sens, l’organisation n’est pas tant un système de « traitement de l’information » mais bien de « création de connaissance collective ». C’est là que réside l’enjeu humain du Knowledge Management.

Du Knowledge Management au knowledge enabling

Partant de ces considérations sur la nature de la connaissance, profondément engrammée dans l’individu en tant que sujet, on peut en déduire qu’on ne manage pas la connaissance, comme on manage un objet ; le terme Knowledge Management, que j’utilise volontiers, est en fait un abus de langage ; tout au plus peut on manager les conditions dans lesquelles la connaissance peut se créer, se formaliser, s’échanger, se valider, etc. Les anglo-saxons parleraient de knowledge enabling.

Cela permet également d’introduire une précision fondamentale : le management de la connaissance collective est avant tout une problématique de flux ; ce qui est important c’est de manager les transitions entre tous les états de la connaissance : tacite, implicite, explicite, individuel, collectif, etc. Tous les outils du KM (socialisation, formalisation, médiatisation, pédagogie) doivent se focaliser sur l’optimisation de ces flux de transition.

Si j’ai demandé l’autorisation à son auteur d’exhumer et reproduire ici-même un de ses articles pourtant déjà vieux de presque dix ans, c’est parce qu’il touche à une notion simple mais essentielle : la confiance.

Si j’ai demandé l’autorisation à son auteur d’exhumer et reproduire ici-même un de ses articles pourtant déjà vieux de presque dix ans, c’est parce qu’il touche à une notion simple mais essentielle : la confiance. Tout le monde connaît ou tout du moins a déjà entendu parler du

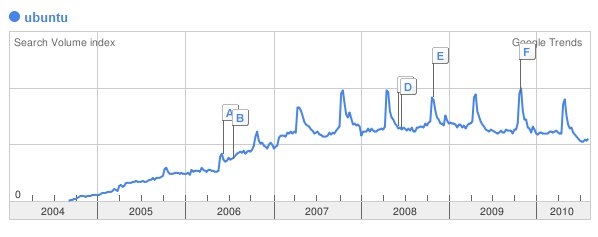

Tout le monde connaît ou tout du moins a déjà entendu parler du

Il est trop rare que nous évoquions le système d’exploitation libre

Il est trop rare que nous évoquions le système d’exploitation libre  Le petit garçon s’ennuyait tout seul chez lui.

Le petit garçon s’ennuyait tout seul chez lui.