La dégooglisation du GRAP, partie 3 : Le bilan

On vous a partagé la semaine dernière la deuxième partie de La dégooglisation du GRAP qui vous invitait à découvrir comment iels avaient réussi à sortir de Google Agenda et gmail. Voici donc la suite et fin de ce récit palpitant de dégooglisation. Encore merci à l’équipe informatique du GRAP d’avoir documenté leur démarche : c’est vraiment très précieux ! Bonne lecture !

Dans l’épisode précédent…

Après la sortie de Google Drive remplacé par Nextcloud, Google Agenda par Nextcloud Agenda, nous avons fini par le plus gros bout en 2021-2022, sortir de Gmail et en finir avec le tentaculaire Google.

Le mardi 23 novembre, nous débranchions enfin Google. Nous voilà libres ! Presque 😉

Bilan dégooglisation

Après 4 ans de dégooglisation, où en sommes-nous de notre utilisation de logiciels non libres ?

Dans l’équipage ⛵

| Système d’exploitation | Libre ? | Commentaire |

| Windows | ❌ | 13 personnes |

| Ubuntu | ✅ | 9 personnes |

| Gestion documentaire et travail collaboratif | ||

| Nextcloud Files | ✅ | Tout le monde depuis 2020 ✅ |

| Nextcloud Agenda | ✅ | Tout le monde depuis 2021 ✅ |

| Téléphonie et visio | ||

| 3CX | ❌ | Tout le monde ❌ |

| Nextcloud Discussions | ✅ | |

| Mail et nom de domaine |

||

| Gandi |

✅ | Tout le monde depuis 2022 ✅ |

| Logiciels métier | ||

| Odoo (suivi des actis, achat/revente, facturation) |

✅ | Pôles info, accompagnement et logistique |

| EBP (compta) |

❌ | Pôle compta |

| Cegid (paie) | ❌ | Pôle social |

| Gimp, Inkscape, Scribus (graphisme et mise en page) |

✅ | Pôle communication |

| BookstackApp (documentation) | ✅ | Tous pôles |

| Logiciels bureautique | ||

| Suite Office | ❌ | |

| Suite LibreOffice | ✅ | |

| Réseaux sociaux | ||

| Facebook, Linkedin, Twitter, Eventbrite | ❌ | |

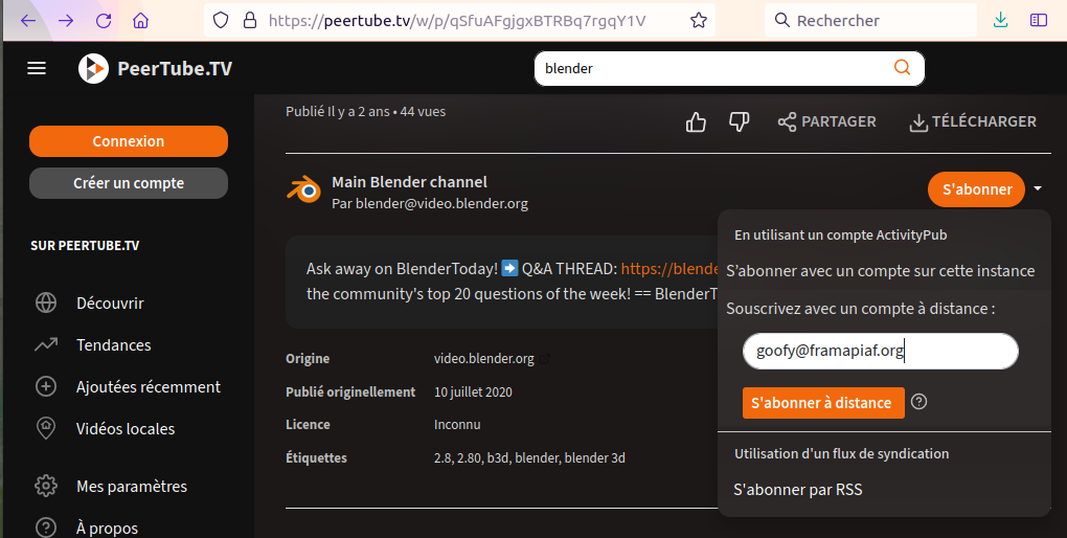

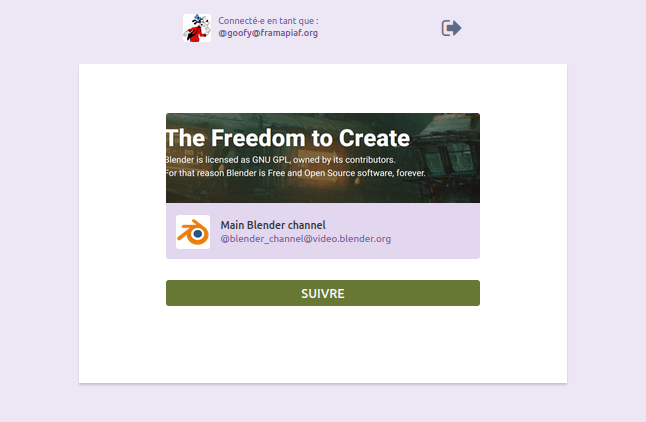

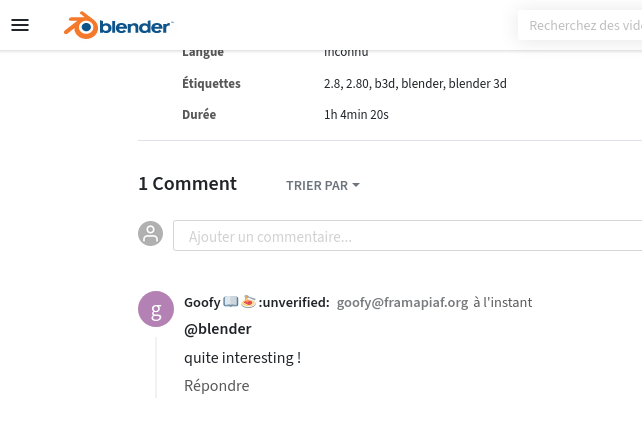

| Peertube | ✅ |

Nos pistes d’amélioration en logiciel libre sont donc du côté du système d’exploitation et des logiciels métiers.

Les blocages sont dus :

- à certains logiciels métiers qui n’existent pas en logiciel libre

→ à voir si on arrive à développer certains bouts métier sur Odoo dans les prochaines années - à la difficulté de se passer d’Excel pour certaines personnes grandement habituées à ses logiques et son efficacité

→ à voir si LibreOffice continue à s’améliorer et/ou si on se forme plus sur LibreOffice

Dans la coopérative 🌸

| Système d’exploitation | Libre ? | Commentaire |

| Ubuntu | ✅ | Dans tous les points de vente ordinateurs portables |

| Windows ou Mac | ❌ | Les autres ordinateurs portables |

| Gestion documentaire et travail collaboratif | ||

| Nextcloud Files | ✅ | Tout le monde y a accès depuis 2020 ✅ |

| Fournisseur mail principal |

||

| Gandi |

✅ | 55% |

| Gmail | ❌ | 37% |

| Ecomail | ? | 4% |

| Logiciels métier | ||

| Odoo (achat, revente, stock, facturation, intelligence décisionnelle) |

✅ | Utilisé par 95% des activités |

| Autres |

❌ ✅ | Dur à dire, mais la majorité des activités de transformation utilise des tableaux Excel ou des logiciels dédiés |

| Logiciels bureautique | ||

| Suite Office | ❌ | Pas de référencement fait. Aucune visibilité actuellement |

| Suite LibreOffice | ✅ |

Nos pistes d’amélioration sont donc du côté des logiciels mails et des logiciels métiers.

→ Un des gros chantiers de 2022-2023 est justement le développement et la migration sur Odoo Transfo. Pas pour le côté politique du logiciel libre mais bien de l’amélioration continue d’un même logiciel partagé dans la coopérative.

→ À voir si la dégooglisation de l’équipe « inspire » certaines activités pour se motiver à se dégoogliser. Nous serons là pour les accompagner et continuer à porter le message à qui veut l’entendre.

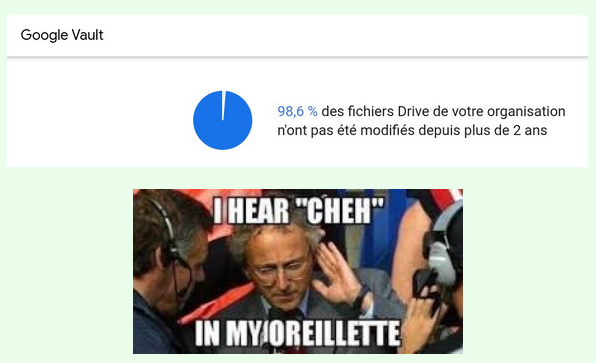

Bilan humain

À l’heure où nous écrivons (fin octobre 2022), il est trop tôt pour faire le bilan de la sortie de Gmail. Nous comptons d’ailleurs envoyer un nouveau questionnaire dans quelques mois qui nous permettra d’y voir plus clair. Mais nous pouvons d’ores et déjà dire que ce fut clairement l’étape la plus compliquée de la dégooglisation.

Sortir d’un logiciel fonctionnel, performant et joli est forcément compliqué quand on migre vers un logiciel aux logiques différentes (logiciel bureau VS web par exemple) et qui souffre de la comparaison au premier abord. Pour compenser cela, nous avons fait le choix de dédier beaucoup de temps humains (nombreuses formations par mini groupes ou en individuels, réponses rapides aux questions posées) et beaucoup de documentations et de partage de retour d’expériences.

La sortie de Google Drive et Google Agenda furent relativement douces et moins complexes que Gmail. Le logiciel Nextcloud étant assez mature pour assurer un changement plutôt simple et serein.

Ça paraît simple une fois énoncé, mais plus les gens travaillent avec un outil (Google par exemple), plus il sera difficile de les amener à changer facilement d’outil.

Conseil n°5 :

Dans la mesure du possible, la meilleure des dégooglisation est celle qui commence dès le début, par l’utilisation d’outils Libres. En 2022, quasiment tout logiciel a son alternative Libre mature et fonctionnel.

Si ce n’est pas possible, dès que les moyens humains sont disponibles et que la majorité le veut, envisagez votre dégooglisation ?

À Grap, il existe une certaine culture politique de compréhension autour des enjeux du logiciel libre et des GAFAM. Cela nous a aidé. Et cela nous parait quasiment obligatoire avant d’envisager une dégooglisation. Car c’est un processus long où l’on a besoin du consentement – au moins théorique – des gens impactés pour que celleux-ci acceptent de se former à de nouveaux outils, s’habituer à de nouvelles habitudes etc.

Conseil n°6 : avant d’entamer une dégooglisation, faire monter en compétences votre groupe sur les sujets autour du Logiciel Libre et des enjeux des Gafam à travers des projections de films par exemple.

Voici un récap de quelques ressources.

Bilan technique

Voici nos choix de logiciels pour notre dégooglisation :

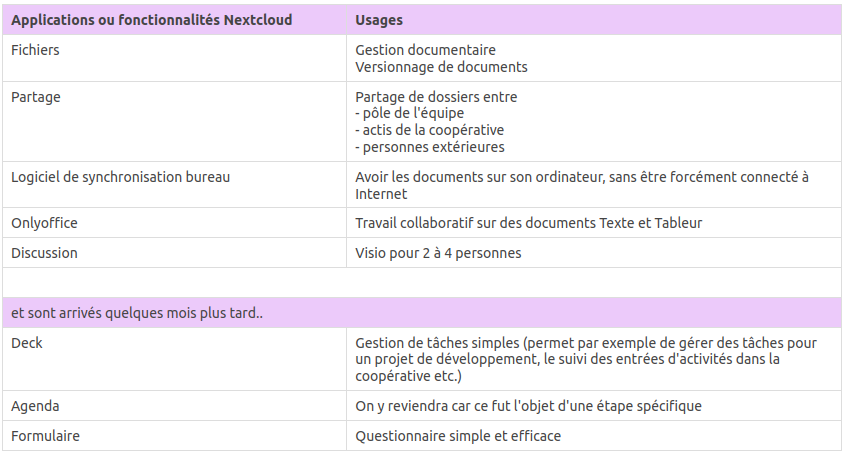

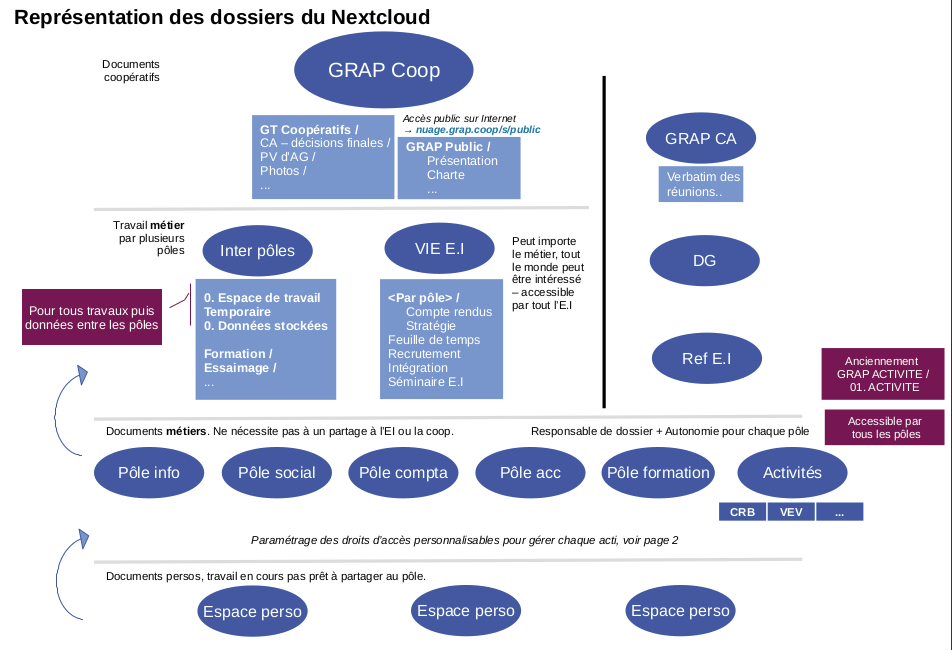

- Nextcloud pour la gestion documentaire et le travail collaboratif (agenda, visio, gestion de tâches)

- complété par Onlyoffice avec une image Docker sans limitation d’usage (pendant 2 ans l’image

nemskiller007/officeunleashedpuis désormaisalehoho/oo-ce-docker-license) - sauvegarde quotidienne par le logiciel de sauvegarde Borg

- complété par Onlyoffice avec une image Docker sans limitation d’usage (pendant 2 ans l’image

- BookstackApp et Peertube pour la documentation écrite et vidéo

- Meshcentral pour la prise en main à distance d’autres ordinateurs

- Gandi pour le prestataire de mails

- Thunderbird pour le logiciel bureau pour gérer ses mails (et K9Mail sur téléphone)

Voici nos choix d’infrastructure :

- OVH et Online pour la location de serveurs faisant tourner ses services (choix historique)

- 4 serveurs :

- 1 serveur dédié Nextcloud de 2To (Gamme Start-1-L Intel Xeon E3 1220v2 @3,1 Ghz, 16Go RAM)

- 1 serveur dédié Nextcloud Test en miroir du Nextcloud

- 1 serveur de sauvegarde (mutualisé avec d’autres services de la coopérative)

- 1 serveur dédié à différents services (Peertube, Meshcentral, Bookstackapp)

Bilan économique

Pour calculer le coût économique de notre dégooglisation commencé en 2018, voici les chiffres retenus.

☀️ Le scénario « Dégooglisation » est celui réellement effectué depuis 2018.

Son coût comprend :

- le temps de travail du service informatique, découpé en

- l’aide au collègue habituelle : qui subit une augmentation du fait de l’internalisation de certaines questions, notamment avec le changement de Gmail à Thunderbird

- le support et administration système des services :

- toutes les recherches techniques (comment bien gérer les installations, sauvegardes etc.)

- toutes les questions / réponses par mail et téléphone

- le « temps de dégooglisation » qui correspond

- les temps d’écriture de documentation et de formation

- les mails d’annonce, de relance, de re-re-relance 😉

- le coût des serveurs informatiques pour faire tourner les logiciels remplaçant les services Google et Teamviewer

🤮 À l’opposé, le scénario Google comprend :

- le temps de travail du service informatique sur l’aide au collègue – accès stable dans le temps – qui augmente par le nombre de gens dans l’équipe, mais diminue par notre appropriation des logiciels, améliorations de l’existant, documentation etc.

- la facturation des comptes Google Workspace

- stable depuis 2018, Google a annoncé cet été l’augmentation de ces prix. Les pauvres n’ont eu que 6% de croissance en 2022 avec 14 milliards de dollars de bénéfices. Passant donc les comptes pro de 4€ à 10,40€/mois à partir de juin 2023.

- la facturation hypothétique (car elle n’a jamais eu lieu) de Teamviewer Pro

- En effet, jusqu’à juin 2019, nous utilisions Teamviewer pour aider les activités de la coopérative à distance. Mais notre utilisation intensive ne rentrait plus dans la version gratuite et Teamviewer nous bloquait l’usage du logiciel pour que l’on souscrive à leur abonnement.

- Heureusement, nous sommes passés sur des logiciels auto-hebergés et libre : RemoteHelp (un logiciel libre abandonné depuis) puis en décembre 2020 sur Meshcentral.

En prenant en compte ces données, le scénario « Dégooglisation » finit par devenir moins cher que le scénario « Google ».

Pour le coût mensuel, cela arrive dès septembre 2022 (quasi à la fin de la sortie de Gmail donc) ! 🎉

Pour le coût cumulé, cela devient rentable deux ans après, en septembre 2024 ! 🎉

Ces chiffres s’expliquent par :

- le coût important au démarrage de la sortie de Google Drive

- 128h passées sur les 5 premiers mois pour valider la solution Nextcloud

- un temps de support / administration système pour Nextcloud qui baisse progressivement

- passant de 14h mensuels en 2019, à 9h en 2020, à 5h en 2021, à 3h en 2022

- le prix de Google qui aurait augmenté (mais on y a échappé avant, ouf !)

Bilan politique

Nous sommes fièr·es en tant que coopérative de porter concrètement nos valeurs dans le choix de nos logiciels qui sont plus que de simples outils.

Ces outils sont porteurs de valeurs démocratiques très fortes. Nous ne voulons pas continuer à engraisser Google – et autres GAFAM – de nos données privées et professionnelles qui les revendent à des entreprises publicitaires et des états à tendance anti-démocratique (voir les révélations Snowden, le scandale Facebook-Cambridge Analytica). Cela est en contradiction avec ce que nous prônons : la coopération, de l’entraide et le lien humain.

Nous avons besoin d’outils conviviaux, modulables et modifiables selon qui nous sommes. Nous avons besoin de pouvoir trifouiller les outils que nous utilisons, comme nous pouvons trifouiller un vélo pour y réparer le frein ou y rajouter un porte-bagages. Des outils émancipateurs en somme, qui nous empouvoire et ne rendent pas plus esclave de la matrice capitaliste.

Notre démarche n’aurait pas pu avoir lieu sans le travail et l’aide de millions de personnes qui ont construit des outils Libres, des documentations Libres, des conférences et autres vidéos Libres. Elle n’aurait pas eu lieu non plus sans l’inspiration de structures comme Framasoft ou la Quadrature du Net. Merci.

🍎 La route est longue, la voie est libre, et sur le chemin nous y cueillerons des pommes bios et paysannes. 🍏

Encore un grand merci aux informaticiens du GRAP pour leur travail de documentation sur cette démarche. D’autres témoignages de Dégooglisation ont été publiés sur ce blog, n’hésitez pas à prendre connaissance. Et si vous aussi, vous faites partie d’une organisation qui s’est lancée dans une démarche similaire et que vous souhaitez partager votre expérience, n’hésitez pas à nous envoyer un message pour nous le faire savoir. On sera ravi d’en parler ici !