Dans les ateliers libres du futur tout objet produit est en bêta

Il y a de l’espoir. Qu’on les appelle fab lab ou, comme ici, open source workshops, il se passe véritablement quelque chose dans le monde matériel actuellement. Quelque chose qui localement nous donne envie de nous retrouver pour créer ensemble et donner du sens à cette production[1].

Dans ce monde en gestation, certains mots comme compétition, délocalisation, marketing, argent, banque, normalisation… s’estompent pour laisser place à un vivre ensemble potentiel qui sonne moins creux que dans la bouche des politiciens.

Il en aura fallu passer par internet, et par l’expérience virtuelle probante de projets collaboratifs comme le logiciel libre ou Wikipédia, pour en arriver là. Là c’est-à-dire en des lieux où il ne tient qu’à nous de faire pousser nos propres ateliers libres, tel l’Open Design City de Berlin dont nous vous racontons l’histoire ci-dessous.

Comme le dit Stallman lorsqu’il nous salue : « Happy Hacking! »

Un aperçu du futur du « Do It Yourself » : les ateliers libres – Tout produit est en bêta !

A Peek at the Future of DIY: Open-source Workshops – Every product is beta!

Jude Stewart – 4 octobre 2010 – Fast Co Design

(Traduction Framalang : Lolo le 13, Goofy, Julien, Mammig et Martin)

Le « faites-le vous-même » (NdT : Traduction littérale et non satisfaisante du DIY pour Do It Yourself) règne en maître dans le monde virtuel. Nous pouvons en effet aujourd’hui construire librement et sans trop de frais nos propres blogs, e-books et magazines Web. Par contre fabriquer des choses réelles, palpables et tangibles semble être le domaine réservé de ceux qui savent s’y prendre avec un marteau et des clous.

Ce n’est pourtant plus le cas désormais. La révolution open source est en train de mettre la conception des produits entre les mains de tout un chacun. Prenez l’Open Design City (ODC) basé à Berlin. C’est un atelier dans lequel n’importe qui peut apprendre à faire à peu près n’importe quoi, du portefeuille en bioplastique à la lampe à pull-overs (cf ci-dessous). La recette est simple comme un sourire : rassemblez des personnes qui veulent partager des idées et collaborer, apprennez-leur à utiliser quelques machines-outils, puis faites des choses sympas ensemble.

C’est un mouvement qui peut potentiellement se substituer à la manière traditionnelle de concevoir et fabriquer industriellement des objets, voire même changer notre mode de consommation. « Je crois fortement que nous verrons émerger de plus en plus d’espaces comme celui-ci » dit Christoph Fahle d’Open Design City. « Nous ne sommes pas à proprement parler dans du développement scientifique, parce que pour que cela marche, il n’y a pas besoin d’expert en balistique. Il s’agit plutôt de favoriser les interactions sociales permettant de créer de nouvelles choses. Si vous regardez Facebook, ce bien moins sa technologie qui a influencé les usages que l’idée du réseau social

Les ateliers ouverts sont une conséquence et un prolongement de la fièvre que connaît actuellement le Do It Yourself. Il y a beaucoup de ressources et d’énergie sur des sites comme MAKE, Instructables.com et IKEAhacker ou de réseaux de vente comme Etsy et Supermarket. Aujourd’hui les gens peuvent acheter leurs propres imprimantes 3D pour moins de 1 000 $.

Le co-fondateur Jay Cousins est arrivé dans Open Design City par une voie détournée. Il était un concepteur de produits haut de gamme spécialisé dans ce qu’il appelle la vaisselle et il fut déçu de cette expérience. « Ce travail s’est transformé en piège, tout devenait management au lieu d’être créativité » se souvient-il. « C’est ce qui m’a fait penser en un lieu où les concepteurs et les inventeurs se retrouvent ensemble pour participer à la production. » À la recherche d’une nouvelle inspiration, Jay Cousins a déménagé à Berlin en 2009 et a attéri à Palomar 5, un espace innovant sponsorisé par Deutsche Telecom (malgré son nom qui sonne très hippie). À Palomar 5, « nous avons beaucoup observé comment nous nous collaborions » dit Jay Cousins. « Vous entrez dans un intense conscience de ce qui vous soutient dans votre énergie créative et de ce qui vous bloque ». Là-bas, il rencontra Christopher Doering, un concepteur produit qui est passé par la Bauhaus University de Weimar.

Après ces six semaines à Palomar 5, tout deux eurent envie de créer leur propre atelier ouvert. La fortune souriant aux audacieux, l’occasion de présenta et, au cours du printemps dernier, Jay Cousins et Christopher Doering mirent sur pied un atelier DoIt Yourself à Betahaus, un nouvel espace de travail collaboratif dans le quartier Kreuzberg de Berlin, Open Design CIty était né.

À Open Design City les travailleurs du premier étage peuvent déambuler au rez-de chaussée et louer des outils à l’heure ou au jour. Ils peuvent participer à un atelier ouvert dans lequel un responsable enseigne au groupe une technique particulière puis ouvre l’étage aux expérimentations.

L’équipement mis à leur disposition des participants est vaste. Ils peuvent ainsi faire joujou avec des outils (scies, scies sauteuses, marteaux…), un sérigraphe pour les textiles, du matériel photographique, des plaques électriques et un évier, de la laine, du savon et du papier-bulle pour faire du feutre, un stock généreux de fécule, de vinaigre et de glycérine qui une fois mélangés avec de l’eau et chauffés font un bioplastique modelable et modulable.

Peu d’outils sont véritablement high-tech mis à part une imprimante 3D qui imprime en pressant de fines couches de certains matériaux et qui est capable de produire une forme en utilisant les données en trois dimensions que l’utilisateur lui donne. Une telle machine ressemble à un four : une fine couche de nylon est chauffée jusqu’à ce qu’elle s’amolisse puis est injectée dans un moule dans lequel elle se durcit à nouveau. Open Design City n’a pas de découpage laser ou d’autres outils similaires permettant de le qualifier pleinement de « fablab ».

La grosse partie de l’équipement provient des dons. « Un type a un jour acheté une tonne de briques Légo blanches en choisissant d’en offrir quelques uns à l’atelier » dit Fahle.

Apprendre à utiliser l’équipement est d’ordinaire la partie la plus difficile.

Doering se souvient d’un membre de l’ODC, une responsable de communication née en Iran qui travailait au betahaus. Elle voulait faire des énormes lettres en polystyrène expansé pour écrire des slogans lors d’un événement de soutien à la résistance iranienne (cf ci-dessous). Après avoir fait faire des devis « incroyablement cher » dans un atelier de prototypage traditionnel, elle est venue à l’ODC pensant qu’elle pourrait expliquer son projet et ensuite le laisser entre des mains plus expertes. Eh bien non. « Nous avons fait un marché : qu’elle nous aide à acheter une machine pour couper le polystyrène et on lui enseignera alors (à elle et à ses amis) comment l’utiliser » explique Doering. « Au début, elle ne cessa de répéter : Ce n’est pas possible ! Comment pourrai-je faire ça ? Mais une fois que nous avions passé 15 minutes ensemble, elle a vu comment c’est vraiment amusant et facile à faire. Elle et ses amis se sont totalement éclatés à faire ça. Ils ont passé une semaine à couper comme des dingues, monter une fausse prison en briques et inventer une méthode pour joindre les lettres. Tout ce dont il y avait besoin était ce petit coup de pouce de départ. »

Open Design City enourage une méthode parallèle de travail qui compose avec les égos et promeut le sens du jeu. Cousins explique : « Si je crois qu’un projet doit être réalisé d’une certaine manière et Chris a une idée différente, au lieu de nous disputer pour savoir laquelle est la meilleure, nous essayons les deux méthodes en même temps et partageons ce que nous apprenons au fur et à mesure. »

Est-ce que le talent ou l’expérience importe dans ce meilleur des mondes ? Oui et non.

Doering aime la façon dont les ateliers ouverts comme Open Design City remettent en question l’idée même de qualité (d’autant que c’est le sujet de sa thèse au Bauhaus). « La qualité doit toujours répondre à certains critères objectifs, bien sûr », explique-t-il, « la culture industrielle dit : voici un produit pour une certaine utilisation et qui a une certaine valeur. Mais les objets aiment à s’échapper des carcans. Il est totalement limitant de dire : c’est une lampe, son but est de remplir l’espace avec de la lumière. Parce que c’est aussi un cadeau de votre grand-mère, c’est une touche personnelle dans votre living-room, etc. et il faut conserver cette flexibilité-là. »

Il a pris une feuille de plastique d’amidon sur l’établi et il l’a brandie. « C’est un biopolymère. Ce n’est pas résistant à l’eau et je ne sais pas combien de temps cela peut tenir en état, un an, peut-être. Voilà au contraire ce qui se passe avec les plastiques à base de pétrole : ils durent éternellement et ce n’est pas une bonne façon de penser. Nous n’aimons pas nos produits aussi longtemps ».

La valorisation des déchets (NdT : upcycling), qui récupère de vieux produits pour les recombiner dans de nouveaux objets désirables, est au programme de futurs événements de l’ODC.

Tout cela résonne furieusement anti-industriel — et d’un certain côté c’est bien le cas.

Mais en tant que concepteur produit et pionnier du mouvement Open Design, Ronen Kadushin nous rappelle que renverser la structure du pouvoir dans l’entreprise n’est pas le but. « Vous connaissez le vieux proverbe romain à propos de la hache de votre grand-père ? » dit-il. « Mon père a changé son manche et j’ai changé la lame. Rien de ce que j’ai dans la main ne vient de mon grand-père, mais c’est toujours la sienne. C’est une tradition de valeur. Nous n’avons désormais plus d’objets qui remplissent ce besoin ; nous n’avons pas de hache. La meilleure façon de rester attaché à un produit ou un objet est de le faire soi-même. »

Vers quel avenir pourrait nous mener la fabrication libre de tels produits ?

Vers un Moyen Âge dopé au silicium, répondent Doering, Fahle et Cousins, dans lequel des artisans seraient connectés « localement » avec toute la planète grâce à internet. « Une telle perspective est un peu régressive, en fait » admet Cousins. « Elle nous ramène à l’ère du boulanger, du fabricant de meubles, du spécialiste en électronique, de votre homme à tout faire — un système distribué dans lequel nous reconnaissons mutuellement nos compétences, et les valorisons. Nous ne pouvons plus nous permettre de prendre un objet et de déclarer : « il est 100% éthique, personne n’a été blessé, aucune communauté n’a été décimée au cours de sa fabrication » parce que c’est trop complexe à gérer et non satisfaisant puisque nous demeurons passifs. Diffuser et partager la connaissance de la fabrication d’objets au sein de la communauté ODC nous apporte de la résilience tout en nous permettant de mieux nous débrouiller seuls ».

« Mais ce n’est pas seulement une question de survie », poursuit Cousins, « Nous luttons pour nous reconnecter à une communauté et une culture de la participation. C’est un lien très puissant qui s’est progressivement étiolé au cours de ces cent dernières années ». Le paradoxe n’est qu’apparent : les déchets de la révolution industrielle devenant le matériau brut pour des ateliers de type médiéval, un mouvement rendu possible par un Internet massivement collaboratif, une population lassée de vivre virtuellement, et des machines dont le prix s’est démocratisé grâce à une base de consommateurs désireuses d’acheter de nouveaux moyens de production. Ce qui est vieux redevient alors réellement nouveau.

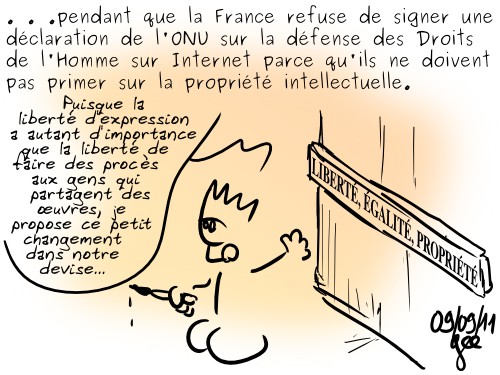

Les institutions européennes, toujours promptes à donner la leçon, ont peut-être d’autres chats à fouetter actuellement mais il nous semble bon de leur rappeler un passé peu glorieux et un présent scandaleux[

Les institutions européennes, toujours promptes à donner la leçon, ont peut-être d’autres chats à fouetter actuellement mais il nous semble bon de leur rappeler un passé peu glorieux et un présent scandaleux[ Les mots ont un sens, et ce n’est pas notre

Les mots ont un sens, et ce n’est pas notre  Voilà, on y est. Après la musique, c’est désormais la sphère du livre qui est pleinement impactée, voire bousculée, pour l’arrivée inopinée et intempestive du numérique.

Voilà, on y est. Après la musique, c’est désormais la sphère du livre qui est pleinement impactée, voire bousculée, pour l’arrivée inopinée et intempestive du numérique. Je travaille depuis quatre ans avec David Dauvergne au développement d’un logiciel libre pour les éditeurs,

Je travaille depuis quatre ans avec David Dauvergne au développement d’un logiciel libre pour les éditeurs,

En visite en Angleterre, voici ce que disait le patron de Google dans une

En visite en Angleterre, voici ce que disait le patron de Google dans une