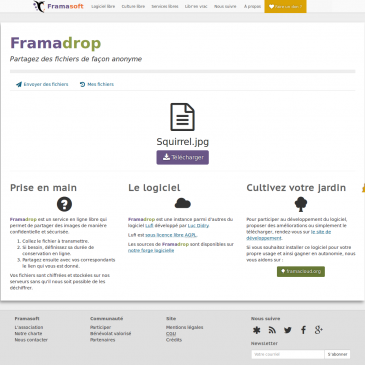

Framadrop : envoyez de gros fichiers en toute sécurité !

Envoyer un email, c’est bien. Mettre en pièce jointe l’ensemble de ses photos de vacances c’est… trop volumineux. Au mieux, vous remplirez la boite email de vos destinataires en moins de temps qu’il en faut pour dire “Tux” ; au pire, … Lire la suite