Argos Panoptès, l’interview

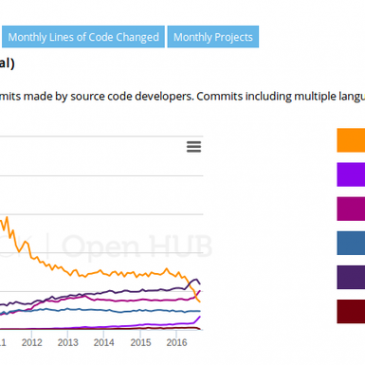

Pour Framaspace, Framasoft a fait développer un outil de supervision de sites web nommé Argos Panoptès (ou juste Argos pour aller plus vite). Développé par Alexis Métaireau, développeur entre autres du générateur de site statique Pelican, et de l’outil de … Lire la suite