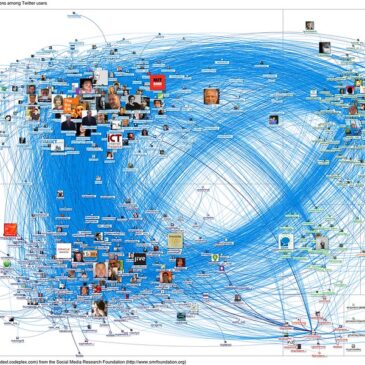

Le X de Musk n’est pas une inconnue…

L’actualité récente nous invite à republier avec son accord l’article de Kazhnuz sur son blog (il est sous licence CC BY-SA 4.0) qui souligne un point assez peu observé de la stratégie d’Elon Musk : elle n’est guère innovante et ne … Lire la suite