François Elie est co-fondateur et président de l’Adullact[1] ainsi que vice-président de l’Aful[2], professeur agrégé de philosophie et élu de la ville et de l’agglomération d’Angoulème dont il a été longtemps en charge des nouvelles technologies.

François Elie est co-fondateur et président de l’Adullact[1] ainsi que vice-président de l’Aful[2], professeur agrégé de philosophie et élu de la ville et de l’agglomération d’Angoulème dont il a été longtemps en charge des nouvelles technologies.

Vous comprendrez alors aisément pourquoi lorsqu’a été mis en ligne le rapport Fourgous Réussir l’école numérique[3] (dont nous avons publié ici-même quelques libres extraits), nous lui avons demandé son avis, qui a pris la forme d’une note de lecture que nous vous proposons ci-dessous.

François Elie est également l’auteur du livre Économie du logiciel libre[4] dont la première phrase annonce la couleur : « Cet ouvrage s’adresse à ceux qui font, vendent, utilisent ou achètent du logiciel libre, c’est-à-dire tôt ou tard… à tout le monde ».

Et puis l’on se souvient de sa lettre aux candidats à l’élection présidentielle de 2007[5]. Elle reste plus que jamais d’actualité. Mais nous en sommes déjà à mi-mandat et le constat est là. « En vous demandant de prendre la mesure des enjeux du développement du logiciel libre pour la France, j’écris ces mots en tremblant: l’avenir en effet nous jugera. Ceux qui pouvaient agir et ne l’auront pas fait porteront une lourde responsabilité devant l’histoire ».

Le rapport Fourgous est une belle occasion d’agir, a fortiori si l’on prend ces quelques notes en considération.

Remarque : Vous pouvez également voir sur le Framablog cette interview de François Elie réalisée par Intelli’n TV à l’occasion de la sortie de son livre.

Notes de lecture du rapport Fourgous par François Elie

Précaution

Même si je suis un geek, très loin d’être un technophobe, je crois pour d’assez fortes raisons comme Alain que « l’enseignement doit être résolument retardataire »[6] (relire les Propos sur l’éducation). On ne commence pas par la fin !

Pour ce qui nous occupe, ce qu’il faut craindre, ce sont les séductions du numérique. Apprendre le clavier avant de savoir écrire ? Non ! L’école doit éclairer et exercer l’esprit. Elle doit nous rendre libres, et non nous habituer/enchaîner à telle ou telle interface. Alors on aurait peut-être du parler de l’école à l’ère du numérique. Mais cela n’a pas d’importance si ce n’est qu’affaire de mots. Disons qu’il faut vraiment craindre l’école numérisée.

Le numérique ?

Je n’ai pas vu que le rapport définisse le numérique. En philosophie nous avons tendance à nous méfier des fausses évidences. Le numérique, tout le monde saist ce que c’est ! Pas si sûr. Alors je développe un instant. Car au fait, c’est quoi le numérique ?

La codification digitale de l’information sur des supports informatiques a deux conséquences énormes.

La première conséquence : là où l’imprimerie avait édifié une interface de pouvoir entre celui qui écrit et celui qui lit, l’internet rend à chacun le pouvoir d’écrire. L’école à l’ère du numérique n’est pas une école où l’on apprend surtout à lire, mais une école où l’on apprend aussi à écrire.

Le rapport le mentionne, 41% des jeunes ont un blog. Pensera-t-on à l’inclure dans leur e-portfolio ? Apprend-on aux enfants à écrire dans Wikipédia? Est-ce le pays qui a fait naître l’Encyclopédie de Diderot (et où Arago a racheté le brevet du daguerréotype pour le donner au monde) doit aider au financement de Wikipédia ? Mais je pose peut-être de mauvaises questions. Le rapport mentionne la création, la participation, comme ingrédient et adjuvant des enseignements, sans doute. L’école numérique peut être plus enthousiasmante: elle peut être le lieu où l’on accède au savoir, où l’on apprend à le produire et à le partager.

La seconde conséquence : dans le monde du numérique, copier n’est pas reproduire[7]. La diffusion du savoir peut se faire à coût marginal nul.

Cela change tout (ou devrait tout changer) de la façon dont l’école se situe par rapport aux éditeurs de contenu. Cela bouscule les systèmes juridiques, les modèles économiques. On sent comme une hésitation dans le rapport sur ce point. J’y reviendrai.

Sur le contexte

Analogie avec l’arrivée de la télévision – J’appartiens à la génération qui a vu se développer la télévision: on ne s’en est pas servi ou si peu ou si mal à l’école. Il y aurait eu là un instrument formidable pour accompagner la massification. Il y avait là aussi une menace terrible. L’école n’a pas réussi à en faire un instrument, sans doute faut-il le regretter. Elle a su résister à s’en faire l’instrument. Il faut s’en féliciter. Il y aura deux manières de rater l’école numérique : ne pas réussir à intégrer le numérique dans les situations d’enseignement, réduire le système éducatif à n’être qu’un client pour des industries numériques. Nous devons craindre davantage ce second danger.

Souvenir

La France qui était un géant de l’informatique est devenue un nain. Elle a retardé par exemple son entrée de plain pied dans l’internet grâce/à cause du minitel. Il me semble qu’il faut considérer cela comme un élément de contexte. Parmi les freins: notre aptitude à nous tirer des balles dans le pied, à ne pas voir nos atouts. Que serait une ligne Maginot numérique ?

Sur la méthode. Il est toujours important de regarder ce qui se fait ailleurs. mais attention à « l’herbe est toujours plus verte ailleurs ». Il faut aussi regarder ici, d’ailleurs. Regarder ailleurs ce qu’on nous envie! On s’extasie à l’étranger sur le développement du logiciel libre en France et sur Sésamath (Serons-nous les derniers à nous en apercevoir, et à miser vraiment, réellement sur nos atouts, pas sur ceux que nous envions aux autres). Et puis on ne gagne pas les guerres avec les armes de la précédente.

Comment ne pas partager le diagnostic du rapport ?

- En France, l’orientation ressemble trop à une sélection par l’échec.

- « L’impact du milieu socio-économique de l’élève a en France une très forte influence sur ses résultats scolaires ». Autrefois on disait « l’ascenseur social est cassé ».

- « La France fait partie des pays dans lesquels l’écart de performance entre les élèves est le plus important, même s’il y a peu d’élèves brillants et une forte proportion d’élèves très faibles ». Ce que je réponds à des amis qui me demandent si le niveau baisse: « non, l’écart se creuse ».

- Le discours tenu sur les enseignants et sur l’école est catastrophique. La (dernière) priorité du rapport: « médiatiser les enjeux du numérique en valorisant le travail des enseignants ».

- « 97% des enseignants sont équipés d’un ordinateur à leur domicile et si 94% l’utilisent pour la préparation de leurs cours, seuls 12% des enseignants utilisent les Tice dans un quart de leurs cours ». On les décourage ou quoi ? Pourquoi feraient-ils davantage ? Ils seraient mieux notés, mieux payés, mieux considérés ?

Il me semble qu’il faut fixer des objectifs, évaluer. Comment mesurer si les mesures préconisées ont été efficaces ? Finalement, plutôt que d’expérimenter sans évaluer, je me demande s’il ne suffirait pas parfois de seulement mesurer… On gagnerait du temps !

On mentionne l’Académie en ligne. Dispose-t-on d’une évaluation de ses premiers résultats ?

Sur le rapport, dans son ensemble

Ce n’est pas toujours très lisible, trop d’items, où l’on trouve mélangés des détails d’équipement et des principes. Sans doute la loi du genre.

J’ai tendance à penser qu’il faut réfléchir aux buts avant de réfléchir aux moyens. J’observe que le rapport commence par mesurer que le haut débit n’est pas assez utilisé en France et l’on y parle d’abord « équipement ». Revenons aux fondamentaux: aux frontons de nos écoles figure la devise de la République: liberté, égalité, fraternité. Regardons comment le numérique pourrait aider l’école à redevenir ou rester l’école.

- La liberté – Je la vois dans les logiciels libres, et dans les ressources libres. Nous sommes le pays des Lumières. C’est là que le monde nous attend. Le rapport l’évoque, mais très timidement.

- L’égalité – Le rapport ne s’indigne pas assez de ce qu’introduit actuellement le numérique à l’école: l’inégalité! Entre les collectivités de rattachement, entre les écoles, entre les classes, entre les élèves. Il n’y a pas besoin de développer en détail. On lutte contre la fracture numérique en grattant la plaie. Equiper c’est bien, rétablir l’égalité c’est mieux!

- La fraternité – Il faut encourager le travail collaboratif, la coopération, la coopétition, les formes de communication asynchrones et distantes, la production d’un patrimoine commun de ressources. Entre les élèves évidemment, entre les enseignants sans doute, mais aussi et surtout entre tous les acteurs (en particulier ceux qui financent, et qui peuvent massivement mutualiser).

Mesure 2 – Tableau numérique interactif

Je suis un peu surpris que dans un rapport d’un tel niveau on préconise en mesure 2 le déploiement d’un outil particulier.

D’autant que les videoprojecteurs intègrent désormais cette fonction[8] ! Mais pas exactement au même prix…

Ces matériels doivent être interopérables ! Actuellement ce n’est pas le cas. Il y a des établissements avec des TBI de plusieurs marques différentes, incompatibles et a fortiori non interopérables.

Mon inquiétude générale

Mon inquiétude, c’est que l’école soit vue après ce rapport par les industriels comme un simple marché pour leurs produits. L’école vaut mieux que cela. Oui au « serious game » ! Mais par exemple le critère d’évaluation ne sera pas la santé de l’industrie du serious game, mais le progrès des élèves. Si l’on voulait faire du serious game libre, avec des systèmes-auteurs à libre disposition ce serait possible! Mais est-ce cela que l’on veut ?

Je vais prendre un exemple plus parlant.

À propos des handicapés

La situation des personnes handicapées en matière de nouvelles technologies est alarmante. Oui, les nouvelles technologies sont un formidable instrument d’accessibilité. Mais à quel prix ? Dans cette niche les marchands ne sont pas exactement des philanthropes. Vous savez combien coûte un système mécanique pour tourner les pages d’un livre ? Est-ce qu’il serait utile de financer un système de visio-conférence libre ? Vous imaginez les conséquences pour le développement du télétravail ? Le frein, ce n’est pas l’usage des outils, c’est le coût exhorbitant des outils ! Il faut choisir entre promouvoir les usages et promouvoir les outils.

Promouvoir vraiment les usages (et l’économie qui va avec) c’est libérer les outils !

Plutôt que d’aider les gens à se payer des logiciels… libérons les logiciels. L’économie autour des usages est plus rentable que le commerce sur les outils.

Sur l’enseignement de l’informatique

C’est une très bonne chose ! Au sein du groupe ITIC[9], j’ai suivi ce dossier. C’est une chose qui me tient à coeur. Mais s’est-on demandé pourquoi cet enseignement n’existait pas, avait été supprimé ?

Il faut aller au bout des choses: créer une inspection d’informatique, proposer un concours, avec une certification ouverte à la VAE[10]. Tout cela est bel et bon.

L’enjeu de fond reste toujours quand même : faut-il enseigner à utiliser ou à maîtriser. Je ne suis pas rassuré sur ce point. Faut-il enseigner à « maîtriser l’utilisation » ? La Finlande, c’est le pays où sont nés Linux et Nokia. Excusez du peu. Il faut croire qu’ils ont du chercher à vraiment comprendre comment ça marchait !

Sur l’enseignement des langues

Sur les langues j’ai écrit[11] l’an dernier à tous les départements, toutes les régions, au ministère, pour leur dire qu’il serait intelligent d’investir dans le développement d’LLSOLL[12], le labo de langue libre qu’avait commencé la ville de Genève.

Je suis un peu désabusé, même si j’observe qu’en matière de langues on met le paquet dans la réforme de la seconde (avec une inquiétude sur l’enseignement de l’allemand, mais c’est une autre histoire…).

Naïveté ?

Le logiciel qui renforce l’estime de soi « bravo, continue ». Les enfants ne sont pas dupes… Pour parler philosophie, disons que le désir de reconnaissance d’un sujet n’est pas exactement le désir d’être reconnu par un objet.

ADNE

L’idée d’une structure de coordination nationale est-elle une bonne idée ? Cela me rappelle la formule de Clémenceau : « Quand on veut enterrer un problème, on crée une commission ».

Va pour l’Agence pour l’Accompagnement au Développement du Numérique dans l’Education (ADNE). La vraie question c’est: que devra-t-elle faire ?

Ce serait l’occasion pour faire du collaboratif entre acteurs de l’école, pour donner l’exemple : on n’enseigne que ce qu’on est !

Opportunité pour le soutien scolaire

Accompagnement à la scolarité. Il faut impliquer les enseignants, en profiter pour transformer les relations avec les élèves. Sinon les élèves iront chercher tous chercher ailleurs.

Il manque une offre logicielle de qualité en la matière ? Il faut faire développer, la mettre en libre et distribuer partout. Il y a 70.000 établissements scolaires. On paie 1 fois le développement en amont et on économise 70.000 licences. Cela devrait s’appeler de l’efficience non ?

À moins que l’on se prépare à faire payer 70.000 fois ceci, et 70.000 cela.

Les ENT

Le développement des ENT[13] a été un poème… On aurait voulu qu’ils ne se développent pas ou le plus lentement possible qu’on ne s’y serait pas pris autrement. Passons…

Au lieu de se mettre autour d’une table et de financer en mutualisant un système libre qui puisse 1) être déployé vite et bien et 2) être maintenu correctement partout, on a laissé chacun se débrouiller, et on y est encore…

La région Ile de France vient de notifier un marché pour un ENT libre. I had a dream…

Mesure 27 – Développer un ENT spécifique pour le premier degré aux fonctionnalités adaptées, en particulier cahier de textes, et de liaison, pour la relation école-familles.

Si les enseignants doivent rentrer leurs notes, pourquoi l’Institution ne développerait pas en libre (ou ne racheterait pas un logiciel de notes pour le mettre sous licence libre), pour une ergonomie commune.

La forge de l’Adullact[14] l’accueillera avec plaisir.

À propos du haut débit

C’est très bien de mettre du très haut débit partout. Mais il faudra aller au bout de la démarche. Est-ce que cela va nous conduire à nous déplacer… pour avoir tout à disposition, comme dans le télétravail, qui existe déjà: on se déplace… pour télétravailler ! Le rapport le mentionne : le temps et le lieu de l’école vont devoir changer. Décidement le haut débit pour tous, ça touche à tout !

L’école numérique ce n’est pas l’école + le haut débit…

Mesure 14 – Exception pédagogique

Comme suppléant de Bernard Lang au Conseil Supérieur de la Propriété Littéraire et Artistisque[15], je crains que voter une exception pédagogique en urgence ne soit une contradiction dans les termes. Le test en trois étapes peut-il passer ?

Il y a pourtant une solution simple et très rapide à mettre en place : miser vraiment sur les ressources libres et ouvertes (logiciels et ressources documentaires).

Sur le pilotage

Je n’ai pas compris le but. Ou alors il n’est pas lisible. Mutualisation ?

Dommage qu’il ne soit pas question des développements logiciels d’ENT (à partir de la souche de Dijon par exemple[16]).

Mesure 23 – Favoriser les ressources libres et la mise à disposition de ressources non payantes

À première vue c’est formidable. Mais la mesure précédente, la 22, est un fonds pour soutenir l’édition propriétaire. Doit-on comprendre alors que l’on va encourager/favoriser les ressources libres… sans argent.

Pourtant elles sont comme les logiciels : elle sont gratuites une fois qu’elles ont été payées… Dire (tandis qu’on finance par ailleurs les marchands) à ceux qui produisent bénévolement un patrimoine libre avec le souci du bien commun « Bravo, merci, continuez », ce n’est pas vraiment les y encourager !

Le collaboratif

Sésamath est présenté comme une référence (son influence sur d’autres associations professionnnelles dans d’autres matières que les mathématiques en atteste assez). Le rapport encourage-t-il l’Institution à promouvoir à grande échelle cette exception française ? Et dans toutes les matières ?

Il y a comme une hésitation dans le rapport. Il faudrait que les enseignants collaborent, coopèrent, surtout pour se former. Le fait qu’ils aillent jusqu’à produire des contenus, et les plus adaptés, semble un peu embêtant…

Comment dire aux enseignants: collaborez, tandis que les contenus et les logiciels s’achèteraient ailleurs. Ca va forcément clocher quelque part.

Mutualisation : qui paie ?

Une certitude: ce sont les collectivités qui paieront. Habituellement c’est celui qui paie qui finalement décide. (C’est celui met la pièce dans le juke-box qui choisit la musique).

Il y a deux scénarios possibles:

- Mutualisation tous azimuts: on rétablit et on assure l’égalité en pariant sur les ressources logicielles et documentaires libres et ouvertes (ENT, visio-conférences, laboratoires de langue, forges de développement de ressources, outils d’administration, etc.)

- Pas de mutualisation, les régions, départements et communes riches s’équipent richement et le fossé se creuse.

Dans les deux cas l’industrie du numérique se développera… mais dans le second cas l’école numérique sera une autre école.

Priorité forges de développement : ce qu’il faudrait bâtir

Le rapport parle de la mise en place de plate-formes collaboratives. Plus que des lieux de rencontre, ce sont des lieux de production: les places de marchés sont là, pas ailleurs !

C’est là que se produisent les ressources (logicielles et documentaires).

Conclusion:

Pourvu qu’on ne soit pas en train de passer à côté d’une opportunité formidable, en se trompant sur ce qu’est l’Economie Numérique. On risque de déplacer un modèle de l’édition (d’outils et de contenus) qui est totalement inadapté, et qui va se fonder sur des modèles instables et transitoires. Cela fera peut-être la fortune de quelques habiles, mais l’école en tirera-t-elle bénéfice? C’est ce que je saurais dire…

Ce que j’espère ? Que les collectivités, qui vont payer, aillent vers la mutualisation, pour produire ensemble des resssources libres. Mais je ne sais pas si ce choix sera fait, car il n’est pas simple d’organiser cette mutualisation et d’inventer. Mais à coup sûr nous aurions là une école à donner au monde !

De toutes manières, nous aurons l’école numérique que nous méritons.

En décembre dernier nous vous annoncions la création d’un Centre de Formation Logiciels Libres (ou CF2L) dans le cadre de l’Université numérique Paris Île-de-France (UNPIdF), par l’entremise de Thierry Stœhr interviewé pour l’occasion.

En décembre dernier nous vous annoncions la création d’un Centre de Formation Logiciels Libres (ou CF2L) dans le cadre de l’Université numérique Paris Île-de-France (UNPIdF), par l’entremise de Thierry Stœhr interviewé pour l’occasion. « Depuis le printemps 2008, l’Union européenne, les États-Unis, le Japon, le Canada, la Corée du Sud, l’Australie ainsi qu’un certain nombre d’autres pays négocient secrètement un accord commercial destiné à lutter contre la contrefaçon (Anti-Counterfeinting Trade Agreement ou ACTA). Suite à des fuites de documents confidentiels, il apparaît clairement que l’un des buts principaux de ce traité est de forcer les pays signataires à mettre en place des mesures de répression de partage d’œuvre sur Internet sous la forme de riposte graduée et de filtrage du Net.

« Depuis le printemps 2008, l’Union européenne, les États-Unis, le Japon, le Canada, la Corée du Sud, l’Australie ainsi qu’un certain nombre d’autres pays négocient secrètement un accord commercial destiné à lutter contre la contrefaçon (Anti-Counterfeinting Trade Agreement ou ACTA). Suite à des fuites de documents confidentiels, il apparaît clairement que l’un des buts principaux de ce traité est de forcer les pays signataires à mettre en place des mesures de répression de partage d’œuvre sur Internet sous la forme de riposte graduée et de filtrage du Net. François Elie est co-fondateur et président de l’Adullact[

François Elie est co-fondateur et président de l’Adullact[ Reprise du second article de l’enquête de Mediapart sur l’école à l’ère numérique, introduite dans un

Reprise du second article de l’enquête de Mediapart sur l’école à l’ère numérique, introduite dans un  Nous avons déjà eu l’occasion de le signaler dans notre

Nous avons déjà eu l’occasion de le signaler dans notre  Cela leur fait même parfois un peu tourner la tête. Nous avions

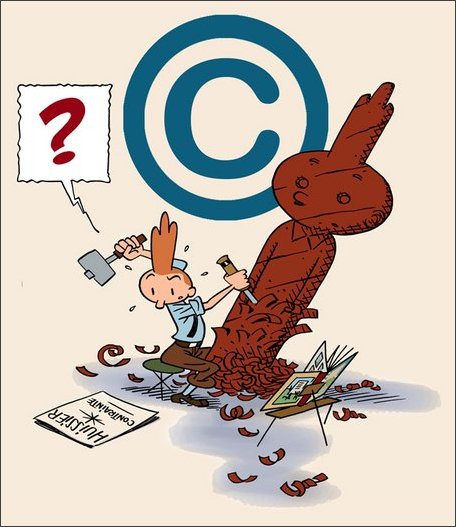

Cela leur fait même parfois un peu tourner la tête. Nous avions  Il faut bien comprendre que la moindre reproduction de vignettes est interdite par les avocats de Moulinsart : « une vignette de bande dessinée est une œuvre à part entière, or une œuvre à part entière ne peut pas être citée (…) il y a environ mille vignettes par album, il y a donc mille dessins protégés par des droits d’auteur » (source

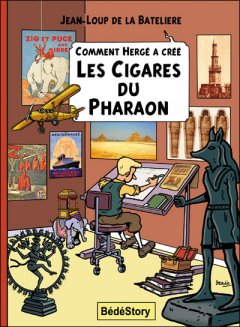

Il faut bien comprendre que la moindre reproduction de vignettes est interdite par les avocats de Moulinsart : « une vignette de bande dessinée est une œuvre à part entière, or une œuvre à part entière ne peut pas être citée (…) il y a environ mille vignettes par album, il y a donc mille dessins protégés par des droits d’auteur » (source  BédéStory publie sous le titre générique « Comment Hergé a créé… » des études portant sur la genèse de l’œuvre d’Hergé : Comment Hergé a créé Tintin au Congo, Comment Hergé a créé Tintin en Amérique, et ainsi de suite.

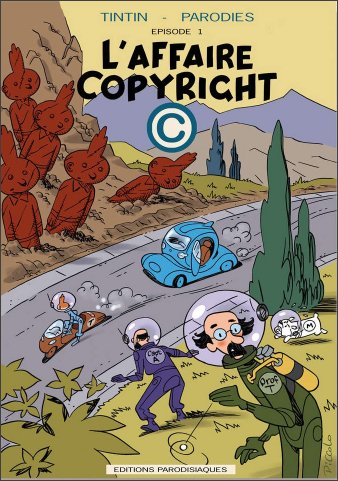

BédéStory publie sous le titre générique « Comment Hergé a créé… » des études portant sur la genèse de l’œuvre d’Hergé : Comment Hergé a créé Tintin au Congo, Comment Hergé a créé Tintin en Amérique, et ainsi de suite. L’ironie de l’histoire c’est que BédéStory a également publié tout récemment un album aux éditions « Parodisiaques » (histoire que ce soit bien clair) dont le titre, dans ce contexte, ne passe pas inaperçu : L’affaire copyright.

L’ironie de l’histoire c’est que BédéStory a également publié tout récemment un album aux éditions « Parodisiaques » (histoire que ce soit bien clair) dont le titre, dans ce contexte, ne passe pas inaperçu : L’affaire copyright.

Le logiciel libre et sa culture n’ont toujours pas la place qu’ils méritent à l’école. Tel est l’

Le logiciel libre et sa culture n’ont toujours pas la place qu’ils méritent à l’école. Tel est l’ Quel sera le futur format vidéo du Web ? Certainement plus le Flash dont les jours sont comptés. Mais quel nouveau format va alors s’imposer, un format ouvert au bénéfice de tous ou un format fermé dont le profit à court terme de quelques-uns se ferait au détriment des utilisateurs ?

Quel sera le futur format vidéo du Web ? Certainement plus le Flash dont les jours sont comptés. Mais quel nouveau format va alors s’imposer, un format ouvert au bénéfice de tous ou un format fermé dont le profit à court terme de quelques-uns se ferait au détriment des utilisateurs ? Une fois n’est pas coutume, nous vous proposons aujourd’hui une traduction qui non seulement ne parle pas de logiciel libre mais qui en plus provient de

Une fois n’est pas coutume, nous vous proposons aujourd’hui une traduction qui non seulement ne parle pas de logiciel libre mais qui en plus provient de