Le jour où la suite bureautique MS Office devint fréquentable ?

Le 28 avril prochain, Microsoft devrait mettre en ligne sa nouvelle mise à jour majeure de la suite Office 2007 (dans le vocable Microsoft, on parle de Service Pack, ici le numéro 2, donc SP2).

Le 28 avril prochain, Microsoft devrait mettre en ligne sa nouvelle mise à jour majeure de la suite Office 2007 (dans le vocable Microsoft, on parle de Service Pack, ici le numéro 2, donc SP2).

C’est un évènement beaucoup plus important qu’il n’y parait. En effet, parmi les nouveautés, la célèbre suite bureautique intégrera pour la première fois nativement le format ouvert Open Document Format.

Auparavant on pouvait en théorie lire et écrire en ODF sur la suite Office, mais il fallait télécharger un plugin et faire tout un tas de manipulations compliquées pour arriver au résultat souhaité (lire le rapport Becta pour avoir de plus amples informations).

En arriver là ne fut pas une mince affaire, il aura fallu mettre la pression sur Microsoft qui, avec son arrogance sa manière de faire habituelle, souhaitait plutôt nous imposer son propre format de fichier, le très controversé OOXML.

Toujours est-il qu’on tient enfin là un format de fichier bureautique, ouvert, standard, et en pratique réellement interopérable (en admettant bien entendu que la qualité technique soit bel et bien au rendez-vous). D’un coup d’un seul, la principale critique faite à la suite MS Office tombe, et l’on se retrouve avec un produit beaucoup plus fréquentable, pourvu que les utilisateurs de cette suite aient la bonne idée et lire, écrire et échanger par défaut avec le format ODF (ce qui, a mon humble avis, nécessitera tout de même un temps d’adaptation où il faudra être patient et pédagogue).

Pour « célébrer » l’événement, nous avons choisi de traduire un vieil article Jonathan Schwartz, PDG de Sun, qui témoigne de l’intérêt fondamental de posséder des formats ouverts, en bureautique comme ailleurs[1].

Mes photos de famille – et ODF

Jonathan Schwartz – 12 février 2007 – Blog

(Traduction : Poupoul2, Goofy et Olivier)

Il y a quelques années, alors que je me trouvais chez mes parents, j’ai passé un peu de temps à regarder de vieilles photos de famille tirées d’une boîte à chaussures. C’était sympa. J’y prenais beaucoup de plaisir… jusqu’à ce que je m’aperçoive que la plupart de ces photos étaient uniques. C’est à dire qu’il s’agissait d’exemplaires uniques. Uniques au monde. Et pour au moins l’un des membres de ma famille, il n’existait que deux ou trois photos prises au long de sa vie. Ouch !

Une boîte à chaussures, me dis-je. Un peu archaïque, non ? Et si jamais il y avait une inondation, ou pire encore, un feu ? Voici des photos que je veux partager avec ma famille et transmettre de génération en génération. Je veux que mes enfants en connaissent l’histoire, et mes petits-enfants, et les enfants de mes petits enfants.

Alors, j’ai fait ce que tout bon fils ferait : j’ai convaincu mes parents de me laisser leur subtiliser la boîte un certain temps, je suis rentré à la maison et j’ai numérisé les photos (j’ai aussi rendu la boîte à mes parents).

Les photos numérisées se trouvaient désormais sur mon disque dur. Dans mon portable. Dans ma cuisine (c’est là que vit mon portable).

Étant donné ce qui se passe tous les jours dans ma cuisine, elles s’y trouvaient sans doute moins en sécurité que dans leur boîte à chaussures. Et un point pour l’archaïsme. Un échec, un !

J’ai alors gravé quelques DVDs, les ai distribués autour de moi, et en ai donné quelques-uns aux autres membres de la famille. Cela va sans dire, la plupart des DVDs ont été perdus, ce n’est pas un hasard si les administrateurs système amateurs restent amateurs… Et deux échecs, deux !.

La bonne nouvelle, c’est qu’un jour, quelqu’un de brillant a dit que le réseau est l’ordinateur… Il y a quelque temps, j’ai décidé de les télécharger sur mon service de photos en ligne. Si vous allez vous résoudre à surveiller une boîte à chaussures, autant se tourner vers quelqu’un dont c’est le métier, qui surveille déjà plein d’autres boîtes à chaussure et qui pourrait bien être le meilleur au monde dans ce domaine.

Et puis je me suis demandé…

Comment puis-je garantir que le service sera au rendez-vous, ou que je serais capable de visualiser les images que j’y ai stockées… pas seulement dans un an, mais dans cinq ou cinquante ans ? Que se passera-t-il si les images survivent à la technologie ?

Le décor étant planté, voilà qui illustre bien la raison d’être de ce petit truc qu’on appelle Open Document Format.

Mettez vous dans la peau du législateur écrivant un texte de loi, ou dans celle d’un médecin rédigeant l’ordonnance de son patient, ou encore dans celle d’un étudiant travaillant sur une nouvelle de son cru. Et cinq ou cinquante ans plus tard vous prend l’envie de revoir vos documents. Sauf que le développeur de l’application qui a servi à créer ces documents, l’entreprise qui a créé le traitement de texte a, au choix, cessé son activité, ou décidé de vous demander $10000 pour vous fournir une version capable de lire de vieux formats de fichiers. L’information survit toujours à la technologie, ces scénarios en sont de bons exemples.

Que faites vous alors ?

Premier réflexe : vous râlez. Après tout, l’information que vous avez créée vous appartient à vous et pas à l’éditeur. C’est pareil pour vos photos de famille, vous imaginez qu’un fabricant d’appareil photo vous demande de passer à la caisse avant que vous ne puissiez voir vos propres photos ? C’est là tout le danger lié aux des applications n’utilisant pas des formats de fichiers ouverts. N’oubliez pas, l’information survit à la technologie.

C’est la raison pour laquelle, aux côtés de quelques-uns des plus grands groupes technologiques, ainsi que d’une foule de gouvernements et d’organismes du monde entier, nous avons créé quelque chose que l’on appelle Open Document Format (ou "ODF" de son petit nom). ODF décrit un format ouvert pour les informations contenues dans des documents, indépendant des applications utilisées pour créer les documents enregistrés en ODF.

En d’autres termes, si vous écrivez un texte de loi, un dossier médical ou une fiche réglementaire avec un traitement de texte supportant aujourd’hui l’ODF, et que vous avez besoin d’y accéder n’importe quand dans l’avenir, vous serez libre de le faire à vos conditions. ODF est un véritable format standard, mis en oeuvre par des éditeurs variés (d’IBM à Sun, en passant par Google, Red Hat et même Microsoft désormais), et adopté à une très large échelle sur toute la planète. Et c’est gratuit.

La pérennité de l’information et des formats de fichiers est plus qu’essentielle pour des institutions et des entreprises adoptant des politiques de rétention de documents allant bien au-delà de la vie utile du logiciel (ou des employés) qui a permis la création des documents. La disponibilité de l’information est ainsi garantie dans l’avenir. Il en va de même pour nos photographies dans nos boîtes à chaussures. En tant que CIO (NdT : Directeur informatique) à la maison, j’exige que les images me survivent.

La pérennité de l’information et des formats de fichiers est plus qu’essentielle pour des institutions et des entreprises adoptant des politiques de rétention de documents allant bien au-delà de la vie utile du logiciel (ou des employés) qui a permis la création des documents. La disponibilité de l’information est ainsi garantie dans l’avenir. Il en va de même pour nos photographies dans nos boîtes à chaussures. En tant que CIO (NdT : Directeur informatique) à la maison, j’exige que les images me survivent.

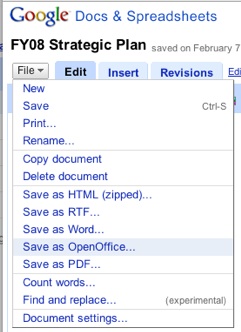

Et juste au cas où vous auriez raté une étape, nous travaillons avec Google pour garantir l’interopérabilité entre les documents bureautique de Google et les documents OpenOffice, élevant l’ODF au rang de mécanisme d’échange. Tout document créé avec la suite bureautique de Google peut être aisément exporté vers (et bientôt importé de) OpenOffice (voir la copie d’écran). Combinés, les 2 produits permettent aux entreprises et aux particuliers de préserver, dans le monde entier et pour plusieurs générations, l’accès aux lois, aux contrats, aux dossiers médicaux, aux journaux ou aux plans stratégiques. Et c’est strictement pareil pour les présentations et les feuilles de calculs.

Enfin, pour ceux qui découvrent OpenOffice, il s’agit d’une suite bureautique libre, qui sera toujours gratuite, pour les entreprises comme pour les utilisateurs finaux. D’après nos estimations, nous en avons distribué des centaines de millions de copies autour du monde (cliquez ici pour le télécharger). Et maintenant que Microsoft a annoncé le support de l’ODF, les utilisateurs peuvent sereinement penser qu’OpenOffice peut être introduit dans toutes les chaumières et les bureaux, pas uniquement dans les pays en voie de développement, mais aussi dans les pays développés. Dans quelques semaines, vous aurez la possibilité de télécharger ici un plug-in ODF, qui permettra à Microsoft Word de lire et écrire de l’ODF par défaut. Une fois installé, vous le verrez apparaître dans les options de Word :

(Je mettrai un lien dès que le plug-in sera prêt)

À partir de maintenant, ODF devient votre format par défaut. Que vous soyez une compagnie pétrolière ou un étudiant, ODF vous permettra une interopérabilité sans heurts entre des environnements Open Source ou propriétaires, aussi longtemps que le standard (et pas la technologie ou le produit) existera.

Du point de vue des entreprises, de grandes institutions peuvent envisager une migration en douceur, les cadres pourraient conserver Microsoft Word, tandis que le reste du personnel peut passer à une alternative interopérable (par exemple : le traitement de texte de Google ou OpenOffice, ou même les deux). Accessibilité et interopérabilité sont de bonnes choses pour Internet, et nous avons bien l’intention de les utiliser pour les générations futures.

Notes

[1] Crédit photo : Kevin N. Murphy (Creative Commons By)

La sortie de

La sortie de  Il y a une semaine, Sylvain Zimmer, l’un des fondateurs de la plate-forme de musique « libre, légale et illimitée »

Il y a une semaine, Sylvain Zimmer, l’un des fondateurs de la plate-forme de musique « libre, légale et illimitée »

« 18 juin 1940 – le général de Gaulle envoit un message sur Twitter et crée une cause sur Facebook. 19 juin 1940 – déjà plus de 30 millions d’internautes ont rejoint les rangs des Français Libres sur les réseaux sociaux. Les SMS et mails de soutien affluent. Des milliers de blogs fleurissent… »

« 18 juin 1940 – le général de Gaulle envoit un message sur Twitter et crée une cause sur Facebook. 19 juin 1940 – déjà plus de 30 millions d’internautes ont rejoint les rangs des Français Libres sur les réseaux sociaux. Les SMS et mails de soutien affluent. Des milliers de blogs fleurissent… » Ce blog n’est pas le dernier à le constater : les enseignants et le logiciel libre, c’est parfois tout un poème…

Ce blog n’est pas le dernier à le constater : les enseignants et le logiciel libre, c’est parfois tout un poème… Si seulement c’était vrai… Bien que le premier avril soit passé depuis longtemps, vous devez vous en doutez un peu : mon titre n’est qu’un

Si seulement c’était vrai… Bien que le premier avril soit passé depuis longtemps, vous devez vous en doutez un peu : mon titre n’est qu’un  Framasoft en général et le Framablog en particulier vous ont souvent raconté des histoires de

Framasoft en général et le Framablog en particulier vous ont souvent raconté des histoires de