Internet et Google vont-ils finir par nous abrutir ?

Voici la traduction d’un article assez passionnant qui a connu un bel impact dans la sphère anglophone au moment de sa mise en ligne cet été. Son titre choc Is Google Making Us Stupid? est un peu trompeur car il s’agit bien moins de charger l’emblématique Google que de s’interroger sur les transformations profondes induites par internet et les nouvelles technologies, transformations qui peuvent aller jusqu’à modifier nos perceptions, nos modes de pensée, voire même notre cerveau.

Voici la traduction d’un article assez passionnant qui a connu un bel impact dans la sphère anglophone au moment de sa mise en ligne cet été. Son titre choc Is Google Making Us Stupid? est un peu trompeur car il s’agit bien moins de charger l’emblématique Google que de s’interroger sur les transformations profondes induites par internet et les nouvelles technologies, transformations qui peuvent aller jusqu’à modifier nos perceptions, nos modes de pensée, voire même notre cerveau.

Prenons le Framablog par exemple. Il possède, merci pour lui, d’assez bonnes statistiques d’audience globales, mais lorsque l’on se penche sur la moyenne du temps passé par page, c’est la grosse déprime car cela ne dépasse que trop rarement les deux minutes, intervalle qui ne vous permet généralement pas d’y parcourir les articles du début à la fin. En décidant d’en achever la lecture bien avant la conclusion, peut-on affirmer que plus de la moitié des visiteurs ne les trouvent pas intéressants ? C’est fort probable.

Mais il y a peut-être aussi une autre explication. Les articles de ce blog sont souvent relativement « longs » et par la-même nécessitent de trouver un minimum de temps disponible et de concentration. Ils nous demandent de fixer notre attention et d’interrompre notre surf internet en coupant momentanément le contact avec le flot continu d’informations dont nous sommes abreuvés.

Allons plus loin avec l’objet livre (que nous défendons d’ailleurs avec force et modestie sur Framabook). Lit-on moins de livres au fur et à mesure qu’Internet prend de plus en plus de place dans nos vies ? Et surtout les lit-on avec les mêmes facilités qu’auparavant ? Et qu’en est-il de la jeune génération ?[1]

Nicholas Carr, partant du constat qu’il n’a plus la même patience que par le passé vis-à-vis de la lecture « calme et profonde », revisite quelques dates marquantes de l’Histoire (le passage de l’oral à l’écrit, l’apparition de l’imprimerie, de la machine à écrire, du taylorisme…) pour nous inviter à une réflexion autour de l’influence des technologies et leurs systèmes sur rien moins que notre manière de penser et de percevoir le monde.

Vous vous sentez vous aussi atteint par le symptôme ? Ne vous laissez pas abattre ! Oubliez l’espace d’un instant SMS, MSN, Facebook, Twitter… et sérendipité, en réussissant l’exploit de parcourir ce billet jusqu’à son terme 😉

Est-ce que Google nous rend idiots ?

Nicholas Carr – juin 2008 – The Atlantic

(Traduction Framalang : Penguin, Olivier et Don Rico)

« Dave, arrête. Arrête, s’il te plaît. Arrête Dave. Vas-tu t’arrêter, Dave ? » Ainsi le super-ordinateur HAL suppliait l’implacable astronaute Dave Bowman dans une scène célèbre et singulièrement poignante à la fin du film de Stanley Kubrick 2001, l’odyssée de l’espace. Bowman, qui avait failli être envoyé à la mort, au fin fond de l’espace, par la machine détraquée, est en train de déconnecter calmement et froidement les circuits mémoires qui contrôlent son « cerveau » électronique. « Dave, mon esprit est en train de disparaître », dit HAL, désespérément. « Je le sens. Je le sens. »

Moi aussi, je le sens. Ces dernières années, j’ai eu la désagréable impression que quelqu’un, ou quelque chose, bricolait mon cerveau, en reconnectait les circuits neuronaux, reprogrammait ma mémoire. Mon esprit ne disparaît pas, je n’irai pas jusque là, mais il est en train de changer. Je ne pense plus de la même façon qu’avant. C’est quand je lis que ça devient le plus flagrant. Auparavant, me plonger dans un livre ou dans un long article ne me posait aucun problème. Mon esprit était happé par la narration ou par la construction de l’argumentation, et je passais des heures à me laisser porter par de longs morceaux de prose. Ce n’est plus que rarement le cas. Désormais, ma concentration commence à s’effilocher au bout de deux ou trois pages. Je m’agite, je perds le fil, je cherche autre chose à faire. J’ai l’impression d’être toujours en train de forcer mon cerveau rétif à revenir au texte. La lecture profonde, qui était auparavant naturelle, est devenue une lutte.

Je crois savoir ce qui se passe. Cela fait maintenant plus de dix ans que je passe énormément de temps sur la toile, à faire des recherches, à surfer et même parfois à apporter ma pierre aux immenses bases de données d’Internet. En tant qu’écrivain, j’ai reçu le Web comme une bénédiction. Les recherches, autrefois synonymes de journées entières au milieu des livres et magazines des bibliothèques, s’effectuent désormais en un instant. Quelques recherches sur Google, quelques clics de lien en lien et j’obtiens le fait révélateur ou la citation piquante que j’espérais. Même lorsque je ne travaille pas, il y a de grandes chances que je sois en pleine exploration du dédale rempli d’informations qu’est le Web ou en train de lire ou d’écrire des e-mails, de parcourir les titres de l’actualité et les derniers billets de mes blogs favoris, de regarder des vidéos et d’écouter des podcasts ou simplement de vagabonder d’un lien à un autre, puis à un autre encore. (À la différence des notes de bas de page, auxquelles on les apparente parfois, les liens hypertextes ne se contentent pas de faire référence à d’autres ouvrages ; ils vous attirent inexorablement vers ces nouveaux contenus.)

Pour moi, comme pour d’autres, le Net est devenu un media universel, le tuyau d’où provient la plupart des informations qui passent par mes yeux et mes oreilles. Les avantages sont nombreux d’avoir un accès immédiat à un magasin d’information d’une telle richesse, et ces avantages ont été largement décrits et applaudis comme il se doit. « Le souvenir parfait de la mémoire du silicium », a écrit Clive Thompson de Wired, “peut être une fantastique aubaine pour la réflexion.” Mais cette aubaine a un prix. Comme le théoricien des média Marshall McLuhan le faisait remarquer dans les années 60, les média ne sont pas uniquement un canal passif d’information. Ils fournissent les bases de la réflexion, mais ils modèlent également le processus de la pensée. Et il semble que le Net érode ma capacité de concentration et de réflexion. Mon esprit attend désormais les informations de la façon dont le Net les distribue : comme un flux de particules s’écoulant rapidement. Auparavant, j’étais un plongeur dans une mer de mots. Désormais, je fends la surface comme un pilote de jet-ski.

Je ne suis pas le seul. Lorsque j’évoque mes problèmes de lecture avec des amis et des connaissances, amateurs de littérature pour la plupart, ils me disent vivre la même expérience. Plus ils utilisent le Web, plus ils doivent se battre pour rester concentrés sur de longues pages d’écriture. Certains des bloggeurs que je lis ont également commencé à mentionner ce phénomène. Scott Karp, qui tient un blog sur les média en ligne, a récemment confessé qu’il avait complètement arrêté de lire des livres. « J’étais spécialisé en littérature à l’université et je passais mon temps à lire des livres », écrit-il. « Que s’est-il passé ? » Il essaie de deviner la réponse : « Peut-être que je ne lis plus que sur Internet, non pas parce que ma façon de lire a changé (c’est à dire parce que je rechercherais la facilité), mais plutôt parce que ma façon de PENSER a changé ? »

Bruce Friedman, qui bloggue régulièrement sur l’utilisation des ordinateurs en médecine, décrit également la façon dont Internet a transformé ses habitudes intellectuelles. « J’ai désormais perdu presque totalement la capacité de lire et d’absorber un long article, qu’il soit sur le Web ou imprimé », écrivait-il plus tôt cette année. Friedman, un pathologiste qui a longtemps été professeur l’école à de médecine du Michigan, a développé son commentaire lors d’une conversation téléphonique avec moi. Ses pensées, dit-il, ont acquis un style « staccato », à l’image de la façon dont il scanne rapidement de petits passages de texte provenant de multiples sources en ligne. « Je ne peux plus lire Guerre et Paix », admet-il. « J’ai perdu la capacité de le faire. Même un billet de blog de plus de trois ou quatre paragraphes est trop long pour que je l’absorbe. Je l’effleure à peine. »

Les anecdotes par elles-mêmes ne prouvent pas grand chose. Et nous attendons encore des expériences neurologiques et psychologiques sur le long terme, qui nous fourniraient une image définitive sur la façon dont Internet affecte nos capacités cognitives. Mais une étude publiée récemment sur les habitudes de recherches en ligne, conduite par des spécialistes de l’université de Londres, suggère que nous assistons peut-être à de profonds changements de notre façon de lire et de penser. Dans le cadre de ce programme de recherche de cinq ans, ils ont examiné des traces informatiques renseignant sur le comportement des visiteurs de deux sites populaires de recherche, l’un exploité par la bibliothèque britannique et l’autre par un consortium éducatif anglais, qui fournissent un accès à des articles de journaux, des livres électroniques et d’autres sources d’informations écrites. Ils ont découvert que les personnes utilisant ces sites présentaient « une forme d’activité d’écrémage », sautant d’une source à une autre et revenant rarement à une source qu’ils avaient déjà visitée. En règle générale, ils ne lisent pas plus d’une ou deux pages d’un article ou d’un livre avant de « bondir » vers un autre site. Parfois, ils sauvegardent un article long, mais il n’y a aucune preuve qu’ils y reviendront jamais et le liront réellement. Les auteurs de l’étude rapportent ceci :

Il est évident que les utilisateurs ne lisent pas en ligne dans le sens traditionnel. En effet, des signes montrent que de nouvelles formes de « lecture » apparaissent lorsque les utilisateurs « super-naviguent » horizontalement de par les titres, les contenus des pages et les résumés pour parvenir à des résultats rapides. Il semblerait presque qu’ils vont en ligne pour éviter de lire de manière traditionnelle.

Grâce à l’omniprésence du texte sur Internet, sans même parler de la popularité des textos sur les téléphones portables, nous lisons peut-être davantage aujourd’hui que dans les années 70 ou 80, lorsque la télévision était le média de choix. Mais il s’agit d’une façon différente de lire, qui cache une façon différente de penser, peut-être même un nouveau sens de l’identité. « Nous ne sommes pas seulement ce que nous lisons », dit Maryanne Wolf, psychologue du développement à l’université Tufts et l’auteur de « Proust et le Calamar : l’histoire et la science du cerveau qui lit. ». « Nous sommes définis par notre façon de lire. » Wolf s’inquiète que le style de lecture promu par le Net, un style qui place « l’efficacité » et « l’immédiateté » au-dessus de tout, puisse fragiliser notre capacité pour le style de lecture profonde qui a émergé avec une technologie plus ancienne, l’imprimerie, qui a permis de rendre banals les ouvrages longs et complexes. Lorsque nous lisons en ligne, dit-elle, nous avons tendance à devenir de « simples décodeurs de l’information ». Notre capacité à interpréter le texte, à réaliser les riches connexions mentales qui se produisent lorsque nous lisons profondément et sans distraction, reste largement inutilisée.

La lecture, explique Wolf, n’est pas une capacité instinctive de l’être humain. Elle n’est pas inscrite dans nos gènes de la même façon que le langage. Nous devons apprendre à nos esprits comment traduire les caractères symboliques que nous voyons dans un langage que nous comprenons. Et le médium ou toute autre technologie que nous utilisons pour apprendre et exercer la lecture joue un rôle important dans la façon dont les circuits neuronaux sont modelés dans nos cerveaux. Les expériences montrent que les lecteurs d’idéogrammes, comme les chinois, développent un circuit mental pour lire très différent des circuits trouvés parmi ceux qui utilisent un langage écrit employant un alphabet. Les variations s’étendent à travers de nombreuses régions du cerveau, incluant celles qui gouvernent des fonctions cognitives essentielles comme la mémoire et l’interprétation des stimuli visuels et auditifs. De la même façon, nous pouvons nous attendre à ce que les circuits tissés par notre utilisation du Net seront différents de ceux tissés par notre lecture des livres et d’autres ouvrages imprimés.

En 1882, Friedrich Nietzsche acheta une machine à écrire, une « Malling-Hansen Writing Ball » pour être précis. Sa vue était en train de baisser, et rester concentré longtemps sur une page était devenu exténuant et douloureux, source de maux de têtes fréquents et douloureux. Il fut forcé de moins écrire, et il eut peur de bientôt devoir abandonner. La machine à écrire l’a sauvé, au moins pour un temps. Une fois qu’il eut maîtrisé la frappe, il fut capable d’écrire les yeux fermés, utilisant uniquement le bout de ses doigts. Les mots pouvaient de nouveau couler de son esprit à la page.

Mais la machine eut un effet plus subtil sur son travail. Un des amis de Nietzsche, un compositeur, remarqua un changement dans son style d’écriture. Sa prose, déjà laconique, devint encore plus concise, plus télégraphique. « Peut-être que, grâce à ce nouvel instrument, tu vas même obtenir un nouveau langage », lui écrivit cet ami dans une lettre, notant que dans son propre travail ses « pensées sur la musique et le langage dépendaient souvent de la qualité de son stylo et du papier ».

« Tu as raison », répondit Nietzsche , « nos outils d’écriture participent à l’éclosion de nos pensées ». Sous l’emprise de la machine, écrit le spécialiste allemand des médias Friedrich A. Kittler, la prose de Nietzsche « est passée des arguments aux aphorismes, des pensées aux jeux de mots, de la rhétorique au style télégraphique ».

Le cerveau est malléable presque à l’infini. On a longtemps cru que notre réseau mental, les connexions denses qui se forment parmi nos cent milliards et quelques de neurones, sont largement établis au moment où nous atteignons l’âge adulte. Mais des chercheurs du cerveau ont découvert que ce n’était pas le cas. James Olds, professeur de neurosciences qui dirige l’institut Krasnow pour l’étude avancée à l’université George Mason, dit que même l’esprit adulte « est très plastique ». Les cellules nerveuses rompent régulièrement leurs anciennes connexions et en créent de nouvelles. « Le cerveau », selon Olds, « a la capacité de se reprogrammer lui-même à la volée, modifiant la façon dont il fonctionne. »

Lorsque nous utilisons ce que le sociologue Daniel Bell appelle nos « technologies intellectuelles », les outils qui étendent nos capacités mentales plutôt que physiques, nous empruntons inéluctablement les qualités de ces technologies. L’horloge mécanique, qui est devenu d’utilisation fréquente au 14ème siècle, fournit un exemple frappant. Dans « Technique et Civilisation », l’historien et critique culturel Lewis Mumford décrit comment l’horloge « a dissocié le temps des événements humains et a contribué à créer la croyance en un monde indépendant constitué de séquences mathématiquement mesurables ». La « structure abstraite du découpage du temps » est devenue « le point de référence à la fois pour l’action et les pensées ».

Le tic-tac systématique de l’horloge a contribué à créer l’esprit scientifique et l’homme scientifique. Mais il nous a également retiré quelque chose. Comme feu l’informaticien du MIT Joseph Weizenbaum l’a observé dans son livre de 1976, « Le pouvoir de l’ordinateur et la raison humaine : du jugement au calcul », la conception du monde qui a émergé de l’utilisation massive d’instruments de chronométrage « reste une version appauvrie de l’ancien monde, car il repose sur le rejet de ces expériences directes qui formaient la base de l’ancienne réalité, et la constituaient de fait. ». En décidant du moment auquel il faut manger, travailler, dormir et se lever, nous avons arrêté d’écouter nos sens et commencé à nous soumettre aux ordres de l’horloge.

Le processus d’adaptation aux nouvelles technologies intellectuelles est reflété dans les métaphores changeantes que nous utilisons pour nous expliquer à nous-mêmes. Quand l’horloge mécanique est arrivée, les gens ont commencé à penser que leur cerveau opérait « comme une horloge ». Aujourd’hui, à l’ère du logiciel, nous pensons qu’il fonctionne « comme un ordinateur ». Mais les changements, selon la neuroscience, dépassent la simple métaphore. Grâce à la plasticité de notre cerveau, l’adaptation se produit également au niveau biologique.

Internet promet d’avoir des effets particulièrement profonds sur la cognition. Dans un article publié en 1936, le mathématicien anglais Alan Turing a prouvé que l’ordinateur numérique, qui à l’époque n’existait que sous la forme d’une machine théorique, pouvait être programmé pour réaliser les fonctions de n’importe quel autre appareil traitant l’information. Et c’est ce à quoi nous assistons de nos jours. Internet, un système informatique d’une puissance inouïe, inclut la plupart de nos autres technologies intellectuelles. Il devient notre plan et notre horloge, notre imprimerie et notre machine à écrire, notre calculatrice et notre téléphone, notre radio et notre télévision.

Quand le Net absorbe un médium, ce médium est recréé à l’image du Net. Il injecte dans le contenu du médium des liens hypertextes, des pubs clignotantes et autres bidules numériques, et il entoure ce contenu avec le contenu de tous les autres média qu’il a absorbés. Un nouveau message e-mail, par exemple, peut annoncer son arrivée pendant que nous jetons un coup d’œil aux derniers titres sur le site d’un journal. Résultat : notre attention est dispersée et notre concentration devient diffuse.

L’influence du Net ne se limite pas aux bords de l’écran de l’ordinateur non plus. En même temps que l’esprit des gens devient sensible au patchwork disparate du médium Internet, les média traditionnels ont dû s’adapter aux nouvelles attentes de leur public. Les programmes de télévision ajoutent des textes défilants et des pubs qui surgissent, tandis que les magazines et les journaux réduisent la taille de leurs articles, ajoutent des résumés, et parsèment leurs pages de fragments d’information faciles à parcourir. Lorsque, au mois de mars de cette année, le New York Times a décidé de consacrer la deuxième et la troisième page de toutes ses éditions à des résumés d’articles, son directeur artistique, Tom Badkin, explique que les “raccourcis” donneront aux lecteurs pressés un « avant-goût » des nouvelles du jour, leur évitant la méthode « moins efficace » de tourner réellement les pages et de lire les articles. Les anciens média n’ont pas d’autre choix que de jouer suivant les règles du nouveau médium.

Jamais système de communication n’a joué autant de rôles différents dans nos vies, ou exercé une si grande influence sur nos pensées, que ne le fait Internet de nos jours. Pourtant, malgré tout ce qui a été écrit à propos du Net, on a très peu abordé la façon dont, exactement, il nous reprogramme. L’éthique intellectuelle du Net reste obscure.

À peu près au moment où Nietzsche commençait à utiliser sa machine à écrire, un jeune homme sérieux du nom de Frederick Winslow Taylor apporta un chronomètre dans l’aciérie Midvale de Philadelphie et entama une série d’expériences historique dont le but était d’améliorer l’efficacité des machinistes de l’usine. Avec l’accord des propriétaires de Midvale, il embaucha un groupe d’ouvriers, les fit travailler sur différentes machines de métallurgie, enregistra et chronométra chacun de leurs mouvements ainsi que les opérations des machines. En découpant chaque travail en une séquence de petites étapes unitaires et en testant les différentes façons de réaliser chacune d’entre elles, Taylor créa un ensemble d’instructions précises, un « algorithme », pourrions dire de nos jours, décrivant comment chaque ouvrier devait travailler. Les employés de Midvale se plaignirent de ce nouveau régime strict, affirmant que cela faisait d’eux quelque chose d’à peine mieux que des automates, mais la productivité de l’usine monta en flèche.

Plus de cent ans après l’invention de la machine à vapeur, la révolution industrielle avait finalement trouvé sa philosophie et son philosophe. La chorégraphie industrielle stricte de Taylor, son « système » comme il aimait l’appeler, fut adoptée par les fabricants dans tout le pays et, avec le temps, dans le monde entier. À la recherche de la vitesse, de l’efficacité et de la rentabilité maximales, les propriétaires d’usine utilisèrent les études sur le temps et le mouvement pour organiser leur production et configurer le travail de leurs ouvriers. Le but, comme Taylor le définissait dans son célèbre traité de 1911, « La direction des ateliers » (le titre original « The principles of scientific management » pourrait être traduit en français par « Les principes de l’organisation scientifique »), était d’identifier et d’adopter, pour chaque poste, la « meilleure méthode » de travail et ainsi réaliser « la substitution graduelle de la science à la méthode empirique dans les arts mécaniques ». Une fois que le système serait appliqué à tous les actes du travail manuel, garantissait Taylor à ses émules, cela amènerait un remodelage, non seulement de l’industrie, mais également de la société, créant une efficacité parfaite utopique. « Dans le passé, l’homme était la priorité », déclare-t-il, « dans le futur, la priorité, ce sera le système ».

Le système de Taylor, le taylorisme, est encore bien vivant ; il demeure l’éthique de la production industrielle. Et désormais, grâce au pouvoir grandissant que les ingénieurs informaticiens et les programmeurs de logiciel exercent sur nos vies intellectuelles, l’éthique de Taylor commence également à gouverner le royaume de l’esprit. Internet est une machine conçue pour la collecte automatique et efficace, la transmission et la manipulation des informations, et des légions de programmeurs veulent trouver « LA meilleure méthode », l’algorithme parfait, pour exécuter chaque geste mental de ce que nous pourrions décrire comme « le travail de la connaissance ».

Le siège de Google, à Mountain View, en Californie, le Googleplex, est la Haute Église d’Internet, et la religion pratiquée en ses murs est le taylorisme. Google, selon son directeur-général Eric Schmidt, est « une entreprise fondée autour de la science de la mesure » et il s’efforce de « tout systématiser » dans son fonctionnement. En s’appuyant sur les téra-octets de données comportementales qu’il collecte à travers son moteur de recherche et ses autres sites, il réalise des milliers d’expériences chaque jour, selon le Harvard Business Review, et il utilise les résultats pour peaufiner les algorithmes qui contrôlent de plus en plus la façon dont les gens trouvent l’information et en extraient le sens. Ce que Taylor a fait pour le travail manuel, Google le fait pour le travail de l’esprit.

Google a déclaré que sa mission était « d’organiser les informations du monde et de les rendre universellement accessibles et utiles ». Cette société essaie de développer « le moteur de recherche parfait », qu’elle définit comme un outil qui “comprendrait exactement ce que vous voulez dire et vous donnerait en retour exactement ce que vous désirez”. Selon la vision de Google, l’information est un produit comme un autre, une ressource utilitaire qui peut être exploitée et traitée avec une efficacité industrielle. Plus le nombre de morceaux d’information auxquels nous pouvons « accéder » est important, plus rapidement nous pouvons en extraire l’essence, et plus nous sommes productifs en tant que penseurs.

Où cela s’arrêtera-t-il ? Sergey Brin et Larry Page, les brillants jeunes gens qui ont fondé Google pendant leur doctorat en informatique à Stanford, parlent fréquemment de leur désir de transformer leur moteur de recherche en une intelligence artificielle, une machine comme HAL, qui pourrait être connectée directement à nos cerveaux. « Le moteur de recherche ultime est quelque chose d’aussi intelligent que les êtres humains, voire davantage », a déclaré Page lors d’une conférence il y a quelques années. « Pour nous, travailler sur les recherches est un moyen de travailler sur l’intelligence artificielle. » Dans un entretien de 2004 pour Newsweek, Brin affirmait : « Il est certain que si vous aviez toutes les informations du monde directement fixées à votre cerveau ou une intelligence artificielle qui serait plus intelligente que votre cerveau, vous vous en porteriez mieux. » L’année dernière, Page a dit lors d’une convention de scientifiques que Google « essayait vraiment de construire une intelligence artificielle et de le faire à grande échelle. »

Une telle ambition est naturelle, et même admirable, pour deux mathématiciens prodiges disposant d’immenses moyens financiers et d’une petite armée d’informaticiens sous leurs ordres. Google est une entreprise fondamentalement scientifique, motivée par le désir d’utiliser la technologie, comme l’exprime Eric Schmidt, « pour résoudre les problèmes qui n’ont jamais été résolus auparavant », et le frein principal à la réussite d’une telle entreprise reste l’intelligence artificielle. Pourquoi Brin et Page ne voudraient-ils pas être ceux qui vont parvenir à surmonter cette difficulté ?

Pourtant, leur hypothèse simpliste voulant que nous nous « porterions mieux » si nos cerveaux étaient assistés ou même remplacés par une intelligence artificielle, est inquiétante. Cela suggère que d’après eux l’intelligence résulte d’un processus mécanique, d’une suite d’étapes discrètes qui peuvent être isolés, mesurés et optimisés. Dans le monde de Google, le monde dans lequel nous entrons lorsque nous allons en ligne, il y a peu de place pour le flou de la réflexion. L’ambiguïté n’est pas un préliminaire à la réflexion mais un bogue à corriger. Le cerveau humain n’est qu’un ordinateur dépassé qui a besoin d’un processeur plus rapide et d’un plus gros disque dur.

L’idée que nos esprits doivent fonctionner comme des machines traitant des données à haute vitesse n’est pas seulement inscrite dans les rouages d’Internet, c’est également le business-model qui domine le réseau. Plus vous surfez rapidement sur le Web, plus vous cliquez sur des liens et visitez de pages, plus Google et les autres compagnies ont d’occasions de recueillir des informations sur vous et de vous nourrir avec de la publicité. La plupart des propriétaires de sites commerciaux ont un enjeu financier à collecter les miettes de données que nous laissons derrière nous lorsque nous voletons de lien en lien : plus y a de miettes, mieux c’est. Une lecture tranquille ou une réflexion lente et concentrée sont bien les dernières choses que ces compagnies désirent. C’est dans leur intérêt commercial de nous distraire.

Peut-être ne suis-je qu’un angoissé. Tout comme il y a une tendance à glorifier le progrès technologique, il existe la tendance inverse, celle de craindre le pire avec tout nouvel outil ou toute nouvelle machine. Dans le Phèdre de Platon, Socrate déplore le développement de l’écriture. Il avait peur que, comme les gens se reposaient de plus en plus sur les mots écrits comme un substitut à la connaissance qu’ils transportaient d’habitude dans leur tête, ils allaient, selon un des intervenants d’un dialogue, « arrêter de faire travailler leur mémoire et devenir oublieux. » Et puisqu’ils seraient capables de « recevoir une grande quantité d’informations sans instruction appropriée », ils risquaient de « croire posséder une grande connaissance, alors qu’ils seraient en fait largement ignorants ». Ils seraient « remplis de l’orgueil de la sagesse au lieu de la sagesse réelle ». Socrate n’avait pas tort, les nouvelles technologies ont souvent les effets qu’il redoutait, mais il manquait de vision à long terme. Il ne pouvait pas prévoir les nombreux moyens que l’écriture et la lecture allaient fournir pour diffuser l’information, impulsant des idées fraîches et élargissant la connaissance humaine (voire la sagesse).

L’arrivée de l’imprimerie de Gutenberg, au XVème siècle, déclencha une autre série de grincements de dents. L’humaniste italien Hieronimo Squarciafico s’inquiétait que la facilité à obtenir des livres conduise à la paresse intellectuelle, rende les hommes « moins studieux » et affaiblisse leur esprit. D’autres avançaient que des livres et journaux imprimés à moindre coût allaient saper l’autorité religieuse, rabaisser le travail des érudits et des scribes, et propager la sédition et la débauche. Comme le professeur de l’université de New York, Clay Shirky, le remarque, « la plupart des arguments contre l’imprimerie était corrects et même visionnaires. » Mais, encore une fois, les prophètes de l’apocalypse ne pouvaient imaginer la myriade de bienfaits que le texte imprimé allait amener.

Alors certes, vous pouvez vous montrer sceptique vis-à-vis de mon scepticisme. Ceux qui considèrent les détracteurs d’Internet comme des béotiens technophobes ou passéistes auront peut-être raison, et peut-être que de nos esprits hyperactifs, gavés de données surgira un âge d’or de la découverte intellectuelle et de la sagesse universelle. Là encore, le Net n’est pas l’alphabet, et même s’il remplacera peut-être l’imprimerie, il produira quelque chose de complètement différent. Le type de lecture profonde qu’une suite de pages imprimées stimule est précieux, non seulement pour la connaissance que nous obtenons des mots de l’auteur, mais aussi pour les vibrations intellectuelles que ces mots déclenchent dans nos esprits. Dans les espaces de calme ouverts par la lecture soutenue et sans distraction d’un livre, ou d’ailleurs par n’importe quel autre acte de contemplation, nous faisons nos propres associations, construisons nos propres inférences et analogies, nourrissons nos propres idées. La lecture profonde, comme le défend Maryanne Wolf, est indissociable de la pensée profonde.

Si nous perdons ces endroits calmes ou si nous les remplissons avec du « contenu », nous allons sacrifier quelque chose d’important non seulement pour nous même, mais également pour notre culture. Dans un essai récent, l’auteur dramatique Richard Foreman décrit de façon éloquente ce qui est en jeu :

Je suis issu d’une tradition culturelle occidentale, pour laquelle l’idéal (mon idéal) était la structure complexe, dense et « bâtie telle une cathédrale » de la personnalité hautement éduquée et logique, un homme ou une femme qui transporte en soi-même une version unique et construite personnellement de l’héritage tout entier de l’occident. Mais maintenant je vois en nous tous (y compris en moi-même) le remplacement de cette densité interne complexe par une nouvelle sorte d’auto-évolution sous la pression de la surcharge d’information et la technologie de « l’instantanément disponible ».

À mesure que nous nous vidons de notre « répertoire interne issu de notre héritage dense », conclut Foreman, nous risquons de nous transformer en « crêpe humaine », étalée comme un pâte large et fine à mesure que nous nous connectons à ce vaste réseau d’information accessible en pressant simplement sur une touche.”

Cette scène de 2001 : l’odyssée de l’espace me hante. Ce qui la rend si poignante, et si bizarre, c’est la réponse pleine d’émotion de l’ordinateur lors du démontage de son esprit : son désespoir à mesure que ses circuits s’éteignent les uns après les autres, sa supplication enfantine face à l’astronaute, “Je le sens, je le sens. J’ai peur.”, ainsi que sa transformation et son retour final à ce que nous pourrions appeler un état d’innocence. L’épanchement des sentiments de HAL contraste avec l’absence d’émotion qui caractérise les personnages humains dans le film, lesquels s’occupent de leur boulot avec une efficacité robotique. Leurs pensées et leurs actions semblent scénarisées, comme s’ils suivaient les étapes d’un algorithme. Dans le monde de 2001, les hommes sont devenus si semblables aux machines que le personnage le plus humain se trouve être une machine. C’est l’essence de la sombre prophétie de Kubrick : à mesure que nous nous servons des ordinateurs comme intermédiaires de notre compréhension du monde, c’est notre propre intelligence qui devient semblable à l’intelligence artificielle.

D’un côté vous avez le « copyright », qui donne à l’auteur un droit exclusif d’exploitation sur son œuvre (texte, image, musique, cinéma, logiciel, etc.) et qui s’applique par défaut en l’absence de toute autre mention.

D’un côté vous avez le « copyright », qui donne à l’auteur un droit exclusif d’exploitation sur son œuvre (texte, image, musique, cinéma, logiciel, etc.) et qui s’applique par défaut en l’absence de toute autre mention. Suite et bientôt fin des billets anticipant la très prochaine campagne de soutien.

Suite et bientôt fin des billets anticipant la très prochaine campagne de soutien.

Désolé d’en

Désolé d’en  Il y a à peine un mois la

Il y a à peine un mois la  Le développement d’un logiciel libre est paradoxal. En théorie, et c’est même ce qui le fonde, il est ouvert à tout le monde mais en pratique son efficacité tire très souvent profit d’une structure qui voit une personne, presque toujours le créateur initial, se dégager de la multitude pour exercer, ce que l’on qualifie faut de mieux, une « dictature bienveillante ».

Le développement d’un logiciel libre est paradoxal. En théorie, et c’est même ce qui le fonde, il est ouvert à tout le monde mais en pratique son efficacité tire très souvent profit d’une structure qui voit une personne, presque toujours le créateur initial, se dégager de la multitude pour exercer, ce que l’on qualifie faut de mieux, une « dictature bienveillante ». Hier, c’était

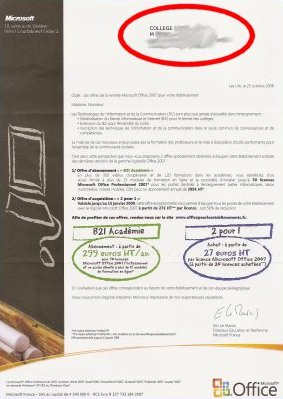

Hier, c’était  En juin dernier Microsoft « offrait » sa suite bureautique aux enseignants sous l’aile bienveillante et complice d’associations comme

En juin dernier Microsoft « offrait » sa suite bureautique aux enseignants sous l’aile bienveillante et complice d’associations comme