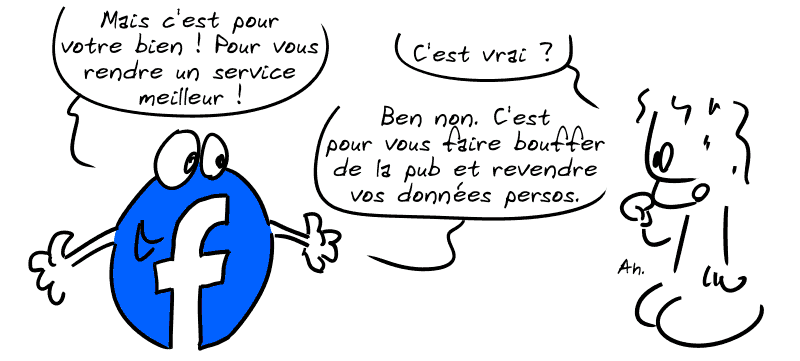

Attention à l’économie de l’attention

Parce que les phénomènes d’addiction aux médias sociaux ne sont pas apparus spontanément mais ont savamment été mis en place par les GAFAM, et qu’il faudrait sans doute que ça se sache un peu plus… Attention à l’économie de l’attention … Lire la suite