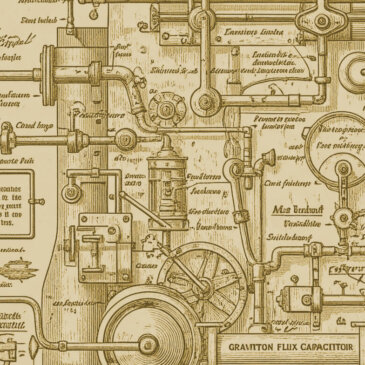

Techno parade

La prétendue « neutralité technologique » est un écran de fumée politique au service d’un discours néolibéral. Face à cela, il ne s’agit pas de rejeter la technologie en bloc, mais de l’aborder selon plusieurs perspectives qu’il faut sans cesse renouveler. Si … Lire la suite